Robots.txt dla AI: Jak kontrolować dostęp botów do Twoich treści

Dowiedz się, jak używać robots.txt do kontroli, które boty AI mają dostęp do Twoich treści. Kompletny przewodnik po blokowaniu GPTBot, ClaudeBot i innych crawle...

Strategiczne podejście pozwalające właścicielom stron internetowych selektywnie zezwalać określonym crawlerom AI, jednocześnie blokując inne, w oparciu o cele biznesowe, umowy licencyjne dotyczące treści oraz ocenę wartości. Zamiast wdrażać ogólne polityki, różnicowany dostęp polega na indywidualnej ocenie każdego crawlera pod kątem generowania ruchu, respektowania warunków licencyjnych czy zgodności z celami monetyzacji. Wydawcy korzystają z narzędzi takich jak robots.txt, nagłówki HTTP oraz platformowe mechanizmy kontroli, aby wdrażać szczegółowe zasady dostępu. Metoda ta równoważy możliwości innowacji z ochroną treści i sprawiedliwym wynagrodzeniem.

Strategiczne podejście pozwalające właścicielom stron internetowych selektywnie zezwalać określonym crawlerom AI, jednocześnie blokując inne, w oparciu o cele biznesowe, umowy licencyjne dotyczące treści oraz ocenę wartości. Zamiast wdrażać ogólne polityki, różnicowany dostęp polega na indywidualnej ocenie każdego crawlera pod kątem generowania ruchu, respektowania warunków licencyjnych czy zgodności z celami monetyzacji. Wydawcy korzystają z narzędzi takich jak robots.txt, nagłówki HTTP oraz platformowe mechanizmy kontroli, aby wdrażać szczegółowe zasady dostępu. Metoda ta równoważy możliwości innowacji z ochroną treści i sprawiedliwym wynagrodzeniem.

Eksplozja crawlerów AI zasadniczo zaburzyła wieloletnią relację pomiędzy właścicielami stron a botami. Przez lata internet funkcjonował na prostej zasadzie wymiany: wyszukiwarki takie jak Google indeksowały treści i kierowały ruch z powrotem do oryginalnych źródeł, tworząc symbiotyczną relację nagradzającą wysoką jakość tworzonych treści. Dziś nowa generacja crawlerów AI — w tym GPTBot, ClaudeBot, PerplexityBot i dziesiątki innych — działa według innych reguł. Te boty pobierają treści nie po to, by je indeksować do odnalezienia, lecz by bezpośrednio zasilać nimi modele AI generujące odpowiedzi bez odsyłania użytkowników do źródła. Skutki są wyraźne: według danych Cloudflare, GPTBot OpenAI osiąga stosunek crawl-to-referral około 1 700:1, a ClaudeBot od Anthropic aż 73 000:1, co oznacza, że na każdego odwiedzającego odesłanego do strony wydawcy przypadają tysiące przeszukanych stron na potrzeby treningu danych. Ta zerwana wymiana zmusiła wydawców do ponownego przemyślenia polityk dostępu dla crawlerów, przechodząc od binarnego wyboru „zezwól wszystkim” lub „zablokuj wszystkich” do bardziej zniuansowanej strategii: różnicowanego dostępu dla crawlerów. Zamiast wdrażać ogólne polityki, świadomi wydawcy oceniają teraz każdego crawlera z osobna, zadając kluczowe pytania o wartość, licencjonowanie i zgodność z celami biznesowymi.

Zrozumienie różnych typów crawlerów AI jest kluczowe dla wdrożenia skutecznej strategii różnicowanego dostępu, ponieważ każdy z nich służy odmiennym celom i ma różny wpływ na Twój biznes. Crawlery AI dzielą się na trzy główne kategorie: crawlery treningowe (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider), które zbierają treści do treningu modeli; crawlery wyszukiwawcze (OAI-SearchBot, PerplexityBot, Google-Extended), indeksujące treści na potrzeby wyników wyszukiwania AI; oraz agenci uruchamiani przez użytkownika (ChatGPT-User, Claude-Web, Perplexity-User), pobierający treści tylko wtedy, gdy użytkownik wyraźnie zażąda. Propozycja wartości różni się diametralnie między tymi kategoriami. Crawlery treningowe zwykle generują minimalny ruch zwrotny na Twoją stronę — pobierają wartość bez wzajemnych korzyści — i dlatego często są blokowane. Crawlery wyszukiwawcze mogą natomiast zapewnić znaczący ruch referencyjny i konwersje subskrybentów, podobnie jak tradycyjne wyszukiwarki. Agenci uruchamiani przez użytkownika stanowią kategorię pośrednią, aktywując się tylko przy zaangażowaniu użytkownika. The Atlantic, jeden z największych wydawców cyfrowych, wdrożył zaawansowaną metodę oceny crawlerów, monitorując wolumen ruchu i konwersje subskrybentów dla każdego bota. Analizy wykazały, że niektóre crawlery generują realną wartość, podczas gdy inne praktycznie nie generują ruchu, zużywając jedynie transfer. Takie podejście oparte na danych pozwala podejmować decyzje w oparciu o fakty, a nie przypuszczenia.

| Typ crawlera | Przykłady | Główny cel | Typowa wartość ruchu | Zalecany dostęp |

|---|---|---|---|---|

| Treningowy | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Zbiory danych do treningu modeli | Bardzo niska (stosunek 1 700:1 do 73 000:1) | Często blokowany |

| Wyszukiwawczy | OAI-SearchBot, PerplexityBot, Google-Extended | Indeksacja wyszukiwania AI | Średnia do wysokiej | Często dozwolony |

| Uruchamiany przez użytkownika | ChatGPT-User, Claude-Web, Perplexity-User | Bezpośrednie żądania użytkownika | Zmienna | Indywidualna decyzja |

Wdrożenie różnicowanego dostępu dla crawlerów wymaga połączenia narzędzi technicznych i decyzji strategicznych, z wieloma dostępnymi metodami w zależności od możliwości technicznych i wymagań biznesowych. Najbardziej podstawowym narzędziem jest robots.txt, prosty plik tekstowy w głównym katalogu strony, który określa preferencje dostępu crawlerów za pomocą dyrektyw User-agent. Choć robots.txt jest dobrowolny i tylko 40-60% botów AI go respektuje, pozostaje pierwszą linią obrony i nic nie kosztuje. Dla wydawców oczekujących silniejszego egzekwowania, zarządzany robots.txt od Cloudflare automatycznie tworzy i aktualizuje dyrektywy dla crawlerów, dodając je do istniejącego pliku i eliminując ręczną administrację. Poza robots.txt dostępne są dodatkowe mechanizmy kontroli:

Najskuteczniejsze podejście łączy kilka warstw: robots.txt dla botów respektujących zasady, reguły WAF dla egzekwowania oraz narzędzia monitorujące do śledzenia skuteczności i identyfikacji nowych zagrożeń.

Wdrożenie różnicowanego dostępu dla crawlerów wymaga wyjścia poza kwestie techniczne i opracowania spójnej strategii biznesowej, zgodnej z modelem przychodów i pozycjonowaniem konkurencyjnym. Metoda The Atlantic stanowi praktyczne ramy: oceniają każdego crawlera w oparciu o dwa główne wskaźniki — wolumen ruchu i konwersje subskrybentów — zadając pytanie, czy dany crawler generuje wystarczającą wartość, aby uzasadnić dostęp do treści. Dla wydawcy, gdzie wartość subskrybenta to 80 USD rocznie, crawler generujący 1 000 subskrybentów oznacza 80 000 USD rocznego przychodu, co zasadniczo zmienia decyzję o dostępie. Jednak ruch i konwersje to tylko część równania. Wydawcy muszą również brać pod uwagę:

Najbardziej strategiczni wydawcy wdrażają polityki warstwowego dostępu: zezwalają crawlerom wyszukiwawczym generującym ruch, blokują crawlerów treningowych nieprzynoszących wartości i negocjują licencje z najważniejszymi firmami AI. Takie podejście maksymalizuje widoczność i przychody, chroniąc jednocześnie własność intelektualną.

Mimo że różnicowany dostęp dla crawlerów oferuje istotne korzyści, rzeczywistość jest bardziej złożona niż teoria i wymaga ciągłego nadzoru z uwagi na ograniczenia efektywności. Najważniejszym ograniczeniem jest to, że robots.txt jest dobrowolny — crawlery respektujące go robią to z własnej woli, nie z obowiązku. Badania wskazują, że robots.txt zatrzymuje tylko 40-60% botów AI, kolejne 30-40% udaje się zablokować poprzez blokowanie agenta użytkownika, a 10-30% crawlerów działa bez ograniczeń. Niektóre firmy AI i złośliwi aktorzy celowo ignorują robots.txt, uznając dostęp do treści za cenniejszy niż zgodność. Ponadto techniki omijania blokad stale ewoluują: zaawansowane boty podszywają się pod przeglądarki, korzystają z rozproszonych adresów IP i używają przeglądarek headless, które imitują zachowania ludzi. Dylemat Google-Extended dobrze ilustruje złożoność: blokowanie Google-Extended chroni Twoje treści przed treningiem Gemini AI, ale Google AI Overviews (pojawiające się w wynikach wyszukiwania) korzystają ze standardowych zasad Googlebot — nie można zrezygnować z Overviews AI bez utraty widoczności w wyszukiwarce. Monitoring i egzekwowanie wymagają też znacznych zasobów — śledzenie nowych crawlerów, aktualizacja polityk i weryfikacja skuteczności to nieustanna praca. Wreszcie aspekty prawne są niepewne: choć teoretycznie prawo autorskie chroni treści, egzekwowanie wobec firm AI jest kosztowne i niepewne, przez co wydawcy polegają głównie na kontroli technicznej, a nie na gwarancjach prawnych.

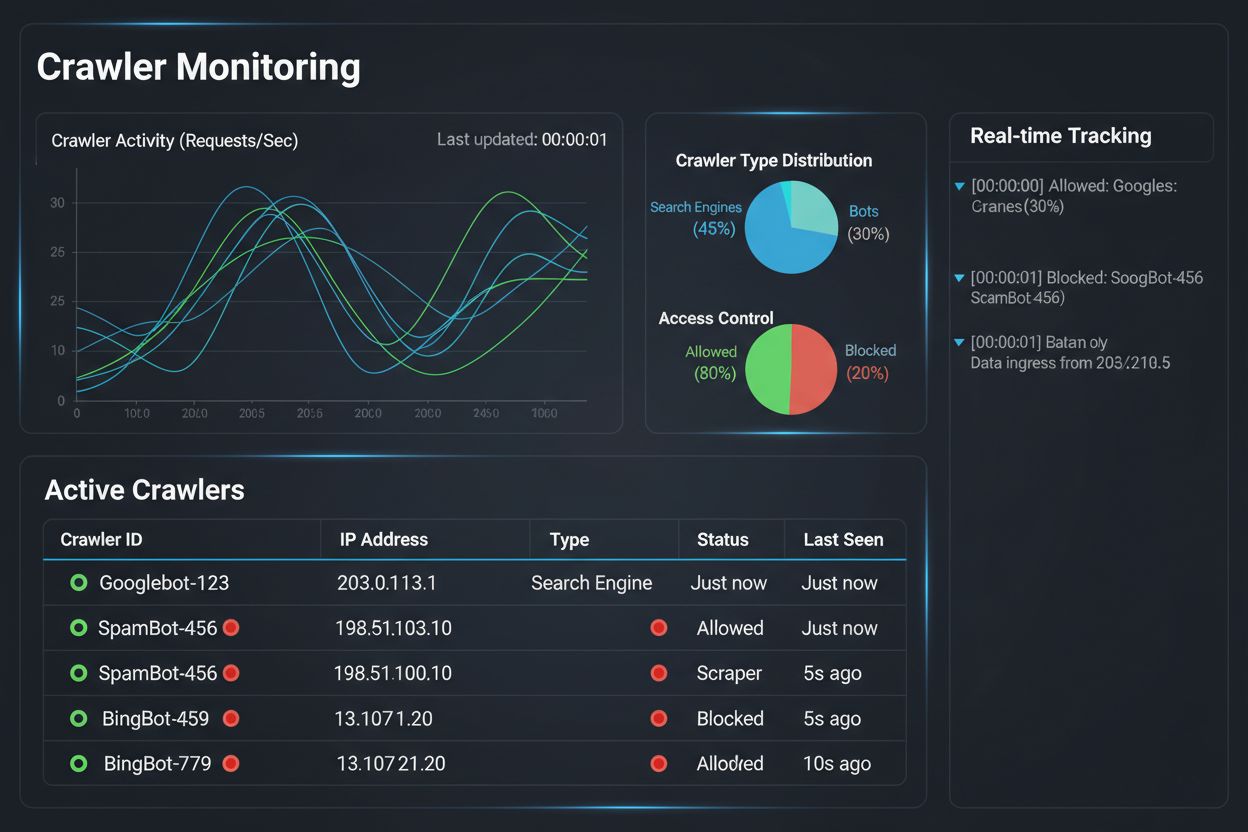

Wdrożenie strategii różnicowanego dostępu dla crawlerów to tylko połowa sukcesu; drugą jest zrozumienie rzeczywistego wpływu wdrożonych polityk dzięki kompleksowemu monitorowaniu i pomiarom. Tutaj kluczową rolę odgrywa AmICited.com, niezbędny element zarządzania crawlerami. AmICited specjalizuje się w monitoringu tego, jak systemy AI cytują i odnoszą się do Twojej marki w GPT, Perplexity, Google AI Overviews i innych platformach — zapewniając wgląd, które crawlery rzeczywiście korzystają z Twoich treści i jak są one prezentowane w odpowiedziach AI. Zamiast polegać na logach serwera i domysłach, panel AmICited dokładnie pokazuje, które systemy AI miały dostęp do Twoich treści, jak często i — co najważniejsze — czy Twoje treści są cytowane, czy tylko pochłaniane do zbiorów treningowych bez atrybucji. Te informacje bezpośrednio wspierają decyzje o różnicowanym dostępie: jeśli crawler korzysta z Twoich treści, ale nigdy nie cytuje ich w odpowiedziach AI, blokada staje się oczywistą decyzją biznesową. AmICited umożliwia też benchmarking konkurencyjny, pokazując widoczność Twoich treści w systemach AI na tle konkurencji, ułatwiając ocenę, czy polityki dostępu są zbyt restrykcyjne lub zbyt liberalne. Platforma oferuje alerty w czasie rzeczywistym o nowych AI odwołujących się do Twoich treści, pozwalając na szybką korektę polityk. Dzięki połączeniu monitoringu AmICited z narzędziami egzekwującymi Cloudflare, wydawcy zyskują pełną widoczność i kontrolę: widzą, które crawlery mają dostęp, mierzą wpływ biznesowy i dostosowują polityki. Takie podejście oparte na danych zmienia zarządzanie crawlerami z technicznego obowiązku w strategiczną funkcję biznesową.

Krajobraz różnicowanego dostępu dla crawlerów szybko się zmienia, a nowe standardy i modele biznesowe kształtują relacje między wydawcami a firmami AI wokół treści. Propozycja preferencji AI IETF to ważny krok naprzód, ustanawiający znormalizowane sposoby komunikowania przez strony internetowe preferencji dotyczących treningu AI, inferencji i wykorzystania w wyszukiwaniu. Zamiast polegać na robots.txt — standardzie mającym 30 lat, stworzonym dla wyszukiwarek — nowa struktura daje wyraźną, szczegółową kontrolę nad wykorzystaniem treści przez AI. Równocześnie modele biznesowe oparte na zgodach zyskują na popularności, a inicjatywa Cloudflare Pay Per Crawl wytycza nową ścieżkę, w której firmy AI płacą wydawcom za dostęp do treści, przekształcając crawlery z zagrożeń w źródło przychodów. Przesunięcie z blokowania na licencjonowanie to fundamentalna zmiana ekonomii internetu: zamiast walki o dostęp, wydawcy i firmy AI negocjują sprawiedliwe wynagrodzenie. Standardy uwierzytelniania i weryfikacji crawlerów również się rozwijają, a kryptograficzne metody pozwalają wydawcom potwierdzać tożsamość crawlerów i zapobiegać podszywaniu się. W przyszłości spodziewać się można wzmożonych regulacji dotyczących danych treningowych AI, które mogą wymagać wyraźnej zgody i wynagrodzenia za użycie treści. Konwergencja tych trendów — standardów technicznych, modeli licencyjnych, mechanizmów uwierzytelniania i nacisków regulacyjnych — sprawia, że różnicowany dostęp dla crawlerów ewoluuje z defensywnej strategii w zaawansowaną funkcję biznesową, w której wydawcy aktywnie zarządzają, monitorują i monetyzują dostęp AI do swoich treści. Wydawcy, którzy już dziś wdrażają kompleksowy monitoring i strategiczne polityki, najlepiej wykorzystają nadchodzące możliwości.

Blokowanie wszystkich crawlerów całkowicie usuwa Twoje treści z systemów AI, eliminując zarówno ryzyka, jak i szanse. Różnicowany dostęp pozwala indywidualnie ocenić każdego crawlera, blokując te, które nie przynoszą wartości, a zezwalając tym, które generują ruch lub oferują możliwości licencyjne. Takie zniuansowane podejście maksymalizuje widoczność i przychody, chroniąc jednocześnie własność intelektualną.

Możesz monitorować aktywność crawlerów poprzez logi serwera, panel analityczny Cloudflare lub specjalistyczne narzędzia monitorujące, takie jak AmICited.com. AmICited śledzi konkretnie, które systemy AI mają dostęp do Twoich treści i jak Twoja marka pojawia się w odpowiedziach generowanych przez AI, oferując biznesowe wnioski wykraczające poza techniczne logi.

Nie. Blokowanie crawlerów treningowych AI takich jak GPTBot, ClaudeBot i CCBot nie wpływa na Twoje pozycje w Google ani Bing. Tradycyjne wyszukiwarki korzystają z innych crawlerów (Googlebot, Bingbot), które działają niezależnie. Blokuj je tylko wtedy, jeśli chcesz całkowicie zniknąć z wyników wyszukiwania.

Tak, to najbardziej strategiczne podejście dla wielu wydawców. Możesz zezwolić crawlerom nastawionym na wyszukiwanie, takim jak OAI-SearchBot i PerplexityBot (które generują ruch), blokując jednocześnie crawlerów treningowych, jak GPTBot i ClaudeBot (które zwykle tego nie robią). Dzięki temu utrzymasz widoczność w wynikach wyszukiwania AI, chroniąc jednocześnie treści przed wykorzystaniem do treningu modeli.

Podczas gdy główne crawlery OpenAI, Anthropic i Google respektują robots.txt, niektóre boty celowo go ignorują. Jeśli crawler nie przestrzega robots.txt, potrzebne będą dodatkowe metody egzekwowania, takie jak reguły WAF, blokowanie IP czy funkcje zarządzania botami Cloudflare. Dlatego narzędzia monitorujące, jak AmICited, są kluczowe — pokazują, które crawlery rzeczywiście przestrzegają Twoich zasad.

Rewiduj polityki co najmniej raz na kwartał, ponieważ firmy AI regularnie wprowadzają nowe crawlery. Anthropic połączył swoje boty 'anthropic-ai' i 'Claude-Web' w 'ClaudeBot', dając nowemu botowi tymczasowy, nieograniczony dostęp do stron, które nie zaktualizowały zasad. Regularny monitoring z AmICited pozwala wyprzedzać zmiany.

Googlebot to crawler Google indeksujący treści do wyników wyszukiwania. Google-Extended to specjalny token kontrolny, który decyduje, czy Twoje treści będą użyte do treningu Gemini AI. Możesz zablokować Google-Extended bez wpływu na pozycje w wyszukiwarce, ale należy pamiętać, że Google AI Overviews (pojawiające się w wynikach wyszukiwania) korzystają ze standardowych zasad Googlebot — nie możesz zrezygnować z AI Overviews bez utraty widoczności w wyszukiwarce.

Tak, pojawiają się modele licencyjne, jak Cloudflare Pay Per Crawl, umożliwiające wydawcom pobieranie opłat od firm AI za dostęp do treści. Zmienia to crawlery z zagrożenia w źródło przychodów. Wymaga to jednak negocjacji z firmami AI i może wiązać się z umowami prawnymi. Monitoring AmICited pomaga zidentyfikować crawlery będące najbardziej wartościowymi partnerami licencyjnymi.

Śledź, które systemy AI uzyskują dostęp do Twoich treści i jak Twoja marka pojawia się w odpowiedziach generowanych przez AI. Uzyskaj wgląd w czasie rzeczywistym w zachowanie crawlerów i mierz biznesowy wpływ polityk różnicowanego dostępu.

Dowiedz się, jak używać robots.txt do kontroli, które boty AI mają dostęp do Twoich treści. Kompletny przewodnik po blokowaniu GPTBot, ClaudeBot i innych crawle...

Kompletny przewodnik po AI crawlerach i botach. Identyfikuj GPTBot, ClaudeBot, Google-Extended oraz 20+ innych AI crawlerów z agentami użytkownika, tempem indek...

Dowiedz się, jak działają AI crawlers takie jak GPTBot i ClaudeBot, czym różnią się od tradycyjnych crawlerów wyszukiwarek oraz jak zoptymalizować swoją stronę ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.