Edge SEO

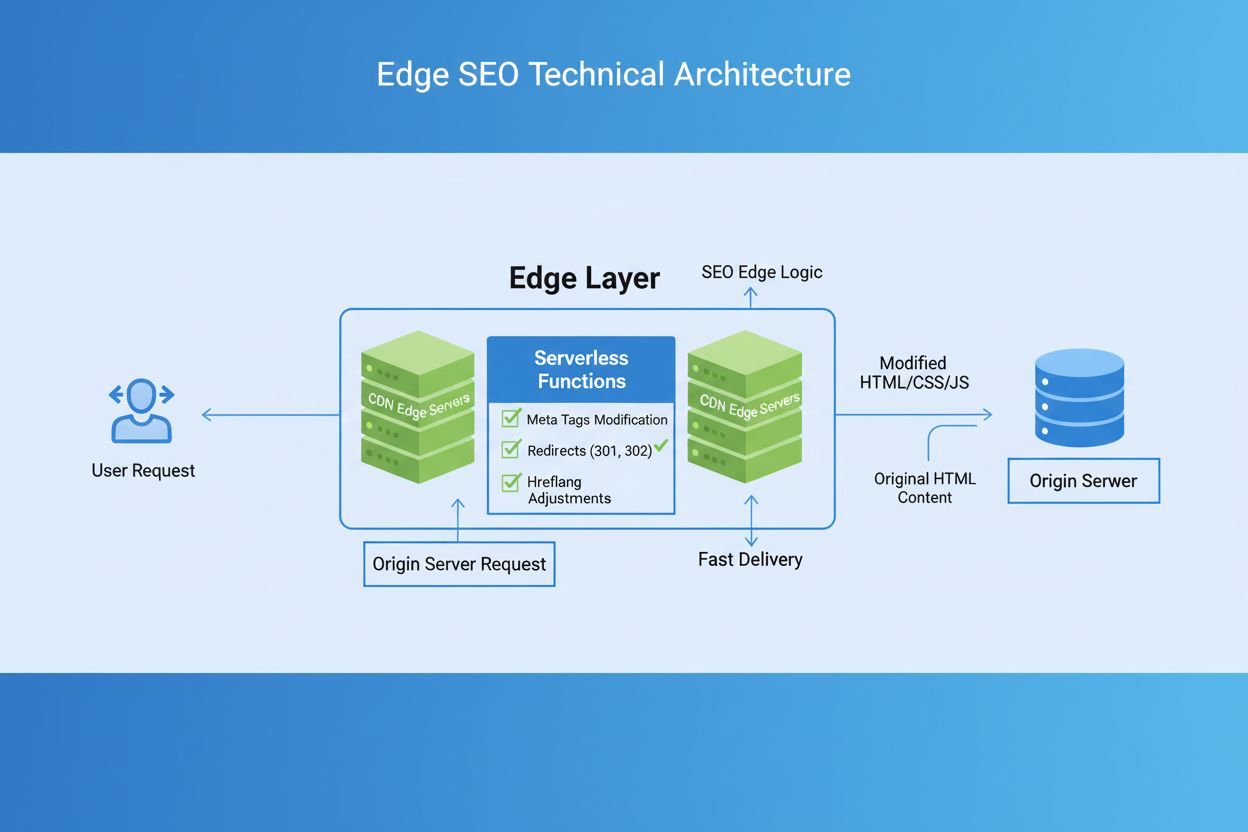

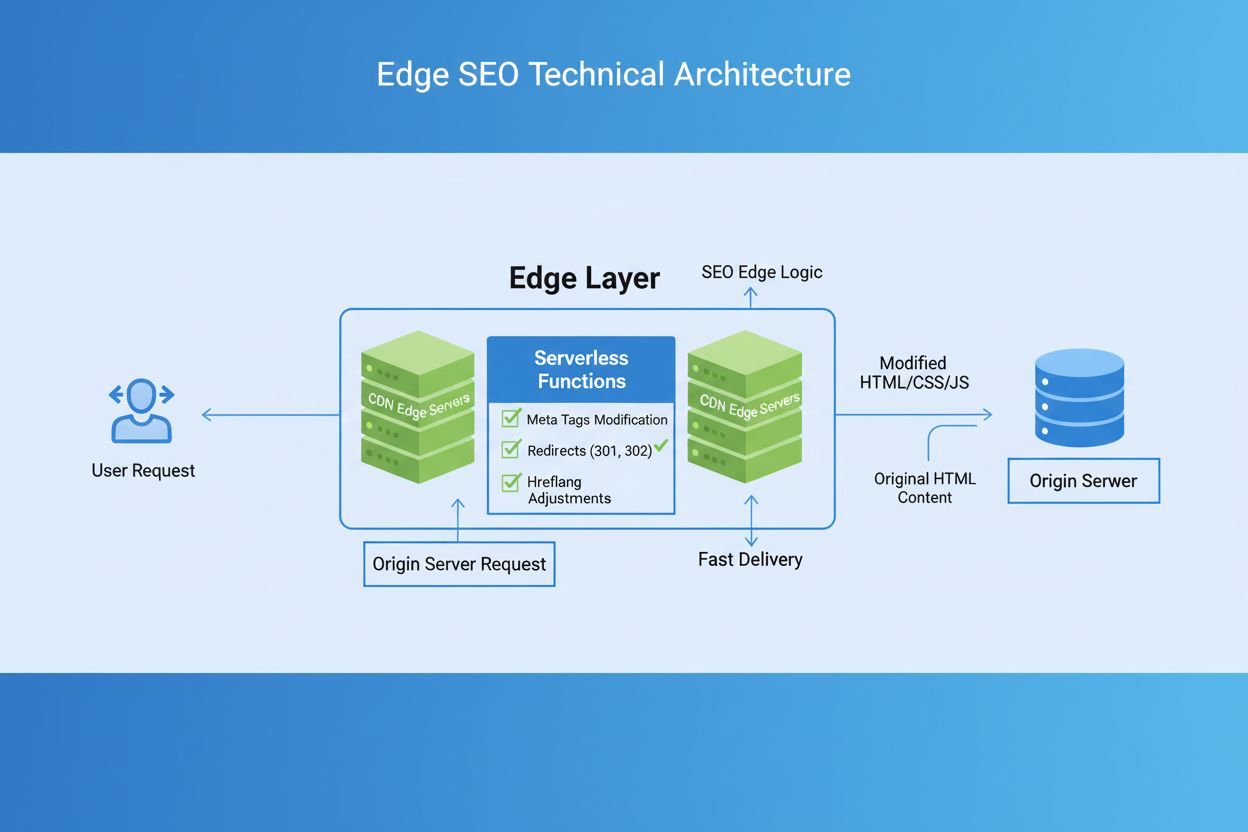

Edge SEO to praktyka wdrażania technicznych zmian SEO na krawędzi sieci przy użyciu funkcji serverless na CDN. Dowiedz się, jak poprawia wydajność, umożliwia sz...

Przetwarzanie Edge AI odnosi się do wdrażania algorytmów sztucznej inteligencji bezpośrednio na urządzeniach lokalnych lub serwerach brzegowych, umożliwiając przetwarzanie i analizę danych w czasie rzeczywistym bez stałej zależności od infrastruktury chmurowej. Takie podejście zmniejsza opóźnienia, zwiększa prywatność danych i pozwala na natychmiastowe podejmowanie decyzji w aplikacjach takich jak monitoring marki, urządzenia IoT czy systemy autonomiczne.

Przetwarzanie Edge AI odnosi się do wdrażania algorytmów sztucznej inteligencji bezpośrednio na urządzeniach lokalnych lub serwerach brzegowych, umożliwiając przetwarzanie i analizę danych w czasie rzeczywistym bez stałej zależności od infrastruktury chmurowej. Takie podejście zmniejsza opóźnienia, zwiększa prywatność danych i pozwala na natychmiastowe podejmowanie decyzji w aplikacjach takich jak monitoring marki, urządzenia IoT czy systemy autonomiczne.

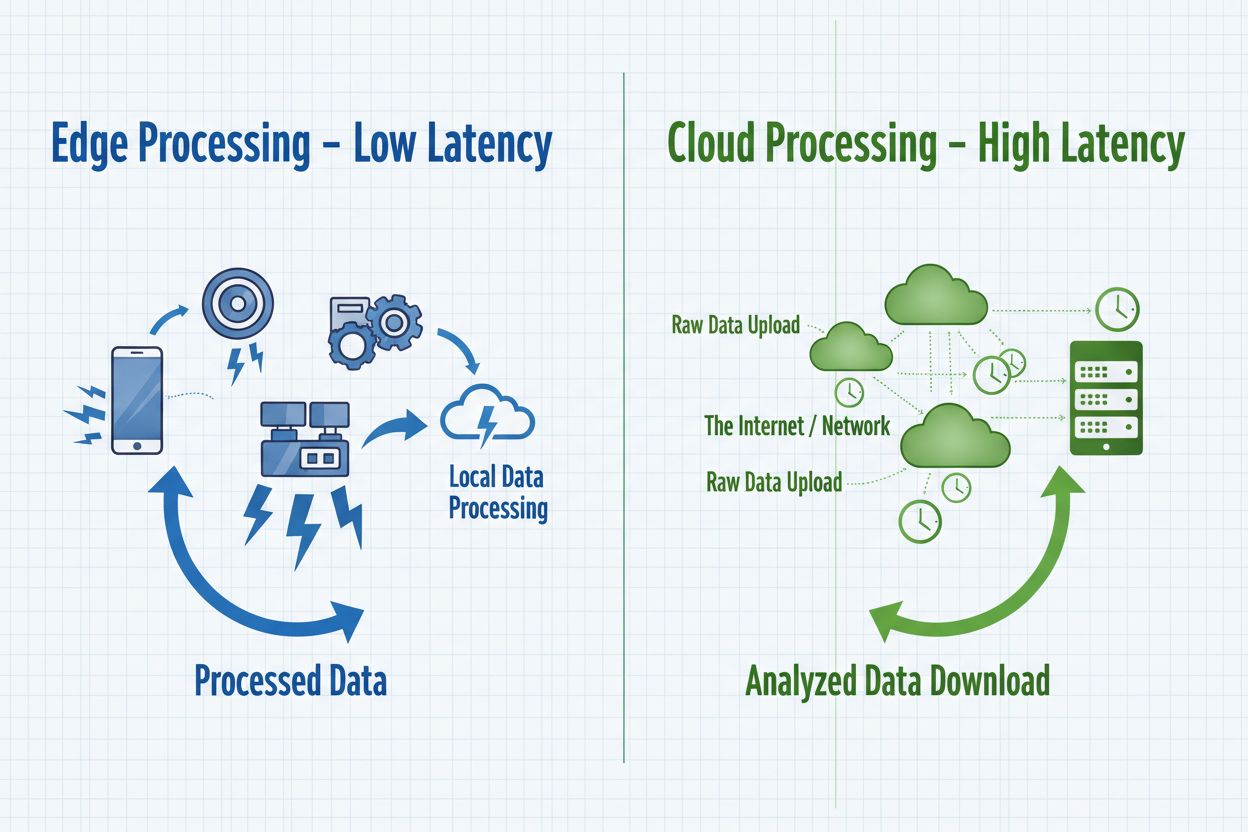

Przetwarzanie Edge AI to przełomowy sposób wdrażania sztucznej inteligencji, w którym zadania obliczeniowe są realizowane bezpośrednio na urządzeniach brzegowych—takich jak smartfony, czujniki IoT, kamery czy systemy wbudowane—zamiast polegać wyłącznie na scentralizowanych serwerach chmurowych. Takie podejście przetwarza dane u źródła, umożliwiając natychmiastową analizę i podejmowanie decyzji bez przesyłania surowych danych do odległych centrów danych. W przeciwieństwie do tradycyjnego cloud AI, który wysyła dane do zdalnych serwerów w celu przetworzenia i zwraca wyniki po czasie opóźnienia sieciowego, edge AI przenosi inteligencję na peryferia sieci, tam gdzie powstają dane. Przetwarzanie odbywa się na lokalnym sprzęcie z wbudowanymi modelami uczenia maszynowego, dzięki czemu urządzenia mogą działać autonomicznie i podejmować decyzje w czasie rzeczywistym. Edge AI łączy lekkie sieci neuronowe, zoptymalizowane algorytmy oraz wyspecjalizowane akceleratory sprzętowe, aby zapewnić możliwości AI w warunkach ograniczonych zasobów. Ten rozproszony model inteligencji zasadniczo zmienia podejście organizacji do prywatności danych, szybkości reakcji systemów i kosztów infrastruktury. Przetwarzając wrażliwe informacje lokalnie, edge AI eliminuje konieczność przesyłania potencjalnie poufnych danych przez sieci, odpowiadając na rosnące obawy dotyczące prywatności w branżach regulowanych.

Edge AI i cloud AI to uzupełniające się podejścia do wdrażania sztucznej inteligencji, z których każde ma swoje zalety dostosowane do różnych przypadków użycia i wymagań organizacyjnych. Cloud AI doskonale radzi sobie z obsługą ogromnych zbiorów danych, trenowaniem złożonych modeli i wykonywaniem obliczeniowo intensywnych zadań, które korzystają z centralnej mocy obliczeniowej i nieograniczonej skalowalności. Jednak rozwiązania chmurowe wprowadzają nieuniknione opóźnienia związane z przesyłaniem danych przez sieć, co czyni je nieodpowiednimi dla aplikacji wymagających natychmiastowych reakcji. Edge AI stawia na szybkość i responsywność dzięki lokalnemu przetwarzaniu informacji, umożliwiając podejmowanie decyzji w czasie poniżej milisekundy—co jest kluczowe dla systemów autonomicznych i monitoringu w czasie rzeczywistym. Wybór między tymi podejściami zależy od konkretnych wymagań: cloud AI sprawdza się w przetwarzaniu wsadowym, trenowaniu modeli i aplikacjach, gdzie dopuszczalne są niewielkie opóźnienia, natomiast edge AI jest dedykowane do zastosowań w czasie rzeczywistym, operacji wrażliwych na prywatność oraz tam, gdzie sieć jest zawodna. Organizacje coraz częściej wdrażają hybrydowe architektury, łącząc oba podejścia—urządzenia brzegowe służą do natychmiastowego przetwarzania, a infrastruktura chmurowa do trenowania modeli, analiz i długoterminowego przechowywania danych. Zrozumienie tych fundamentalnych różnic pozwala budować rozwiązania równoważące wydajność, bezpieczeństwo i efektywność operacyjną.

| Aspekt | Edge AI | Cloud AI |

|---|---|---|

| Opóźnienia | Reakcja poniżej milisekundy; lokalne przetwarzanie | 50-500 ms+ z powodu przesyłu i przetwarzania na serwerze |

| Zużycie pasma | Minimalna transmisja danych; lokalne przetwarzanie | Wysokie wymagania dotyczące pasma; ciągła transmisja surowych danych |

| Bezpieczeństwo i prywatność | Dane pozostają lokalnie; mniejsze ryzyko wycieku | Dane przesyłane przez sieć; centralne przechowywanie to pojedynczy punkt awarii |

| Moc obliczeniowa | Ograniczona sprzętem; lekkie modele | Nieograniczona skalowalność; obsługa złożonych modeli i dużych zbiorów danych |

| Skalowalność | Skalowanie poziome na wielu urządzeniach | Skalowanie pionowe z infrastrukturą serwerową; centralne zarządzanie |

Systemy Edge AI składają się z czterech kluczowych komponentów technicznych, które wspólnie zapewniają inteligentne przetwarzanie na peryferiach sieci. Silnik inferencyjny wykonuje wytrenowane modele uczenia maszynowego na urządzeniach brzegowych, realizując predykcje i klasyfikacje bez konieczności połączenia z chmurą. Silniki te korzystają z zoptymalizowanych frameworków, takich jak TensorFlow Lite, ONNX Runtime czy PyTorch Mobile, które kompresują modele, by mieściły się w pamięci urządzeń, zachowując przy tym akceptowalną dokładność. Akceleratory sprzętowe—w tym GPU, TPU i wyspecjalizowane układy AI—dostarczają mocy obliczeniowej niezbędnej do efektywnego uruchamiania sieci neuronowych na urządzeniach o ograniczonych zasobach. Urządzenia brzegowe stosują techniki optymalizacji modeli, takie jak kwantyzacja, przycinanie i destylacja wiedzy, by zmniejszyć rozmiar modelu i wymagania obliczeniowe bez istotnej utraty wydajności. Warstwa zarządzania danymi odpowiada za lokalny zbiór danych, ich wstępne przetwarzanie oraz selektywne przesyłanie istotnych wniosków do systemów chmurowych w celu agregacji i długoterminowej analizy. Wreszcie moduł łączności zarządza przerywanymi połączeniami sieciowymi, umożliwiając urządzeniom pracę offline i synchronizację danych, gdy połączenie staje się dostępne.

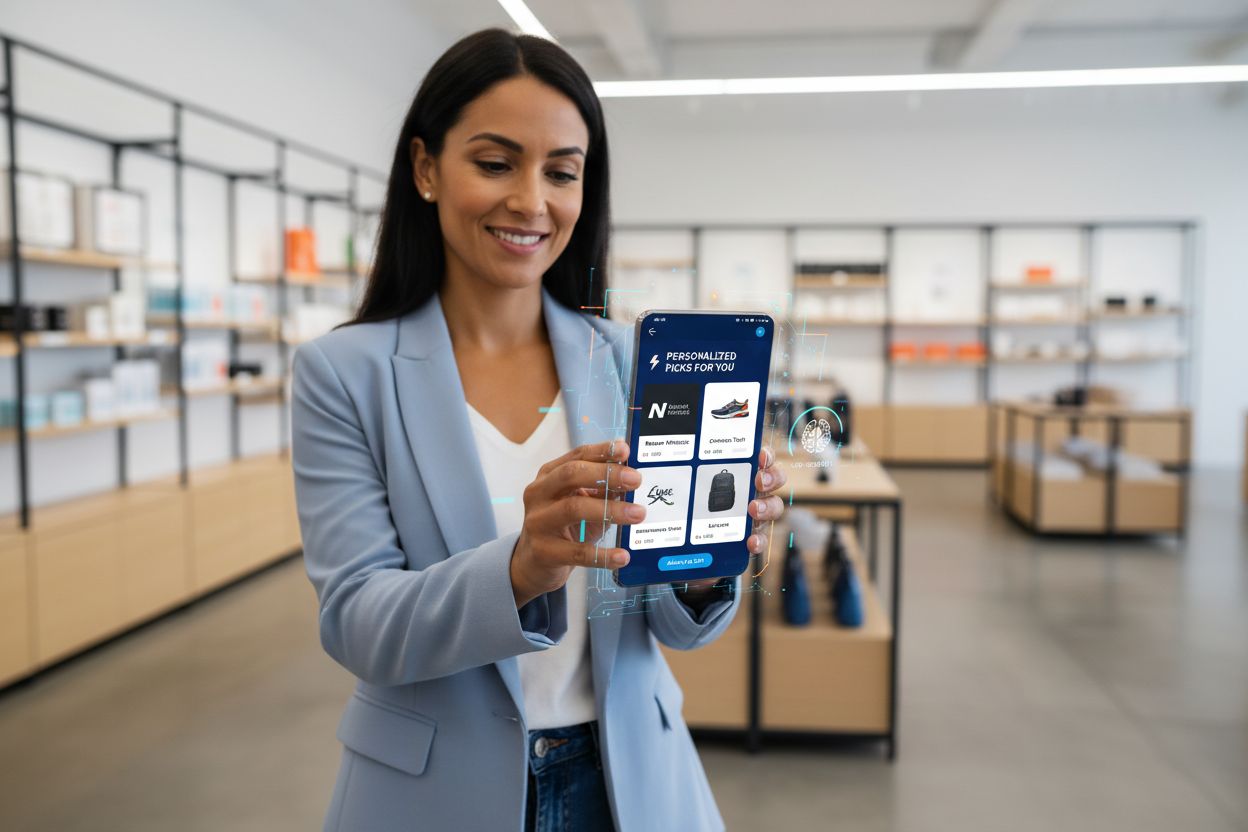

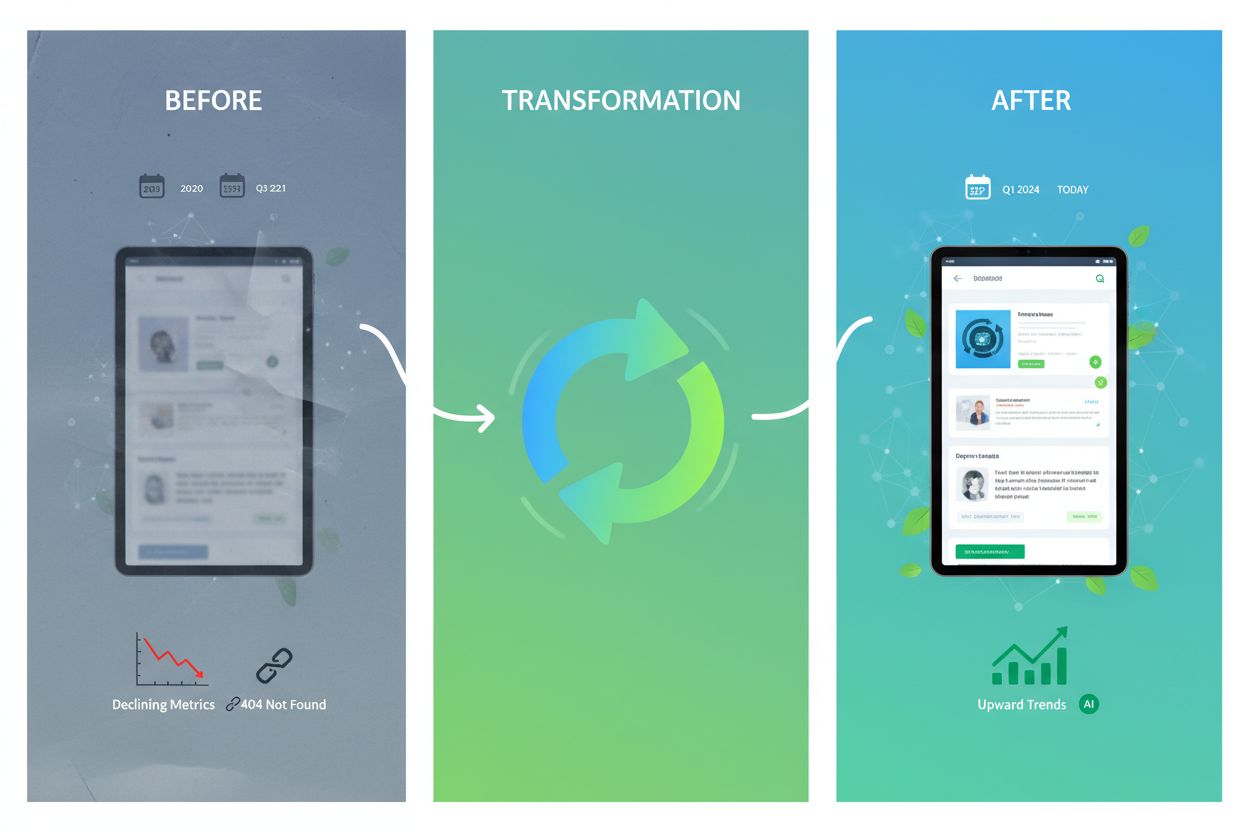

Przetwarzanie Edge AI umożliwia niespotykane dotąd możliwości w zakresie rekomendacji marki w czasie rzeczywistym oraz monitorowania wyników AI, bezpośrednio wspierając potrzebę śledzenia i weryfikacji decyzji AI już w punkcie ich wykonania. Aplikacje detaliczne wykorzystują edge AI do natychmiastowego dostarczania spersonalizowanych rekomendacji produktowych podczas przeglądania przez klientów, analizując wzorce zachowań lokalnie, bez przesyłania wrażliwych danych zakupowych na zewnętrzne serwery. Monitorowanie w czasie rzeczywistym wyników AI staje się możliwe, gdy wnioskowanie odbywa się na urządzeniach brzegowych, pozwalając organizacjom natychmiast wykrywać anomalie, tendencyjne predykcje czy dryf modeli, zanim rekomendacje trafią do odbiorców. Takie lokalne przetwarzanie generuje ślady audytowe i dzienniki decyzji wspierające wymogi zgodności oraz pozwala markom dokładnie zrozumieć, dlaczego wygenerowano konkretne rekomendacje. Systemy monitoringu edge AI mogą wychwytywać podejrzane wzorce—np. rekomendacje nadmiernie faworyzujące określone produkty lub grupy demograficzne—co umożliwia szybką interwencję i dostosowanie modeli. W kontekście bezpieczeństwa marki i zarządzania reputacją monitoring AI na brzegu zapewnia, że automatyczne systemy działają w określonych ramach i są zgodne z wartościami marki, zanim trafią do klientów. Możliwość monitorowania wyników AI w czasie rzeczywistym na brzegu zmienia sposób, w jaki organizacje utrzymują kontrolę jakości nad decyzjami algorytmicznymi, wspierając transparentność i budując zaufanie klientów dzięki możliwemu do weryfikacji zarządzaniu AI.

Przetwarzanie Edge AI zapewnia znaczące korzyści w wielu obszarach, odpowiadając na kluczowe wyzwania organizacyjne w nowoczesnych środowiskach cyfrowych. Zmniejszone opóźnienia to podstawowa zaleta, umożliwiająca aplikacje wymagające natychmiastowej reakcji—pojazdy autonomiczne podejmujące błyskawiczne decyzje nawigacyjne, roboty przemysłowe reagujące na zagrożenia bezpieczeństwa czy urządzenia medyczne wykrywające krytyczne stany pacjentów. Zwiększona prywatność to kolejna korzyść, gdyż wrażliwe dane pozostają na urządzeniach lokalnych, zamiast być przesyłane przez sieci czy przechowywane w scentralizowanej chmurze, co pozwala spełnić wymogi RODO, HIPAA i innych regulacji. Optymalizacja pasma zmniejsza przeciążenie sieci i związane z tym koszty poprzez lokalne przetwarzanie danych i przesyłanie wyłącznie istotnych wniosków zamiast surowych strumieni informacji. Funkcjonalność offline pozwala urządzeniom brzegowym podejmować inteligentne decyzje nawet przy braku połączenia z siecią, co jest kluczowe w odległych lokalizacjach i aplikacjach krytycznych. Większa niezawodność wynika z rozproszonego przetwarzania—awarie pojedynczych urządzeń nie wpływają na całą infrastrukturę, a lokalne przetwarzanie trwa niezależnie od dostępności usług chmurowych. Efektywność kosztowa pojawia się dzięki mniejszym wydatkom na usługi chmurowe, gdy organizacje przetwarzają dane lokalnie zamiast płacić za ciągłą infrastrukturę chmurową i transmisję danych. Skalowalność w edge AI objawia się w inny sposób niż w chmurze; systemy skalują się poziomo na rozproszonych urządzeniach, bez konieczności rozbudowy infrastruktury centralnej, co jest idealne dla wdrożeń IoT obejmujących tysiące urządzeń.

Przetwarzanie Edge AI przekształca działania w różnych branżach, umożliwiając inteligentne podejmowanie decyzji tam, gdzie powstają dane. Zakłady produkcyjne wdrażają edge AI do predykcyjnego utrzymania ruchu, analizując lokalnie wibracje i rozkład temperatury sprzętu, by przewidywać awarie zanim wystąpią, co zmniejsza przestoje i koszty napraw. Placówki medyczne wykorzystują edge AI w urządzeniach do obrazowania, które wykonują wstępną analizę lokalnie, umożliwiając szybszą diagnostykę i zapewniając ochronę prywatności pacjentów poprzez pozostawienie wrażliwych danych na miejscu. Sklepy detaliczne wdrażają edge AI do zarządzania zapasami, analizy zachowań klientów i natychmiastowego dostarczania spersonalizowanych rekomendacji bez opóźnień związanych z chmurą. Pojazdy autonomiczne całkowicie polegają na edge AI, przetwarzając dane z kamer, lidaru i radaru lokalnie, by podejmować decyzje dotyczące nawigacji i bezpieczeństwa w milisekundach. Systemy inteligentnych domów wykorzystują edge AI do rozpoznawania poleceń głosowych, wykrywania zagrożeń i automatyzacji codziennych czynności bez przesyłania dźwięku czy obrazu do chmury. Systemy bezpieczeństwa i monitoringu stosują edge AI do wykrywania anomalii, identyfikacji zagrożeń i generowania alarmów lokalnie, co pozwala ograniczyć fałszywe alarmy dzięki inteligentnej filtracji, zanim powiadomienia trafią do centrów monitoringu. Rolnictwo korzysta z edge AI na czujnikach IoT do monitorowania warunków gleby, pogody i stanu upraw, podejmując decyzje dotyczące nawadniania i nawożenia lokalnie oraz minimalizując koszty transmisji danych na terenach o ograniczonej łączności.

Pomimo licznych zalet, Przetwarzanie Edge AI wiąże się z istotnymi wyzwaniami technicznymi i operacyjnymi, które należy uwzględnić podczas wdrożenia. Zużycie energii to poważne ograniczenie, ponieważ uruchamianie sieci neuronowych na urządzeniach zasilanych bateryjnie szybko rozładowuje baterie, skracając czas pracy i wymagając starannej optymalizacji modeli dla równowagi między dokładnością a efektywnością. Ograniczenia obliczeniowe zawężają złożoność modeli możliwych do wdrożenia na urządzeniach brzegowych; organizacje muszą wybierać między uproszczonymi modelami o mniejszej dokładności a dłuższym czasem inferencji na sprzęcie o ograniczonych zasobach. Złożoność zarządzania modelami wzrasta w środowiskach rozproszonych, ponieważ aktualizowanie modeli na tysiącach urządzeń wymaga solidnego wersjonowania, możliwości cofania i mechanizmów zapewniających spójność w całej flocie. Heterogeniczność danych stanowi wyzwanie, gdy urządzenia brzegowe działają w różnych środowiskach o odmiennych charakterystykach danych, przez co modele wytrenowane na danych centralnych mogą gorzej działać na danych lokalnych. Trudności w debugowaniu i monitorowaniu wynikają z rozproszonego charakteru systemów edge, co utrudnia diagnozowanie awarii, zrozumienie zachowania modeli i zbieranie wszechstronnych metryk wydajności na urządzeniach rozmieszczonych geograficznie. Luki bezpieczeństwa na urządzeniach brzegowych zwiększają powierzchnię ataku—zainfekowane urządzenia mogą wykonywać złośliwy kod lub manipulować lokalnymi modelami, dlatego wymagane są solidne zabezpieczenia i regularne aktualizacje. Złożoność integracji z istniejącą infrastrukturą chmurową wymaga starannego planowania architektury, by systemy edge skutecznie współpracowały z centralnymi analitykami i pipeline’ami do trenowania modeli.

Przecięcie Przetwarzania Edge AI i monitorowania AI tworzy potężne możliwości dla organizacji pragnących zachować nadzór nad podejmowaniem decyzji algorytmicznych na dużą skalę. Tradycyjne podejścia do monitorowania AI napotykają trudności w środowiskach chmurowych, gdzie opóźnienia i koszty transmisji danych ograniczają bieżący wgląd w wyniki modeli; monitoring edge AI rozwiązuje ten problem, umożliwiając lokalną analizę predykcji przed ich wpływem na klientów. Systemy weryfikacji wyników wdrażane na urządzeniach brzegowych mogą natychmiast sprawdzać predykcje względem reguł biznesowych, wykrywać anomalie i oznaczać decyzje wymagające interwencji człowieka przed ich wykonaniem. Takie lokalne monitorowanie wspiera inicjatywy bezpieczeństwa marki, zapewniając zgodność rekomendacji AI, decyzji dotyczących treści i interakcji z klientami z wartościami organizacji i wymogami prawnymi. Systemy monitorujące na brzegu generują szczegółowe ślady audytowe dokumentujące, dlaczego podjęto konkretne decyzje, co wspiera przejrzystość i umożliwia późniejszą analizę zachowań algorytmów. Mechanizmy wykrywania biasu działające na brzegu mogą identyfikować, kiedy modele generują nieproporcjonalne wyniki wobec różnych grup demograficznych, umożliwiając szybką interwencję zanim tendencyjne rekomendacje trafią do klientów. Połączenie edge AI i monitoringu tworzy pętlę zwrotną, w której lokalne dzienniki decyzji informują o ponownym trenowaniu modeli, zapewniając ciągłe doskonalenie systemów przy jednoczesnym nadzorze nad ich działaniem. Organizacje wdrażające monitoring edge AI zyskują niespotykaną dotąd przejrzystość w zakresie podejmowania decyzji algorytmicznych, przekształcając AI z „czarnej skrzynki” w przejrzysty, audytowalny system wspierający zarówno optymalizację wydajności, jak i odpowiedzialne zarządzanie AI.

Przetwarzanie Edge AI stoi na czele ewolucji technologicznej, a nowe trendy zmieniają sposób wdrażania i zarządzania rozproszoną inteligencją w organizacjach. Uczenie federacyjne to przełomowe podejście, w którym urządzenia brzegowe wspólnie trenują modele bez przesyłania surowych danych na scentralizowane serwery, umożliwiając uczenie maszynowe z zachowaniem prywatności na dużą skalę. Rozwój sieci 5G znacząco przyspieszy adopcję edge AI, zapewniając niezawodną, niskolatencyjną łączność, która pozwala na płynną synchronizację między urządzeniami brzegowymi i infrastrukturą chmurową przy zachowaniu zalet lokalnego przetwarzania. Rozwój wyspecjalizowanego sprzętu trwa nadal, a producenci tworzą coraz wydajniejsze układy AI zoptymalizowane pod konkretne zastosowania brzegowe, poprawiając wskaźniki wydajności na wat, co jest kluczowe dla urządzeń bateryjnych. Prognozy rynkowe wskazują na gwałtowny wzrost—globalny rynek edge AI ma osiągnąć 15,7 miliarda dolarów do 2030 roku, rosnąc w tempie 38,3% rocznie od 2023 do 2030 roku. TinyML (uczenie maszynowe na mikrokontrolerach) staje się istotnym trendem, umożliwiając AI na urządzeniach o minimalnej pamięci i mocy obliczeniowej, rozszerzając zastosowania edge AI na dotąd niedostępne obszary. Konteneryzacja i technologie orkiestracji, takie jak Kubernetes, dostosowują się do środowisk brzegowych, pozwalając zarządzać rozproszonymi wdrożeniami edge tymi samymi narzędziami i procesami, co w chmurze. Konwergencja tych trendów sugeruje przyszłość, w której inteligentne przetwarzanie odbywa się płynnie w rozproszonych sieciach—urządzenia brzegowe realizują decyzje w czasie rzeczywistym, a systemy chmurowe odpowiadają za trenowanie, agregację i długoterminową analitykę.

Skuteczne wdrożenie Przetwarzania Edge AI wymaga starannego planowania na wielu płaszczyznach, aby zapewnić oczekiwaną wydajność i wartość biznesową. Wybór modelu to pierwszy kluczowy krok—organizacje muszą ocenić dostępne modele wytrenowane, ich dokładność w konkretnych zastosowaniach oraz określić, czy konieczne jest tworzenie własnych modeli. Strategie optymalizacji muszą równoważyć dokładność modelu względem ograniczeń urządzeń, wykorzystując kwantyzację, przycinanie i wyszukiwanie architektury, by dostosować modele do sprzętu przy zachowaniu wydajności. Wybór sprzętu zależy od wymagań aplikacji, potrzeb obliczeniowych i ograniczeń energetycznych; należy rozważyć zarówno procesory ogólnego przeznaczenia, jak i specjalizowane akceleratory AI. Mechanizmy wdrożeniowe powinny obejmować solidne procesy dystrybucji modeli na urządzenia, zarządzania wersjami oraz możliwość szybkiego wycofania wersji w razie problemów. Systemy monitoringu i obserwowalności muszą śledzić wydajność modeli, wykrywać dryf danych, identyfikować anomalie i generować alerty przy odchyleniach od oczekiwanego działania. Wzmocnienie bezpieczeństwa chroni urządzenia brzegowe przed nieautoryzowanym dostępem, kradzieżą modeli i manipulacją poprzez szyfrowanie, uwierzytelnianie i regularne aktualizacje. Planowanie integracji zapewnia skuteczną komunikację systemów edge z infrastrukturą chmurową w zakresie aktualizacji modeli, analiz i długoterminowego przechowywania danych, tworząc spójną architekturę hybrydową, która wykorzystuje zalety obu podejść. Organizacje wdrażające edge AI powinny zdefiniować jasne wskaźniki sukcesu, rozpocząć pilotażowo na ograniczoną skalę przed pełnym wdrożeniem i zachować elastyczność w dostosowywaniu strategii na podstawie rzeczywistych danych o wydajności.

Edge AI przetwarza dane lokalnie na urządzeniach, zapewniając natychmiastowe czasy reakcji (opóźnienia poniżej milisekundy), podczas gdy Cloud AI wysyła dane do zdalnych serwerów, co wprowadza opóźnienia sieciowe. Edge AI stawia na szybkość i prywatność, a Cloud AI oferuje nieograniczoną moc obliczeniową do złożonych zadań.

Edge AI utrzymuje wrażliwe dane na urządzeniach lokalnych, zamiast przesyłać je przez sieci lub przechowywać w scentralizowanych serwerach chmurowych. To podejście zmniejsza ryzyko wycieku danych, wspiera zgodność z RODO i HIPAA oraz zapewnia, że dane osobowe pozostają pod kontrolą organizacji.

Edge AI osiąga czasy reakcji poniżej milisekundy poprzez lokalne przetwarzanie danych, w porównaniu do 50-500 ms lub więcej w systemach chmurowych. Tak znaczne zmniejszenie opóźnień umożliwia zastosowania w czasie rzeczywistym, takie jak pojazdy autonomiczne, robotyka przemysłowa czy urządzenia medyczne wymagające natychmiastowych decyzji.

Tak, systemy Edge AI mogą działać całkowicie offline, ponieważ przetwarzanie odbywa się lokalnie na urządzeniach. Funkcja offline jest kluczowa w lokalizacjach o słabym dostępie do sieci oraz w zastosowaniach krytycznych, gdzie awarie sieci nie mogą przerwać działania.

Edge AI działa na różnorodnych urządzeniach, takich jak smartfony, czujniki IoT, sprzęt przemysłowy, kamery do monitoringu, smartwatche, pojazdy autonomiczne i systemy wbudowane. Współczesne urządzenia brzegowe obejmują zarówno mikrokontrolery z minimalnymi zasobami, jak i wydajne komputery jednopłytkowe ze specjalizowanymi akceleratorami AI.

Edge AI przetwarza dane lokalnie i przesyła jedynie istotne wnioski, a nie surowe strumienie informacji. Tak selektywna transmisja znacząco zmniejsza zużycie pasma, obniża koszty sieciowe i poprawia wydajność systemów przez minimalizowanie przesyłania danych przez sieć.

Edge AI umożliwia monitorowanie w czasie rzeczywistym rekomendacji i decyzji generowanych przez AI w punkcie ich wykonania, pozwalając organizacjom natychmiast wykrywać anomalie, weryfikować bezpieczeństwo marki i zapewnić zgodność wyników algorytmów z wartościami organizacji, zanim dotrą one do klientów.

Kluczowe wyzwania to zużycie energii w urządzeniach zasilanych bateryjnie, ograniczenia obliczeniowe wymagające optymalizacji modeli, złożoność zarządzania systemami rozproszonymi, podatności na ataki w urządzeniach brzegowych oraz trudności integracji z istniejącą infrastrukturą chmurową.

Przetwarzanie Edge AI umożliwia natychmiastową analizę wyników AI i cytowań marki. AmICited śledzi, jak Twoja marka pojawia się w treściach generowanych przez AI w GPT, Perplexity oraz Google AI Overviews z precyzją w czasie rzeczywistym.

Edge SEO to praktyka wdrażania technicznych zmian SEO na krawędzi sieci przy użyciu funkcji serverless na CDN. Dowiedz się, jak poprawia wydajność, umożliwia sz...

Dowiedz się, jak systematycznie odświeżać i optymalizować treści pod kątem wyszukiwarek AI. Poznaj strategie zwiększania cytowań przez AI, utrzymania autorytetu...

Dowiedz się, czym jest RAG (Retrieval-Augmented Generation) w wyszukiwaniu AI. Odkryj, jak RAG zwiększa dokładność, ogranicza halucynacje i napędza ChatGPT, Per...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.