Cloaking

Cloaking to technika czarnego SEO polegająca na prezentowaniu innych treści wyszukiwarkom niż użytkownikom. Dowiedz się, jak działa, jakie niesie ryzyko, jak wy...

Ukryty tekst odnosi się do tekstu lub linków na stronie internetowej, które są niewidoczne dla użytkowników, ale czytelne dla robotów wyszukiwarek i systemów AI. Technika ta jest zazwyczaj wykorzystywana do manipulowania pozycjami w wynikach wyszukiwania i uznawana jest za praktykę black-hat SEO, która narusza wytyczne wyszukiwarek.

Ukryty tekst odnosi się do tekstu lub linków na stronie internetowej, które są niewidoczne dla użytkowników, ale czytelne dla robotów wyszukiwarek i systemów AI. Technika ta jest zazwyczaj wykorzystywana do manipulowania pozycjami w wynikach wyszukiwania i uznawana jest za praktykę black-hat SEO, która narusza wytyczne wyszukiwarek.

Ukryty tekst to treść umieszczona na stronie internetowej, która jest niewidoczna lub niedostępna dla użytkowników, ale pozostaje czytelna dla robotów wyszukiwarek i systemów AI. Technika ta polega na wykorzystaniu różnych metod HTML i CSS do ukrywania tekstu przed wizualnym wyświetleniem na stronie, przy jednoczesnym pozostawieniu go w kodzie źródłowym. Google definiuje ukryty tekst jako “tekst lub linki w Twoich treściach używane do manipulacji rankingami wyszukiwania Google, które mogą być uznane za wprowadzające w błąd.” Główna różnica między legalną ukrytą treścią a spamem leży w intencji: ukryty tekst służący manipulacji rankingami narusza wytyczne wyszukiwarek, natomiast ukryta treść mająca na celu poprawę doświadczenia użytkownika lub dostępności jest akceptowalna. Ukryty tekst pozostaje wyzwaniem dla SEO od początku lat 2000, gdy algorytmy wyszukiwarek były mniej zaawansowane i łatwiej było oszukać systemy rankingowe. Dziś, dzięki zaawansowanym technologiom crawlowania i systemom wykrywania opartym na AI, ukryty tekst jest jedną z najłatwiej rozpoznawalnych i najsurowiej karanych praktyk black-hat SEO.

Praktyka ukrywania tekstu pojawiła się na wczesnym etapie rozwoju SEO, kiedy algorytmy rankingowe Google opierały się głównie na zagęszczeniu słów kluczowych i analizie tekstu na stronie. Webmasterzy odkryli, że mogą sztucznie podbijać trafność słów kluczowych, umieszczając ukryty tekst, który był indeksowany przez wyszukiwarki, lecz niewidoczny dla użytkowników. Do typowych implementacji należały: biały tekst na białym tle, tekst pozycjonowany daleko poza ekran przy użyciu ujemnych wartości CSS oraz tekst o zerowym rozmiarze czcionki. Technika ta była szczególnie rozpowszechniona w latach 2000-2005, zanim Google wdrożyło zaawansowane systemy wykrywania spamu. Praktyka stała się tak powszechna, że szacuje się, iż około 15-20% stron internetowych w połowie lat 2000 stosowało jakąś formę ukrywania tekstu, choć odsetek ten znacząco spadł wraz z zaostrzeniem kar i poprawą wykrywania.

Reakcja Google na nadużycia związane z ukrytym tekstem była szybka i kompleksowa. Wyszukiwarka zaczęła nakładać ręczne kary na strony stosujące ukryty tekst, a w 2008 roku zautomatyzowane systemy były już w stanie wykryć większość powszechnych technik ukrywania. Wprowadzenie indeksowania mobile-first w 2018 roku faktycznie zmieniło podejście do ukrytej treści, ponieważ Google uznało, że niektóre ukryte treści—takie jak rozwijane menu i sekcje—rzeczywiście poprawiają doświadczenie użytkownika na urządzeniach mobilnych. Rozróżnienie między oszukańczym ukrytym tekstem a legalną ukrytą treścią zostało sformalizowane w wytycznych Google, co dało webmasterom jasne ramy do zrozumienia, co jest, a co nie jest akceptowalne.

Biały tekst na białym tle to najbardziej znana technika ukrywania tekstu, choć obecnie wyszukiwarki wykrywają ją bez trudu. Metoda polega na ustawieniu koloru tekstu na biały (#FFFFFF) na białym tle, co czyni go niewidocznym dla użytkowników, lecz obecnym w HTML. Techniki pozycjonowania CSS wykorzystują ujemne wartości dla właściwości takich jak text-indent: -9999px, by przenieść tekst daleko poza widoczny obszar strony, zachowując go w DOM, lecz niewidocznego. Manipulacja rozmiarem czcionki polega na ustawieniu font-size: 0 lub bardzo małych wartości, np. font-size: 1px, przez co tekst jest nieczytelny, ale technicznie obecny na stronie.

Właściwości przezroczystości i widoczności wykorzystują reguły CSS takie jak opacity: 0 lub visibility: hidden, by uczynić tekst niewidocznym, przy jednoczesnym zachowaniu go w strukturze dokumentu. Tekst ukryty za obrazami polega na umieszczeniu tekstu pod elementami graficznymi przy użyciu warstwowania z-index, co czyni go niewidocznym dla użytkownika, ale dostępnym dla robotów. Nadużywanie tagu NoScript polega na wypełnianiu <noscript> tekstem nasyconym słowami kluczowymi, który może być zaindeksowany przez wyszukiwarki, gdy JavaScript jest wyłączony. Upychanie słów kluczowych w ukrytych elementach łączy techniki ukrywania tekstu z nadmiernym powtarzaniem fraz, tworząc strony, które są normalne dla użytkownika, ale zawierają nienaturalne nagromadzenie słów kluczowych w ukrytych sekcjach.

Nowoczesne implementacje są bardziej wyrafinowane, wykorzystując JavaScript do dynamicznego ukrywania i pokazywania treści w zależności od wykrytego user-agenta, serwując inną treść robotom wyszukiwarek niż użytkownikom. Niektóre strony używają ukrytych divów wywoływanych określonymi interakcjami użytkownika, próbując ukryć treść podczas początkowego ładowania, ale pozostawić ją dostępną dla robotów. Te zaawansowane techniki są obecnie wprost zabronione przez politykę cloakingu Google i są wykrywane przez renderowanie w przeglądarkach headless, które symulują zachowanie użytkownika.

| Aspekt | Ukryty tekst Black-Hat (Spam) | Legalna ukryta treść White-Hat | Perspektywa robota AI |

|---|---|---|---|

| Intencja | Manipulacja rankingami przez oszustwo | Poprawa doświadczenia i dostępności | Wykrywalne przez analizę intencji |

| Korzyść dla użytkownika | Brak; treść nie służy użytkownikowi | Poprawa nawigacji, redukcja bałaganu, ułatwienia dostępności | Roboty oceniają faktyczną wartość dla użytkownika |

| Typowe przykłady | Biały tekst na białym, upychanie słów kluczowych, tekst poza ekranem | Akordeony, zakładki, rozwijane menu, tekst dla czytników ekranu | Oba typy są crawlowane, ale oceniane inaczej |

| Traktowanie przez wyszukiwarki | Kary ręczne, spadki pozycji, potencjalne usunięcie z indeksu | Indeksowane normalnie, mogą mieć niższą wagę | Systemy AI indeksują oba, ale priorytet mają widoczne treści |

| Metoda wykrywania | Analiza kolorów, inspekcja CSS, porównanie renderingu | Analiza interakcji użytkownika, przegląd znaczników dostępności | Renderowanie w headless browserach i analiza DOM |

| Czas odzyskiwania | Od kilku tygodni do miesięcy po złożeniu wniosku | Nie dotyczy; brak naruszenia | Natychmiastowe po poprawkach ponowne crawlowanie |

| Wpływ mobile-first | Karane we wszystkich metodach indeksowania | Często nagradzane za poprawę UX mobilnego | Mobilne renderowanie jako główna metoda oceny |

| Zgodność z dostępnością | Narusza wytyczne WCAG | Zgodne ze standardami dostępności | Kompatybilność z czytnikami ekranu jest weryfikowana |

Roboty wyszukiwarek działają w kilku trybach renderowania, by wykrywać ukryty tekst. Pierwszy tryb to analiza surowego HTML, gdzie roboty sprawdzają kod źródłowy i identyfikują tekst obecny w DOM niezależnie od stylów CSS. Drugi tryb to analiza renderowanej strony, gdzie roboty korzystają z przeglądarek headless, takich jak Chromium, by renderować stronę tak, jak widzi ją użytkownik, a następnie porównują efekt renderowania z surowym HTML. Znaczne rozbieżności między tymi wersjami uruchamiają algorytmy wykrywające ukryty tekst.

System wykrywania Google analizuje wiele sygnałów, by zidentyfikować ukryty tekst: współczynniki kontrastu kolorów między tekstem a tłem, właściwości CSS ukrywające elementy, wartości rozmiaru czcionki poniżej progu czytelności oraz pozycjonowanie przenoszące treść poza ekran. System ocenia także zagęszczenie słów kluczowych i sens semantyczny, flagując strony, gdzie ukryty tekst zawiera słowa kluczowe niepowiązane z widoczną treścią lub gdzie zagęszczenie fraz w ukrytych sekcjach znacząco przewyższa to w części widocznej. Modele uczenia maszynowego wytrenowane na milionach stron potrafią dziś wykryć subtelne techniki ukrywania tekstu, których proste systemy regułowe by nie zauważyły.

Roboty AI, takie jak GPTBot, ClaudeBot i PerplexityBot, stosują podobne mechanizmy wykrywania, renderując strony w headless browserach i analizując relacje między widoczną a ukrytą treścią. Systemy te są szczególnie zaawansowane, ponieważ muszą rozumieć intencję i sens semantyczny treści, nie tylko techniczną implementację. Strona z legalną ukrytą treścią (np. akordeonem) będzie miała spójność semantyczną między widocznymi i ukrytymi sekcjami, podczas gdy strona ze spamem ukrytym tekstem—znaczące różnice tematyczne lub w zagęszczeniu słów kluczowych.

Google nakłada ręczne działania za naruszenia związane z ukrytym tekstem, które pojawiają się w raporcie Działania ręczne w Google Search Console. Strony objęte tą karą odnotowują spadki pozycji o 50-90% dla dotkniętych stron, a niektóre tracą całkowicie widoczność w wynikach wyszukiwania. Kara może obejmować całą witrynę lub tylko wybrane strony, w zależności od skali i powszechności ukrytego tekstu. Odzyskanie pozycji wymaga całkowitego usunięcia ukrytego tekstu, potwierdzenia zgodności witryny z wytycznymi i złożenia wniosku o ponowne rozpatrzenie w Search Console.

Proces rozpatrywania trwa zwykle 2-4 tygodnie przy pierwszej ocenie, choć w bardziej złożonych przypadkach może być dłuższy. Zespół Google ręcznie sprawdza stronę, by upewnić się, że cały ukryty tekst został usunięty i strona jest zgodna z polityką. Około 60-70% wniosków o ponowne rozpatrzenie jest początkowo odrzucanych, co zmusza webmasterów do dalszych poprawek i ponownej wysyłki. Nawet po pozytywnym rozpatrzeniu, strony mogą podlegać “karze zaufania”, przez co pozycje wracają powoli przez kilka miesięcy, podczas gdy algorytmy Google odbudowują zaufanie do zgodności witryny z wytycznymi.

Inne wyszukiwarki i systemy AI stosują podobne kary. Bing posiada własne systemy wykrywania spamu identyfikujące ukryty tekst, a wyszukiwarki AI, takie jak Perplexity czy Claude, mogą obniżać priorytet lub wykluczać treści z witryn znanych z używania technik ukrywania. Kumulatywny efekt tych kar może zrujnować ruch organiczny strony, co czyni ukryty tekst jedną z najkosztowniejszych pomyłek w SEO.

Interfejsy akordeonowe i zakładki to obecnie standardowe wzorce projektowe, które poprawiają doświadczenie użytkownika, organizując złożone informacje w rozwijane sekcje. Elementy te domyślnie ukrywają treść, ale odsłaniają ją po interakcji użytkownika, zmniejszając obciążenie poznawcze i bałagan na stronie. Google wprost wspiera te wzorce, jeśli są wdrożone z użyciem semantycznego HTML i atrybutów dostępności. Kluczowe jest, by ukryta treść była semantycznie powiązana z treścią widoczną i służyła rzeczywistej organizacji informacji.

Rozwijane menu nawigacyjne ukrywają dodatkowe opcje do czasu, aż użytkownik najedzie kursorem lub kliknie główny element menu. Ten wzorzec jest niemal uniwersalny we współczesnym web designie i w pełni wspierany przez wyszukiwarki. Projektowanie responsywne mobile-first często opiera się na ukrytej treści, gdzie nawigacja desktopowa jest ukrywana na urządzeniach mobilnych i zastępowana menu hamburgerowymi lub innymi rozwiązaniami mobilnymi. Indeksowanie mobile-first przez Google nagradza efektywne wdrożenie tych wzorców, ponieważ pokazuje troskę o doświadczenie użytkownika mobilnego.

Tekst dla czytników ekranu i funkcje dostępności celowo ukrywają treść przed widzącymi użytkownikami, ale udostępniają ją osobom z niepełnosprawnościami wzroku. Obejmuje to linki do pomijania nawigacji, opisy alternatywne do obrazów i rozbudowane etykiety formularzy, które zapewniają kontekst technologiom asystującym. Takie wdrożenia są nie tylko akceptowalne, ale wymagane przez standardy WCAG. Wyszukiwarki rozpoznają i wspierają te wzorce, ponieważ służą rzeczywistej dostępności.

Rozwijane sekcje z treścią, takie jak przyciski “Czytaj więcej”, skracanie recenzji produktów i akordeony FAQ, to legalne zastosowania ukrytej treści. Wzorce te poprawiają wydajność strony, zmniejszając początkowy rozmiar ładowanej treści przy jednoczesnym zachowaniu jej dostępności. Wyszukiwarki indeksują całą treść, nawet jeśli jest ona początkowo ukryta za interakcją, zapewniając jej uwzględnienie w rankingach.

Pojawienie się wyszukiwarek opartych na AI, takich jak ChatGPT, Perplexity, Google AI Overviews i Claude, stworzyło nowe wyzwania i możliwości związane z ukrytym tekstem. Systemy te crawlują i indeksują strony internetowe na potrzeby trenowania modeli i generowania odpowiedzi, zmagając się z tymi samymi problemami ukrytego tekstu, co tradycyjne wyszukiwarki. Roboty AI są szczególnie zaawansowane w wykrywaniu ukrytego tekstu, ponieważ renderują strony na różne sposoby i analizują semantykę treści, by zrozumieć intencje.

Dla platform monitorujących marki, takich jak AmICited, ukryty tekst stanowi szczególne wyzwanie. Gdy strony używają ukrytego tekstu zawierającego wzmianki o marce, mogą one zostać zaindeksowane przez roboty AI, ale pozostać niewidoczne dla użytkownika. To prowadzi do rozbieżności między tym, co pojawia się w odpowiedziach AI, a tym, co widzi użytkownik na stronie źródłowej. Systemy monitorujące AmICited muszą uwzględniać zarówno widoczną, jak i ukrytą treść, by dostarczać dokładne metryki dotyczące obecności marki w wyszukiwarkach AI. Platforma śledzi nie tylko to, czy marka została wspomniana, ale także kontekst i widoczność tych wzmianek, pomagając klientom zrozumieć ich pełny cyfrowy ślad w odpowiedziach generowanych przez AI.

Ukryty tekst może sztucznie zawyżać liczbę wzmianek o marce w wynikach AI, jeśli strony zawierają ukryte słowa kluczowe związane z marką. Powoduje to fałszywe wrażenie widoczności marki i może zakłócić analizę rynku. Z drugiej strony, legalna ukryta treść, taka jak akordeony FAQ zawierające informacje o marce, powinna być prawidłowo indeksowana i prezentowana w odpowiedziach AI, ponieważ dostarcza rzeczywistej wartości użytkownikom. Rozróżnienie tych scenariuszy jest kluczowe dla prawidłowego monitorowania marki i analizy konkurencji.

Zaawansowanie systemów wykrywania ukrytego tekstu stale rośnie, ponieważ wyszukiwarki i systemy AI inwestują w coraz potężniejsze technologie renderowania i analizy. Modele uczenia maszynowego coraz lepiej rozumieją intencję treści, przez co niemal niemożliwe staje się ukrycie manipulacyjnego tekstu przed systemami wykrywania. Przyszłe algorytmy będą prawdopodobnie uwzględniać analizę zachowań użytkowników, badając wzorce interakcji, by wykrywać strony, gdzie ukryta treść nie służy żadnemu rzeczywistemu zaangażowaniu użytkowników.

Technologie blockchain i transparentności mogą w przyszłości odegrać rolę w weryfikacji treści, umożliwiając użytkownikom i wyszukiwarkom potwierdzenie, że zawartość strony nie została zmanipulowana ani ukryta. Regulacje dotyczące AI i wyszukiwania mogą z czasem wymagać jawnego ujawniania ukrytej treści, podobnie jak obecnie obowiązują wytyczne dotyczące oznaczania reklam. Wzrost znaczenia danych zero-party oraz mechanizmów świadomej zgody użytkownika może zmienić odbiór ukrytej treści, umożliwiając użytkownikom aktywne decydowanie o jej ujawnieniu lub ukryciu.

Wyszukiwarki AI prawdopodobnie będą jeszcze bardziej zdecydowane w karaniu ukrytego tekstu, rywalizując o najbardziej wiarygodne i przejrzyste wyniki. Integracja mechanizmów feedbacku od użytkowników do systemów wyszukiwania AI może pozwolić na zgłaszanie ukrytego tekstu i manipulacyjnych treści, tworząc warstwę crowdsourcingowego wykrywania ponad automatycznymi algorytmami. Przyszłość SEO będzie coraz mniej techniczna, a coraz bardziej oparta na jakości treści, optymalizacji doświadczenia użytkownika i transparentnej komunikacji między stronami a systemami wyszukiwania.

Dla platform monitorujących, takich jak AmICited, ewolucja wykrywania ukrytego tekstu oznacza coraz dokładniejsze śledzenie wzmianek o marce w systemach AI. Wraz z rozwojem robotów AI, różnica między legalną a manipulacyjną ukrytą treścią będzie coraz wyraźniejsza, umożliwiając precyzyjniejsze monitorowanie marki i analizę konkurencyjną. Organizacje stawiające na transparentność i strategię skoncentrowaną na użytkowniku zyskają lepszą widoczność zarówno w tradycyjnych, jak i opartych na AI wynikach wyszukiwania.

Do najpopularniejszych technik ukrywania tekstu należą: biały tekst na białym tle, pozycjonowanie CSS przenoszące tekst poza ekran przy użyciu ujemnych wartości text-indent, ustawianie rozmiaru czcionki na zero, ukrywanie tekstu za obrazami oraz stosowanie zerowej przezroczystości. Metody te były szczególnie powszechne na początku lat 2000, gdy algorytmy wyszukiwarek były mniej zaawansowane. Współczesne wyszukiwarki, takie jak Google, Perplexity czy Claude, potrafią teraz wykryć te techniki dzięki zaawansowanym możliwościom crawlowania i renderowania, przez co są one nieskuteczne i ryzykowne dla SEO.

Wyszukiwarki wykrywają ukryty tekst poprzez analizę HTML i CSS stron internetowych, aby znaleźć rozbieżności między tym, co widzi użytkownik, a tym, do czego mają dostęp roboty. Sprawdzają wartości kolorów, właściwości CSS takie jak display:none i visibility:hidden, rozmiary czcionek oraz atrybuty pozycjonowania. Roboty AI takie jak GPTBot i ClaudeBot stosują podobne metody, renderując strony jak użytkownik i porównując efekt renderowania z kodem źródłowym HTML. Narzędzie Inspekcja adresu URL w Google Search Console pomaga również webmasterom wykrywać naruszenia związane z ukrytym tekstem na własnych stronach.

Strony przyłapane na używaniu ukrytego tekstu w celu manipulacji rankingami podlegają poważnym karom, w tym ręcznym działaniom ze strony Google, znacznym spadkom pozycji, całkowitemu usunięciu z wyników wyszukiwania oraz wykluczeniu ze specjalnych funkcji wyszukiwania, takich jak Google News czy Discover. Kary te mogą obejmować całą witrynę lub konkretne strony, w zależności od skali naruszenia. Odzyskanie pozycji wymaga złożenia wniosku o ponowne rozpatrzenie po usunięciu całego ukrytego tekstu i wykazaniu zgodności z wytycznymi wyszukiwarek. Proces ten może trwać tygodnie lub miesiące, podczas których ruch i widoczność strony są poważnie ograniczone.

Nie, nie każda ukryta treść narusza wytyczne wyszukiwarek. Przykłady white-hat ukrytej treści obejmują menu akordeonowe, interfejsy z zakładkami, rozwijane nawigacje oraz treści ujawniane po interakcji użytkownika, które poprawiają doświadczenie użytkownika. Tekst dla czytników ekranu w celach dostępności jest również akceptowalny. Kluczowe jest tu zamierzenie: jeśli ukryta treść służy manipulacji rankingami, a nie poprawie użyteczności lub dostępności, narusza politykę wyszukiwarek. Google w ramach indeksowania mobile-first wręcz wspiera ukrytą treść, jeśli poprawia ona użyteczność i nawigację na urządzeniach mobilnych.

Ukryty tekst stanowi wyzwanie dla platform monitorujących AI, które śledzą wzmianki o marce w systemach AI, takich jak ChatGPT, Perplexity czy Claude. Jeśli strony używają ukrytego tekstu zawierającego odniesienia do marki, wzmianki te mogą być zaindeksowane przez roboty AI, ale niewidoczne dla użytkowników, co prowadzi do rozbieżności w danych monitorujących. Systemy śledzące AmICited muszą uwzględniać zarówno widoczną, jak i ukrytą treść, aby dostarczać precyzyjne metryki obecności marki w wyszukiwarkach AI, zapewniając klientom pełny obraz ich cyfrowego śladu w odpowiedziach generowanych przez AI.

Legalne zastosowania ukrytej treści obejmują poprawę doświadczenia mobilnego użytkownika dzięki rozwijanym menu i akordeonom, dostarczanie informacji uzupełniających poprzez sekcje rozwijane, wdrażanie funkcji dostępności dla czytników ekranu oraz organizowanie złożonych informacji o produktach za pomocą zakładek. Sklepy internetowe często ukrywają szczegółowe specyfikacje i recenzje za rozwijanymi sekcjami, aby ograniczyć bałagan na stronie. Serwisy newsowe używają ukrytej treści do skrótowych podglądów artykułów z funkcją 'czytaj więcej'. Takie implementacje nie naruszają wytycznych, ponieważ służą rzeczywistym celom użytkowym, a nie manipulacji rankingami.

Wykrywanie ukrytego tekstu przeszło od prostego dopasowywania wzorców do zaawansowanych modeli uczenia maszynowego, które rozumieją sposób renderowania stron, wzorce interakcji użytkownika i intencję treści. Nowoczesne systemy renderują strony w przeglądarkach headless, widząc dokładnie to, co użytkownik, po czym porównują ten efekt z kodem HTML i CSS. Systemy AI potrafią teraz wykrywać subtelne różnice w kolorze tekstu, przezroczystości i pozycjonowaniu, których starsze algorytmy nie wychwytywały. Ponadto przetwarzanie języka naturalnego pomaga wykrywać upychanie słów kluczowych i nienaturalne wzorce tekstu, co utrudnia ukrywanie treści przed systemami detekcji.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Cloaking to technika czarnego SEO polegająca na prezentowaniu innych treści wyszukiwarkom niż użytkownikom. Dowiedz się, jak działa, jakie niesie ryzyko, jak wy...

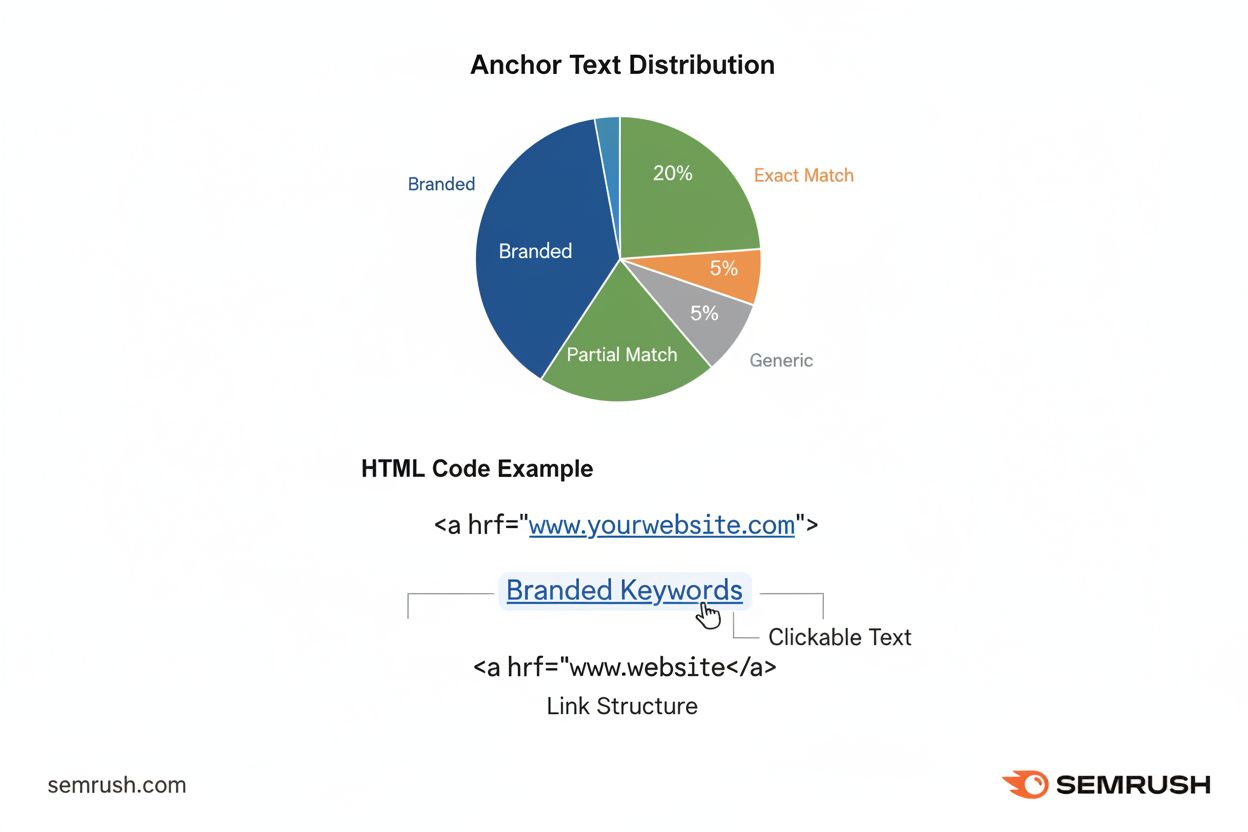

Tekst zakotwiczenia to klikalny tekst w hiperłączach, który pomaga wyszukiwarkom zrozumieć trafność strony i poprawia nawigację użytkownika. Poznaj typy, najlep...

Dowiedz się, jak ukryte crawlery omijają dyrektywy robots.txt, jakie mechanizmy techniczne stoją za obchodzeniem zabezpieczeń przez crawlery oraz poznaj rozwiąz...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.