Content SEO

Content SEO to strategiczne tworzenie i optymalizacja wysokiej jakości treści w celu poprawy pozycji w wyszukiwarkach i widoczności organicznej. Dowiedz się, ja...

JavaScript SEO to proces optymalizacji stron renderowanych przez JavaScript w celu zapewnienia, że wyszukiwarki mogą skutecznie indeksować, renderować i analizować treści. Obejmuje najlepsze praktyki, które sprawiają, że aplikacje internetowe oparte na JavaScript są wykrywalne i mogą osiągać wysokie pozycje w wynikach wyszukiwania, przy jednoczesnym zachowaniu wysokiej wydajności i dobrego doświadczenia użytkownika.

JavaScript SEO to proces optymalizacji stron renderowanych przez JavaScript w celu zapewnienia, że wyszukiwarki mogą skutecznie indeksować, renderować i analizować treści. Obejmuje najlepsze praktyki, które sprawiają, że aplikacje internetowe oparte na JavaScript są wykrywalne i mogą osiągać wysokie pozycje w wynikach wyszukiwania, przy jednoczesnym zachowaniu wysokiej wydajności i dobrego doświadczenia użytkownika.

JavaScript SEO to wyspecjalizowana praktyka optymalizacji stron renderowanych przez JavaScript w celu zapewnienia, że wyszukiwarki mogą skutecznie crawlowac, renderować i indeksować treści. Obejmuje kompleksowy zestaw strategii technicznych, najlepszych praktyk i metod wdrożeniowych, które zapewniają, że aplikacje internetowe oparte na JavaScript są w pełni wykrywalne i mogą osiągać wysokie pozycje w wynikach wyszukiwania. W przeciwieństwie do tradycyjnych stron HTML, gdzie treść jest natychmiast dostępna w odpowiedzi serwera, treść renderowana przez JavaScript wymaga dodatkowych kroków przetwarzania, które mogą znacząco wpłynąć na sposób, w jaki wyszukiwarki rozumieją i pozycjonują Twoje strony. Dyscyplina ta łączy wiedzę z zakresu technicznego SEO z rozumieniem, jak nowoczesne frameworki webowe, takie jak React, Vue i Angular, współpracują z crawlerami wyszukiwarek. JavaScript SEO stało się niezwykle istotne, ponieważ 98,7% stron internetowych zawiera obecnie elementy JavaScript, co sprawia, że jest to niezbędna wiedza dla każdego specjalisty SEO pracującego z nowoczesnymi technologiami webowymi.

Wzrost popularności frameworków JavaScript zasadniczo zmienił sposób budowania stron internetowych oraz sposób ich przetwarzania przez wyszukiwarki. Na początku działania internetu Googlebot po prostu analizował odpowiedzi HTML z serwerów, co sprawiało, że SEO było proste — treści obecne w HTML były indeksowane. Jednak wraz z wprowadzeniem renderowania po stronie klienta w celu stworzenia bardziej interaktywnych i dynamicznych doświadczeń dla użytkowników, wyszukiwarki stanęły przed poważnym wyzwaniem: treść przestała być obecna w początkowej odpowiedzi HTML, a zaczęła być generowana dopiero przez JavaScript w przeglądarce. Ta zmiana spowodowała powstanie znaczącej luki między tym, co widzieli użytkownicy, a tym, co początkowo mogły zobaczyć wyszukiwarki. Google odpowiedziało, rozwijając możliwości renderowania headless Chromium, co umożliwiło Googlebotowi wykonywanie JavaScript i przetwarzanie renderowanego DOM. Jednak ten proces renderowania jest bardzo zasobożerny — około 100 razy bardziej kosztowny niż zwykła analiza HTML — co oznacza, że Google nie może renderować każdej strony natychmiast. Te ograniczenia zasobów wprowadziły pojęcie budżetu renderowania (render budget), w którym strony są kolejkowane do renderowania na podstawie ich oczekiwanej ważności i potencjału ruchu z wyszukiwarek. Zrozumienie tej ewolucji jest kluczowe, ponieważ wyjaśnia, dlaczego JavaScript SEO nie jest opcjonalne, lecz stanowi podstawowy element nowoczesnej strategii technicznego SEO.

Podejście Google do treści renderowanych przez JavaScript to zaawansowany, trójfazowy proces, znacząco różniący się od tradycyjnego crawlowania HTML. W fazie crawlowania Googlebot pobiera adres URL i otrzymuje początkową odpowiedź HTML. Natychmiast analizuje tę odpowiedź, by wyodrębnić linki i sprawdzić dyrektywy indeksowania, takie jak meta robots czy deklaracje noindex. Co ważne, jeśli strona zawiera tag noindex w początkowym HTML, Google nie przejdzie do jej renderowania — to kluczowa różnica, o której wielu specjalistów SEO zapomina. Jednocześnie adres URL trafia do kolejki fazę renderowania, w której Web Rendering Service (WRS) wykorzystuje headless Chromium do wykonania JavaScript, zbudowania DOM i wygenerowania pełnego renderowanego HTML. Ten krok może zająć kilka sekund lub dłużej, w zależności od złożoności JavaScript, a strony mogą czekać w kolejce renderowania przez dłuższy czas, jeśli zasoby Google są ograniczone. W końcu, w fazie indeksowania, Google przetwarza renderowany HTML, by wyodrębnić treść, linki i metadane do włączenia do indeksu wyszukiwarki. Kluczowy wniosek: Google indeksuje na podstawie renderowanego HTML, a nie początkowej odpowiedzi HTML — co oznacza, że JavaScript może całkowicie zmienić to, co zostanie zaindeksowane. Ten trójfazowy proces wyjaśnia, dlaczego strony JavaScript często mają wolniejszą indeksację, dlaczego opóźnienia w renderowaniu są istotne oraz dlaczego porównywanie response HTML z rendered HTML jest niezbędne w diagnozowaniu problemów z JavaScript SEO.

| Metoda renderowania | Jak działa | Zalety SEO | Wady SEO | Najlepsze zastosowanie |

|---|---|---|---|---|

| Renderowanie po stronie serwera (SSR) | Treść w pełni renderowana na serwerze przed dostarczeniem do klienta | Treść natychmiast dostępna w początkowym HTML; szybka indeksacja; brak opóźnień w renderowaniu; obsługa wszystkich crawlerów | Większe obciążenie serwera; wolniejszy TTFB; złożona implementacja | Strony krytyczne dla SEO, e-commerce, serwisy z dużą ilością treści, wydawcy newsowi |

| Renderowanie po stronie klienta (CSR) | Serwer wysyła minimalny HTML; JavaScript renderuje treść w przeglądarce | Mniejsze obciążenie serwera; lepsza skalowalność; szybsze przejścia między podstronami dla użytkowników | Opóźniona indeksacja; konieczność renderowania; niewidoczne dla crawlerów LLM; wolniejsze ładowanie początkowe; zużywa budżet crawlowania | Aplikacje webowe, panele administracyjne, treści za logowaniem, strony niezależne od SEO |

| Renderowanie dynamiczne | Serwer rozpoznaje crawlery i dostarcza prerenderowany HTML; użytkownicy otrzymują CSR | Treść natychmiast dostępna dla crawlerów; balansuje doświadczenie bota i użytkownika; łatwiejsze wdrożenie niż SSR | Złożona konfiguracja; zależność od narzędzi; ryzyko cloakingu; wymaga rozpoznania botów; rozwiązanie tymczasowe | Duże strony oparte na JavaScript, SPA wymagające widoczności w wyszukiwarce, rozwiązanie przejściowe |

| Statyczne generowanie stron (SSG) | Treść prerenderowana podczas budowania; serwowana jako statyczny HTML | Najlepsza wydajność; optymalne SEO; brak opóźnień w renderowaniu; doskonałe Core Web Vitals | Ograniczona treść dynamiczna; konieczność przebudowy przy zmianach; nieodpowiednie do danych w czasie rzeczywistym | Blogi, dokumentacja, strony marketingowe, treści rzadko aktualizowane |

Strony renderowane przez JavaScript stwarzają wiele wyzwań technicznych, które bezpośrednio wpływają na wydajność SEO i widoczność w wyszukiwarkach. Najważniejszym problemem jest opóźnienie renderowania — ponieważ renderowanie jest kosztowne zasobowo, Google może opóźnić renderowanie stron nawet o godziny lub dni, przez co treści nie zostaną zaindeksowane natychmiast po publikacji. Jest to szczególnie problematyczne w przypadku treści wrażliwych na czas, takich jak newsy czy premiery produktów. Kolejnym istotnym problemem są miękkie błędy 404 powstające wtedy, gdy aplikacje jednostronicowe zwracają kod 200 HTTP nawet dla nieistniejących stron, co dezorientuje wyszukiwarki. Zmiany wprowadzane przez JavaScript w kluczowych elementach to kolejna duża przeszkoda: gdy JavaScript modyfikuje tytuły, tagi kanoniczne, dyrektywy meta robots czy linki wewnętrzne po początkowej odpowiedzi HTML, wyszukiwarki mogą zaindeksować niewłaściwe wersje lub pominąć ważne sygnały SEO. Problem zużycia budżetu crawlowania jest szczególnie dotkliwy na dużych witrynach — pliki JavaScript są duże i kosztowne w przetwarzaniu, więc Google zużywa więcej zasobów i renderuje mniej stron, ograniczając głębokość crawlowania. Dodatkowo crawlery LLM i narzędzia AI search nie wykonują JavaScript, przez co treści dostępne wyłącznie po renderowaniu są dla nich niewidoczne (np. na Perplexity, Claude i innych). Statystyki pokazują, że 31,9% specjalistów SEO nie wie, jak sprawdzić, czy strona jest zależna od JavaScript, a 30,9% nie czuje się komfortowo w analizie problemów SEO spowodowanych przez JavaScript, co podkreśla lukę kompetencyjną w branży.

Optymalizacja treści renderowanych przez JavaScript wymaga wieloaspektowego podejścia łączącego wdrożenia techniczne i strategiczne decyzje. Najważniejszą praktyką jest umieszczanie kluczowej treści w początkowej odpowiedzi HTML — tytuły, opisy meta, tagi kanoniczne oraz istotna zawartość strony powinny być dostępne w odpowiedzi serwera przed wykonaniem JavaScript. Gwarantuje to, że wyszukiwarki otrzymają pełny pierwszy obraz strony i nie będą musiały czekać na renderowanie, by ją zrozumieć. Nie blokuj plików JavaScript w robots.txt, ponieważ uniemożliwi to Google prawidłowe renderowanie stron — pozwól na dostęp do wszystkich zasobów JavaScript niezbędnych do renderowania. Stosuj poprawne kody statusu HTTP — używaj 404 dla nieistniejących stron i 301 dla przekierowań, zamiast obsługiwać te przypadki za pomocą JavaScript. Dla aplikacji jednostronicowych korzystaj z History API zamiast fragmentów URL, aby każda podstrona miała unikalny, crawlable URL; fragmenty takie jak #/produkty są niewiarygodne dla wyszukiwarek. Minimalizuj i opóźniaj ładowanie niekrytycznego JavaScript, aby skrócić czas renderowania i poprawić Core Web Vitals — wykorzystuj dzielenie kodu (code splitting), by ładować tylko niezbędny JavaScript na każdej stronie. Wdrażaj leniwe ładowanie obrazów przy użyciu natywnego atrybutu loading="lazy" zamiast rozwiązań opartych na JavaScript, co umożliwia wyszukiwarkom wykrycie obrazów bez konieczności renderowania. Stosuj hashowanie zawartości w nazwach plików JavaScript (np. main.2a846fa617c3361f.js), aby Google wiedział, kiedy kod się zmienił i wymaga ponownego pobrania. Regularnie testuj wdrożenia przy użyciu Inspekcji adresu URL Google Search Console, Screaming Frog z włączonym renderowaniem lub raportu Response vs Render w Sitebulb, by porównywać początkowy HTML z renderowanym HTML i wykrywać rozbieżności.

Wybór odpowiedniej strategii renderowania to jedna z najistotniejszych decyzji w JavaScript SEO. Renderowanie po stronie serwera (SSR) to złoty standard dla stron, gdzie SEO jest priorytetem, ponieważ treść jest w pełni renderowana na serwerze przed wysłaniem do użytkownika, eliminując opóźnienia renderowania i zapewniając dostępność treści dla wszystkich crawlerów. Frameworki takie jak Next.js i Nuxt.js ułatwiają wdrożenie SSR w nowoczesnych zespołach deweloperskich. SSR wymaga jednak większych zasobów serwera i może wydłużać Time to First Byte (TTFB), co wpływa na doświadczenie użytkownika. Renderowanie po stronie klienta (CSR) sprawdza się w aplikacjach, gdzie SEO nie jest kluczowe, np. panele administracyjne, narzędzia za logowaniem czy aplikacje wewnętrzne. CSR zmniejsza obciążenie serwera i pozwala na wysoką interaktywność, ale powoduje opóźnienia w indeksacji i sprawia, że treści są niewidoczne dla crawlerów LLM. Renderowanie dynamiczne to kompromis: wykrywa crawlery i serwuje im prerenderowany HTML, podczas gdy użytkownicy dostają interaktywny CSR. Narzędzia takie jak Prerender.io automatyzują ten proces, ale Google wyraźnie zaznacza, że to rozwiązanie tymczasowe i zaleca przejście na SSR w dłuższej perspektywie. Statyczne generowanie stron (SSG) jest optymalne dla treści, które rzadko się zmieniają — są prerenderowane podczas budowania i serwowane jako statyczny HTML, gwarantując najlepszą wydajność i właściwości SEO. Decyzję należy podjąć w oparciu o priorytety SEO, zasoby techniczne i częstotliwość aktualizacji treści. Dane pokazują, że 60% specjalistów SEO korzysta obecnie z crawlerów JavaScript do audytów, co wskazuje na rosnącą świadomość, że renderowanie musi być uwzględnione w analizie technicznego SEO.

Skuteczne JavaScript SEO wymaga bieżącego monitorowania konkretnych metryk i wskaźników pokazujących, jak wyszukiwarki przetwarzają Twoje treści renderowane przez JavaScript. Porównanie response vs rendered HTML jest podstawowe — przy użyciu np. raportu Response vs Render w Sitebulb można dokładnie zidentyfikować, co JavaScript zmienia na Twoich stronach, w tym modyfikacje tytułów, opisów meta, tagów kanonicznych, linków wewnętrznych czy dyrektyw robots. Statystyki wskazują, że 18,26% crawlów JavaScript ma tagi H1 wyłącznie w renderowanym HTML (a nie w początkowym), a co istotne, 4,60% audytów JavaScript wykazuje tagi noindex tylko w response HTML — to krytyczna sytuacja, w której Google widzi noindex i nigdy nie renderuje strony, uniemożliwiając jej indeksację. Zużycie budżetu renderowania należy monitorować w raporcie Pokrycie Google Search Console, który pokazuje, ile stron czeka na renderowanie, a ile już zostało wyrenderowanych. Core Web Vitals są szczególnie ważne w przypadku stron JavaScript, ponieważ ich wykonanie bezpośrednio wpływa na Largest Contentful Paint (LCP), First Input Delay (FID) i Cumulative Layout Shift (CLS). Monitoruj opóźnienie indeksacji — czyli ile czasu po publikacji Twoja treść pojawia się w indeksie Google — strony JavaScript zwykle mają dłuższe opóźnienia niż strony HTML. Śledź wydajność crawlowania, porównując liczbę crawlowanych stron do wszystkich podstron w serwisie; strony JavaScript często mają niższą efektywność crawlowania z powodu ograniczeń zasobów. Korzystaj z Inspekcji adresu URL w Google Search Console, by upewnić się, że kluczowa treść pojawia się w renderowanym HTML Google’a, a nie tylko w początkowej odpowiedzi.

Pojawienie się platform wyszukiwania opartych na AI, takich jak Perplexity, ChatGPT, Claude i Google AI Overviews, wprowadziło nowy wymiar do JavaScript SEO, wykraczający poza tradycyjne wyszukiwarki. Większość crawlerów LLM nie wykonuje JavaScript — analizuje surowy HTML i treść DOM taką, jaką otrzymuje w początkowej odpowiedzi serwera. Oznacza to, że jeśli Twoje kluczowe treści, informacje o produktach lub komunikaty marki pojawiają się dopiero po wykonaniu JavaScript, są one całkowicie niewidoczne dla narzędzi AI search. Tworzy to podwójny problem widoczności: treści niewidoczne dla crawlerów LLM nie będą cytowane w odpowiedziach AI, a użytkownicy korzystający z platform AI nie odkryją Twojej strony. Dla użytkowników AmICited monitorujących obecność marki i domeny w odpowiedziach AI jest to szczególnie istotne — jeśli treści renderowane przez JavaScript nie są dostępne dla crawlerów LLM, nie pojawisz się w cytowaniach AI. Rozwiązaniem jest zapewnienie, by kluczowe treści były obecne w początkowej odpowiedzi HTML, dostępnej dla tradycyjnych wyszukiwarek i crawlerów AI. Dlatego właśnie renderowanie po stronie serwera lub renderowanie dynamiczne nabiera jeszcze większego znaczenia w erze wyszukiwania AI — Twoje treści muszą być widoczne nie tylko dla Googlebota, ale i dla rosnącego ekosystemu narzędzi AI, które nie wykonują JavaScript.

Środowisko JavaScript SEO stale się rozwija wraz z postępem wyszukiwarek i technologii webowych. Google poczyniło znaczące inwestycje w poprawę możliwości renderowania JavaScript, przechodząc od procesu dwuetapowego (crawlowanie i indeksowanie) do trójfazowego (crawlowanie, renderowanie i indeksowanie), który lepiej obsługuje nowoczesne aplikacje webowe. Jednak renderowanie nadal jest ograniczone zasobami i nic nie wskazuje na to, by Google renderowało każdą stronę natychmiast lub by budżety renderowania miały zniknąć. Branża obserwuje zwrot ku hybrydowym podejściom renderowania, gdzie kluczowa treść jest renderowana po stronie serwera, a elementy interaktywne po stronie klienta, co pozwala pogodzić potrzeby SEO z doświadczeniem użytkownika. Web Components i Shadow DOM stają się coraz popularniejsze, wymagając od specjalistów SEO zrozumienia ich wpływu na renderowanie przez wyszukiwarki. Wzrost znaczenia wyszukiwania AI wymusza konieczność udostępniania kluczowych treści bez potrzeby wykonywania JavaScript, co potencjalnie przyspieszy adopcję SSR i SSG. Core Web Vitals nadal są czynnikiem rankingowym, a wpływ JavaScript na te metryki sprawia, że optymalizacja wydajności jest nierozerwalnie związana z JavaScript SEO. Dane branżowe pokazują, że tylko 10,6% specjalistów SEO doskonale rozumie, jak Google crawluje, renderuje i indeksuje JavaScript, co oznacza znaczną przestrzeń do edukacji i rozwoju kompetencji. Wraz z rozwojem frameworków JavaScript i ekspansją platform AI, kompetencje z zakresu JavaScript SEO będą coraz bardziej wartościowe i kluczowe dla konkurencyjnej widoczności organicznej.

main.2a846fa617c3361f.js), by Google wiedział o zmianach kodu i pobierał aktualne plikiloading="lazy") zamiast rozwiązań JavaScript dla lepszej kompatybilności z crawleramiJavaScript SEO przekształciło się z niszowego zagadnienia technicznego w fundamentalny element współczesnej optymalizacji wyszukiwarek. Ponieważ 98,7% stron internetowych wykorzystuje JavaScript, a 88% specjalistów SEO regularnie spotyka się ze stronami zależnymi od JavaScript, umiejętność optymalizacji treści renderowanych przez JavaScript nie jest już opcjonalna — jest niezbędna. Złożoność trójfazowego pipeline renderowania, ograniczenia budżetów renderowania oraz pojawienie się platform AI search stwarzają wielowymiarowe wyzwanie wymagające zarówno wiedzy technicznej, jak i strategicznych decyzji. Statystyki są niepokojące: 41,6% specjalistów SEO nie czytało dokumentacji JavaScript Google, 31,9% nie wie, jak rozpoznać strony zależne od JavaScript, a 30,9% nie czuje się komfortowo w analizie problemów SEO powodowanych przez JavaScript. Mimo to wpływ jest znaczący — 4,60% audytów JavaScript wykazuje krytyczne problemy, takie jak tagi noindex wyłącznie w response HTML, co całkowicie uniemożliwia indeksację. Dalsza droga wymaga inwestycji w edukację, przyjęcia odpowiednich strategii renderowania oraz wdrożenia najlepszych praktyk zapewniających dostępność treści zarówno dla wyszukiwarek, jak i crawlerów AI. Niezależnie od tego, czy korzystasz z SSR, renderowania dynamicznego, czy starannie optymalizujesz CSR, cel pozostaje niezmienny: spraw, aby Twoje treści oparte na JavaScript były w pełni wykrywalne, indeksowalne i widoczne we wszystkich platformach wyszukiwania — od tradycyjnego Google Search po nowoczesne narzędzia AI. Dla organizacji korzystających z AmICited do monitorowania widoczności marki w odpowiedziach AI, JavaScript SEO staje się jeszcze ważniejsze, ponieważ nieoptymalizowana treść renderowana przez JavaScript będzie niewidoczna dla crawlerów LLM i nie wygeneruje cytowań w wynikach AI search.

Tak, Google renderuje i indeksuje treści JavaScript, korzystając z headless Chromium. Jednak renderowanie jest zasobożerne i odbywa się dopiero, gdy Google ma dostępne zasoby. Google przetwarza strony w trzech fazach: crawling, rendering i indexing. Strony oznaczone tagiem noindex nie są renderowane, a opóźnienia w renderowaniu mogą spowolnić indeksację. Najważniejsze jest to, że do decyzji o indeksowaniu Google wykorzystuje renderowany HTML, a nie początkowy HTML z odpowiedzi serwera.

Według danych z 2024 roku, 98,7% stron internetowych korzysta w pewnym stopniu z JavaScript. Dodatkowo 62,3% deweloperów używa JavaScript jako głównego języka programowania, a 88% specjalistów SEO ma do czynienia ze stronami zależnymi od JavaScript czasami lub cały czas. Tak powszechne użycie sprawia, że wiedza z zakresu JavaScript SEO jest niezbędna dla nowoczesnych specjalistów SEO.

Kluczowe wyzwania to opóźnienia w renderowaniu, które spowalniają indeksowanie, zasobożerne przetwarzanie zużywające budżet crawlowania, potencjalne miękkie błędy 404 w aplikacjach jednostronicowych oraz zmiany wprowadzane przez JavaScript w kluczowych elementach, takich jak tytuły, tagi kanoniczne czy meta robots. Dodatkowo większość crawlerów LLM i narzędzi AI nie wykonuje JavaScript — treści widoczne dopiero po renderowaniu stają się dla nich niewidoczne.

Response HTML to początkowy kod HTML przesyłany z serwera (to, co widzisz w „Wyświetl źródło strony”). Rendered HTML to finalny DOM po wykonaniu JavaScript (to, co widzisz w Inspektorze przeglądarki). JavaScript może znacząco modyfikować DOM, wstrzykując treści, zmieniając metatagi, przepisując tytuły czy dodając/usuwać linki. Wyszukiwarki indeksują renderowany HTML, a nie response HTML.

Renderowanie po stronie serwera (SSR) jest optymalne dla SEO, ponieważ treść jest w pełni renderowana na serwerze przed dostarczeniem do użytkownika. Renderowanie po stronie klienta (CSR) wymaga, by wyszukiwarki same renderowały strony, co powoduje opóźnienia i problemy z indeksacją. Renderowanie dynamiczne polega na dostarczaniu prerenderowanego HTML crawlerom, a użytkownikom CSR, jednak Google zaleca tę metodę tylko jako rozwiązanie tymczasowe. Wybierz metodę w zależności od priorytetów SEO i zasobów technicznych strony.

Użyj narzędzia Inspekcja adresu URL w Google Search Console: przejdź do Inspekcji adresu URL, kliknij „Przetestuj aktywny adres URL”, a następnie w zakładce „HTML” zobaczysz renderowany HTML, który Google przetworzył. Alternatywnie możesz skorzystać z narzędzi takich jak Screaming Frog z włączonym renderowaniem, raport Response vs Render w Sitebulb lub Chrome DevTools, aby porównać początkowy HTML z renderowanym DOM i zidentyfikować problemy związane z JavaScript.

Render budget to ilość zasobów, które Google przydziela na renderowanie stron Twojej witryny. Google priorytetowo renderuje strony, które mają szansę uzyskać większy ruch z wyszukiwania. Strony mocno oparte na JavaScript, które mają niższy priorytet, mogą doświadczać znacznych opóźnień w renderowaniu, co spowalnia indeksację. Dlatego tak ważna jest optymalizacja JavaScript w celu skrócenia czasu renderowania oraz umieszczanie kluczowej treści w początkowym HTML.

Większość crawlerów LLM i narzędzi wyszukiwania AI (np. Perplexity, Claude i inne) nie wykonuje JavaScript — analizują jedynie surowy HTML. Jeśli kluczowe treści pojawiają się dopiero po wykonaniu JavaScript, są one niewidoczne zarówno dla pierwotnego crawl Google, jak i dla platform AI search. To sprawia, że JavaScript SEO jest istotne nie tylko dla tradycyjnego wyszukiwania, ale również dla widoczności i cytowań w AI.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Content SEO to strategiczne tworzenie i optymalizacja wysokiej jakości treści w celu poprawy pozycji w wyszukiwarkach i widoczności organicznej. Dowiedz się, ja...

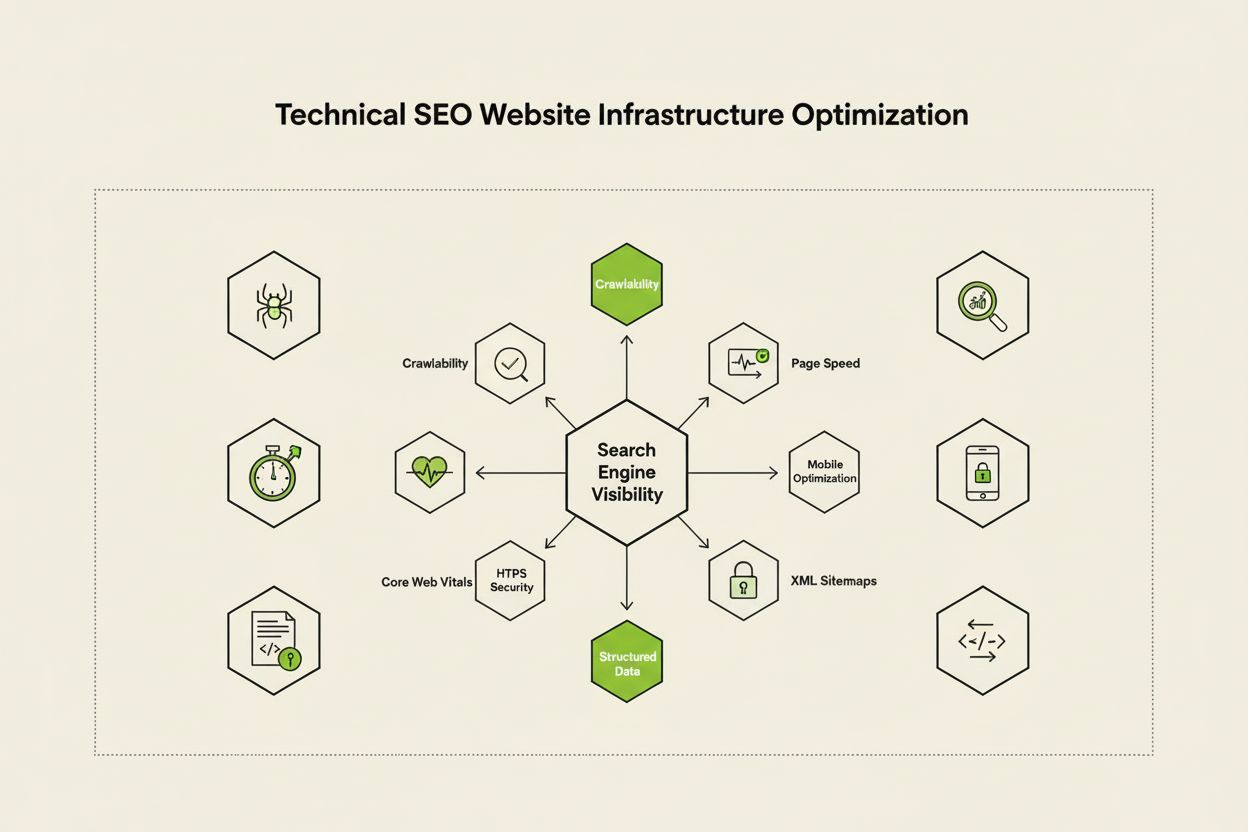

Techniczne SEO optymalizuje infrastrukturę strony internetowej pod kątem indeksowania, crawlowania i pozycjonowania przez wyszukiwarki. Dowiedz się o crawlabili...

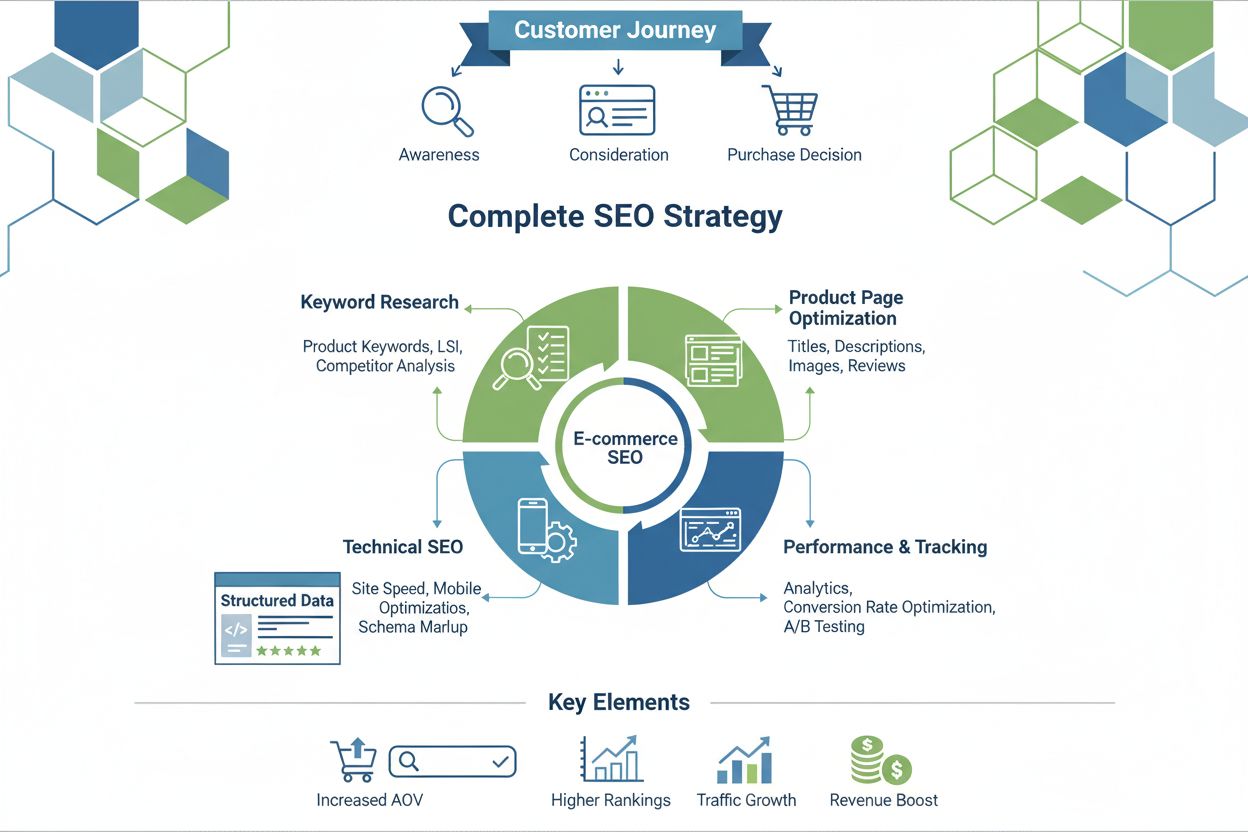

SEO ecommerce to optymalizacja sklepów internetowych pod kątem widoczności w wyszukiwarkach. Poznaj badanie słów kluczowych, optymalizację stron produktów, tech...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.