Czym jest MUM i jak wpływa na wyszukiwanie AI?

Dowiedz się, czym jest Multitask Unified Model (MUM) Google i jaki ma wpływ na wyniki wyszukiwania AI. Zrozum, jak MUM przetwarza złożone zapytania w różnych fo...

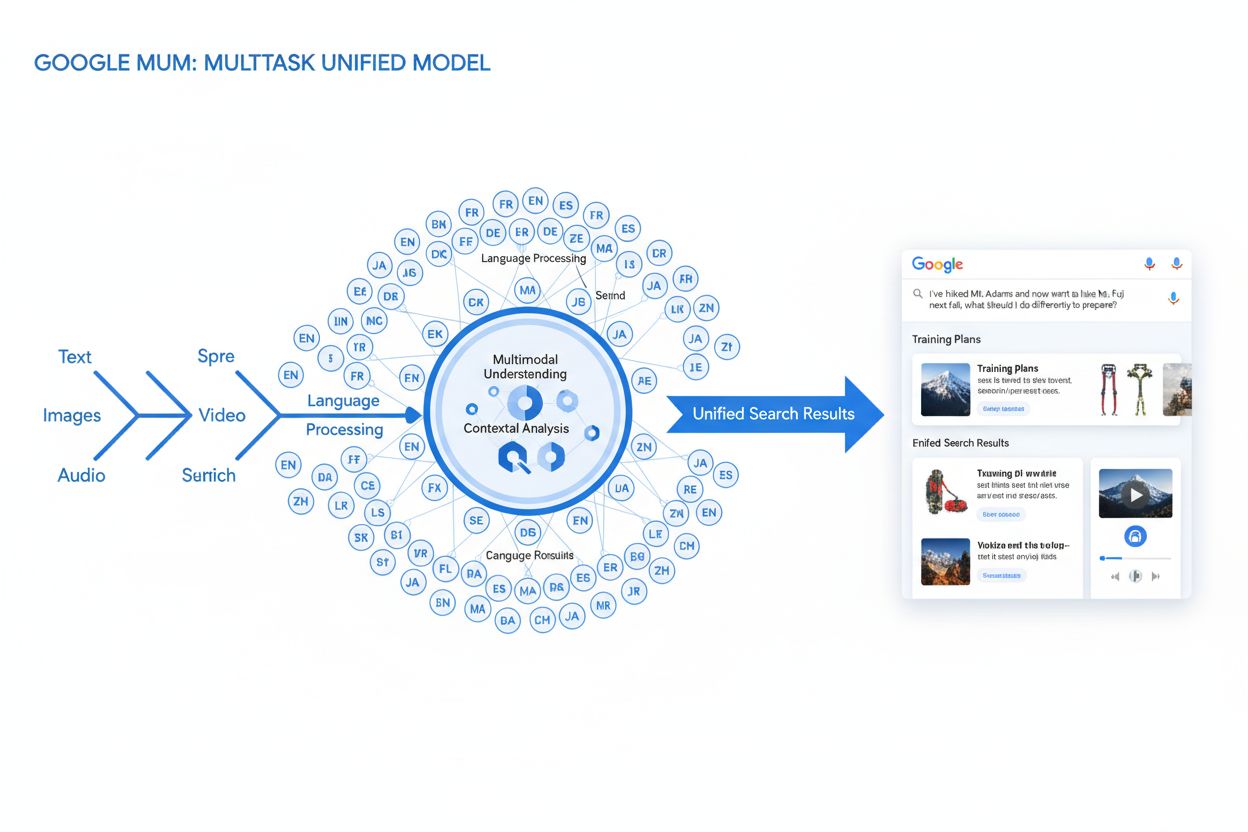

MUM (Multitask Unified Model) to zaawansowany, multimodalny model AI Google, który jednocześnie przetwarza tekst, obrazy, wideo i dźwięk w ponad 75 językach, aby dostarczać bardziej kompleksowe, kontekstowe wyniki wyszukiwania. Wprowadzony w 2021 roku, MUM jest 1000 razy potężniejszy niż BERT i oznacza fundamentalną zmianę w sposobie, w jaki wyszukiwarki rozumieją i odpowiadają na złożone zapytania użytkowników.

MUM (Multitask Unified Model) to zaawansowany, multimodalny model AI Google, który jednocześnie przetwarza tekst, obrazy, wideo i dźwięk w ponad 75 językach, aby dostarczać bardziej kompleksowe, kontekstowe wyniki wyszukiwania. Wprowadzony w 2021 roku, MUM jest 1000 razy potężniejszy niż BERT i oznacza fundamentalną zmianę w sposobie, w jaki wyszukiwarki rozumieją i odpowiadają na złożone zapytania użytkowników.

MUM (Multitask Unified Model) to zaawansowany multimodalny model sztucznej inteligencji Google stworzony, by zrewolucjonizować sposób, w jaki wyszukiwarki rozumieją i odpowiadają na złożone zapytania użytkowników. Ogłoszony w maju 2021 roku przez Pandu Nayaka, Google Fellow i wiceprezesa ds. wyszukiwania, MUM oznacza fundamentalną zmianę w technologii wyszukiwania informacji. Zbudowany na frameworku T5 text-to-text i obejmujący około 110 miliardów parametrów, MUM jest 1000 razy potężniejszy niż BERT, poprzedni przełomowy model przetwarzania języka naturalnego Google. W przeciwieństwie do tradycyjnych algorytmów wyszukiwania, które przetwarzają tekst w izolacji, MUM jednocześnie przetwarza tekst, obrazy, wideo i dźwięk, rozumiejąc informacje w ponad 75 językach natywnie. Ta multimodalność i wielojęzyczność pozwala MUM rozumieć złożone zapytania, które wcześniej wymagały od użytkowników wielu wyszukiwań, przekształcając wyszukiwanie z prostego dopasowania słów kluczowych w inteligentny, kontekstowy system wyszukiwania informacji. MUM nie tylko rozumie język, ale także go generuje, co pozwala mu syntezować informacje z różnych źródeł i formatów, by dostarczać kompleksowe, zniuansowane odpowiedzi, obejmujące pełen zakres intencji użytkownika.

Droga Google do MUM to lata stopniowych innowacji w przetwarzaniu języka naturalnego i uczeniu maszynowym. Ewolucja rozpoczęła się od Hummingbird (2013), który wprowadził semantyczne rozumienie, interpretując znaczenie zapytań zamiast tylko dopasowywać słowa kluczowe. Następnie pojawił się RankBrain (2015), wykorzystujący uczenie maszynowe do rozumienia długich ogonów słów kluczowych i nowych wzorców wyszukiwań. Neural Matching (2018) poszedł dalej, stosując sieci neuronowe do głębszego dopasowania zapytań z treściami na poziomie semantycznym. BERT (Bidirectional Encoder Representations from Transformers), wprowadzony w 2019 roku, był przełomem w zrozumieniu kontekstu w zdaniach i akapitach, poprawiając zdolność Google do interpretacji zniuansowanego języka. Jednak BERT miał istotne ograniczenia — przetwarzał wyłącznie tekst, miał ograniczoną wielojęzyczność i nie radził sobie złożonością zapytań wymagających syntezy informacji z różnych formatów. Według badań Google, użytkownicy wydawali średnio osiem osobnych zapytań, by uzyskać odpowiedź na złożone pytania, np. porównując dwa miejsca na wycieczkę górską czy oceniając opcje produktów. Ten statystyczny fakt uwypuklił istotną lukę w technologii wyszukiwania, którą MUM miał wypełnić. Helpful Content Update (2022) i framework E-E-A-T (2023) dodatkowo udoskonaliły sposób, w jaki Google priorytetyzuje treści autorytatywne i godne zaufania. MUM bazuje na tych wszystkich innowacjach, wprowadzając możliwości, które przekraczają wcześniejsze ograniczenia — to nie tylko ulepszenie, ale zmiana paradygmatu w sposobie przetwarzania i dostarczania informacji przez wyszukiwarki.

Techniczne podstawy MUM opierają się na architekturze Transformer, a konkretnie na frameworku T5 (Text-to-Text Transfer Transformer) opracowanym wcześniej przez Google. Framework T5 traktuje wszystkie zadania z zakresu przetwarzania języka naturalnego jako problemy text-to-text, przekształcając wejścia i wyjścia w jednolite reprezentacje tekstowe. MUM rozszerza to podejście o zdolności przetwarzania multimodalnego, umożliwiając jednoczesną obsługę tekstu, obrazów, wideo i dźwięku w jednym, zintegrowanym modelu. Ten wybór architektoniczny jest istotny, ponieważ pozwala MUM rozumieć relacje i kontekst pomiędzy różnymi typami mediów w sposób niedostępny dla wcześniejszych modeli. Przykładowo, podczas obsługi zapytania o wejście na Fuji wraz ze zdjęciem konkretnych butów trekkingowych, MUM nie analizuje tekstu i obrazu osobno — przetwarza je razem, rozumiejąc, jak cechy butów odnoszą się do kontekstu zapytania. Model z 110 miliardami parametrów posiada zdolność przechowywania i przetwarzania ogromnej wiedzy o języku, koncepcjach wizualnych i ich powiązaniach. MUM jest trenowany równocześnie w 75 językach i wielu zadaniach, dzięki czemu zdobywa szersze rozumienie informacji i wiedzy o świecie niż modele uczone na pojedynczych językach lub zadaniach. To podejście multitask sprawia, że MUM rozpoznaje wzorce i relacje przenoszące się między językami i domenami, czyniąc go bardziej odpornym i uniwersalnym od poprzedników. Równoczesne przetwarzanie wielu języków podczas treningu pozwala MUM dokonywać transferu wiedzy między językami — rozumieć informacje napisane w jednym języku i stosować je do zapytań w innym, skutecznie przełamując bariery językowe, które wcześniej ograniczały wyniki wyszukiwania.

| Atrybut | MUM (2021) | BERT (2019) | RankBrain (2015) | Framework T5 |

|---|---|---|---|---|

| Podstawowa funkcja | Multimodalne rozumienie zapytań i synteza odpowiedzi | Kontekstowe rozumienie tekstu | Interpretacja długiego ogona słów kluczowych | Uczenie transferowe text-to-text |

| Formaty wejścia | Tekst, obrazy, wideo, dźwięk | Tylko tekst | Tylko tekst | Tylko tekst |

| Obsługa języków | Ponad 75 języków natywnie | Ograniczona wielojęzyczność | Głównie angielski | Głównie angielski |

| Liczba parametrów | ~110 miliardów | ~340 milionów | Brak danych | ~220 milionów |

| Porównanie mocy | 1000x potężniejszy niż BERT | Punkt odniesienia | Poprzednik BERT | Podstawa dla MUM |

| Możliwości | Rozumienie + generowanie | Tylko rozumienie | Rozpoznawanie wzorców | Transformacja tekstu |

| Wpływ na SERP | Wieloformatowe, wzbogacone wyniki | Lepsze fragmenty i kontekst | Wyższa trafność | Podstawa technologiczna |

| Obsługa złożonych zapytań | Złożone, wieloetapowe zapytania | Kontekst jednego zapytania | Długi ogon wariacji | Zadania transformacji tekstu |

| Transfer wiedzy | Międzyjęzykowy i międzyformatowy | Tylko w ramach języka | Ograniczony transfer | Transfer między zadaniami |

| Zastosowania praktyczne | Google Search, AI Overviews | Ranking Google Search | Ranking Google Search | Podstawa techniczna MUM |

Przetwarzanie zapytań przez MUM obejmuje wiele zaawansowanych etapów, które współdziałają, aby dostarczyć kompleksowe, kontekstowe odpowiedzi. Gdy użytkownik wysyła zapytanie, MUM rozpoczyna od językowo niezależnego przetwarzania wstępnego, rozumiejąc je w dowolnym z ponad 75 obsługiwanych języków, bez potrzeby tłumaczenia. To natywne rozumienie języka zachowuje niuanse i kontekst regionalny, które mogłyby zostać utracone w tłumaczeniu. Następnie MUM stosuje dopasowywanie sequence-to-sequence, analizując całe zapytanie jako sekwencję znaczeń, a nie pojedyncze słowa kluczowe. Pozwala to zrozumieć relacje między pojęciami — np. rozpoznać, że pytanie o “przygotowanie na Fuji po wejściu na Adams” dotyczy porównania, przygotowania i adaptacji do kontekstu. Jednocześnie MUM prowadzi analizę wejścia multimodalnego, przetwarzając dołączone obrazy, wideo lub inne media. Model uruchamia równoczesne przetwarzanie zapytania, analizując wiele możliwych intencji użytkownika równolegle, zamiast zawężać się do jednej interpretacji. Oznacza to, że przy pytaniu o wędrówkę na Fuji, MUM może rozpoznać, że chodzi o przygotowanie fizyczne, wybór sprzętu, doświadczenia kulturowe lub logistykę podróży — i wyświetlić informacje dla wszystkich tych znaczeń. Semantyczne rozumienie wektorowe przekształca zapytanie i indeksowane treści w wektory wysokowymiarowe reprezentujące znaczenie semantyczne, umożliwiając wyszukiwanie na podstawie podobieństwa koncepcyjnego, a nie dopasowania słów. Następnie MUM stosuje filtrowanie treści przez transfer wiedzy, wykorzystując uczenie maszynowe na danych z logów wyszukiwania, historii przeglądania i wzorców zachowań użytkowników, aby priorytetyzować źródła wysokiej jakości. Na końcu MUM generuje wielomedialną, wzbogaconą kompozycję SERP, łącząc fragmenty tekstu, obrazy, wideo, powiązane pytania i interaktywne elementy w jedno, warstwowe doświadczenie wyszukiwania. Cały proces trwa milisekundy, umożliwiając MUM dostarczanie wyników, które odpowiadają nie tylko na jawne pytanie, ale także na przewidywane pytania uzupełniające i powiązane potrzeby informacyjne.

Multimodalność MUM stanowi fundamentalne odejście od wyszukiwarek opartych wyłącznie na tekście. Model potrafi jednocześnie przetwarzać i rozumieć informacje z tekstu, obrazów, wideo i dźwięku, wydobywając znaczenie z każdego formatu i syntezując je w spójne odpowiedzi. Ta zdolność jest szczególnie przydatna w zapytaniach wymagających kontekstu wizualnego. Na przykład, jeśli użytkownik zapyta “Czy mogę użyć tych butów trekkingowych na Fuji?” pokazując zdjęcie swoich butów, MUM rozumie cechy butów na zdjęciu — materiał, bieżnik, wysokość, kolor — i łączy tę wiedzę z informacjami o terenie Fuji, klimacie i wymaganiach, by udzielić kontekstowej odpowiedzi. Wielojęzyczny wymiar MUM jest równie przełomowy. Dzięki natywnej obsłudze ponad 75 języków, MUM może dokonywać transferu wiedzy między językami — uczy się ze źródeł w jednym języku i stosuje tę wiedzę do zapytań w innym. Przełamuje to barierę, która wcześniej ograniczała wyniki do treści w języku użytkownika. Jeśli najbardziej kompletne informacje o Fuji są po japońsku — np. lokalne przewodniki, sezonowe warunki pogodowe czy niuanse kulturowe — MUM zrozumie te treści i wyświetli istotne informacje użytkownikom anglojęzycznym. Według testów Google, MUM potrafił wymienić 800 wariantów szczepionek na COVID-19 w ponad 50 językach w ciągu kilku sekund, co pokazuje skalę i szybkość jego wielojęzycznego przetwarzania. Ta wielojęzyczność jest szczególnie cenna dla użytkowników spoza rynków anglojęzycznych i dla zapytań o tematy, które mają bogate źródła w różnych językach. Połączenie przetwarzania multimodalnego i wielojęzycznego sprawia, że MUM potrafi wyświetlić najbardziej adekwatne informacje niezależnie od formatu i języka publikacji, tworząc prawdziwie globalne doświadczenie wyszukiwania.

MUM radykalnie zmienia sposób prezentacji i odbioru wyników wyszukiwania przez użytkowników. Zamiast tradycyjnej listy niebieskich linków, która dominowała przez dekady, MUM tworzy wzbogacone, interaktywne SERP-y, łączące różne formaty treści na jednej stronie. Użytkownicy widzą teraz fragmenty tekstu, obrazy w wysokiej rozdzielczości, karuzele wideo, powiązane pytania i elementy interaktywne bez opuszczania wyników wyszukiwania. Ta zmiana ma ogromne konsekwencje dla sposobu korzystania z wyszukiwarki. Zamiast wykonywać wiele wyszukiwań, by zebrać informacje o złożonym temacie, użytkownicy mogą eksplorować różne aspekty i podtematy bezpośrednio w SERP-ie. Na przykład zapytanie o “przygotowanie na Fuji jesienią” może wyświetlić porównania wysokości, prognozy pogody, rekomendacje sprzętu, przewodniki wideo i recenzje użytkowników — wszystko kontekstowo na jednej stronie. Integracja Google Lens napędzana MUM pozwala wyszukiwać za pomocą obrazów zamiast słów kluczowych, zamieniając elementy wizualne ze zdjęć w narzędzia do odkrywania treści. Panele ‘Things to Know’ rozbijają złożone zapytania na łatwe do przyswojenia podtematy, prowadząc użytkownika przez różne aspekty tematu za pomocą odpowiednich fragmentów. Powiększalne, wysokiej jakości obrazy pojawiają się bezpośrednio w wynikach, umożliwiając wizualne porównania i ułatwiając podjęcie decyzji na wczesnym etapie. Funkcja ‘Refine and Broaden’ sugeruje pokrewne zagadnienia, pomagając użytkownikowi zgłębić wybrany aspekt lub poznać tematy pokrewne. Te zmiany przekształcają wyszukiwanie z prostego narzędzia wyszukującego w interaktywne, eksploracyjne doświadczenie, które przewiduje potrzeby użytkownika i zapewnia kompleksowe informacje w samym interfejsie wyszukiwarki. Badania wskazują, że bogatsze SERP-y zmniejszają średnią liczbę wyszukiwań potrzebnych do uzyskania odpowiedzi na złożone pytanie, choć oznacza to również, że użytkownicy częściej konsumują informacje bezpośrednio w wynikach niż klikając w strony internetowe.

Dla organizacji śledzących swoją obecność w systemach AI, MUM oznacza kluczową ewolucję w sposobie odkrywania i prezentowania informacji. Wraz z coraz większą integracją MUM z Google Search i wpływem na inne systemy AI, zrozumienie, jak marki i domeny pojawiają się w wynikach opartych na MUM, staje się niezbędne dla utrzymania widoczności. Multimodalność MUM oznacza, że marki muszą optymalizować treści w wielu formatach, nie tylko tekstowych. Marka, która wcześniej opierała się na rankingach dla konkretnych słów kluczowych, musi teraz zadbać o widoczność treści w obrazach, wideo i danych strukturalnych. Zdolność modelu do syntezowania informacji z różnych źródeł oznacza, że widoczność marki zależy nie tylko od jej własnej strony, ale od tego, jak jej informacje są prezentowane w całym ekosystemie internetu. Wielojęzyczność MUM tworzy nowe szanse i wyzwania dla marek globalnych. Treści opublikowane w jednym języku mogą być odkrywane przez użytkowników szukających w innym, co zwiększa potencjalny zasięg. Jednocześnie marki muszą zadbać o spójność i rzetelność informacji w różnych językach, ponieważ MUM może prezentować dane z wielu języków dla jednego zapytania. Dla platform monitoringu AI, takich jak AmICited, śledzenie wpływu MUM jest kluczowe, bo obrazuje sposób, w jaki nowoczesne AI wyszukują i prezentują informacje. Monitorując, gdzie marka pojawia się w odpowiedziach AI — czy to w Google AI Overviews, Perplexity, ChatGPT czy Claude — zrozumienie technologii stojącej za MUM pomaga wyjaśnić, dlaczego pojawiają się określone treści i jak optymalizować widoczność. Przejście do multimodalnego, wielojęzycznego wyszukiwania oznacza, że marki potrzebują kompleksowego monitoringu obejmującego obecność w różnych formatach i językach, a nie tylko pozycje na słowa kluczowe. Organizacje, które poznają możliwości MUM, skuteczniej zoptymalizują strategię treści i zapewnią widoczność w nowym krajobrazie wyszukiwania.

Mimo że MUM to ogromny postęp, wprowadza także nowe wyzwania i ograniczenia, z którymi organizacje muszą się zmierzyć. Niższe współczynniki kliknięć to poważny problem dla wydawców i twórców treści, ponieważ użytkownicy mogą konsumować kompletne informacje bezpośrednio w SERP, bez przechodzenia na strony. To sprawia, że tradycyjne wskaźniki ruchu stają się mniej miarodajne. Większe wymagania techniczne SEO sprawiają, że by zostać właściwie zrozumianym przez MUM, treści muszą być dobrze zbudowane, ze znacznikiem schema, semantycznym HTML i jasnymi relacjami encji. Treści bez tej bazy technicznej mogą nie być właściwie indeksowane lub rozumiane przez MUM. Saturacja SERP utrudnia widoczność, bo więcej formatów treści konkuruje o uwagę na jednej stronie. Nawet wartościowe treści mogą nie zdobyć kliknięć, jeśli użytkownicy znajdą odpowiedź w samym SERP. Ryzyko mylących wyników istnieje, gdy MUM łączy informacje z niespójnych źródeł lub gdy kontekst ginie podczas syntezy. Zależność od danych strukturalnych oznacza, że nieustrukturyzowane lub słabo sformatowane treści mogą nie zostać poprawnie zrozumiane czy wyświetlone. Wyzwania związane z niuansami językowymi i kulturowymi mogą się pojawić podczas transferu wiedzy między językami, jeśli MUM nie uwzględni kontekstu kulturowego lub wariacji regionalnych. Wymagania sprzętowe do uruchamiania MUM na dużą skalę są ogromne, choć Google inwestuje w poprawę wydajności i ograniczanie śladu węglowego. Problemy z biasem i sprawiedliwością wymagają ciągłej uwagi, by MUM nie utrwalał uprzedzeń z danych treningowych lub nie dyskryminował pewnych perspektyw czy społeczności.

Pojawienie się MUM wymaga fundamentalnej zmiany podejścia do SEO i strategii treści. Tradycyjna optymalizacja oparta na słowach kluczowych staje się mniej skuteczna, gdy MUM rozumie intencje i kontekst poza dopasowaniem słów. Strategia oparta na tematach zyskuje na znaczeniu — organizacje muszą tworzyć rozbudowane klastry treści obejmujące tematy z różnych perspektyw. Tworzenie treści multimedialnych przestaje być opcją, a staje się koniecznością — trzeba inwestować w wysokiej jakości zdjęcia, wideo i treści interaktywne uzupełniające tekst. Implementacja danych strukturalnych staje się kluczowa, bo schema markup pomaga MUM zrozumieć strukturę i powiązania treści. Budowanie encji i optymalizacja semantyczna wzmacniają autorytet tematyczny i poprawiają sposób, w jaki MUM rozpoznaje relacje między treściami. Wielojęzyczna strategia treści zyskuje na znaczeniu, bo możliwości transferu językowego MUM pozwalają na odkrywanie treści na różnych rynkach. Mapowanie intencji użytkownika staje się bardziej zaawansowane — trzeba uwzględniać nie tylko główną intencję, ale też pytania poboczne i podtematy, które użytkownicy mogą eksplorować. Świeżość i dokładność treści nabierają znaczenia, bo MUM syntezuje informacje z wielu źródeł — przestarzałe lub nieprecyzyjne treści mogą być pomijane. Optymalizacja cross-platformowa wykracza poza Google Search, obejmując także AI, takie jak Google AI Overviews, Perplexity i inne wyszukiwarki AI. Sygnały E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność) są coraz ważniejsze, bo MUM premiuje treści autorytatywne. Organizacje, które dostosują strategie do możliwości MUM — stawiając na rozbudowane, multimodalne, dobrze zbudowane treści o wysokim poziomie ekspertyzy i autorytetu — utrzymają widoczność w ewoluującym krajobrazie wyszukiwania.

**MUM to nie koniec drogi, a przystanek na ścieżce

Podczas gdy BERT (2019) skupiał się na rozumieniu języka naturalnego w zapytaniach tekstowych, MUM stanowi znaczącą ewolucję. MUM jest oparty na frameworku T5 text-to-text i jest 1000 razy potężniejszy niż BERT. W przeciwieństwie do tekstowego przetwarzania BERT, MUM jest multimodalny — jednocześnie przetwarza tekst, obrazy, wideo i dźwięk. Dodatkowo MUM natywnie obsługuje ponad 75 języków, podczas gdy BERT miał ograniczoną wielojęzyczność na początku. MUM potrafi zarówno rozumieć, jak i generować język, dzięki czemu radzi sobie ze złożonymi, wieloetapowymi zapytaniami, których BERT nie był w stanie skutecznie obsłużyć.

'Multimodalny' odnosi się do zdolności MUM do jednoczesnego przetwarzania i rozumienia informacji pochodzących z różnych formatów wejściowych. Zamiast analizować tekst oddzielnie od obrazów czy wideo, MUM przetwarza wszystkie te formaty razem, w sposób zintegrowany. Oznacza to, że gdy wyszukujesz np. 'buty trekkingowe na Fuji', MUM rozumie Twoje zapytanie tekstowe, analizuje zdjęcia butów, ogląda recenzje wideo i wyciąga opisy audio — wszystko równocześnie. To zintegrowane podejście pozwala MUM dostarczać bogatsze, bardziej kontekstowe odpowiedzi, które biorą pod uwagę informacje ze wszystkich tych mediów.

MUM został wytrenowany w ponad 75 językach, co stanowi ogromny postęp w globalnej dostępności wyszukiwania. Ta wielojęzyczność oznacza, że MUM potrafi przenosić wiedzę pomiędzy językami — jeśli przydatne informacje na dany temat istnieją po japońsku, MUM może je zrozumieć i wyświetlić odpowiednie wyniki użytkownikom anglojęzycznym. To przełamuje bariery językowe, które wcześniej ograniczały wyniki wyszukiwania do treści w języku użytkownika. Dla marek i twórców treści oznacza to potencjalną widoczność w wielu rynkach językowych, a użytkownicy na całym świecie mogą uzyskiwać dostęp do informacji niezależnie od języka publikacji.

T5 (Text-to-Text Transfer Transformer) to wcześniejszy model Google oparty na architekturze transformer, na którym zbudowany jest MUM. Framework T5 traktuje wszystkie zadania NLP jako problemy text-to-text, czyli konwertuje wejście i wyjście na format tekstowy do zintegrowanego przetwarzania. MUM rozszerza możliwości T5 o multimodalne przetwarzanie (obrazy, wideo, dźwięk) i skalowanie do około 110 miliardów parametrów. Ta podstawa pozwala MUM zarówno rozumieć, jak i generować język przy zachowaniu wydajności i elastyczności, które przyczyniły się do sukcesu T5.

MUM zasadniczo zmienia sposób odkrywania i prezentowania treści w wynikach wyszukiwania. Zamiast tradycyjnych, niebieskich linków, MUM tworzy wzbogacone SERP-y z wieloma formatami treści — obrazami, wideo, fragmentami tekstu i elementami interaktywnymi — na jednej stronie. Oznacza to, że marki muszą optymalizować treści w różnych formatach, nie tylko tekst. Treści, które wcześniej wymagały przechodzenia przez wiele stron, mogą być teraz wyświetlane bezpośrednio w wynikach wyszukiwania. Jednak oznacza to również niższe współczynniki kliknięć dla niektórych treści, ponieważ użytkownicy mogą konsumować informacje w samym SERP-ie. Marki muszą teraz skupiać się na widoczności w wynikach oraz upewnić się, że ich treści są poprawnie zbudowane ze znacznikami schema, by były właściwie rozumiane przez MUM.

MUM jest kluczowy dla platform monitoringu AI, ponieważ odzwierciedla sposób, w jaki nowoczesne systemy AI rozumieją i wyszukują informacje. W miarę jak MUM staje się coraz bardziej obecny w wyszukiwarce Google i wpływa na inne systemy AI, monitorowanie, gdzie marki i domeny pojawiają się w wynikach opartych na MUM, staje się niezbędne. AmICited śledzi, jak marki są cytowane i pojawiają się w systemach AI, w tym w wyszukiwarce Google z MUM. Zrozumienie możliwości multimodalnych i wielojęzycznych MUM pomaga organizacjom optymalizować obecność w różnych formatach treści i językach, zapewniając widoczność wtedy, gdy systemy AI, takie jak MUM, prezentują ich informacje użytkownikom.

Tak, MUM potrafi przetwarzać obrazy i wideo z zaawansowanym zrozumieniem. Gdy przesyłasz obraz lub dołączasz wideo do zapytania, MUM nie tylko rozpoznaje obiekty — wyodrębnia kontekst, znaczenie i powiązania. Na przykład, jeśli pokażesz MUM zdjęcie butów trekkingowych i zapytasz 'czy mogę użyć tych butów na Fuji?', MUM rozumie cechy butów ze zdjęcia i łączy tę wiedzę z Twoim pytaniem, aby udzielić kontekstowej odpowiedzi. Ta multimodalna zdolność rozumienia jest jedną z najmocniejszych cech MUM i pozwala odpowiadać na pytania wymagające połączenia wiedzy wizualnej z tekstową.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, czym jest Multitask Unified Model (MUM) Google i jaki ma wpływ na wyniki wyszukiwania AI. Zrozum, jak MUM przetwarza złożone zapytania w różnych fo...

Dyskusja społecznościowa wyjaśniająca Google MUM i jego wpływ na wyszukiwanie z AI. Eksperci dzielą się tym, jak ten multimodalny model AI wpływa na optymalizac...

Dowiedz się, jak wielomodalne systemy wyszukiwania AI przetwarzają tekst, obrazy, dźwięk i wideo razem, aby dostarczać dokładniejsze i bardziej kontekstowe wyni...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.