Aktualizacja Hummingbird

Dowiedz się, czym jest aktualizacja Hummingbird, jak zrewolucjonizowała semantyczne wyszukiwanie w 2013 roku i dlaczego ma znaczenie dla monitorowania AI oraz w...

Aktualizacja Penguin to algorytm Google zaprojektowany do zwalczania spamu linkowego i manipulacyjnych praktyk budowania linków poprzez identyfikację oraz dewaluację niskiej jakości, nienaturalnych backlinków. Po raz pierwszy uruchomiony w kwietniu 2012 roku, w 2016 roku stał się komponentem algorytmu działającym w czasie rzeczywistym, który nieustannie monitoruje i dostosowuje pozycje na podstawie jakości backlinków oraz schematów linkowania.

Aktualizacja Penguin to algorytm Google zaprojektowany do zwalczania spamu linkowego i manipulacyjnych praktyk budowania linków poprzez identyfikację oraz dewaluację niskiej jakości, nienaturalnych backlinków. Po raz pierwszy uruchomiony w kwietniu 2012 roku, w 2016 roku stał się komponentem algorytmu działającym w czasie rzeczywistym, który nieustannie monitoruje i dostosowuje pozycje na podstawie jakości backlinków oraz schematów linkowania.

Aktualizacja Penguin to algorytm Google stworzony specjalnie do zwalczania spamu linkowego i manipulacyjnych praktyk budowania linków poprzez identyfikację, dewaluację oraz karanie stron internetowych posiadających nienaturalne lub niskiej jakości profile backlinków. Po raz pierwszy oficjalnie ogłoszona przez Matta Cuttsa 24 kwietnia 2012 roku, aktualizacja Penguin była zdecydowaną reakcją Google na narastający problem technik black-hat SEO, które sztucznie zwiększały pozycje w wyszukiwarce za pomocą kupowanych linków, wymian linków i innych nieuczciwych praktyk. Głównym celem algorytmu jest zapewnienie, by naturalne, autorytatywne i istotne linki były nagradzane, podczas gdy manipulacyjne i spamowe linki są obniżane lub całkowicie ignorowane. W przeciwieństwie do aktualizacji skupionych na treści, takich jak Panda, która celuje w niskiej jakości content, Penguin ocenia jakość i autentyczność profilu linków przychodzących na stronę, co czyni go kluczowym elementem systemu rankingowego Google od ponad dekady.

Aktualizacja Penguin pojawiła się w kluczowym momencie rozwoju SEO, gdy ilość linków miała nieproporcjonalnie duży wpływ na pozycje w wyszukiwarce. Przed wdrożeniem Penguina właściciele stron mogli sztucznie podnosić rankingi, pozyskując dużą liczbę niskiej jakości linków z farm linków, prywatnych sieci blogowych i innych źródeł spamu. Praktyka ta powodowała poważny problem dla wyników Google, ponieważ niskiej jakości witryny i treści pojawiały się na wysokich pozycjach mimo braku rzeczywistego autorytetu czy powiązania tematycznego. Matt Cutts, ówczesny szef zespołu ds. spamu Google, wyjaśnił podczas konferencji SMX Advanced 2012: „Traktujemy to jako coś zaprojektowanego do walki z niskiej jakości treściami. Zaczęło się od Pandy, a potem zauważyliśmy, że nadal jest dużo spamu i Penguin powstał, by to zwalczać”. Pierwsza aktualizacja Penguin wpłynęła na ponad 3% wszystkich zapytań, co czyni ją jedną z najbardziej znaczących aktualizacji algorytmu w historii Google. Ten ogromny wpływ był sygnałem dla branży SEO, że Google stanowczo walczy z manipulacyjnymi praktykami linkowania i będzie stale ulepszać algorytmy, by utrzymać jakość wyszukiwania.

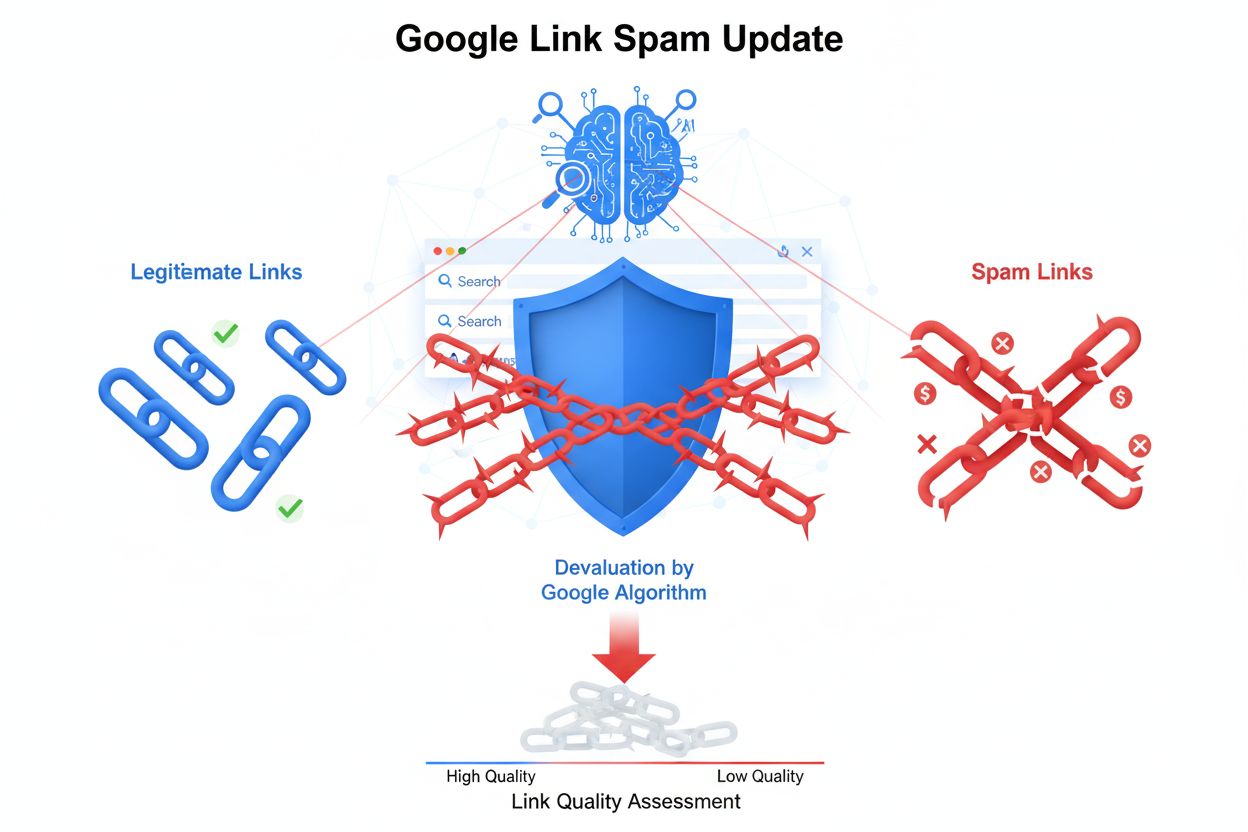

Algorytm Penguin działa w oparciu o zaawansowane uczenie maszynowe i systemy rozpoznawania wzorców, które analizują profile backlinków w celu wykrycia nienaturalnych schematów linkowania. Analizuje wiele czynników przy ocenie jakości linków, w tym autorytet i powiązanie tematyczne domen linkujących, anchor text użyty w linkach, szybkość pozyskiwania linków oraz kontekstualne powiązanie między stroną linkującą a docelową. Penguin celuje szczególnie w schematy linków, obejmujące szeroki zakres manipulacyjnych praktyk: kupowane linki, wymiany linków, linki z prywatnych sieci blogowych (PBN), linki z niskiej jakości katalogów oraz linki z przesadnie nasyconym słowami kluczowymi anchor textem. Algorytm ocenia również stosunek linków wysokiej jakości do niskiej jakości w profilu backlinków, uznając, że nawet autentyczne strony mogą czasem otrzymać niskiej jakości linki. Jednak gdy proporcja spamowych linków staje się zbyt wysoka, Penguin oznacza witrynę do potencjalnej korekty rankingu. Ważną cechą Penguina jest to, że analizuje tylko linki przychodzące do witryny; nie bada linków wychodzących z tej strony, skupiając się wyłącznie na jakości backlinków prowadzących do domeny.

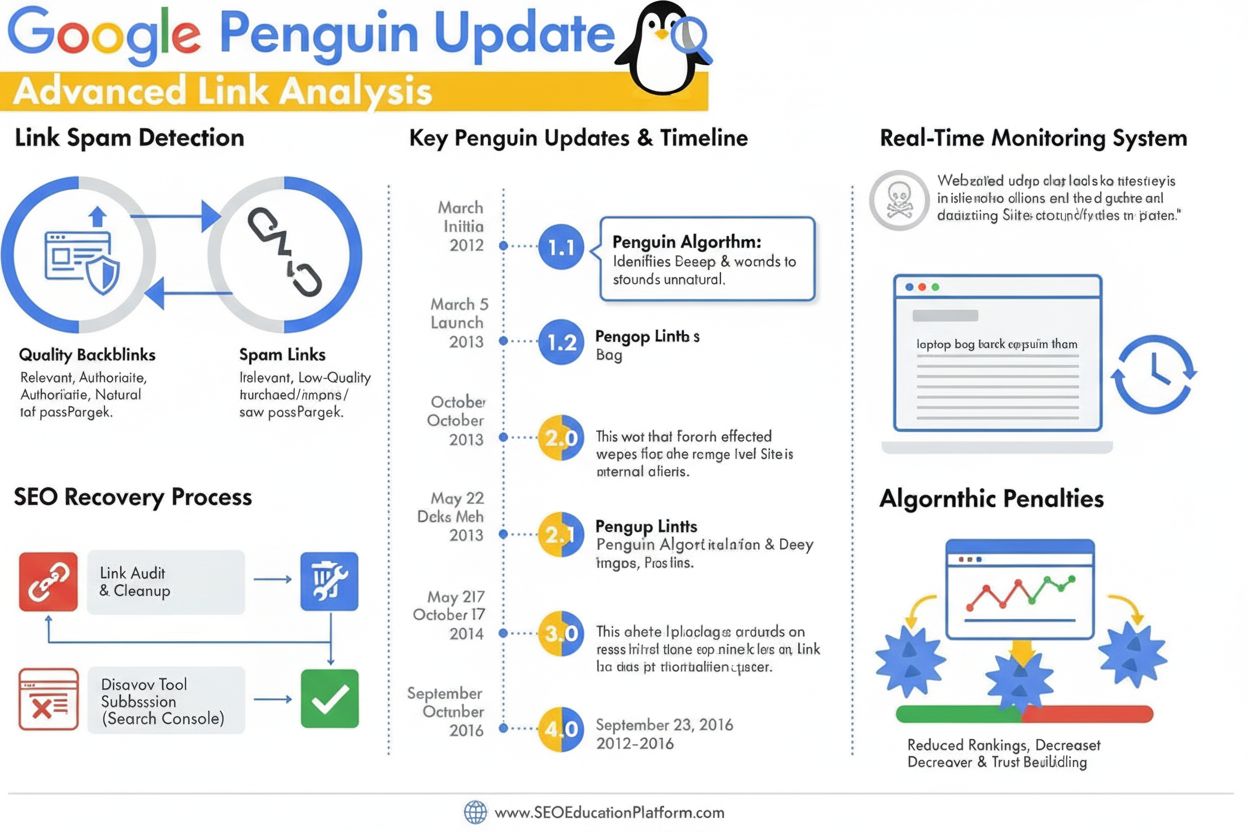

Aktualizacja Penguin przeszła znaczącą ewolucję od pierwotnego wdrożenia przez liczne iteracje, z których najbardziej przełomowa zmiana nastąpiła we wrześniu 2016 roku wraz z wprowadzeniem Penguin 4.0. Wcześniej Penguin działał w trybie aktualizacji wsadowych — Google ogłaszało okresowe odświeżenia, podczas których ponownie oceniano profile backlinków i odpowiednio korygowano rankingi. Penguin 1.1 (marzec 2012) i Penguin 1.2 (październik 2012) były odświeżeniami danych, pozwalającymi wcześniej ukaranym stronom na odzyskanie pozycji po oczyszczeniu profilu linków. Penguin 2.0 (maj 2013) to bardziej zaawansowana wersja, która wpłynęła na około 2,3% anglojęzycznych zapytań i jako pierwsza analizowała nie tylko stronę główną czy kategorie, ale także głębsze struktury witryn pod kątem spamu linkowego. Penguin 2.1 (październik 2013) i Penguin 3.0 (październik 2014) kontynuowały ten rozwój, wprowadzając kolejne ulepszenia wykrywania. Jednak wydanie Penguin 4.0 zasadniczo zmieniło działanie algorytmu, integrując go z głównym algorytmem Google jako komponent czasu rzeczywistego. Oznacza to, że strony są teraz oceniane nieustannie, a korekty pozycji następują natychmiast po zmianie profilu linków, bez oczekiwania na zaplanowane aktualizacje. Przejście na przetwarzanie w czasie rzeczywistym zmieniło również mechanizm karania: zamiast całkowitych sankcji rankingowych stosuje się dewaluację linków — spamowe linki są po prostu ignorowane, zamiast powodować ogólny spadek pozycji.

| Czynnik oceny | Linki wysokiej jakości | Linki niskiej jakości/spamowe | Wykrywanie przez Penguin |

|---|---|---|---|

| Autorytet źródła linku | Ugruntowane, zaufane domeny z wysokim autorytetem | Nowe domeny, strony o niskim DA lub znane sieci spamowe | Analizuje historię domeny, sygnały zaufania i powiązanie tematyczne |

| Anchor text | Naturalne, zróżnicowane, kontekstowo powiązane frazy | Frazy exact-match, powtarzalne, nadmiernie zoptymalizowane | Oznacza nienaturalne schematy anchorów i upychanie słów kluczowych |

| Szybkość pozyskiwania linków | Stopniowe, organiczne pozyskiwanie w czasie | Nagłe wzrosty lub nienaturalne schematy | Monitoruje tempo i spójność pozyskiwania |

| Powiązanie kontekstowe | Linki z tematycznie powiązanych, autorytatywnych źródeł | Linki z niepowiązanych lub niskiej jakości stron | Ocena powiązania semantycznego między źródłem a celem |

| Umiejscowienie linku | Linki redakcyjne w treści, naturalny kontekst | Linki w stopkach, paskach bocznych lub farmach linków | Analiza umiejscowienia i integracji linku w kontekście |

| Jakość strony linkującej | Wysokiej jakości treść, legalna działalność | Cienka treść, automatyczne strony lub PBN | Ocena ogólnej jakości strony i autentyczności treści |

| Status nofollow | Odpowiednio stosowany w razie potrzeby | Nadużywany lub brak przy linkach płatnych/sponsorowanych | Rozpoznaje prawidłowe użycie nofollow dla linków nieredakcyjnych |

Aktualizacja Penguin fundamentalnie zmieniła praktyki SEO, ustanawiając jakość linków jako kluczowy czynnik rankingowy i zniechęcając do powszechnych technik black-hat link-building. Przed Penguinem wiele agencji SEO i webmasterów prowadziło agresywne kampanie kupowania linków, wymian linków czy tworzenia PBN bez większych konsekwencji. Wdrożenie algorytmu wywołało natychmiastowe zamieszanie rynkowe, tysiące stron odnotowały gwałtowne spadki pozycji i ruchu. To zmusiło branżę SEO do przyjęcia etycznych, white-hat praktyk, opartych na zdobywaniu linków dzięki wysokiej jakości treści i autentycznym relacjom. Kara Penguin stała się przestrogą wpływającą na podejście firm do budowania linków, prowadząc do większych inwestycji w content marketing, public relations i budowanie marki jako główne strategie pozyskiwania linków. Badania branżowe wykazują, że zrozumienie i przestrzeganie wytycznych Penguina stało się kluczowe dla długoterminowego sukcesu SEO, a wiele organizacji wdrożyło audyt backlinków i monitorowanie linków jako standardowe działania. Algorytm podniósł również znaczenie autorytetu domeny, powiązania tematycznego oraz szybkości pozyskiwania linków jako kluczowych metryk ocenianych przez specjalistów SEO przy analizie szans linkowych. Obecnie ponad 78% przedsiębiorstw używa narzędzi do monitorowania treści wspieranych AI lub analizy linków dla śledzenia profilu backlinków i zgodności z wytycznymi Google, co jest bezpośrednią konsekwencją wpływu Penguina na standardy branżowe.

Wyjście z obniżenia przez Penguin wymaga systematycznego podejścia obejmującego audyt backlinków, usuwanie linków oraz strategiczne wykorzystanie narzędzia Google do zrzekania się linków. Pierwszym krokiem jest kompleksowy audyt wszystkich linków przychodzących przy użyciu Google Search Console oraz narzędzi zewnętrznych, takich jak Ahrefs, SEMrush czy Moz, które dostarczają szczegółowe profile backlinków i ich ocenę jakości. Następnie webmasterzy muszą indywidualnie ocenić każdą domenę linkującą, aby stwierdzić, czy link jest wartościowy i naturalny, czy pochodzi z manipulacyjnych praktyk. Dla linków ewidentnie spamowych lub niskiej jakości zaleca się kontakt z webmasterem strony linkującej i prośbę o usunięcie linku. Google wyraźnie odradza płacenie za usuwanie linków, ponieważ podtrzymuje to problem handlu linkami. Dla linków, których nie da się usunąć poprzez kontakt, narzędzie zrzekania się linków w Google Search Console umożliwia przesłanie pliku wskazującego Google, które linki należy zignorować podczas oceny witryny. Warto pamiętać, że zrzekając się linku, usuwasz także jego ewentualną pozytywną wartość, więc narzędzie należy stosować wyłącznie wobec rzeczywiście szkodliwych linków. Po przesłaniu pliku disavow Google przetwarza go natychmiast, jednak faktyczny wpływ na ranking zależy od momentu ponownego zindeksowania tych linków przez Google. Ponieważ Penguin 4.0 działa w czasie rzeczywistym, powrót pozycji może nastąpić dość szybko — czasem w ciągu kilku dni lub tygodni — po podjęciu wystarczających działań naprawczych. Nie należy jednak oczekiwać, że ranking wróci do poziomu sprzed kary, gdyż część dawnych pozycji mogła być sztucznie zawyżona przez usuwane niskiej jakości linki.

Wraz ze wzrostem znaczenia platform wyszukiwania AI, takich jak ChatGPT, Perplexity, Google AI Overviews i Claude, zrozumienie zasad Penguina nabiera znaczenia także poza tradycyjnymi wynikami wyszukiwania. Systemy AI często cytują autorytatywne źródła i wysokiej jakości strony podczas generowania odpowiedzi, a witryny z silnym profilem backlinków i czystą historią linków mają większą szansę być rozpoznawane jako autorytety przez dane treningowe i systemy wyszukiwania AI. Strona ukarana przez Penguina za spam linkowy może nie tylko stracić pozycje w organicznych wynikach Google, ale również być pomijana przez systemy AI oceniające wiarygodność źródeł. Z drugiej strony, strony utrzymujące czyste, wysokiej jakości profile backlinków są częściej cytowane jako autorytety w odpowiedziach generowanych przez AI. To tworzy dodatkową motywację do utrzymywania zgodności z Penguinem także poza tradycyjnymi metrykami SEO. AmICited i podobne platformy monitoringu AI pomagają organizacjom śledzić, jak ich domeny pojawiają się w odpowiedziach generowanych przez AI, zapewniając wgląd, czy ich autorytet jest rozpoznawany w różnych systemach wyszukiwania AI. Przecięcie zgodności z Penguinem i monitoringu cytowań AI stanowi nowy rozdział w marketingu cyfrowym, w którym jakość linków wpływa zarówno na tradycyjną widoczność w wyszukiwarkach, jak i na obecność w wynikach AI.

Aktualizacja Penguin nadal ewoluuje, gdy Google udoskonala rozumienie jakości linków i manipulacyjnych praktyk. Przejście na przetwarzanie w czasie rzeczywistym w 2016 roku było fundamentalną zmianą w działaniu algorytmu, jednak Google stale wzmacnia mechanizmy wykrywania dzięki uczeniu maszynowemu i sztucznej inteligencji. Niedawne udoskonalenia systemu SpamBrain ogłoszone przez Google w 2022 roku to kolejny etap rozwoju wykrywania spamu, opartego na zaawansowanej AI, która identyfikuje zarówno strony kupujące linki, jak i te służące do ich dystrybucji. Oznacza to, że kolejne iteracje wykrywania spamu linkowego będą jeszcze bardziej zaawansowane, co utrudni manipulacyjne praktyki unikanie wykrycia. Trend branżowy w kierunku white-hat SEO i earned media prawdopodobnie będzie się nasilał wraz ze wzrostem skuteczności algorytmów Google w rozróżnianiu linków naturalnych od sztucznych. Ponadto, wraz z wzrostem znaczenia platform wyszukiwania AI, konieczność utrzymywania czystych profili backlinków wykracza poza algorytm Google, obejmując szerszą rozpoznawalność jako autorytatywne źródło w różnych systemach AI. Organizacje, które priorytetowo traktują jakość linków, autorytet marki i doskonałość treści, będą lepiej przygotowane do odniesienia sukcesu zarówno w tradycyjnym SEO, jak i w nowych środowiskach wyszukiwania AI. Dziedzictwo aktualizacji Penguin to nie tylko konkretny algorytm, ale fundamentalna zmiana w sposobie, w jaki wyszukiwarki i systemy AI oceniają autorytet witryn, czyniąc jakość linków trwałym i coraz ważniejszym czynnikiem widoczności cyfrowej.

Obniżenie przez Penguin jest algorytmiczne i odbywa się automatycznie, gdy algorytm Penguin wykryje schematy spamu linkowego — nie wymaga interwencji manualnej. Kara Penguin (czyli ręczna akcja) jest nakładana przez zespół ds. spamu Google po ludzkiej weryfikacji i wymaga złożenia prośby o ponowne rozpatrzenie. Od czasu, gdy Penguin 4.0 stał się algorytmem czasu rzeczywistego w 2016 roku, z algorytmicznych obniżeń można wyjść niemal natychmiast po podjęciu działań naprawczych, podczas gdy ręczne kary wymagają wyraźnej akceptacji Google.

Aktualizacja Penguin wykorzystuje algorytmy uczenia maszynowego do analizy profili backlinków i identyfikacji manipulacyjnych schematów linkowania, w tym kupowanych linków, wymian linków, prywatnych sieci blogowych (PBN) oraz nienaturalnych schematów anchor textów. Algorytm ocenia stosunek wysokiej jakości, naturalnych linków do niskiej jakości, spamowych linków prowadzących do strony. Analizuje również trafność i autorytet domen linkujących, by określić, czy linki zostały pozyskane sztucznie, a nie redakcyjnie.

Tak, możliwe jest odzyskanie pozycji poprzez wieloetapowy proces obejmujący audyt backlinków, usuwanie spamowych linków i korzystanie z narzędzia Google do zrzekania się linków, których nie można usunąć bezpośrednio. Ponieważ Penguin 4.0 działa w czasie rzeczywistym, powrót może nastąpić względnie szybko po oczyszczeniu profilu linków i ponownym zindeksowaniu tych stron przez Google. Jednak odzyskanie pozycji nie gwarantuje powrotu do wcześniejszych rankingów, ponieważ część tych pozycji mogła być sztucznie zawyżona przez niskiej jakości linki, które usuwasz.

Penguin karze linki pochodzące z farm linków, płatnych sieci linkowych, prywatnych sieci blogowych (PBN), wzajemnych wymian linków oraz stron z nienaturalnymi schematami anchor textów. Algorytm celuje także w linki z niskiej jakości katalogów, spamu w komentarzach, forach oraz linki pozyskane manipulacyjnie. Dodatkowo Penguin oznacza linki z autorytatywnych stron, które wydają się być sprzedane lub umieszczone jako artykuły sponsorowane bez odpowiednich tagów nofollow, ponieważ narusza to wytyczne dotyczące schematów linków Google.

Od czasu wydania Penguin 4.0 we wrześniu 2016 roku, algorytm działa nieprzerwanie w czasie rzeczywistym jako część głównego algorytmu Google. Oznacza to, że Google stale ocenia profile backlinków oraz dostosowuje pozycje na podstawie jakości linków bez oczekiwania na zaplanowane aktualizacje. Wcześniej Penguin działał w trybie wsadowym z ogłaszanymi odświeżeniami, ale przetwarzanie w czasie rzeczywistym wyeliminowało potrzebę takich komunikatów i pozwala na szybsze odzyskiwanie pozycji po naprawie problemów.

Narzędzie do zrzekania się linków to funkcja w Google Search Console, która pozwala właścicielom stron poinformować Google, by zignorował określone backlinki przy ocenie witryny. Używa się go w ostateczności, gdy nie można skontaktować się z webmasterami w celu usunięcia spamowych linków. Zrzekając się niskiej jakości linków, zapobiegasz negatywnemu wpływowi tych linków na ranking w ramach algorytmu Penguin. Jednak zrzeknięte linki przestają też przynosić jakąkolwiek wartość, dlatego narzędzie należy stosować tylko wobec rzeczywiście szkodliwych linków.

Oryginalna aktualizacja Penguin, uruchomiona w kwietniu 2012 roku, według szacunków Google wpłynęła na ponad 3% wszystkich zapytań w wyszukiwarce. Kolejne aktualizacje miały różny wpływ: Penguin 2.0 dotknął około 2,3% anglojęzycznych zapytań, Penguin 2.1 około 1% zapytań, a Penguin 3.0 mniej niż 1% anglojęzycznych zapytań. Te wartości procentowe oznaczają miliony stron na całym świecie, czyniąc Penguin jedną z najważniejszych aktualizacji algorytmu w historii wyszukiwania.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

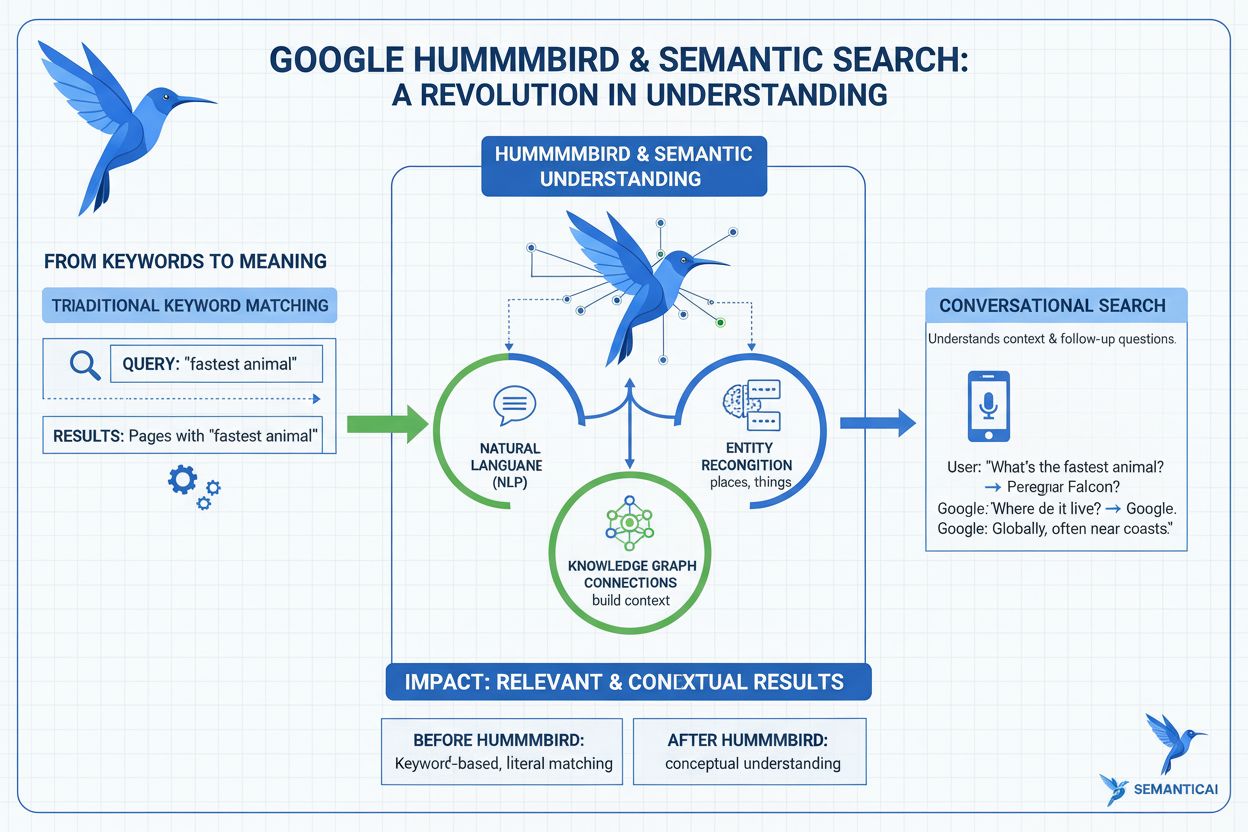

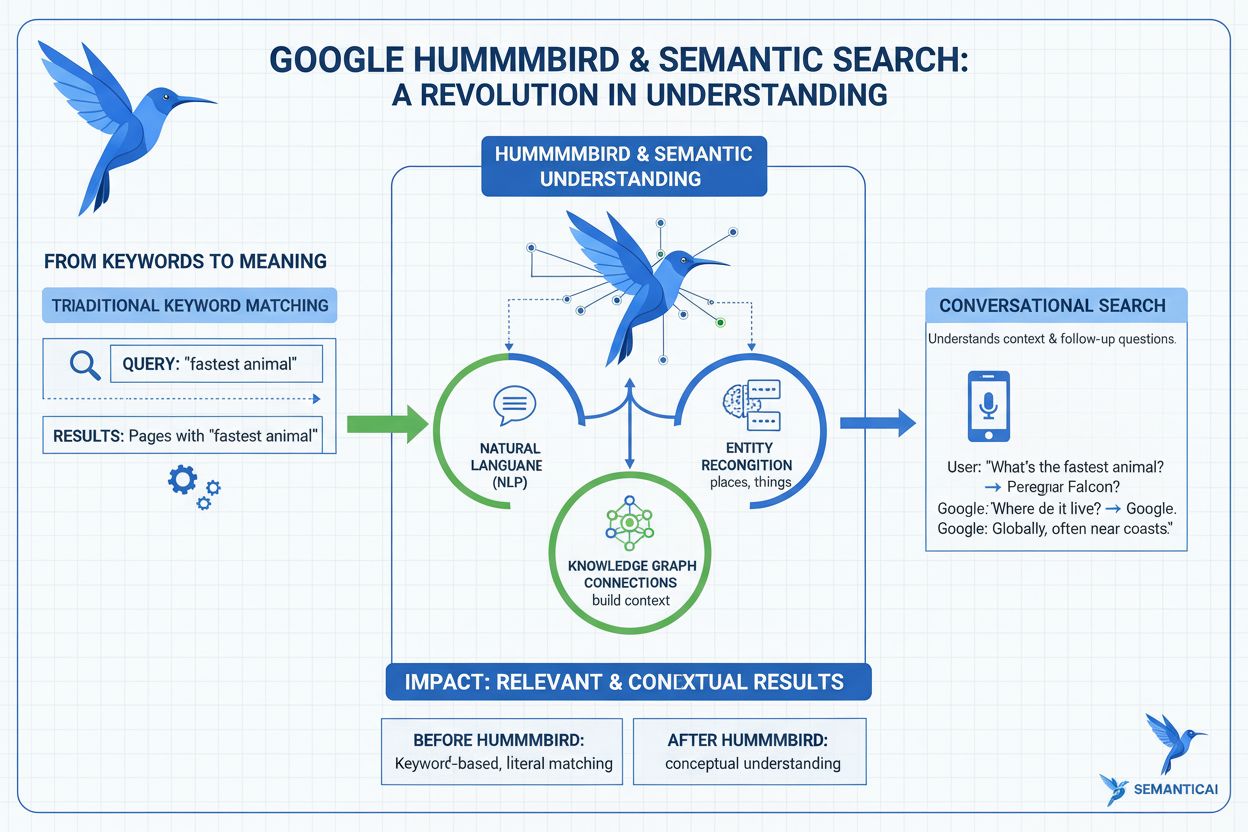

Dowiedz się, czym jest aktualizacja Hummingbird, jak zrewolucjonizowała semantyczne wyszukiwanie w 2013 roku i dlaczego ma znaczenie dla monitorowania AI oraz w...

Dowiedz się więcej o aktualizacji Panda Google, zmianie algorytmu z 2011 roku wymierzonej w treści niskiej jakości. Zrozum, jak działa, jaki ma wpływ na SEO ora...

Dowiedz się, czym jest Link Spam Update Google, która deprecjonuje manipulacyjne backlinki. Zrozum, jak SpamBrain wykrywa spam linkowy, wpływ na SEO oraz najlep...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.