Czym jest inżynieria promptów w wyszukiwaniu AI – Kompletny przewodnik

Dowiedz się, czym jest inżynieria promptów, jak działa z wyszukiwarkami AI, takimi jak ChatGPT i Perplexity, oraz odkryj kluczowe techniki optymalizacji wyników...

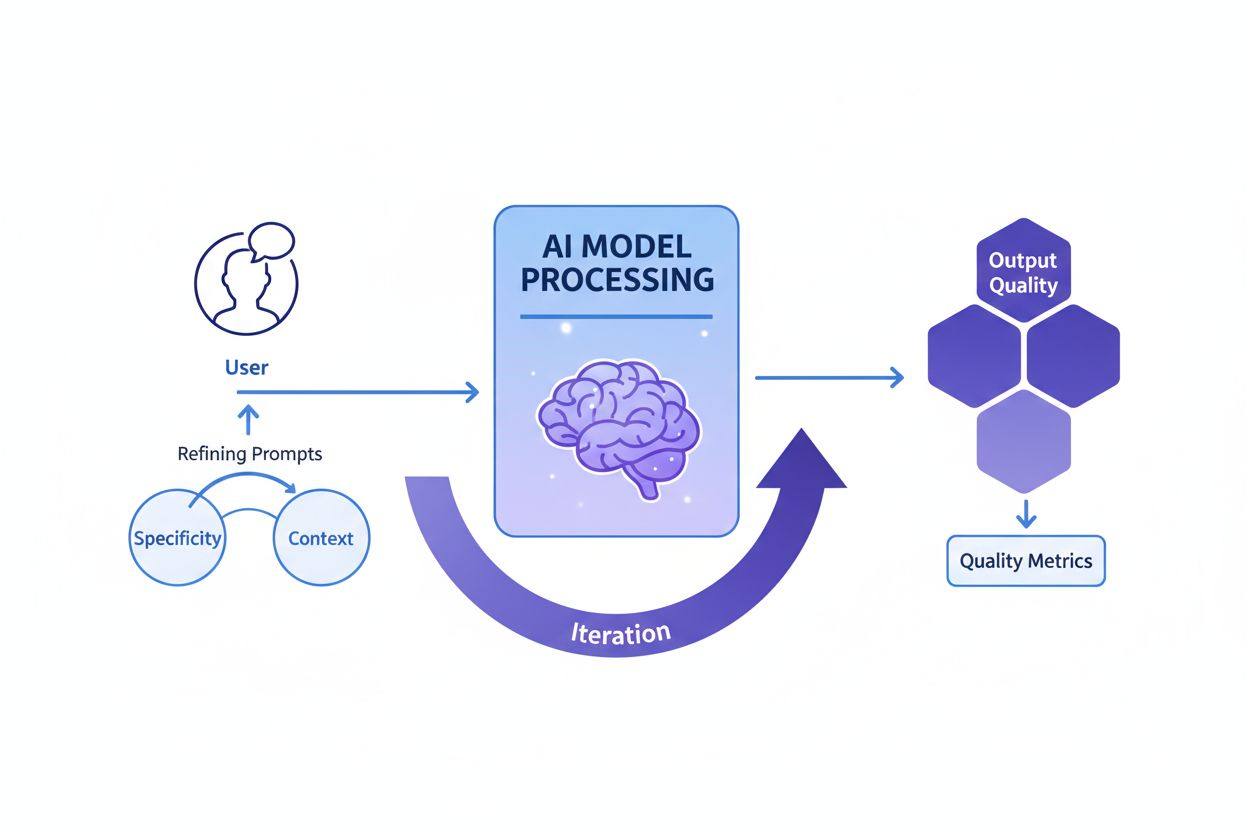

Inżynieria promptów to proces tworzenia, udoskonalania i optymalizacji instrukcji w języku naturalnym mających na celu ukierunkowanie generatywnych modeli AI na produkcję pożądanych, dokładnych i trafnych rezultatów. Polega na iteracyjnych eksperymentach z formułowaniem treści, kontekstem oraz strukturą, aby zmaksymalizować wydajność AI bez modyfikacji samego modelu.

Inżynieria promptów to proces tworzenia, udoskonalania i optymalizacji instrukcji w języku naturalnym mających na celu ukierunkowanie generatywnych modeli AI na produkcję pożądanych, dokładnych i trafnych rezultatów. Polega na iteracyjnych eksperymentach z formułowaniem treści, kontekstem oraz strukturą, aby zmaksymalizować wydajność AI bez modyfikacji samego modelu.

Inżynieria promptów to systematyczny proces projektowania, udoskonalania i optymalizacji instrukcji w języku naturalnym – zwanych promptami – w celu ukierunkowania generatywnych modeli AI na generowanie pożądanych, dokładnych i kontekstowo trafnych rezultatów. Zamiast modyfikować sam model AI, inżynierowie promptów pracują z istniejącymi możliwościami modelu, starannie konstruując dane wejściowe, by wpłynąć na sposób przetwarzania informacji i generowania odpowiedzi przez model. Ta dziedzina pojawiła się jako kluczowa umiejętność podczas boomu generatywnej AI w latach 2023-2025, kiedy organizacje zdały sobie sprawę, że sam dostęp do potężnych narzędzi AI takich jak ChatGPT, Claude, Perplexity i Google AI nie wystarcza bez umiejętności skutecznej komunikacji z tymi systemami. Inżynieria promptów wypełnia lukę między intencją człowieka a możliwościami AI, przekształcając niejasne cele biznesowe w konkretne, wysokiej jakości wyniki AI. Praktyka ta ma charakter iteracyjny i wymaga ciągłego eksperymentowania, testowania i udoskonalania, aby osiągać optymalne rezultaty dla konkretnych zastosowań.

Koncepcja inżynierii promptów wyłoniła się naturalnie po publicznej premierze ChatGPT w listopadzie 2022 roku, gdy miliony użytkowników zaczęły eksperymentować z uzyskiwaniem lepszych wyników z dużych modeli językowych. Wczesni użytkownicy odkryli, że jakość odpowiedzi AI zależy w dużym stopniu od sposobu sformułowania pytania, dostarczonego kontekstu oraz precyzji instrukcji. Ta obserwacja doprowadziła do sformalizowania inżynierii promptów jako osobnej dziedziny. Już w 2023 roku największe firmy technologiczne, takie jak OpenAI, Google, Microsoft i Anthropic zaczęły zatrudniać dedykowanych inżynierów promptów, oferując niektórym z nich wynagrodzenia przekraczające 300 000 dolarów rocznie. Światowy rynek inżynierii promptów został wyceniony na około 222,1 mln dolarów w 2023 roku, a prognozuje się, że do 2030 roku osiągnie wartość 2,06 miliarda dolarów, co oznacza dynamiczny wzrost (CAGR). Tak szybki rozwój rynku odzwierciedla rosnące uznanie, że inżynieria promptów to nie chwilowy trend, lecz fundamentalna umiejętność dla organizacji wykorzystujących AI na szeroką skalę. Dziedzina ta ewoluowała od prostych eksperymentów metodą prób i błędów do zaawansowanej praktyki obejmującej sprawdzone techniki, ramy ewaluacyjne i najlepsze praktyki dokumentowane przez czołowe instytucje badawcze i praktyków branży AI.

Skuteczna inżynieria promptów opiera się na kilku fundamentalnych zasadach, które odróżniają wysokiej jakości prompty od nieskutecznych. Precyzja jest kluczowa – im bardziej szczegółowy i opisowy jest prompt, tym lepiej model AI zrozumie wymagania i wygeneruje zgodne wyniki. Zamiast prosić AI o „napisz o psach”, lepszym promptem będzie „stwórz 300-słowny poradnik weterynaryjny dotyczący zdrowia golden retrieverów, skierowany do właścicieli zwierząt z wykształceniem na poziomie 8 klasy, z naciskiem na profilaktykę”. Dostarczanie kontekstu jest równie istotne; odpowiednie tło, przykłady lub ograniczenia pomagają modelowi zawęzić zakres i uzyskać trafniejsze odpowiedzi. Jasność zapewnia, że polecenia są jednoznaczne i bezpośrednio komunikują zadanie bez konieczności interpretowania niejasności. Iteracyjne udoskonalanie zakłada, że pierwszy prompt rzadko daje najlepsze wyniki; skuteczni inżynierowie promptów stale testują warianty, analizują rezultaty i modyfikują podejście. Dopasowanie tonu i stylu polega na określeniu pożądanego charakteru wypowiedzi, stopnia formalności i formatu prezentacji, by odpowiedzi były zgodne z oczekiwaniami organizacji lub użytkownika. Zasady te obowiązują na wszystkich platformach AI, niezależnie czy tworzymy prompty do ChatGPT, Perplexity, Claude czy Google AI Overviews, czyniąc je uniwersalnie wartościowymi dla każdego, kto chce zoptymalizować interakcje z AI.

Dziedzina inżynierii promptów wypracowała wiele zaawansowanych technik, dostosowanych do różnych typów zadań i poziomów złożoności. Zero-shot prompting to najprostsze podejście, polegające na podaniu AI jasnej instrukcji lub pytania bez dodatkowych przykładów czy kontekstu. Metoda ta dobrze sprawdza się przy prostych zadaniach, ale może mieć trudności z bardziej złożonym rozumowaniem. Few-shot prompting poprawia skuteczność, dostarczając modelowi jeden lub kilka przykładów, które pokazują pożądany format wyjścia lub sposób rozumowania, tym samym „ucząc” model przez demonstrację. Chain-of-thought (CoT) prompting rozbija złożone problemy na pośrednie etapy rozumowania, zachęcając model do „pokazania toku myślenia” i poprawiając dokładność w zadaniach wieloetapowych. Prompt chaining dzieli skomplikowane zadanie na mniejsze, kolejno realizowane podzadania, wykorzystując wynik jednego promptu jako wejście do kolejnego, co zwiększa niezawodność i spójność skomplikowanych procesów. Tree-of-thought prompting uogólnia chain-of-thought, pozwalając modelowi eksplorować równocześnie kilka możliwych ścieżek rozumowania i wybrać najbardziej obiecującą. Maieutyczne promptowanie polega na proszeniu modelu o wyjaśnienie rozumowania, a następnie zadawaniu pytań pogłębiających konkretne fragmenty wyjaśnienia, co pomaga wykrywać i korygować niespójności. Generated knowledge prompting nakazuje modelowi najpierw wygenerować przydatne fakty lub informacje tła przed podjęciem głównego zadania, co kondycjonuje model na istotny kontekst. Self-refine prompting polega na tym, że model rozwiązuje problem, ocenia własne rozwiązanie, a następnie poprawia je na podstawie tej oceny, powtarzając proces aż do uzyskania satysfakcjonujących wyników. Każda z technik służy innym celom, a najskuteczniejsza inżynieria promptów często łączy kilka metod strategicznie dobranych do realizowanego zadania.

| Technika | Najlepsze dla | Złożoność | Typowy przypadek użycia | Skuteczność |

|---|---|---|---|---|

| Zero-shot Prompting | Proste, bezpośrednie zadania | Niska | Podstawowe pytania, nieskomplikowane polecenia | Dobre dla prostych zadań, ograniczone przy złożonym rozumowaniu |

| Few-shot Prompting | Zadania wymagające spójności formatowania | Średnia | Generowanie treści, klasyfikacja, formatowanie | Świetne do pokazania oczekiwanego schematu odpowiedzi |

| Chain-of-Thought | Zadania wymagające rozumowania wieloetapowego | Średnio-wysoka | Zadania matematyczne, dedukcja logiczna, analiza | Znacząco poprawia dokładność w złożonych zadaniach |

| Prompt Chaining | Złożone procesy z zależnościami | Wysoka | Wieloetapowe tworzenie treści, przetwarzanie danych | Świetnie sprawdza się w rozbijaniu skomplikowanych problemów |

| Tree-of-Thought | Problemy z wieloma ścieżkami rozwiązań | Wysoka | Planowanie strategiczne, kreatywne rozwiązywanie problemów | Doskonałe do eksploracji alternatywnych podejść |

| Generated Knowledge | Zadania wymagające kontekstu | Średnia | Pytania branżowe, wyjaśnienia techniczne | Poprawia trafność i dokładność przez dostarczenie kontekstu |

| Self-Refine | Zastosowania wymagające wysokiej jakości | Wysoka | Pisanie profesjonalne, dokumentacja techniczna | Najwyższa jakość wyników dzięki iteracji |

Zrozumienie, jak prompty wpływają na zachowanie modeli AI, wymaga podstawowej wiedzy o funkcjonowaniu dużych modeli językowych (LLM). Modele te przetwarzają tekst, dzieląc go na tokeny (małe fragmenty tekstu), a następnie przewidują najbardziej prawdopodobny kolejny token na podstawie wzorców poznanych podczas treningu. Prompt pełni rolę początkowego kontekstu, który kształtuje wszystkie kolejne przewidywania. Gdy prompt zawiera konkretne instrukcje, przykłady lub ograniczenia, zawęża rozkład prawdopodobieństwa możliwych wyjść, kierując model na odpowiedzi zgodne z intencją. Parametry temperature i top-p sampling dodatkowo wpływają na zmienność wyników – niższa temperatura daje bardziej przewidywalne, skupione odpowiedzi, wyższa – większą kreatywność i różnorodność. Okno kontekstowe (ilość tekstu, którą model może brać pod uwagę) ogranicza, ile informacji można zawrzeć w promptcie; dłuższe prompty zajmują więcej miejsca, co może zmniejszać przestrzeń na właściwe zadanie. Skuteczni inżynierowie promptów rozumieją te ograniczenia techniczne i konstruują prompty, które mieszczą się w tych ramach. Dla organizacji monitorujących widoczność marki na platformach AI za pomocą takich narzędzi jak AmICited, zrozumienie tych mechanizmów jest kluczowe, ponieważ to właśnie prompty użytkowników decydują, jakie informacje system AI pobierze i zacytuje. Dobrze skonstruowany prompt typu „wymień trzy największe firmy w chmurze obliczeniowej” przyniesie inne rezultaty niż „wymień innowacyjne firmy chmurowe założone po 2015 roku”, co może wpłynąć na to, które marki zyskają widoczność w odpowiedziach generowanych przez AI.

Skuteczna implementacja inżynierii promptów w organizacjach wymaga stosowania sprawdzonych najlepszych praktyk wypracowanych zarówno przez naukę, jak i branżę. Zaczynaj od prostych rozwiązań i iteruj – to podstawowa zasada; startuj od prostego promptu i stopniowo wprowadzaj złożoność, testując na każdym etapie, by zrozumieć, jakie zmiany poprawiają wyniki. Wyrażaj wymagania wprost, jasno określając oczekiwany format wyjścia, długość, ton i wszelkie ograniczenia; niejasne prompty dają niejasne odpowiedzi. Dostarczaj istotny kontekst, ale nie przeciążaj modelu; uwzględniaj tylko informacje potrzebne do zrozumienia zadania, by nie zajmować niepotrzebnie okna kontekstowego. Używaj wyraźnych separatorów, takich jak „###” lub „—”, aby rozdzielać różne sekcje promptu (instrukcje, kontekst, przykłady), co ułatwia modelowi analizę struktury. Unikaj negacji – wyrażaj, czego oczekujesz, zamiast czego nie chcesz; zamiast „nie bądź zbyt formalny”, napisz „użyj tonu konwersacyjnego”. Testuj różne warianty systematycznie, zmieniając jeden element na raz, by zrozumieć, co wpływa na poprawę wyników. Dokumentuj skuteczne prompty w centralnym repozytorium, tworząc bibliotekę sprawdzonych szablonów do ponownego wykorzystania i modyfikacji przez zespoły. Monitoruj wskaźniki wydajności, takie jak dokładność, trafność, spójność i satysfakcja użytkownika, by obiektywnie ocenić, czy prompty osiągają zamierzone cele. Wprowadzaj pętle zwrotne, w których opinie użytkowników bezpośrednio wpływają na udoskonalanie promptów, tworząc cykl ciągłego doskonalenia. Organizacje wdrażające te praktyki odnotowują znaczną poprawę jakości i spójności wyników AI, skracając czas poświęcany na ręczne poprawki.

Relacja między inżynierią promptów a monitorowaniem widoczności AI nabiera coraz większego znaczenia dla organizacji chcących zrozumieć, jak ich marki, produkty i treści pojawiają się w odpowiedziach generowanych przez AI. Platformy takie jak AmICited śledzą wzmianki o marce na ChatGPT, Perplexity, Google AI Overviews i Claude, ale to właśnie prompty wprowadzone przez użytkowników do tych systemów bezpośrednio decydują, jakie informacje AI pobierze i zacytuje. Organizacje rozumiejące inżynierię promptów mogą konstruować strategiczne zapytania, by sprawdzić, jak prezentuje się ich marka, jakie firmy konkurencyjne są wymieniane obok nich i czy ich treści są poprawnie cytowane. Przykładowo, firma może skonstruować prompt „Jakie są najlepsze rozwiązania do zarządzania danymi przedsiębiorstw?”, by zobaczyć, jak AI pozycjonuje jej ofertę względem konkurencji. Analizując prompty, które generują pozytywne lub negatywne wzmianki o marce, organizacje mogą budować strategie treściowe zwiększające widoczność w odpowiedziach generowanych przez AI. Jest to nowy obszar optymalizacji pod wyszukiwarki (SEO) i zarządzania marką, gdzie umiejętność komunikacji z AI staje się równie ważna, jak tradycyjne pozycjonowanie słów kluczowych. Firmy inwestujące w kompetencje z zakresu inżynierii promptów zyskują przewagę strategiczną w środowisku informacyjnym napędzanym przez AI, zapewniając swojej marce odpowiednią widoczność i rzetelną reprezentację.

Aby stwierdzić, czy dany prompt jest skuteczny, należy zdefiniować jasne, obiektywne kryteria zgodne z celami biznesowymi. Dokładność mierzy, czy wyniki są zgodne z faktami – szczególnie ważne w branżach takich jak zdrowie, finanse czy prawo, gdzie błędy mogą mieć poważne konsekwencje. Trafność ocenia, na ile wynik odpowiada pierwotnej intencji użytkownika, często mierzona przez semantyczną zgodność lub ocenę ręczną. Spójność sprawdza, czy identyczne prompty dają podobne odpowiedzi przy wielokrotnym uruchomieniu – istotne w zastosowaniach wymagających niezawodności. Kompletność określa, czy odpowiedzi obejmują wszystkie wymagane elementy, mierzona jako stosunek pokrytych komponentów do wszystkich wymaganych. Szczegółowość ocenia poziom detalu w odpowiedziach, ważny np. dla dokumentacji technicznej. Czytelność i spójność logiczna mierzą przejrzystość i płynność wypowiedzi, oceniane przez wzory czytelności lub ludzi. Satysfakcja użytkownika odzwierciedla zadowolenie z odpowiedzi, zwykle badana w ankietach lub przez mechanizmy opinii. Organizacje wdrażające kompleksowe ramy ewaluacyjne raportują, że skuteczność promptów wzrasta o 40–60% dzięki systematycznej ocenie i doskonaleniu. Narzędzia takie jak Portkey, DSPy czy Evaluate Library Hugging Face umożliwiają automatyczne pomiary tych aspektów, a platformy A/B testingowe pozwalają porównywać różne wersje promptów. Najbardziej zaawansowane firmy łączą wiele metod ewaluacji, nadając wagę poszczególnym wskaźnikom zgodnie z priorytetami, by uzyskać końcowy wynik jakości promptu.

Rynek pracy dla inżynierów promptów dynamicznie rośnie, co odzwierciedla kluczowe znaczenie tej umiejętności w erze AI. W 2025 roku Glassdoor podaje średnią pensję podstawową na poziomie 123 274 USD rocznie dla inżynierów promptów, przy ofertach od 90 000 USD (25. percentyl) do ponad 335 000 USD w wyspecjalizowanych rolach w czołowych firmach AI, takich jak Anthropic. Portal Indeed prezentuje ponad 110 000 otwartych ofert pracy na stanowisko prompt engineer, co wskazuje na utrzymujący się popyt w różnych branżach. Wielkie firmy technologiczne takie jak Google, Microsoft, Amazon i Meta aktywnie rekrutują inżynierów promptów, oferując wynagrodzenia od 110 000 do 250 000 USD. Firmy AI jak OpenAI, Anthropic, Cohere czy Midjourney zapewniają wyzwania na najwyższym poziomie, zdalną kulturę pracy i atrakcyjne pakiety udziałów. Duże przedsiębiorstwa z sektorów finansów, zdrowia, ubezpieczeń i innych branż regulowanych zatrudniają inżynierów promptów do integracji AI, często pod tytułami „AI Solutions Architect”. Firmy konsultingowe – zarówno Wielka Czwórka, jak i wyspecjalizowane podmioty jak Booz Allen Hamilton – oferują stanowiska do 212 000 USD w projektach rządowych i korporacyjnych. Oferty freelancerskie na portalach takich jak Upwork czy Toptal sięgają 100–300 USD za godzinę dla doświadczonych specjalistów. Typowa ścieżka kariery wymaga dyplomu z informatyki lub pokrewnej dziedziny, choć przedstawiciele takich profesji jak pisarstwo, dziennikarstwo czy kreatywność również odnoszą sukcesy jako inżynierowie promptów. Najważniejsze jest jednak wykazanie praktycznych umiejętności z narzędziami AI, portfolio pokazujące kompetencje w inżynierii promptów oraz ciągła nauka zgodnie z rozwojem dziedziny.

Inżynieria promptów stoi przed dużą ewolucją wraz z rozwojem technologii AI i dojrzewaniem praktyk organizacyjnych. Promptowanie multimodalne będzie coraz częściej łączyć tekst, kod, obrazy i inne typy danych w pojedynczych promptach, wymagając od inżynierów zrozumienia interakcji różnych modalności w systemach AI. Adaptacyjne prompty, automatycznie dostosowujące się do kontekstu, zachowań użytkownika i informacji zwrotnej w czasie rzeczywistym, staną się coraz bardziej zaawansowane, przechodząc od statycznych szablonów do dynamicznych, responsywnych systemów. Inżynieria kontekstu wyłania się jako ewolucja inżynierii promptów, kładąc nacisk na szerszy kontekst działania promptu, nie tylko na samą jego treść. Etyczne i sprawiedliwe promptowanie zyska na znaczeniu, gdy organizacje będą priorytetyzować odpowiedzialne wdrażanie AI, z promptami projektowanymi explicite do ograniczania stronniczości, zapewniania transparentności i zgodności z regulacjami. Integracja z agentami AI zatarze granicę między inżynierią promptów a szeroko pojętą orkiestracją AI, gdy prompty staną się elementami większych autonomicznych systemów. Rola „inżyniera promptów” może ewoluować lub łączyć się z innymi stanowiskami, takimi jak „strateg AI”, „inżynier kontekstu” czy „AI product manager”, co odzwierciedla dojrzewanie branży. Organizacje inwestujące dziś w kompetencje z zakresu inżynierii promptów będą liderami gospodarki napędzanej przez AI, bo umiejętność skutecznej komunikacji i kierowania systemami AI staje się coraz bardziej kluczowa dla przewagi konkurencyjnej. Dla firm korzystających z AmICited do monitorowania widoczności marki w odpowiedziach AI, wiedza z zakresu inżynierii promptów stanie się niezbędna do optymalizacji obecności w wynikach wyszukiwania AI i zapewnienia rzetelnej reprezentacji na platformach takich jak ChatGPT, Perplexity, Google AI czy Claude.

Inżynieria promptów zasadniczo różni się od tradycyjnego programowania: zamiast pisania kodu, który bezpośrednio kontroluje zachowanie, inżynierowie promptów kierują modelami AI za pomocą instrukcji w języku naturalnym. Programowanie tradycyjne wymaga precyzyjnej składni i logiki, natomiast inżynieria promptów opiera się na iteracyjnym udoskonalaniu, dostarczaniu kontekstu i strategicznym formułowaniu poleceń, by ukierunkować AI na pożądane wyniki. Obie dziedziny wymagają umiejętności rozwiązywania problemów, jednak inżynieria promptów kładzie nacisk na komunikację i eksperymentowanie zamiast ścisłej składni kodu.

Inżynieria promptów bezpośrednio wpływa na to, jak marki pojawiają się w odpowiedziach generowanych przez AI na platformach takich jak ChatGPT, Perplexity, Google AI Overviews czy Claude. Dobrze opracowane prompty mogą decydować o tym, czy i jak systemy AI cytują, wspominają lub rekomendują marki. Dla organizacji korzystających z narzędzi takich jak AmICited do monitorowania widoczności AI, zrozumienie inżynierii promptów pomaga przewidywać i optymalizować sposób prezentacji marki w odpowiedziach AI, zapewniając rzetelną reprezentację i konkurencyjną pozycję w środowisku wyszukiwania AI.

Kluczowe techniki to m.in. chain-of-thought prompting (dzielenie złożonych problemów na etapy), few-shot prompting (podawanie przykładów), zero-shot prompting (bezpośrednie instrukcje), prompt chaining (rozdzielanie zadań na podzadania) oraz tree-of-thought prompting (badanie wielu ścieżek rozumowania). Skuteczność każdej metody zależy od złożoności zadania, możliwości modelu oraz oczekiwanego typu wyniku. Najlepsze rezultaty osiąga się, łącząc różne techniki dopasowane do konkretnych przypadków użycia.

Skuteczność promptów mierzy się za pomocą wskaźników takich jak dokładność (prawdziwość odpowiedzi), trafność (zgodność z intencją), spójność (powtarzalność), kompletność (pokrycie wymaganych elementów) oraz satysfakcja użytkownika. Metody oceny obejmują przeglądy manualne, automatyczną ocenę za pomocą narzędzi takich jak BLEU i ROUGE, testy A/B różnych wersji promptów oraz zbieranie bezpośrednich opinii użytkowników. Organizacje często łączą wiele wskaźników w ważoną ocenę odzwierciedlającą ich priorytety.

Inżynierowie promptów powinni mieć silne umiejętności komunikacyjne i pisarskie, rozumieć działanie dużych modeli językowych, znać pojęcia AI takie jak tokenizacja i okna kontekstowe oraz wykazywać się kreatywnym rozwiązywaniem problemów. Umiejętności techniczne z zakresu Pythona, SQL czy JavaScript są często mile widziane, lecz nie zawsze wymagane. Ekspertyza branżowa (np. zdrowie, finanse, prawo) jest wysoko ceniona. Najważniejsze jednak, by inżynier promptów wykazywał się ciągłą nauką i eksperymentowaniem.

Inżynieria promptów jest kluczowa dla monitorowania AI, ponieważ to właśnie prompty wprowadzane do systemów AI determinują, jakie informacje zostaną pobrane i zacytowane. Dzięki zrozumieniu inżynierii promptów organizacje mogą konstruować zapytania, które pozwolą im odkryć, jak ich marka, treści czy branża pojawiają się w odpowiedziach AI. AmICited śledzi te wystąpienia na wielu platformach AI, co sprawia, że wiedza o inżynierii promptów jest niezbędna do optymalizacji widoczności marki w treściach generowanych przez AI.

Rynek pracy dla inżynierów promptów pozostaje silny, ze średnimi zarobkami około 123 274 USD rocznie według Glassdoor oraz stanowiskami w przedziale od 90 000 do ponad 335 000 USD w zależności od doświadczenia i firmy. Obecnie na portalach pracy jest ponad 110 000 ofert na stanowisko prompt engineer. Obszar ten ewoluuje od wyspecjalizowanej roli ku szerszym obowiązkom integracji AI, z możliwościami pracy w firmach technologicznych, przedsiębiorstwach, konsultingu i na platformach freelancerskich. Praca zdalna jest powszechna, co zmniejsza znaczenie lokalizacji geograficznej.

Oczekuje się, że inżynieria promptów będzie ewoluować w kierunku promptów multimodalnych (łączenie tekstu, kodu i obrazów), adaptacyjnych promptów dostosowujących się do kontekstu oraz większego nacisku na etykę i sprawiedliwość AI. Wraz ze wzrostem możliwości modeli AI, inżynieria promptów może połączyć się z szerszą strategią AI oraz inżynierią kontekstu. Dziedzina ta będzie podkreślać odpowiedzialne praktyki AI, ograniczanie stronniczości oraz zapewnianie transparentności wyników generowanych przez AI na platformach monitorowanych przez AmICited.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, czym jest inżynieria promptów, jak działa z wyszukiwarkami AI, takimi jak ChatGPT i Perplexity, oraz odkryj kluczowe techniki optymalizacji wyników...

Dowiedz się, jak inżynieria promptów wzmacnia strategię GEO, aby Twoja marka była cytowana przez AI, takie jak ChatGPT, Perplexity i Google AI Overviews.

Dyskusja społeczności na temat tego, czy marketerzy muszą posiadać umiejętności inżynierii promptów, aby optymalizować pod kątem wyszukiwania AI. Zrozumienie, j...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.