Jak znaleźć luki w treści dla wyszukiwania AI – Kompleksowa strategia

Dowiedz się, jak identyfikować luki w treści dla wyszukiwarek AI, takich jak ChatGPT i Perplexity. Poznaj metody analizy widoczności LLM, znajdowania brakującyc...

Problemy z bezpieczeństwem i luki w zabezpieczeniach stron internetowych to słabości w infrastrukturze, kodzie lub konfiguracji witryny, które narażają ją na cyberataki, złośliwe oprogramowanie i wycieki danych, bezpośrednio szkodząc pozycjom w wyszukiwarkach, ruchowi organicznemu i zaufaniu użytkowników. Gdy wyszukiwarki, takie jak Google, wykrywają luki w zabezpieczeniach, karzą dotknięte strony spadkami w rankingach, umieszczaniem na czarnych listach lub całkowitym usunięciem z wyników wyszukiwania, co sprawia, że bezpieczeństwo witryny staje się kluczowym czynnikiem rankingowym SEO.

Problemy z bezpieczeństwem i luki w zabezpieczeniach stron internetowych to słabości w infrastrukturze, kodzie lub konfiguracji witryny, które narażają ją na cyberataki, złośliwe oprogramowanie i wycieki danych, bezpośrednio szkodząc pozycjom w wyszukiwarkach, ruchowi organicznemu i zaufaniu użytkowników. Gdy wyszukiwarki, takie jak Google, wykrywają luki w zabezpieczeniach, karzą dotknięte strony spadkami w rankingach, umieszczaniem na czarnych listach lub całkowitym usunięciem z wyników wyszukiwania, co sprawia, że bezpieczeństwo witryny staje się kluczowym czynnikiem rankingowym SEO.

Problemy z bezpieczeństwem i luki w zabezpieczeniach stron internetowych oznaczają słabości w infrastrukturze, kodzie lub konfiguracji witryny, które narażają ją na cyberataki, infekcje złośliwym oprogramowaniem, wycieki danych oraz nieautoryzowany dostęp. Luki te obejmują zarówno nieaktualne oprogramowanie i słabe hasła, jak i niezałatane wtyczki, błędy SQL injection czy podatności typu cross-site scripting (XSS). Gdy wyszukiwarki, takie jak Google, wykrywają luki bezpieczeństwa na stronie, traktują ją jako zagrożenie dla użytkowników i nakładają poważne kary, takie jak obniżenie pozycji, wyświetlanie ostrzeżeń o zagrożeniu, a w skrajnych przypadkach – całkowite usunięcie z wyników wyszukiwania. To sprawia, że bezpieczeństwo strony internetowej to nie tylko kwestia IT, ale kluczowy czynnik rankingowy SEO bezpośrednio wpływający na widoczność organiczną, ruch i przychody. Według danych branżowych, średnio 30 000 stron internetowych jest codziennie hakowanych na całym świecie, z czego 43% ataków dotyczy małych firm, niezależnie od ich wielkości czy branży. Związek bezpieczeństwa z SEO stał się na tyle istotny, że Google już w 2014 roku potwierdził HTTPS jako czynnik rankingowy, i nadal traktuje bezpieczeństwo jako wskaźnik jakości w algorytmach rankingowych.

Powiązanie bezpieczeństwa strony internetowej z optymalizacją pod kątem wyszukiwarek pojawiało się stopniowo, w miarę jak wyszukiwarki rozwijały kryteria rankingowe. Na początku lat 2000 bezpieczeństwo było głównie problemem IT, mającym niewielki wpływ na SEO. Jednak wraz z tym, jak Google i inne wyszukiwarki zaczęły stawiać na doświadczenie i bezpieczeństwo użytkowników, krajobraz zmienił się radykalnie. Inicjatywa Google Safe Browsing, uruchomiona w 2007 roku, była przełomem – wprowadziła ona bieżące sprawdzanie witryn pod kątem złośliwego oprogramowania, phishingu i innych zagrożeń. W 2014 roku Google oficjalnie ogłosiło, że certyfikaty HTTPS/SSL staną się czynnikiem rankingowym, dając stronom z szyfrowanym połączeniem przewagę konkurencyjną w wynikach wyszukiwania. Ta decyzja pokazała, że bezpieczeństwo nie jest już opcjonalne – stało się integralną częścią strategii SEO.

Obecnie stawka jest wyższa niż kiedykolwiek. Badania Cyber Management Alliance wskazują, że 57% organizacji traktuje dziś cyberbezpieczeństwo jako przewagę konkurencyjną, bezpośrednio związaną z budowaniem zaufania klientów i utrzymaniem widoczności w wyszukiwarce. Średni koszt wycieku danych osiągnął 4,45 mln dolarów globalnie (raport IBM Data Breach 2024), mimo to wiele organizacji nadal niedoinwestowuje działania prewencyjne. Dla stron opierających się na ruchu organicznym wpływ finansowy naruszenia bezpieczeństwa wykracza daleko poza utratę danych – obejmuje katastrofalne szkody SEO, załamanie przychodów i miesiące odbudowy. Badania pokazują, że strony po naruszeniu bezpieczeństwa tracą średnio 76% słów kluczowych w rankingu, a pozycje w Top 10 znikają w 88% przypadków. Tak drastyczny wpływ sprawił, że bezpieczeństwo stało się strategicznym priorytetem biznesowym dla zespołów marketingowych i specjalistów SEO.

| Typ luki | Metoda ataku | Główny wpływ na SEO | Czas odzyskiwania | Poziom zagrożenia |

|---|---|---|---|---|

| SQL Injection | Wykorzystanie zapytań do bazy danych do wstrzykiwania złośliwego kodu | Wstrzykiwanie spamu SEO, tworzenie nieautoryzowanych stron, kradzież danych | 4-8 tygodni | Krytyczny |

| Cross-Site Scripting (XSS) | Wstrzykiwanie złośliwych skryptów do stron | Dystrybucja malware, przekierowania użytkowników, manipulacja treścią | 2-4 tygodnie | Wysoki |

| Nieaktualne wtyczki/motywy | Wykorzystanie znanych luk w niezałatanym oprogramowaniu | Dostęp typu backdoor, trwałe malware, ponowne infekcje | 6-12 tygodni | Wysoki |

| Słabe hasła | Ataki brute force na konta administracyjne | Przejęcie strony, podmiana treści, umieszczenie na czarnej liście | 8-16 tygodni | Krytyczny |

| Infekcja malware | Wstrzykiwanie złośliwego kodu do plików strony | Umieszczenie na czarnej liście Google, załamanie ruchu, obniżenie pozycji | 6-18 miesięcy | Krytyczny |

| Strony phishingowe | Tworzenie fałszywych stron logowania w celu kradzieży danych | Kary ręczne, utrata zaufania użytkowników, usunięcie z indeksu | 4-12 tygodni | Wysoki |

| Ataki DDoS | Zalewanie serwera ruchem, powodowanie przestojów | Niedostępność strony, błędy indeksowania, spadek pozycji | 1-4 tygodnie | Średni |

| Scraping treści | Kopiowanie treści na inne domeny | Kary za duplikaty, osłabienie autorytetu | 3-8 tygodni | Średni |

| Niebezpieczne API | Wykorzystanie niechronionych interfejsów aplikacji | Wyciek danych, nieautoryzowany dostęp, naruszenia zgodności | 4-10 tygodni | Wysoki |

| Nieszyfrowane dane | Przesyłanie danych bez HTTPS | Utrata zaufania, kara rankingowa, problemy zgodności | 1-2 tygodnie | Średni |

Luki w zabezpieczeniach stron www otwierają wiele ścieżek do szkód SEO, z których każda ma własny mechanizm i konsekwencje. Gdy atakujący wykorzystują luki SQL injection, zyskują dostęp do bazy danych strony, dzięki czemu mogą wstrzykiwać złośliwy kod, tworzyć nieautoryzowane strony i manipulować istniejącą treścią. Zwykle wstrzykiwana treść zawiera spamerskie frazy z branży farmaceutycznej, hazardowej lub dla dorosłych – zaprojektowane tak, by pozycjonować się w wyszukiwarkach i generować przychody dla atakujących. Roboty Google wykrywają te strony podczas indeksowania, a obecność spamu uruchamia kary algorytmu Panda, które obniżają ocenę jakości całej witryny. Algorytm traktuje spam jako dowód na to, że strona publikuje niskiej jakości lub wprowadzającą w błąd treść, przez co wszystkie podstrony – nawet te wartościowe – tracą autorytet.

Luki cross-site scripting (XSS) działają inaczej, ale są równie groźne dla SEO. Pozwalają atakującym wstrzykiwać złośliwy JavaScript do stron, który wykonywany jest w przeglądarkach użytkowników. Skrypt taki może przekierowywać użytkowników na strony z malware, wyświetlać niechciane pop-upy lub przejmować sesje użytkowników. Gdy roboty Google wykryją te przekierowania i złośliwe działania, oznaczają witrynę jako niebezpieczną i wyświetlają ostrzeżenia bezpieczeństwa. Ostrzeżenia pojawiają się przed dostępem do treści, przez co 95% użytkowników natychmiast opuszcza stronę. To powoduje efekt domina: ruch spada, metryki zaangażowania się pogarszają, współczynnik odrzuceń rośnie, a Google interpretuje to jako zły UX, dodatkowo obniżając pozycje.

Infekcje złośliwym oprogramowaniem to najpoważniejsza kategoria zagrożeń SEO. Malware może utrzymywać się w plikach strony miesiącami, stale wstrzykując spam, tworząc tylne drzwi dla kolejnych ataków i rozprzestrzeniając złośliwy kod wśród odwiedzających. Infekcja często pozostaje niewidoczna dla właścicieli, podczas gdy systemy Google wykrywają ją na podstawie analizy zachowań. Po wykryciu malware Google natychmiast umieszcza stronę na czarnej liście Safe Browsing, przez co wszyscy użytkownicy z wyników wyszukiwania widzą ostrzeżenia bezpieczeństwa. To powoduje załamanie ruchu organicznego o 95% lub więcej w ciągu 24-72 godzin. Nawet po oczyszczeniu strony, powrót do zaufania Google wymaga nie tylko usunięcia malware, ale też wielu miesięcy aktywnej optymalizacji i monitoringu bezpieczeństwa.

Wpływ problemów z bezpieczeństwem wykracza daleko poza wskaźniki techniczne — przekłada się bezpośrednio na utratę przychodów, udziałów w rynku i przewagi konkurencyjnej. Przykład: średniej wielkości firma SaaS B2B generująca 50 000 wizyt organicznych miesięcznie, z konwersją na poziomie 3% i średnią wartością klienta 5 000 USD. Firma uzyskuje 7,5 mln USD miesięcznie z ruchu organicznego. Po ataku i umieszczeniu na czarnej liście Google ruch spada do 2 500 wizyt (spadek o 95%), a miesięczny przychód do 375 000 USD. W ciągu sześciomiesięcznego okresu odbudowy, gdy ruch wraca do 50% poziomu, firma traci około 22,5 mln USD z ruchu organicznego. Dodając koszty czyszczenia (50 000 USD), awaryjne kampanie PPC (200 000 USD) i intensywny marketing (200 000 USD), łączny koszt sięga 22,95 mln USD – strata, której wiele firm nie jest w stanie znieść.

Poza bezpośrednim spadkiem przychodów, naruszenia bezpieczeństwa powodują też skutki uboczne, które się kumulują. Koszt pozyskania klienta (CAC) gwałtownie rośnie, gdy ruch organiczny znika. Przed atakiem firma może pozyskiwać klientów przy blended CAC 120 USD (organiczny + płatny). W trakcie i po ataku, bez ruchu organicznego, CAC rośnie do ponad 400 USD, bo trzeba polegać wyłącznie na płatnych reklamach po stawkach kryzysowych. To niszczy unit economics – jeśli LTV klienta wynosi 600 USD, stosunek LTV:CAC spada z 5:1 do 1,5:1, co może czynić akwizycję nieopłacalną. Firmy muszą albo ograniczyć wydatki marketingowe (tracąc udziały), albo akceptować stratę na każdym kliencie.

Konkurencja potęguje straty. Gdy Twoja strona się odbudowuje, konkurenci kontynuują działania SEO, przejmując Twój udział w rynku, klientów i budując silniejsze pozycje. Firma, która spadła z 1. na 5. miejsce w rankingu kluczowego słowa, nie traci tylko 4 pozycji – traci 70% kliknięć. Tymczasem konkurent, który awansował na 1. miejsce, zyskuje je. Efekt jest podwójny: Ty tracisz ruch, a konkurencja go zyskuje. W ciągu 6-miesięcznego okresu odbudowy konkurenci mogą na stałe przejąć udziały rynkowe, relacje z klientami i lojalność wobec marki, która nigdy nie wróci do Twojej firmy. Ta utrata przewagi często okazuje się bardziej bolesna niż bezpośrednia strata przychodów.

Luki w zabezpieczeniach wpływają nie tylko na tradycyjne wyszukiwarki, ale coraz częściej także na to, jak strony pojawiają się na platformach AI, takich jak Perplexity, ChatGPT, Google AI Overviews czy Claude. Systemy AI przeszukują i analizują strony, by generować odpowiedzi, a kwestie bezpieczeństwa bezpośrednio decydują, jak Twoja marka i treści prezentowane są w odpowiedziach AI. Gdy strona zostaje zablokowana lub oznaczona jako niebezpieczna, systemy AI mogą wykluczyć ją z danych treningowych lub zdegradować jej znaczenie w generowanych odpowiedziach, ograniczając widoczność marki w AI. Tworzy to narastający problem widoczności: tracisz pozycje w wyszukiwarce ORAZ cytowania w AI jednocześnie.

Google Search Console to główne narzędzie do monitorowania wpływu problemów bezpieczeństwa na SEO. Google wyświetla konkretne ostrzeżenia, m.in. „Zhakowana: spam”, „Zhakowana: malware”, „Phishing” oraz „Czysty spam”. Każdy typ wymaga innego podejścia naprawczego i ma inną ścieżkę powrotu. Kary ręczne przyznane przez Search Console wymagają złożenia prośby o ponowne rozpatrzenie po usunięciu zagrożenia, co wydłuża powrót o 1-3 tygodnie poza czas czyszczenia. Monitorowanie powiadomień o bezpieczeństwie w Search Console jest kluczowe dla wczesnego wykrycia – strony, które wykrywają naruszenia w ciągu 24 godzin, odzyskują pozycje o 2-3 tygodnie szybciej niż te, które wykrywają problem po 1-2 tygodniach.

Strony WordPress są szczególnie narażone na luki wpływające na SEO. Badania pokazują, że 94% infekcji CMS dotyczy WordPressa, głównie przez nieaktualne wtyczki, motywy i rdzeń systemu. Popularność WordPressa czyni go głównym celem atakujących, a zdecentralizowana architektura wtyczek generuje wiele potencjalnych słabości. Jedna nieaktualna wtyczka może zagrozić całej instalacji WordPressa, wstrzykując malware na wszystkich podstronach i wywołując globalne kary SEO. Dlatego bezpieczeństwo WordPressa jest kluczowe dla SEO – jedna luka może zniszczyć pozycje tysięcy stron jednocześnie.

Skuteczne wdrożenie bezpieczeństwa wymaga podejścia wielowarstwowego, obejmującego luki na każdym poziomie infrastruktury strony. Certyfikaty SSL/TLS i szyfrowanie HTTPS to podstawa współczesnego bezpieczeństwa i SEO. Google potwierdziło HTTPS jako czynnik rankingowy, a współczesne przeglądarki pokazują ostrzeżenia dla stron bez HTTPS. Wdrożenie HTTPS to obecnie wymóg SEO – to zarówno czynnik rankingowy, jak i sygnał zaufania dla użytkownika. Organizacje powinny stosować szyfrowanie minimum 256-bitowe oraz regularnie odnawiać i poprawnie konfigurować certyfikaty.

Regularne audyty bezpieczeństwa i skanowanie podatności pozwalają wykryć słabości zanim zrobią to atakujący. Automatyczne skanery wykrywają nieaktualne oprogramowanie, błędy konfiguracji i znane luki. Jednak automatyzację należy uzupełniać ręcznymi testami penetracyjnymi, które wykrywają błędy logiki i złożone wektory ataku pomijane przez automaty. Audyty należy wykonywać co kwartał, a dla stron o dużym ruchu – nawet częściej. Wyniki trzeba dokumentować i śledzić realizację poprawek w określonym terminie.

Aktualizacja całego oprogramowania jest kluczowa w zapobieganiu wykorzystaniu znanych luk. Dotyczy to CMS (WordPress, Drupal, Joomla), wszystkich wtyczek i motywów, systemów operacyjnych serwerów i aplikacji zewnętrznych. Deweloperzy stale wydają łatki bezpieczeństwa; ich nieinstalowanie pozostawia otwarte wektory ataku. W przypadku WordPressa 56% zainfekowanych stron miało nieaktualne oprogramowanie w momencie ataku, co pokazuje, że wiele włamań jest możliwych do uniknięcia przez podstawową konserwację. Tam gdzie to możliwe, należy wdrażać automatyczne aktualizacje i testować ich wpływ na funkcjonalność.

Web Application Firewall (WAF) zapewnia ochronę w czasie rzeczywistym przed typowymi atakami, takimi jak SQL injection, XSS czy DDoS. WAF analizuje ruch przychodzący, identyfikuje szkodliwe wzorce i blokuje żądania zanim dotrą do witryny. Chmurowe WAF-y, takie jak Cloudflare, AWS WAF czy Sucuri, oferują dodatkowo ochronę przed DDoS, skanowanie malware i automatyczną reakcję na zagrożenia. Firewalle należy konfigurować tak, by blokowały znane ataki, ale przepuszczały ruch legalny – wymaga to optymalizacji pod kątem fałszywych alarmów.

Integracja bezpieczeństwa z algorytmami rankingowymi SEO będzie się pogłębiać w kolejnych latach. Model E-E-A-T Google (Experience, Expertise, Authoritativeness, Trustworthiness) coraz mocniej stawia na wiarygodność, która bezpośrednio zależy od bezpieczeństwa. Strony z dobrym bilansem bezpieczeństwa, bez historii malware i z solidną ochroną, będą otrzymywać sygnały zaufania poprawiające pozycje. Z kolei strony po naruszeniach będą stale poddawane algorytmicznej kontroli i wolniej odzyskiwać zaufanie, nawet po oczyszczeniu.

Systemy AI coraz mocniej będą uwzględniać bezpieczeństwo w ocenie treści i decyzjach o cytowaniu. Wraz z przejmowaniem przez Perplexity, ChatGPT, Google AI Overviews i Claude roli głównych źródeł informacji, systemy te będą preferowały cytowanie stron bezpiecznych i wiarygodnych. Naruszenia bezpieczeństwa zaszkodzą nie tylko tradycyjnemu SEO, ale też ograniczą cytowania AI i widoczność w odpowiedziach generowanych przez AI. Powstaje więc podwójny problem widoczności: słabe bezpieczeństwo szkodzi zarówno SEO, jak i obecności na platformach AI. Organizacje muszą monitorować swój status bezpieczeństwa w obu ekosystemach, by utrzymać pełną widoczność online.

Modele bezpieczeństwa typu zero-trust staną się standardem, zastępując przestarzałą ochronę perymetryczną. Zero-trust zakłada, że cały ruch – zarówno wewnętrzny, jak i zewnętrzny – może być złośliwy i wymaga weryfikacji. Połączenie tego podejścia z ciągłym monitoringiem i analizą behawioralną pozwala szybciej wykrywać i neutralizować ataki niż tradycyjne modele. Organizacje wdrażające zero-trust będą rzadziej padać ofiarą ataków i szybciej odbudowywać SEO, co daje przewagę konkurencyjną.

Zgodność z regulacjami coraz mocniej będzie łączyć się z efektywnością SEO. RODO, CCPA i nowe regulacje prywatności wymagają solidnej ochrony danych użytkowników. Ich nieprzestrzeganie oznacza kary finansowe, odpowiedzialność prawną i utratę reputacji – wszystko to szkodzi SEO. Wyszukiwarki mogą zacząć uwzględniać status zgodności w algorytmach rankingowych, przez co compliance stanie się bezpośrednim czynnikiem SEO. Organizacje muszą traktować bezpieczeństwo i zgodność nie jako odrębne projekty, a jako zintegrowane strategie chroniące zarówno pozycję prawną, jak i widoczność w wynikach wyszukiwania.

Przyszłość SEO jest nierozerwalnie związana z bezpieczeństwem. Firmy, które traktują bezpieczeństwo jako kluczowy element strategii SEO, a nie dodatek, utrzymają przewagę konkurencyjną w widoczności w wyszukiwarce, cytowaniach AI, zaufaniu użytkowników i generowaniu przychodów. Koszt proaktywnej inwestycji w bezpieczeństwo (zwykle 1 200–6 000 USD rocznie) jest znikomy w porównaniu z kosztami naprawy po ataku (50 000–500 000+ USD) i utraconymi przychodami (100 000–5 000 000+ USD). Dla zespołów marketingowych i SEO bezpieczeństwo nie jest już opcją – to podstawowy warunek utrzymania i rozwoju widoczności organicznej w coraz bardziej świadomym zagrożeń środowisku cyfrowym.

Do najczęstszych luk należą: SQL injection, cross-site scripting (XSS), nieaktualne wtyczki i motywy, słabe hasła, niebezpieczne API oraz niezałatane instalacje CMS. Według badań, 94% infekcji WordPressa w 2019 roku wystąpiło na stronach z nieaktualnym oprogramowaniem. Luki te pozwalają atakującym na wstrzykiwanie złośliwego oprogramowania, tworzenie stron spamowych i manipulowanie treścią, co wywołuje ostrzeżenia bezpieczeństwa Google oraz kary rankingowe. Regularne audyty bezpieczeństwa i szybkie aktualizacje są niezbędne do zapobiegania.

Google zazwyczaj wykrywa i karze zhakowane strony w ciągu 24-72 godzin od infekcji. Wyszukiwarki wyświetlają użytkownikom ostrzeżenia o zagrożeniu, powodując natychmiastowy spadek ruchu organicznego nawet o 95% lub więcej. Nawet bez widocznych ostrzeżeń algorytmy Google obniżają pozycje lub usuwają strony z indeksu. Szybkość wykrycia zależy od częstotliwości indeksowania i skali naruszenia bezpieczeństwa, ale efekt jest niemal natychmiastowy dla większości stron.

Algorytmiczne obniżenie pozycji następuje automatycznie i znika samo po usunięciu problemu (3-7 dni), podczas gdy kara ręczna wymaga interwencji człowieka i może potrwać o 1-3 tygodnie dłużej. Kary ręczne nakładane są za poważne naruszenia, takie jak phishing, dystrybucja złośliwego oprogramowania czy spam SEO. Oba typy poważnie szkodzą pozycjom, ale kara ręczna wymaga złożenia prośby o ponowne rozpatrzenie w Google Search Console i dotyczy poważniejszych naruszeń zasad Google.

Pełna odbudowa SEO trwa zazwyczaj 6-18 miesięcy w zależności od skali naruszenia, jakości reakcji i ciągłości działań SEO. Usunięcie ostrzeżeń bezpieczeństwa trwa 1-2 tygodnie, częściowy powrót ruchu (60-80%) zajmuje 3-6 miesięcy, a pełne odzyskanie wymaga 6-18 miesięcy aktywnej optymalizacji. Niektóre strony nigdy nie odzyskują w pełni pozycji, zwłaszcza jeśli stracą ważne linki lub otrzymają trwałą karę ręczną. Profesjonalne czyszczenie i agresywny marketing przyspieszają ten proces.

Tak, złośliwe oprogramowanie znacząco pogarsza Core Web Vitals, wstrzykując złośliwe skrypty, które obciążają serwer i spowalniają ładowanie strony. Largest Contentful Paint (LCP) może wzrosnąć z 2 sekund do ponad 8 sekund, First Input Delay (FID) z 80 ms do ponad 500 ms, a Cumulative Layout Shift (CLS) dramatycznie rośnie przez wstrzyknięte reklamy i wyskakujące okienka. Ponieważ Core Web Vitals są potwierdzonymi czynnikami rankingowymi Google, pogorszenie wydajności bezpośrednio szkodzi pozycjom SEO na wszystkich urządzeniach.

Wstrzykiwanie spamu SEO to sytuacja, gdy hakerzy wykorzystują SQL injection lub inne luki, aby zapełnić legalną stronę spamerskimi słowami kluczowymi, linkami i automatycznie generowanymi stronami z branży farmaceutycznej, hazardowej lub dla dorosłych. Powoduje to kary algorytmu Panda za cienką lub zduplikowaną treść, obniża ocenę jakości strony i marnuje budżet indeksowania na strony spamowe. Wstrzyknięta treść osłabia autorytet tematyczny witryny i powoduje utratę pozycji wszystkich legalnych stron z powodu ogólnego spadku jakości.

Umieszczenie na czarnej liście Google powoduje natychmiastowy i drastyczny spadek ruchu – typowo o 95% w ciągu 24-72 godzin. Użytkownicy widzą ostrzeżenia bezpieczeństwa przed wejściem na stronę i większość z nich wybiera „Powrót do bezpieczeństwa”, zamiast kontynuować. Nawet po usunięciu zagrożenia powrót do poprzedniego stanu trwa tygodnie lub miesiące, bo Google musi ponownie zaindeksować i ocenić stronę. Umieszczenie na czarnej liście szkodzi również reputacji marki, bo użytkownicy zapamiętują ostrzeżenie i niechętnie wracają, nawet po naprawie problemu, co powoduje długotrwały spadek CTR.

Zespoły marketingowe powinny się tym przejmować, ponieważ bezpieczeństwo strony bezpośrednio chroni aktywa SEO warte miliony dolarów w ruchu organicznym i przychodach. Jedno naruszenie bezpieczeństwa może zniszczyć miesiące lub lata inwestycji SEO z dnia na dzień, powodując straty od 100 000 do ponad 5 000 000 USD w zależności od wolumenu ruchu. Bezpieczeństwo to obecnie kluczowa strategia SEO, a nie tylko kwestia IT. Proaktywna inwestycja w bezpieczeństwo ma ROI ponad 100:1 w porównaniu do kosztów naprawy po ataku, co czyni ją jednym z najrozsądniejszych wydatków marketingowych.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, jak identyfikować luki w treści dla wyszukiwarek AI, takich jak ChatGPT i Perplexity. Poznaj metody analizy widoczności LLM, znajdowania brakującyc...

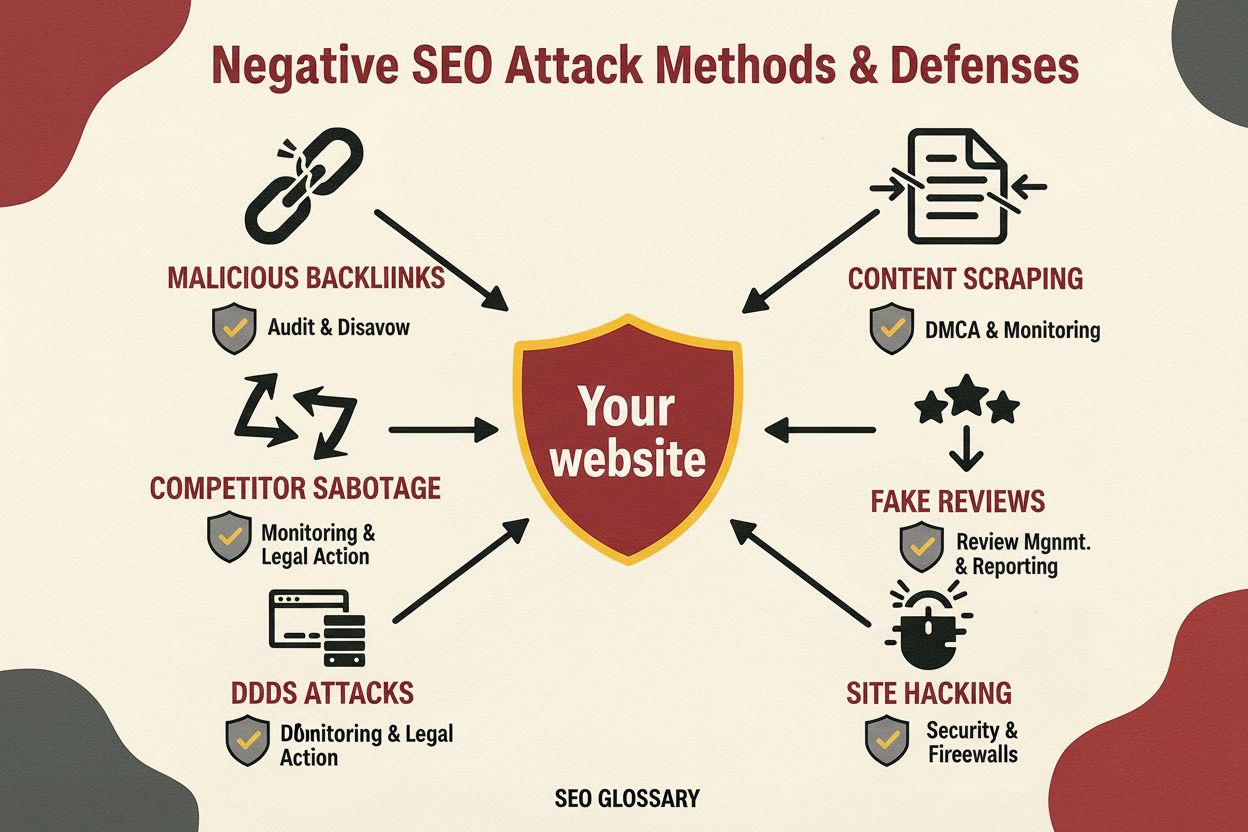

Negatywne SEO to praktyka wykorzystania nieetycznych technik w celu zaszkodzenia pozycjom konkurencji. Dowiedz się, jakie są metody ataku, sposoby wykrywania or...

Poznaj kluczowe błędy, które niszczą widoczność Twojej marki w wyszukiwaniu AI. Dowiedz się, jak zła struktura treści, brak oznaczeń schema i inne błędy GEO uni...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.