Spam wyszukiwarek

Dowiedz się, czym jest spam wyszukiwarek, w tym techniki black hat SEO, takie jak upychanie słów kluczowych, cloaking i farmy linków. Zrozum, jak Google wykrywa...

Wykrywanie spamu to zautomatyzowany proces identyfikacji i filtrowania niechcianych, niezamówionych lub manipulacyjnych treści – w tym e-maili, wiadomości i postów w mediach społecznościowych – z wykorzystaniem algorytmów uczenia maszynowego, analizy treści oraz sygnałów behawioralnych w celu ochrony użytkowników i zachowania integralności platformy.

Wykrywanie spamu to zautomatyzowany proces identyfikacji i filtrowania niechcianych, niezamówionych lub manipulacyjnych treści – w tym e-maili, wiadomości i postów w mediach społecznościowych – z wykorzystaniem algorytmów uczenia maszynowego, analizy treści oraz sygnałów behawioralnych w celu ochrony użytkowników i zachowania integralności platformy.

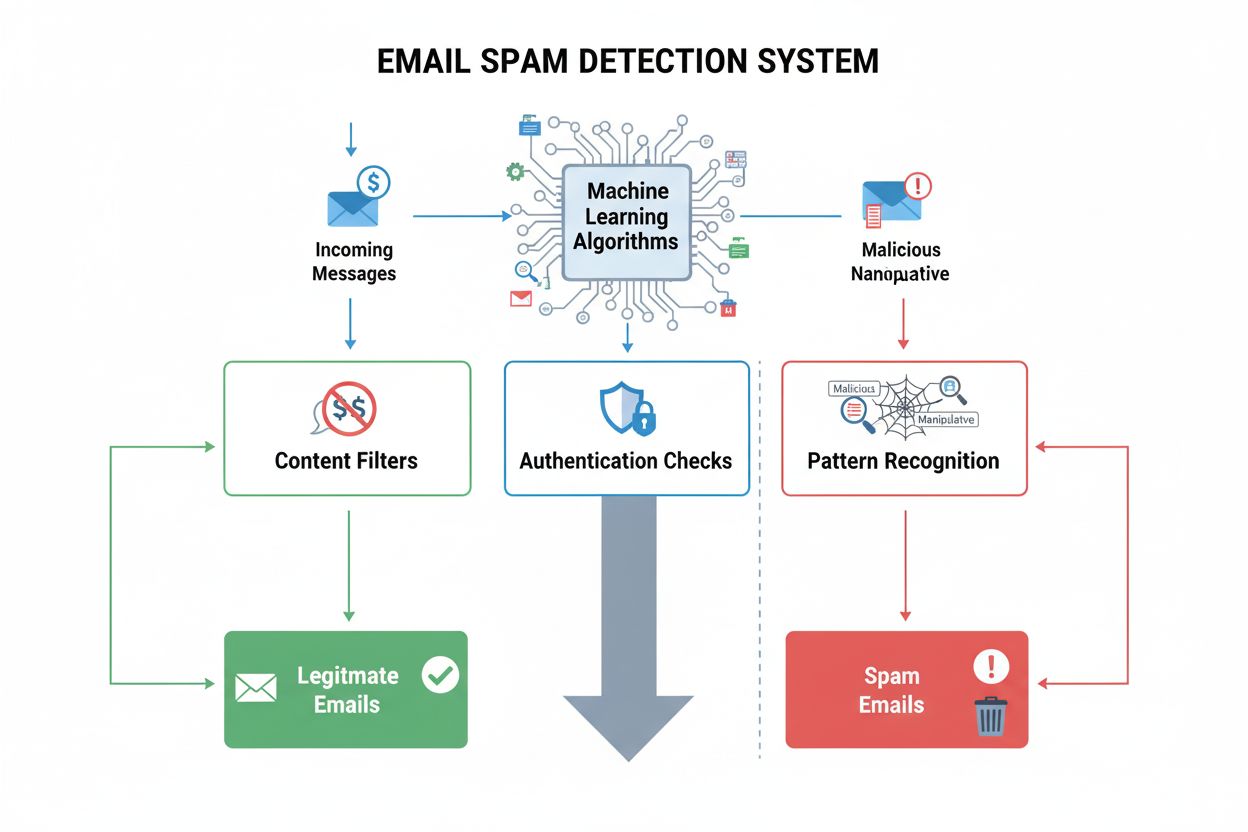

Wykrywanie spamu to zautomatyzowany proces identyfikacji i filtrowania niechcianych, niezamówionych lub manipulacyjnych treści – obejmujących e-maile, wiadomości, posty w mediach społecznościowych oraz odpowiedzi generowane przez AI – przy użyciu algorytmów uczenia maszynowego, analizy treści, sygnałów behawioralnych i protokołów uwierzytelniania. Termin ten obejmuje zarówno techniczne mechanizmy identyfikujące spam, jak i szeroką praktykę ochrony użytkowników przed zwodniczą, złośliwą lub powtarzającą się komunikacją. W kontekście nowoczesnych systemów AI i platform cyfrowych wykrywanie spamu stanowi kluczowe zabezpieczenie przed phishingiem, oszustwami, podszywaniem się pod marki oraz skoordynowanymi nieautentycznymi działaniami. Definicja wykracza poza proste filtrowanie poczty e-mail, obejmując wykrywanie manipulacyjnych treści w mediach społecznościowych, serwisach opinii, chatbotach AI oraz wynikach wyszukiwania, gdzie osoby działające w złej wierze próbują sztucznie zwiększać widoczność, manipulować opinią publiczną lub wprowadzać użytkowników w błąd poprzez nieuczciwe praktyki.

Historia wykrywania spamu przebiega równolegle z rozwojem komunikacji cyfrowej. W początkach poczty elektronicznej spam identyfikowano głównie za pomocą prostych systemów opartych na regułach, które oznaczały wiadomości zawierające określone słowa kluczowe lub adresy nadawców. Przełomowa praca Paula Grahama z 2002 roku „A Plan for Spam” wprowadziła filtrowanie bayesowskie do zabezpieczeń e-mail, rewolucjonizując tę dziedzinę dzięki możliwości uczenia się na podstawie przykładów zamiast polegania na sztywnych regułach. Podejście statystyczne znacząco poprawiło skuteczność i elastyczność, pozwalając filtrom ewoluować wraz ze zmianami taktyk spamerów. W połowie lat 2000 standardem w systemach poczty korporacyjnej stały się techniki uczenia maszynowego, w tym klasyfikatory Naive Bayes, drzewa decyzyjne i maszyny wektorów nośnych. Pojawienie się mediów społecznościowych przyniosło nowe wyzwania – skoordynowane nieautentyczne działania, sieci botów i fałszywe recenzje – co wymusiło analizę wzorców sieciowych i zachowań użytkowników, a nie tylko samej treści wiadomości. Dzisiejszy krajobraz wykrywania spamu ewoluował, obejmując modele głębokiego uczenia, architektury transformerów i analizę behawioralną w czasie rzeczywistym, osiągając skuteczność 95-98% w filtrowaniu poczty e-mail i jednocześnie odpowiadając na nowe zagrożenia, takie jak phishing generowany przez AI (wzrost o 466% w I kwartale 2025) oraz manipulacje deepfake.

Systemy wykrywania spamu działają poprzez wiele uzupełniających się warstw, które oceniają przychodzące treści równocześnie pod różnymi względami. Pierwsza warstwa to weryfikacja uwierzytelnienia, gdzie systemy sprawdzają rekordy SPF (Sender Policy Framework) w celu potwierdzenia autoryzowanych serwerów nadawczych, weryfikują podpisy kryptograficzne DKIM (DomainKeys Identified Mail) dla zapewnienia integralności wiadomości i egzekwują polityki DMARC (Domain-based Message Authentication, Reporting, and Conformance), określające sposób postępowania z błędami uwierzytelniania. Majowa egzekucja Microsoftu w 2025 roku uczyniła uwierzytelnienie obowiązkowym dla masowych nadawców przekraczających 5 000 e-maili dziennie – wiadomości niespełniające wymagań otrzymują błąd SMTP “550 5.7.515 Access denied”, czyli całkowite odrzucenie dostarczenia zamiast trafienia do spamu. Druga warstwa to analiza treści, podczas której systemy analizują tekst wiadomości, tematy, formatowanie HTML i osadzone linki pod kątem cech charakterystycznych dla spamu. Nowoczesne filtry treści nie polegają już wyłącznie na dopasowaniu słów kluczowych (co okazało się nieskuteczne wobec adaptacji języka przez spamerów), lecz analizują wzorce językowe, stosunek obrazu do tekstu, zagęszczenie adresów URL i anomalie strukturalne. Trzecia warstwa to inspekcja nagłówków, obejmująca analizę trasowania, szczegółów uwierzytelnienia nadawcy i rekordów DNS pod kątem niezgodności sugerujących spoofing lub przejętą infrastrukturę. Czwarta warstwa ocenia reputację nadawcy, porównując domeny i adresy IP z czarnymi listami, analizując historyczne wzorce wysyłki i oceniając wskaźniki zaangażowania z poprzednich kampanii.

| Metoda wykrywania | Jak działa | Skuteczność | Główne zastosowanie | Zalety | Ograniczenia |

|---|---|---|---|---|---|

| Filtrowanie oparte na regułach | Stosuje zdefiniowane kryteria (słowa kluczowe, adresy nadawców, typy załączników) | 60-75% | Systemy legacy, proste czarne listy | Szybkie, przejrzyste, łatwe do wdrożenia | Nie adaptuje się do nowych taktyk, dużo fałszywych trafień |

| Filtrowanie bayesowskie | Wykorzystuje analizę prawdopodobieństw występowania słów w spamie i legalnej poczcie | 85-92% | Systemy e-mail, filtry osobiste | Uczy się z opinii użytkownika, adaptuje się w czasie | Wymaga danych treningowych, słabe przy nowych atakach |

| Uczenie maszynowe (Naive Bayes, SVM, Random Forests) | Analizuje wektory cech (metadane nadawcy, cechy treści, wzorce zaangażowania) | 92-96% | Poczta korporacyjna, social media | Rozpoznaje złożone wzorce, ogranicza fałszywe trafienia | Wymaga oznaczonych danych, obciążające obliczeniowo |

| Uczenie głębokie (LSTM, CNN, Transformery) | Przetwarza dane sekwencyjne i relacje kontekstowe przez sieci neuronowe | 95-98% | Zaawansowane systemy e-mail, platformy AI | Najwyższa skuteczność, wykrywa zaawansowaną manipulację | Wymaga dużych zbiorów danych, trudne do interpretacji |

| Analiza behawioralna w czasie rzeczywistym | Dynamicznie monitoruje interakcje użytkowników, wzorce zaangażowania i relacje sieciowe | 90-97% | Social media, wykrywanie oszustw | Wychwytuje skoordynowane ataki, dostosowuje się do preferencji użytkowników | Wątpliwości co do prywatności, wymaga ciągłego monitoringu |

| Metody zespołowe (Ensemble) | Łączy wiele algorytmów (głosowanie, stacking), wykorzystując ich mocne strony | 96-99% | Gmail, systemy korporacyjne | Największa niezawodność, równoważy precyzję/czułość | Złożone wdrożenie, duże zużycie zasobów |

Techniczna podstawa nowoczesnego wykrywania spamu to algorytmy nadzorowanego uczenia, które klasyfikują wiadomości jako spam lub legalne na podstawie oznaczonych danych treningowych. Klasyfikatory Naive Bayes obliczają prawdopodobieństwo, że e-mail jest spamem na podstawie częstotliwości występowania słów – jeśli pewne słowa pojawiają się częściej w spamie, ich obecność podnosi ocenę spamu. Podejście to jest popularne ze względu na efektywność obliczeniową, przejrzystość oraz zaskakująco dobrą skuteczność mimo uproszczeń. Maszyny wektorów nośnych (SVM) tworzą hiperpłaszczyzny w wielowymiarowej przestrzeni cech, oddzielając spam od legalnych wiadomości – świetnie radzą sobie ze złożonymi, nieliniowymi relacjami między cechami. Random Forests generują wiele drzew decyzyjnych i agregują ich prognozy, ograniczając przeuczenie i zwiększając odporność na manipulacje. Ostatnio sieci LSTM i inne rekurencyjne sieci neuronowe osiągnęły przewagę, analizując sekwencyjne wzorce w tekście e-maili – rozumiejąc, że pewne ciągi słów lepiej wskazują spam niż pojedyncze wyrazy. Modele transformerowe, napędzające współczesne modele językowe jak GPT czy BERT, zrewolucjonizowały wykrywanie spamu przez uchwycenie relacji kontekstowych w całych wiadomościach, umożliwiając wykrycie zaawansowanych manipulacji, które umykają prostszym algorytmom. Badania pokazują, że systemy oparte na LSTM osiągają 98% skuteczności na zbiorach testowych, choć wyniki w rzeczywistości zależą od jakości danych, treningu modelu i zaawansowania ataków przeciwników.

Manipulacyjne treści obejmują szerokie spektrum działań mających na celu wprowadzenie użytkownika w błąd, sztuczne zwiększenie widoczności lub szkodzenie reputacji marki. Ataki phishingowe podszywają się pod legalne organizacje w celu kradzieży danych logowania lub informacji finansowych – phishing zasilany przez AI wzrósł o 466% w I kwartale 2025, ponieważ generatywne AI eliminuje błędy gramatyczne, które dawniej zdradzały zamiary atakującego. Skoordynowane nieautentyczne działania to sieci fałszywych kont lub botów wzmacniających przekaz, sztucznie zawyżających wskaźniki zaangażowania i tworzących pozory popularności lub konsensusu. Deepfake’i wykorzystują AI do tworzenia realistycznych, lecz fałszywych obrazów, filmów lub nagrań audio, które mogą szkodzić reputacji marki lub szerzyć dezinformację. Fałszywe recenzje sztucznie zawyżają lub zaniżają oceny produktów, manipulując percepcją konsumentów i podważając zaufanie do systemów opinii. Spam komentarzy zalewa posty w mediach społecznościowych nieistotnymi wiadomościami, linkami promocyjnymi lub złośliwą treścią, by odciągnąć uwagę od prawdziwej dyskusji. Spoofing e-mail polega na fałszowaniu adresów nadawców w celu podszycia się pod zaufane organizacje i dostarczenia złośliwych treści lub phishingu. Credential stuffing wykorzystuje automaty do testowania skradzionych par login-hasło na wielu platformach, przejmując konta i umożliwiając dalszą manipulację. Nowoczesne systemy antyspamowe muszą wykrywać te różnorodne techniki manipulacji poprzez analizę behawioralną, rozpoznawanie wzorców sieciowych i weryfikację autentyczności treści – co staje się coraz trudniejsze wraz z rosnącym wyrafinowaniem technik AI stosowanych przez atakujących.

Różne platformy wdrażają wykrywanie spamu na różnych poziomach zaawansowania, dostosowanych do specyficznych zagrożeń i grup użytkowników. Gmail stosuje metody zespołowe łączące systemy oparte na regułach, filtrowanie bayesowskie, klasyfikatory uczenia maszynowego oraz analizę behawioralną, osiągając 99,9% skuteczności blokowania spamu przed dostarczeniem do skrzynek i utrzymując odsetek fałszywych trafień poniżej 0,1%. System Gmail analizuje ponad 100 milionów e-maili dziennie, stale aktualizując modele na podstawie opinii użytkowników (zgłoszenia spamu, oznaczanie jako nie spam) i nowych wzorców zagrożeń. Microsoft Outlook wdraża wielowarstwowe filtrowanie obejmujące weryfikację uwierzytelnienia, analizę treści, ocenę reputacji nadawcy i modele uczenia maszynowego trenowane na miliardach e-maili. Perplexity i inne platformy wyszukiwawcze AI stają przed unikalnymi wyzwaniami w wykrywaniu manipulacyjnych treści w odpowiedziach generowanych przez AI, wymagając wykrywania ataków typu prompt injection, zmyślonych cytowań oraz skoordynowanych prób sztucznego zwiększania liczby wzmianek o marce w wynikach AI. ChatGPT i Claude wdrażają systemy moderacji treści, które filtrują szkodliwe zapytania, wykrywają próby obejścia wytycznych bezpieczeństwa oraz identyfikują manipulacyjne prompty mające na celu generowanie mylących informacji. Platformy społecznościowe, takie jak Facebook i Instagram, wykorzystują AI do automatycznego filtrowania komentarzy, usuwając mowę nienawiści, oszustwa, boty, próby phishingu i spam w komentarzach pod postami. AmICited jako platforma monitorująca prompty AI, musi odróżniać prawdziwe wzmianki o marce od spamu i manipulacyjnych treści w różnych systemach AI, wymagając zaawansowanych algorytmów rozumiejących kontekst, intencje i autentyczność w różnych formatach odpowiedzi tych platform.

Ocena skuteczności systemów wykrywania spamu wymaga uwzględnienia wielu metryk obejmujących różne aspekty efektywności. Skuteczność (accuracy) mierzy odsetek poprawnych klasyfikacji (zarówno trafień pozytywnych, jak i negatywnych), ale może być myląca w przypadku nierównomiernego rozkładu spamu i legalnych e-maili – system oznaczający wszystko jako legalne osiąga wysoką skuteczność, jeśli spam stanowi tylko 10% wiadomości. Precyzja (precision) mierzy odsetek wiadomości oznaczonych jako spam, które rzeczywiście są spamem, bezpośrednio odnosząc się do fałszywych trafień, które psują doświadczenie użytkownika blokując legalną korespondencję. Czułość (recall) mierzy odsetek rzeczywistego spamu wychwyconego przez system, czyli dotyczy fałszywych pominięć, gdy złośliwe treści docierają do użytkowników. F1-score równoważy precyzję i czułość, dając pojedynczą miarę ogólnej skuteczności. W wykrywaniu spamu priorytetem zwykle jest precyzja, ponieważ fałszywe trafienia (legalne e-maile jako spam) są bardziej szkodliwe niż fałszywe pominięcia (spam w skrzynce), gdyż blokowanie legalnej komunikacji biznesowej mocniej narusza zaufanie użytkownika niż okazjonalny spam. Nowoczesne systemy osiągają 95-98% skuteczności, 92-96% precyzji i 90-95% czułości na zbiorach referencyjnych, choć wyniki w rzeczywistości zależą znacząco od jakości danych, treningu modelu i wyrafinowania ataków. Odsetek fałszywych trafień w systemach korporacyjnych zwykle waha się od 0,1 do 0,5%, co oznacza, że na każde 1000 wysłanych e-maili 1-5 legalnych wiadomości zostaje błędnie odfiltrowanych. Badania EmailWarmup wskazują, że średni wskaźnik dostarczenia do skrzynki odbiorczej u głównych dostawców wynosi 83,1%, co oznacza, że jedna na sześć wiadomości nie dociera w ogóle, z czego 10,5% trafia do spamu, a 6,4% znika całkowicie – podkreślając stałe wyzwanie równoważenia bezpieczeństwa z dostarczalnością.

Przyszłość wykrywania spamu będzie kształtowana przez narastający wyścig zbrojeń między coraz bardziej wyrafinowanymi atakami a zaawansowanymi systemami obronnymi. Ataki zasilane przez AI szybko ewoluują – phishing generowany przez AI wzrósł o 466% w I kwartale 2025, eliminując błędy gramatyczne i niezręczności językowe, które wcześniej zdradzały złośliwe intencje. Ewolucja ta wymaga, by systemy wykrywania stosowały równie zaawansowaną AI, wychodząc poza rozpoznawanie wzorców w kierunku rozumienia intencji, kontekstu i autentyczności na głębszym poziomie. Wykrywanie deepfake’ów stanie się coraz ważniejsze, gdy generatywne AI umożliwia tworzenie przekonujących, ale fałszywych obrazów, filmów i dźwięków – systemy wykrywania będą musiały analizować niezgodności wizualne, artefakty dźwiękowe i anomalie behawioralne ujawniające syntetyczne pochodzenie. Biometria behawioralna odegra większą rolę, analizując sposób interakcji użytkownika z treścią (wzorce pisania, ruchy myszki, czas interakcji), by odróżnić prawdziwych użytkowników od botów lub przejętych kont. Uczenie federacyjne pozwoli organizacjom wspólnie ulepszać wykrywanie spamu bez wymiany wrażliwych danych, rozwiązując problemy prywatności przy wykorzystaniu inteligencji zbiorowej. Wymiana informacji o zagrożeniach w czasie rzeczywistym przyspieszy reakcję na nowe ataki, umożliwiając szybkie rozprzestrzenianie wiedzy o nowych wektorach i technikach manipulacji. Ramowe regulacje takie jak RODO, CAN-SPAM oraz powstające przepisy dotyczące AI będą wpływać na działanie systemów antyspamowych, wymagając przejrzystości, wyjaśnialności i kontroli użytkownika nad decyzjami filtrów. Dla platform takich jak AmICited monitorujących wzmianki o marce w systemach AI, wyzwanie będzie narastać wraz z rozwojem wyrafinowanych technik manipulowania odpowiedziami AI, wymagając ciągłej ewolucji algorytmów, by odróżnić autentyczne cytowania od skoordynowanej manipulacji. Konwergencja zaawansowania AI, presji regulacyjnej i wyrafinowania przeciwników sugeruje, że przyszłość wykrywania spamu będzie wymagać współpracy człowieka z AI – gdzie automatyczne systemy radzą sobie z ilością i rozpoznawaniem wzorców, a eksperci ludzie zajmują się przypadkami brzegowymi, nowymi zagrożeniami i dylematami etycznymi, których same algorytmy nie rozwiążą.

Wykrywanie spamu polega na identyfikacji niezamówionych, powtarzających się lub manipulacyjnych wiadomości przy użyciu zautomatyzowanych algorytmów i rozpoznawania wzorców, podczas gdy moderacja treści to szersza praktyka przeglądania i zarządzania treściami generowanymi przez użytkowników pod kątem naruszeń zasad, szkodliwych materiałów oraz standardów społeczności. Wykrywanie spamu koncentruje się na ilości, reputacji nadawcy oraz cechach wiadomości, natomiast moderacja treści obejmuje kontekst, intencje i zgodność z politykami platformy. Oba systemy często współpracują ze sobą na nowoczesnych platformach, by zapewnić bezpieczeństwo użytkowników i jakość doświadczenia.

Nowoczesne systemy wykrywania spamu osiągają dokładność na poziomie 95-98% dzięki zaawansowanym modelom uczenia maszynowego, takim jak LSTM (Long Short-Term Memory) oraz metodom zespołowym łączącym wiele algorytmów. Jednak dokładność zależy od platformy i implementacji – Gmail podaje, że blokuje 99,9% spamu zanim dotrze on do skrzynek odbiorczych, podczas gdy odsetek fałszywych trafień (prawidłowe e-maile oznaczone jako spam) zwykle wynosi 0,1-0,5%. Wyzwanie polega na zrównoważeniu precyzji (unikaniu fałszywych trafień) i czułości (wychwytywaniu całego spamu), ponieważ przeoczenie spamu jest zazwyczaj mniej szkodliwe niż blokowanie prawdziwych wiadomości.

Systemy AI analizują wzorce, kontekst i relacje, które mogą umknąć człowiekowi, umożliwiając wykrywanie zaawansowanych technik manipulacji, takich jak skoordynowane nieautentyczne działania, deepfake'i czy phishing generowany przez AI. Modele uczenia maszynowego trenowane na milionach przykładów potrafią rozpoznawać subtelne wzorce językowe, anomalie behawioralne i struktury sieciowe wskazujące na manipulację. Jednak ataki zasilane przez AI również ewoluują – phishing generowany przez AI wzrósł o 466% w I kwartale 2025 r. – co wymaga stałych aktualizacji modeli i testów odpornościowych, by skutecznie przeciwdziałać nowym zagrożeniom.

Filtry antyspamowe równoważą precyzję (minimalizowanie fałszywych trafień, gdy prawidłowe e-maile są blokowane) i czułość (wychwytywanie całego rzeczywistego spamu). Większość systemów priorytetowo traktuje precyzję, ponieważ blokowanie legalnych wiadomości bardziej szkodzi zaufaniu użytkownika niż przepuszczenie części spamu. Filtry bayesowskie uczą się na podstawie opinii użytkowników – gdy odbiorcy oznaczają przefiltrowane e-maile jako „nie spam”, systemy dostosowują progi. Systemy korporacyjne często implementują strefy kwarantanny, gdzie podejrzane e-maile są zatrzymywane do przeglądu przez administratora zamiast być kasowane, co umożliwia odzyskiwanie prawidłowych wiadomości przy zachowaniu bezpieczeństwa.

Wykrywanie spamu wykorzystuje wiele uzupełniających się technik: systemy oparte na regułach stosują z góry określone kryteria, filtrowanie bayesowskie wykorzystuje analizę prawdopodobieństwa statystycznego, algorytmy uczenia maszynowego identyfikują złożone wzorce, a analiza w czasie rzeczywistym dynamicznie sprawdza adresy URL i załączniki. Filtry treści analizują tekst wiadomości i formatowanie, filtry nagłówków sprawdzają informacje routingu i autoryzacji, filtry reputacji weryfikują historię nadawcy na czarnych listach, a filtry behawioralne monitorują wzorce zaangażowania użytkowników. Nowoczesne systemy łączą te techniki jednocześnie – wiadomość może przejść test treści, ale nie zdać uwierzytelnienia, co wymaga kompleksowej oceny we wszystkich aspektach.

Dla platform monitorujących AI, śledzących wzmianki o marce w ChatGPT, Perplexity, Google AI Overviews i Claude, wykrywanie spamu pomaga odróżnić prawdziwe wzmianki od manipulacyjnych treści, fałszywych recenzji i skoordynowanych nieautentycznych działań. Skuteczne wykrywanie spamu zapewnia, że dane z monitoringu odzwierciedlają autentyczne interakcje użytkowników, a nie szum generowany przez boty lub manipulacje przeciwników. Jest to kluczowe dla rzetelnego oceniania reputacji marki, ponieważ spam i manipulacyjne treści mogą sztucznie zwiększać lub zaniżać widoczność marki, prowadząc do błędnych decyzji strategicznych.

Fałszywe trafienia w wykrywaniu spamu generują istotne koszty biznesowe i wpływają na doświadczenie użytkowników: legalne e-maile marketingowe nie docierają do klientów, co obniża współczynniki konwersji i przychody; ważne wiadomości transakcyjne (reset hasła, potwierdzenia zamówień) mogą zostać pominięte, wywołując frustrację użytkowników; reputacja nadawcy cierpi w miarę wzrostu liczby skarg. Badania pokazują, że średni wskaźnik dostarczenia do skrzynki odbiorczej wynosi 83,1%, co oznacza, że jedna na sześć wiadomości nie dociera w ogóle, a fałszywe trafienia znacząco się do tego przyczyniają. W przypadku przedsiębiorstw nawet 1% fałszywych trafień przy milionach wysłanych e-maili oznacza tysiące utraconych szans biznesowych i nadwątlonych relacji z klientami.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

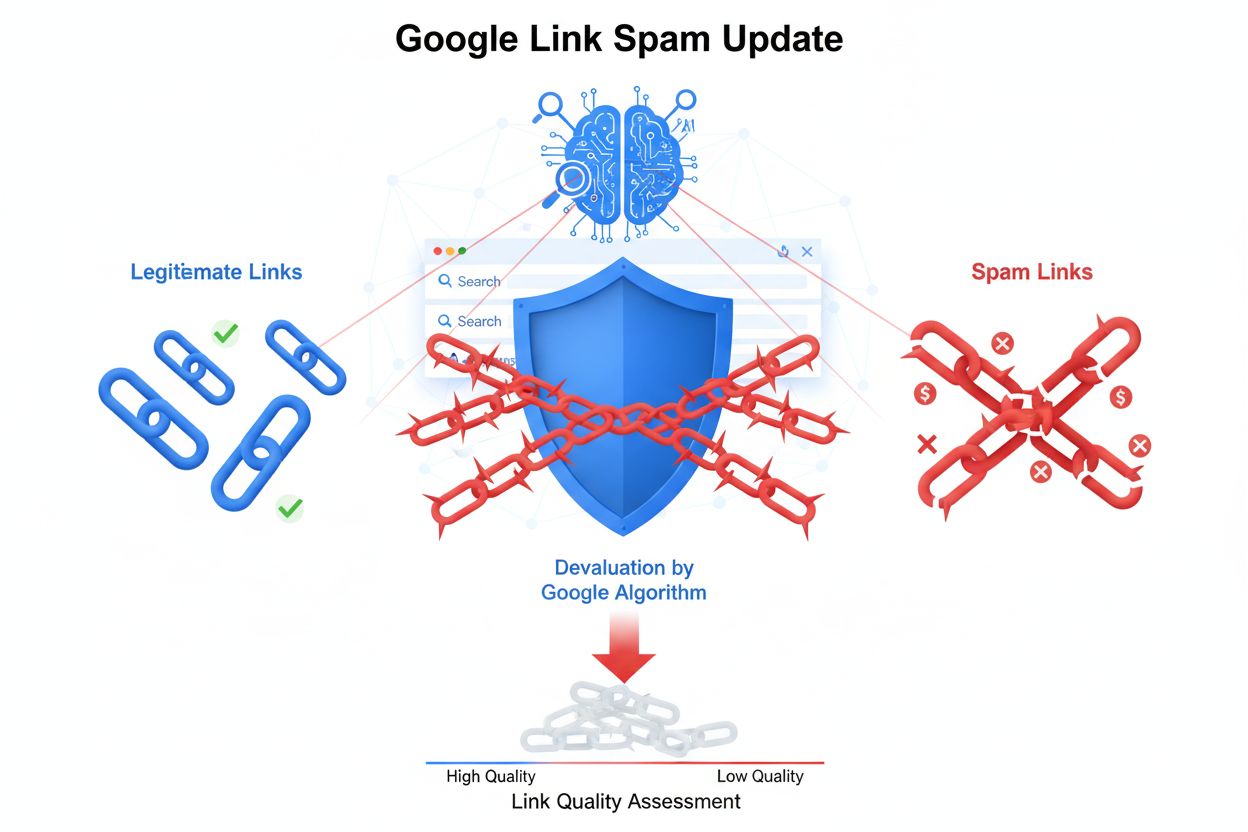

Dowiedz się, czym jest spam wyszukiwarek, w tym techniki black hat SEO, takie jak upychanie słów kluczowych, cloaking i farmy linków. Zrozum, jak Google wykrywa...

Dowiedz się, czym jest wykrywanie treści AI, jak działają narzędzia oparte na uczeniu maszynowym i NLP oraz dlaczego są ważne dla monitorowania marki, edukacji ...

Dowiedz się, czym jest Link Spam Update Google, która deprecjonuje manipulacyjne backlinki. Zrozum, jak SpamBrain wykrywa spam linkowy, wpływ na SEO oraz najlep...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.