Licencjonowanie treści dla AI

Dowiedz się więcej o umowach licencyjnych na treści dla AI, które regulują wykorzystanie chronionych prawem autorskim materiałów przez systemy sztucznej intelig...

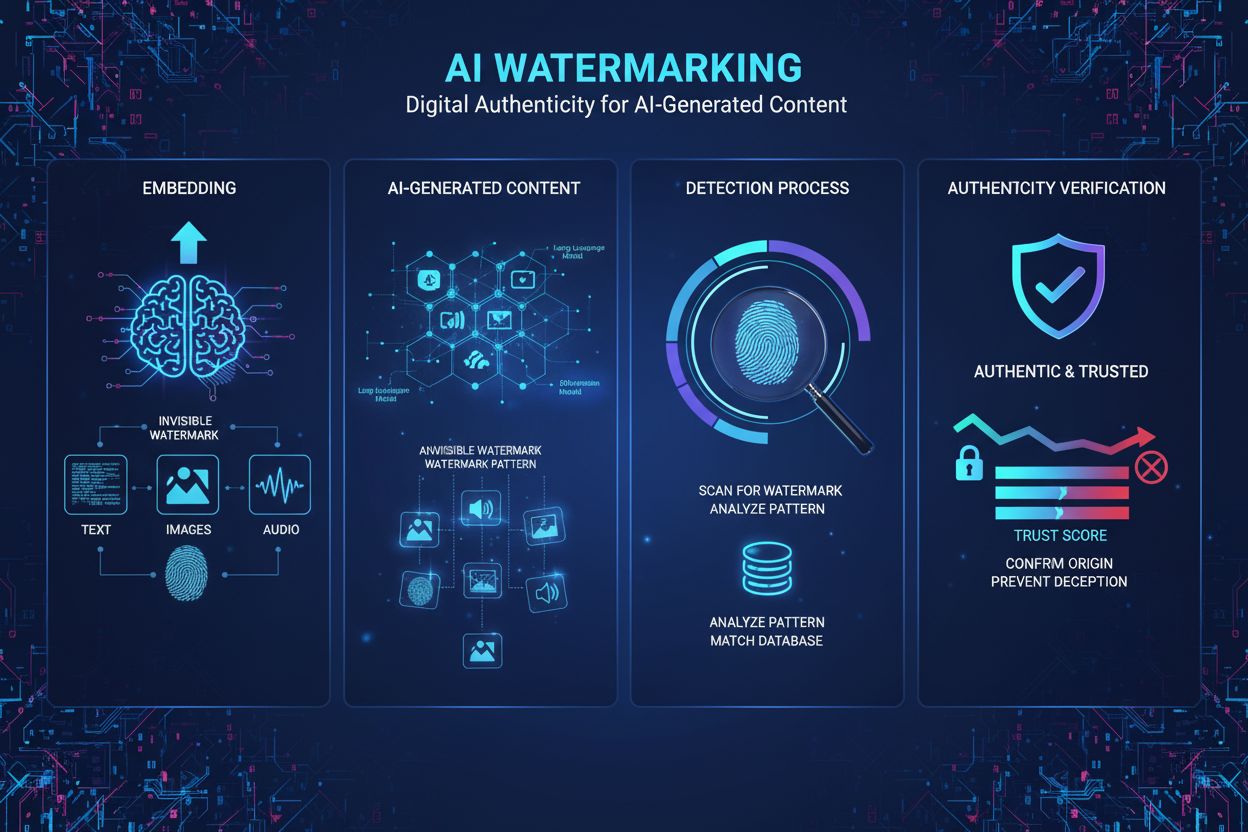

Znakowanie treści AI to proces osadzania niewidocznych lub widocznych cyfrowych znaczników w tekście, obrazach, dźwięku lub wideo generowanych przez AI, aby zidentyfikować i uwierzytelnić te treści jako stworzone przez maszynę. Takie znaki wodne pełnią rolę cyfrowych odcisków palców, umożliwiając wykrywanie, weryfikację oraz śledzenie materiałów wygenerowanych przez sztuczną inteligencję w różnych platformach i aplikacjach.

Znakowanie treści AI to proces osadzania niewidocznych lub widocznych cyfrowych znaczników w tekście, obrazach, dźwięku lub wideo generowanych przez AI, aby zidentyfikować i uwierzytelnić te treści jako stworzone przez maszynę. Takie znaki wodne pełnią rolę cyfrowych odcisków palców, umożliwiając wykrywanie, weryfikację oraz śledzenie materiałów wygenerowanych przez sztuczną inteligencję w różnych platformach i aplikacjach.

Znakowanie treści AI odnosi się do procesu osadzania cyfrowych znaczników, wzorów lub podpisów w materiałach generowanych przez AI, aby zidentyfikować, uwierzytelnić i śledzić ich pochodzenie. Takie znaki wodne pełnią rolę cyfrowych odcisków palców, odróżniając treści wygenerowane przez maszyny od prac autorstwa człowieka w formatach tekstu, obrazów, dźwięku i wideo. Głównym celem znakowania treści AI jest zapewnienie przejrzystości pochodzenia treści przy jednoczesnej walce z dezinformacją, ochronie własności intelektualnej oraz zapewnieniu odpowiedzialności w dynamicznie rozwijającym się środowisku generatywnej sztucznej inteligencji. W przeciwieństwie do tradycyjnych, widocznych znaków wodnych na dokumentach czy obrazach, współczesne techniki znakowania AI często wykorzystują niewidoczne wzory wykrywalne tylko przez wyspecjalizowane algorytmy, zachowując wysoką jakość treści przy jednoczesnym zapewnieniu solidnych możliwości uwierzytelniania.

Pojęcie znakowania wywodzi się ze świata rzeczywistego, gdzie niewidoczne oznaczenia na banknotach i dokumentach służyły zapobieganiu fałszerstwom. Wraz z rozwojem mediów cyfrowych, naukowcy w latach 90. i 2000. adaptowali techniki znakowania do obrazów, dźwięku i wideo. Jednak pojawienie się zaawansowanych generatywnych modeli AI, takich jak ChatGPT, DALL-E czy Midjourney w latach 2022–2023, stworzyło pilną potrzebę standaryzowanych metod uwierzytelniania treści AI. Szybki postęp AI w generowaniu realistycznych treści syntetycznych skłonił rządy, firmy technologiczne i organizacje społeczne do uznania znakowania za kluczowy mechanizm zabezpieczający. Według badań Instytutu Brookings, ponad 78% przedsiębiorstw dostrzega wagę narzędzi monitorujących treści generowane przez AI w zarządzaniu ryzykiem związanym z mediami syntetycznymi. EU AI Act, formalnie przyjęty w marcu 2024 roku, stał się pierwszym ważnym aktem prawnym nakazującym znakowanie treści AI, zobowiązując dostawców systemów AI do oznaczania wyników jako wygenerowanych przez sztuczną inteligencję. Ten impuls regulacyjny przyspieszył badania i rozwój technologii znakowania, a firmy takie jak Google DeepMind, OpenAI czy Meta inwestują znaczące środki w solidne systemy znakowania.

Znakowanie AI realizowane jest dwoma głównymi podejściami technicznymi: znakowaniem widocznym i znakowaniem niewidocznym. Widoczne znaki wodne to oczywiste etykiety, logotypy lub informacje tekstowe dodawane do treści – jak pięć kolorowych kwadratów, które DALL-E umieszcza na generowanych obrazach, czy wstęp ChatGPT „as a language model trained by OpenAI”. Mimo łatwości wdrożenia, widoczne znaki wodne można bez trudu usunąć prostą edycją. Niewidoczne znakowanie natomiast polega na osadzaniu subtelnych wzorów niedostrzegalnych dla człowieka, ale wykrywalnych przez specjalistyczne algorytmy. W przypadku obrazów generowanych przez AI wykorzystuje się na przykład znaki wodne typu tree-ring, opracowane na Uniwersytecie Maryland, które osadzają wzory w początkowym szumie przed procesem dyfuzji, czyniąc je odpornymi na kadrowanie, obrót czy filtrowanie. Dla tekstu generowanego przez AI najbardziej perspektywiczne jest statystyczne znakowanie – model językowy subtelnie preferuje pewne tokeny („zielone tokeny”), unikając innych („czerwone tokeny”) w zależności od wcześniejszego kontekstu, co powoduje statystycznie nietypowy układ słów, wykrywany przez algorytmy z wysoką pewnością. Znakowanie dźwięku polega na osadzaniu niewidocznych wzorów w zakresach częstotliwości poza słyszalnością człowieka (poniżej 20 Hz lub powyżej 20 000 Hz), analogicznie do znakowania obrazów, lecz z uwzględnieniem właściwości akustycznych. Technologia SynthID od Google DeepMind to przykład nowoczesnego znakowania, gdzie wspólnie trenowane są modele generujące i wykrywające, co gwarantuje odporność na transformacje przy zachowaniu jakości treści.

| Metoda znakowania | Typ treści | Odporność | Wpływ na jakość | Wymaga dostępu do modelu | Wykrywalność |

|---|---|---|---|---|---|

| Widoczne znakowanie | Obrazy, wideo | Bardzo niska | Brak | Nie | Wysoka (ludzka) |

| Statystyczne znakowanie | Tekst, obrazy | Wysoka | Minimalna | Tak | Wysoka (algorytmiczna) |

| Oparte na uczeniu maszynowym | Obrazy, dźwięk | Wysoka | Minimalna | Tak | Wysoka (algorytmiczna) |

| Tree-ring watermarking | Obrazy | Bardzo wysoka | Brak | Tak | Wysoka (algorytmiczna) |

| Pochodzenie treści (C2PA) | Wszystkie media | Średnia | Brak | Nie | Średnia (metadane) |

| Wykrywanie post-hoc | Wszystkie media | Niska | N/D | Nie | Niska (niepewna) |

Statystyczne znakowanie to najbardziej obiecująca technika uwierzytelniania tekstu generowanego przez AI, odpowiadająca na wyzwanie, że tekst nie oferuje tylu wymiarów do osadzania wzorów, co obraz czy dźwięk. Podczas generowania, model językowy otrzymuje instrukcje preferowania określonych tokenów na podstawie klucza kryptograficznego znanego tylko twórcy modelu. Losowość modelu jest „ładowana” według tego schematu, przez co preferowane są konkretne słowa lub frazy, a inne są pomijane. Protokoły wykrywania analizują wygenerowany tekst, by obliczyć prawdopodobieństwo uzyskania wykrytego wzoru tokenów przypadkowo; statystycznie nieprawdopodobne układy wskazują na obecność znaku wodnego. Badania Uniwersytetu Maryland oraz OpenAI wykazały, że podejście to pozwala na wysoką skuteczność wykrywania przy zachowaniu jakości tekstu. Jednak statystyczne znakowanie tekstu napotyka ograniczenia: odpowiedzi faktograficzne o ograniczonej elastyczności generowania (np. rozwiązania matematyczne czy fakty historyczne) są trudniejsze do oznaczenia, a gruntowne przepisanie lub tłumaczenie na inny język znacząco obniża pewność wykrycia. Implementacja SynthID Text, dostępna obecnie w Hugging Face Transformers v4.46.0+, oferuje produkcyjne znakowanie z możliwością konfiguracji parametrów, takich jak klucze kryptograficzne czy długość n-gramów, co pozwala na balansowanie odporności i wykrywalności.

Obrazy generowane przez AI pozwalają na stosowanie bardziej zaawansowanych metod znakowania dzięki wysokowymiarowej przestrzeni do osadzania wzorów. Znakowanie typu tree-ring osadza ukryte wzory w początkowej losowej wersji obrazu przed dyfuzją, tworząc znaki wodne odporne na typowe transformacje, takie jak kadrowanie, rozmycie czy obrót, przy zachowaniu jakości obrazu. Znakowanie oparte na uczeniu maszynowym (Meta, Google) wykorzystuje sieci neuronowe do osadzania i wykrywania niewidocznych znaków wodnych, osiągając skuteczność powyżej 96% na niezmienionych obrazach i odporność na ataki na poziomie piksela. Znakowanie audio polega na podobnych zasadach – wzory osadzane są w zakresach częstotliwości poza percepcją człowieka. AudioSeal (Meta) trenuje wspólnie generator i detektor znaków wodnych, aby były odporne na naturalne transformacje audio przy zachowaniu nieodróżnialnej jakości dźwięku. Technologia wykorzystuje stratę percepcyjną, by dźwięk z oznaczeniem był identyczny z oryginałem, a stratę lokalizacyjną do wykrywania znaku wodnego niezależnie od zakłóceń. Te podejścia pokazują, że niewidoczne znakowanie może być zarówno odporne, jak i nie pogarszać jakości, choć wymaga dostępu do modelu AI w celu osadzenia znaku.

Otoczenie regulacyjne dotyczące znakowania treści AI bardzo dynamicznie się rozwija – wiele jurysdykcji wprowadza lub proponuje obowiązkowe wymogi znakowania. EU AI Act, formalnie przyjęty w marcu 2024 r., to najbardziej kompleksowe ramy prawne, nakazujące dostawcom systemów AI oznaczanie wyników jako treści generowanych przez AI. Regulacja ta dotyczy wszystkich generatywnych systemów AI wdrażanych na terenie Unii Europejskiej i ustanawia prawny obowiązek zgodności znakowania. Kalifornijska AI Transparency Act (SB 942), obowiązująca od 1 stycznia 2026 roku, wymaga od objętych dostawców AI udostępnienia bezpłatnych, publicznie dostępnych narzędzi wykrywania treści AI, co w praktyce nakłada konieczność stosowania znakowania lub równoważnych mechanizmów uwierzytelniania. National Defense Authorization Act (NDAA) na rok fiskalny 2024 w USA przewiduje konkurs na ocenę technologii znakowania i nakazuje Departamentowi Obrony badania oraz pilotaż wdrożenia „otwartych branżowych standardów technicznych” do osadzania informacji o pochodzeniu treści w metadanych. Executive Order Białego Domu dotyczące AI nakazuje Departamentowi Handlu opracowanie i wdrożenie standardów oznaczania treści generowanych przez AI. Te inicjatywy regulacyjne odzwierciedlają rosnący konsensus, że znakowanie AI jest kluczowe dla przejrzystości, odpowiedzialności i ochrony konsumentów. Jednak wyzwania wdrożeniowe są wciąż poważne, szczególnie w kontekście modeli open-source, koordynacji międzynarodowej i technicznych możliwości uniwersalnych standardów znakowania.

Pomimo znacznych postępów technicznych, znakowanie AI wciąż napotyka poważne ograniczenia praktyczne. Usunięcie znaku wodnego jest możliwe różnymi metodami obejścia: parafrazowaniem tekstu, kadrowaniem lub filtrowaniem obrazów, tłumaczeniem treści na inne języki czy stosowaniem zakłóceń adversarialnych. Badania Uniwersytetu Duke wykazały skuteczność ataków typu proof-of-concept przeciwko detektorom znaków opartych na uczeniu maszynowym – nawet zaawansowane metody są podatne na działania zdeterminowanych przeciwników. Problem nieuniwersalności to kolejne kluczowe ograniczenie – detektory znaków są specyficzne dla danego modelu, przez co użytkownicy muszą osobno korzystać z usług wykrywania każdej firmy AI, by zweryfikować pochodzenie treści. Bez centralnego rejestru i standaryzowanych protokołów wykrywania, rozpoznawanie treści AI staje się nieefektywne i przypadkowe. Wskaźniki fałszywie pozytywnych wyników w wykrywaniu znaków, szczególnie w tekście, są problematyczne; algorytmy mogą błędnie oznaczać teksty pisane przez ludzi jako generowane przez AI lub nie wykryć znaku po drobnych modyfikacjach. Kompatybilność z modelami open-source generuje wyzwania zarządcze, gdyż znaki można wyłączyć usuwając kod z pobranego modelu. Pogorszenie jakości następuje, gdy algorytmy znakowania sztucznie ograniczają wyniki modelu dla osadzenia wykrywalnych wzorów, co może obniżać jakość treści lub ograniczać elastyczność generowania w zadaniach faktograficznych. Implikacje dla prywatności – zwłaszcza jeśli znaki wodne zawierają dane identyfikujące użytkownika – wymagają starannej polityki ochrony. Ponadto, pewność wykrycia znacząco maleje wraz ze skróceniem treści lub jej silną modyfikacją, co ogranicza użyteczność znakowania w wielu zastosowaniach.

Przyszłość znakowania AI zależy od dalszych innowacji technicznych, harmonizacji regulacji oraz budowy zaufanej infrastruktury do wykrywania i weryfikacji znaków. Naukowcy pracują nad publicznie wykrywalnymi znakami, które zachowują odporność nawet po ujawnieniu metod detekcji, co może umożliwić zdecentralizowane weryfikowanie bez konieczności zaufania zewnętrznym usługom. Standaryzacja prowadzona przez organizacje takie jak ICANN czy konsorcja branżowe może przynieść uniwersalne protokoły znakowania, ograniczając fragmentację i usprawniając wykrywanie międzyplatformowe. Integracja ze standardami pochodzenia treści (C2PA) może pozwolić na warstwowe uwierzytelnianie, łącząc znaki wodne z metadanymi śledzącymi pochodzenie. Rozwój znaków odpornych na tłumaczenie i parafrazowanie to aktywnie badany kierunek, z potencjałem do uwierzytelniania treści wielojęzycznych. Systemy weryfikacji oparte na blockchainie mogą zapewnić niezmienność zapisów wykrycia znaku i pochodzenia treści, wzmacniając zaufanie do wyników uwierzytelniania. Wraz z rozwojem generatywnych AI, techniki znakowania muszą ewoluować, by utrzymać skuteczność wobec coraz bardziej wyrafinowanych prób obejścia. Impuls regulacyjny ze strony EU AI Act i przepisów kalifornijskich prawdopodobnie przyspieszy globalne przyjmowanie standardów znakowania, tworząc rynkowe bodźce do wdrożenia solidnych rozwiązań technicznych. Realistycznie należy jednak przyjąć, że znakowanie będzie głównie narzędziem zarządzania treściami pochodzącymi z popularnych modeli komercyjnych i pozostanie ograniczone w zastosowaniach wymagających natychmiastowej detekcji o wysokiej stawce. Integracja platform do monitorowania treści AI (np. AmICited) z infrastrukturą znakowania pozwoli organizacjom śledzić atrybucję marki w systemach AI, zapewniając właściwe uznanie, gdy ich domeny pojawiają się w odpowiedziach generowanych przez AI. Przyszłe rozwiązania prawdopodobnie będą kładły nacisk na współpracę ludzi i AI przy uwierzytelnianiu treści, łącząc automatyczne wykrywanie znaków z weryfikacją ludzką w newralgicznych zastosowaniach, takich jak dziennikarstwo, postępowania prawne czy integralność akademicka.

Widoczne znaki wodne są łatwo dostrzegalne przez ludzi, na przykład jako logotypy lub etykiety tekstowe dodane do obrazów czy klipów audio, lecz łatwo je usunąć lub podrobić. Niewidoczne znaki wodne natomiast osadzają subtelne wzory niewidoczne dla ludzkiego oka, ale wykrywalne przez specjalistyczne algorytmy, co czyni je znacznie bardziej odpornymi na manipulacje i próby usunięcia. Niewidoczne znaki wodne są zazwyczaj preferowane do uwierzytelniania treści AI, ponieważ nie wpływają na jakość treści, a jednocześnie zapewniają wyższy poziom bezpieczeństwa przed obejściem oznaczenia.

Statystyczne znakowanie tekstu polega na subtelnym wpływaniu na wybór tokenów przez model językowy podczas generowania tekstu. Twórca modelu „ustawia kości” za pomocą schematu kryptograficznego, przez co model preferuje określone „zielone tokeny” i unika „czerwonych tokenów” w zależności od wcześniejszego kontekstu. Algorytmy wykrywające analizują następnie tekst, by sprawdzić, czy uprzywilejowane tokeny pojawiają się ze statystycznie nietypową częstotliwością, co wskazuje na obecność znaku wodnego. Takie podejście pozwala zachować jakość tekstu, a jednocześnie osadzić wykrywalny odcisk palca.

Kluczowe wyzwania to łatwość usunięcia znaku wodnego poprzez drobne zmiany lub przekształcenia, brak uniwersalnej wykrywalności dla różnych modeli AI oraz trudność znakowania tekstu w porównaniu z obrazami czy dźwiękiem. Dodatkowo, znakowanie wymaga współpracy twórców modeli AI, nie jest kompatybilne z otwartymi modelami open-source i może pogarszać jakość treści, jeśli nie zostanie starannie wdrożone. Istotnym wyzwaniem technicznym są także fałszywe pozytywy i negatywy w procesie wykrywania.

Rozporządzenie EU AI Act, formalnie przyjęte w marcu 2024 roku, wymaga od dostawców systemów AI oznaczania swoich wyników jako treści generowanych przez sztuczną inteligencję. Kalifornijska ustawa AI Transparency Act (SB 942), obowiązująca od 1 stycznia 2026 roku, nakłada na objętych dostawców AI obowiązek udostępnienia bezpłatnych, publicznie dostępnych narzędzi do wykrywania treści AI. Amerykańska ustawa National Defense Authorization Act (NDAA) na rok fiskalny 2024 zawiera zapisy dotyczące oceny technologii znakowania i opracowywania standardów branżowych dla pochodzenia treści.

Znakowanie osadza wzory identyfikacyjne bezpośrednio w treści generowanej przez AI, tworząc trwały cyfrowy odcisk palca, który pozostaje nawet po skopiowaniu lub modyfikacji treści. Pochodzenie treści, np. standard C2PA, przechowuje informacje o źródle i historii modyfikacji osobno w metadanych pliku. Znakowanie jest bardziej odporne na obejście, ale wymaga współpracy twórców modeli, podczas gdy pochodzenie treści jest łatwiejsze we wdrożeniu, ale można je usunąć poprzez kopiowanie treści bez metadanych.

SynthID to technologia Google DeepMind, która znakując i identyfikuje treści generowane przez AI poprzez osadzanie cyfrowych znaków wodnych bezpośrednio w obrazach, dźwięku, tekście i wideo. W przypadku tekstu SynthID wykorzystuje procesor logitów, który wzbogaca proces generowania modelu o informację znakowania bez znaczącego wpływu na jakość. Technologia ta wykorzystuje modele uczenia maszynowego zarówno do osadzania, jak i wykrywania znaków wodnych, dzięki czemu jest odporna na typowe ataki i zachowuje wierność treści.

Tak, osoby zdeterminowane mogą usuwać lub omijać znaki wodne za pomocą różnych technik, takich jak parafrazowanie tekstu, kadrowanie lub filtrowanie obrazów czy tłumaczenie treści na inne języki. Jednak usunięcie zaawansowanych znaków wodnych wymaga wiedzy technicznej oraz znajomości zastosowanego schematu znakowania. Statystyczne znaki wodne są bardziej odporne od tradycyjnych metod, ale badania wykazały skuteczność ataków typu proof-of-concept nawet na zaawansowane techniki znakowania, co oznacza, że żadna metoda nie jest całkowicie niezawodna.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się więcej o umowach licencyjnych na treści dla AI, które regulują wykorzystanie chronionych prawem autorskim materiałów przez systemy sztucznej intelig...

Dowiedz się, czym jest wykrywanie treści AI, jak działają narzędzia oparte na uczeniu maszynowym i NLP oraz dlaczego są ważne dla monitorowania marki, edukacji ...

Dowiedz się, jak syndykacja treści oparta na AI wykorzystuje uczenie maszynowe do dystrybucji treści na platformach zoptymalizowanych pod kątem odkrywalności pr...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.