Impacto dos Crawlers de IA nos Recursos do Servidor: O Que Esperar

Saiba como crawlers de IA impactam recursos do servidor, banda e desempenho. Descubra estatísticas reais, estratégias de mitigação e soluções de infraestrutura ...

Aprenda como tomar decisões estratégicas sobre o bloqueio de crawlers de IA. Avalie tipo de conteúdo, fontes de tráfego, modelos de receita e posição competitiva com nossa estrutura de decisão abrangente.

Crawlers de IA tornaram-se uma força significativa no ecossistema digital, mudando fundamentalmente a forma como o conteúdo é descoberto, indexado e utilizado na internet. Esses sistemas automatizados são projetados para navegar sistematicamente por sites, extrair dados e alimentá-los em modelos de aprendizado de máquina que impulsionam desde mecanismos de busca até aplicações de IA generativa. O cenário abrange três tipos distintos de crawlers: scrapers de dados que extraem informações específicas para fins comerciais, crawlers de mecanismos de busca como o Googlebot que indexam conteúdo para resultados de busca e crawlers de assistentes de IA que coletam dados de treinamento para grandes modelos de linguagem. Exemplos incluem o GPTBot da OpenAI, o Claude-Web da Anthropic e o crawler de AI Overviews do Google, cada um com propósitos e impactos diferentes. Segundo análises recentes, aproximadamente 21% dos 1.000 maiores sites já implementaram algum tipo de bloqueio a crawlers de IA, indicando uma conscientização crescente sobre a necessidade de gerenciar esses visitantes automatizados. Compreender quais crawlers estão acessando seu site e por que o fazem é o primeiro passo crítico para tomar uma decisão informada sobre bloqueá-los ou permiti-los. Os riscos são altos porque essa decisão impacta diretamente a visibilidade do seu conteúdo, seus padrões de tráfego e, em última análise, seu modelo de receita.

Em vez de tomar uma decisão generalizada de bloquear ou permitir todos os crawlers de IA, uma abordagem mais sofisticada envolve avaliar sua situação específica usando o Framework BEDC, que representa Modelo de Negócio, Risco de Exposição, Dependência de Busca Orgânica e Posição Competitiva. Cada um desses quatro fatores tem peso diferente dependendo das características do seu site e, juntos, criam uma matriz de decisão abrangente que leva em conta a complexidade da publicação digital moderna. O framework reconhece que não existe uma resposta universal—o que funciona para uma organização de notícias pode ser completamente inadequado para uma empresa SaaS, e o que beneficia uma marca estabelecida pode prejudicar um concorrente emergente. Ao avaliar sistematicamente cada fator, você pode ir além de reações emocionais à IA e tomar decisões baseadas em dados que estejam alinhadas com seus objetivos de negócio.

| Fator | Recomendação | Consideração Principal |

|---|---|---|

| Modelo de Negócio | Sites sustentados por anúncios devem ser mais cautelosos; modelos de assinatura podem ser mais permissivos | Dependência de receita pelo engajamento direto do usuário vs. licenciamento |

| Risco de Exposição | Pesquisas originais e conteúdo proprietário justificam bloqueio; conteúdo comum pode ser mais aberto | Vantagem competitiva atrelada a insights ou dados exclusivos |

| Dependência de Busca Orgânica | Alta dependência (>40% do tráfego) sugere permitir crawlers do Google, mas bloquear assistentes de IA | Equilíbrio entre visibilidade em busca e proteção de dados de treinamento de IA |

| Posição Competitiva | Líderes de mercado podem se dar ao luxo de bloquear; emergentes podem se beneficiar da visibilidade em IA | Vantagem de pioneirismo em parcerias de IA vs. proteção de conteúdo |

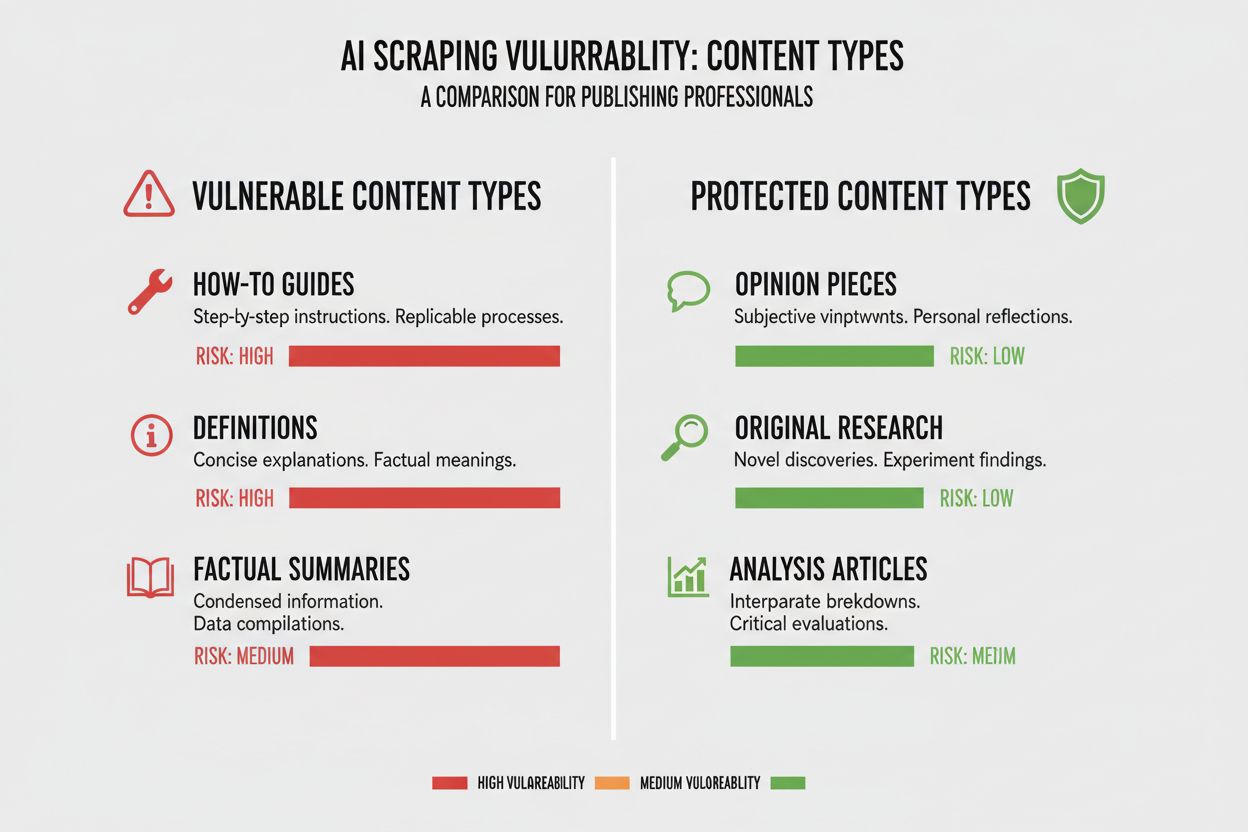

Diferentes tipos de conteúdo apresentam níveis muito distintos de vulnerabilidade ao crawling de IA, e entender a posição do seu conteúdo nesse espectro é essencial para tomar a decisão correta. Pesquisas originais e dados proprietários são seus ativos de maior valor e merecem a proteção mais forte, pois modelos de IA treinados com esse conteúdo podem competir diretamente com sua estratégia de monetização. Notícias e informações em tempo real ocupam um meio-termo—enquanto o valor do tempo é rapidamente reduzido, ser indexado por mecanismos de busca continua crítico para o tráfego, criando uma tensão entre visibilidade em busca e proteção de dados para IA. Conteúdo comum como tutoriais, guias e material de referência geral é muito menos vulnerável porque está amplamente disponível na internet e tem menos probabilidade de ser seu principal gerador de receita. Conteúdo multimídia e dirigido por voz tem proteção natural porque crawlers de IA atuais têm dificuldade em extrair valor significativo de áudio e vídeo, tornando esses formatos inerentemente mais seguros contra extração de dados para IA. Conteúdo educacional perene e artigos de opinião estão em um meio-termo, são valiosos para tráfego de busca mas menos ameaçados diretamente pela competição com IA. O principal insight é que sua estratégia de bloqueio deve ser proporcional à vantagem competitiva que seu conteúdo oferece—protegendo suas joias da coroa enquanto permanece aberto para crawlers em conteúdos que se beneficiam de ampla distribuição.

Sua dependência de tráfego orgânico de busca é talvez o fator mais concreto na decisão sobre crawlers de IA, pois quantifica diretamente o equilíbrio entre visibilidade em buscas e proteção de conteúdo. Sites que recebem mais de 40% do tráfego de busca orgânica enfrentam uma restrição crítica: bloquear crawlers de IA muitas vezes significa também bloquear ou limitar crawlers do Google, o que devastaria sua visibilidade em buscas e o tráfego orgânico. A distinção entre Google-Extended (que faz crawling para treinamento de IA) e Googlebot (que faz crawling para indexação de busca) é crucial aqui, pois você pode teoricamente permitir um e bloquear o outro, embora isso crie complexidade técnica. Um estudo do The New York Times ilustra a importância do tráfego: a publicação recebeu aproximadamente 240.600 visitas de crawlers de IA em determinado período, demonstrando a escala do tráfego orientado por IA para grandes publicadores. Entretanto, a realidade mostrada por dados da Akamai revela que bloquear crawlers resulta em 96% menos tráfego de referência dessas fontes, sugerindo que a contribuição desses crawlers para o tráfego é mínima comparada à busca tradicional. A taxa de retorno de crawling para referência da maioria dos crawlers de IA é extremamente baixa—frequentemente menos de 0,15% do conteúdo rastreado gera visitas de retorno—o que significa que bloquear esses crawlers tem impacto mínimo no tráfego real de usuários. Para sites com alta dependência de busca orgânica, a decisão de bloquear crawlers de IA deve ser equilibrada com o risco de bloquear acidentalmente crawlers de mecanismos de busca, que seria muito mais prejudicial para o negócio.

Seu modelo de receita molda fundamentalmente como você deve abordar crawlers de IA, pois diferentes estratégias de monetização criam incentivos distintos em torno da distribuição e proteção do conteúdo. Sites sustentados por anúncios enfrentam a maior tensão com crawlers de IA, pois sua receita depende de usuários visitando o site para ver anúncios, e modelos de IA que resumem seu conteúdo reduzem o incentivo para os usuários clicarem. Modelos baseados em assinaturas podem ser mais permissivos com crawlers de IA, já que a receita vem de assinaturas diretas de usuários em vez de impressões de anúncios, e alguma visibilidade em IA pode até impulsionar novas assinaturas. Modelos híbridos que combinam anúncios, assinaturas e receita de afiliados exigem uma análise mais cuidadosa, pois bloquear crawlers pode proteger a receita de anúncios mas prejudicar oportunidades de afiliados ou crescimento de assinantes. Uma oportunidade emergente que merece atenção é o modelo de referência via IA, em que sites podem potencialmente ganhar receita permitindo acesso de crawlers de IA em troca de atribuição e referências de tráfego—um modelo ainda em desenvolvimento, mas que pode mudar a economia da distribuição de conteúdo. Para publicadores que buscam entender o impacto total dos crawlers de IA em seu negócio, ferramentas como a AmICited.com oferecem monitoramento essencial para rastrear onde seu conteúdo está sendo citado e usado por sistemas de IA, oferecendo visibilidade sobre o real valor de troca do seu conteúdo. O essencial é compreender seu modelo de receita a fundo para prever como crawlers de IA afetarão cada fonte de receita, ao invés de tomar uma decisão generalizada baseada apenas em princípios.

Depois de decidir bloquear determinados crawlers de IA, a implementação técnica exige compreender as capacidades e limitações das ferramentas ao seu alcance. A abordagem mais comum é usar o robots.txt, um arquivo de texto simples colocado na raiz do site que instrui os crawlers sobre quais partes do site podem ou não ser acessadas. Porém, o robots.txt tem uma limitação crítica: trata-se de um padrão voluntário, dependendo da boa-fé dos crawlers, e crawlers maliciosos ou agressivos podem ignorá-lo completamente. Veja um exemplo de como bloquear crawlers de IA específicos no seu robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Além do robots.txt, você deve considerar bloquear estes grandes crawlers de IA:

Para uma proteção mais robusta, muitas organizações implementam bloqueio em nível de CDN usando serviços como a Cloudflare, que podem bloquear o tráfego na borda da rede antes que chegue aos seus servidores, proporcionando melhor desempenho e segurança. Uma abordagem em duas camadas combinando robots.txt com bloqueio em nível de CDN oferece a proteção mais forte, pois atinge tanto crawlers respeitosos que seguem o robots.txt quanto crawlers agressivos que o ignoram. Vale lembrar que bloquear crawlers em nível de CDN requer maior sofisticação técnica e pode ter consequências inesperadas se não for configurado cuidadosamente, sendo mais indicado para organizações com recursos técnicos dedicados.

A verdade desconfortável sobre bloquear crawlers de IA é que o impacto real no tráfego costuma ser muito menor do que sugere a reação emocional ao scraping por IA, e os dados revelam um cenário mais sutil do que muitos publicadores esperam. Segundo análises recentes, crawlers de IA normalmente representam apenas 0,15% do tráfego total de sites para a maioria dos publicadores, um número surpreendentemente pequeno considerando a atenção que o tema recebe. Contudo, a taxa de crescimento do tráfego de crawlers de IA tem sido dramática, com alguns relatórios mostrando crescimento de 7x ao ano em requisições de crawlers de IA, indicando que, embora o impacto atual seja pequeno, a trajetória é ascendente. O ChatGPT responde por aproximadamente 78% de todo o tráfego de crawlers de IA, tornando o crawler da OpenAI a força dominante nesse espaço, seguido por contribuições bem menores de outras empresas de IA. O dado de taxa de conversão de crawling para referência é especialmente revelador: enquanto crawlers de IA podem requisitar milhões de páginas, geram visitas reais em taxas geralmente abaixo de 0,15%, o que significa que bloqueá-los tem impacto mínimo no seu tráfego de usuários. Bloquear crawlers de IA reduz o tráfego de referência em 96%, mas como esse tráfego já era mínimo (muitas vezes menos de 0,15% do tráfego total), o impacto líquido no seu negócio frequentemente é insignificante. Isso gera um paradoxo: bloquear crawlers de IA parece uma posição de princípio contra o roubo de conteúdo, mas o impacto real no negócio costuma ser tão pequeno que mal aparece em suas métricas. A verdadeira questão não é se bloquear crawlers prejudicará seu tráfego—geralmente não prejudica—mas se permitir crawlers cria oportunidades estratégicas ou riscos que superam a contribuição mínima de tráfego que oferecem.

Sua posição competitiva no mercado molda fundamentalmente como abordar crawlers de IA, pois a estratégia ideal para um líder de mercado difere drasticamente da de um concorrente emergente. Jogadores dominantes, como The New York Times, Wall Street Journal e grandes organizações de notícias podem se dar ao luxo de bloquear crawlers de IA porque seu reconhecimento de marca e relacionamento direto com o público significam que não dependem de descoberta via IA para gerar tráfego. Novos competidores e publicadores de nicho enfrentam outra lógica: serem indexados por sistemas de IA e aparecerem em resumos gerados por IA pode ser uma das poucas formas de ganhar visibilidade frente a concorrentes estabelecidos. A vantagem de pioneirismo em parcerias com IA pode ser significativa—publicadores que negociam cedo com empresas de IA podem garantir melhor atribuição, referências de tráfego ou acordos de licenciamento do que os que esperam. Existe também um efeito de subsídio: quando grandes publicadores bloqueiam crawlers de IA, cria-se incentivo para as empresas de IA se apoiarem mais no conteúdo de quem permite crawling, potencialmente dando a esses publicadores visibilidade desproporcional em sistemas de IA. Isso gera uma dinâmica competitiva em que bloquear pode inclusive prejudicar sua posição se seus concorrentes permitem crawlers e ganham visibilidade em IA como resultado. Compreender sua posição no cenário competitivo é essencial para prever como sua decisão de bloqueio afetará sua posição frente aos concorrentes.

Tomar a decisão de bloquear ou permitir crawlers de IA exige avaliar sistematicamente sua situação com critérios concretos. Use este checklist para guiar seu processo de decisão:

Avaliação de Exposição de Conteúdo

Análise da Composição do Tráfego

Avaliação da Posição de Mercado

Avaliação de Risco de Receita

Após esta avaliação inicial, implemente revisões trimestrais de sua estratégia para crawlers de IA, pois o cenário está evoluindo rapidamente e sua decisão ideal hoje pode mudar em poucos meses. Use ferramentas como a AmICited.com para rastrear onde seu conteúdo está sendo citado e usado por sistemas de IA, fornecendo dados concretos sobre o valor de troca do seu conteúdo. O principal insight é que essa decisão não deve ser tomada uma única vez e esquecida—ela exige avaliação e ajuste contínuos conforme o cenário de IA amadurece e as circunstâncias do seu negócio mudam.

Uma oportunidade emergente com potencial para transformar todo o cenário de crawlers de IA é o recurso pay-per-crawl da Cloudflare, que introduz um modelo de internet baseado em permissão, no qual os donos de sites podem monetizar o acesso de crawlers de IA, em vez de simplesmente bloquear ou permitir. Essa abordagem reconhece que empresas de IA extraem valor ao rastrear seu conteúdo e, em vez de engajar numa guerra de bloqueios, você pode negociar compensação por esse acesso. O modelo depende de verificação criptográfica para garantir que apenas crawlers autorizados acessem seu conteúdo, impedindo scraping não autorizado enquanto permite que empresas legítimas de IA paguem pelo acesso. Isso cria controle granular sobre quais crawlers podem acessar qual conteúdo, permitindo monetizar conteúdo de alto valor e permanecer aberto para mecanismos de busca e outros crawlers benéficos. O modelo pay-per-crawl também habilita recursos de auditoria de IA, permitindo saber exatamente qual conteúdo foi rastreado, quando e por quem, oferecendo transparência impossível nos métodos tradicionais de bloqueio. Para publicadores que implementam essa estratégia, as capacidades de monitoramento da AmICited.com tornam-se ainda mais valiosas, pois você pode rastrear não só onde seu conteúdo aparece em sistemas de IA, mas também verificar se está recebendo compensação apropriada por esse uso. Embora esse modelo ainda esteja surgindo e tenha adoção limitada, representa uma abordagem potencialmente mais sofisticada do que a escolha binária entre bloquear e permitir—uma abordagem que reconhece o valor mútuo na relação entre publicadores e empresas de IA, protegendo seus interesses via mecanismos contratuais e técnicos.

Bloquear crawlers de IA impede que eles acessem seu conteúdo por meio do robots.txt ou bloqueio em nível de CDN, protegendo seu conteúdo de ser usado em treinamento de IA. Permitir crawlers significa que seu conteúdo pode ser indexado por sistemas de IA, potencialmente aparecendo em resumos e respostas geradas por IA. A escolha depende do tipo de conteúdo, modelo de receita e posição competitiva.

Bloquear crawlers de IA não prejudicará seu SEO diretamente se você bloquear apenas crawlers específicos de IA como o GPTBot enquanto permite o Googlebot. No entanto, se você bloquear o Googlebot por engano, seu posicionamento nas buscas será significativamente afetado. O segredo é usar controle granular para bloquear apenas crawlers de treinamento de IA preservando o acesso dos mecanismos de busca.

Sim, você pode usar o robots.txt para bloquear crawlers específicos pelo seu user-agent, enquanto permite outros. Por exemplo, você pode bloquear o GPTBot e permitir o Google-Extended, ou vice-versa. Essa abordagem granular permite proteger seu conteúdo de certas empresas de IA enquanto permanece visível para outras.

O robots.txt é um padrão voluntário que depende dos crawlers respeitarem suas instruções—algumas empresas de IA o ignoram. O bloqueio em nível de CDN (como o da Cloudflare) bloqueia o tráfego na borda da rede antes de chegar aos seus servidores, oferecendo uma aplicação mais forte. Uma abordagem em duas camadas usando ambos os métodos oferece a melhor proteção.

Você pode verificar os logs do seu servidor em busca de user-agents de crawlers de IA conhecidos como GPTBot, CCBot e Claude-Web. Ferramentas como a AmICited.com oferecem recursos de monitoramento para rastrear onde seu conteúdo aparece em sistemas de IA e com que frequência está sendo acessado por crawlers de IA.

Pay-per-crawl é um modelo emergente em que empresas de IA pagam pelo acesso ao seu conteúdo. Embora ainda esteja em fase beta e tenha adoção limitada, representa uma possível nova fonte de receita. A viabilidade depende do volume de tráfego de crawlers de IA e dos valores que as empresas de IA estão dispostas a pagar.

Se um crawler de IA ignorar as diretivas do seu robots.txt, implemente o bloqueio em nível de CDN por meio de serviços como a Cloudflare. Você também pode configurar seu servidor para retornar erros 403 para user-agents de crawlers de IA conhecidos. Para violações persistentes, considere ação legal ou entrar em contato diretamente com a empresa de IA.

Revise sua estratégia para crawlers de IA trimestralmente, pois o cenário está evoluindo rapidamente. Monitore mudanças no tráfego de crawlers de IA, novos crawlers entrando no mercado e alterações em sua posição competitiva. Use ferramentas como a AmICited.com para acompanhar como seu conteúdo está sendo usado por sistemas de IA e ajuste sua estratégia conforme necessário.

Acompanhe onde seu conteúdo aparece em respostas geradas por IA e compreenda o impacto dos crawlers de IA em seu negócio com a plataforma de monitoramento abrangente da AmICited.com.

Saiba como crawlers de IA impactam recursos do servidor, banda e desempenho. Descubra estatísticas reais, estratégias de mitigação e soluções de infraestrutura ...

Aprenda como identificar e monitorar crawlers de IA como GPTBot, PerplexityBot e ClaudeBot em seus logs de servidor. Descubra strings de user-agent, métodos de ...

Guia abrangente dos crawlers de IA em 2025. Identifique GPTBot, ClaudeBot, PerplexityBot e mais de 20 outros bots de IA. Aprenda como bloquear, permitir ou moni...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.