Limites de Tokens e Otimização de Conteúdo: Considerações Técnicas

Explore como os limites de tokens afetam a performance da IA e aprenda estratégias práticas para otimização de conteúdo, incluindo RAG, chunking e técnicas de s...

Um token é a unidade básica de texto processada por modelos de linguagem, representando palavras, subpalavras, caracteres ou sinais de pontuação convertidos em identificadores numéricos. Os tokens formam a base de como sistemas de IA como ChatGPT, Claude e Perplexity entendem e geram texto, com cada token recebendo um valor inteiro único dentro do vocabulário do modelo.

Um token é a unidade básica de texto processada por modelos de linguagem, representando palavras, subpalavras, caracteres ou sinais de pontuação convertidos em identificadores numéricos. Os tokens formam a base de como sistemas de IA como ChatGPT, Claude e Perplexity entendem e geram texto, com cada token recebendo um valor inteiro único dentro do vocabulário do modelo.

Um token é a unidade fundamental de texto que os modelos de linguagem processam e compreendem. Tokens representam palavras, subpalavras, sequências de caracteres ou sinais de pontuação, cada um com um identificador numérico único dentro do vocabulário do modelo. Em vez de processar texto bruto diretamente, sistemas de IA como ChatGPT, Claude, Perplexity e Google AI Overviews convertem todo texto de entrada em sequências de tokens—essencialmente traduzindo a linguagem humana para um formato numérico que redes neurais podem computar. Esse processo de tokenização é o passo inicial crítico que permite aos modelos de linguagem analisar relações semânticas, gerar respostas coerentes e manter eficiência computacional. Entender tokens é essencial para quem trabalha com sistemas de IA, já que a contagem de tokens influencia diretamente os custos de API, qualidade das respostas e a capacidade do modelo de manter contexto em conversas.

A tokenização é o processo sistemático de dividir texto bruto em tokens discretos que um modelo de linguagem pode processar. Quando você insere texto em um sistema de IA, o tokenizador primeiro analisa o texto e o divide em unidades gerenciáveis. Por exemplo, a frase “I heard a dog bark loudly” pode ser tokenizada em tokens individuais: I, heard, a, dog, bark, loudly. Cada token então recebe um identificador numérico único—talvez I vire o token ID 1, heard seja o 2, a o 3, e assim por diante. Essa representação numérica permite que a rede neural realize operações matemáticas sobre os tokens, calculando relações e padrões que possibilitam ao modelo compreender significado e gerar respostas apropriadas.

A maneira exata como o texto é tokenizado depende do algoritmo de tokenização empregado por cada modelo. Diferentes modelos de linguagem usam tokenizadores distintos, por isso o mesmo texto pode gerar quantidades variadas de tokens em diferentes plataformas. O vocabulário do tokenizador—o conjunto completo de tokens únicos que ele reconhece—tipicamente varia de dezenas a centenas de milhares de tokens. Quando o tokenizador encontra texto ou palavras fora de seu vocabulário, ele aplica estratégias específicas para lidar com esses casos, seja dividindo-os em subpalavras menores ou representando-os como combinações de tokens conhecidos. Essa flexibilidade é crucial para lidar com idiomas diversos, jargões técnicos, erros de digitação e combinações inéditas de palavras que aparecem em textos do mundo real.

Diferentes abordagens de tokenização oferecem vantagens e desvantagens distintas. Compreender esses métodos é essencial para entender como diferentes plataformas de IA processam informações:

| Método de Tokenização | Como Funciona | Vantagens | Desvantagens | Usado Por |

|---|---|---|---|---|

| Nível de Palavra | Divide o texto em palavras completas com base em espaços e pontuação | Simples de entender; preserva o significado total da palavra; sequências menores de tokens | Vocabulário grande; não lida com palavras desconhecidas ou raras (OOV); inflexível com erros de digitação | Sistemas tradicionais de PLN |

| Nível de Caractere | Trata cada caractere individual como um token, incluindo espaços | Lida com qualquer texto; sem problemas de fora do vocabulário; controle detalhado | Sequências de tokens muito longas; exige mais computação; baixa densidade semântica por token | Alguns modelos especializados; modelos de idioma chinês |

| Nível de Subpalavra (BPE) | Mescla iterativamente pares frequentes de caracteres/subpalavras em tokens maiores | Equilibra tamanho e cobertura do vocabulário; lida bem com palavras raras; reduz erros de OOV | Implementação mais complexa; pode dividir unidades significativas; exige treinamento | Modelos GPT, ChatGPT, Claude |

| WordPiece | Começa pelos caracteres e mescla progressivamente combinações frequentes | Excelente para lidar com palavras desconhecidas; vocabulário eficiente; boa preservação semântica | Requer pré-treinamento; mais intensivo computacionalmente | BERT, Modelos do Google |

| SentencePiece | Método independente de idioma, tratando texto como bytes brutos | Excelente para modelos multilíngues; lida com qualquer caractere Unicode; sem pré-processamento | Menos intuitivo; requer ferramentas especializadas | Modelos multilíngues, T5 |

Depois que o texto é convertido em tokens, os modelos de linguagem processam essas sequências numéricas por múltiplas camadas de redes neurais. Cada token é representado como um vetor multidimensional chamado embedding, que captura significado semântico e relações contextuais. Durante o treinamento, o modelo aprende a reconhecer padrões em como os tokens aparecem juntos, entendendo que certos tokens frequentemente coexistem ou aparecem em contextos similares. Por exemplo, os tokens para “king” e “queen” desenvolvem embeddings semelhantes porque compartilham propriedades semânticas, enquanto “king” e “paper” têm embeddings mais distantes devido a seus significados e usos diferentes.

O mecanismo de atenção do modelo é fundamental nesse processo. A atenção permite ao modelo ponderar a importância de diferentes tokens entre si ao gerar uma resposta. Ao processar a frase “The bank executive sat by the river bank”, o mecanismo de atenção ajuda o modelo a entender que o primeiro “bank” refere-se a uma instituição financeira enquanto o segundo refere-se à margem de um rio, com base em tokens contextuais como “executive” e “river”. Essa compreensão contextual emerge das relações aprendidas entre embeddings de tokens, permitindo uma compreensão sofisticada da linguagem, muito além de simples correspondência de palavras.

Durante a inferência (quando o modelo gera respostas), ele prevê o próximo token em uma sequência com base em todos os tokens anteriores. O modelo calcula pontuações de probabilidade para cada token em seu vocabulário, então seleciona o próximo token mais provável. Esse processo se repete iterativamente—o novo token gerado é adicionado à sequência, e o modelo utiliza esse contexto expandido para prever o token seguinte. A geração ocorre token a token até que o modelo preveja um token especial de “fim de sequência” ou atinja o limite máximo de tokens. Por isso é fundamental entender os limites de tokens: se seu prompt e a resposta desejada juntos excederem a janela de contexto do modelo, ele não poderá gerar uma resposta completa.

Todo modelo de linguagem tem uma janela de contexto—um número máximo de tokens que pode processar ao mesmo tempo. Esse limite soma tokens de entrada (seu prompt) e tokens de saída (resposta do modelo). Por exemplo, o GPT-3.5-Turbo tem uma janela de contexto de 4.096 tokens, enquanto o GPT-4 oferece janelas de 8.000 a 128.000 tokens conforme a versão. Os modelos Claude 3 suportam janelas de até 200.000 tokens, permitindo análise de livros inteiros ou documentos extensos. Entender a janela de contexto do seu modelo é essencial para planejar prompts e gerenciar orçamentos de tokens de forma eficaz.

Ferramentas de contagem de tokens são essenciais para otimizar o uso de IA. A OpenAI oferece a biblioteca tiktoken, um tokenizador de código aberto que permite aos desenvolvedores contar tokens antes de fazer chamadas de API. Isso evita custos inesperados e possibilita otimização precisa de prompts. Por exemplo, se você usa o GPT-4 com janela de contexto de 8.000 tokens e seu prompt consome 2.000 tokens, você terá 6.000 tokens disponíveis para a resposta do modelo. Conhecendo esse limite, você pode criar prompts que se encaixem no espaço disponível sem abrir mão de respostas abrangentes. Modelos diferentes usam tokenizadores distintos—Claude tem seu próprio sistema de tokenização, Perplexity utiliza sua abordagem, e o Google AI Overviews outra ainda. Isso faz com que o mesmo texto gere diferentes contagens de tokens nas plataformas, tornando essencial a contagem específica por plataforma para estimar custos e prever desempenho com precisão.

Tokens tornaram-se a unidade fundamental de valor econômico na indústria de IA. A maioria dos provedores de serviço de IA cobra com base no consumo de tokens, com tarifas separadas para tokens de entrada e de saída. A estrutura de preços da OpenAI exemplifica esse modelo: em 2024, o GPT-4 cobra aproximadamente US$ 0,03 por 1.000 tokens de entrada e US$ 0,06 por 1.000 tokens de saída, ou seja, tokens de saída custam cerca do dobro dos de entrada. Essa estrutura reflete a realidade computacional de que gerar novos tokens exige mais processamento do que processar tokens de entrada existentes. A precificação da Claude segue padrão semelhante, enquanto Perplexity e outras plataformas adotam seus próprios esquemas baseados em tokens.

Entender a economia dos tokens é crucial para gerenciar custos de IA em escala. Um prompt prolixo pode consumir 500 tokens, enquanto um prompt conciso e bem estruturado alcança o mesmo objetivo com apenas 200 tokens. Em milhares de chamadas de API, essa diferença de eficiência gera economias relevantes. Pesquisas indicam que empresas que usam ferramentas de monitoramento de conteúdo por IA podem reduzir o consumo de tokens em 20-40% por meio de otimização de prompts e estratégias inteligentes de cache. Além disso, muitas plataformas implementam limites de taxa medidos em tokens por minuto (TPM), restringindo quantos tokens um usuário pode processar em determinado período. Esses limites evitam abusos e garantem distribuição justa dos recursos entre usuários. Para organizações que monitoram sua presença de marca em respostas de IA via plataformas como a AmICited, entender os padrões de consumo de tokens revela não apenas impactos de custo, mas também a profundidade e amplitude do engajamento da IA com seu conteúdo.

Para plataformas dedicadas a monitorar aparições de marcas e domínios em respostas de IA, os tokens representam um critério crítico para medir engajamento e influência. Quando a AmICited rastreia como sua marca aparece no ChatGPT, Claude, Perplexity e Google AI Overviews, a contagem de tokens revela os recursos computacionais que esses sistemas dedicam ao seu conteúdo. Uma citação que consome 50 tokens indica um engajamento mais substancial do que uma menção breve de apenas 5 tokens. Ao analisar padrões de tokens entre diferentes plataformas de IA, as organizações podem entender quais sistemas priorizam seu conteúdo, quão profundamente os modelos discutem sua marca e se seu conteúdo recebe análise detalhada ou apenas superficial.

O rastreamento de tokens também permite análise sofisticada da qualidade e relevância das respostas de IA. Quando um sistema de IA gera uma resposta longa e detalhada sobre sua marca usando centenas de tokens, isso indica alta confiança e conhecimento abrangente. Por outro lado, respostas breves com poucos tokens podem indicar informação limitada ou menor relevância. Essa distinção é crucial para o gerenciamento de marcas na era da IA. Organizações podem usar o monitoramento em nível de token para identificar quais aspectos da marca recebem mais atenção das IAs, quais plataformas priorizam seu conteúdo e como sua visibilidade se compara aos concorrentes. Ademais, padrões de consumo de tokens podem revelar tendências emergentes—se o uso de tokens para sua marca aumentar repentinamente em várias plataformas de IA, isso pode indicar crescimento de relevância ou cobertura de notícias recentes incorporadas aos dados de treinamento das IAs.

O cenário de tokenização segue evoluindo à medida que os modelos de linguagem se tornam mais sofisticados e capazes. Modelos antigos usavam tokenização simples por palavra, mas sistemas modernos empregam métodos avançados de tokenização por subpalavra que equilibram eficiência e preservação semântica. O Byte-Pair Encoding (BPE), pioneiro pela OpenAI e agora padrão da indústria, representa um grande avanço em relação às abordagens anteriores. No entanto, pesquisas emergentes sugerem que métodos ainda mais eficientes podem surgir à medida que os modelos escalam para contextos mais longos e dados mais diversos.

O futuro da tokenização vai além do texto. Modelos multimodais como o GPT-4 Vision e o Claude 3 tokenizam imagens, áudio e vídeo além do texto, criando representações unificadas de tokens entre modalidades. Isso significa que um único prompt pode conter tokens de texto, imagem e áudio, todos processados pela mesma arquitetura de rede neural. À medida que esses sistemas multimodais amadurecem, entender o consumo de tokens entre diferentes tipos de dados se torna cada vez mais importante. Além disso, o surgimento de modelos de raciocínio que geram “tokens de pensamento” intermediários invisíveis ao usuário representa outra evolução. Esses modelos consomem muito mais tokens durante a inferência—às vezes 100x mais do que modelos tradicionais—para produzir raciocínio e soluções de problemas de maior qualidade. Esse desenvolvimento sugere que a indústria de IA pode migrar para medir valor não só por tokens de saída, mas pelo total de tokens computacionais consumidos, incluindo processos de raciocínio ocultos.

A padronização da contagem de tokens entre plataformas continua sendo um desafio em andamento. Embora a biblioteca tiktoken da OpenAI tenha ampla adoção, diferentes plataformas mantêm tokenizadores proprietários que produzem resultados distintos. Essa fragmentação cria complexidade para organizações que monitoram sua presença em múltiplos sistemas de IA. Desenvolvimentos futuros podem incluir padrões de tokens para toda a indústria, assim como padrões de codificação de caracteres (UTF-8) unificaram a representação de texto entre sistemas. Essa padronização simplificaria a previsão de custos, permitiria comparação justa de serviços de IA e facilitaria o monitoramento da presença de marca em todo o ecossistema de IA. Para plataformas como a AmICited, dedicadas a rastrear aparições de marcas em respostas de IA, métricas padronizadas de tokens permitiriam medições mais precisas de como diferentes sistemas de IA interagem com o conteúdo e alocam recursos computacionais.

Em média, um token representa aproximadamente 4 caracteres ou cerca de três quartos de uma palavra em inglês. No entanto, isso varia significativamente dependendo do método de tokenização utilizado. Palavras curtas como 'the' ou 'a' normalmente consomem um token, enquanto palavras mais longas ou complexas podem exigir dois ou mais tokens. Por exemplo, a palavra 'darkness' pode ser dividida em 'dark' e 'ness' como dois tokens separados.

Modelos de linguagem são redes neurais que processam dados numéricos, não texto. Os tokens convertem texto em representações numéricas (embeddings) que as redes neurais podem entender e processar eficientemente. Essa etapa de tokenização é essencial porque padroniza a entrada, reduz a complexidade computacional e permite ao modelo aprender relações semânticas entre diferentes partes do texto por meio de operações matemáticas sobre os vetores de tokens.

Tokens de entrada são os tokens do seu prompt ou pergunta enviados ao modelo de IA, enquanto tokens de saída são os tokens que o modelo gera em sua resposta. A maioria dos serviços de IA cobra de forma diferente por tokens de entrada e de saída, sendo que os tokens de saída geralmente custam mais porque gerar novo conteúdo exige mais recursos computacionais do que processar texto existente. Seu uso total de tokens é a soma dos tokens de entrada e de saída.

A contagem de tokens determina diretamente os custos de API para modelos de linguagem. Serviços como OpenAI, Claude e outros cobram por token, com tarifas variando conforme modelo e tipo de token. Um prompt mais longo com mais tokens custa mais para processar, e gerar respostas mais extensas consome mais tokens de saída. Entender a eficiência dos tokens ajuda a otimizar custos—prompts concisos que transmitem as informações necessárias minimizam o consumo de tokens sem comprometer a qualidade da resposta.

Uma janela de contexto é o número máximo de tokens que um modelo de linguagem pode processar de uma vez, somando tokens de entrada e de saída. Por exemplo, o GPT-4 possui uma janela de contexto de 8.000 a 128.000 tokens, dependendo da versão. Esse limite determina quanto texto o modelo pode 'enxergar' e lembrar ao gerar respostas. Janelas de contexto maiores permitem processar documentos mais longos, mas também exigem mais recursos computacionais.

Os três principais métodos de tokenização são: nível de palavra (dividindo o texto em palavras inteiras), nível de caractere (tratando cada caractere como um token) e tokenização de subpalavra, como o Byte-Pair Encoding (BPE) usado pelos modelos GPT. A tokenização de subpalavra é a mais comum nos LLMs modernos porque equilibra o tamanho do vocabulário, lida bem com palavras raras e reduz erros de OOV (fora do vocabulário) preservando o significado semântico.

Para plataformas como a AmICited, que monitoram respostas de IA em ChatGPT, Perplexity, Claude e Google AI Overviews, o rastreamento de tokens é crucial para entender quanto do seu conteúdo de marca ou URLs estão sendo processados e citados por sistemas de IA. A contagem de tokens revela a profundidade do engajamento da IA com seu conteúdo—um uso maior de tokens indica citações ou referências mais substanciais, ajudando a medir a visibilidade e a influência da sua marca em respostas geradas por IA.

Sim, absolutamente. Diferentes modelos de linguagem usam diferentes tokenizadores e vocabulários, então o mesmo texto pode gerar diferentes quantidades de tokens. Por exemplo, a palavra 'antidisestablishmentarianism' resulta em 5 tokens no GPT-3, mas 6 tokens no GPT-4 devido a algoritmos de tokenização distintos. Por isso é importante usar contadores de tokens específicos do modelo ao estimar custos ou planejar prompts para sistemas de IA específicos.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Explore como os limites de tokens afetam a performance da IA e aprenda estratégias práticas para otimização de conteúdo, incluindo RAG, chunking e técnicas de s...

Saiba como modelos de IA processam texto por meio de tokenização, embeddings, blocos transformadores e redes neurais. Entenda o pipeline completo do input ao ou...

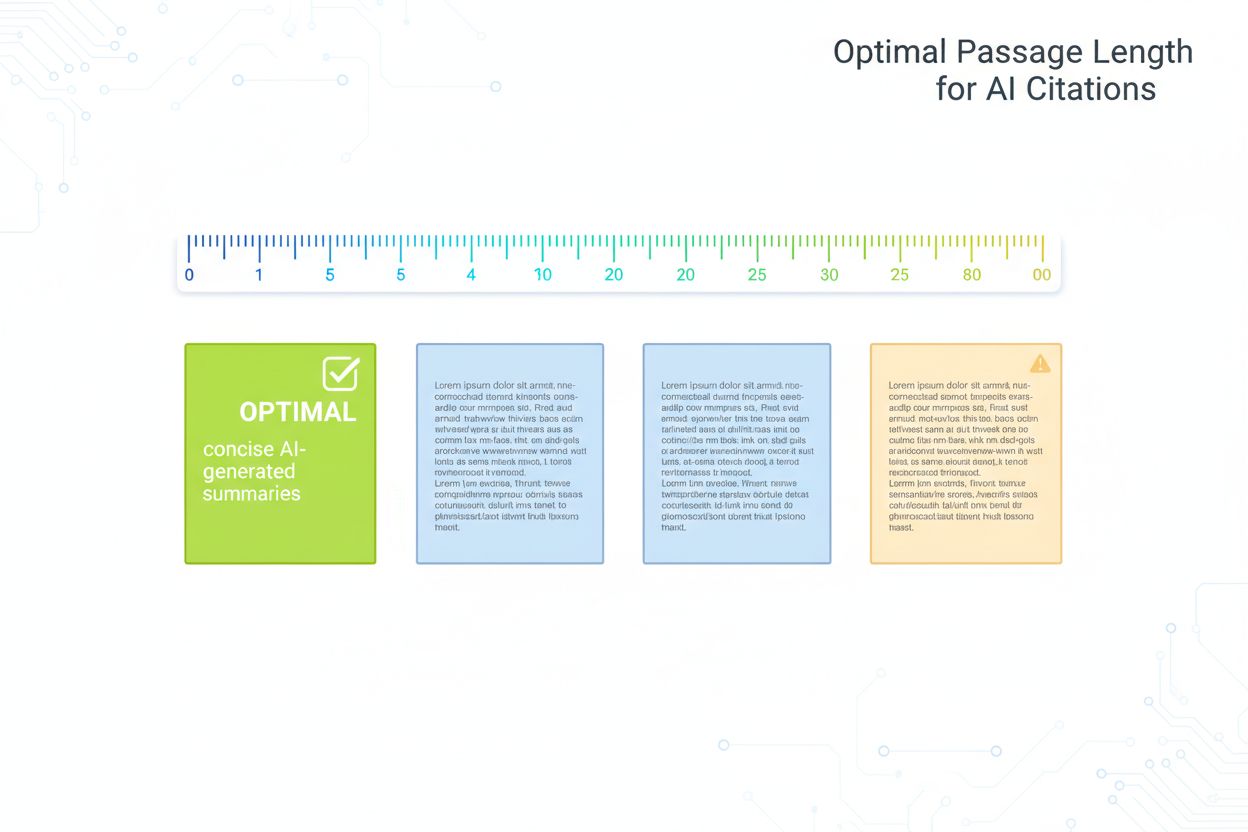

Guia fundamentado em pesquisa sobre o comprimento ideal de trechos para citações de IA. Saiba por que 75-150 palavras é o ideal, como os tokens afetam a recuper...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.