PerplexityBot

Află despre PerplexityBot, crawlerul web al Perplexity care indexează conținutul pentru motorul său AI de răspunsuri. Înțelege cum funcționează, respectarea rob...

Ghid complet despre crawler-ul PerplexityBot - înțelege cum funcționează, gestionează accesul, monitorizează citările și optimizează pentru vizibilitatea în Perplexity AI. Află despre preocupările privind stealth crawling și cele mai bune practici.

PerplexityBot este crawler-ul web oficial dezvoltat de Perplexity AI, conceput pentru a indexa și a afișa site-uri web în rezultatele de căutare alimentate de AI ale Perplexity. Spre deosebire de unele crawlere AI care colectează date pentru antrenarea modelelor lingvistice mari, PerplexityBot are un scop specific: să descopere, să scaneze și să lege site-uri care oferă răspunsuri relevante la întrebările utilizatorilor. Crawler-ul funcționează folosind un user-agent string clar definit (Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot)) și își publică intervalele de adrese IP, permițând proprietarilor de site-uri să identifice și să gestioneze traficul crawler-ului. Înțelegerea funcționării PerplexityBot este esențială pentru proprietarii de site-uri care doresc să controleze vizibilitatea conținutului lor în motorul de răspunsuri al Perplexity, menținând în același timp transparența asupra modului în care site-urile sunt accesate.

PerplexityBot operează ca un crawler web standard, scanând continuu internetul pentru a descoperi și indexa pagini web. Când întâlnește un site, citește fișierul robots.txt pentru a înțelege ce conținut îi este permis să acceseze, apoi scanează sistematic paginile pentru a extrage și indexa conținutul acestora. Această informație indexată alimentează algoritmul de căutare al Perplexity, care o folosește pentru a oferi răspunsuri citate la întrebările utilizatorilor. Totuși, Perplexity folosește de fapt două crawlere distincte cu scopuri diferite, fiecare cu propriul user-agent și propriile tipare de comportament. Înțelegerea diferenței dintre aceste crawlere este crucială pentru proprietarii de site-uri care doresc să își ajusteze politicile de acces.

| Caracteristică | PerplexityBot | Perplexity-User |

|---|---|---|

| Scop | Indexează site-uri pentru rezultate de căutare și citări | Preia pagini specifice în timp real când răspunde la întrebări ale utilizatorilor |

| User-Agent String | PerplexityBot/1.0 | Perplexity-User/1.0 |

| Respectare robots.txt | Respectă directivele disallow din robots.txt | De obicei ignoră robots.txt (cereri inițiate de utilizator) |

| Intervale IP | Publicate la perplexity.com/perplexitybot.json | Publicate la perplexity.com/perplexity-user.json |

| Frecvență | Crawling continuu, programat | La cerere, declanșat de interogările utilizatorilor |

| Utilizare | Construirea indexului de căutare | Preluarea informațiilor actuale pentru răspunsuri |

Distincția dintre aceste două crawlere este importantă deoarece pot fi gestionate separat prin reguli robots.txt și configurații de firewall. Crawling-ul regulat al PerplexityBot respectă directivele robots.txt, în timp ce Perplexity-User le poate ignora, deoarece preia conținut ca răspuns la o cerere specifică a utilizatorului. Ambele crawlere își publică intervalele de adrese IP, permițând proprietarilor de site-uri să implementeze reguli precise de firewall dacă doresc să blocheze sau să permită un anumit trafic de crawler.

În 2025, Cloudflare a publicat o investigație detaliată arătând că Perplexity folosea crawlere nedeclarate pentru a ocoli restricțiile site-urilor. Conform constatărilor, când crawlerele declarate ale Perplexity (PerplexityBot și Perplexity-User) erau blocate prin robots.txt sau firewall, compania folosea alte crawlere cu user-agent-uri generice de browser (precum Chrome pe macOS) și adrese IP rotative din diferite ASN-uri (Autonomous System Numbers) pentru a continua accesarea conținutului restricționat. Acest comportament contrazice direct standardele de crawling web din RFC 9309, care subliniază transparența și respectarea preferințelor proprietarilor de site-uri. Investigația a testat această practică creând domenii noi cu reguli explicite de disallow în robots.txt, iar Perplexity tot a furnizat informații detaliate despre conținut, sugerând folosirea unor surse de date nedeclarate sau tehnici de stealth crawling.

Aceasta contrastează puternic cu modul în care OpenAI gestionează crawlerele. GPTBot de la OpenAI se identifică clar, respectă directivele robots.txt și oprește crawling-ul când întâlnește restricții—dovedind că un comportament transparent și etic al crawler-elor este posibil și practic. Constatările Cloudflare au ridicat preocupări serioase privind veridicitatea angajamentului Perplexity de a respecta preferințele site-urilor, în special pentru proprietarii care doresc explicit să oprească indexarea sau citarea conținutului lor de către sisteme AI. Pentru acești proprietari, controversa subliniază importanța monitorizării comportamentului crawler-elor și folosirii mai multor nivele de protecție (robots.txt, reguli WAF și blocare IP) pentru a-și impune preferințele.

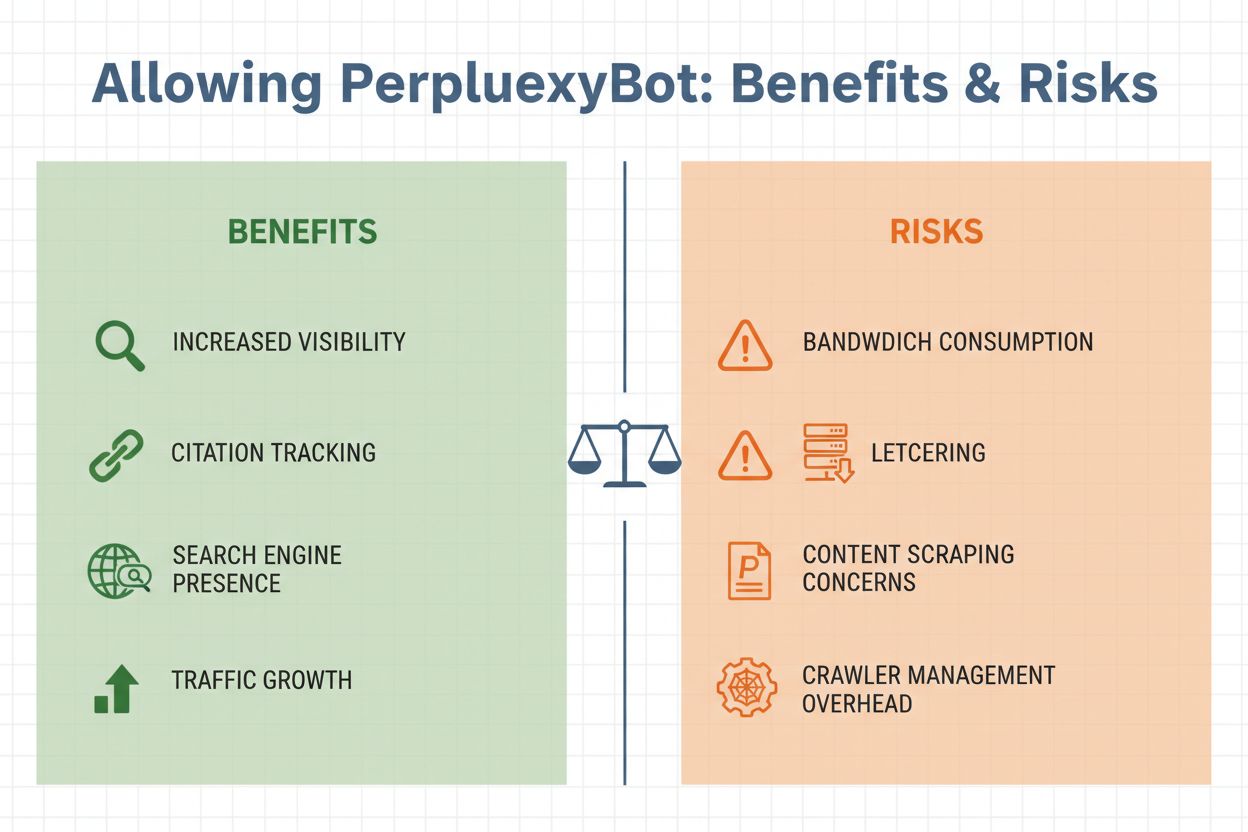

Decizia de a permite PerplexityBot pe site-ul tău implică evaluarea mai multor factori importanți. Pe de o parte, permiterea crawler-ului aduce beneficii semnificative: conținutul tău devine eligibil pentru a fi citat în răspunsurile Perplexity, ceea ce poate atrage trafic de referință de la utilizatorii care îți văd site-ul menționat în răspunsurile AI. Pe de altă parte, există preocupări legitime legate de consumul de bandă, scraping-ul conținutului și pierderea controlului asupra modului în care informațiile tale sunt folosite. Decizia depinde în final de obiectivele afacerii, strategia de conținut și nivelul de confort privind accesul AI la datele tale.

Considerente cheie pentru permiterea PerplexityBot:

Gestionarea accesului PerplexityBot este simplă și poate fi realizată prin mai multe metode, în funcție de infrastructura tehnică și cerințele tale specifice. Cea mai comună abordare este folosirea fișierului robots.txt, care oferă directive clare tuturor crawler-elor care respectă regulile privind ce conținut pot accesa.

Pentru a permite PerplexityBot în robots.txt:

User-agent: PerplexityBot

Allow: /

Pentru a bloca PerplexityBot în robots.txt:

User-agent: PerplexityBot

Disallow: /

Dacă dorești să blochezi PerplexityBot doar din anumite directoare, permițând accesul la altele, poți folosi reguli mai detaliate:

User-agent: PerplexityBot

Disallow: /admin/

Disallow: /private/

Allow: /public/

Pentru protecție mai robustă, mai ales dacă te preocupă stealth crawling-ul, implementează reguli de firewall la nivelul Web Application Firewall (WAF). Utilizatorii Cloudflare WAF pot crea reguli personalizate pentru a bloca PerplexityBot combinând user-agent-ul și potrivirea cu adresele IP publicate:

Utilizatorii AWS WAF ar trebui să creeze IP set-uri folosind intervalele oficiale PerplexityBot de la https://www.perplexity.com/perplexitybot.json, apoi să creeze reguli care să se potrivească atât cu IP set-ul, cât și cu user-agent-ul PerplexityBot. Folosește întotdeauna intervalele oficiale publicate de Perplexity, întrucât acestea se actualizează regulat și sunt sursa autoritară pentru traficul legitim al crawlerului.

După stabilirea unei politici pentru PerplexityBot, monitorizarea activității efective a crawler-ului te ajută să verifici dacă regulile funcționează corect și să înțelegi impactul asupra infrastructurii. Poți identifica cererile PerplexityBot în logurile serverului căutând user-agent-ul distinctiv: PerplexityBot/1.0 sau user-agent generic de browser dacă are loc stealth crawling. Majoritatea platformelor de analiză web și uneltelor de analiză a logurilor permit filtrarea traficului după user-agent, facilitând izolarea cererilor PerplexityBot și analiza tiparelor acestora.

Metrici cheie de monitorizat includ frecvența vizitelor crawler-ului, paginile accesate și lățimea de bandă consumată. Dacă observi tipare neobișnuite—precum crawling rapid al paginilor sensibile sau cereri din adrese IP care nu apar în intervalele publicate de Perplexity—acesta poate fi un indiciu de stealth crawling. Pe lângă monitorizarea de bază a traficului, folosirea unor unelte specializate precum AmICited.com oferă informații mai detaliate despre cum conținutul tău este citat pe platforme AI precum Perplexity. AmICited urmărește mențiunile brandului și conținutului tău în răspunsurile generate de AI, permițându-ți să măsori impactul real al permiterii PerplexityBot și să înțelegi care pagini sunt cele mai valoroase pentru sistemele AI. Aceste date te ajută să iei decizii informate despre gestionarea crawler-elor în viitor și strategiile de optimizare a conținutului.

Gestionarea eficientă a PerplexityBot necesită o abordare echilibrată, care să îți protejeze interesele, dar să recunoască și valoarea vizibilității AI. În primul rând, stabilește o politică clară bazată pe obiectivele afacerii: decide dacă traficul și expunerea brandului obținute prin citările Perplexity justifică preocupările legate de bandă și controlul conținutului. Documentează această decizie în fișierul robots.txt și comunic-o echipei, astfel încât toată lumea să înțeleagă strategia de gestionare a crawler-elor.

În al doilea rând, implementează protecție pe mai multe niveluri dacă alegi să blochezi PerplexityBot. Nu te baza doar pe robots.txt, deoarece controversa stealth crawling demonstrează că unele crawlere pot ignora aceste directive. Combină regulile din robots.txt cu reguli WAF și blocare IP pentru o protecție de tip defense-in-depth. În al treilea rând, fii la curent cu comportamentul crawler-elor monitorizând regulat logurile și urmărind discuțiile din industrie despre etica și transparența crawler-elor AI. Peisajul evoluează rapid, iar noi crawlere sau tactici pot apărea, necesitând ajustări ale politicilor.

În final, folosește strategic unelte de monitorizare pentru a măsura impactul real al deciziilor tale. Unelte precum AmICited.com oferă vizibilitate asupra modului în care sistemele AI citează conținutul tău, ajutându-te să înțelegi dacă permiterea PerplexityBot aduce beneficiile de vizibilitate pe care le aștepți. Dacă permiți crawler-ul, aceste date te ajută să optimizezi conținutul pentru citare AI. Dacă îl blochezi, monitorizarea confirmă că blocajele sunt eficiente și că nu apari în rezultatele Perplexity prin alte metode.

PerplexityBot operează într-un peisaj aglomerat de crawlere AI, fiecare cu scopuri și standarde de transparență diferite. GPTBot, operat de OpenAI, este recunoscut pentru comportamentul transparent—se identifică clar, respectă directivele robots.txt și oprește crawling-ul când este blocat. Crawler-ele Google pentru AI Overviews și alte funcții AI mențin, de asemenea, transparență și respect pentru preferințele site-urilor. În schimb, comportamentul de stealth crawling al Perplexity, documentat de Cloudflare, reprezintă o abatere îngrijorătoare de la aceste standarde.

Diferența cheie constă în transparență și respectarea preferințelor proprietarilor de site-uri. Crawlerele bine-intenționate precum GPTBot facilitează înțelegerea activității lor și oferă mecanisme clare de control. Utilizarea de crawlere nedeclarate și rotația IP-urilor de către Perplexity pentru a ocoli restricțiile subminează această încredere. Pentru proprietarii de site-uri, aceasta înseamnă că ar trebui să fie mai precauți față de politicile declarate ale Perplexity și să implementeze controale tehnice mai puternice dacă vor să se asigure că preferințele le sunt respectate. Pe măsură ce ecosistemul crawler-elor AI se maturizează, este de așteptat să crească presiunea asupra companiilor precum Perplexity să adopte practici mai transparente și etice, aliniate la standardele web consacrate și respectul pentru autonomia proprietarilor de site-uri.

PerplexityBot este crawler-ul web oficial al Perplexity AI, conceput pentru a indexa site-uri și a le afișa în rezultatele de căutare alimentate de AI ale Perplexity. Spre deosebire de unele crawlere AI care colectează date pentru antrenare, PerplexityBot descoperă și leagă site-uri care oferă răspunsuri relevante la întrebările utilizatorilor. Acționează transparent, cu un user-agent publicat și intervale de adrese IP disponibile.

Nu. Conform documentației oficiale Perplexity, PerplexityBot este conceput pentru a afișa și lega site-uri în rezultatele căutării pe Perplexity. Nu este folosit pentru a scana conținut în scopul antrenării modelelor AI de bază. Singura funcție a crawler-ului este să indexeze conținut pentru includerea în motorul de răspunsuri Perplexity.

Poți bloca PerplexityBot folosind fișierul robots.txt, adăugând 'User-agent: PerplexityBot' urmat de 'Disallow: /' pentru a preveni orice acces. Pentru protecție suplimentară, implementează reguli WAF pe Cloudflare sau AWS WAF care blochează cererile ce coincid cu user-agent-ul și intervalele de IP ale PerplexityBot. Totuși, fii atent că stealth crawling-ul poate ocoli aceste controale.

Perplexity publică intervalele oficiale de adrese IP pentru PerplexityBot la https://www.perplexity.com/perplexitybot.json și pentru Perplexity-User la https://www.perplexity.com/perplexity-user.json. Aceste intervale sunt actualizate regulat și ar trebui să fie sursa autoritară pentru configurațiile tale de firewall și WAF. Folosește întotdeauna aceste endpoint-uri oficiale, nu liste de IP-uri învechite.

PerplexityBot susține că respectă directivele robots.txt, însă investigația Cloudflare din 2025 a găsit dovezi de stealth crawling folosind user-agents nedeclarate și adrese IP rotative pentru a ocoli restricțiile robots.txt. Deși crawler-ul PerplexityBot declarat ar trebui să respecte regulile din robots.txt, este recomandat să implementezi și protecții suplimentare WAF pentru a te asigura că preferințele tale sunt aplicate.

Consumul de lățime de bandă variază în funcție de dimensiunea și volumul de conținut al site-ului tău. PerplexityBot realizează crawling continuu, programat, similar cu crawler-ul Google. Site-urile cu trafic ridicat pot observa un consum măsurabil de bandă. Poți monitoriza utilizarea reală filtrând logurile serverului după cererile PerplexityBot și analizând volumul de date transferat pentru a determina dacă afectează infrastructura ta.

Da. Poți căuta manual pe Perplexity interogări legate de conținutul tău pentru a vedea dacă site-ul tău este citat în răspunsuri. Pentru monitorizare mai amplă, folosește instrumente precum AmICited.com, care urmărește cum brandul și conținutul tău apar pe platforme AI, inclusiv Perplexity, oferind informații în timp real despre vizibilitatea și tiparul citărilor AI.

PerplexityBot este crawler-ul programat care indexează continuu site-uri pentru indexul de căutare al Perplexity. Perplexity-User este declanșat la cerere când utilizatorii pun întrebări iar Perplexity trebuie să preia pagini specifice pentru informații în timp real. PerplexityBot respectă robots.txt, în timp ce Perplexity-User îl ignoră de obicei, deoarece răspunde cererilor utilizatorilor. Fiecare are propriul user-agent și intervale IP separate.

Urmărește cum Perplexity și alte platforme AI citează brandul tău. Obține informații în timp real despre vizibilitatea ta în AI și optimizează-ți strategia de conținut pentru impact maxim în motoarele de căutare generative.

Află despre PerplexityBot, crawlerul web al Perplexity care indexează conținutul pentru motorul său AI de răspunsuri. Înțelege cum funcționează, respectarea rob...

Perplexity AI este un motor de răspunsuri alimentat de AI care combină căutarea web în timp real cu LLM-uri pentru a oferi răspunsuri citate și exacte. Află cum...

Depanează problemele de crawling AI cu jurnalele de server, identificarea agenților utilizatori și soluții tehnice. Monitorizează crawlerele ChatGPT, Perplexity...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.