Viziunea pe termen lung pentru vizibilitatea AI: Încotro ne îndreptăm

Explorează viitorul monitorizării vizibilității AI, de la standarde de transparență la conformitate cu reglementările. Află cum se pot pregăti brandurile pentru...

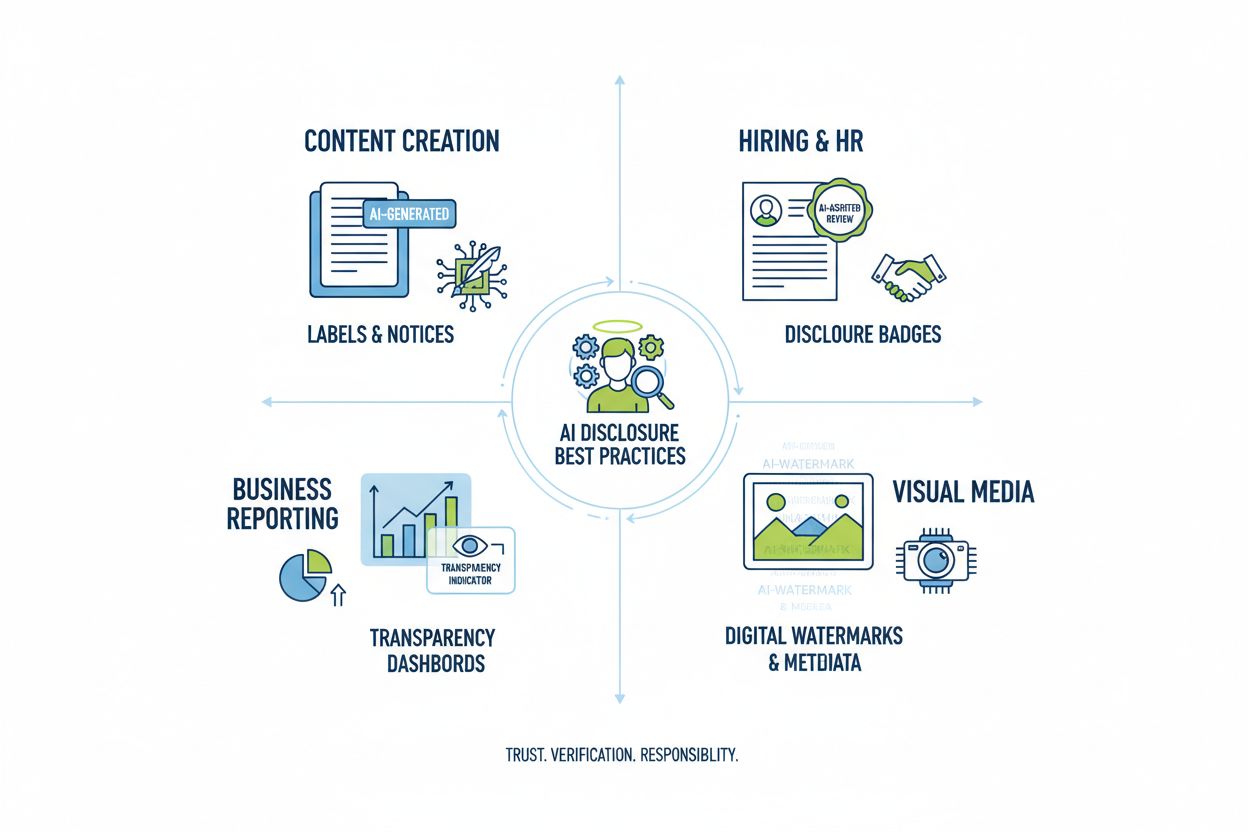

Învață cele mai bune practici esențiale pentru transparență și divulgare AI. Descoperă metode comportamentale, verbale și tehnice de divulgare pentru a construi încredere și a asigura conformitatea cu reglementările AI în continuă evoluție.

Transparența AI a devenit o cerință esențială într-o eră în care sistemele de inteligență artificială influențează totul, de la crearea de conținut la deciziile de angajare și recomandările financiare. Pe măsură ce conținutul generat de AI se răspândește pe platformele digitale, organizațiile se confruntă cu o presiune tot mai mare de a dezvălui când și cum folosesc aceste tehnologii, nu doar ca obligație legală, ci ca o condiție fundamentală pentru menținerea încrederii și credibilității în fața audienței lor. Miza este deosebit de ridicată pentru branduri și creatori de conținut, deoarece consumatorii solicită tot mai des să știe dacă informațiile pe care le consumă provin din expertiză umană sau sunt generate algoritmic. Fără practici transparente de divulgare, organizațiile riscă să piardă încrederea construită în ani de zile, putând suferi daune de imagine, sancțiuni de reglementare și pierderea încrederii publicului. Relația dintre transparență și credibilitate este simbiotică — organizațiile care dezvăluie proactiv utilizarea AI demonstrează integritate și respect față de părțile interesate, poziționându-se ca actori onești într-un peisaj tot mai dominat de AI.

Proliferarea conținutului generat de AI a creat un paradox profund al încrederii: publicul întâmpină dificultăți în a distinge între lucrări autentice realizate de oameni și alternative sofisticate generate de AI, însă transparența privind utilizarea AI rămâne inconsistentă între industrii. Această confuzie subminează contractul fundamental dintre creatori și consumatori, unde audiența se așteaptă să cunoască adevărata sursă a conținutului întâlnit. Când conținutul generat de AI este prezentat fără divulgare, acest lucru încalcă acordul implicit, creând o dihotomie între “real” și “fals” care merge dincolo de simpla autenticitate — atinge aspecte precum înșelăciunea, manipularea și consimțământul informat. Paradoxul se adâncește deoarece unele conținuturi generate de AI pot fi imposibil de deosebit de cele umane ca stil și calitate, ceea ce face ca indiciile vizuale sau stilistice să nu fie de încredere. Transparența contează tocmai pentru că rezolvă acest paradox, oferind publicului informațiile necesare pentru a lua decizii informate despre conținutul consumat și în care se poate avea încredere. Organizațiile care adoptă practici clare de divulgare transformă scepticismul potențial în încredere, arătând că nu au nimic de ascuns și totul de câștigat din comunicarea onestă.

Mediul reglementărilor privind divulgarea AI evoluează rapid, mai multe jurisdicții implementând sau propunând cerințe pe care organizațiile trebuie să le navigheze cu atenție. Legea AI a UE, unul dintre cele mai cuprinzătoare cadre, impune ca orice conținut generat sau editat semnificativ de AI să includă divulgare vizibilă sau la nivel de metadate, cu cerințe specifice pentru sistemele AI cu risc ridicat și obligații de transparență pentru dezvoltatori. În Statele Unite, FTC a emis avertismente că neactualizarea Termenilor de utilizare și a Politicilor de confidențialitate pentru utilizarea AI poate constitui practici înșelătoare, în timp ce reglementările la nivel de stat — în special noua lege de divulgare AI frontier model din California — impun obligații sporite de transparență și raportare pentru dezvoltatorii de sisteme AI mari. Considerațiile legate de drepturile de autor și proprietatea intelectuală adaugă un nivel suplimentar de complexitate, deoarece organizațiile trebuie să dezvăluie dacă datele de antrenament au inclus materiale protejate prin drepturi de autor și cum au fost antrenate sistemele AI. În plus, cerințele GDPR și CCPA se extind asupra sistemelor AI care procesează date cu caracter personal, solicitând organizațiilor să dezvăluie deciziile automate și să ofere persoanelor informații relevante despre procesarea AI. Tabelul următor rezumă principalele cerințe de reglementare în jurisdicțiile majore:

| Jurisdicție | Regulament | Cerințe principale | Data intrării în vigoare |

|---|---|---|---|

| Uniunea Europeană | Legea AI a UE | Divulgare pentru AI cu risc ridicat; rapoarte de transparență; etichetare cu metadate pentru conținutul generat de AI | Faze (2024-2026) |

| Statele Unite (Federal) | Ghiduri FTC | Actualizare politici de confidențialitate; divulgare utilizare AI; evitarea practicilor înșelătoare | Permanent |

| California | AI Frontier Model Law | Divulgare standardizată; obligații de raportare; măsuri de siguranță | 2025 |

| Uniunea Europeană | GDPR | Divulgare decizii automate; furnizare informații despre procesarea AI | Permanent |

| Statele Unite (Mai multe state) | CCPA & Similar | Divulgare utilizare date în sistemele AI; mecanisme de opt-out | Variază după stat |

| Internațional | Considerații de drepturi de autor | Divulgare surse de date de antrenament; abordarea drepturilor de autor în output-uri AI | În curs de apariție |

Organizațiile care operează în mai multe jurisdicții trebuie să implementeze practici de divulgare care să satisfacă cele mai stricte cerințe, deoarece conformitatea cu un standard depășește adesea minimul cerut de altele.

Semnalele comportamentale reprezintă cea mai subtilă, dar puternică formă de divulgare AI, acționând prin prezentare, stil, voce și alegeri creative pe care publicul le procesează inconștient când evaluează autenticitatea conținutului. Aceste semnale includ tipare distincte în stilul de scriere, consistența vocii, alegerile de compoziție vizuală, caracteristicile avatarului sau personajului și gradul general de “fidelitate” a creatorului — practic, măsura în care conținutul reflectă personalitatea și deciziile umane autentice. De exemplu, textul generat de AI prezintă adesea anumite tipare în structura frazelor, alegeri de vocabular și flux logic diferite față de scrierea umană, iar imaginile generate de AI pot avea inconsistențe subtile în iluminare, anatomie sau detalii de fundal, observabile de ochiul antrenat. Conceptul de fidelitate a creatorului este central aici: publicul dezvoltă așteptări despre cum ar trebui să sune, să arate și să se prezinte un anumit creator, iar abaterile de la acest tipar pot semnala implicarea AI. Totuși, a te baza doar pe semnalele comportamentale este problematic, deoarece sistemele AI devin rapid tot mai bune la imitarea caracteristicilor umane, iar publicul nu poate fi transformat în experți de forensică AI. Prin urmare, semnalele comportamentale ar trebui să fie complementare, nu să înlocuiască metodele explicite de divulgare, constituind un strat secundar de transparență care întărește, nu substituie, comunicarea clară și directă despre utilizarea AI.

Strategiile de divulgare verbală oferă comunicare explicită și directă despre utilizarea AI prin semnale bazate pe limbaj care elimină ambiguitatea privind originea conținutului și implicarea AI. Aceste metode sunt esențiale deoarece creează o înregistrare clară, documentată a divulgării și asigură că publicul primește informații neechivoce despre utilizarea AI. Organizațiile pot implementa divulgarea verbală prin mai multe abordări complementare:

Adecvarea fiecărei metode depinde de context: etichetele funcționează bine pentru social media și conținut vizual, watermark-urile sunt potrivite pentru video și audio, byline-urile pentru jurnalism și creație, câmpurile de divulgare pentru conținutul de tip long-form, iar mulțumirile oferă context complet pentru proiecte complexe. Organizațiile ar trebui să aleagă metode de divulgare care se potrivesc formatului conținutului și așteptărilor audienței, asigurându-se că divulgarea nu poate fi trecută cu vederea, dar rămâne neintruzivă pentru experiența utilizatorului.

Semnalele tehnice și metadatele oferă informații standardizate, lizibile de mașină despre implicarea AI, permițând detectarea, verificarea și urmărirea automată a conținutului generat de AI în ecosistemele digitale. Aceste abordări folosesc date încorporate și tehnici criptografice pentru a crea înregistrări permanente, rezistente la falsificare, ale originii conținutului și istoricului de procesare. Standardele IPTC, recent actualizate pentru a include proprietăți de metadate specifice AI, permit creatorilor să insereze informații structurate despre utilizarea AI direct în fișierele de imagine, inclusiv detalii despre ce sisteme AI au fost folosite, ce procesări au fost aplicate și ce modificări umane au fost realizate. C2PA (Coalition for Content Provenance and Authenticity) reprezintă un standard emergent care folosește semnături criptografice și credențiale de conținut pentru a stabili lanțuri verificabile de proveniență, permițând publicului să urmărească conținutul până la sursa originală și să înțeleagă toate modificările aplicate. Aceste abordări tehnice rezolvă o limitare critică a divulgării lizibile de om: creează înregistrări permanente, verificabile, care nu pot fi ușor eliminate sau alterate și permit sistemelor automate să identifice și să marcheze conținutul AI la scară largă. Organizațiile care implementează divulgarea tehnică ar trebui să adopte credentțiale C2PA pentru conținutul valoros, să insereze metadate IPTC în imagini și fișiere media și să mențină documentație detaliată despre tipul sursei digitale care urmărește implicarea AI pe tot parcursul ciclului de viață al conținutului. Avantajul semnalelor tehnice este permanența și verificabilitatea lor; provocarea este ca publicul și platformele să înțeleagă și să respecte aceste semnale.

Divulgarea AI de succes presupune instituționalizarea practicilor de transparență pe tot parcursul fluxului de creare a conținutului, transformând divulgarea dintr-un gând de final într-o componentă fundamentală a guvernanței conținutului. Organizațiile ar trebui să implementeze cadre structurate de conținut care să surprindă implicarea AI în fiecare etapă a creării — de la cercetare și redactare la editare și publicare — asigurând că informațiile despre divulgare circulă natural prin sistemele de gestionare a conținutului. Automatizarea și integrarea în fluxul de lucru sunt esențiale: sistemele de gestionare a conținutului ar trebui să includă câmpuri obligatorii pentru divulgare AI, notificări automate care să ceară creatorilor să documenteze utilizarea AI înainte de publicare și fluxuri de aprobare care să verifice completitudinea divulgării înainte ca materialele să fie publicate. Această abordare tratează divulgarea ca pe o cerință de asigurare a calității, similar cu verificarea faptelor, revizuirea legală sau conformitatea cu brandul. Organizațiile trebuie să stabilească și politici clare care să definească ce constituie utilizare AI ce necesită divulgare (ex: este necesară divulgarea dacă AI-ul a fost folosit pentru cercetare? Dar pentru editare asistată de AI?), asigurând coerență între echipe și prevenind lacunele de divulgare. Instruirea și documentarea sunt la fel de importante: creatorii de conținut au nevoie de ghidaj clar privind modul de a divulga corect utilizarea AI pentru diferite tipuri de conținut și platforme. Prin integrarea divulgării în modelele și fluxurile de lucru ale conținutului, organizațiile transformă transparența dintr-o povară de conformitate într-o procedură standard ce protejează atât organizația, cât și publicul.

Aplicațiile diferite ale AI necesită abordări personalizate de divulgare, adaptate la context, așteptările audienței și cerințele de reglementare. Crearea de conținut (articole, social media, texte de marketing) ar trebui să includă etichete clare sau modificări de byline care indică implicarea AI, cu câmpuri suplimentare de divulgare care explică ce instrumente AI au fost folosite și câtă supraveghere umană a existat; acest lucru este deosebit de important pentru conținutul de știri și editorial unde încrederea depinde de înțelegerea originii. Angajarea și recrutarea cer divulgare riguroasă, deoarece candidații au dreptul să știe când aplicațiile lor sunt evaluate de sisteme AI sau când screeningul inițial e automatizat, cu explicații detaliate despre modul în care se iau deciziile AI și ce procese de revizuire umană urmează. Raportarea și analiza (rapoarte financiare, cercetări de piață, analize de date) ar trebui să includă divulgări tehnice și metadate care să indice ce analize au fost asistate de AI, mai ales când sistemele AI au identificat modele sau au generat concluzii care au influențat rezultatele. Conținutul vizual (imagini, video, grafică) necesită atât watermark-uri vizuale, cât și divulgare prin metadate, deoarece publicul nu poate distinge fiabil între vizualurile generate de AI și cele autentice; acest aspect este crucial pentru fotografii de știri, imagini de produs și orice material unde autenticitatea influențează deciziile de cumpărare sau încrederea. Comunicările cu clienții (chatbot-uri, răspunsuri automate, servicii clienți) trebuie să indice clar implicarea AI la începutul interacțiunii, permițând clienților să solicite asistență umană dacă doresc. Organizațiile ar trebui să auditeze utilizarea AI în toate aceste contexte și să implementeze practici de divulgare proporționale cu sensibilitatea și impactul fiecărui caz de utilizare, recunoscând că cerințele de transparență diferă în funcție de modul în care deciziile AI afectează publicul.

Viitorul divulgării AI depinde de standardizarea la nivel de industrie și de dezvoltarea unor cadre interoperabile care să permită transparență coerentă și comparabilă între organizații și platforme. Standardele emergente precum C2PA, specificațiile de metadate IPTC și AI Risk Management Framework al NIST oferă structuri de bază, dar adoptarea largă necesită efort coordonat din partea platformelor tehnologice, creatorilor de conținut, reglementatorilor și organizațiilor de industrie. Legea AI a UE și cadrele de reglementare similare impulsionează standardizarea prin impunerea unor formate de divulgare și categorii de informații specifice, creând presiune pentru adoptarea la scară largă a unor standarde comune în locul abordărilor individuale. Inițiativele de industrie precum ghidurile etice AI ale PRSA și diverse cadre de raportare a transparenței demonstrează un consens tot mai mare privind cele mai bune practici, deși adoptarea voluntară rămâne inconsistentă. Următorul pas critic este trecerea de la standarde voluntare la cerințe reglementate care să impună divulgarea standardizată, similar cu modul în care etichetele nutriționale FDA au standardizat transparența alimentară. Platformele de monitorizare și vizibilitate — precum AmICited.com — joacă un rol tot mai important, urmărind modul în care AI menționează brandurile și conținutul în răspunsuri generate de AI, oferind organizațiilor vizibilitate asupra modului în care munca lor apare în output-urile AI și dacă se realizează atribuiri și divulgări corecte. Pe măsură ce sistemele AI devin tot mai sofisticate și omniprezente, capacitatea de a monitoriza, verifica și audita practicile de divulgare AI devine esențială pentru menținerea încrederii în ecosistemele digitale de informații. Organizațiile care investesc astăzi în practici solide de divulgare și capacități de monitorizare vor fi cel mai bine poziționate să navigheze peisajul reglementărilor în schimbare și să mențină încrederea publicului într-un viitor dominat de AI.

Divulgarea comportamentală folosește alegeri de prezentare (stil, voce, avatar) pentru a semnala implicarea AI. Divulgarea verbală folosește declarații explicite, etichete și watermark-uri. Divulgarea tehnică încorporează metadate lizibile de mașină și semnături criptografice. Fiecare metodă servește audiențe și contexte diferite, iar organizațiile ar trebui să utilizeze mai multe metode împreună pentru transparență completă.

Cerințele legale variază în funcție de jurisdicție. Legea AI a UE impune divulgarea pentru sistemele AI cu risc ridicat. FTC solicită divulgare când utilizarea AI poate influența deciziile consumatorilor. Legi la nivel de stat precum AI Frontier Model Law din California impun obligații de raportare. Legea dreptului de autor cere divulgarea conținutului generat de AI. Organizațiile trebuie să consulte consilieri juridici pentru cerințe specifice fiecărei jurisdicții.

Imaginile generate de AI trebuie să includă atât watermark-uri vizuale, cât și divulgare prin metadate. Watermark-urile vizuale trebuie să fie vizibile, dar neintruzive, indicând clar generarea AI. Metadatele ar trebui să conțină informații IPTC despre tipul sursei digitale și credențiale C2PA când sunt disponibile. Legendele și câmpurile de divulgare trebuie să menționeze explicit că imaginile sunt generate de AI, mai ales pentru conținut de știri, produse sau promoțional.

Standardele IPTC oferă câmpuri structurate de metadate pentru documentarea utilizării AI în imagini și fișiere media. Permit detectarea și urmărirea automată a conținutului generat de AI pe platforme. Categoriile IPTC pentru tipul sursei digitale includ 'Trained Algorithmic Media', 'Composite Synthetic' și 'Algorithmic Media'. Aceste standarde contează deoarece creează înregistrări permanente, verificabile ale implicării AI care nu pot fi ușor eliminate sau modificate.

Companiile ar trebui să efectueze un audit AI pentru a identifica toate cazurile de utilizare, să implementeze politici de divulgare aliniate cu reglementările aplicabile, să integreze divulgarea în fluxurile de lucru de gestionare a conținutului, să instruiască echipele privind cerințele de divulgare și să monitorizeze regulat conformitatea. Consultarea cu experți juridici familiarizați cu reglementările AI locale este esențială, deoarece cerințele variază semnificativ între regiuni.

Consecințele includ sancțiuni de reglementare (amenzi FTC, încălcări ale legii statului), daune reputaționale și pierderea încrederii publicului, răspundere juridică pentru încălcarea dreptului de autor sau practici înșelătoare și posibile procese din partea părților afectate. Organizațiile care nu dezvăluie utilizarea AI riscă să erodeze credibilitatea construită în ani de zile, ceea ce face ca divulgarea proactivă să fie o investiție strategică în încrederea pe termen lung.

Diferite părți interesate au nevoie de niveluri diferite de informații. Publicul larg are nevoie de declarații simple și clare despre implicarea AI. Reglementatorii au nevoie de documentație tehnică detaliată și dovezi de conformitate. Jurnaliștii și creatorii de conținut au nevoie de informații specifice despre instrumentele AI și supravegherea umană. Clienții trebuie să înțeleagă cum le influențează AI experiența. Adaptați formatul și detaliile divulgării la nevoile și așteptările fiecărei audiențe.

C2PA (Coalition for Content Provenance and Authenticity) oferă credențiale criptografice pentru verificarea conținutului. Standardele IPTC permit încorporarea metadatelor în imagini. Sistemele de gestionare a conținutului includ tot mai frecvent câmpuri de divulgare AI. Platforme de monitorizare precum AmICited.com urmăresc referințele și vizibilitatea AI. Cadrul oferit de organizații precum PRSA, NIST și altele furnizează ghidaj. Adoptarea acestor instrumente și standarde se accelerează pe măsură ce reglementările devin mai stricte.

Urmărește cum sistemele AI menționează brandul tău pe GPT-uri, Perplexity și Google AI Overviews. Asigură-te că conținutul tău primește atribuirea corectă și vizibilitate în răspunsurile generate de AI.

Explorează viitorul monitorizării vizibilității AI, de la standarde de transparență la conformitate cu reglementările. Află cum se pot pregăti brandurile pentru...

Află ce înseamnă transparența clasificării AI, de ce contează pentru creatorii de conținut și utilizatori și cum diferite platforme AI precum Perplexity, Google...

Află cum să alegi platforma potrivită de monitorizare a vizibilității AI pentru brandul tău. Compară funcționalități, prețuri și capabilități pentru a-ți urmări...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.