Cum Identifici Intenția de Căutare pentru Optimizarea AI

Află cum să identifici și să optimizezi pentru intenția de căutare în motoarele de căutare AI. Descoperă metode de clasificare a interogărilor utilizatorilor, a...

Află cum interpretează modelele lingvistice mari intenția utilizatorului dincolo de cuvinte cheie. Descoperă extinderea interogărilor, înțelegerea semantică și cum determină sistemele AI ce conținut să citeze în răspunsuri.

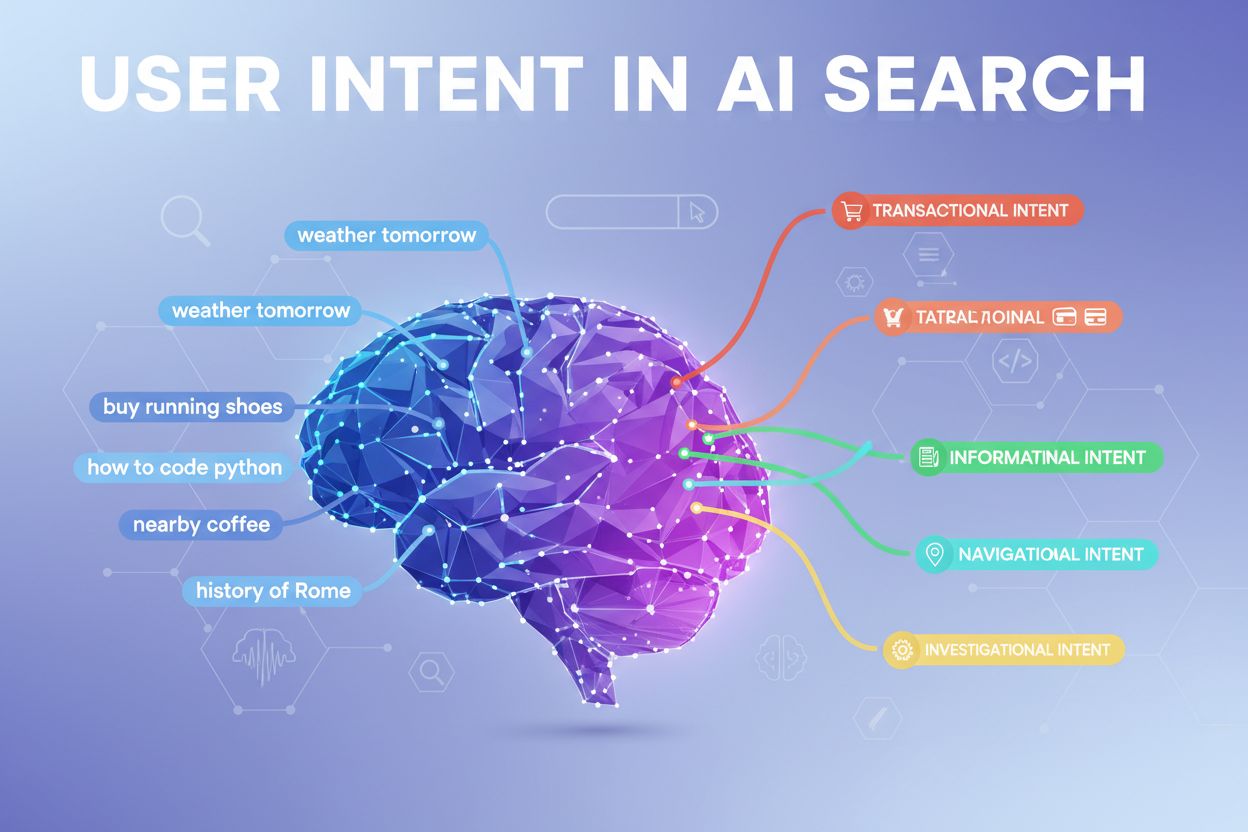

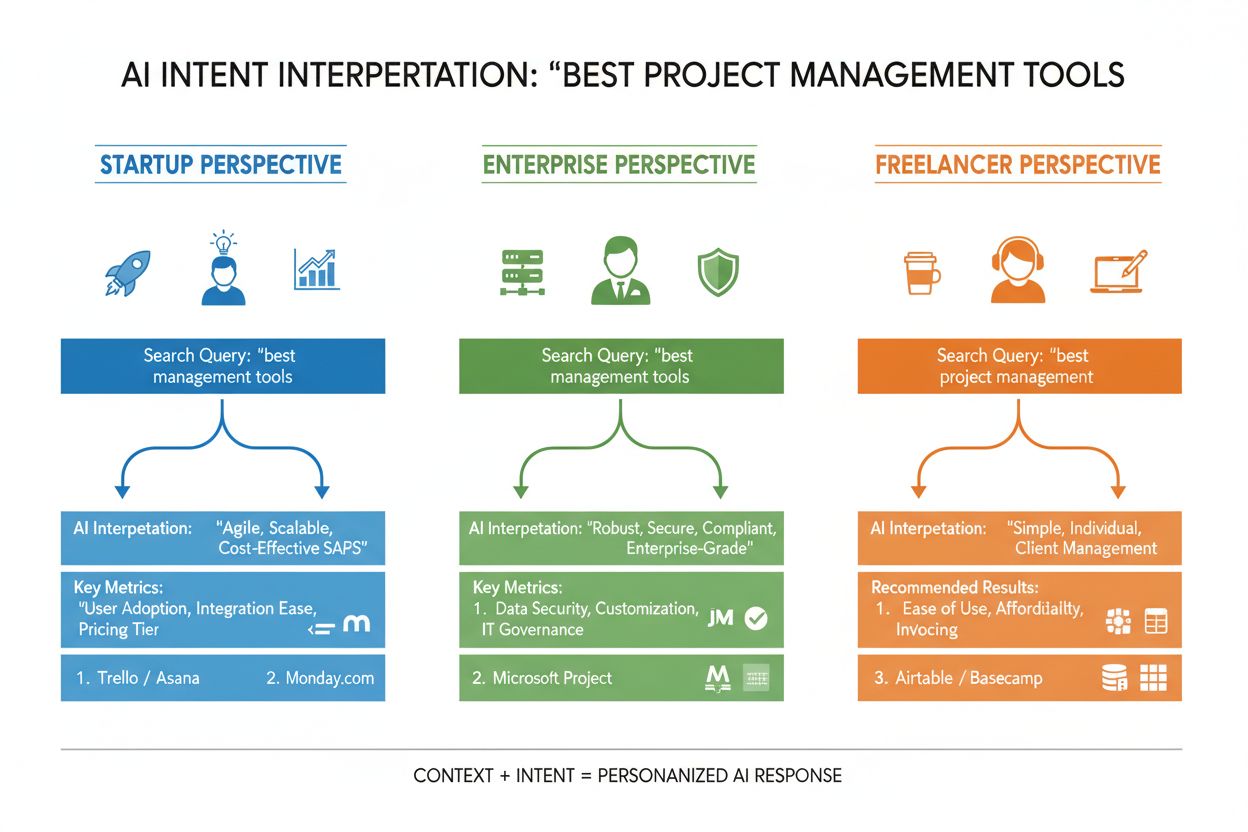

Intenția utilizatorului în căutarea AI se referă la scopul sau obiectivul de bază din spatele unei interogări, nu doar la cuvintele cheie tastate de cineva. Când cauți „cele mai bune instrumente de management de proiect”, poți să vrei o comparație rapidă, informații despre prețuri sau capabilități de integrare—iar modelele lingvistice mari (LLM-uri) precum ChatGPT, Perplexity și Gemini de la Google lucrează pentru a înțelege care dintre aceste obiective le urmărești de fapt. Spre deosebire de motoarele de căutare tradiționale, care potrivesc cuvintele cheie cu pagini, LLM-urile interpretează sensul semantic al interogării tale analizând contextul, formularea și semnalele conexe pentru a prezice ce vrei cu adevărat să realizezi. Această trecere de la potrivirea cuvintelor cheie la înțelegerea intenției este fundamentală pentru modul în care funcționează sistemele moderne de căutare AI și determină direct ce surse sunt citate în răspunsurile generate de AI. Înțelegerea intenției utilizatorului a devenit esențială pentru brandurile care urmăresc vizibilitate în rezultatele căutării AI, întrucât instrumente precum AmICited monitorizează acum modul în care sistemele AI fac referire la conținutul tău pe baza alinierii intenției.

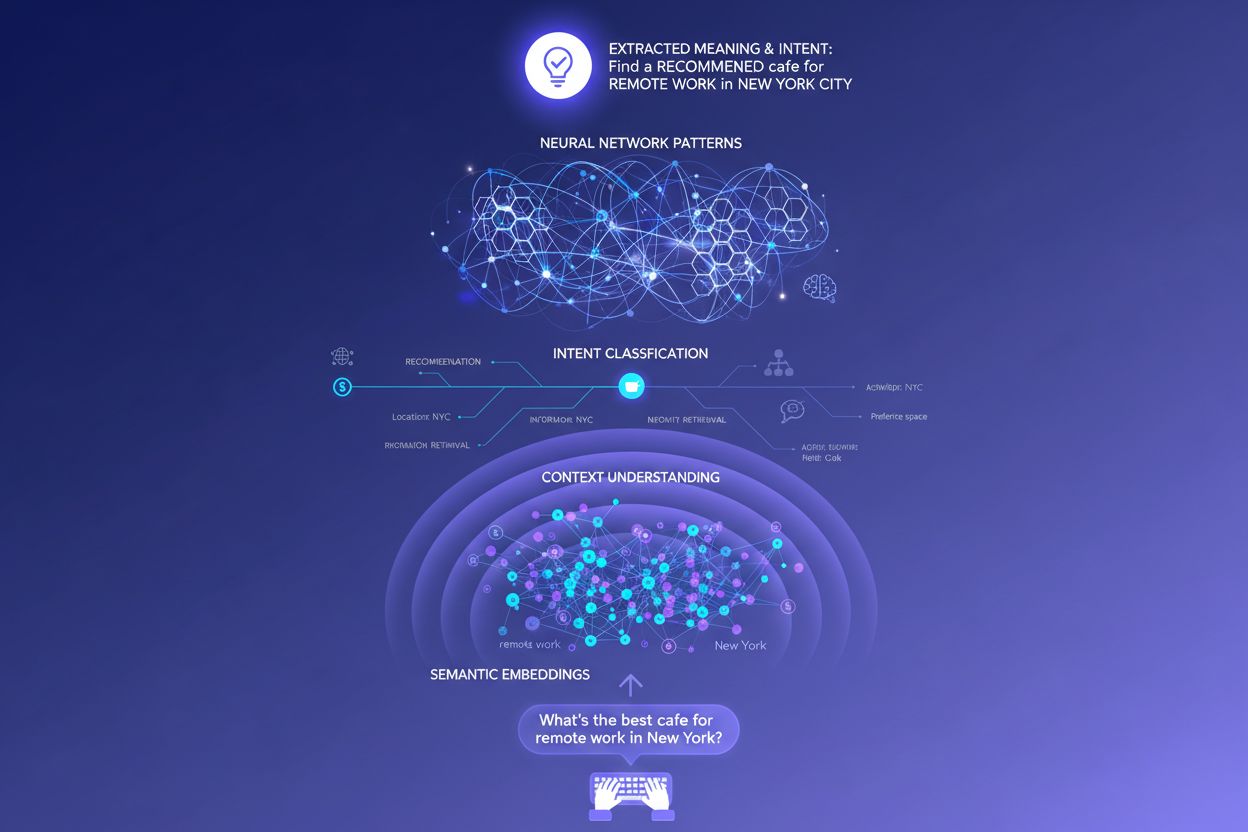

Când introduci o singură interogare într-un sistem de căutare AI, se întâmplă ceva remarcabil în culise: modelul nu răspunde doar direct la întrebarea ta. În schimb, îți extinde interogarea în zeci de micro-întrebări conexe, un proces pe care cercetătorii îl numesc „query fan-out”. De exemplu, o căutare simplă ca „Notion vs Trello” poate declanșa sub-interogări precum „Care este mai bun pentru colaborarea în echipă?”, „Care sunt diferențele de preț?”, „Care se integrează mai bine cu Slack?” și „Care este mai ușor pentru începători?” Această extindere permite LLM-urilor să exploreze diferite fațete ale intenției tale și să adune informații mai cuprinzătoare înainte de a genera un răspuns. Sistemul evaluează apoi pasaje din surse diferite la un nivel granular, nu doar pagini întregi, ceea ce înseamnă că un singur paragraf din conținutul tău poate fi selectat, în timp ce restul paginii este ignorat. Această analiză la nivel de pasaj explică de ce claritatea și specificitatea fiecărei secțiuni contează mai mult ca niciodată—un răspuns bine structurat la o sub-intenție specifică poate fi motivul pentru care conținutul tău ajunge într-un răspuns generat de AI.

| Interogare originală | Sub-intenție 1 | Sub-intenție 2 | Sub-intenție 3 | Sub-intenție 4 |

|---|---|---|---|---|

| „Cele mai bune instrumente de management de proiect” | „Care este cel mai bun pentru echipe la distanță?” | „Care este prețul?” | „Care se integrează cu Slack?” | „Care este cel mai ușor pentru începători?” |

| „Cum să-ți îmbunătățești productivitatea” | „Ce instrumente ajută la gestionarea timpului?” | „Care sunt metodele dovedite de productivitate?” | „Cum să reduci distragerile?” | „Ce obiceiuri cresc concentrarea?” |

| „Motoarele de căutare AI explicate” | „Cum diferă de Google?” | „Care motor AI este cel mai precis?” | „Cum gestionează confidențialitatea?” | „Care este viitorul căutării AI?” |

LLM-urile nu evaluează interogarea ta în izolare—ele construiesc ceea ce cercetătorii numesc un „embedding al utilizatorului”, un profil bazat pe vectori care surprinde intenția ta în evoluție pe baza istoricului de căutare, locației, tipului de dispozitiv, orei din zi și chiar a conversațiilor anterioare. Această înțelegere contextuală permite sistemului să personalizeze rezultatele în mod dramatic: doi utilizatori care caută „cele mai bune instrumente CRM” pot primi recomandări complet diferite dacă unul este fondator de startup, iar celălalt manager într-o corporație. Re-clasificarea în timp real rafinează și mai mult rezultatele în funcție de modul în care interacționezi cu ele—dacă dai click pe anumite rezultate, petreci timp citind anumite secțiuni sau pui întrebări suplimentare, sistemul ajustează înțelegerea intenției tale și actualizează recomandările viitoare. Acest circuit de feedback comportamental înseamnă că sistemele AI învață constant ce își doresc cu adevărat utilizatorii, nu doar ce au tastat inițial. Pentru creatorii de conținut și marketeri, acest lucru evidențiază importanța creării de conținut care să satisfacă intenția în mai multe contexte și stadii de decizie ale utilizatorului.

Sistemele moderne de AI clasifică intenția utilizatorului în mai multe categorii distincte, fiecare necesitând tipuri diferite de conținut și răspunsuri:

LLM-urile clasifică automat aceste intenții analizând structura interogării, cuvintele cheie și semnalele contextuale, apoi selectează conținutul care se potrivește cel mai bine tipului de intenție detectat. Înțelegerea acestor categorii ajută creatorii de conținut să își structureze paginile pentru a răspunde intenției specifice aduse de utilizator în căutare.

Motoarele de căutare bazate pe cuvinte cheie funcționează prin potrivire simplă de șiruri—dacă pagina ta conține exact cuvintele căutate de cineva, poate fi afișată. Această abordare eșuează complet cu sinonimele, parafrazarea și contextul. Dacă cineva caută „software de management de proiect accesibil” iar pagina ta folosește expresia „platformă de coordonare a sarcinilor prietenoasă cu bugetul”, căutarea tradițională poate rata complet legătura. Embedding-urile semantice rezolvă această problemă convertind cuvintele și expresiile în vectori matematici care surprind sensul, nu doar textul de suprafață. Acești vectori există într-un spațiu multidimensional unde conceptele semantic similare se grupează, permițând LLM-urilor să recunoască faptul că „accesibil”, „prietenos cu bugetul”, „ieftin” și „low-cost” exprimă aceeași intenție. Această abordare semantică gestionează mult mai bine interogările de tip long-tail și conversaționale decât potrivirea de cuvinte cheie—o interogare ca „Sunt freelancer și am nevoie de ceva simplu dar puternic” poate fi potrivită cu conținut relevant chiar dacă nu conține niciun cuvânt cheie tradițional. Rezultatul practic este că sistemele AI pot afișa răspunsuri relevante la interogări vagi, complexe sau neconvenționale, făcându-le mult mai utile decât predecesorii lor bazate pe cuvinte cheie.

În centrul tehnic al interpretării intenției se află arhitectura transformer, un design de rețea neuronală care procesează limbajul analizând relațiile dintre cuvinte printr-un mecanism numit „atenție”. În loc să citească textul secvențial ca un om, transformerele evaluează modul în care fiecare cuvânt se raportează la toate celelalte dintr-o interogare, permițând surprinderea nuanțelor de sens și context. Embedding-urile semantice sunt reprezentările numerice care rezultă din acest proces—fiecare cuvânt, expresie sau concept este convertit într-un vector de numere care codifică semnificația acestuia. Modele ca BERT (Bidirectional Encoder Representations from Transformers) și RankBrain folosesc aceste embedding-uri pentru a înțelege că „cel mai bun CRM pentru startup-uri” și „cea mai bună platformă de management al relațiilor cu clienții pentru companii noi” exprimă o intenție similară, deși folosesc cuvinte complet diferite. Mecanismul de atenție este deosebit de puternic pentru că permite modelului să se concentreze pe cele mai relevante părți dintr-o interogare—în „cele mai bune instrumente de management de proiect pentru echipe la distanță cu bugete limitate”, sistemul învață să acorde o pondere mai mare expresiilor „echipe la distanță” și „bugete limitate” ca semnale critice de intenție. Această sofisticare tehnică explică de ce căutarea AI modernă pare mult mai inteligentă decât sistemele tradiționale bazate pe cuvinte cheie.

Înțelegerea modului în care LLM-urile interpretează intenția schimbă fundamental strategia de conținut. În loc să scrii un singur ghid exhaustiv care încearcă să se claseze pentru un singur cuvânt cheie, conținutul de succes abordează acum multiple sub-intenții în secțiuni modulare care pot exista independent. Dacă scrii despre instrumente de management de proiect, în loc de o comparație masivă, creează secțiuni distincte care răspund la „Care este cel mai bun pentru echipe la distanță?”, „Care este cea mai accesibilă opțiune?” și „Care se integrează cu Slack?”—fiecare secțiune devine un potențial card de răspuns pe care LLM-urile îl pot extrage și cita. Formatarea pregătită pentru citare contează enorm: folosește fapte în loc de afirmații vagi, include cifre și date specifice și structurează informația astfel încât să fie ușor de citat sau rezumat de sistemele AI. Bulinele, titlurile clare și paragrafele scurte ajută LLM-urile să parcurgă mai eficient conținutul tău decât proza densă. Instrumente precum AmICited permit acum marketerilor să monitorizeze cum fac referire sistemele AI la conținutul lor pe ChatGPT, Perplexity și Google AI, dezvăluind ce aliniamente de intenție funcționează și unde există lacune de conținut. Această abordare bazată pe date pentru strategia de conținut—optimizarea pentru modul în care sistemele AI interpretează și citează efectiv munca ta—reprezintă o schimbare fundamentală față de SEO-ul tradițional.

Să luăm exemplul unui magazin online: când cineva caută „geacă impermeabilă sub 200$”, exprimă simultan mai multe intenții—dorește informații despre durabilitate, confirmare de preț și recomandări de produse. Un sistem AI poate extinde această interogare în sub-întrebări despre tehnologia impermeabilizării, comparații de preț, recenzii de brand și informații despre garanție. Un brand care abordează toate aceste aspecte într-un conținut modular, bine structurat, are mult mai multe șanse să fie citat într-un răspuns AI decât un concurent cu o pagină de produs generică. În zona SaaS, aceeași întrebare „Cum îmi invit echipa în acest workspace?” poate apărea de sute de ori în jurnalele de suport, semnalând o lacună critică de conținut. Un asistent AI instruit pe documentația ta poate avea dificultăți să răspundă clar la această întrebare, ducând la experiență slabă pentru utilizator și vizibilitate redusă în răspunsurile AI generate pentru suport. În contexte de știri și informare, o interogare precum „Ce se întâmplă cu reglementarea AI?” va fi interpretată diferit în funcție de contextul utilizatorului—un politician poate avea nevoie de detalii legislative, un lider de afaceri de implicații competitive, iar un tehnician de informații despre standarde tehnice. Conținutul de succes abordează explicit aceste contexte de intenție diferite.

În ciuda sofisticării lor, LLM-urile se confruntă cu provocări reale în interpretarea intenției. Interogările ambigue precum „Java” pot face referire la limbajul de programare, insulă sau cafea—chiar și cu context, sistemul poate clasifica greșit intenția. Intențiile mixte sau suprapuse complică și mai mult: „Este acest CRM mai bun decât Salesforce și unde îl pot încerca gratuit?” combină comparație, evaluare și intenție tranzacțională într-o singură interogare. Limitările ferestrei de context înseamnă că LLM-urile pot considera doar o cantitate finită de istoric conversațional, astfel încât în conversațiile lungi pe mai multe runde, semnalele de intenție anterioare pot fi uitate. Halucinațiile și erorile factuale rămân o problemă, în special în domenii ce necesită acuratețe ridicată precum sănătatea, finanțele sau consultanța juridică. Considerentele de confidențialitate contează și ele—pe măsură ce sistemele colectează tot mai multe date comportamentale pentru a îmbunătăți personalizarea, trebuie să echilibreze acuratețea recunoașterii intenției cu protecția intimității utilizatorului. Înțelegerea acestor limitări ajută creatorii de conținut și marketerii să își seteze așteptări realiste privind vizibilitatea în căutarea AI și să recunoască faptul că nu orice interogare va fi interpretată perfect.

Căutarea bazată pe intenție evoluează rapid către o înțelegere și interacțiune tot mai sofisticate. AI conversațională va deveni din ce în ce mai naturală, cu sisteme care mențin contextul pe parcursul unor dialoguri complexe și lungi, în care intenția se poate schimba și evolua. Înțelegerea multimodală a intenției va combina text, imagini, voce și chiar video pentru a interpreta scopurile utilizatorului mai holistic—imaginează-ți că îi arăți asistentului AI o fotografie și îi spui „găsește-mi ceva ca asta”. Căutarea fără interogare (zero-query search) reprezintă o frontieră emergentă în care sistemele AI anticipează nevoile utilizatorului înainte de a fi exprimate explicit, folosind semnale comportamentale și context pentru a oferi proactiv informații relevante. Personalizarea îmbunătățită va face ca rezultatele să fie din ce în ce mai adaptate profilurilor individuale, stadiilor de decizie și situațiilor contextuale. Integrarea cu sistemele de recomandare va estompa granița dintre căutare și descoperire, cu sisteme AI care sugerează conținut relevant pe care utilizatorii nici nu știau că îl caută. Pe măsură ce aceste capabilități se maturizează, avantajul competitiv va aparține tot mai mult brandurilor și creatorilor care înțeleg profund intenția și își structurează conținutul pentru a o satisface complet în multiple contexte și pentru diferite tipuri de utilizatori.

Intenția utilizatorului se referă la scopul sau obiectivul din spatele unei interogări, nu doar la cuvintele cheie tastate. LLM-urile interpretează sensul semantic analizând contextul, formularea și semnalele conexe pentru a prezice ce dorește cu adevărat utilizatorul să realizeze. De aceea, aceeași interogare poate genera rezultate diferite în funcție de contextul utilizatorului și stadiul de luare a deciziei.

LLM-urile folosesc un proces numit 'query fan-out' pentru a descompune o singură interogare în zeci de micro-întrebări conexe. De exemplu, 'Notion vs Trello' poate fi extinsă în subinterogări despre colaborarea în echipă, prețuri, integrări și ușurința de utilizare. Acest lucru permite sistemelor AI să exploreze diverse fațete ale intenției și să adune informații cuprinzătoare.

Înțelegerea intenției ajută creatorii de conținut să optimizeze pentru modul real în care sistemele AI interpretează și citează munca lor. Conținutul care abordează mai multe sub-intenții în secțiuni modulare are mai multe șanse să fie selectat de LLM-uri. Acest lucru are impact direct asupra vizibilității în răspunsurile generate de AI pe ChatGPT, Perplexity și Google AI.

Embedding-urile semantice convertesc cuvintele și expresiile în vectori matematici care surprind sensul și nu doar textul de suprafață. Astfel, LLM-urile recunosc că 'accesibil', 'prietenos cu bugetul' și 'ieftin' exprimă aceeași intenție, chiar dacă folosesc cuvinte diferite. Această abordare semantică gestionează mult mai bine sinonimele, parafrazarea și contextul decât potrivirea tradițională a cuvintelor cheie.

Da, LLM-urile se confruntă cu provocări precum interogări ambigue, intenții mixte și limitări de context. Interogări ca 'Java' pot face referire la limbajul de programare, geografie sau cafea. Conversațiile lungi pot depăși ferestrele de context, determinând uitarea semnalelor de intenție anterioare. Înțelegerea acestor limitări ajută la stabilirea unor așteptări realiste privind vizibilitatea în căutarea AI.

Brandurile ar trebui să creeze conținut modular care abordează mai multe sub-intenții în secțiuni distincte. Folosiți formatare pregătită pentru citare cu fapte, cifre specifice și structură clară. Monitorizați modul în care sistemele AI fac referire la conținutul vostru folosind instrumente precum AmICited pentru a identifica lacunele de aliniere a intenției și a optimiza în consecință.

Intenția este orientată spre sarcină—ce vor utilizatorii să realizeze chiar acum. Interesul este curiozitate generală, mai largă. Sistemele AI prioritizează intenția deoarece aceasta determină direct ce conținut este selectat pentru răspunsuri. Un utilizator poate fi interesat de instrumente de productivitate în general, dar intenția sa poate fi să găsească ceva special pentru colaborarea echipelor la distanță.

Sistemele AI citează sursele care se potrivesc cel mai bine cu intenția detectată. Dacă conținutul tău abordează clar o sub-intenție specifică cu informații bine structurate și factuale, șansele de a fi selectat cresc. Instrumente precum AmICited urmăresc aceste tipare de citare, arătând ce aliniamente de intenție generează vizibilitate în răspunsurile AI.

Înțelege cum LLM-urile fac referire la conținutul tău pe ChatGPT, Perplexity și Google AI. Urmărește alinierea intenției și optimizează pentru vizibilitatea în AI cu AmICited.

Află cum să identifici și să optimizezi pentru intenția de căutare în motoarele de căutare AI. Descoperă metode de clasificare a interogărilor utilizatorilor, a...

Explorează categoriile de intenție de căutare AI și modul în care motoare generative precum ChatGPT, Perplexity și Google AI interpretează obiectivele utilizato...

Află ce înseamnă intenția de căutare informațională pentru sistemele AI, cum recunoaște AI aceste interogări și de ce este importantă înțelegerea acestei intenț...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.