Înțelegerea factorilor de viteză ai indexării AI

Viteza de indexare AI determină cât de rapid devine conținutul tău descoperibil în motoarele de căutare bazate pe AI, precum ChatGPT, Perplexity și AI Overviews de la Google. Spre deosebire de motoarele de căutare tradiționale care doar potrivesc cuvinte cheie cu pagini, sistemele AI trebuie să parcurgă, să înțeleagă și să sintetizeze conținutul tău pentru a genera răspunsuri precise. Rapiditatea acestui proces depinde de numeroși factori interconectați care îți afectează direct vizibilitatea în răspunsurile generate de AI și abilitatea de a atrage trafic din platformele de căutare AI.

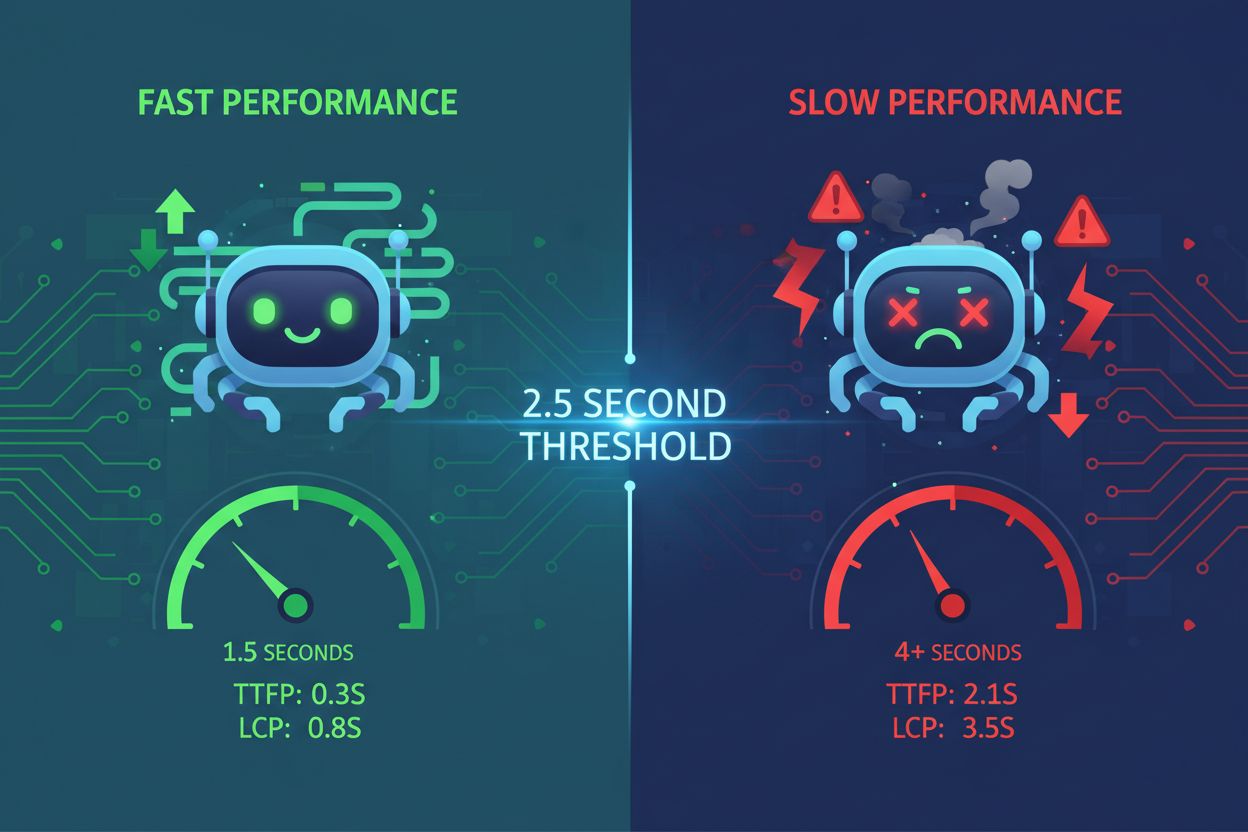

Viteza de încărcare a paginii este unul dintre cei mai critici factori care afectează viteza de indexare AI. Crawler-ele AI operează în limite stricte de resurse și timp — de obicei între 1-5 secunde per solicitare de pagină. Când site-ul tău se încarcă lent, crawler-ele petrec mai mult timp pentru a prelua conținutul, ceea ce înseamnă că mai puține pagini sunt indexate în fereastra lor de crawl alocată. Acest lucru creează un efect de cascadă unde performanța slabă reduce direct numărul de pagini pe care sistemele AI le pot procesa și indexa.

Site-urile cu încărcare lentă semnalează mentenanță slabă pentru sistemele AI. Când paginile necesită prea mult timp pentru a fi afișate, crawler-ele AI pot expira înainte de a accesa conținutul real, indexând doar scheletul HTML. Acest lucru este problematic în special pentru site-urile încărcate cu JavaScript unde conținutul se încarcă dinamic pe partea de client. Procesul de randare în două etape necesar pentru JavaScript adaugă latență semnificativă, îngreunând extragerea informațiilor relevante de către sistemele AI. Comprimarea imaginilor, minificarea codului, implementarea încărcării lazy și utilizarea rețelelor de livrare a conținutului (CDN) pot îmbunătăți dramatic timpii de încărcare și permit crawler-elor AI să proceseze mai eficient mai multe pagini.

| Indicator de performanță | Țintă | Impact asupra indexării AI |

|---|

| Timp de încărcare pagină | Sub 3 secunde | Permite crawlingul mai multor pagini per sesiune |

| Largest Contentful Paint (LCP) | Sub 2,5 secunde | Asigură că AI vede rapid conținutul relevant |

| First Input Delay (FID) | Sub 100ms | Îmbunătățește răspunsul crawler-ului |

| Cumulative Layout Shift (CLS) | Aproape de zero | Previne erorile de extragere a conținutului |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Constrângeri de buget crawl

Bugetul de crawl reprezintă numărul limitat de pagini pe care sistemele AI le pot vizita într-o anumită perioadă de timp. Fiecărui site i se alocă un crawl limitat de către motoarele de căutare AI, similar cu modul în care Google alocă bugetul de crawl. Când bugetul de crawl se epuizează, sistemele AI nu mai indexează conținut nou, indiferent de calitate. Această limitare devine deosebit de problematică pentru site-urile mari cu sute sau mii de pagini care concurează pentru resursele limitate de indexare.

Optimizarea alocării bugetului de crawl este esențială pentru o indexare AI mai rapidă. Ar trebui să prioritizezi paginile cu valoare ridicată — cele care generează venituri, atrag trafic sau conțin informații critice — în detrimentul paginilor cu valoare redusă, precum filtrele de categorii duplicate sau paginile redundante de taguri. Folosind fișiere robots.txt strategic, poți bloca accesul crawler-elor AI la paginile care nu necesită indexare, conservând bugetul de crawl pentru conținutul important. De asemenea, menținerea unui sitemap XML actualizat și o structură corectă de linkuri interne ajută sistemele AI să descopere mai rapid cele mai importante pagini, asigurându-se că sunt indexate înainte de epuizarea bugetului.

Calitatea și originalitatea conținutului

Sistemele AI penalizează puternic conținutul duplicat și subțire, ceea ce încetinește semnificativ indexarea. Când crawler-ele AI întâlnesc conținut lipsit de originalitate sau substanță, prioritizează mai puțin crawling-ul paginilor similare de pe site-ul tău. Acest lucru se întâmplă deoarece sistemele AI evaluează calitatea conținutului folosind semnale E-E-A-T (Experiență, Expertiză, Autoritate și Încredere). Conținutul care pare de slabă calitate, generat de AI fără revizuire umană sau duplicat din alte surse, primește o prioritate mai mică în coada de indexare.

Conținutul de calitate, cuprinzător, este indexat mai rapid de sistemele AI. Conținutul care depășește 3.000 de cuvinte și răspunde complet la întrebările utilizatorilor din mai multe perspective primește prioritate la indexare. Sistemele AI favorizează conținutul care include date de sprijin, statistici, exemple reale și studii de caz, deoarece aceste elemente demonstrează expertiză și încredere. Când creezi conținut original, bine documentat, care aduce valoare reală, crawler-ele AI alocă mai multe resurse pentru indexarea paginilor tale, rezultând o descoperire mai rapidă și includere în răspunsurile generate de AI.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Configurare SEO tehnică

Configurarea incorectă a robots.txt poate bloca accidental crawler-ele AI să indexeze conținutul tău. Multe site-uri previn involuntar accesul roboților AI la pagini prin configurări greșite ale fișierului robots.txt. Diferite sisteme AI folosesc identificatori diferiți — ChatGPT utilizează OAI-SearchBot, Perplexity folosește PerplexityBot, iar altele AndiBot sau ExaBot. Dacă robots.txt nu permite explicit acești crawler-i, ei nu pot indexa conținutul tău, indiferent de calitate sau relevanță.

Structura HTML curată și markup-ul semantic accelerează indexarea AI. Crawler-ele AI întâmpină dificultăți cu implementările grele în JavaScript și structurile complexe imbricate. Folosirea tagurilor semantice HTML5 (article, section, nav), ierarhiilor corecte de heading-uri (H1-H6), text descriptiv pentru linkuri și text alternativ pentru imagini face ca conținutul tău să devină accesibil instant sistemelor AI. Framework-urile de randare pe server (SSR) precum Next.js sau Gatsby pregenerează conținutul pe server, asigurând că crawler-ele AI primesc pagini complete fără a fi nevoie de execuție JavaScript, accelerând semnificativ indexarea.

Indexarea bazei de date și infrastructura

Supraindexarea în baza de date creează latență ce încetinește viteza de indexare AI. Când bazele de date au indici excesivi, redundanți sau suprapusi, fiecare operațiune de inserare, actualizare și ștergere trebuie să actualizeze mai mulți indici, generând blocaje de performanță la scriere. Acest overhead impactează direct cât de rapid sistemul tău de gestionare a conținutului poate servi pagini către crawler-ele AI. Indicii redundanți consumă spațiu de stocare, introduc latență și forțează planner-ele de interogări să ia decizii suboptime, toate acestea încetinind livrarea conținutului către sistemele AI.

Optimizarea indicilor bazei de date îmbunătățește viteza livrării conținutului către crawler-ele AI. Auditează periodic baza de date pentru a identifica indicii nefolosiți sau redundanți folosind unelte precum pg_stat_user_indexes (PostgreSQL) sau sys.schema_unused_indexes (MySQL). Elimină indicii care nu au fost accesați de săptămâni sau luni, consolidează indicii care se suprapun și asigură-te că schema bazei de date corespunde pattern-urilor actuale de interogare. O bază de date optimizată servește conținutul mai rapid crawler-elor AI, permițând o indexare mai rapidă și includere în răspunsurile generate de AI.

Implementarea Schema Markup

Lipsa sau incompletitudinea markup-ului schema întârzie înțelegerea și indexarea conținutului de către AI. Schema markup oferă date structurate care ajută sistemele AI să înțeleagă rapid contextul, semnificația și relațiile conținutului tău. Fără o implementare corectă a schema, crawler-ele AI trebuie să petreacă timp suplimentar pentru a deduce structura și a extrage informațiile cheie. Acest timp suplimentar reduce viteza de indexare deoarece crawler-ele alocă mai multe resurse per pagină.

Implementarea completă a schema markup accelerează indexarea AI. Schema FAQ, How-To, Article și Product furnizează sistemelor AI informații prestructurate ce pot fi imediat înțelese și indexate. Când incluzi informații despre autor, date de publicare, ratinguri și alte date structurate, sistemele AI pot categoriza și indexa rapid conținutul fără procesare suplimentară. Studiile arată că 36,6% dintre cuvintele cheie de căutare declanșează featured snippets derivate din schema markup, demonstrând cum datele structurate influențează direct vizibilitatea și viteza de indexare AI.

Structura linkurilor interne

O structură slabă de linkuri interne împiedică crawler-ele AI să descopere eficient conținutul tău. Linkurile interne acționează ca o hartă ce ghidează crawler-ele AI prin arhitectura site-ului tău. Fără o structură strategică a linkurilor interne, sistemele AI pot avea dificultăți în a descoperi pagini importante, mai ales conținutul nou ascuns adânc în structura site-ului. Această întârziere a descoperirii se traduce direct printr-o indexare mai lentă, deoarece crawler-ele trebuie să investească mai mult timp pentru a găsi pagini de indexat.

Linkurile interne strategice accelerează descoperirea și indexarea conținutului de către AI. Legarea conținutului nou din paginile relevante existente ajută crawler-ele AI să îl găsească și să îl indexeze mai rapid. Folosirea unui text ancora descriptiv, care indică clar ce conține pagina legată, ajută sistemele AI să înțeleagă relațiile și contextul conținutului. O structură corectă de linkuri interne asigură că paginile valoroase primesc mai multă atenție la crawling, rezultând în indexare mai rapidă și prioritate mai mare în răspunsurile generate de AI.

Experiența utilizatorului și accesibilitatea conținutului

O experiență slabă a utilizatorului semnalează sistemelor AI că este posibil ca conținutul tău să nu fie valoros. Rata mare de abandon, duratele scurte de sesiune și metrici scăzute de angajament indică crawler-elor AI că utilizatorii nu găsesc conținutul satisfăcător. Sistemele AI folosesc din ce în ce mai mult semnale comportamentale pentru a evalua calitatea conținutului, iar paginile cu UX deficitar primesc o prioritate mai mică la indexare. Atunci când utilizatorii părăsesc rapid paginile tale, sistemele AI interpretează acest lucru ca un semnal că materialul nu are valoare, încetinind includerea lui în răspunsurile AI.

O structură prietenoasă pentru cititor îmbunătățește viteza de indexare AI. Conținutul formatat cu paragrafe scurte (2-3 propoziții), subtitluri descriptive, puncte, liste numerotate și tabele este mai ușor de procesat atât pentru utilizatori, cât și pentru sistemele AI. Această scanabilitate crescută permite crawler-elor AI să extragă rapid informații cheie și să înțeleagă structura fără procesare extensivă. Când conținutul este bine organizat și accesibil, sistemele AI îl pot indexa mai rapid și cu încredere crescută în calitatea și relevanța sa.

Infrastructura de hosting și timpul de răspuns al serverului

O infrastructură de hosting lentă creează blocaje care întârzie indexarea AI. Mediile de hosting partajat dispun adesea de resurse limitate și timpi de răspuns mai lenți, ceea ce înseamnă că crawler-ele AI trebuie să aștepte mai mult pentru încărcarea fiecărei pagini. Acest timp de așteptare reduce numărul de pagini ce pot fi indexate în intervalul de timp alocat crawler-ului. Timpul de răspuns al serverului influențează direct eficiența crawlingului — fiecare milisecundă de întârziere reduce totalul paginilor indexate per sesiune.

Trecerea la hosting rapid și scalabil accelerează indexarea AI. Serviciile managed WordPress, soluțiile VPS și platformele cloud precum Google Cloud sau AWS oferă timpi de răspuns mai buni și alocare optimă a resurselor. CDN-urile precum Cloudflare cachează conținutul la nivel global și livrează paginile mai rapid către crawler-i, indiferent de locația lor geografică. Când infrastructura de hosting livrează rapid paginile, crawler-ele AI pot procesa mai mult conținut per sesiune, rezultând o indexare mai rapidă și vizibilitate sporită în răspunsurile generate AI.

Monitorizare și optimizare

Monitorizarea continuă a performanței indexării AI permite optimizarea proactivă. Unelte precum Google Search Console, SE Ranking’s AI Results Tracker și Peec.ai te ajută să urmărești cât de rapid apare conținutul tău în rezultatele AI și să identifici paginile care nu sunt indexate. Prin monitorizarea acestor metrici, poți identifica blocajele și implementa îmbunătățiri țintite ce influențează direct viteza de indexare.

Audituri și actualizări regulate mențin viteza optimă de indexare AI. Efectuează periodic audituri de performanță folosind unelte precum Google PageSpeed Insights, GTmetrix și WebPageTest pentru a identifica blocajele de viteză. Actualizează regulat sitemap-ul XML, reîmprospătează conținutul pentru semnale de actualitate și optimizează continuu baza de date și infrastructura. Optimizarea consecventă asigură că viteza de indexare AI rămâne competitivă și că materialul tău continuă să apară rapid în răspunsurile generate AI.