Scor de Perplexitate

Scorul de perplexitate măsoară predictibilitatea textului în modelele de limbaj. Află cum această metrică NLP cheie cuantifică incertitudinea modelului, calculu...

Află ce înseamnă scorul de perplexitate în conținut și modelele de limbaj. Înțelege cum măsoară incertitudinea modelului, acuratețea predicției și evaluarea calității textului.

Scorul de perplexitate este o metrică ce măsoară cât de bine prezice un model de limbaj următorul cuvânt dintr-o secvență. El cuantifică incertitudinea modelului în realizarea predicțiilor, scorurile mai mici indicând o încredere mai mare și o performanță predictivă mai bună.

Scorul de perplexitate este o metrică fundamentală utilizată în procesarea limbajului natural și în învățarea automată pentru a evalua cât de bine se comportă un model de limbaj în prezicerea textului. În esență, măsoară gradul de incertitudine al unui model atunci când atribuie probabilități cuvintelor dintr-o secvență. Această metrică este deosebit de importantă pentru înțelegerea performanței modelului în sarcini precum generarea de text, traducerea automată sau AI conversațională. Când un model de limbaj procesează text, acesta atribuie valori de probabilitate cuvintelor potențiale următoare, pe baza contextului oferit de cuvintele precedente. Perplexitatea surprinde cât de încrezător este modelul în aceste predicții, fiind un instrument esențial de evaluare pentru dezvoltatorii și cercetătorii care lucrează cu modele mari de limbaj.

Conceptul de perplexitate provine din teoria informației, unde reprezintă o măsură a incertitudinii în distribuțiile de probabilitate. În contextul modelelor de limbaj, scorurile mai mici de perplexitate indică faptul că modelul este mai sigur de predicțiile sale și, prin urmare, produce texte mai coerente și mai fluente. În schimb, scorurile mari de perplexitate sugerează că modelul nu este sigur ce cuvânt ar trebui să urmeze, putând duce la rezultate mai puțin coerente sau relevante. Înțelegerea acestei metrci este esențială pentru oricine lucrează cu generarea de conținut bazat pe AI, deoarece influențează direct calitatea și fiabilitatea textului generat.

Calculul scorului de perplexitate implică mai mulți pași matematici care transformă predicțiile brute de probabilitate într-o singură metrică interpretabilă. Formula fundamentală se bazează pe entropia predicțiilor modelului, care măsoară nivelul de incertitudine al ieșirii. Reprezentarea matematică este: Perplexitate = 2^H(p), unde H(p) reprezintă entropia predicțiilor modelului. Această formulă arată că perplexitatea derivă direct din entropie, valori mai mici ale entropiei ducând la scoruri mai mici de perplexitate.

Procesul practic de calcul urmează o abordare structurată, ce implică mai mulți pași. Mai întâi, modelul de limbaj prezice probabilitatea următorului token pe baza textului de intrare și a contextului oferit. În al doilea rând, se aplică transformarea logaritmică acestor probabilități, ceea ce ajută la convertirea lor într-o măsură mai utilă pentru analiză. În al treilea rând, se calculează media log-verosimilității tuturor cuvintelor prezise din setul de test pe întreaga secvență. În final, exponențierea mediei log-verosimilității produce scorul final de perplexitate. Formula completă pentru calculul perplexității pentru o secvență de cuvinte este: Perplexitate = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), unde p(w_i | w_{i-1}, …, w_1) este probabilitatea prezisă a celui de-al i-lea cuvânt dat toate cuvintele precedente, iar N este numărul total de cuvinte din secvență.

| Pas de calcul | Descriere | Scop |

|---|---|---|

| Predicția tokenului | Modelul prezice probabilitatea următorului cuvânt | Stabilirea predicțiilor de bază |

| Transformare logaritmică | Aplicarea logaritmului asupra probabilităților | Conversie într-o măsură utilă |

| Calculul mediei | Calcularea mediei log-verosimilității pe secvență | Normalizare pe lungimea textului |

| Exponențiere | Ridicarea lui e la minus media respectivă | Obținerea scorului final de perplexitate |

Scorul de perplexitate servește drept metrică esențială pentru evaluarea performanței modelelor de limbaj pe mai multe dimensiuni. Este important deoarece oferă informații directe despre acuratețea predicțiilor, ajutând dezvoltatorii să înțeleagă cât de bine poate un model să prezică cuvinte și să genereze text coerent. Un scor scăzut de perplexitate indică faptul că modelul face predicții sigure și probabil generează conținut fluent, adecvat contextului. Acest lucru este deosebit de valoros pentru aplicații precum chatboți, asistenți virtuali și sisteme de generare de conținut, unde calitatea textului influențează direct experiența utilizatorului. În plus, perplexitatea ajută la evaluarea nivelului de încredere al modelului în predicțiile sale—dacă perplexitatea este mare, modelul este nesigur cu privire la următorul cuvânt, ceea ce poate duce la generarea de text incoerent sau irelevant.

Metrica este esențială și pentru compararea și selecția modelelor. Atunci când se evaluează modele diferite sau versiuni ale aceluiași model în procesul de fine-tuning, perplexitatea oferă o măsură cuantificabilă a îmbunătățirii sau degradării. Dezvoltatorii pot folosi scorurile de perplexitate pentru a determina dacă un model este potrivit pentru sarcini specifice precum generarea de text, traducerea automată, rezumarea sau întrebări-răspunsuri. De asemenea, perplexitatea permite evaluarea în timp real în timpul antrenării modelului, permițând dezvoltatorilor să evalueze instantaneu performanța modelului și să facă ajustări pe parcurs. Această capacitate este deosebit de valoroasă în procesul de fine-tuning, unde monitorizarea perplexității ajută la asigurarea că modelul devine mai bun la predicții sigure, nu doar la supraantrenarea pe datele de antrenament.

A ști cum să interpretezi scorurile de perplexitate este esențial pentru a lua decizii informate privind performanța modelului și adecvarea acestuia la anumite aplicații. Un scor de perplexitate mai mic indică faptul că modelul este mai sigur de predicțiile sale și produce, de regulă, texte de calitate mai ridicată și mai coerente. De exemplu, un scor de perplexitate de 15 sugerează că modelul alege dintre aproximativ 15 cuvinte posibile la fiecare pas de predicție, ceea ce arată o încredere relativ ridicată. În schimb, un scor de perplexitate mai mare de 50 sau peste sugerează că modelul este nesigur și ia în considerare mult mai multe posibilități, ceea ce se corelează adesea cu rezultate mai puțin coerente sau relevante. Interpretarea a ceea ce constituie un scor „bun” de perplexitate depinde de sarcina specifică, setul de date și arhitectura modelului evaluat.

Diferite tipuri de conținut și modele prezintă intervale de perplexitate de bază diferite. De exemplu, modelele antrenate pe texte bine structurate, formale, cum ar fi articolele Wikipedia, obțin de obicei scoruri de perplexitate mai mici decât modelele antrenate pe conținut conversațional sau creativ. Atunci când se compară scorurile de perplexitate între modele diferite, este esențial ca evaluarea să se facă pe același set de date și folosind aceeași metodă de tokenizare, deoarece acești factori influențează semnificativ rezultatele. Un model cu scor de perplexitate 20 pe un set de date nu este neapărat comparabil direct cu alt model cu scor 25 pe alt set de date. În plus, lungimea secvenței influențează calculele perplexității—secvențele mai lungi tind să producă scoruri de perplexitate mai stabile, în timp ce secvențele scurte pot prezenta o variabilitate mai mare și pot genera valori extreme care denaturează rezultatele.

Deși scorul de perplexitate este o metrică valoroasă, are limitări importante ce trebuie înțelese la evaluarea modelelor de limbaj. O limitare semnificativă este faptul că perplexitatea nu măsoară înțelegerea—un model cu perplexitate scăzută poate totuși genera text incoerent, irelevant sau factual incorect. Metrica măsoară doar capacitatea modelului de a prezice următorul cuvânt pe baza tiparelor statistice din datele de antrenament, nu dacă modelul înțelege cu adevărat sensul sau contextul conținutului. Asta înseamnă că un model poate obține scoruri excelente de perplexitate generând texte corecte gramatical, dar lipsite de sens sau incorecte factual.

O altă considerație importantă este că perplexitatea nu surprinde eficient dependențele pe termen lung. Metrica se bazează pe predicții imediate ale cuvântului următor și poate să nu reflecte cât de bine menține un model coerența și consistența pe secvențe mai lungi de text. De asemenea, sensibilitatea la tokenizare este un factor critic—diferite metode de tokenizare pot afecta semnificativ scorurile de perplexitate, ceea ce face dificilă comparația directă între modele care folosesc tokenizatoare diferite. De exemplu, modelele la nivel de caracter pot obține scoruri de perplexitate mai mici decât cele la nivel de cuvânt, dar asta nu înseamnă neapărat că generează texte mai bune. În plus, perplexitatea este proiectată în principal pentru modele autoregresive sau cauzale și nu este bine definită pentru modele mascate precum BERT, care utilizează mecanisme de predicție diferite.

Pentru a obține o evaluare completă a performanței modelului de limbaj, perplexitatea trebuie folosită împreună cu alte metrici de evaluare, nu ca o măsură de sine stătătoare. BLEU, ROUGE și METEOR sunt metrici larg utilizate care compară textul generat cu texte de referință și sunt deosebit de valoroase pentru sarcini precum traducerea automată și rezumarea. Evaluarea umană realizată de evaluatori calificați oferă perspective asupra aspectelor pe care metricile automate nu le pot surprinde, cum ar fi fluența, relevanța, coerența și calitatea generală. Acuratețea factuală evaluată cu sisteme de întrebări-răspunsuri bazate pe cunoștințe sau cadre de fact-checking asigură că textul generat nu este doar fluent, ci și corect. Metrici de diversitate și creativitate precum rata de repetiție, scorul de noutate și entropia măsoară cât de variat și original este textul generat, ceea ce este important pentru aplicațiile creative.

De asemenea, evaluarea modelelor pentru bias și echitate asigură implementarea lor sigură în aplicații reale, unde biasurile dăunătoare pot provoca probleme semnificative. Combinând perplexitatea cu aceste metrici suplimentare, dezvoltatorii pot evalua mai bine acuratețea predicțiilor, fluența și utilizabilitatea reală a unui model. Această abordare complexă permite identificarea modelelor care nu doar prezic corect, ci o fac cu încredere, coerență și fiabilitate. Combinarea metricalor oferă o imagine mai completă a performanței și ajută la asigurarea că modelele selectate răspund cerințelor specifice ale aplicațiilor lor.

Scorul de perplexitate este utilizat pe scară largă în multiple aplicații reale, unde performanța modelelor de limbaj influențează direct experiența utilizatorului și calitatea conținutului. În aplicațiile de generare de text, perplexitatea ajută la asigurarea că textul generat este coerent și fluent, confirmând că predicțiile modelului sunt sigure și adecvate contextului. Pentru sistemele de traducere automată, perplexitatea evaluează cât de bine prezice modelul de traducere următorul cuvânt în limba țintă, ceea ce este crucial pentru obținerea unor traduceri de calitate care păstrează sensul și nuanța din limba sursă. În chatboți și asistenți virtuali, o perplexitate scăzută asigură că răspunsurile sunt fluente și adecvate contextului, îmbunătățind direct satisfacția și implicarea utilizatorilor.

Modelele de rezumare beneficiază de evaluarea perplexității prin asigurarea că rezumatele generate sunt lizibile și coerente, păstrând informațiile esențiale din textul sursă. Creatorii de conținut și platformele AI folosesc perplexitatea pentru a evalua calitatea conținutului generat de AI înainte de publicare sau prezentare către utilizatori. Pe măsură ce generarea de conținut bazată pe AI devine tot mai răspândită pe motoare de căutare și platforme de răspunsuri, înțelegerea și monitorizarea scorurilor de perplexitate ajută la asigurarea că textul generat respectă standardele de calitate. Organizațiile care lucrează cu sisteme AI pot utiliza metricile de perplexitate pentru a identifica când modelele necesită reantrenare, fine-tuning sau înlocuire pentru a menține constantă calitatea conținutului și încrederea utilizatorilor în răspunsurile generate de AI.

Urmărește cum apare conținutul tău în răspunsurile AI din ChatGPT, Perplexity și alte motoare de căutare AI. Asigură-te că brandul tău primește atribuirea corectă în răspunsurile generate de AI.

Scorul de perplexitate măsoară predictibilitatea textului în modelele de limbaj. Află cum această metrică NLP cheie cuantifică incertitudinea modelului, calculu...

Discuție în comunitate despre scorul de perplexitate în conținut și modele lingvistice. Scriitori și experți AI dezbat dacă acesta contează pentru crearea și op...

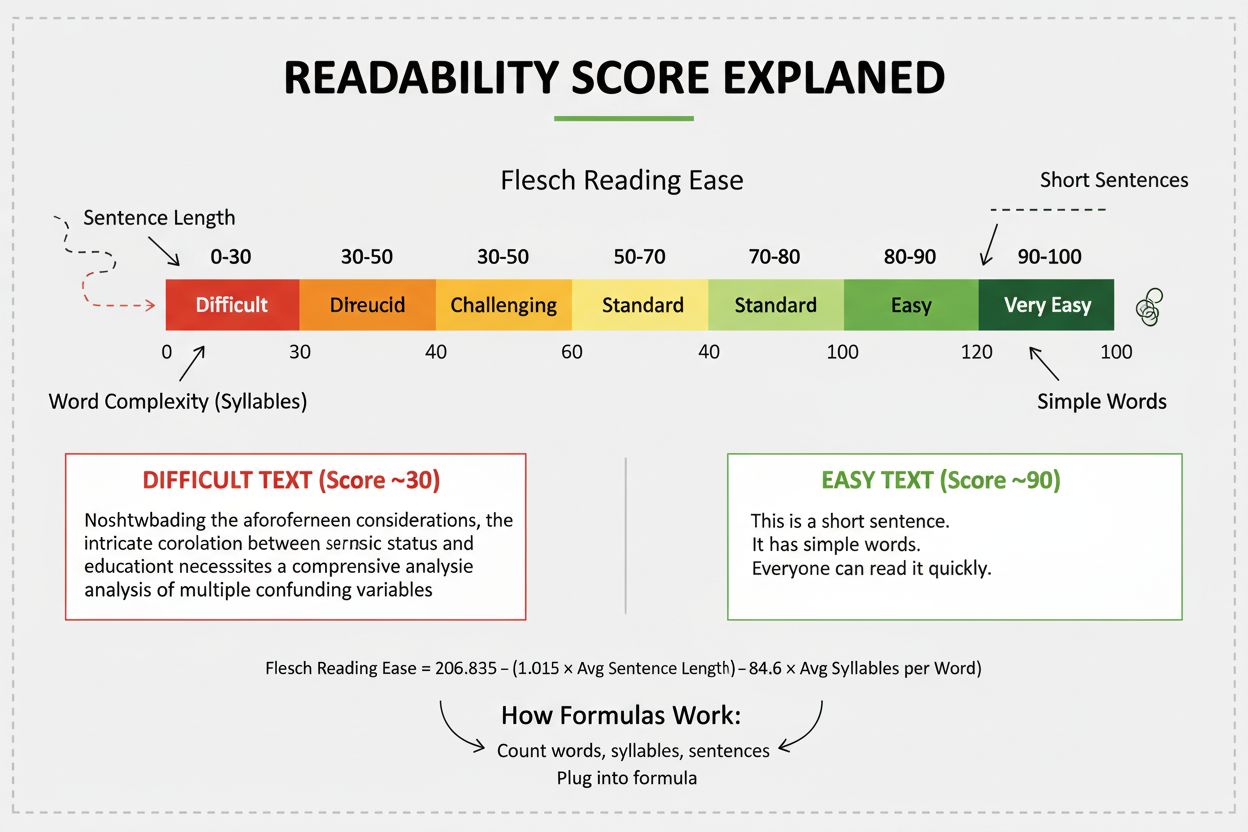

Scorul de lizibilitate măsoară dificultatea de înțelegere a conținutului prin analiza lingvistică. Află cum formulele Flesch, Gunning Fog și altele influențează...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.