Selecția Surselor de către AI

Află cum sistemele AI selectează și clasifică sursele pentru citare. Descoperă algoritmii, semnalele și factorii care determină ce site-uri web sunt citate de p...

Află ce este biasul de selecție a sursei în AI, cum afectează modelele de învățare automată, exemple din lumea reală și strategii pentru a detecta și reduce această problemă critică de echitate.

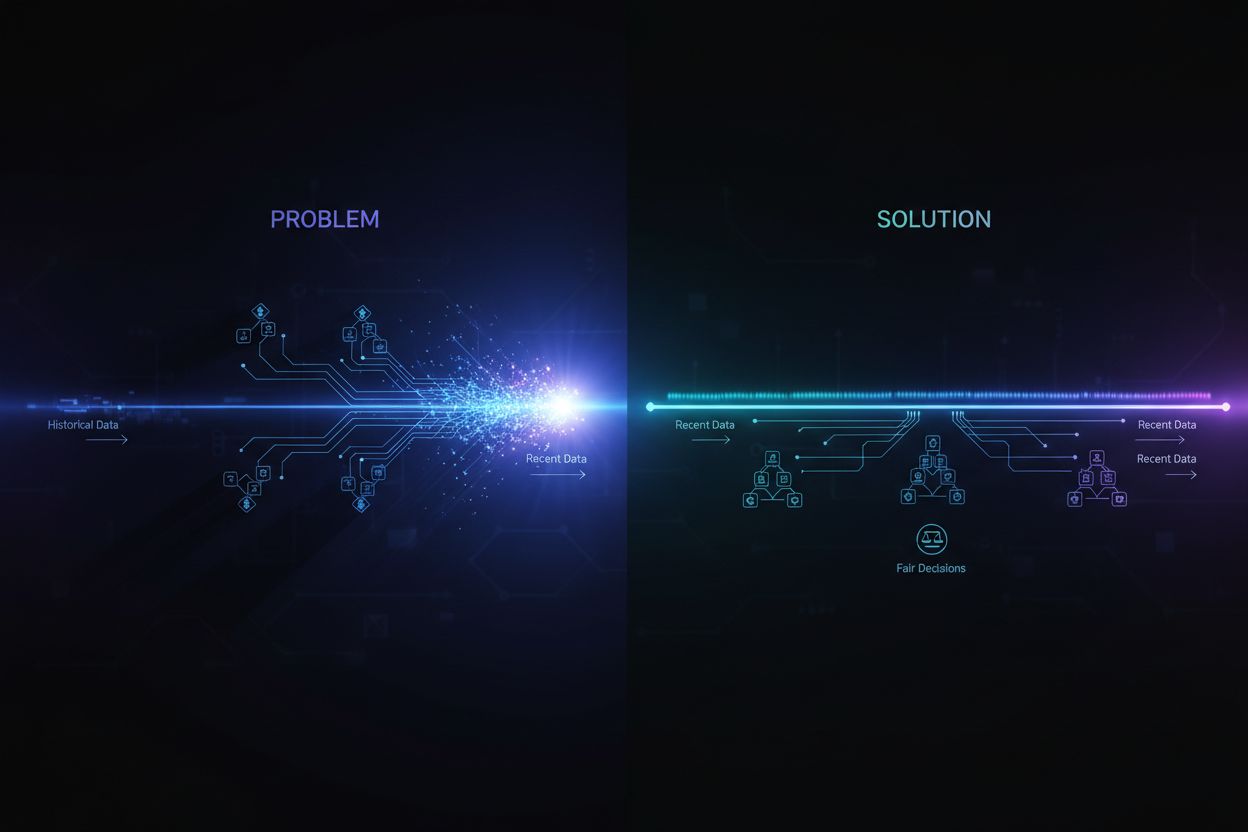

Biasul de selecție a sursei apare atunci când datele de antrenament nu sunt reprezentative pentru întreaga populație sau distribuția din lumea reală, determinând modelele AI să facă predicții inexacte pentru grupuri sau scenarii subreprezentate.

Biasul de selecție a sursei este o problemă fundamentală în inteligența artificială care apare atunci când datele folosite pentru antrenarea modelelor de învățare automată nu reprezintă cu acuratețe populația sau distribuția din lumea reală pe care modelele ar trebui să le deservească. Acest tip de bias apare când seturile de date sunt alese astfel încât să excludă sau să subreprezinte sistematic anumite grupuri, scenarii sau caracteristici. Consecința este că modelele AI învață tipare din date incomplete sau distorsionate, ducând la predicții inexacte, incorecte sau discriminatorii pentru populațiile subreprezentate. Înțelegerea acestui bias este esențială pentru oricine dezvoltă, implementează sau se bazează pe sisteme AI, deoarece are un impact direct asupra corectitudinii, acurateței și fiabilității deciziilor automate în toate industriile.

Biasul de selecție a sursei se diferențiază de alte forme de bias deoarece își are originea chiar în etapa de colectare a datelor. În loc să provină din alegerile algoritmice sau presupunerile umane din timpul dezvoltării modelului, biasul de selecție a sursei este încorporat în fundația setului de date de antrenament. Acest lucru îl face deosebit de insidios, deoarece modelele antrenate pe date părtinitoare vor perpetua și amplifica aceste biasuri în predicțiile lor, indiferent de cât de sofisticat este algoritmul. Problema devine și mai critică atunci când sistemele AI sunt implementate în domenii sensibile precum sănătatea, finanțele, justiția penală sau recrutarea, unde predicțiile părtinitoare pot avea consecințe grave pentru indivizi și comunități.

Biasul de selecție a sursei se dezvoltă prin mai multe mecanisme distincte în timpul procesului de colectare și curare a datelor. Cea mai comună cale este biasul de acoperire, unde anumite populații sau scenarii sunt excluse sistematic din setul de date de antrenament. De exemplu, dacă un sistem de recunoaștere facială este antrenat în principal pe imagini cu persoane cu pielea deschisă la culoare, va avea o acoperire slabă pentru fețele cu piele mai închisă, ducând la rate de eroare mai mari pentru acele populații. Acest lucru se întâmplă deoarece colectorii de date pot avea acces limitat la populații diverse sau pot prioritiza inconștient anumite grupuri când adună date.

Un alt mecanism critic este biasul de non-răspuns, numit și bias de participare, care apare atunci când anumite grupuri sunt mai puțin predispuse să participe la procesele de colectare a datelor. De exemplu, într-un set de date bazat pe chestionare pentru a prezice preferințele consumatorilor: dacă anumite grupuri demografice răspund semnificativ mai puțin la chestionare, preferințele lor vor fi subreprezentate în datele de antrenament. Aceasta creează un set de date care pare echilibrat, dar reflectă de fapt tiparele de participare, nu caracteristicile reale ale populației. În domeniul sănătății, de exemplu, dacă datele din studiile clinice provin predominant din populații urbane cu acces la facilități medicale avansate, modelele AI rezultate nu se vor generaliza bine la comunități rurale sau defavorizate.

Biasul de eșantionare reprezintă un al treilea mecanism, unde nu se folosește o randomizare corectă la colectarea datelor. În loc să selecteze aleator datele, colectorii pot alege primele exemple disponibile sau pot folosi metode de eșantionare convenabile. Aceasta introduce erori sistematice deoarece eșantioanele alese nu sunt reprezentative pentru populația generală. De exemplu, dacă un model AI pentru prezicerea restanțelor la credite este antrenat pe date colectate dintr-o anumită regiune geografică sau perioadă de timp, este posibil să nu prezică corect restanțele în alte regiuni sau în condiții economice diferite.

| Tipul de Bias | Mecanism | Exemplu din Lumea Reală |

|---|---|---|

| Bias de Acoperire | Excluderea sistematică a populațiilor | Recunoaștere facială antrenată doar pe fețe cu piele deschisă |

| Bias de Non-Răspuns | Gaps de participare în colectarea datelor | Modele de sănătate antrenate doar pe populații urbane |

| Bias de Eșantionare | Randomizare incorectă la selecție | Modele de credit antrenate pe o singură regiune geografică |

| Bias Temporal | Date din anumite perioade de timp | Modele antrenate pe date pre-pandemice aplicate post-pandemie |

| Bias de Diversitate a Surselor | Surse de date limitate | Seturi de date imagistice medicale dintr-un singur spital |

Consecințele biasului de selecție a sursei în sistemele AI sunt profunde și extinse, afectând atât indivizii, cât și organizațiile. În sănătate, biasul de selecție a sursei a condus la sisteme de diagnosticare care funcționează semnificativ mai slab pentru anumite populații de pacienți. Cercetările au arătat că algoritmii AI pentru diagnosticarea cancerului de piele prezintă o acuratețe mult mai scăzută pentru pacienții cu tenul mai închis, unele studii indicând doar jumătate din acuratețea pentru pacienții cu pielea deschisă. Această disparitate se traduce direct în diagnosticări întârziate, recomandări de tratament nepotrivite și rezultate mai slabe pentru populațiile subreprezentate. Când datele de antrenament provin în principal dintr-un singur grup demografic, modelele rezultate învață tipare specifice acelui grup și nu se generalizează la altele.

În servicii financiare, biasul de selecție a sursei în scorarea de credit și algoritmii de acordare a creditelor a perpetuat discriminarea istorică. Modelele antrenate pe date istorice de aprobare a creditelor care reflectă practici de creditare discriminatorii vor reproduce aceleași biasuri în deciziile viitoare. Dacă anumite grupuri au fost refuzate istoric din cauza discriminării sistemice, iar aceste date istorice sunt folosite pentru antrenarea modelelor AI, modelele vor învăța să refuze creditul grupurilor similare în viitor. Acest lucru creează un cerc vicios în care inechitățile istorice sunt încorporate în deciziile algoritmice, afectând accesul la capital și oportunitățile economice.

Recrutarea și angajarea reprezintă un alt domeniu critic unde biasul de selecție a sursei provoacă daune semnificative. Instrumentele AI folosite pentru filtrarea CV-urilor au fost descoperite ca prezentând biasuri pe baza rasei sau genului perceput, unele studii arătând că numele asociate cu persoane albe au fost favorizate în 85% din cazuri. Când datele de antrenament provin din istoricul angajărilor care reflectă discriminări anterioare sau tipare omogene de recrutare, modelele AI rezultate reproduc aceste tipare. Astfel, biasul de selecție a sursei în datele de recrutare perpetuează discriminarea la scară largă, limitând oportunitățile grupurilor subreprezentate și reducând diversitatea forței de muncă.

În justiția penală, biasul de selecție a sursei din sistemele predictive de poliție a dus la vizarea disproporționată a anumitor comunități. Când datele de antrenament provin din istoricul arestărilor, care sunt ele însele părtinitoare împotriva grupurilor marginalizate, modelele rezultate amplifică aceste biasuri prezicând rate mai mari de infracționalitate în acele comunități. Se creează astfel un cerc vicios în care predicțiile părtinitoare duc la activitate polițienească sporită în anumite zone, ceea ce generează mai multe date de arestări din acele zone, consolidând și mai mult biasul din model.

Detectarea biasului de selecție a sursei necesită o abordare sistematică ce combină analiza cantitativă, evaluarea calitativă și monitorizarea continuă pe tot parcursul ciclului de viață al modelului. Primul pas este efectuarea unui audit cuprinzător al datelor, care analizează sursele, metodele de colectare și reprezentativitatea datelor de antrenament. Acest lucru presupune documentarea sursei datelor, a modului de colectare și dacă procesul ar fi putut exclude sistematic anumite populații sau scenarii. Pune întrebări critice: Au fost toate grupurile demografice relevante reprezentate în procesul de colectare a datelor? Au existat bariere de participare care ar fi putut descuraja anumite grupuri să participe? Perioada sau aria geografică de colectare au limitat reprezentarea?

Analiza parității demografice oferă o abordare cantitativă pentru detectarea biasului de selecție a sursei. Aceasta presupune compararea distribuției caracteristicilor cheie din datele de antrenament cu distribuția din populația reală pe care o va deservi modelul. Dacă datele de antrenament subreprezintă semnificativ anumite grupuri demografice, categorii de vârstă, regiuni geografice sau alte caracteristici relevante, ai dovezi clare de bias de selecție a sursei. De exemplu, dacă datele de antrenament conțin doar 5% reprezentare feminină, dar populația țintă este 50% femei, acesta este un bias de acoperire grav, care va duce probabil la performanțe slabe ale modelului pentru femei.

Analiza performanței pe segmente este o altă tehnică esențială, unde evaluezi performanța modelului separat pentru diferite grupuri demografice și subpopulații. Chiar dacă acuratețea generală a modelului pare acceptabilă, performanța poate varia dramatic între grupuri. Dacă modelul atinge o acuratețe de 95% pe ansamblu, dar doar 70% pentru un anumit grup demografic, aceasta sugerează că biasul de selecție a sursei a dus la învățarea unor tipare specifice grupului majoritar, fără a surprinde tiparele relevante pentru grupul minoritar. Această analiză trebuie realizată nu doar pe acuratețea generală, ci și pe metrici de echitate precum “equalized odds” sau “disparate impact”.

Testarea adversarială presupune crearea deliberată de cazuri de test menite să expună potențiale biasuri. Asta poate însemna testarea modelului pe date din populații subreprezentate, cazuri limită sau scenarii slab reprezentate în datele de antrenament. Prin testarea intensivă a modelului cu date diverse, poți identifica unde biasul de selecție a sursei a creat puncte oarbe. De exemplu, dacă modelul a fost antrenat în principal pe date urbane, testează-l extensiv pe date rurale pentru a vedea dacă performanța scade. Dacă datele de antrenament provin dintr-o anumită perioadă, testează modelul pe date din alte perioade pentru a detecta bias temporal.

Reducerea biasului de selecție a sursei necesită intervenții în mai multe etape ale ciclului de viață AI, de la colectarea datelor până la evaluarea și implementarea modelului. Cea mai eficientă abordare este mitigarea centrată pe date, care tratează biasul la sursă prin îmbunătățirea calității și reprezentativității datelor de antrenament. Aceasta începe cu colectarea diversificată a datelor, unde se urmărește activ includerea populațiilor și scenariilor subreprezentate. În loc să se bazeze pe eșantionare convenabilă sau pe seturi de date existente, organizațiile ar trebui să desfășoare campanii țintite de colectare a datelor pentru a asigura reprezentarea adecvată a tuturor grupurilor demografice relevante și a cazurilor de utilizare.

Tehnicile de resampling și reponderare oferă metode practice pentru a corecta dezechilibrele din seturile de date existente. Supraeșantionarea aleatorie dublează exemplele din grupurile subreprezentate, în timp ce subeșantionarea aleatorie reduce exemplele din grupurile suprasolicitate. Abordări mai sofisticate, precum eșantionarea stratificată, asigură reprezentare proporțională pe mai multe dimensiuni simultan. Reponderarea atribuie o importanță mai mare exemplarelor subreprezentate în timpul antrenării, indicând algoritmului să acorde mai multă atenție tiparelor din grupurile minoritare. Aceste tehnici funcționează cel mai bine combinate cu eforturi de colectare a datelor mai diverse, nu doar cu resamplingul unor date limitate.

Generarea de date sintetice oferă o altă cale pentru abordarea biasului de selecție a sursei, mai ales când colectarea datelor reale din populații subreprezentate este dificilă sau costisitoare. Tehnici precum Rețelele Generative Adversariale (GANs) sau Autoencoderii Variaționali (VAEs) pot crea exemple sintetice realiste pentru grupurile minoritare. Abordări precum SMOTE (Synthetic Minority Over-sampling Technique) creează exemple sintetice prin interpolare între instanțe minoritare existente. Totuși, datele sintetice trebuie folosite cu grijă și validate riguros, deoarece pot introduce propriile biasuri dacă nu sunt generate corect.

Algoritmii conștienți de echitate (fairness-aware) reprezintă o altă strategie de reducere ce operează la nivelul antrenării modelului. Acești algoritmi încorporează explicit constrângeri de echitate în procesul de învățare, asigurând performanțe acceptabile pentru toate grupurile demografice, nu doar pentru cel majoritar. Debiasarea adversarială, de exemplu, folosește o rețea adversarială pentru a se asigura că predicțiile modelului nu pot fi folosite pentru a deduce caracteristici protejate precum rasa sau genul. Regularizarea conștientă de echitate adaugă termeni de penalizare în funcția de pierdere care descurajează comportamentul discriminatoriu. Aceste abordări permit reglarea explicită a compromisului între acuratețe și echitate, alegând echilibrul care corespunde priorităților etice.

Monitorizarea și reantrenarea continuă asigură că biasul de selecție a sursei nu apare sau nu se agravează în timp. Chiar dacă datele tale de antrenament inițiale sunt reprezentative, distribuția reală a populației deservite de model poate evolua odată cu schimbările demografice, economice sau de altă natură. Implementarea unor sisteme de monitorizare a performanței care urmăresc separat acuratețea modelului pentru diferite grupuri demografice permite detectarea apariției biasului. Când se detectează degradarea performanței, reantrenarea cu date actualizate ce reflectă distribuția curentă poate restabili echitatea. Acest proces continuu recunoaște că reducerea biasului nu este un efort singular, ci o responsabilitate permanentă.

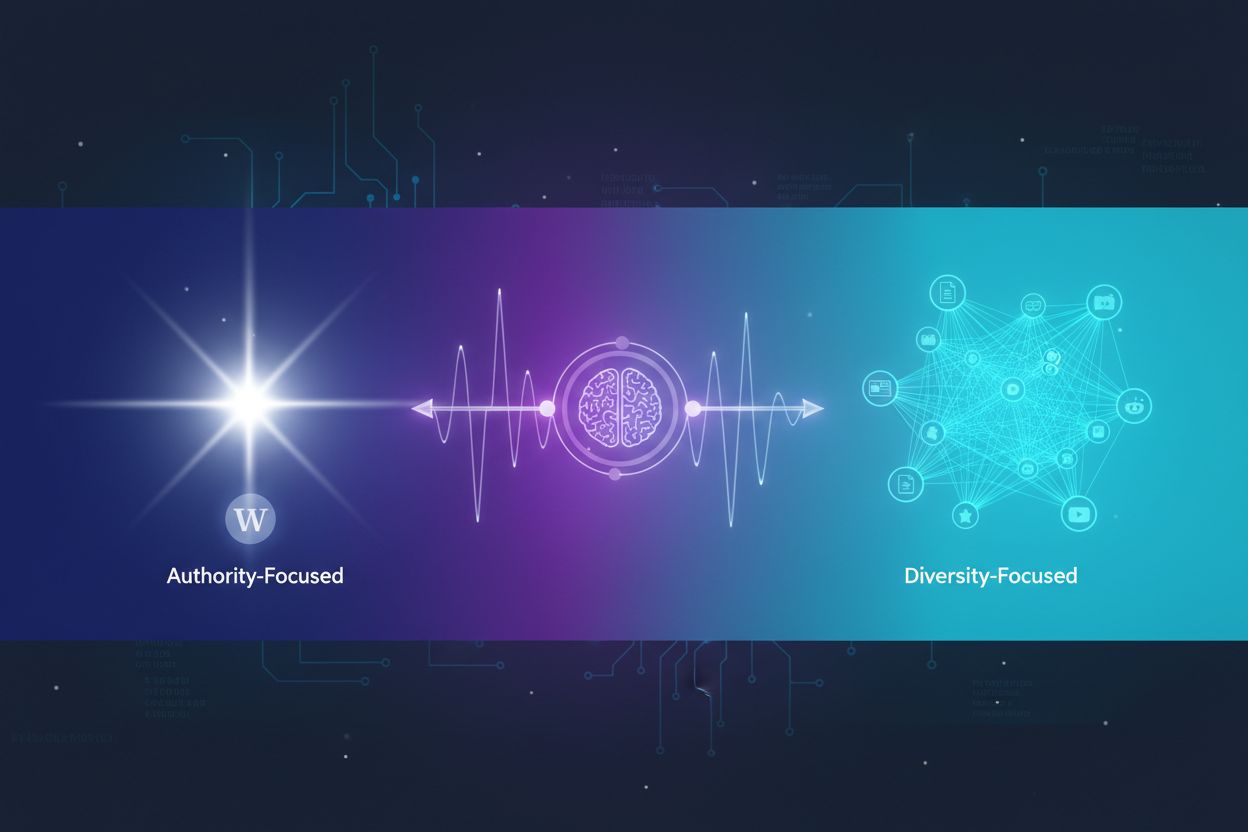

Înțelegerea biasului de selecție a sursei devine tot mai importantă în contextul monitorizării răspunsurilor AI și urmăririi prezenței brandului. Pe măsură ce sisteme AI precum ChatGPT, Perplexity și alți generatori de răspunsuri AI devin surse principale de informații pentru utilizatori, sursele pe care aceste sisteme le citează și informația prezentată sunt modelate de datele de antrenament. Dacă datele de antrenament ale acestor sisteme AI prezintă bias de selecție a sursei, răspunsurile generate vor reflecta acel bias. De exemplu, dacă datele de antrenament ale unui sistem AI suprareprezintă anumite site-uri, publicații sau perspective și subreprezintă altele, sistemul AI va cita și amplifica mai des informațiile din sursele suprareprezentate.

Acest lucru are implicații directe pentru monitorizarea brandului și vizibilitatea conținutului. Dacă brandul, domeniul sau URL-urile tale sunt subreprezentate în datele de antrenament ale marilor sisteme AI, conținutul tău poate fi sistematic exclus sau subreprezentat în răspunsurile generate de AI. Pe de altă parte, dacă branduri concurente sau surse de dezinformare sunt suprareprezentate, acestea vor primi vizibilitate disproporționată în răspunsurile AI. Monitorizarea modului în care brandul tău apare în răspunsurile AI pe diferite platforme te ajută să înțelegi dacă biasul de selecție a sursei din aceste sisteme îți afectează vizibilitatea și reputația. Prin urmărirea surselor citate, a frecvenței cu care apare conținutul tău și a corectitudinii informațiilor, poți identifica posibile biasuri în modul în care AI-ul îți reprezintă brandul și industria.

Biasul de selecție a sursei în AI este o problemă critică de echitate care își are originea în etapa de colectare a datelor și se propagă în toate aplicațiile ulterioare ale modelelor de învățare automată. Apare atunci când datele de antrenament exclud sau subreprezintă sistematic anumite populații, scenarii sau caracteristici, rezultând modele care fac predicții inexacte sau incorecte pentru grupurile subreprezentate. Consecințele sunt severe și extinse, afectând rezultatele în sănătate, accesul financiar, oportunitățile de angajare și deciziile din justiție. Detectarea biasului de selecție a sursei necesită audituri de date cuprinzătoare, analiză a parității demografice, analiză a performanței pe segmente și testare adversarială. Reducerea acestui bias presupune o abordare multifactorială, inclusiv colectare de date diversificată, resampling și reponderare, generare de date sintetice, algoritmi conștienți de echitate și monitorizare continuă. Organizațiile trebuie să recunoască faptul că adresarea biasului de selecție a sursei nu este opțională, ci esențială pentru construirea unor sisteme AI corecte, precise și de încredere pentru toate populațiile și cazurile de utilizare.

Asigură-te că brandul tău apare corect în răspunsurile generate de AI pe ChatGPT, Perplexity și alte platforme AI. Urmărește cum sistemele AI citează conținutul tău și identifică potențiale biasuri în răspunsurile AI.

Află cum sistemele AI selectează și clasifică sursele pentru citare. Descoperă algoritmii, semnalele și factorii care determină ce site-uri web sunt citate de p...

Află ce este biasul de recență în sistemele AI, cum afectează vizibilitatea conținutului, algoritmii de recomandare și deciziile de business. Descoperă strategi...

Află cum sistemele AI decid între citarea mai multor surse sau concentrarea pe cele autoritare. Înțelege tiparele de citare pe ChatGPT, Google AI Overviews, Per...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.