Definiția cuvintelor cheie LSI

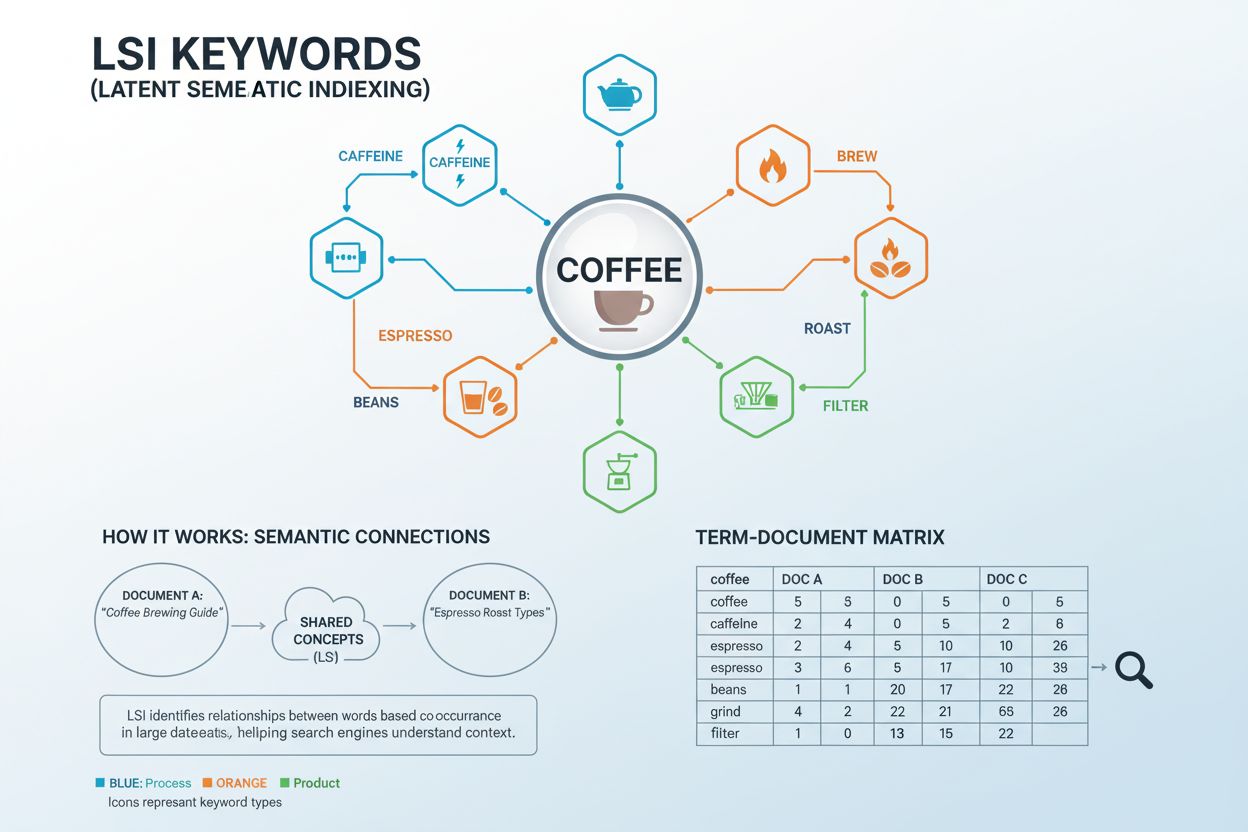

Cuvintele cheie LSI (Latent Semantic Indexing Keywords) sunt cuvinte și expresii care sunt conceptual legate de cuvântul cheie țintă și apar frecvent împreună în contexte similare. Termenul provine dintr-o tehnică matematică dezvoltată în anii 1980 care analizează relațiile semantice ascunse dintre cuvinte în colecții mari de documente. În termeni practici SEO, cuvintele cheie LSI sunt termeni de căutare care ajută motoarele de căutare și sistemele AI să înțeleagă contextul mai larg și subiectul conținutului tău, dincolo de potrivirea exactă a expresiilor cheie. De exemplu, dacă principalul tău cuvânt cheie este „cafea”, cuvinte cheie LSI asociate ar putea fi „cofeină”, „preparare”, „espresso”, „boabe”, „prăjire” și „măcinare”. Acești termeni lucrează împreună pentru a semnala motoarelor de căutare că acoperi în mod cuprinzător subiectul cafelei, nu doar menționezi cuvântul în mod repetat.

Context istoric și evoluția cuvintelor cheie LSI

Indexarea semantică latentă a fost introdusă într-o lucrare de cercetare seminală din 1988 ca „o nouă abordare pentru rezolvarea problemei vocabularului în interacțiunea om-calculator”. Tehnologia a fost concepută pentru a rezolva o provocare fundamentală: motoarele de căutare erau prea dependente de potrivirea exactă a cuvintelor cheie, ceea ce ducea adesea la nerecuperarea documentelor relevante atunci când utilizatorii foloseau termeni sau sinonime diferite. În 2004, Google a implementat conceptele LSI în algoritmul său de căutare, marcând o schimbare semnificativă în modul în care motoarele de căutare înțelegeau conținutul. Această actualizare a permis Google să treacă dincolo de analiza simplă a frecvenței cuvintelor cheie și să înceapă să înțeleagă contextul, sensul și relațiile conceptuale dintre termeni. Peste 15% din căutările zilnice de pe Google sunt acum termeni noi care nu au mai fost căutați anterior, conform cercetărilor proprii Google, iar înțelegerea contextuală prin termeni înrudiți devine tot mai critică. Evoluția de la LSI la analiza semantică modernă reprezintă una dintre cele mai importante schimbări în tehnologia motoarelor de căutare, schimbând fundamental modul în care creatorii de conținut abordează optimizarea.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Cuvinte cheie LSI vs. Termenologie asociată: Tabel comparativ

| Termen | Definiție | Accent | Relația cu cuvântul cheie principal | Impact în SEO modern |

|---|

| Cuvinte cheie LSI | Cuvinte care apar împreună cu cuvântul cheie principal, pe baza analizei matematice | Modele de frecvență și co-apariție a cuvintelor | Relație contextuală directă | Limitat (Google nu folosește algoritmul LSI) |

| Cuvinte cheie semantice | Termeni conceptuali înrudiți care răspund intenției utilizatorului și adâncimii subiectului | Sens și intenția utilizatorului | Relație tematică mai largă | Ridicat (esențial pentru SEO modern) |

| Sinonime | Cuvinte cu semnificații identice sau foarte similare | Înlocuire directă de cuvinte | Același sens, cuvânt diferit | Moderat (utile, dar nu focus principal) |

| Cuvinte cheie long-tail | Expresii cheie mai lungi și mai specifice | Volum de căutare și specificitate | Versiune mai specifică a cuvântului cheie principal | Ridicat (concurență mai mică, intenție mai clară) |

| Cuvinte cheie asociate | Termeni căutați frecvent alături de cuvântul cheie principal | Modele de comportament de căutare | Modele de căutare ale utilizatorului | Ridicat (indicativ pentru intenție) |

| Cuvinte cheie entitate | Entități și concepte denumite legate de subiect | Relații între entități și grafuri de cunoștințe | Relație conceptuală și categorială | Foarte ridicat (sistemele AI prioritizează entitățile) |

Fundamentul matematic: Cum funcționează cuvintele cheie LSI

Indexarea semantică latentă operează printr-un proces matematic sofisticat, numit Decompoziție în Valori Singulare (SVD), care analizează relațiile dintre cuvinte în colecții mari de documente. Sistemul începe prin crearea unei matrice termen-document (TDM)—o grilă bidimensională care monitorizează cât de frecvent apare fiecare cuvânt în diverse documente. Cuvintele de legătură (precum „și”, „este”, „la”) sunt eliminate pentru a izola termenii purtători de conținut. Algoritmul aplică apoi funcții de ponderare pentru a identifica modele de co-apariție—situații în care anumite cuvinte apar împreună cu frecvență similară în mai multe documente. Când cuvintele apar constant împreună în contexte similare, sistemul le recunoaște ca fiind semantic înrudite. De exemplu, cuvintele „cafea”, „preparare”, „espresso” și „cofeină” apar frecvent împreună în documente despre băuturi, semnalând relația lor semantică. Această abordare matematică permite computerelor să înțeleagă că „espresso” și „cafea” sunt concepte legate, fără a fi nevoie de reguli explicite. Vectorii SVD generați de această analiză prezic semnificația mai precis decât analizarea termenilor individuali, permițând motoarelor de căutare să înțeleagă conținutul la un nivel conceptual mai profund decât permite potrivirea simplă a cuvintelor cheie.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

De ce Google nu folosește LSI (dar apreciază în continuare înțelegerea semantică)

În ciuda eleganței teoretice a indexării semantice latente, Google a declarat explicit că nu folosește LSI în algoritmul său de clasificare. John Mueller, reprezentant Google, a confirmat în 2019: „Nu există așa ceva ca și cuvinte cheie LSI—oricine vă spune altceva se înșală, îmi pare rău.” Mai mulți factori explică de ce Google a renunțat la LSI pentru abordări moderne. În primul rând, LSI a fost proiectat pentru colecții mici, statice de documente, nu pentru World Wide Web-ul dinamic și în continuă expansiune. Brevetul original LSI, acordat Bell Communications Research în 1989, a expirat în 2008, dar până atunci Google deja depășise această tehnologie. Mai important, Google a dezvoltat sisteme mult mai avansate, precum RankBrain (introdus în 2015), care folosește învățarea automată pentru a transforma textul în vectori matematici ușor de înțeles de computere. Google a introdus ulterior BERT (Bidirectional Encoder Representations from Transformers) în 2019, care analizează cuvintele bidirecțional—luând în considerare toate cuvintele dinainte și după un termen anume pentru a înțelege contextul. Spre deosebire de LSI, care elimină cuvintele de legătură, BERT recunoaște că termeni precum „găsesc” în „Unde pot găsi un dentist local?” sunt esențiali pentru a înțelege intenția căutării. Astăzi, Google folosește MUM (Multitask Unified Model) și AI Overviews pentru a genera rezumate contextuale direct în rezultate, reprezentând o evoluție cu mult peste ce putea realiza LSI.

SEO semantic: Evoluția modernă a conceptelor LSI

Deși cuvintele cheie LSI ca tehnologie specifică sunt depășite, principiul de bază—ca motoarele de căutare să înțeleagă contextul și sensul conținutului—rămâne fundamental pentru SEO modern. SEO semantic reprezintă evoluția acestui concept, concentrându-se pe intenția utilizatorului, autoritatea tematică și acoperirea cuprinzătoare a subiectului, nu pe modelele de frecvență ale cuvintelor cheie. Conform datelor din 2025, aproximativ 74% dintre toate căutările sunt acum expresii long-tail, ceea ce face ca înțelegerea semantică să fie crucială pentru a ajunge la audiențe diverse. SEO semantic presupune crearea unui conținut care abordează complet un subiect din mai multe perspective, încorporând natural concepte înrudite și răspunzând întrebărilor relevante. Această abordare este în acord cu modul în care sistemele AI moderne precum ChatGPT, Perplexity, Google AI Overviews și Claude evaluează sursele. Aceste sisteme prioritizează conținutul care demonstrează expertiză, cuprindere și autoritate tematică clară—calități care apar firesc când incluzi termeni și concepte semantic înrudite. Trecerea de la LSI la SEO semantic marchează maturizarea tehnologiei de căutare, trecând de la recunoașterea matematică a modelelor la înțelegerea contextuală autentică alimentată de rețele neuronale și învățare automată.

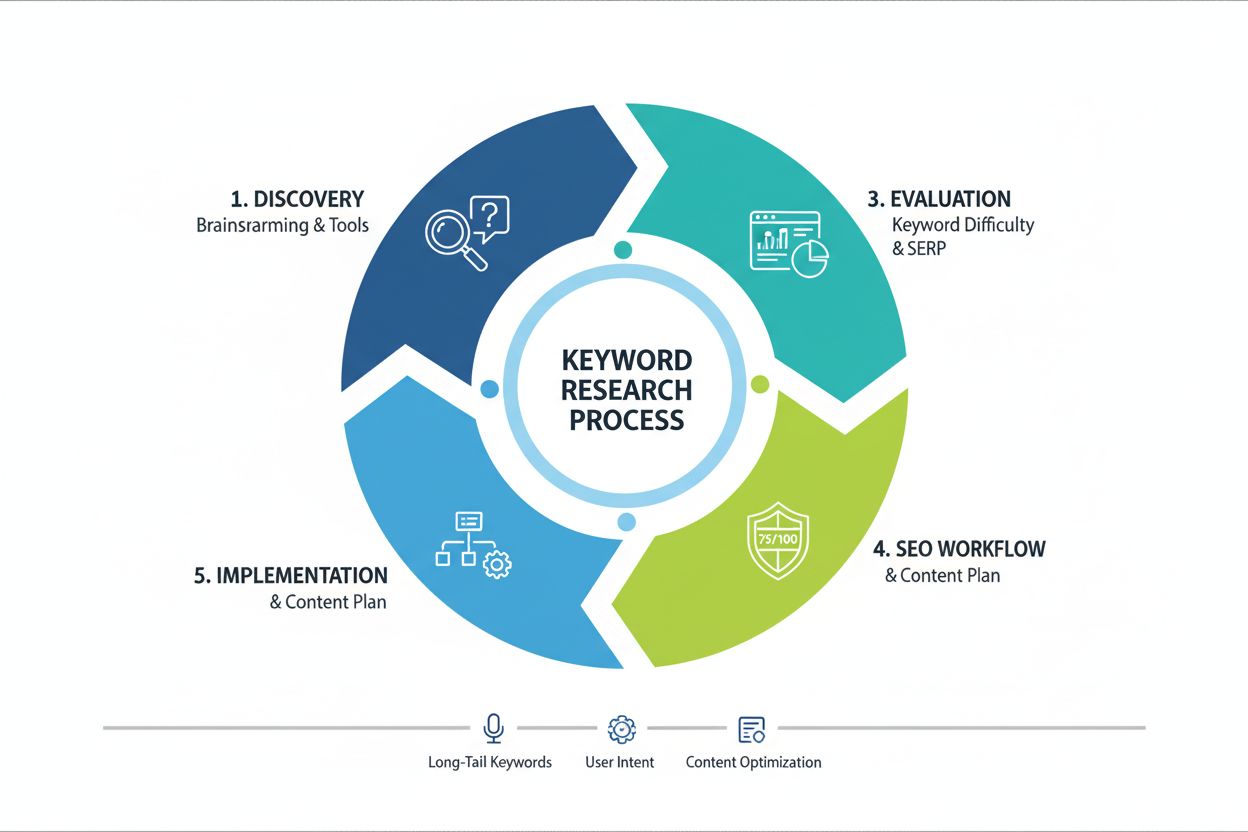

Implementare practică: Unde și cum să folosești cuvinte cheie înrudite

Includerea cuvintelor cheie LSI și a termenilor semantic înrudiți în conținutul tău necesită plasare strategică și integrare naturală. Cele mai eficiente locații pentru acești termeni includ etichetele title și anteturile H1, care au o pondere semnificativă în evaluarea motoarelor de căutare. Subtitlurile H2 și H3 oferă oportunități excelente de a introduce natural concepte înrudite, organizând în același timp logic conținutul. Textul alternativ al imaginilor reprezintă o altă oportunitate valoroasă, permițând consolidarea relevanței tematice și îmbunătățirea accesibilității. Pe parcursul conținutului principal, termenii înrudiți ar trebui integrați firesc în propoziții și paragrafe, susținând narațiunea principală fără a o perturba. Meta descrierile pot include cuvinte cheie înrudite pentru a crește rata de clic din rezultatele căutării. Textele ancoră ale linkurilor interne oferă oportunități suplimentare de a consolida relațiile semantice între paginile relevante de pe site-ul tău. Principiul cheie este integrarea naturală—dacă un termen înrudit nu se potrivește firesc în conținut, nu ar trebui forțat. Studiile arată că un conținut cu un cuvânt cheie LSI la fiecare 200-300 de cuvinte păstrează un echilibru optim între bogăția semantică și lizibilitate. Acest raport nu este o regulă strictă, ci mai degrabă un ghid util pentru a asigura acoperirea tematică fără umplere cu cuvinte cheie.

Cuvintele cheie LSI și vizibilitatea în căutările AI

Pentru branduri și creatori de conținut concentrați pe vizibilitatea în căutările AI și citările pe platforme precum cele monitorizate de AmICited, înțelegerea cuvintelor cheie LSI și a relațiilor semantice devine tot mai importantă. Sistemele AI care generează răspunsuri pentru ChatGPT, Perplexity, Google AI Overviews și Claude evaluează sursele pe baza cuprinderii tematice și a semnalelor de expertiză. Când conținutul tău include termeni și concepte semantic înrudite, transmiți acestor sisteme AI că ai acoperit subiectul în profunzime. Această acoperire cuprinzătoare crește probabilitatea ca materialul tău să fie selectat drept sursă pentru răspunsuri generate de AI. În plus, cuvintele cheie semantice ajută la stabilirea relațiilor de entitate—conexiuni între concepte pe care sistemele AI le folosesc pentru a înțelege domenii de cunoaștere. De exemplu, un conținut despre „cafea” care include entități precum „cofeină”, „espressoare”, „boabe de cafea” și „metode de preparare” demonstrează o expertiză mai largă decât un conținut care menționează doar cuvântul cheie principal. Acest conținut bogat în entități are șanse mai mari să fie citat de sistemele AI care generează răspunsuri cuprinzătoare. Pe măsură ce căutarea AI evoluează, capacitatea de a demonstra autoritate tematică prin bogăție semantică devine un avantaj competitiv esențial pentru vizibilitate și citări.

Aspecte cheie ale cuvintelor cheie LSI și optimizării semantice

- Relații contextuale: Termeni înrudiți care apar frecvent împreună în contexte similare, ajutând motoarele de căutare să înțeleagă sensul conținutului dincolo de potrivirile exacte ale cuvintelor cheie

- Modele de co-apariție: Cuvinte care apar constant împreună în mai multe documente, semnalând relații semantice algoritmilor de căutare

- Autoritate tematică: Acoperire completă a unui subiect prin concepte înrudite, stabilind expertiză și credibilitate atât pentru motoarele de căutare, cât și pentru sistemele AI

- Integrare naturală: Includerea firească a termenilor înrudiți în conținut astfel încât să fie lizibil pentru oameni și relevant pentru motoarele de căutare

- Aliniere cu intenția de căutare: Folosirea termenilor semantic înrudiți care corespund căutărilor reale ale utilizatorilor, îmbunătățind relevanța conținutului și rata de clic

- Recunoaștere de entități: Identificarea și integrarea entităților și conceptelor relevante pentru subiectul principal, esențiale pentru evaluarea de către sistemele AI

- Bogăție semantică: Gradul de profunzime și lărgime a conținutului conceptual înrudit, indicând acoperirea completă a subiectului

- Variații long-tail ale cuvintelor cheie: Expresii mai lungi și mai specifice care captează intenții de căutare asociate și reduc concurența

- Cuprindere a conținutului: Abordarea mai multor perspective și subiecte conexe cuvântului cheie principal, îmbunătățind calitatea generală a conținutului

- Potențial de citare AI: Demonstrarea expertizei prin acoperire semantică crește șansele de a fi citat de sisteme AI precum ChatGPT și Perplexity

Viitorul înțelegerii semantice în căutare

Traiectoria tehnologiei de căutare indică clar o înțelegere semantică tot mai sofisticată, alimentată de inteligență artificială și învățare automată. Cuvintele cheie LSI ca tehnologie specifică reprezintă o încercare timpurie de rezolvare a problemei înțelegerii semantice, dar abordările moderne au depășit cu mult aceste capabilități. Viitoarele sisteme de căutare vor depinde probabil și mai mult de rețele neuronale, modele transformer și modele lingvistice de mari dimensiuni, pentru a înțelege nu doar ce spune conținutul, ci și ce înseamnă acesta în contexte mai largi. Apariția disciplinei Generative Engine Optimization (GEO) reflectă această schimbare—specialiștii în marketing trebuie să optimizeze nu doar pentru motoarele de căutare tradiționale, ci și pentru sistemele AI care generează răspunsuri. Aceste sisteme AI evaluează sursele pe baza cuprinderii, expertizei și autorității tematice—calități care apar firesc prin optimizare semantică. Pe măsură ce AI Overviews devin tot mai prezente în rezultatele căutării, abilitatea de a demonstra expertiză tematică prin conținut semantic bogat devine din ce în ce mai valoroasă. Viitorul probabil va implica o integrare și mai strânsă între SEO tradițional și optimizarea pentru AI, cu înțelegerea semantică drept liant între aceste discipline. Creatorii de conținut care înțeleg și aplică principiile optimizării semantice vor păstra avantajul de vizibilitate pe măsură ce tehnologia de căutare evoluează.

Concluzie: De la cuvinte cheie LSI la autoritate semantică

Deși cuvintele cheie LSI ca abordare algoritmică specifică nu mai sunt folosite de Google, principiul de bază—ca motoarele de căutare să înțeleagă contextul și sensul conținutului—rămâne mai relevant ca niciodată. Evoluția de la LSI la SEO semantic și apoi la optimizarea AI modernă reprezintă o progresie firească în modul în care tehnologia de căutare înțelege și evaluează conținutul. Pentru creatorii de conținut și brandurile concentrate pe vizibilitatea în motoarele de căutare și pe platformele AI, concluzia practică este clară: creează conținut cuprinzător, bogat tematic, care integrează natural concepte înrudite și demonstrează expertiză. Această abordare satisface atât cerințele motoarelor de căutare tradiționale, cât și criteriile de evaluare folosite de sisteme AI precum ChatGPT, Perplexity, Google AI Overviews și Claude. Înțelegând relațiile dintre cuvântul tău cheie principal și termenii înrudiți semantic, poți crea conținut care se clasează bine în rezultatele de căutare tradiționale și este citat drept sursă autoritară de către sistemele AI. Viitorul vizibilității în căutare aparține celor care stăpânesc optimizarea semantică—nu prin umplerea cuvintelor cheie sau integrarea artificială a termenilor, ci prin expertiză autentică și acoperire completă a subiectului, care integrează natural concepte înrudite și demonstrează o înțelegere profundă a tematicii abordate.