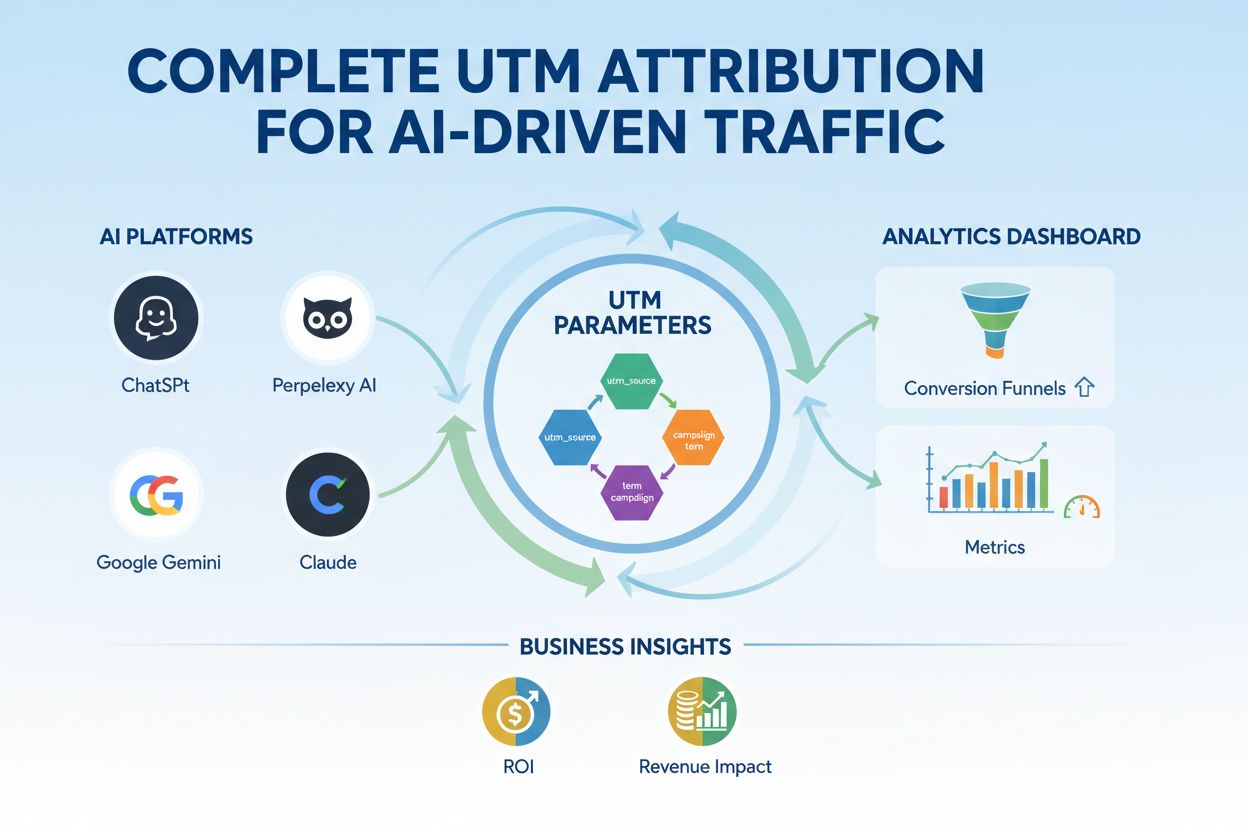

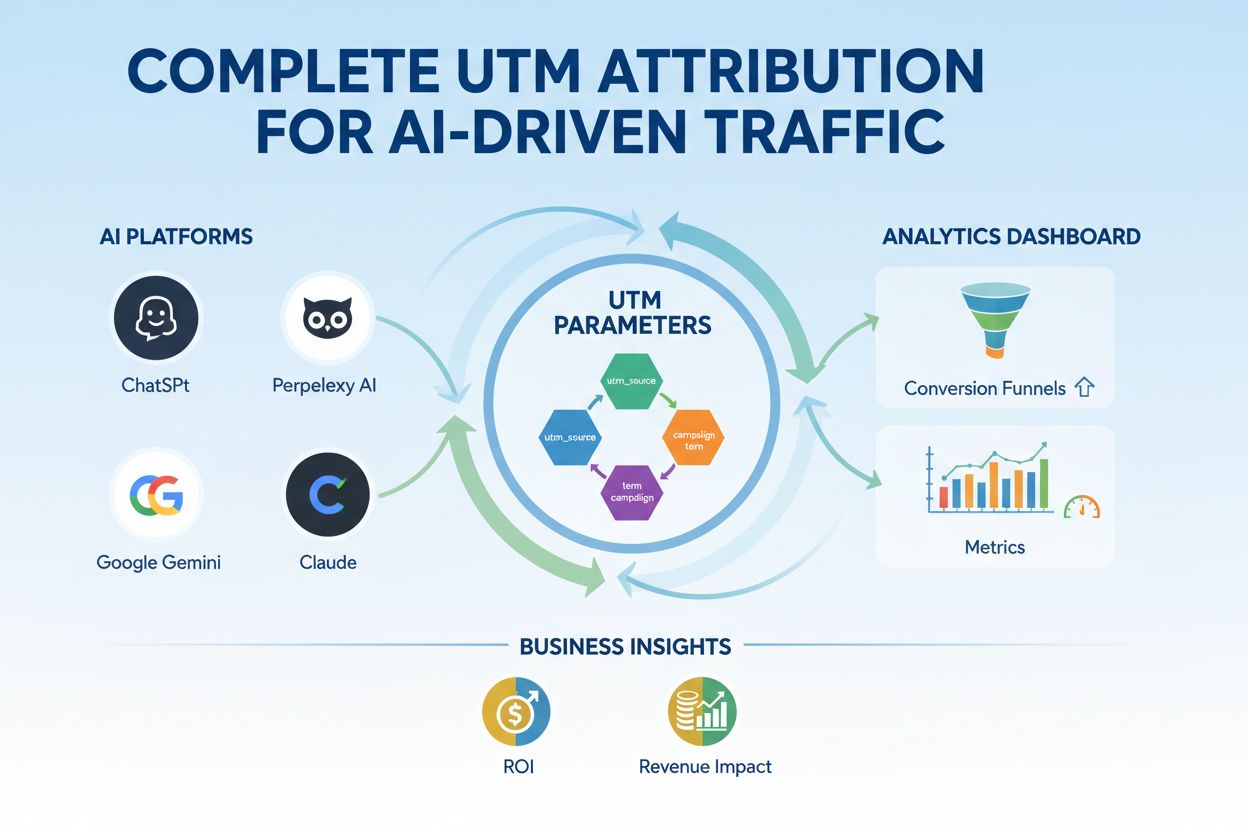

Parametrii UTM pentru Trafic Generat de AI

Stăpânește urmărirea UTM pentru platforme AI precum ChatGPT, Perplexity și Google Gemini. Învață configurarea, cele mai bune practici și cum să atribui corect t...

Parametrii de model sunt variabile învățabile din modelele de inteligență artificială, precum greutăți și biaisuri, care sunt ajustate automat în timpul antrenării pentru a optimiza abilitatea modelului de a face predicții precise și definesc modul în care modelul procesează datele de intrare pentru a genera rezultate.

Parametrii de model sunt variabile învățabile din modelele de inteligență artificială, precum greutăți și biaisuri, care sunt ajustate automat în timpul antrenării pentru a optimiza abilitatea modelului de a face predicții precise și definesc modul în care modelul procesează datele de intrare pentru a genera rezultate.

Parametrii de model sunt variabile învățabile din modelele de inteligență artificială care sunt ajustate automat în timpul procesului de antrenare pentru a optimiza abilitatea modelului de a face predicții precise și definesc modul în care modelul procesează datele de intrare pentru a genera rezultate. Acești parametri acționează ca niște „butoane de control” fundamentale ale sistemelor de învățare automată, determinând comportamentul precis și tiparele de decizie ale modelelor AI. În contextul învățării profunde și al rețelelor neuronale, parametrii constau în principal din greutăți și biaisuri—valori numerice care controlează modul în care informația circulă prin rețea și cât de puternic influențează diferite trăsături predicțiile. Scopul antrenării este de a descoperi valorile optime pentru acești parametri care să minimizeze erorile de predicție și să permită modelului să generalizeze bine pe date noi, nevăzute. Înțelegerea parametrilor de model este esențială pentru a înțelege cum funcționează sistemele AI moderne precum ChatGPT, Claude, Perplexity și Google AI Overviews și de ce produc rezultate diferite pentru aceeași intrare.

Conceptul de parametri învățabili în învățarea automată datează din primele zile ale rețelelor neuronale artificiale din anii 1950 și 1960, când cercetătorii au recunoscut pentru prima dată că rețelele pot ajusta valori interne pentru a învăța din date. Totuși, aplicarea practică a parametrilor a rămas limitată până la apariția backpropagation în anii 1980, care a oferit un algoritm eficient pentru calcularea modului în care trebuie ajustați parametrii pentru a reduce erorile. Explozia numărului de parametri s-a accelerat dramatic odată cu ascensiunea învățării profunde în anii 2010. Primele rețele neuronale convoluționale pentru recunoașterea imaginilor conțineau milioane de parametri, în timp ce modelele moderne de large language models (LLMs) conțin sute de miliarde sau chiar trilioane de parametri. Conform cercetărilor Our World in Data și Epoch AI, numărul de parametri în sisteme AI notabile a crescut exponențial, cu GPT-3 având 175 de miliarde de parametri, GPT-4o aproximativ 200 de miliarde de parametri, iar unele estimări sugerează că GPT-4 poate avea până la 1,8 trilioane de parametri dacă se iau în calcul arhitecturile mixture-of-experts. Această scalare dramatică a transformat fundamental ceea ce pot realiza sistemele AI, permițându-le să capteze tipare din ce în ce mai complexe în limbaj, vedere și sarcini de raționament.

Parametrii de model operează printr-un cadru matematic în care fiecare parametru reprezintă o valoare numerică ce influențează modul în care modelul transformă intrările în ieșiri. Într-un model simplu de regresie liniară, parametrii constau din pantă (m) și ordonata la origine (b) în ecuația y = mx + b, unde aceste două valori determină linia care se potrivește cel mai bine datelor. În rețelele neuronale, situația devine exponențial mai complexă. Fiecare neuron dintr-un strat primește intrări de la stratul precedent, înmulțește fiecare intrare cu un parametru de greutate corespunzător, însumează aceste intrări ponderate, adaugă un parametru de biais, și trece rezultatul printr-o funcție de activare pentru a produce o ieșire. Această ieșire devine apoi intrare pentru neuronii din stratul următor, creând un lanț de transformări ghidate de parametri. În timpul antrenării, modelul folosește gradient descent și algoritmi de optimizare pentru a calcula modul în care trebuie ajustat fiecare parametru pentru a reduce funcția de cost—o măsură matematică a erorii de predicție. Gradientul pierderii în raport cu fiecare parametru indică direcția și magnitudinea ajustării necesare. Prin backpropagation, acești gradienti circulă înapoi prin rețea, permițând optimizatorului să actualizeze toți parametrii simultan într-un mod coordonat. Acest proces iterativ continuă pe parcursul mai multor epoci de antrenare până când parametrii converg către valori care minimizează pierderea pe datele de antrenament menținând o bună generalizare pe date noi.

| Aspect | Parametri de model | Hiperparametri | Trăsături |

|---|---|---|---|

| Definiție | Variabile învățabile ajustate în timpul antrenării | Setări de configurare definite înainte de antrenare | Caracteristici ale datelor de intrare folosite de model |

| Când sunt setați | Învățați automat prin optimizare | Configurați manual de specialiști | Extrași sau construiți din date brute |

| Exemple | Greutăți, biaisuri în rețele neuronale | Rată de învățare, batch size, număr de straturi | Valori de pixeli în imagini, embeddinguri de cuvinte în text |

| Impact asupra modelului | Determină modul în care modelul mapează intrările la ieșiri | Controlează procesul de antrenare și structura modelului | Furnizează informația brută din care modelul învață |

| Metodă de optimizare | Gradient descent, Adam, AdaGrad | Grid search, random search, optimizare bayesiană | Feature engineering, selecția trăsăturilor |

| Număr în modele mari | Miliarde până la trilioane (ex: 200B în GPT-4o) | De obicei 5-20 hiperparametri cheie | Mii până la milioane în funcție de date |

| Cost computațional | Mare în timpul antrenării; afectează viteza de inferență | Cost computațional minim la setare | Determinat de colectarea și preprocesarea datelor |

| Transferabilitate | Pot fi transferați prin fine-tuning și transfer learning | Trebuie recalibrați pentru sarcini noi | Pot necesita re-inginerie pentru domenii noi |

Parametrii de model iau forme diferite în funcție de arhitectura și tipul de model de învățare automată utilizat. În rețelele neuronale convoluționale (CNNs) folosite pentru recunoașterea imaginilor, parametrii includ greutățile din filtrele de convoluție (numite și kerneluri) care detectează tipare spațiale precum margini, texturi și forme la diferite scări. Rețelele neuronale recurente (RNNs) și rețelele LSTM conțin parametri care controlează fluxul informației în timp, inclusiv parametri de gating care determină ce informație se reține sau se uită. Modelele Transformer, ce stau la baza modelelor mari de limbaj moderne, au parametri în mai multe componente: greutăți de atenție care determină pe ce părți ale intrării să se concentreze modelul, greutăți în rețelele feed-forward și parametri de normalizare a straturilor. În modelele probabilistice precum Naive Bayes, parametrii definesc distribuții de probabilitate condiționate. Support vector machines folosesc parametri care poziționează și orientează frontierele de decizie în spațiul trăsăturilor. Mixture of Experts (MoE), utilizate în unele versiuni GPT-4, conțin parametri pentru mai multe subrețele specializate plus parametri de rutare care decid ce expert procesează fiecare intrare. Această diversitate arhitecturală înseamnă că natura și numărul parametrilor variază semnificativ între modele, dar principiul fundamental rămâne: parametrii sunt valorile învățate care permit modelului să își îndeplinească sarcina.

Greutățile și biaisurile reprezintă cele două tipuri fundamentale de parametri în rețelele neuronale și stau la baza modului în care aceste modele învață. Greutățile sunt valori numerice atribuite conexiunilor dintre neuroni, determinând puterea și direcția influenței pe care o ieșire a unui neuron o are asupra intrării următorului neuron. Într-un strat complet conectat cu 1.000 de neuroni de intrare și 500 de neuroni de ieșire, ar exista 500.000 de parametri de greutate—câte unul pentru fiecare conexiune. În timpul antrenării, greutățile sunt ajustate pentru a crește sau diminua influența anumitor trăsături asupra predicțiilor. O greutate mare pozitivă înseamnă că trăsătura activează puternic neuronul următor, în timp ce o greutate negativă îl inhibă. Biaisurile sunt parametri suplimentari, câte unul pentru fiecare neuron dintr-un strat, care oferă un offset constant la suma de intrare a neuronului înainte de aplicarea funcției de activare. Matematic, dacă un neuron primește o sumă ponderată de intrări egală cu zero, biaisul permite neuronului să producă totuși o ieșire nenulă, oferind flexibilitate crucială. Această flexibilitate permite rețelelor neuronale să învețe frontiere de decizie complexe și să capteze tipare care nu ar fi posibile doar cu greutăți. Într-un model cu 200 de miliarde de parametri precum GPT-4o, majoritatea covârșitoare sunt greutăți în mecanismele de atenție și rețelele feed-forward, biaisurile reprezentând o parte mai mică dar tot semnificativă. Împreună, greutățile și biaisurile permit modelului să învețe tipare complexe în limbaj, viziune sau alte domenii, făcând sistemele AI moderne atât de puternice.

Numărul de parametri într-un model are un impact profund asupra capacității sale de a învăța tipare complexe și asupra performanței generale. Cercetările arată constant că legi ale scalării guvernează relația dintre numărul de parametri, dimensiunea datelor de antrenament și performanța modelului. Modelele cu mai mulți parametri pot reprezenta funcții mai complexe și capta tipare mai nuanțate în date, ducând în general la performanțe mai bune pe sarcini dificile. GPT-3 cu 175 de miliarde de parametri a demonstrat abilități remarcabile de few-shot learning pe care modelele mai mici nu le puteau atinge. GPT-4o cu 200 de miliarde de parametri prezintă îmbunătățiri suplimentare în raționament, generare de cod și înțelegere multimodală. Totuși, relația dintre parametri și performanță nu este liniară și depinde critic de cantitatea și calitatea datelor de antrenament. Un model cu prea mulți parametri față de date va supraantrena, memorând exemple specifice în loc să învețe tipare generalizabile, ceea ce duce la performanță slabă pe date noi. Invers, un model cu prea puțini parametri poate subantrena, ratând tipare importante și având performanțe suboptime chiar și pe datele de antrenament. Numărul optim de parametri pentru o sarcină depinde de complexitatea acesteia, dimensiunea și diversitatea setului de date de antrenament și constrângerile computaționale. Cercetările Epoch AI arată că sistemele AI moderne au atins performanțe remarcabile prin scalare masivă, unele modele conținând trilioane de parametri dacă se iau în calcul arhitecturile mixture-of-experts, unde nu toți parametrii sunt activi pentru fiecare intrare.

Deși modelele mari cu miliarde de parametri ating performanțe impresionante, costul computațional al antrenării și implementării acestor modele este substanțial. Acest lucru a condus la cercetări privind metode de fine-tuning eficiente din perspectiva parametrilor care permit practicienilor să adapteze modele pre-antrenate la sarcini noi fără a actualiza toți parametrii. LoRA (Low-Rank Adaptation) este o tehnică proeminentă care îngheață majoritatea parametrilor pre-antrenați și antrenează doar un set mic de matrici suplimentare low-rank, reducând numărul de parametri antrenați cu ordine de mărime menținând performanța. De exemplu, fine-tuning-ul unui model cu 7 miliarde de parametri cu LoRA poate implica antrenarea a doar 1-2 milioane de parametri suplimentari în loc de toți cei 7 miliarde. Modulele adapter inserează rețele mici antrenabile între straturile unui model pre-antrenat înghețat, adăugând doar un mic procent de parametri și permițând adaptarea la sarcini specifice. Prompt engineering și in-context learning sunt abordări alternative care nu modifică deloc parametrii, ci folosesc mai eficient parametrii existenți prin intrări atent concepute. Aceste abordări eficiente din punct de vedere al parametrilor au democratizat accesul la modelele mari de limbaj, permițând organizațiilor cu resurse computaționale limitate să personalizeze modele de ultimă generație pentru nevoile lor specifice. Compromisul între eficiența parametrilor și performanță rămâne un domeniu activ de cercetare, practicienii echilibrând dorința de eficiență computațională cu necesitatea acurateței pentru sarcini specifice.

Înțelegerea parametrilor de model este crucială pentru platforme precum AmICited care monitorizează modul în care brandurile și domeniile apar în răspunsurile generate de AI pe sisteme precum ChatGPT, Perplexity, Claude și Google AI Overviews. Modelele AI diferite, cu configurații de parametri diferite, produc rezultate diferite pentru aceeași întrebare, influențând unde și cum sunt menționate brandurile. Cei 200 de miliarde de parametri din GPT-4o sunt configurați diferit față de parametrii din Claude 3.5 Sonnet sau modelele Perplexity, ducând la variații în generarea răspunsurilor. Parametrii învățați în timpul antrenării pe seturi de date și obiective de antrenare diferite determină ca modelele să aibă cunoștințe, tipare de raționament și comportamente de citare diferite. Atunci când se monitorizează menționarea brandului în răspunsurile AI, înțelegerea faptului că aceste diferențe provin din variațiile parametrilor ajută la explicarea motivului pentru care un brand poate fi evidențiat într-un răspuns AI și abia menționat în altul. Parametrii care controlează mecanismele de atenție determină ce părți ale datelor de antrenament sunt cele mai relevante pentru o întrebare, influențând tiparele de citare. Parametrii din straturile de generare a ieșirii determină modul în care modelul structurează și prezintă informația. Urmărind modul în care diferite sisteme AI cu configurații de parametri diferite menționează brandurile, AmICited oferă perspective despre cum comportamentul modelului, determinat de parametri, afectează vizibilitatea brandului în peisajul căutărilor alimentate de AI.

Viitorul parametrilor de model este modelat de mai multe tendințe convergente care vor schimba fundamental modul în care sistemele AI sunt proiectate și implementate. Arhitecturile Mixture of Experts (MoE) reprezintă o evoluție semnificativă, unde modelele conțin mai multe subrețele specializate (experți) cu parametri separați, iar un mecanism de rutare determină care experți procesează fiecare intrare. Această abordare permite modelelor să scaleze la trilioane de parametri menținând eficiența computațională la inferență, deoarece nu toți parametrii sunt activi pentru fiecare intrare. Se pare că GPT-4 utilizează o arhitectură MoE cu 16 experți, fiecare cu 110 miliarde de parametri, totalizând 1,8 trilioane de parametri, dar folosind doar o fracție la inferență. Parametrii sparși și tehnicile de pruning sunt dezvoltate pentru a identifica și elimina parametrii mai puțin importanți, reducând dimensiunea modelului fără a sacrifica performanța. Învățarea continuă își propune să actualizeze eficient parametrii pe măsură ce devin disponibile date noi, permițând modelelor să se adapteze fără reantrenare completă. Învățarea federată distribuie antrenarea parametrilor pe mai multe dispozitive păstrând confidențialitatea, permițând organizațiilor să beneficieze de antrenare la scară largă fără a centraliza date sensibile. Apariția small language models (SLMs) cu miliarde, nu sute de miliarde de parametri, sugerează un viitor în care eficiența parametrilor va deveni la fel de importantă ca numărul lor brut. Pe măsură ce sistemele AI devin tot mai integrate în aplicații critice, înțelegerea și controlul parametrilor de model va deveni din ce în ce mai importantă pentru asigurarea siguranței, corectitudinii și alinierii cu valorile umane. Relația dintre numărul de parametri și comportamentul modelului va rămâne un punct central al cercetării AI, cu implicații pentru totul, de la sustenabilitatea computațională la interpretabilitatea și fiabilitatea sistemelor AI.

Parametrii de model sunt variabile interne învățate în timpul antrenării prin algoritmi de optimizare precum gradient descent, în timp ce hiperparametrii sunt setări externe configurate înainte de începerea antrenării. Parametrii determină modul în care modelul mapează intrările la ieșiri, pe când hiperparametrii controlează procesul de antrenare propriu-zis, precum rata de învățare și numărul de epoci. De exemplu, greutățile și biaisurile din rețelele neuronale sunt parametri, în timp ce rata de învățare este un hiperparametru.

Modelele mari de limbaj moderne conțin miliarde până la trilioane de parametri. GPT-4o conține aproximativ 200 de miliarde de parametri, în timp ce GPT-4o-mini are aproximativ 8 miliarde de parametri. Claude 3.5 Sonnet operează de asemenea cu sute de miliarde de parametri. Aceste numere masive de parametri permit modelelor să capteze tipare complexe în limbaj și să genereze răspunsuri sofisticate și relevante contextual pe diverse subiecte.

Mai mulți parametri cresc capacitatea unui model de a învăța tipare și relații complexe în date. Cu parametri suplimentari, modelele pot reprezenta trăsături și interacțiuni mai nuanțate, ducând la o acuratețe mai mare pe datele de antrenament. Totuși, există un echilibru critic: prea mulți parametri în raport cu datele de antrenament pot duce la supraantrenare, în care modelul memorează zgomotul în loc să învețe tipare generalizabile, ceea ce duce la o performanță scăzută pe date noi, nevăzute.

Parametrii de model sunt actualizați prin backpropagation și algoritmi de optimizare precum gradient descent. În timpul antrenării, modelul face predicții, calculează pierderea (eroarea) dintre predicții și valorile reale, apoi calculează gradientul care arată cum a contribuit fiecare parametru la acea eroare. Optimizatorul ajustează apoi parametrii în direcția care reduce pierderea, repetând acest proces de-a lungul mai multor iterații de antrenare până când modelul converge la valori optime.

Greutățile determină puterea conexiunilor dintre neuroni în rețelele neuronale, controlând cât de puternic influențează trăsăturile de intrare ieșirile. Biaisurile acționează ca reglaje de prag, permițând neuronilor să se activeze chiar și când intrările ponderate sunt zero, oferind flexibilitate și permițând modelului să învețe tipare de bază. Împreună, greutățile și biaisurile formează nucleul parametrilor învățați care permit rețelelor neuronale să aproximeze funcții complexe și să facă predicții precise.

Parametrii de model influențează direct modul în care sistemele AI precum ChatGPT, Perplexity și Claude procesează și răspund la întrebări. Înțelegerea numărului și configurației parametrilor ajută la explicarea motivului pentru care modele AI diferite produc rezultate diferite pentru același prompt. Pentru platforme de monitorizare a brandurilor precum AmICited, urmărirea modului în care parametrii influențează comportamentul modelului este crucială pentru a prezice unde apar brandurile în răspunsurile AI și pentru a înțelege consistența între diferite sisteme AI.

Da, prin transfer learning, parametrii unui model pre-antrenat pot fi adaptați pentru sarcini noi. Această abordare, numită fine-tuning, implică preluarea unui model cu parametri deja învățați și adaptarea lor pe date noi pentru aplicații specifice. Metode eficiente de fine-tuning precum LoRA (Low-Rank Adaptation) permit actualizarea selectivă a parametrilor, reducând costurile computaționale menținând performanța. Această tehnică este folosită pe scară largă pentru a personaliza modele mari de limbaj pentru domenii specializate.

Parametrii de model influențează direct cerințele computaționale atât în timpul antrenării, cât și în timpul inferenței. Mai mulți parametri necesită mai multă memorie, putere de procesare și timp pentru antrenare și implementare. Un model cu 175 de miliarde de parametri (precum GPT-3) necesită resurse computaționale semnificativ mai mari decât un model cu 7 miliarde de parametri. Această relație este esențială pentru organizațiile care implementează sisteme AI, deoarece numărul de parametri influențează costurile de infrastructură, latența și consumul de energie în mediile de producție.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Stăpânește urmărirea UTM pentru platforme AI precum ChatGPT, Perplexity și Google Gemini. Învață configurarea, cele mai bune practici și cum să atribui corect t...

Află cum specificațiile produselor îmbunătățesc sistemele de recomandare AI prin furnizarea de date structurate, creșterea acurateței și permiterea unei persona...

Află cum ajustarea fină a modelelor AI adaptează modelele pre-antrenate pentru sarcini specifice industriei și brandului, îmbunătățind acuratețea și reducând co...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.