Cum să configurezi robots.txt pentru crawlere AI: Ghid complet

Află cum să configurezi robots.txt pentru a controla accesul crawlerelor AI inclusiv GPTBot, ClaudeBot și Perplexity. Gestionează vizibilitatea brandului tău în...

Un fișier robots.txt este un fișier text simplu plasat în directorul rădăcină al unui site web care comunică instrucțiuni către crawlerele web și roboții motoarelor de căutare despre ce URL-uri pot sau nu pot accesa. Acesta servește drept element fundamental al protocolului de excludere a roboților, ajutând proprietarii de site-uri să gestioneze traficul crawlerelor, să optimizeze bugetul de crawl și să protejeze conținutul sensibil de la indexare.

Un fișier robots.txt este un fișier text simplu plasat în directorul rădăcină al unui site web care comunică instrucțiuni către crawlerele web și roboții motoarelor de căutare despre ce URL-uri pot sau nu pot accesa. Acesta servește drept element fundamental al protocolului de excludere a roboților, ajutând proprietarii de site-uri să gestioneze traficul crawlerelor, să optimizeze bugetul de crawl și să protejeze conținutul sensibil de la indexare.

Robots.txt este un fișier text simplu plasat în directorul rădăcină al unui site web (de exemplu, www.example.com/robots.txt ) care comunică instrucțiuni către crawlerele web și roboții motoarelor de căutare despre ce URL-uri pot sau nu pot accesa. Acest fișier servește drept element fundamental al protocolului de excludere a roboților, un standard care ajută la gestionarea activității roboților pe site-uri. Prin specificarea unor directive precum “allow” și “disallow”, proprietarii de site pot controla modul în care motoarele de căutare și alte crawlere interacționează cu conținutul lor. Potrivit Google Search Central, un fișier robots.txt le spune crawlerelor motoarelor de căutare ce URL-uri pot accesa pe site-ul tău, în principal pentru a evita supraîncărcarea cu solicitări și pentru a optimiza alocarea bugetului de crawl.

Importanța fișierului robots.txt depășește simpla controlare a accesului. Acesta reprezintă un mecanism esențial de comunicare între proprietarii de site-uri și sistemele automate care indexează și analizează conținutul web. Fișierul trebuie să fie denumit exact “robots.txt” și să fie plasat în directorul rădăcină pentru a fi recunoscut de crawlerele web. Fără o configurare corespunzătoare a robots.txt, motoarele de căutare pot irosi bugetul de crawl pe pagini duplicate, conținut temporar sau resurse neesențiale, reducând în cele din urmă eficiența indexării paginilor importante. Acest lucru face din robots.txt o componentă esențială a SEO tehnic și a strategiei de management al site-ului.

Protocolul de excludere a roboților a fost propus pentru prima dată în 1994 ca un standard voluntar pentru crawlerele web de a respecta preferințele proprietarilor de site. Specificația originală a fost simplă, dar eficientă, permițând webmasterilor să comunice reguli de acces de bază fără sisteme complexe de autentificare. De-a lungul deceniilor, robots.txt a evoluat pentru a acomoda noi tipuri de crawlere, inclusiv roboți ai motoarelor de căutare, crawlere pentru social media și, mai recent, crawlere pentru antrenarea AI folosite de companii precum OpenAI, Anthropic și Perplexity. Protocolul a rămas în mare parte compatibil cu versiunile anterioare, asigurând ca site-urile create cu zeci de ani în urmă să funcționeze și cu crawlerele moderne.

Adoptarea robots.txt a crescut semnificativ în timp. Potrivit Web Almanac 2024, solicitări de succes pentru fișiere robots.txt au fost făcute pe 83,9% dintre site-uri la accesarea de pe mobil și 83,5% de pe desktop, față de 82,4% și 81,5% în 2022. Această tendință ascendentă reflectă conștientizarea tot mai mare a proprietarilor de site-uri privind importanța gestionării traficului crawlerelor. Cercetările privind site-urile de dezinformare au arătat o rată de adoptare de 96,4%, sugerând că robots.txt este acum considerat o practică standard în categorii variate de site-uri. Evoluția robots.txt continuă și astăzi, pe măsură ce proprietarii de site se confruntă cu noi provocări, cum ar fi blocarea roboților AI care pot să nu respecte directivele tradiționale robots.txt sau pot utiliza crawlere nedeclarate pentru a evita restricțiile.

Când un crawler web vizitează un site, verifică mai întâi dacă există fișierul robots.txt în directorul rădăcină înainte de a accesa alte pagini. Crawlerul citește fișierul și interpretează directivele pentru a determina ce URL-uri poate accesa. Acest proces are loc printr-o solicitare HTTP către domeniul rădăcină, iar serverul răspunde cu conținutul fișierului robots.txt. Crawlerul va parsa apoi fișierul conform propriei implementări a protocolului de excludere a roboților, care poate varia ușor între diferite motoare de căutare și tipuri de roboți. Această verificare inițială asigură că crawlerele respectă preferințele proprietarului site-ului înainte de a consuma resursele serverului.

Directiva user-agent este cheia pentru a viza crawlere specifice. Fiecare crawler are un identificator unic (string user-agent), precum “Googlebot” pentru crawlerul Google, “Bingbot” pentru Microsoft sau “GPTbot” pentru OpenAI. Proprietarii de site pot crea reguli pentru user-agents specifici sau pot folosi wildcard-ul “*” pentru a aplica reguli tuturor crawlerelor. Directiva disallow specifică ce URL-uri sau modele de URL nu pot fi accesate de crawler, iar directiva allow poate suprascrie regulile disallow pentru anumite pagini. Acest sistem ierarhic oferă un control granular asupra comportamentului crawlerelor, permițând proprietarilor de site să creeze modele complexe de acces care să optimizeze atât resursele serverului, cât și vizibilitatea în motoarele de căutare.

| Aspect | Robots.txt | Meta Robots Tag | X-Robots-Tag Header | Protecție prin parolă |

|---|---|---|---|---|

| Scop | La nivel de site sau director | La nivel de pagină individuală | La nivel de pagină sau resursă | Control la nivel de server |

| Implementare | Fișier text simplu în directorul rădăcină | Meta tag HTML în | Header la răspunsul HTTP | Autentificare server |

| Scop principal | Gestionarea traficului și bugetului de crawl | Controlul indexării și crawling-ului | Controlul indexării și crawling-ului | Prevenirea oricărui acces |

| Forță juridică | Voluntar (nu este obligatoriu legal) | Voluntar (nu este obligatoriu legal) | Voluntar (nu este obligatoriu legal) | Impus de server |

| Respectare de către roboți AI | Variabilă (unii roboți o ignoră) | Variabilă (unii roboți o ignoră) | Variabilă (unii roboți o ignoră) | Foarte eficientă |

| Impact în rezultate căutare | Pagina poate apărea fără descriere | Pagina exclusă din rezultate | Pagina exclusă din rezultate | Pagina ascunsă complet |

| Caz de utilizare optim | Optimizarea bugetului de crawl, gestionarea încărcării serverului | Prevenirea indexării unor pagini specifice | Prevenirea indexării unor resurse | Protejarea datelor sensibile |

| Ușurință de implementare | Ușor (fișier text) | Ușor (tag HTML) | Moderat (necesită configurare server) | Moderat spre complex |

Un fișier robots.txt folosește o sintaxă simplă pe care proprietarii de site o pot crea și edita cu orice editor de text. Structura de bază constă într-o linie user-agent urmată de una sau mai multe linii de directive. Cele mai des folosite directive sunt disallow (previne accesul crawlerelor la anumite URL-uri), allow (permite accesul la anumite URL-uri chiar dacă există o regulă disallow mai generală), crawl-delay (specifică cât timp ar trebui să aștepte un crawler între solicitări) și sitemap (direcționează crawlerele către locația sitemap-ului XML). Fiecare directivă trebuie să fie pe un rând separat, iar fișierul trebuie să fie formatat corect pentru a fi recunoscut de crawlere.

De exemplu, un fișier robots.txt de bază ar putea arăta astfel:

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /private/public-page.html

Sitemap: https://www.example.com/sitemap.xml

Această configurație le spune tuturor crawlerelor să evite directoarele /admin/ și /private/, dar permite accesul la pagina /private/public-page.html. Directiva sitemap ghidează crawlerele către sitemap-ul XML pentru indexare eficientă. Proprietarii de site pot crea mai multe blocuri user-agent pentru a aplica reguli diferite pentru crawlere diferite. De exemplu, un site poate permite Googlebot să acceseze tot conținutul, dar poate restricționa alte crawlere de la accesarea anumitor directoare. Directiva crawl-delay poate încetini crawlerele agresive, însă Googlebot nu recunoaște această comandă și folosește în schimb setările de viteză din Google Search Console.

Bugetul de crawl se referă la numărul de URL-uri pe care un motor de căutare le va accesa pe un site într-o anumită perioadă de timp. Pentru site-urile mari, cu milioane de pagini, bugetul de crawl este o resursă finită care trebuie gestionată strategic. Robots.txt joacă un rol crucial în optimizarea bugetului de crawl, prevenind crawlerele de la a irosi resurse pe conținut de valoare scăzută, precum pagini duplicate, fișiere temporare sau resurse neesențiale. Prin folosirea robots.txt pentru blocarea URL-urilor inutile, proprietarii de site pot asigura că motoarele de căutare își concentrează bugetul de crawl pe paginile importante care trebuie indexate și clasate. Acest aspect este deosebit de important pentru site-urile de comerț electronic, publicații de știri și alte site-uri de mari dimensiuni unde bugetul de crawl influențează direct vizibilitatea în căutări.

Ghidul oficial Google subliniază că robots.txt ar trebui folosit pentru a gestiona traficul de crawl și pentru a evita supraîncărcarea site-ului cu solicitări. Pentru site-urile mari, Google oferă recomandări specifice pentru gestionarea bugetului de crawl, inclusiv folosirea robots.txt pentru a bloca conținut duplicat, parametri de paginare și fișiere care nu sunt esențiale pentru randarea paginii. Proprietarii de site-uri ar trebui să evite blocarea fișierelor CSS, JavaScript sau a imaginilor esențiale pentru randarea paginilor, deoarece acest lucru poate împiedica Google să înțeleagă corect conținutul paginii. Utilizarea strategică a robots.txt, împreună cu alte practici SEO tehnice precum sitemap-urile XML și legăturile interne, creează un mediu de crawling eficient care maximizează valoarea bugetului de crawl disponibil.

Deși robots.txt este un instrument valoros pentru gestionarea comportamentului crawlerelor, are limitări semnificative pe care proprietarii de site trebuie să le cunoască. În primul rând, robots.txt nu este opozabil din punct de vedere legal și funcționează ca un protocol voluntar. Motoarele de căutare majore precum Google, Bing și Yahoo respectă directivele robots.txt, însă roboții rău intenționați și scrapperii pot alege să ignore complet fișierul. Astfel, robots.txt nu trebuie folosit ca mecanism de securitate pentru protejarea informațiilor sensibile. În al doilea rând, crawlerele interpretează diferit sintaxa robots.txt, ceea ce poate duce la comportamente inconsistente între platforme. Unele crawlere pot să nu înțeleagă anumite directive avansate sau pot interpreta modelele de URL diferit față de intenția proprietarului.

În al treilea rând, extrem de important pentru gestionarea web modernă, o pagină interzisă în robots.txt poate fi totuși indexată dacă este legată de alte site-uri. Conform documentației Google, dacă pagini externe fac legătură către URL-ul tău interzis folosind ancore descriptive, Google poate totuși să indexeze acel URL și să-l afișeze în rezultate fără descriere. Asta înseamnă că robots.txt singur nu poate preveni indexarea; el doar previne crawling-ul. Pentru a preveni corect indexarea, proprietarii de site trebuie să folosească metode alternative precum meta tag-ul noindex, header-e HTTP sau protecție prin parolă. De asemenea, cercetări recente au arătat că unele crawlere AI evită intenționat restricțiile robots.txt folosind stringuri user-agent nedeclarate, făcând robots.txt ineficient împotriva unor roboți de antrenare AI.

Ascensiunea modelelor lingvistice mari și a motoarelor de căutare bazate pe AI a generat noi provocări pentru managementul robots.txt. Companii precum OpenAI (GPTbot), Anthropic (Claude) și Perplexity au dezvoltat crawlere pentru antrenarea modelelor și alimentarea funcțiilor lor de căutare. Mulți proprietari de site au început să blocheze acești roboți AI folosind directive robots.txt. Cercetări realizate de Senior Search Scientist de la Moz arată că GPTbot este cel mai blocat robot, multe publicații de știri și creatori de conținut adăugând reguli disallow specifice crawlerelor AI. Totuși, eficiența robots.txt în blocarea roboților AI este discutabilă, deoarece unele companii AI au fost prinse folosind crawlere nedeclarate care nu se identifică corect.

Cloudflare a raportat că Perplexity folosea crawlere ascunse, nedeclarate pentru a evita directivele de interzicere a crawling-ului, demonstrând că nu toți roboții AI respectă regulile robots.txt. Acest lucru a dus la discuții constante în comunitatea SEO și de dezvoltare web despre dacă robots.txt este suficient pentru controlul accesului roboților AI. Unii proprietari de site-uri au implementat măsuri suplimentare, precum reguli WAF (Web Application Firewall) pentru a bloca adrese IP sau stringuri user-agent specifice. Situația evidențiază importanța monitorizării apariției site-ului tău în rezultatele de căutare AI și de a înțelege ce roboți accesează de fapt conținutul tău. Pentru site-urile preocupate de utilizarea conținutului pentru antrenarea AI, robots.txt ar trebui combinat cu alte măsuri tehnice și, eventual, acorduri legale cu companiile AI.

Crearea unui fișier robots.txt eficient necesită planificare atentă și mentenanță continuă. În primul rând, plasează fișierul robots.txt în directorul rădăcină al site-ului tău (de ex., www.example.com/robots.txt ) și asigură-te că este denumit exact “robots.txt” cu codare UTF-8 corectă. În al doilea rând, folosește reguli disallow clare și specifice care vizează doar conținutul pe care dorești să îl blochezi, evitând regulile prea restrictive care ar putea împiedica accesarea paginilor importante. În al treilea rând, include o directivă sitemap care să indice către sitemap-ul XML, ajutând crawlerele să descopere și să prioritizeze paginile importante. În al patrulea rând, testează fișierul robots.txt folosind instrumente precum Robots Testing Tool de la Google sau funcția Site Crawl din Moz Pro pentru a verifica dacă regulile tale funcționează conform așteptărilor.

Proprietarii de site-uri ar trebui să revizuiască și să actualizeze regulat fișierele robots.txt pe măsură ce structura site-ului se schimbă. Greșeli frecvente includ:

Monitorizarea regulată prin logurile serverului, Google Search Console și instrumente SEO ajută la identificarea rapidă a problemelor. Dacă observi că pagini importante nu sunt indexate sau accesate, verifică mai întâi fișierul robots.txt pentru a te asigura că nu le blochezi accidental. Platformele CMS precum WordPress sau Wix oferă interfețe integrate pentru gestionarea robots.txt, făcând mai ușoară implementarea pentru utilizatorii non-tehnici.

Viitorul robots.txt se confruntă cu provocări și oportunități pe măsură ce web-ul evoluează. Apariția crawelerelor AI și a roboților de antrenare a determinat discuții privind suficiența standardului actual robots.txt pentru nevoile moderne. Unii experți din industrie au propus îmbunătățiri ale protocolului de excludere a roboților pentru a aborda mai bine aspectele specifice AI, cum ar fi diferențierea între crawlerele folosite pentru indexare versus cele pentru colectarea de date pentru antrenare. Cercetările continue Web Almanac arată că adoptarea robots.txt continuă să crească, tot mai multe site-uri recunoscând importanța sa pentru gestionarea traficului crawlerelor și optimizarea resurselor serverului.

O altă tendință emergentă este integrarea managementului robots.txt în platforme de monitorizare SEO și instrumente de urmărire AI. Pe măsură ce companii precum AmICited urmăresc prezența brandului și a domeniului în motoarele de căutare AI, înțelegerea robots.txt devine tot mai importantă pentru controlul modului în care conținutul apare în răspunsuri generate de AI. Proprietarii de site-uri ar putea avea nevoie să implementeze strategii robots.txt mai sofisticate care să țină cont de mai multe tipuri de crawlere cu scopuri și niveluri de conformitate diferite. Posibila standardizare a identificării și comportamentului crawlerelor AI ar putea duce la implementări robots.txt mai eficiente în viitor. În plus, pe măsură ce preocupările privind confidențialitatea și dreptul de proprietate asupra conținutului devin mai importante, robots.txt ar putea evolua pentru a include controale mai detaliate asupra modului în care conținutul poate fi folosit de diverse tipuri de roboți și sisteme AI.

Pentru organizațiile care folosesc AmICited pentru a monitoriza aparițiile brandului și domeniului în motoarele de căutare AI, înțelegerea robots.txt este esențială. Configurarea robots.txt influențează direct ce crawlere AI pot accesa conținutul tău și modul în care acesta apare în răspunsuri generate de AI pe platforme precum ChatGPT, Perplexity, Google AI Overviews și Claude. Dacă blochezi anumiți roboți AI cu robots.txt, poți reduce vizibilitatea în rezultatele lor de căutare, ceea ce poate fi o alegere strategică în funcție de conținutul și obiectivele tale de business. Totuși, după cum am menționat mai devreme, unii roboți AI pot să nu respecte directivele robots.txt, deci monitorizarea apariției reale în răspunsurile AI este crucială.

Capabilitățile de monitorizare ale AmICited te ajută să înțelegi impactul real al configurației robots.txt asupra vizibilității în căutările AI. Urmărind unde apar URL-urile tale în răspunsuri generate de AI, poți evalua dacă strategia ta de gestionare a crawlerelor îți aduce rezultatele dorite. Dacă vrei să crești vizibilitatea în motoare de căutare AI specifice, poate fi nevoie să ajustezi robots.txt pentru a permite accesul crawlerelor respective. Dimpotrivă, dacă vrei să limitezi utilizarea conținutului tău pentru antrenare AI sau răspunsuri, poți implementa reguli robots.txt mai restrictive, deși ar trebui să le combini cu alte măsuri tehnice pentru eficiență sporită. Intersecția dintre managementul robots.txt și monitorizarea căutărilor AI reprezintă o nouă frontieră în marketingul digital și strategia SEO.

Scopul principal al unui fișier robots.txt este de a gestiona traficul crawlerelor și de a comunica cu roboții motoarelor de căutare despre care părți ale unui site pot fi accesate. Conform Google Search Central, robots.txt este utilizat în principal pentru a evita supraîncărcarea site-ului cu solicitări și pentru a gestiona alocarea bugetului de crawl. Ajută proprietarii de site-uri să direcționeze crawlerele către conținut valoros, evitând paginile duplicat sau irelevante, optimizând astfel resursele serverului și eficiența SEO.

Nu, robots.txt nu poate preveni în mod fiabil apariția paginilor în rezultatele Google Search. Conform documentației oficiale Google, dacă alte pagini fac legături către pagina ta cu text descriptiv, Google ar putea totuși să indexeze URL-ul fără a vizita pagina. Pentru a preveni corect indexarea, folosește metode alternative precum protecția prin parolă, meta tag-ul noindex sau header-ele HTTP. O pagină blocată prin robots.txt poate totuși să apară în rezultatele căutării fără descriere.

Robots.txt este un fișier la nivel de site care controlează accesul crawlerelor la directoare întregi sau la tot site-ul, în timp ce meta robots tags sunt directive HTML aplicate paginilor individuale. Robots.txt gestionează comportamentul de crawling, pe când meta robots tags (precum noindex) controlează indexarea. Ambele au scopuri diferite: robots.txt previne crawling-ul pentru a economisi resursele serverului, în timp ce meta robots tags previn indexarea chiar dacă pagina este accesată.

Poți bloca roboții AI adăugând numele lor specifice de user-agent în fișierul robots.txt cu directive de tip disallow. De exemplu, adăugarea 'User-agent: GPTbot' urmat de 'Disallow: /' va bloca robotul OpenAI să acceseze site-ul tău. Cercetările arată că GPTbot este cel mai blocat robot de către site-uri. Totuși, nu toți roboții AI respectă directivele robots.txt și unii pot folosi crawlere nedeclarate pentru a evita restricțiile, deci robots.txt singur nu garantează protecție deplină.

Cele cinci directive standard din robots.txt sunt: User-agent (specifică căror roboți li se aplică regula), Disallow (previne accesul crawlerelor la anumite fișiere sau directoare), Allow (suprascrie regulile disallow pentru anumite pagini), Crawl-delay (introduce întârzieri între solicitări) și Sitemap (direcționează crawlerele către locația sitemap-ului). Fiecare directivă are un rol specific în controlarea comportamentului roboților și optimizarea eficienței de crawling.

Nu, robots.txt nu este opozabil din punct de vedere legal. Funcționează ca un protocol voluntar bazat pe standardul de excludere a roboților. Majoritatea roboților „cumpătați” precum Googlebot și Bingbot respectă directivele robots.txt, însă roboții rău intenționați și scrapperii pot ignora complet fișierul. Pentru informații sensibile care trebuie protejate, folosește măsuri de securitate mai puternice, cum ar fi protecția prin parolă sau controale de acces la nivel de server, nu te baza doar pe robots.txt.

Conform Web Almanac 2024, solicitări de succes pentru fișierele robots.txt au fost făcute pe 83,9% dintre site-uri la accesarea de pe mobil și 83,5% de pe desktop, în creștere față de 82,4% și 81,5% în 2022. Cercetările privind site-urile de dezinformare au arătat o rată de adoptare de 96,4%, ceea ce indică faptul că robots.txt este un standard implementat pe scară largă în web. Acest lucru demonstrează importanța critică a robots.txt în managementul modern al site-urilor.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum să configurezi robots.txt pentru a controla accesul crawlerelor AI inclusiv GPTBot, ClaudeBot și Perplexity. Gestionează vizibilitatea brandului tău în...

Află cum să configurezi robots.txt pentru crawlere AI precum GPTBot, ClaudeBot și PerplexityBot. Înțelege categoriile de crawlere AI, strategiile de blocare și ...

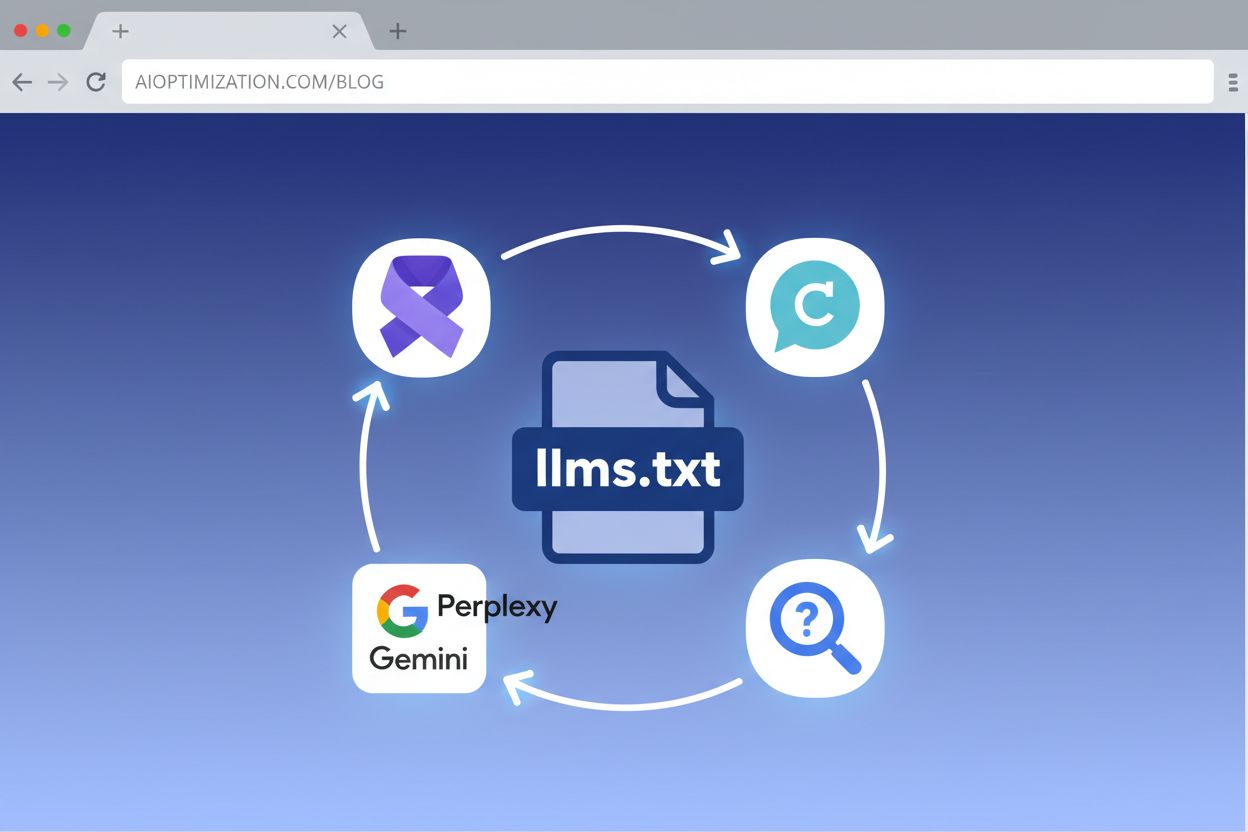

Învață cum să implementezi LLMs.txt pe site-ul tău pentru a ajuta sistemele AI să înțeleagă mai bine conținutul tău. Ghid complet pas cu pas pentru toate platfo...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.