AI tréningové prehľadávače vs. vyhľadávacie prehľadávače: Pochopenie rozdielu

Objavte zásadné rozdiely medzi AI tréningovými prehľadávačmi a vyhľadávacími prehľadávačmi. Zistite, ako ovplyvňujú viditeľnosť vášho obsahu, optimalizačné stra...

Pochopte, ako fungujú AI prehľadávače ako GPTBot a ClaudeBot, v čom sa líšia od tradičných prehľadávačov a ako optimalizovať svoj web pre viditeľnosť v AI vyhľadávaní.

AI prehľadávače sú automatizované programy navrhnuté na systematické prehliadanie internetu a zber dát z webstránok špeciálne na trénovanie a zlepšovanie modelov umelej inteligencie. Na rozdiel od tradičných vyhľadávacích prehľadávačov, ako je Googlebot, ktoré indexujú obsah pre vyhľadávacie výsledky, AI prehľadávače zhromažďujú surové webové dáta na použitie vo veľkých jazykových modeloch (LLM) ako ChatGPT, Claude a ďalšie AI systémy. Tieto boty nepretržite operujú na miliónoch webov, sťahujú stránky, analyzujú obsah a extrahujú informácie, ktoré pomáhajú AI platformám pochopiť jazykové vzory, faktické informácie a rôzne štýly písania. Medzi hlavné subjekty v tejto oblasti patria GPTBot od OpenAI, ClaudeBot od Anthropicu, Meta-ExternalAgent od Meta, Amazonbot od Amazonu a PerplexityBot od Perplexity.ai, pričom každý slúži na trénovanie a prevádzkové potreby vlastnej AI platformy. Pochopenie fungovania týchto prehľadávačov sa stalo nevyhnutnosťou pre majiteľov webov a tvorcov obsahu, pretože AI viditeľnosť teraz priamo ovplyvňuje, ako sa vaša značka zobrazuje vo vyhľadávacích výsledkoch a odporúčaniach poháňaných umelou inteligenciou.

Prostredie webového prehľadávania za posledný rok prešlo dramatickou premenou: AI prehľadávače zažívajú explozívny rast, zatiaľ čo tradičné vyhľadávacie prehľadávače si udržiavajú stabilné vzory. Medzi májom 2024 a májom 2025 vzrástla celková návštevnosť prehľadávačov o 18%, no rozdelenie sa výrazne zmenilo—GPTBot vzrástol o 305% v počte požiadaviek, zatiaľ čo iné prehľadávače ako ClaudeBot klesli o 46% a Bytespider až o 85%. Toto preusporiadanie odráža zintenzívňujúcu sa konkurenciu medzi AI spoločnosťami o získanie trénovacích dát a zlepšenie svojich modelov. Tu je podrobný prehľad hlavných prehľadávačov a ich aktuálnej trhovej pozície:

| Názov prehľadávača | Spoločnosť | Mesačné požiadavky | Medziročný rast | Primárny účel |

|---|---|---|---|---|

| Googlebot | 4,5 miliardy | 96% | Indexácia vyhľadávania & AI prehľady | |

| GPTBot | OpenAI | 569 miliónov | 305% | Tréning modelu ChatGPT & vyhľadávanie |

| Claude | Anthropic | 370 miliónov | -46% | Tréning Claude modelu & vyhľadávanie |

| Bingbot | Microsoft | ~450 miliónov | 2% | Indexácia vyhľadávania |

| PerplexityBot | Perplexity.ai | 24,4 milióna | 157 490% | AI indexácia vyhľadávania |

| Meta-ExternalAgent | Meta | ~380 miliónov | Nový hráč | Tréning Meta AI |

| Amazonbot | Amazon | ~210 miliónov | -35% | Vyhľadávanie & AI aplikácie |

Dáta ukazujú, že kým Googlebot si udržiava dominanciu so 4,5 miliardami mesačných požiadaviek, AI prehľadávače spoločne predstavujú približne 28% objemu Googlebotu, čo z nich robí významnú silu v rámci webovej návštevnosti. Explozívny rast PerplexityBotu (157 490% nárast) demonštruje, akou rýchlosťou nové AI platformy škálujú svoje prehľadávacie operácie, zatiaľ čo pokles niektorých etablovaných AI prehľadávačov naznačuje konsolidáciu trhu okolo najúspešnejších AI platforiem.

GPTBot je webový prehľadávač spoločnosti OpenAI, špeciálne navrhnutý na zber dát pre trénovanie a zlepšovanie ChatGPT a ďalších modelov OpenAI. Spustený ako relatívne malý hráč s len 5% podielom na trhu v máji 2024, GPTBot sa stal dominantným AI prehľadávačom, ktorý do mája 2025 zachytáva 30% celej AI prehľadávacej návštevnosti—čo predstavuje pozoruhodný 305% nárast požiadaviek. Tento explozívny rast odráža agresívnu stratégiu OpenAI zabezpečiť, aby ChatGPT mal prístup k čerstvému, rozmanitému webovému obsahu na trénovanie modelu aj na vyhľadávanie v reálnom čase cez ChatGPT Search. GPTBot operuje so špecifickým prehľadávacím vzorom, uprednostňuje HTML obsah (57,70% požiadaviek), no zároveň sťahuje aj JavaScript súbory a obrázky, hoci JavaScript na vykreslenie dynamického obsahu nespúšťa. Správanie prehľadávača ukazuje, že často naráža na chyby 404 (34,82% požiadaviek), čo naznačuje, že môže nasledovať zastarané odkazy alebo sa pokúša pristupovať k zdrojom, ktoré už neexistujú. Pre majiteľov webstránok dominancia GPTBotu znamená, že zabezpečiť prístupnosť obsahu tomuto prehľadávaču je kľúčové pre viditeľnosť vo vyhľadávacích funkciách ChatGPT a pre potenciálne zahrnutie do budúcich tréningových iterácií modelu.

ClaudeBot, vyvinutý spoločnosťou Anthropic, slúži ako hlavný prehľadávač na trénovanie a aktualizáciu AI asistenta Claude, ako aj na podporu vyhľadávacích a podkladových schopností Claude. Kedysi druhý najväčší AI prehľadávač s 27% podielom na trhu v máji 2024, ClaudeBot zaznamenal výrazný pokles na 21% v máji 2025, pričom požiadavky medziročne klesli o 46%. Tento pokles nemusí nutne naznačovať problém v stratégii Anthropicu, ale skôr odráža širší trhový posun smerom k dominancii OpenAI a nástupu nových konkurentov ako Meta-ExternalAgent. ClaudeBot vykazuje podobné správanie ako GPTBot, uprednostňuje HTML obsah, ale venuje väčšie percento požiadaviek obrázkom (35,17% požiadaviek), čo naznačuje, že Anthropic môže trénovať Claude aj na lepšie pochopenie vizuálneho obsahu. Rovnako ako iné AI prehľadávače, ClaudeBot nevykresľuje JavaScript, takže vidí iba surový HTML stránok bez dynamicky načítaného obsahu. Pre tvorcov obsahu zostáva udržiavanie viditeľnosti pre ClaudeBot dôležité, aby Claude mal prístup k vášmu obsahu a mohol ho citovať, najmä keď Anthropic ďalej rozvíja vyhľadávacie a argumentačné schopnosti Claude.

Okrem GPTBotu a ClaudeBotu aktívne zhromažďuje webové dáta pre svoje platformy aj niekoľko ďalších významných AI prehľadávačov:

Meta-ExternalAgent (Meta): Prehľadávač spoločnosti Meta dramaticky vstúpil do rebríčkov, keď v máji 2025 získal 19% podiel na trhu ako nový hráč. Tento bot zhromažďuje dáta pre AI iniciatívy Meta, vrátane možného tréningu pre Meta AI a integrácie s AI funkciami Instagramu a Facebooku. Rýchly nástup naznačuje, že spoločnosť Meta sa vážne púšťa do AI vyhľadávania a odporúčaní.

PerplexityBot (Perplexity.ai): Aj keď má len 0,2% podiel na trhu, PerplexityBot zaznamenal najexplozívnejší rast s 157 490% medziročným nárastom. To odráža rýchle škálovanie Perplexity ako AI odpoveďového enginu, ktorý sa spolieha na vyhľadávanie v reálnom čase pri tvorbe odpovedí. Pre weby návštevy PerplexityBotu predstavujú priamu príležitosť byť citovaný v AI-generovaných odpovediach tejto platformy.

Amazonbot (Amazon): Prehľadávač Amazonu klesol z 21% na 11% podiel na trhu, pričom požiadavky medziročne klesli o 35%. Amazonbot zhromažďuje dáta pre vyhľadávacie funkcie a AI aplikácie Amazonu, no jeho klesajúci podiel naznačuje, že Amazon možno mení AI stratégiu alebo konsoliduje prehľadávacie operácie.

Applebot (Apple): Prehľadávač Apple zaznamenal 26% pokles požiadaviek, z 1,9% na 1,2% podiel na trhu. Applebot slúži najmä Siri a vyhľadávaniu Spotlight, no môže podporovať aj nové AI iniciatívy Apple. Na rozdiel od väčšiny AI prehľadávačov Applebot dokáže vykresľovať JavaScript, čo mu dáva podobné schopnosti ako Googlebotu.

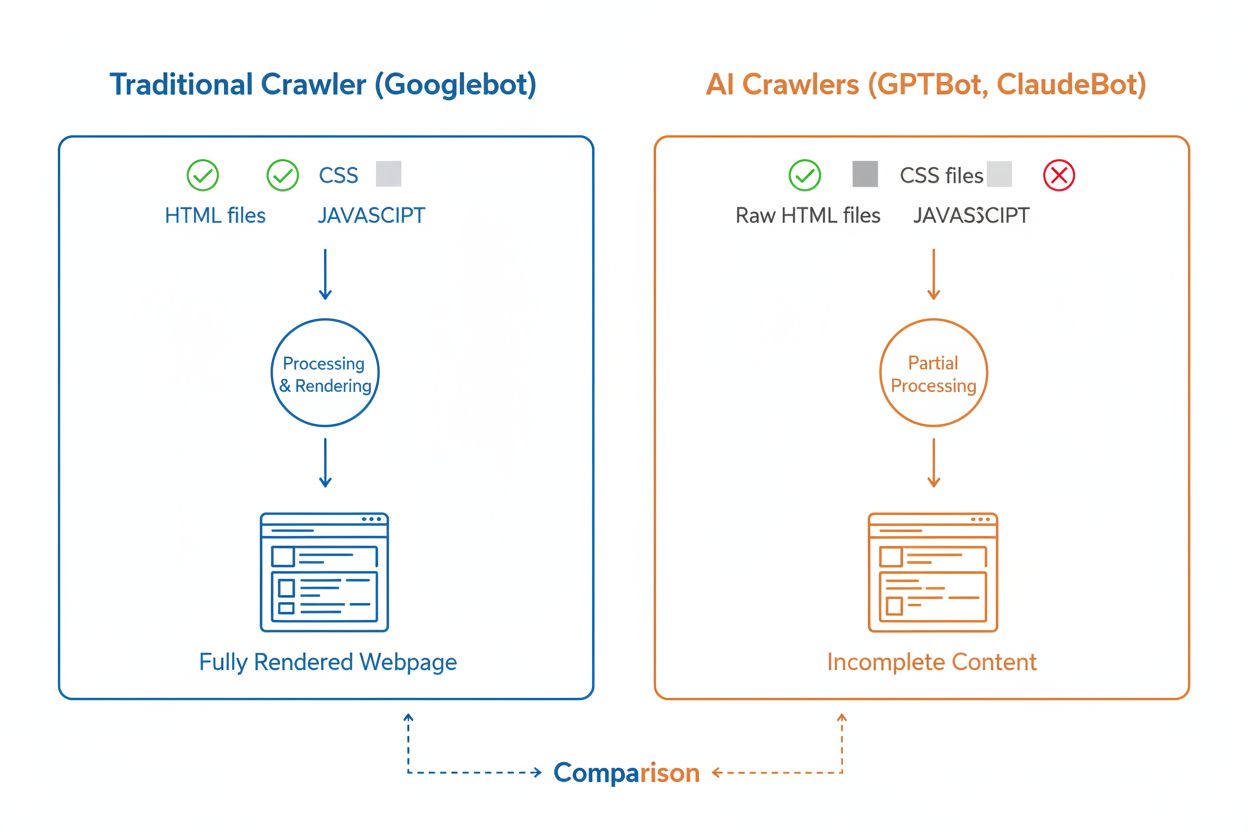

Aj keď AI prehľadávače a tradičné vyhľadávacie prehľadávače ako Googlebot systematicky prechádzajú web, ich technické schopnosti a správanie sa výrazne líšia spôsobom, ktorý priamo ovplyvňuje, ako je váš obsah objavený a pochopený. Najzásadnejším rozdielom je vykresľovanie JavaScriptu: Googlebot dokáže po stiahnutí stránky spustiť JavaScript, vďaka čomu vidí dynamicky načítaný obsah, zatiaľ čo väčšina AI prehľadávačov (GPTBot, ClaudeBot, Meta-ExternalAgent, Bytespider) číta iba surový HTML a ignoruje akýkoľvek obsah závislý na JavaScripte. To znamená, že ak sa váš web spolieha na client-side rendering na zobrazovanie dôležitých informácií, AI prehľadávače uvidia neúplnú verziu vašich stránok. Okrem toho AI prehľadávače vykazujú menej predvídateľné prehľadávacie vzory v porovnaní so systematickým prístupom Googlebotu—trávia 34,82% požiadaviek na stránkach 404 a 14,36% na presmerovaniach, zatiaľ čo Googlebot efektívnejšie spravuje 8,22% na 404 a 1,49% na presmerovaniach. Rôzna je aj frekvencia prehľadávania: kým Googlebot navštevuje stránky podľa prepracovaného systému prehľadávacieho rozpočtu, AI prehľadávače sa zdajú prehľadávať častejšie, ale menej systematicky, pričom niektoré výskumy ukazujú, že AI prehľadávače môžu navštíviť stránky aj viac ako 100-krát častejšie ako Google v niektorých prípadoch. Tieto rozdiely znamenajú, že tradičné SEO optimalizačné stratégie nemusia úplne riešiť AI prehľadávateľnosť a vyžadujú osobitý prístup zameraný na server-side rendering a čistú štruktúru URL.

Jednou z najvýznamnejších technických výziev pre AI prehľadávače je ich neschopnosť vykresľovať JavaScript, čo je dôsledok výpočtovej náročnosti spúšťania JavaScriptu v masovom meradle potrebnom na trénovanie veľkých jazykových modelov. Keď prehľadávač stiahne vašu stránku, dostane úvodnú HTML odpoveď, ale akýkoľvek obsah načítaný alebo pozmenený JavaScriptom—ako sú detaily produktov, ceny, recenzie používateľov či dynamická navigácia—zostáva pre AI prehľadávače neviditeľný. To je kritickým problémom pre moderné weby, ktoré sa silno spoliehajú na client-side rendering frameworky ako React, Vue alebo Angular bez server-side renderingu (SSR) alebo statickej generácie stránok (SSG). Napríklad e-shop, ktorý načítava produktové informácie cez JavaScript, sa AI prehľadávačom javí ako prázdna stránka bez detailov produktov, čo znemožňuje AI systémom tento obsah pochopiť alebo citovať. Riešením je zabezpečiť, aby bol všetok dôležitý obsah servírovaný už v počiatočnej HTML odpovedi cez server-side rendering, ktorý vygeneruje kompletný HTML na serveri ešte pred odoslaním do prehliadača. Tento prístup zabezpečí, že ľudskí návštevníci aj AI prehľadávače dostanú rovnaký obsahovo bohatý zážitok. Weby využívajúce moderné frameworky ako Next.js s SSR, statické generátory ako Hugo či Gatsby alebo klasické serverové platformy ako WordPress sú prirodzene AI-prehľadávačom priateľské, zatiaľ čo tie závislé výhradne od client-side renderingu čelia výrazným problémom s viditeľnosťou v AI vyhľadávaní.

AI prehľadávače vykazujú odlišné vzory frekvencie prehľadávania v porovnaní so správaním Googlebotu, čo má dôležité dôsledky na to, ako rýchlo sa váš obsah dostane do AI systémov. Výskumy ukazujú, že AI prehľadávače ako ChatGPT a Perplexity často krátkodobo po publikovaní navštevujú stránky častejšie ako Google—niekedy až 8-krát častejšie ako Googlebot v priebehu prvých dní. Toto rýchle úvodné prehľadávanie naznačuje, že AI platformy kladú dôraz na rýchle objavenie a indexáciu nového obsahu, pravdepodobne aby ich modely a vyhľadávacie funkcie mali prístup k najnovším informáciám. Po tomto agresívnom úvodnom prehľadávaní však nasleduje vzor, kde sa AI prehľadávače nemusia vrátiť, ak obsah nespĺňa kvalitatívne štandardy, čo robí prvý dojem rozhodujúcim. Na rozdiel od Googlebotu, ktorý má prepracovaný systém prehľadávacieho rozpočtu a vracia sa pravidelne na stránky podľa frekvencie aktualizácie a dôležitosti, AI prehľadávače akoby robili rozhodnutie, či sa oplatí na stránku vrátiť. To znamená, že ak AI prehľadávač navštívi vašu stránku a nájde slabý obsah, technické chyby alebo zlé používateľské signály, môže trvať veľmi dlho, kým sa vráti—ak vôbec. Pre tvorcov obsahu je teda jasné: na rozdiel od tradičných vyhľadávačov sa nemôžete spoliehať na druhú šancu optimalizovať obsah pre AI prehľadávače, takže kontrola kvality pred publikovaním je nevyhnutná.

Majitelia webstránok môžu pomocou súboru robots.txt komunikovať svoje preferencie ohľadom prístupu AI prehľadávačov, no účinnosť a vynucovanie týchto pravidiel sa medzi prehľadávačmi výrazne líši. Podľa aktuálnych dát má približne 14% z top 10 000 webov špecifické pravidlá povolenia alebo zákazu pre AI boty vo svojom robots.txt. GPTBot je najčastejšie blokovaný prehľadávač, pričom 312 domén (250 úplne, 62 čiastočne) ho explicitne zakazuje, no zároveň je aj najčastejšie explicitne povolený s 61 doménami, ktoré mu udeľujú prístup. Medzi ďalšie často blokované prehľadávače patria CCBot (Common Crawl) a Google-Extended (token pre AI tréning Google). Výzvou pri robots.txt je, že jeho dodržiavanie je dobrovoľné—prehľadávače rešpektujú tieto pravidlá len ak sa to ich prevádzkovatelia rozhodnú implementovať a niektoré novšie či menej transparentné prehľadávače môžu direktívy robots.txt úplne ignorovať. Navyše, robots.txt tokeny ako “Google-Extended” priamo nezodpovedajú user-agent reťazcom v HTTP požiadavkách; namiesto toho signalizujú účel prehľadávania, takže nemôžete vždy overiť dodržiavanie cez serverové logy. Na silnejšie vynútenie preto majitelia webov čoraz častejšie siahajú po pravidlách firewallu a webových aplikačných firewalloch (WAF), ktoré dokážu aktívne blokovať konkrétne user-agenty, čím poskytujú spoľahlivejšiu kontrolu než samotný robots.txt. Tento posun k aktívnym blokovacím mechanizmom odráža rastúce obavy o práva k obsahu a snahu o lepšie vynútiteľnú kontrolu nad prístupom AI prehľadávačov.

Sledovanie aktivity AI prehľadávačov na vašom webe je nevyhnutné na pochopenie vašej viditeľnosti v AI vyhľadávaní, no predstavuje unikátne výzvy oproti sledovaniu tradičných vyhľadávacích prehľadávačov. Tradičné analytické nástroje ako Google Analytics sa spoliehajú na JavaScript tracking, ktorý AI prehľadávače nespúšťajú, takže tieto nástroje neposkytujú žiadny prehľad o návštevách AI botov. Rovnako nefunguje ani pixel tracking, pretože väčšina AI prehľadávačov spracováva iba text a obrázky ignoruje. Jediný spoľahlivý spôsob, ako sledovať aktivitu AI prehľadávačov, je serverové monitorovanie—analýza HTTP hlavičiek požiadaviek a serverových logov na identifikáciu user-agentov ešte pred odoslaním stránky. To si vyžaduje buď manuálnu analýzu logov, alebo špecializované nástroje určené na sledovanie AI prehľadávacej návštevnosti. Monitorovanie v reálnom čase je obzvlášť dôležité, pretože AI prehľadávače operujú v nepredvídateľných intervaloch a nemusia sa vrátiť na stránky, ak narazia na problémy, takže týždenný či mesačný audit nemusí zachytiť zásadné nedostatky. Ak AI prehľadávač navštívi váš web a nájde technickú chybu alebo slabú kvalitu obsahu, nemusíte dostať ďalšiu šancu zanechať dobrý dojem. Implementácia 24/7 monitorovacích riešení, ktoré vás okamžite upozornia, keď AI prehľadávače narazia na problémy—napríklad 404 chyby, pomalé načítanie alebo chýbajúce schéma značkovanie—vám umožňuje riešiť problémy skôr, než ovplyvnia vašu AI vyhľadávaciu viditeľnosť. Tento prístup v reálnom čase predstavuje zásadný posun oproti tradičným SEO monitorovacím praktikám a odráža rýchlosť a nepredvídateľnosť správania AI prehľadávačov.

Optimalizácia webu pre AI prehľadávače si vyžaduje iný prístup než tradičné SEO, so zameraním na technické faktory, ktoré priamo ovplyvňujú, ako AI systémy dokážu pristupovať k vášmu obsahu a pochopiť ho. Prvou prioritou je server-side rendering: uistite sa, že všetok dôležitý obsah—nadpisy, hlavný text, meta dáta, štruktúrované dáta—je zahrnutý už v počiatočnej HTML odpovedi, nie dynamicky načítaný cez JavaScript. Platí to pre vašu homepage, kľúčové vstupné stránky a akýkoľvek obsah, ktorý chcete, aby AI systémy citovali alebo referovali. Po druhé, implementujte na najdôležitejších stránkach štruktúrované dáta (Schema.org), vrátane schémy článku pre blogy, schémy produktu pre e-shopy a schémy autora na preukázanie odbornosti a autority. AI prehľadávače využívajú štruktúrované dáta na rýchle pochopenie hierarchie a kontextu obsahu, čím im výrazne uľahčíte parsovanie a citovanie vašich informácií. Po tretie, udržiavajte vysokú kvalitu obsahu na všetkých stránkach, keďže AI prehľadávače zjavne rýchlo hodnotia, či je obsah hodný indexovania a citovania. Znamená to zabezpečiť originalitu, kvalitný výskum, faktickú presnosť a skutočnú hodnotu pre čitateľa. Po štvrté, sledujte a optimalizujte Core Web Vitals a celkový výkon stránky, keďže pomalé načítanie signalizuje zlý používateľský zážitok a môže odradiť AI prehľadávače od návratu. Nakoniec udržiavajte čistú a konzistentnú štruktúru URL, aktualizujte XML sitemapu a správne nastavte robots.txt, aby ste nasmerovali prehľadávače na váš najdôležitejší obsah. Tieto technické optimalizácie vytvárajú základ, vďaka ktorému je váš obsah objaviteľný, pochopiteľný a citovateľný AI systémami.

Prostredie AI prehľadávačov sa bude naďalej rýchlo vyvíjať s rastúcou konkurenciou medzi AI spoločnosťami a s postupným dozrievaním technológií. Jedným z jasných trendov je konsolidácia trhového podielu okolo najúspešnejších platforiem—GPTBot od OpenAI sa stal dominantnou silou, zatiaľ čo noví hráči ako Meta-ExternalAgent rýchlo škálujú, čo naznačuje, že trh sa pravdepodobne stabilizuje okolo niekoľkých veľkých hráčov. S dozrievaním AI prehľadávačov môžeme očakávať zlepšenia v ich technických schopnostiach, najmä v oblasti vykresľovania JavaScriptu a efektívnejších prehľadávacích vzorov, ktoré znížia plytvanie požiadavkami na 404 stránkach a zastaranom obsahu. Odvetvie sa tiež posúva k štandardizovanejším komunikačným protokolom, ako je vznikajúca špecifikácia llms.txt, ktorá umožňuje webom explicitne komunikovať svoju štruktúru a preferencie pre AI prehľadávače. Okrem toho sa mechanizmy na vynucovanie kontroly prístupu AI prehľadávačov stávajú sofistikovanejšími: platformy ako Cloudflare už ponúkajú automatizované blokovanie AI tréningových botov predvolene, čo dáva majiteľom webov detailnejšiu kontrolu nad ich obsahom. Pre tvorcov obsahu a majiteľov webstránok znamená držať krok s týmito zmenami neustále monitorovať aktivitu AI prehľadávačov, udržiavať technickú infraštruktúru optimalizovanú pre AI prístupnosť a prispôsobovať obsahovú stratégiu realite, že AI systémy dnes predstavujú významnú časť návštevnosti vášho webu a kľúčový kanál pre viditeľnosť značky. Budúcnosť patrí tým, ktorí pochopia a optimalizujú pre tento nový ekosystém prehľadávačov.

AI prehľadávače sú automatizované programy, ktoré zhromažďujú webové dáta špecificky na trénovanie a zlepšovanie modelov umelej inteligencie, ako sú ChatGPT a Claude. Na rozdiel od tradičných prehľadávačov vyhľadávačov, ako je Googlebot, ktoré indexujú obsah pre výsledky vyhľadávania, AI prehľadávače zhromažďujú surové webové dáta na použitie vo veľkých jazykových modeloch. Oba typy prehľadávačov systematicky prechádzajú internet, ale slúžia na iné účely a majú odlišné technické schopnosti.

AI prehľadávače pristupujú na váš web, aby zhromažďovali dáta pre tréning AI modelov, zlepšovali vyhľadávacie funkcie a podkladali AI odpovede aktuálnymi informáciami. Keď AI systémy ako ChatGPT alebo Perplexity odpovedajú na otázky používateľov, často potrebujú načítať váš obsah v reálnom čase, aby poskytli presné a citované informácie. Umožnenie prístupu AI prehľadávačom na váš web zvyšuje šancu, že vaša značka bude spomenutá a citovaná v AI-generovaných odpovediach.

Áno, môžete použiť súbor robots.txt na zakázanie konkrétnych AI prehľadávačov špecifikovaním ich user-agent názvov. Avšak dodržiavanie robots.txt je dobrovoľné a nie všetky prehľadávače tieto pravidlá rešpektujú. Na silnejšie vynútenie môžete použiť pravidlá firewallu a Web Application Firewall (WAF), aby ste aktívne blokovali konkrétne user-agenty prehľadávačov. To vám dáva spoľahlivejšiu kontrolu nad tým, ktoré AI prehľadávače majú prístup k vášmu obsahu.

Nie, väčšina AI prehľadávačov (GPTBot, ClaudeBot, Meta-ExternalAgent) nevykonáva JavaScript. Čítajú iba surový HTML vašich stránok, čo znamená, že akýkoľvek obsah načítaný dynamicky cez JavaScript je pre nich neviditeľný. Preto je server-side rendering kľúčový pre prehľadateľnosť AI. Ak váš web spolieha na client-side rendering, AI prehľadávače uvidia neúplnú verziu vašich stránok.

AI prehľadávače navštevujú webstránky krátkodobo po publikovaní obsahu častejšie ako tradičné vyhľadávače. Výskum ukazuje, že môžu navštíviť stránky 8-100 krát častejšie ako Google v priebehu prvých dní. Ak však obsah nespĺňa kvalitatívne štandardy, nemusia sa vrátiť. Prvý dojem je preto kľúčový—nemusíte dostať druhú šancu optimalizovať obsah pre AI prehľadávače.

Kľúčové optimalizácie sú: (1) Používajte server-side rendering, aby bol dôležitý obsah v úvodnom HTML, (2) Pridajte štruktúrované dáta (Schema), aby AI lepšie pochopila váš obsah, (3) Udržiavajte vysokú kvalitu a aktuálnosť obsahu, (4) Sledujte Core Web Vitals pre dobrú používateľskú skúsenosť a (5) Majte čistú štruktúru URL a aktualizovanú sitemapu. Tieto technické optimalizácie vytvárajú základ, ktorý robí váš obsah objaviteľným a citovateľným AI systémami.

GPTBot od OpenAI je momentálne dominantný AI prehľadávač, ktorý zachytáva 30% všetkej AI prehľadávačovej návštevnosti a medziročne rastie o 305%. Mali by ste však optimalizovať pre všetky hlavné prehľadávače vrátane ClaudeBot (Anthropic), Meta-ExternalAgent (Meta), PerplexityBot (Perplexity) a ďalších. Rôzne AI platformy majú rôzne používateľské základne, takže viditeľnosť naprieč viacerými prehľadávačmi maximalizuje prítomnosť vašej značky v AI vyhľadávaní.

Tradičné analytické nástroje ako Google Analytics nezachytia aktivitu AI prehľadávačov, pretože sa spoliehajú na JavaScript tracking. Namiesto toho potrebujete serverové monitorovanie, ktoré analyzuje HTTP hlavičky požiadaviek a serverové logy na identifikáciu user-agentov prehľadávačov. Špecializované nástroje určené na sledovanie AI prehľadávačov poskytujú prehľad v reálnom čase o tom, ktoré stránky sú prehľadávané, ako často a či prehľadávače narážajú na technické problémy.

Sledujte, ako AI prehľadávače ako GPTBot a ClaudeBot pristupujú k vášmu obsahu a citujú ho. Získajte prehľad v reálnom čase o svojej AI vyhľadávacej viditeľnosti s AmICited.

Objavte zásadné rozdiely medzi AI tréningovými prehľadávačmi a vyhľadávacími prehľadávačmi. Zistite, ako ovplyvňujú viditeľnosť vášho obsahu, optimalizačné stra...

Zistite, ako AI vyhľadávacie prehľadávače určujú frekvenciu prehľadávania vašej webovej stránky. Objavte, ako ChatGPT, Perplexity a iné AI motory prehľadávajú o...

Diagnostikujte problémy s prehľadávaním AI pomocou serverových logov, identifikácie používateľských agentov a technických opráv. Monitorujte prehľadávače ChatGP...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.