Ako nakonfigurovať robots.txt pre AI crawlerov: Kompletný sprievodca

Zistite, ako nakonfigurovať robots.txt pre kontrolu prístupu AI crawlerov vrátane GPTBot, ClaudeBot a Perplexity. Spravujte viditeľnosť svojej značky v AI-gener...

Konfigurácia robots.txt so špecifickými pravidlami pre AI crawlerov. AI-špecifický robots.txt umožňuje vlastníkom webstránok kontrolovať, ako umelé inteligencie, veľké jazykové modely a tréningové AI boty pristupujú k a používajú ich obsah. Rozlišuje medzi rôznymi typmi AI crawlerov—tréningové crawlery, vyhľadávacie crawlery a crawlery spustené používateľom—čo umožňuje detailnú kontrolu nad viditeľnosťou obsahu pre AI systémy. Táto konfigurácia je kľúčová, keďže AI crawlery dnes tvoria približne 80 % bot trafficu na mnohých webstránkach.

Konfigurácia robots.txt so špecifickými pravidlami pre AI crawlerov. AI-špecifický robots.txt umožňuje vlastníkom webstránok kontrolovať, ako umelé inteligencie, veľké jazykové modely a tréningové AI boty pristupujú k a používajú ich obsah. Rozlišuje medzi rôznymi typmi AI crawlerov—tréningové crawlery, vyhľadávacie crawlery a crawlery spustené používateľom—čo umožňuje detailnú kontrolu nad viditeľnosťou obsahu pre AI systémy. Táto konfigurácia je kľúčová, keďže AI crawlery dnes tvoria približne 80 % bot trafficu na mnohých webstránkach.

AI-špecifická konfigurácia robots.txt označuje prax vytvárania cielených pravidiel v súbore robots.txt, ktoré špecificky reagujú na crawlery umelej inteligencie a tréningové boty, na rozdiel od tradičných vyhľadávacích crawlerov ako Googlebot. Kým bežné robots.txt sa historicky zameriavalo na správu Googlebot, Bingbot a ďalších indexátorov, vzostup veľkých jazykových modelov a AI tréningových systémov vytvoril úplne novú kategóriu botov, ktorá si vyžaduje samostatné stratégie správy. Podľa údajov z novembra 2025 AI crawlery tvoria približne 80 % všetkej bot návštevnosti na mnohých vydavateľských webstránkach, čo zásadne mení význam konfigurácie robots.txt zo SEO nástroja na kritický mechanizmus ochrany obsahu. Tento rozdiel je dôležitý, pretože tréningové AI crawlery fungujú na inom obchodnom modeli než vyhľadávače—zbierajú dáta na tréning vlastných modelov, nie na generovanie návštevnosti—takže tradičný kompromis medzi povolením crawlerov výmenou za viditeľnosť vo vyhľadávaní už neplatí. Pre vydavateľov to znamená, že rozhodnutia v robots.txt priamo ovplyvňujú viditeľnosť obsahu pre AI systémy, možnosť neautorizovaného použitia obsahu v tréningových datasetoch a celkový dopad na návštevnosť a výnosy v prostredí AI objavovania.

AI crawlery spadajú do troch samostatných prevádzkových kategórií, z ktorých každá má odlišné vlastnosti, dôsledky na návštevnosť a strategické úvahy pre vydavateľov. Tréningové crawlery zbierajú veľké objemy textových dát pre vývoj strojového učenia; obvykle majú vysoké nároky na šírku pásma, generujú významnú záťaž na server a neposkytujú žiadnu referral návštevnosť—príkladom sú GPTBot od OpenAI a ClaudeBot od Anthropic. Vyhľadávacie a citačné crawlery fungujú podobne ako tradičné vyhľadávače, indexujú obsah na účely vyhľadávania a poskytujú atribúciu; generujú stredný objem návštevnosti a môžu poskytnúť referral návštevnosť cez citácie a odkazy—do tejto kategórie patrí OAI-SearchBot od OpenAI a crawler Google AI Overviews. Crawlery spustené používateľom fungujú na požiadanie, keď koncový používateľ výslovne žiada AI analýzu stránky, napríklad prehliadanie webu cez ChatGPT alebo funkcie analýzy dokumentov v Claude; tieto generujú nižší objem návštevnosti, ale predstavujú priamu interakciu používateľa s vaším obsahom. Toto rozdelenie je strategicky dôležité, pretože tréningové crawlery predstavujú najvyššie riziko ochrany obsahu s minimálnym obchodným prínosom, vyhľadávacie crawlery ponúkajú kompromis so šancou na referral návštevnosť a crawlery spustené používateľom sa zvyčajne zhodujú so záujmom používateľa a môžu zvýšiť viditeľnosť.

| Kategória crawlera | Účel | Objem návštevnosti | Referral potenciál | Riziko pre obsah | Príklady |

|---|---|---|---|---|---|

| Tréningové | Vývoj modelu | Veľmi vysoký | Žiadny | Veľmi vysoké | GPTBot, ClaudeBot |

| Vyhľadávacie/Citačné | Indexácia & atribúcia obsahu | Stredný | Stredný | Stredné | OAI-SearchBot, Google AI |

| Spustené používateľom | Analýza na požiadanie | Nízky | Nízky | Nízke | ChatGPT Web Browse, Claude |

Hlavné AI spoločnosti prevádzkujúce crawlery zahŕňajú OpenAI, Anthropic, Google, Meta, Apple a Amazon, pričom každá má vlastné user-agent reťazce umožňujúce identifikáciu v serverových logoch a konfigurácii robots.txt. OpenAI prevádzkuje viacero crawlerov: GPTBot (user-agent: GPTBot/1.0) na zber tréningových dát, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) na indexáciu a citácie a ChatGPT-User (user-agent: ChatGPT-User/1.0) na prehliadanie webu spustené používateľom. Hlavný crawler Anthropic je ClaudeBot (user-agent: Claude-Web/1.0 alebo anthropic-ai) využívaný na tréning a vývoj znalostnej bázy. Google prevádzkuje Google-Extended (user-agent: Google-Extended/1.1) pre Gemini a ďalšie AI produkty, Meta používa facebookexternalhit na analýzu obsahu, Apple prevádzkuje AppleBot pre Siri a vyhľadávací systém a Amazon používa Amazonbot pre Alexa a vyhľadávacie funkcie. Na identifikáciu týchto crawlerov v logoch servera skúmajte User-Agent hlavičku v HTTP požiadavkách—väčšina legitímnych AI crawlerov obsahuje názov firmy a číslo verzie v tomto poli. Pre zvýšenú bezpečnosť môžete overiť legitímnosť crawlera kontrolou IP adresy požiadavky podľa zverejnených IP rozsahov jednotlivých spoločností; OpenAI, Google a ďalší veľkí poskytovatelia zverejňujú svoje IP rozsahy, čo umožňuje rozlíšiť legitímnych crawlerov od podvrhnutých user-agentov.

Základná syntax AI-špecifických pravidiel v robots.txt nasleduje štandardný formát robots.txt s párovaním user-agent a povolením/zákazom na konkrétne crawlery. Na zablokovanie GPTBot od OpenAI pre zber tréningových dát, pričom povolíte ich vyhľadávací crawler, by vaša robots.txt vyzerala takto:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Pre detailnejšiu kontrolu môžete uplatniť pravidlá pre konkrétne cesty, ktoré zablokujú určité sekcie a iné povolia—napríklad blokovať AI crawlery v prístupe k prémiovému alebo používateľskému obsahu:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Viac user-agentov môžete zoskupiť pod jednu sadu pravidiel, aby ste uplatnili rovnaké obmedzenia pre viaceré crawlery a zjednodušili konfiguráciu. Testovanie a validácia vašej robots.txt konfigurácie je kľúčová; nástroje ako robots.txt tester v Google Search Console a nezávislé validátory vedia overiť, že vaše pravidlá sú syntakticky správne a budú crawlermi interpretované podľa očakávania. Pamätajte, že robots.txt je odporúčací, nie vynútiteľný—crawleri, ktorí rešpektujú pravidlá, ich budú dodržiavať, no škodlivé alebo nekompatibilné boty ich môžu úplne ignorovať, takže pre citlivý obsah je potrebné zaviesť serverové mechanizmy ochrany.

Rozhodnutie blokovať alebo povoliť AI crawlery predstavuje zásadný kompromis medzi ochranou obsahu a viditeľnosťou, ktorý sa výrazne líši podľa vášho obchodného modelu a stratégie obsahu. Blokovanie tréningových crawlerov ako GPTBot úplne eliminuje riziko, že váš obsah bude použitý na tréning AI modelov bez kompenzácie, no zároveň znamená, že váš obsah sa nebude objavovať v AI-generovaných odpovediach, čo môže znížiť objaviteľnosť a návštevnosť od používateľov AI. Naopak, povolenie tréningových crawlerov zvyšuje šancu, že váš obsah bude zahrnutý do tréningových datasetov, často bez atribúcie alebo kompenzácie, no môže zvýšiť viditeľnosť, ak AI systémy váš obsah v budúcnosti citujú alebo odkazujú. Rozhodnutie by malo zohľadniť konkurenčnú výhodu vášho obsahu—pre originálne výskumy, unikátne analýzy a údaje je vhodné prísne blokovanie, zatiaľ čo verejný vzdelávací obsah alebo bežné informácie môžu profitovať zo širšej AI viditeľnosti. Rôzne typy vydavateľov majú rôzne prístupy: spravodajské organizácie často povolujú vyhľadávacie crawlery pre citácie, no blokujú tréningové crawlery; vzdelávací vydavatelia zvažujú širší prístup pre zvýšenie dosahu; SaaS firmy zvyčajne blokujú všetky AI crawlery na ochranu dokumentácie. Monitorovanie dosahu týchto rozhodnutí cez serverové logy a analytiku je nevyhnutné na overenie, či konfigurácia plní vaše obchodné ciele.

Hoci robots.txt poskytuje jasný spôsob komunikácie politík crawlerom, je v zásade odporúčací a právne nevynútiteľný—crawleri, ktorí rešpektujú pravidlá, ich budú dodržiavať, no nekompatibilní aktéri ich môžu ignorovať, a preto sú potrebné ďalšie technické vrstvy ochrany. IP overovanie a allowlisting predstavuje najspoľahlivejšiu metódu vynucovania; udržiavaním zoznamu legitímnych IP adries zverejnených OpenAI, Google, Anthropic a ďalšími AI spoločnosťami môžete overiť, že požiadavky deklarované ako crawlery skutočne pochádzajú z ich infraštruktúry. Firewall pravidlá a blokovanie na úrovni servera poskytujú najsilnejšie vynucovanie, keďže dokážu odmietnuť požiadavky od konkrétnych user-agentov či IP rozsahov ešte pred spotrebou serverových zdrojov. Pre Apache servery môže .htaccess konfigurácia vynucovať obmedzenia pre crawlery:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta tagy v hlavičke HTML poskytujú detailnú, stránkovú kontrolu prístupu crawlerov bez úpravy robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Pravidelné kontrolovanie serverových logov na aktivitu crawlerov vám umožní identifikovať nové crawlery, overiť, že vaše pravidlá sú rešpektované a odhaliť user-agentov pokúšajúcich sa obísť obmedzenia. Nástroje ako Knowatoa a Merkle poskytujú automatizovanú validáciu a monitoring vašej robots.txt konfigurácie a správania crawlerov, čím zabezpečia prehľad o tom, ktoré crawlery navštevujú váš web a či dodržiavajú vaše pravidlá.

Priebežná údržba vašej AI-špecifickej konfigurácie robots.txt je nevyhnutná, pretože prostredie AI crawlerov sa rýchlo mení, objavujú sa nové crawlery a existujúce menia svoje user-agent reťazce a správanie. Vaša stratégia monitorovania by mala zahŕňať:

Rýchly vývoj technológií AI crawlerov znamená, že konfigurácia robots.txt, ktorá bola vhodná pred šiestimi mesiacmi, už nemusí zodpovedať vašim aktuálnym potrebám ani aktuálnym hrozbám, preto je pravidelná revízia a adaptácia kľúčová na udržanie efektívnej ochrany obsahu.

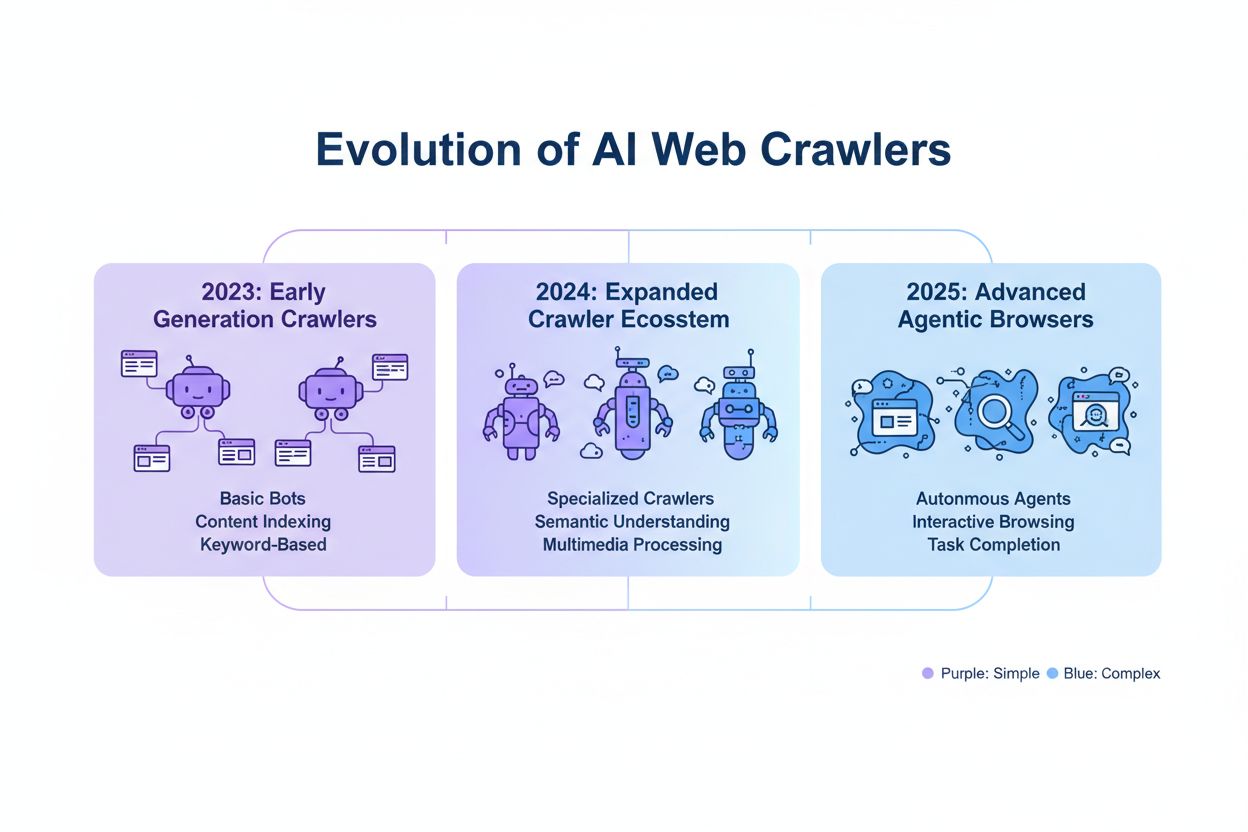

Nová generácia AI crawlerov prináša problémy, ktoré tradičná konfigurácia robots.txt nemusí účinne riešiť. Agentické browser crawlery ako ChatGPT Atlas a Google Project Mariner fungujú ako plnohodnotné webové prehliadače, renderujú JavaScript, vykonávajú interakcie používateľa a správajú sa nerozoznateľne od ľudských návštevníkov—nemusia sa identifikovať špecifickými user-agent reťazcami, takže blokovanie cez robots.txt je neúčinné. Mnohé nové crawlery preberajú štandardné Chrome user-agent reťazce, aby sa vyhli detekcii a blokovaniu, zámerne skrývajúc svoju identitu a obchádzajúc robots.txt pravidlá a ďalšie prístupové kontroly. Tento trend vedie k blokovaniu podľa IP ako novej nevyhnutnosti, kde majitelia stránok musia udržiavať allowlisty legitímnych IP adries crawlerov a blokovať všetku ďalšiu pochybnú návštevnosť, čo zásadne mení model vynucovania z párovania user-agentov na sieťovú kontrolu prístupu. Podvrhnuté user-agenty a obchádzacie techniky sú čoraz bežnejšie, keď škodliví aktéri predstierajú legitímnych crawlerov alebo používajú generické user-agent reťazce na obídenie detekcie. Budúcnosť správy AI crawlerov si pravdepodobne vyžiada viacvrstvový prístup kombinujúci konfiguráciu robots.txt, IP overovanie, firewall pravidlá a prípadne behaviorálnu analýzu na rozlíšenie legitímnych crawlerov od škodlivých aktérov. Udržiavanie si prehľadu o nových technológiách crawlerov a účasť v diskusiách o etike a štandardoch crawlerov je pre vydavateľov, ktorí chcú efektívne chrániť svoj obsah, nevyhnutná.

Efektívna AI-špecifická konfigurácia robots.txt vyžaduje komplexný prístup, ktorý vyvažuje ochranu obsahu so strategickými cieľmi viditeľnosti. Začnite s jasnou politikou ochrany obsahu, ktorá definuje, ktoré kategórie obsahu treba blokovať (originálny výskum, prémiový obsah, používateľský obsah) a ktoré možno bezpečne sprístupniť AI crawlerom (verejné články, vzdelávací obsah, bežné informácie). Zaveďte vrstvenú stratégiu blokovania, ktorá rozlišuje medzi tréningovými crawlermi (zvyčajne blokovať), vyhľadávacími crawlermi (zvyčajne povoliť a monitorovať) a crawlermi spustenými používateľom (zvyčajne povoliť), namiesto plošného prístupu povoliť/blokovať všetky AI crawlery. Kombinujte robots.txt s vynucovaním na úrovni servera implementáciou firewall pravidiel a IP overovania pre najcitlivejší obsah, keďže samotné robots.txt neposkytuje dostatočnú ochranu. Integrujte správu AI crawlerov do vašej SEO a obsahovej stratégie s ohľadom na to, ako rozhodnutia o blokovaní ovplyvnia vašu viditeľnosť v AI-generovaných odpovediach, citáciách a AI-poháňaných vyhľadávacích funkciách—táto integrácia zabezpečí, že vaša robots.txt konfigurácia podporí, nie naruší vaše obchodné ciele. Zaveďte pravidelný plán monitorovania a údržby s týždennými kontrolami logov, mesačnou IP verifikáciou a štvrťročnými auditmi, aby vaša konfigurácia zostala účinná v meniacom sa prostredí crawlerov. Používajte nástroje ako AmICited.com na monitorovanie viditeľnosti vášho obsahu v AI systémoch a pochopenie vplyvu vašich rozhodnutí o blokovaní na AI objavovanie a citácie. Pre rôzne typy vydavateľov: spravodajské organizácie by mali zvyčajne povoliť vyhľadávacie crawlery a blokovať tréningové crawlery na maximalizáciu referral návštevnosti z citácií; vzdelávací vydavatelia môžu zvážiť širší prístup na zvýšenie dosahu; SaaS spoločnosti by mali implementovať prísne blokovanie pre proprietárnu dokumentáciu. Ak blokovanie cez robots.txt nestačí kvôli podvrhnutým user-agentom alebo nekompatibilným crawlerom, prejdite na firewall pravidlá a blokovanie podľa IP, aby ste vynútili ochranu obsahu na úrovni siete.

Tréningové crawlery ako GPTBot a ClaudeBot zbierajú dáta na vývoj modelov a neposkytujú žiadnu referral návštevnosť, takže predstavujú vysoké riziko pre ochranu obsahu. Vyhľadávacie crawlery ako OAI-SearchBot a PerplexityBot indexujú obsah na AI-poháňané vyhľadávanie a môžu posielať referral návštevnosť cez citácie. Väčšina vydavateľov blokuje tréningové crawlery, pričom povolí vyhľadávacie crawlery, aby vyvážili ochranu obsahu s viditeľnosťou.

Google oficiálne uvádza, že blokovanie Google-Extended neovplyvňuje pozície vo vyhľadávaní ani zahrnutie do AI Overviews. Niektorí webmasteri však hlásili obavy, preto sledujte svoj výkon vo vyhľadávaní po zavedení blokovania. AI Overviews vo vyhľadávaní Google nasledujú štandardné pravidlá Googlebotu, nie Google-Extended.

Áno, robots.txt je odporúčací, nie vynútiteľný. Dobre správané crawlery od veľkých spoločností vo všeobecnosti rešpektujú pravidlá robots.txt, no niektoré crawlery ich ignorujú. Pre silnejšiu ochranu implementujte blokovanie na úrovni servera cez .htaccess alebo firewall a overujte legitímnosť crawlerov pomocou zverejnených IP rozsahov.

Svoj blocklist prejdite a aktualizujte aspoň štvrťročne. Pravidelne vznikajú nové AI crawlery, preto mesačne kontrolujte serverové logy a identifikujte nové crawlery navštevujúce váš web. Sledujte komunitné zdroje ako projekt ai.robots.txt na GitHube pre novinky o nových crawleroch a user-agent reťazcoch.

Závisí to od vašich obchodných priorít. Blokovanie tréningových crawlerov chráni váš obsah pred použitím v AI modeloch bez kompenzácie. Blokovanie vyhľadávacích crawlerov môže znížiť vašu viditeľnosť v AI-poháňaných platformách ako ChatGPT search alebo Perplexity. Mnohí vydavatelia volia selektívne blokovanie, ktoré cieli na tréningové crawlery, pričom povolia vyhľadávacie a citačné crawlery.

Skontrolujte serverové logy na user-agent reťazce crawlerov a overte, že blokované crawlery nepristupujú k vašim stránkam. Použite analytické nástroje na sledovanie návštevnosti botov. Otestujte svoju konfiguráciu cez Knowatoa AI Search Console alebo Merkle robots.txt Tester, aby ste overili, že vaše pravidlá fungujú podľa očakávania.

Agentické browser crawlery ako ChatGPT Atlas a Google Project Mariner fungujú ako plnohodnotné webové prehliadače, nie jednoduchí HTTP klienti. Často používajú štandardné Chrome user-agent reťazce, takže sú nerozoznateľné od bežnej návštevnosti. Na kontrolu prístupu k týmto pokročilým crawlerom je potrebné blokovanie podľa IP.

AI-špecifický robots.txt riadi prístup k vášmu obsahu, zatiaľ čo nástroje ako AmICited sledujú, ako AI platformy citujú a odkazujú na váš obsah. Spolu poskytujú úplnú viditeľnosť a kontrolu: robots.txt riadi prístup crawlerov a monitorovacie nástroje sledujú vplyv vášho obsahu naprieč AI systémami.

AmICited sleduje, ako AI systémy ako ChatGPT, Claude, Perplexity a Google AI Overviews citujú a odkazujú na vašu značku. Kombinujte konfiguráciu robots.txt s monitorovaním viditeľnosti v AI, aby ste pochopili vplyv vášho obsahu naprieč AI platformami.

Zistite, ako nakonfigurovať robots.txt pre kontrolu prístupu AI crawlerov vrátane GPTBot, ClaudeBot a Perplexity. Spravujte viditeľnosť svojej značky v AI-gener...

Zistite, ako Web Application Firewall poskytuje pokročilú kontrolu nad AI robotmi nad rámec robots.txt. Implementujte WAF pravidlá na ochranu svojho obsahu pred...

Diskusia komunity o tom, či povoliť AI botom prehľadávať váš web. Skutočné skúsenosti s konfiguráciou robots.txt, implementáciou llms.txt a správou AI crawlerov...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.