Kontextové okno

Kontextové okno vysvetlené: maximálny počet tokenov, ktoré LLM dokáže naraz spracovať. Zistite, ako kontextové okná ovplyvňujú presnosť AI, halucinácie a monito...

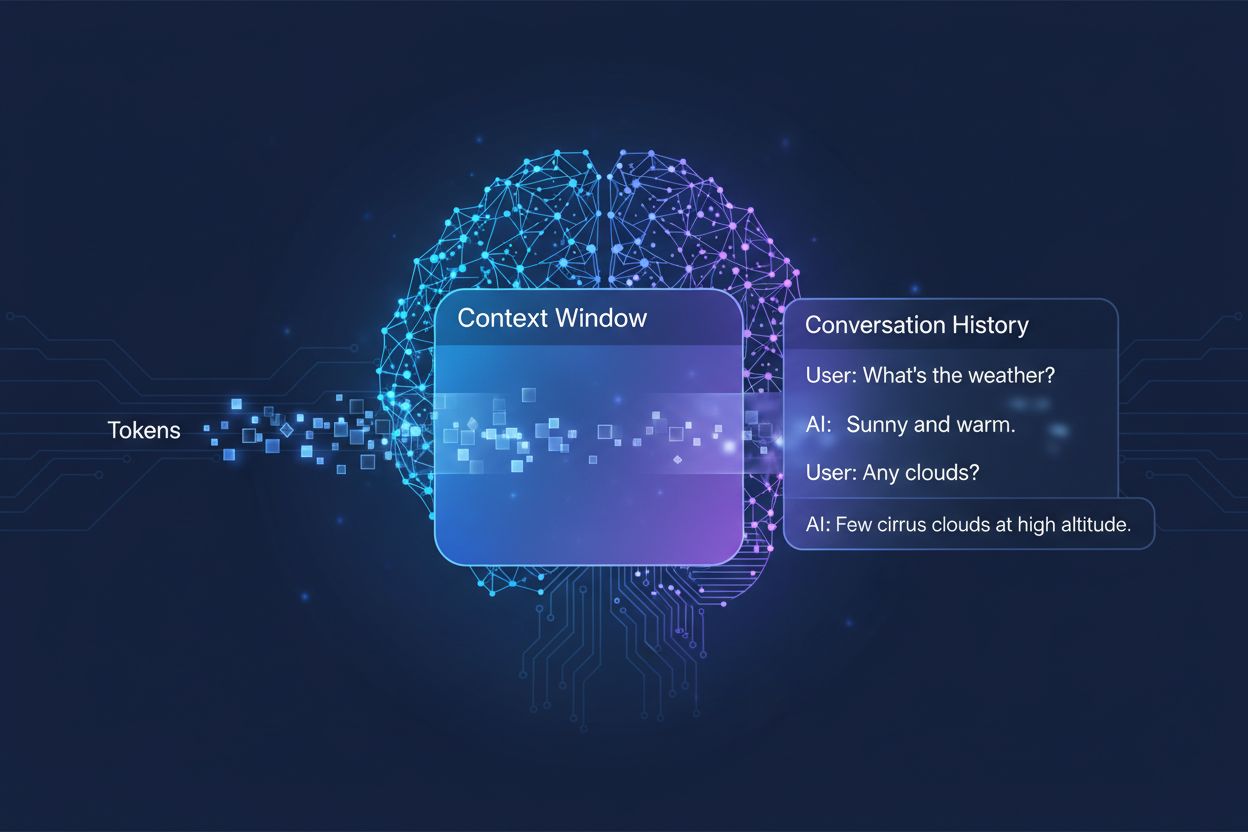

Množstvo predchádzajúcej konverzácie, ktoré AI systém zohľadňuje pri generovaní odpovedí, merané v tokenoch. Určuje, koľko textu môže AI spracovať naraz a priamo ovplyvňuje kvalitu a súdržnosť jej výstupov v rámci viacnásobných konverzácií.

Množstvo predchádzajúcej konverzácie, ktoré AI systém zohľadňuje pri generovaní odpovedí, merané v tokenoch. Určuje, koľko textu môže AI spracovať naraz a priamo ovplyvňuje kvalitu a súdržnosť jej výstupov v rámci viacnásobných konverzácií.

Okno kontextu je maximálne množstvo textu, ktoré dokáže jazykový model umelej inteligencie naraz spracovať a referencovať počas konverzácie alebo úlohy. Predstavte si to ako pracovnú pamäť modelu—tak, ako si človek dokáže v danom momente udržať len obmedzené množstvo informácií, aj AI modely dokážu „vidieť“ len určitý objem textu pred a po svojej aktuálnej pozícii. Táto kapacita sa meria v tokenoch, čo sú malé jednotky textu, ktoré typicky predstavujú slová alebo ich časti (v priemere jedno anglické slovo zodpovedá približne 1,5 tokenu). Pochopenie okna kontextu vášho modelu je kľúčové, pretože priamo určuje, koľko informácií môže AI pri generovaní odpovedí zohľadniť, čo predstavuje základné obmedzenie pri zvládaní komplexných, viacnásobných konverzácií alebo dlhých dokumentov.

Moderné jazykové modely, najmä architektúry založené na transformeroch, spracúvajú text tak, že ho prevedú na tokeny a následne analyzujú vzťahy medzi všetkými tokenmi v rámci okna kontextu súčasne. Transformátorová architektúra, predstavená v prelomovom článku z roku 2017 „Attention is All You Need“, využíva mechanizmus nazývaný self-attention na určenie, ktoré časti vstupu sú navzájom najrelevantnejšie. Tento attention mechanizmus umožňuje modelu vážiť dôležitosť jednotlivých tokenov voči sebe navzájom, čím mu dáva schopnosť chápať kontext a význam naprieč celým oknom. Tento proces sa však pri zväčšovaní okna kontextu stáva výpočtovo náročným, pretože attention mechanizmus musí vypočítať vzťahy medzi každým tokenom a všetkými ostatnými tokenmi—ide o kvadratický problém škálovania. Nasledujúca tabuľka ilustruje, ako sa líšia popredné AI modely vo svojich schopnostiach okna kontextu:

| Model | Okno kontextu (tokeny) | Dátum vydania |

|---|---|---|

| GPT-4 | 128 000 | marec 2023 |

| Claude 3 Opus | 200 000 | marec 2024 |

| Gemini 1.5 Pro | 1 000 000 | máj 2024 |

| GPT-4 Turbo | 128 000 | november 2023 |

| Llama 2 | 4 096 | júl 2023 |

Tieto rôznorodé kapacity odrážajú odlišné dizajnové rozhodnutia a výpočtové kompromisy každej organizácie, pričom väčšie okná umožňujú sofistikovanejšie aplikácie, no zároveň vyžadujú viac výpočtového výkonu.

Cesta k väčším oknám kontextu predstavuje jeden z najvýznamnejších pokrokov v schopnostiach AI za poslednú dekádu. Skoré rekurentné neurónové siete (RNN) a modely long short-term memory (LSTM) mali s kontextom problémy, keďže text spracúvali sekvenčne a len ťažko si uchovávali informácie zo vzdialenejších častí vstupu. Prelom nastal v 2017 s predstavením transformerovej architektúry, ktorá umožnila paralelné spracovanie celých sekvencií a dramaticky zlepšila schopnosť modelu udržať kontext aj pri dlhších textoch. Na tomto základe vznikol GPT-2 v roku 2019 s pôsobivými schopnosťami generovania jazyka a oknom kontextu 1 024 tokenov, nasledovaný GPT-3 v roku 2020 s 2 048 tokenmi a napokon GPT-4 v roku 2023 so 128 000 tokenmi. Každý pokrok mal význam, pretože rozšíril možnosti AI: väčšie okná umožnili modelom spracovať dlhšie dokumenty, udržať súdržnosť cez viacnásobné konverzácie a pochopiť nuansované vzťahy medzi vzdialenými konceptmi v texte. Exponenciálny rast veľkosti okien kontextu odráža pokroky v architektúrach aj narastajúce výpočtové možnosti popredných AI laboratórií.

Väčšie okná kontextu zásadne rozširujú možnosti AI modelov a umožňujú aplikácie, ktoré boli predtým nemožné alebo výrazne obmedzené. Kľúčové prínosy sú:

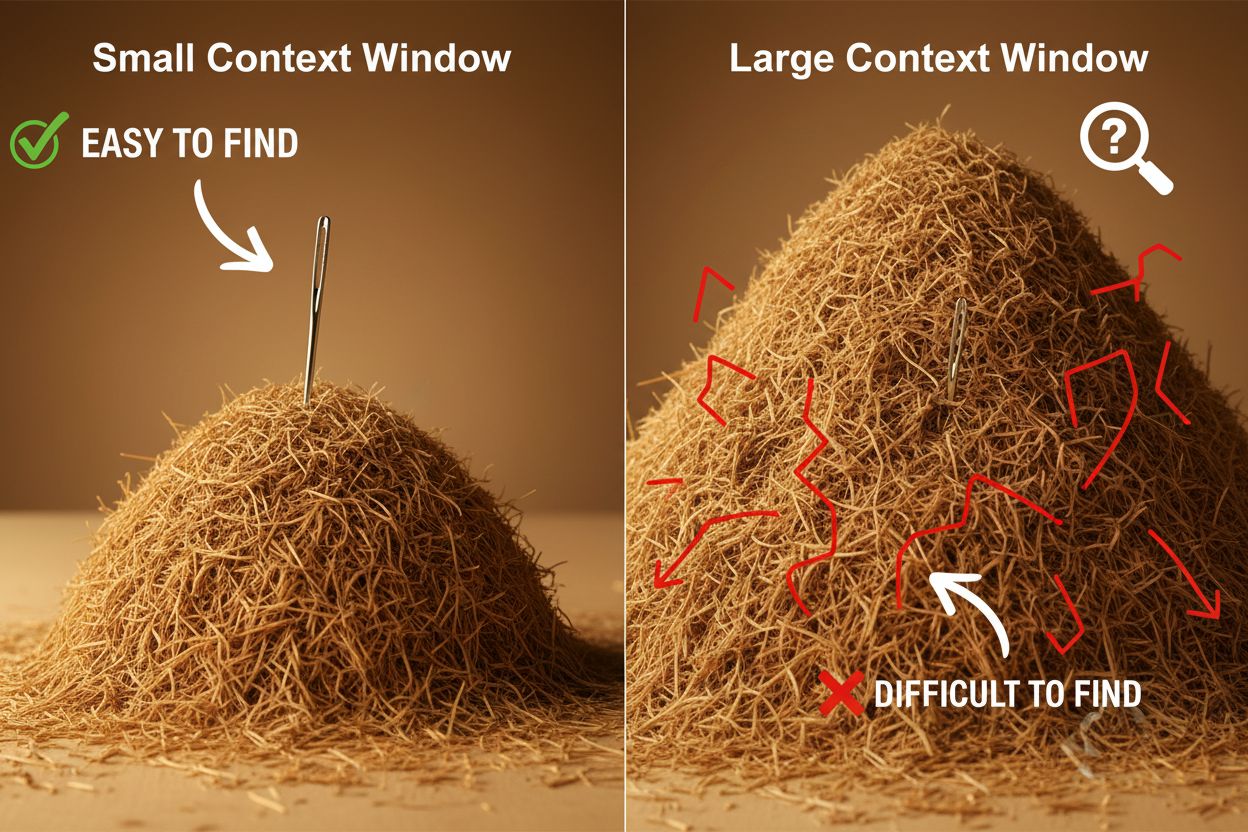

Napriek výhodám prinášajú veľké okná kontextu aj významné technické a praktické výzvy, ktorým sa vývojári a používatelia musia venovať. Najzjavnejšou výzvou sú výpočtové náklady: spracovanie dlhších sekvencií vyžaduje exponenciálne viac pamäte a výkonu kvôli kvadratickému škálovaniu attention mechanizmu, čo robí prevádzku s veľkými oknami výrazne drahšou. Tento zvýšený dopyt po výpočtových zdrojoch spôsobuje aj problémy s latenciou, keďže väčšie okná znamenajú pomalšie odpovede—a to je kritická otázka pre aplikácie v reálnom čase s očakávaním rýchlych reakcií. Ďalším nenápadným, no dôležitým problémom je fenomén „ihly v kope sena“, keď modely ťažko nachádzajú a využívajú relevantné informácie ukryté vo veľmi veľkom okne, čo môže viesť k horším výsledkom než pri menších oknách. Navyše, nastáva context rot, keď informácie zo začiatku dlhého okna strácajú vplyv na výstup modelu, pretože attention mechanizmus uprednostňuje novšie tokeny pred tými vzdialenejšími. Tieto výzvy znamenajú, že maximalizácia veľkosti okna kontextu nie je vždy optimálnym riešením pre každé použitie.

Pochopenie context rot je zásadné pre efektívnu prácu s veľkými oknami kontextu: čím sú sekvencie dlhšie, tým majú tokeny na začiatku menší vplyv na výstup modelu, takže dôležité informácie môžu byť fakticky „zabudnuté“, aj keď sa technicky nachádzajú v okne. Je to dôsledok toho, že attention budget—kapacita modelu efektívne sa venovať všetkým tokenom—je pri väčšom objeme textu rozdelená medzi viac tokenov. Našťastie, objavilo sa niekoľko sofistikovaných techník na riešenie týchto obmedzení. Retrieval-Augmented Generation (RAG) rieši tento problém ukladaním informácií do externých databáz a načítavaním iba relevantných častí podľa potreby, čím sa modelu efektívne rozširuje znalostná báza bez nutnosti obrovského okna. Kompakcia kontextu sumarizuje alebo komprimuje menej dôležité informácie, čím uchováva najzásadnejšie detaily a zároveň šetrí tokeny. Štruktúrované poznámky motivujú používateľov organizovať informácie hierarchicky, vďaka čomu model ľahšie nájde a uprednostní kľúčové koncepty. Tieto riešenia fungujú tak, že strategicky určujú, aké informácie sa dostanú do okna a v akej podobe, namiesto snahy uložiť všetko naraz do pamäte.

Rozšírené okná kontextu v moderných AI modeloch otvorili množstvo reálnych aplikácií, ktoré boli predtým nepraktické alebo nemožné. Zákaznícke podporné systémy dokážu dnes preskúmať celú históriu ticketu aj súvisiacu dokumentáciu v jednej požiadavke, čím poskytujú presnejšie a kontextuálne vhodné odpovede bez toho, aby zákazník musel opakovane vysvetľovať svoj problém. Analýza dokumentov a výskum boli transformované modelmi, ktoré dokážu naraz prečítať celé vedecké práce, právne zmluvy či technické špecifikácie, identifikovať kľúčové informácie a odpovedať na detailné otázky o obsahu, ktorý by človek študoval hodiny. Kontrola kódu a vývoj softvéru profituje z okien dostatočne veľkých na uchovanie celých súborov či viacerých súvisiacich súborov, čo umožňuje AI pochopiť architektonické vzory a dávať inteligentnejšie odporúčania. Tvorba dlhých textov a iteratívne písanie sú efektívnejšie, keď model dokáže sledovať tón, štýl aj dej celého dokumentu počas celého editačného procesu. Analýza prepisov stretnutí a syntéza výskumu využívajú veľké okná kontextu na extrakciu poznatkov z hodín rozhovorov alebo desiatok zdrojových dokumentov, čím identifikujú témy a súvislosti, ktoré by manuálne odhaliť bolo náročné. Tieto aplikácie dokazujú, že veľkosť okna kontextu sa priamo premieta do praktickej hodnoty pre profesionálov v rôznych odvetviach.

Vývoj okien kontextu naznačuje, že sa v krátkodobom horizonte posunieme k ešte dramatickejšiemu zväčšovaniu, pričom Gemini 1.5 Pro už demonštruje okno s 1 000 000 tokenmi a výskumné laboratóriá skúmajú ešte väčšie kapacity. Okrem samotnej veľkosti bude budúcnosť pravdepodobne patriť dynamickým oknám kontextu, ktoré inteligentne prispôsobujú svoju veľkosť podľa typu úlohy, čím pridelia viac kapacity tam, kde je to potrebné, a šetria zdroje pri jednoduchších otázkach. Výskumníci tiež napredujú vo vývoji efektívnejších attention mechanizmov, ktoré znižujú výpočtové nároky pri veľkých oknách a môžu prekonávať kvadratickú bariéru škálovania, ktorá dnes limituje veľkosť kontextu. Ako tieto technológie budú dozrievať, je pravdepodobné, že okná kontextu prestanú byť obmedzením a stanú sa vyriešeným problémom, čo umožní vývojárom sústrediť sa na ďalšie aspekty schopností a spoľahlivosti AI. Súhra väčších okien, vyššej efektivity a inteligentnej správy kontextu pravdepodobne definuje ďalšiu generáciu AI aplikácií a otvorí možnosti, ktoré si dnes ešte len predstavujeme.

Okno kontextu je celkové množstvo textu (merané v tokenoch), ktoré môže AI model naraz spracovať, zatiaľ čo limit tokenov označuje maximálny počet tokenov, ktoré model zvládne. Tieto pojmy sa často používajú zameniteľne, ale okno kontextu konkrétne označuje pracovnú pamäť dostupnú počas jedného inferenčného kroku, zatiaľ čo limit tokenov môže označovať aj výstupné obmedzenia alebo limity používania API.

Väčšie okná kontextu vo všeobecnosti zlepšujú kvalitu odpovedí, pretože model môže zohľadniť viac relevantných informácií a lepšie udržiavať kontinuitu konverzácie. Extrémne veľké okná však môžu niekedy kvalitu zhoršiť v dôsledku tzv. context rot, keď má model problém uprednostniť dôležité informácie medzi veľkým množstvom textu. Optimálna veľkosť okna kontextu závisí od konkrétnej úlohy a od toho, ako dobre sú informácie usporiadané.

Väčšie okná kontextu vyžadujú viac výpočtového výkonu kvôli kvadratickému škálovaniu mechanizmu attention v transformer modeloch. Mechanizmus attention musí vypočítať vzťahy medzi každým tokenom a všetkými ostatnými tokenmi, takže zdvojnásobenie okna kontextu približne zoštvornásobí výpočtové požiadavky. Preto je prevádzka s väčšími oknami kontextu nákladnejšia a prináša pomalšie odpovede.

Problém 'ihly v kope sena' nastáva, keď má AI model problém nájsť a využiť relevantné informácie (ihlu), ktoré sú ukryté vo veľmi veľkom okne kontextu (kopa sena). Modely niekedy podávajú horšie výsledky s extrémne veľkými oknami, pretože mechanizmus attention je rozptýlený medzi príliš veľa informácií, čo sťažuje identifikáciu toho, čo je skutočne dôležité.

Aby ste maximalizovali efektívnosť okna kontextu, organizujte informácie jasne a hierarchicky, najdôležitejšie informácie umiestnite na začiatok alebo koniec kontextu, používajte štruktúrované formáty ako JSON alebo markdown a zvážte využitie Retrieval-Augmented Generation (RAG) na dynamické načítanie len najrelevantnejších informácií. Vyhnite sa zahlteniu modelu irelevantnými detailmi, ktoré spotrebujú tokeny bez pridanej hodnoty.

Okno kontextu je technická kapacita modelu spracovať text naraz, zatiaľ čo história konverzácie je skutočný záznam predchádzajúcich správ v rozhovore. História konverzácie sa musí zmestiť do okna kontextu, avšak okno kontextu zahŕňa aj priestor pre systémové promptové texty, inštrukcie a iné metadáta. História konverzácie môže byť dlhšia ako okno kontextu, čo si vyžaduje sumarizáciu alebo skracovanie.

Žiadne AI modely v súčasnosti nemajú skutočne neobmedzené okno kontextu, pretože všetky modely majú architektonické a výpočtové obmedzenia. Niektoré modely, ako Gemini 1.5 Pro, však ponúkajú extrémne veľké okná (1 000 000 tokenov) a techniky ako Retrieval-Augmented Generation (RAG) môžu efektívne rozšíriť znalostnú bázu modelu nad rámec jeho okna kontextu dynamickým načítavaním informácií podľa potreby.

Veľkosť okna kontextu priamo ovplyvňuje náklady na API, pretože väčšie okná vyžadujú viac výpočtových zdrojov na spracovanie. Väčšina poskytovateľov AI API účtuje podľa spotreby tokenov, takže pri použití väčšieho okna kontextu sa spracuje viac tokenov a náklady rastú. Niektorí poskytovatelia tiež účtujú prémiové ceny za modely s väčšími oknami kontextu, preto je dôležité zvoliť správnu veľkosť modelu pre vaše konkrétne potreby.

AmICited sleduje, ako AI systémy ako ChatGPT, Perplexity a Google AI Overviews citujú a odkazujú na váš obsah. Získajte prehľad o svojej viditeľnosti v AI a monitorujte zmienky o vašej značke naprieč AI platformami.

Kontextové okno vysvetlené: maximálny počet tokenov, ktoré LLM dokáže naraz spracovať. Zistite, ako kontextové okná ovplyvňujú presnosť AI, halucinácie a monito...

Zistite, čo sú kontextové okná v jazykových AI modeloch, ako fungujú, aký majú vplyv na výkon modelu a prečo sú dôležité pre AI aplikácie a monitoring....

Diskusia komunity o kontextových oknách AI a ich dopadoch na content marketing. Pochopenie, ako limity kontextu ovplyvňujú spracovanie vášho obsahu AI systémami...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.