Viditeľnosť AI vo finančných službách: Súlad a optimalizácia

Sledujte, ako sa vaša finančná značka objavuje v odpovediach generovaných AI. Zistite požiadavky na dodržiavanie predpisov, stratégie viditeľnosti a techniky op...

Regulačné požiadavky na finančné inštitúcie, aby transparentne zverejňovali svoje využívanie umelej inteligencie pri rozhodovacích procesoch, riadení rizík a v aplikáciách zameraných na zákazníkov. Zahŕňa očakávania orgánov ako SEC, CFPB, FINRA a ďalších regulátorov na dokumentáciu správy AI, výkonnosti modelov a vplyvov na spotrebiteľov a trhy.

Regulačné požiadavky na finančné inštitúcie, aby transparentne zverejňovali svoje využívanie umelej inteligencie pri rozhodovacích procesoch, riadení rizík a v aplikáciách zameraných na zákazníkov. Zahŕňa očakávania orgánov ako SEC, CFPB, FINRA a ďalších regulátorov na dokumentáciu správy AI, výkonnosti modelov a vplyvov na spotrebiteľov a trhy.

Finančné AI zverejňovanie označuje regulačné požiadavky a osvedčené postupy pre finančné inštitúcie, aby transparentne zverejňovali svoje využívanie umelej inteligencie v rozhodovacích procesoch, riadení rizík a v aplikáciách určených zákazníkom. Zahŕňa očakávania orgánov ako SEC, CFPB, FINRA a ďalších regulátorov na dokumentáciu správy AI, výkonnosti modelov a možných vplyvov na spotrebiteľov a trhy. V decembri 2024 Poradný výbor investorov SEC (IAC) predložil formálne odporúčanie, aby agentúra vydala usmernenie vyžadujúce od emitentov zverejňovanie informácií o dopade umelej inteligencie na ich spoločnosti. IAC poukázal na „nedostatok konzistentnosti“ v súčasných AI zverejneniach, čo „môže byť problematické pre investorov hľadajúcich jasné a porovnateľné informácie“. Iba 40 % spoločností S&P 500 poskytuje zverejňovanie týkajúce sa AI a len 15 % zverejňuje informácie o dohľade predstavenstva nad AI, napriek tomu, že 60 % spoločností S&P 500 považuje AI za významné riziko.

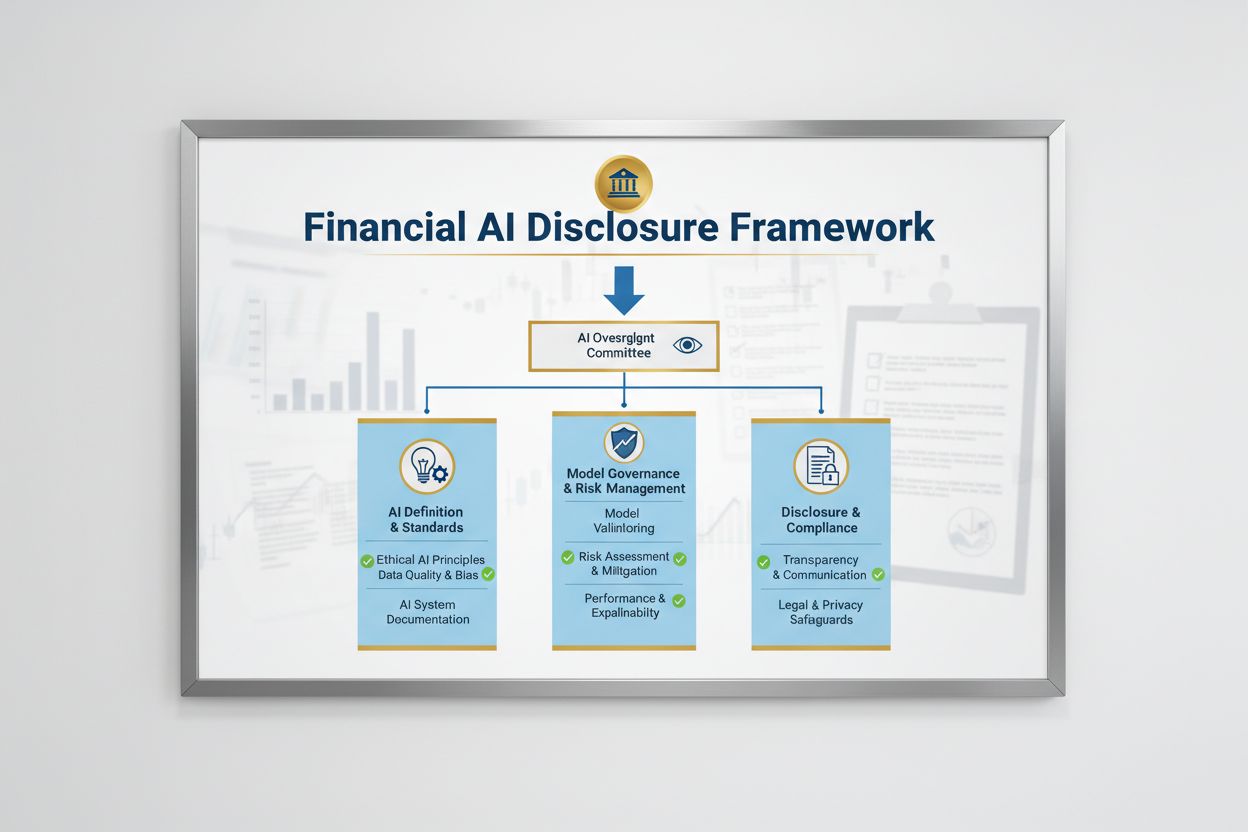

Regulačné prostredie pre Finančné AI zverejňovanie je formované viacerými federálnymi agentúrami, ktoré uplatňujú existujúce technologicky neutrálne zákony na AI systémy. Poradný výbor investorov SEC navrhol počiatočný rámec s tromi kľúčovými piliermi: (1) požadovať od emitentov, aby definovali, čo rozumejú pod pojmom „umelá inteligencia“, (2) zverejňovať mechanizmy dohľadu predstavenstva nad implementáciou AI a (3) informovať o významných implementáciách AI a ich vplyve na vnútorné operácie a produkty určené zákazníkom. Okrem SEC vydali usmernenia aj CFPB, FINRA, OCC a Federálny rezervný systém, pričom zdôraznili, že existujúce zákony na ochranu spotrebiteľa — vrátane spravodlivého úverovania, ochrany údajov a protifraudových predpisov — sa vzťahujú na AI systémy bez ohľadu na použitú technológiu. Tieto agentúry uplatňujú technologicky neutrálny prístup, čo znamená, že povinnosti podľa Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) a štandardov Unfair or Deceptive Acts or Practices (UDAAP) zostávajú nezmenené aj pri použití AI.

| Regulátor | Oblasť zamerania | Kľúčová požiadavka |

|---|---|---|

| SEC | Zverejňovanie pre investorov, konflikty záujmov | Definovať AI, zverejniť dohľad predstavenstva, informovať o významných implementáciách |

| CFPB | Spravodlivé úverovanie, ochrana spotrebiteľa | Zaistiť súlad AI modelov s ECOA, poskytovať oznámenia o nepriaznivých rozhodnutiach |

| FINRA | Operácie obchodníkov, komunikácia so zákazníkmi | Zaviesť politiky správy AI, dohliadať na využívanie AI vo všetkých funkciách |

| OCC/Federal Reserve/FDIC | Správa bankových modelov, prevádzkové riziko | Validovať AI modely, dokumentovať kontroly, posudzovať spoľahlivosť |

| FTC | Nekalé praktiky, spracovanie dát | Monitorovať tvrdenia týkajúce sa AI, predchádzať nekalému využívaniu dát |

Efektívne Finančné AI zverejňovanie vyžaduje jasný dohľad na úrovni predstavenstva nad implementáciou umelej inteligencie a riadením rizík. Odporúčanie IAC SEC zdôrazňuje, že investori majú oprávnený záujem pochopiť, či existujú jasné línie zodpovednosti za zavádzanie AI technológií vo vnútorných obchodných operáciách a produktových líniách. Finančné inštitúcie musia zaviesť riadiace štruktúry, ktoré zverujú zodpovednosť za dohľad nad AI predstavenstvu alebo určenej komisií predstavenstva, čím zabezpečujú, že AI riziká sú riadené na najvyššej úrovni organizácie. Tento rámec správy by mal zahŕňať dokumentované politiky a postupy pre vývoj, testovanie, validáciu a implementáciu AI, s pravidelným hlásením predstavenstvu o výkonnosti modelov, identifikovaných rizikách a nápravných opatreniach. Bez jasnej zodpovednosti predstavenstva hrozí finančným inštitúciám regulačná kontrola a možné sankcie za nedostatočný dohľad nad významnými AI systémami.

Finančné inštitúcie musia samostatne zverejňovať významné účinky implementácie AI na vnútorné obchodné operácie a produkty určené zákazníkom. Pri vnútorných operáciách by zverejnenia mali pokrývať vplyv AI na ľudský kapitál (napríklad znižovanie pracovných miest alebo potrebu nových zručností), presnosť finančného výkazníctva, procesy správy a kybernetické riziká. Pri otázkach týkajúcich sa zákazníkov by inštitúcie mali zverejniť investície do platforiem poháňaných AI, integráciu AI do produktov a služieb, regulačné dopady z využívania AI a spôsob, akým AI ovplyvňuje cenové stratégie alebo obchodné ukazovatele. SEC odporúča integrovať tieto zverejnenia do existujúcich položiek Regulation S-K (ako Items 101, 103, 106 a 303) na základe materiálnosti, namiesto vytvárania úplne nových kategórií zverejňovania. Tento prístup umožňuje finančným inštitúciám využiť existujúce rámce zverejňovania a zároveň poskytovať investorom jasné, porovnateľné informácie o úlohe AI v činnosti a stratégii organizácie.

Vysoká kvalita dát je základom zodpovedného zavádzania AI vo finančných službách, avšak mnohé inštitúcie zápasia s rámcami správy dát, ktoré by spĺňali regulačné očakávania. Finančné inštitúcie musia zabezpečiť, aby dáta použité na trénovanie, testovanie a validáciu AI modelov boli čisté, kompletné, štandardizované a komplexné, s jasnou dokumentáciou zdrojov dát, ich pôvodu a známych obmedzení. Opatrenia na ochranu dát musia zabraňovať „otráveniu dát“ — manipulácii s trénovacími dátami za účelom narušenia integrity modelu — a chrániť pred neoprávneným prístupom či únikom citlivých informácií. Gramm-Leach-Bliley Act (GLBA) poskytuje základnú ochranu pre finančné dáta spotrebiteľov, ale mnohí regulátori a spotrebiteľskí obhajcovia tvrdia, že tieto ochrany sú v kontexte AI nedostatočné, najmä vzhľadom na rozširovanie zberu a používania dát na trénovanie modelov. Finančné inštitúcie musia riešiť aj otázky duševného vlastníctva, zabezpečiť si oprávnenie na používanie dát na vývoj AI a rešpektovať práva tretích strán. Implementácia robustných rámcov správy dát, vrátane princípov minimalizácie dát, prístupových práv a pravidelných auditov, je nevyhnutná na preukázanie súladu s regulačnými očakávaniami.

Regulačné orgány jasne stanovili, že AI modely používané pri finančnom rozhodovaní musia byť testované na zaujatosť a potenciálne diskriminačné výsledky, bez ohľadu na celkovú presnosť či výkonnosť modelu. Problém „čiernej skrinky“ — keď komplexné AI systémy produkujú výstupy, ktoré sú ťažko alebo nemožné vysvetliť — predstavuje významné riziko súladu, najmä v aplikáciách určených spotrebiteľom, ako je úverové hodnotenie, cenotvorba či detekcia podvodov. Finančné inštitúcie musia zaviesť procesy na detekciu a zmierňovanie zaujatosti počas celého životného cyklu modelu, vrátane testovania zaujatosti počas vývoja, validácie a priebežného monitorovania. Súlad so spravodlivým úverovaním vyžaduje, aby inštitúcie vedeli vysvetliť konkrétne dôvody nepriaznivých rozhodnutí (napríklad zamietnutie úveru) a preukázať, že ich AI modely nemajú rozdielny dopad na chránené skupiny. Testovanie „menej diskriminačných alternatív“ — metód, ktoré dosahujú rovnaké obchodné ciele s nižšou zaujatostou — je čoraz častejšie očakávané regulátormi. Mnohé inštitúcie zavádzajú vysvetliteľnú AI (xAI), napríklad analýzu dôležitosti znakov a rozhodovacie stromy, na zlepšenie transparentnosti a zodpovednosti pri AI rozhodnutiach.

Finančné inštitúcie využívajúce AI v aplikáciách určených zákazníkom musia dodržiavať existujúce zákony na ochranu spotrebiteľa, vrátane požiadaviek na oznámenia o nepriaznivých rozhodnutiach, zverejňovania ochrany dát a férové zaobchádzanie. Ak je AI systém použitý na prijímanie alebo významné ovplyvňovanie rozhodnutí o úveroch, poistení alebo iných finančných produktoch, spotrebitelia majú právo vedieť, prečo im bolo zamietnuté alebo ponúknuté menej výhodné podmienky. CFPB zdôraznil, že veritelia podliehajúci Equal Credit Opportunity Act (ECOA) nesmú používať „čierne skrinky“ modelov, ak nemôžu poskytnúť konkrétne a presné dôvody pre nepriaznivé rozhodnutia. Okrem toho sa na AI systémy, ktoré môžu poškodiť spotrebiteľov netransparentným zberom dát, porušením súkromia alebo nasmerovaním na nevhodné produkty vzťahuje štandard Unfair or Deceptive Acts or Practices (UDAAP). Finančné inštitúcie musia zabezpečiť, aby AI systémy používané v zákazníckom servise, odporúčaní produktov a správe účtov boli transparentné v používaní AI a jasne zverejňovali, ako sú spotrebiteľské dáta zbierané, použité a chránené.

Väčšina finančných inštitúcií sa spolieha na dodávateľov tretích strán pri vývoji, implementácii alebo údržbe AI systémov, čo prináša významné povinnosti v oblasti riadenia rizík tretích strán (TPRM). Medziagentúrne usmernenie federálnych bankových agentúr o vzťahoch s tretími stranami zdôrazňuje, že finančné inštitúcie zostávajú zodpovedné za výkonnosť a súlad AI systémov tretích strán, aj keď model nevyvinuli samy. Efektívne TPRM pre AI vyžaduje dôkladnú náležitú starostlivosť pred uzavretím zmluvy s dodávateľom, vrátane posúdenia jeho správy dát, validačných procesov modelu a schopnosti zabezpečiť transparentnosť prevádzky modelu. Finančné inštitúcie musia tiež sledovať riziko koncentrácie — potenciálny systémový dopad, ak by malý počet AI poskytovateľov čelil výpadkom alebo zlyhaniam. Riziká v dodávateľskom reťazci, vrátane spoľahlivosti zdrojov dát a stability infraštruktúry tretích strán, musia byť vyhodnotené a zdokumentované. Zmluvy s AI dodávateľmi by mali obsahovať jasné požiadavky na bezpečnosť dát, monitorovanie výkonnosti modelu, hlásenie incidentov a možnosť auditu či testovania AI systému. Najmä menšie finančné inštitúcie môžu mať problém s technickou expertízou na vyhodnotenie komplexných AI systémov, čo vytvára potrebu odvetvových štandardov alebo certifikačných programov na uľahčenie hodnotenia dodávateľov.

Finančné inštitúcie pôsobiace naprieč hranicami čelia čoraz zložitejšej mozaike AI regulácií, pričom Zákon o AI Európskej únie predstavuje najkomplexnejší rámec doteraz. Zákon EÚ o AI klasifikuje AI systémy používané na úverové hodnotenie, prevenciu podvodov a boj proti praniu špinavých peňazí ako „vysokorizikové“, pričom vyžaduje rozsiahlu dokumentáciu, testovanie zaujatosti, ľudský dohľad a posúdenie zhody. OECD a G7 vydali tiež zásady a odporúčania pre zodpovednú správu AI vo finančných službách, pričom zdôrazňujú transparentnosť, férovosť, zodpovednosť a ľudský dohľad. Mnohé z týchto medzinárodných štandardov majú exteritoriálny dosah, čo znamená, že finančné inštitúcie obsluhujúce klientov v EÚ, Spojenom kráľovstve alebo iných regulovaných jurisdikciách môžu musieť tieto požiadavky plniť, aj keď majú sídlo inde. Snahy o harmonizáciu regulácií pokračujú, no medzi jurisdikciami stále pretrvávajú významné rozdiely, čo vytvára výzvy pri dosahovaní súladu pre globálne finančné inštitúcie. Proaktívne zosúladenie s najprísnejšími medzinárodnými štandardmi — ako je Zákon EÚ o AI a zásady OECD — môže inštitúciám pomôcť pripraviť sa na budúce regulačné zmeny a znížiť riziko sankcií naprieč viacerými jurisdikciami.

Finančné inštitúcie by mali zaviesť komplexné dokumentačné a riadiace postupy na preukázanie súladu s očakávaniami ohľadom Finančného AI zverejňovania. Kľúčové osvedčené postupy zahŕňajú:

Implementáciou týchto postupov môžu finančné inštitúcie znížiť regulačné riziko, budovať dôveru zainteresovaných strán a pozicionovať sa ako lídri v zodpovednom nasadzovaní AI vo finančných službách.

Finančné AI zverejňovanie označuje regulačné požiadavky na finančné inštitúcie, aby transparentne zverejňovali využívanie umelej inteligencie pri rozhodovacích procesoch, riadení rizík a v aplikáciách zameraných na zákazníkov. Zahŕňa očakávania orgánov ako SEC, CFPB, FINRA a ďalších regulátorov na dokumentáciu správy AI, výkonnosti modelov a vplyvov na spotrebiteľov a trhy. Poradný výbor investorov SEC odporučil v decembri 2024, aby finančné inštitúcie definovali svoje využitie AI, zverejnili mechanizmy dohľadu predstavenstva a informovali o významných implementáciách AI.

Finančné inštitúcie musia zverejňovať používanie AI na ochranu investorov, spotrebiteľov a integrity trhu. Regulačné orgány zistili, že iba 40 % spoločností S&P 500 poskytuje zverejnenia týkajúce sa AI, čo vytvára nekonzistentnosť a informačné medzery pre investorov. Požiadavky na zverejňovanie zabezpečujú, že zainteresované strany chápu, ako AI ovplyvňuje finančné rozhodnutia, riadenie rizík a výsledky pre spotrebiteľov. Okrem toho sa na systémy AI vzťahujú aj existujúce zákony o ochrane spotrebiteľa — vrátane predpisov o spravodlivom úverovaní a ochrane údajov, čo robí zverejňovanie nevyhnutným pre splnenie regulačných požiadaviek.

Poradný výbor investorov SEC odporučil tri hlavné piliere pre zverejňovanie AI: (1) požadovať od emitentov, aby definovali, čo znamená 'umelá inteligencia', (2) zverejňovať mechanizmy dohľadu predstavenstva nad zavádzaním AI a (3) informovať o významných implementáciách AI a ich vplyve na vnútorné operácie a produkty určené zákazníkom. Tieto odporúčania majú poskytnúť investorom jasné a porovnateľné informácie o tom, ako AI ovplyvňuje činnosť a stratégiu finančných inštitúcií.

Finančné AI zverejňovanie sa zameriava špecificky na regulačné požiadavky na transparentnú komunikáciu o využívaní AI voči externým zainteresovaným stranám (investorom, regulátorom, spotrebiteľom), zatiaľ čo všeobecná správa AI sa týka vnútorných procesov a kontrol pri riadení AI systémov. Zverejňovanie je externou zložkou správy AI, ktorá zaručuje, že zainteresované strany majú prístup k materiálnym informáciám o implementácii AI, rizikách a vplyvoch. Obe zložky sú dôležité pre zodpovedné zavádzanie AI vo finančných službách.

Zverejňovanie implementácie AI by malo pokrývať vplyvy na vnútorné operácie aj na produkty určené zákazníkom. Pri vnútorných operáciách by inštitúcie mali zverejniť vplyv na ľudský kapitál, finančné výkazníctvo, riadiace procesy a kybernetické riziká. Pri produktoch určených zákazníkom by zverejnenia mali zahŕňať investície do platforiem poháňaných AI, integráciu AI do produktov, regulačné dopady a spôsob, akým AI ovplyvňuje cenotvorbu alebo obchodné stratégie. Zverejnenia by mali byť integrované do existujúcich položiek regulačného zverejňovania (ako je SEC Regulation S-K) na základe materiálnosti.

Zákony o spravodlivom úverovaní, vrátane zákona o rovnakých úverových príležitostiach (ECOA) a zákona o spravodlivom úverovom výkazníctve (FCRA), sa vzťahujú na AI systémy používané pri úverových rozhodnutiach bez ohľadu na použitú technológiu. Finančné inštitúcie musia byť schopné vysvetliť konkrétne dôvody nepriaznivých rozhodnutí (napríklad zamietnutie úveru) a preukázať, že ich AI modely nemajú rozdielny dopad na chránené skupiny. Regulačné orgány očakávajú, že inštitúcie budú testovať AI modely na zaujatosť, kde je to vhodné implementovať 'menej diskriminačné alternatívy' a viesť dokumentáciu o testovaní a validácii férovosti.

Väčšina finančných inštitúcií sa spolieha na dodávateľov tretích strán pri AI systémoch, čím vznikajú významné povinnosti v oblasti riadenia rizík tretích strán (TPRM). Finančné inštitúcie zostávajú zodpovedné za výkonnosť a súlad AI systémov tretích strán, aj keď model nevyvinuli samy. Efektívne TPRM pre AI si vyžaduje dôkladnú náležitú starostlivosť, nepretržité monitorovanie, hodnotenie správy údajov dodávateľa a dokumentáciu výkonnosti modelu. Inštitúcie musia tiež sledovať riziko koncentrácie — potenciálny systémový dopad, ak by malý počet AI poskytovateľov čelil výpadkom.

Zákon o AI Európskej únie predstavuje najkomplexnejší regulačný rámec pre AI, pričom finančné AI systémy klasifikuje ako 'vysokorizikové' a vyžaduje rozsiahlu dokumentáciu, testovanie zaujatosti a ľudský dohľad. OECD a G7 tiež vydali zásady pre zodpovednú správu AI. Mnohé z týchto medzinárodných štandardov majú exteritoriálny dosah, čo znamená, že finančné inštitúcie obsluhujúce zákazníkov v regulovaných jurisdikciách môžu musieť tieto štandardy dodržiavať. Proaktívne zosúladenie s medzinárodnými normami môže inštitúciám pomôcť pripraviť sa na budúce regulačné požiadavky a znížiť riziko vymáhania.

Sledujte, ako je vaša finančná inštitúcia spomínaná v AI odpovediach naprieč GPT, Perplexity a Google AI Overviews. Zaistite, aby vaša značka zostala viditeľná a presná vo finančnom obsahu generovanom AI.

Sledujte, ako sa vaša finančná značka objavuje v odpovediach generovaných AI. Zistite požiadavky na dodržiavanie predpisov, stratégie viditeľnosti a techniky op...

Zistite, čo je reportovanie viditeľnosti v AI, ako funguje a prečo je nevyhnutné pre monitorovanie prítomnosti vašej značky v ChatGPT, Perplexity, Google AI Ove...

Naučte sa zásadné najlepšie postupy pre transparentnosť a zverejňovanie AI. Objavte správanie, verbálne a technické metódy zverejňovania na budovanie dôvery a z...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.