Komplett lista över AI-crawlers 2025: Alla botar du bör känna till

Omfattande guide till AI-crawlers 2025. Identifiera GPTBot, ClaudeBot, PerplexityBot och 20+ andra AI-botar. Lär dig blockera, tillåta eller övervaka crawlers m...

Lär dig hur du fattar strategiska beslut om att blockera AI-crawlers. Utvärdera innehållstyp, trafikkällor, intäktsmodeller och konkurrensposition med vårt omfattande beslutsramverk.

AI-crawlers har blivit en betydande kraft i det digitala ekosystemet och förändrar i grunden hur innehåll upptäcks, indexeras och används på internet. Dessa automatiserade system är utformade för att systematiskt bläddra igenom webbplatser, extrahera data och mata in den i maskininlärningsmodeller som driver allt från sökmotorer till generativa AI-applikationer. Landskapet omfattar tre olika typer av crawlers: data-scrapers som extraherar specifik information för kommersiella ändamål, sökmotor-crawlers som Googlebot som indexerar innehåll för sökresultat, och AI-assistent-crawlers som samlar in träningsdata för stora språkmodeller. Exempel inkluderar OpenAI:s GPTBot, Anthropics Claude-Web och Googles AI Overviews-crawler, alla med olika syften och påverkan. Enligt färsk analys har cirka 21 % av de 1 000 största webbplatserna redan implementerat någon form av blockering av AI-crawlers, vilket tyder på en växande medvetenhet om behovet av att hantera dessa automatiska besökare. Att förstå vilka crawlers som besöker din webbplats och varför de gör det är det första kritiska steget för att fatta ett informerat beslut om du ska blockera eller tillåta dem. Insatserna är höga eftersom detta beslut direkt påverkar ditt innehålls synlighet, dina trafikmönster och i slutändan din intäktsmodell.

Istället för att fatta ett generellt beslut om att blockera eller tillåta alla AI-crawlers innebär ett mer sofistikerat tillvägagångssätt att utvärdera din specifika situation genom BEDC-ramverket, vilket står för Business Model, Exposure Risk, Dependency on Organic Search och Competitive Position. Var och en av dessa fyra faktorer har olika vikt beroende på din webbplats egenskaper, och tillsammans skapar de en omfattande beslutsmatris som tar hänsyn till komplexiteten i modern digital publicering. Ramverket erkänner att det inte finns ett universellt svar—det som fungerar för en nyhetsorganisation kan vara helt fel för ett SaaS-företag, och det som gynnar ett etablerat varumärke kan skada en ny konkurrent. Genom att systematiskt utvärdera varje faktor kan du gå bortom känslomässiga reaktioner på AI och istället fatta datadrivna beslut i linje med dina affärsmål.

| Faktor | Rekommendation | Viktig aspekt |

|---|---|---|

| Business Model | Annonsfinansierade sajter bör vara försiktigare; prenumerationsmodeller kan vara mer tillåtande | Intäktsberoende av direkt användarengagemang vs. licensiering |

| Exposure Risk | Egen forskning och skyddat innehåll bör blockeras; massinnehåll kan vara mer öppet | Konkurrensfördel kopplad till unika insikter eller data |

| Organic Search Dependency | Hög beroendegrad (>40 % trafik) pekar på att tillåta Google-crawlers men blockera AI-assistenter | Balans mellan söksynlighet och skydd av AI-träningsdata |

| Competitive Position | Marknadsledare kan kosta på sig att blockera; nya aktörer kan vinna på AI-synlighet | Förstapartsfördel i AI-partnerskap vs. innehållsskydd |

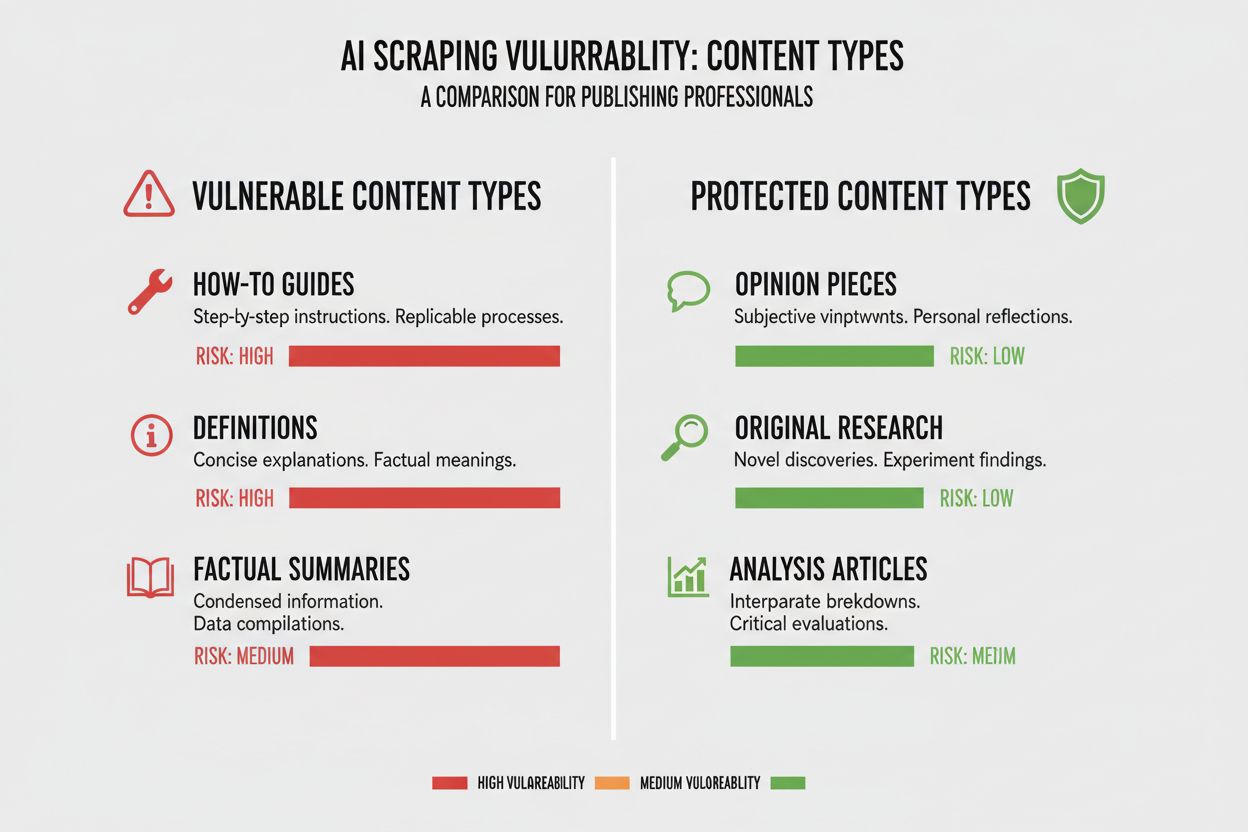

Olika typer av innehåll har mycket olika sårbarhet mot AI-crawling, och att förstå ditt innehålls position i detta spektrum är avgörande för att fatta rätt beslut. Egen forskning och skyddad data utgör dina mest värdefulla tillgångar och kräver starkast skydd, eftersom AI-modeller tränade på detta innehåll direkt kan konkurrera med din intäktsstrategi. Nyheter och färsk information utgör ett mellanting—värdet minskar snabbt över tid, men att indexeras av sökmotorer är fortfarande avgörande för trafiken, vilket skapar en spänning mellan söksynlighet och skydd mot AI-träning. Massingehåll som guider, handledningar och allmän referens är mycket mindre sårbart eftersom det finns överallt på internet och sannolikt inte är din främsta intäktskälla. Röststyrt och multimediainnehåll har ett naturligt skydd eftersom dagens AI-crawlers har svårt att utvinna meningsfullt värde från ljud och video, vilket gör dessa format säkrare mot AI-träning. Tidlöst utbildningsinnehåll och åsiktsartiklar ligger någonstans mittemellan, värdefulla för söktrafik men mindre direkt hotade av AI-konkurrens. Den viktigaste insikten är att din blockeringsstrategi bör stå i proportion till den konkurrensfördel ditt innehåll ger—skydda dina guldkorn men var öppen för crawlers för innehåll som gynnas av bred spridning.

Ditt beroende av organisk söktrafik är kanske den mest konkreta faktorn i AI-crawler-beslutet, eftersom det direkt kvantifierar avvägningen mellan söksynlighet och innehållsskydd. Webbplatser som får mer än 40 % av sin trafik från organisk sökning står inför en kritisk begränsning: att blockera AI-crawlers innebär ofta att även blockera eller begränsa Googles crawlers, vilket skulle slå hårt mot deras söksynlighet och trafik. Skillnaden mellan Google-Extended (som crawlar för AI-träning) och Googlebot (som crawlar för sökindexering) är avgörande här, eftersom du teoretiskt kan tillåta den ena och blockera den andra, även om det ökar den tekniska komplexiteten. En talande fallstudie från The New York Times illustrerar trafikinsatsen: publikation fick cirka 240 600 besök från AI-crawlers under en viss period, vilket visar AI-trafikens omfattning för stora publicister. Samtidigt visar Akamais data att blockering av crawlers leder till 96 % mindre hänvisningstrafik från dessa källor, vilket tyder på att AI-crawlers trafikbidrag är minimalt jämfört med traditionell sök. Crawl-to-referral-kvoten för de flesta AI-crawlers är extremt låg—ofta genererar mindre än 0,15 % av det crawlade innehållet återbesök—vilket betyder att blockering av dessa crawlers har minimal effekt på din faktiska användartrafik. För webbplatser med högt beroende av organisk sök måste beslutet att blockera AI-crawlers vägas mot risken att oavsiktligt blockera sökmotor-crawlers, vilket skulle vara mycket mer skadligt för din verksamhet.

Din intäktsmodell avgör i grunden hur du bör förhålla dig till AI-crawlers, eftersom olika intäktsstrategier skapar olika incitament kring innehållsspridning och skydd. Annonsfinansierade webbplatser står inför den tydligaste konflikten med AI-crawlers, eftersom deras intäkter bygger på att användare besöker sidan för att se annonser, och AI-modeller som sammanfattar innehållet minskar motivationen att klicka vidare. Prenumerationsbaserade modeller kan vara mer tillåtande mot AI-crawlers, då intäkterna kommer från direkta prenumerationer snarare än annonsvisningar, och viss AI-synlighet kan till och med driva på nya prenumerationer. Hybridmodeller som kombinerar annonser, prenumerationer och affiliateintäkter kräver mer nyanserad analys, eftersom blockering kan skydda annonsintäkter men skada affiliate- eller prenumerationstillväxten. En framväxande möjlighet är AI-referensmodellen, där webbplatser potentiellt kan tjäna pengar genom att tillåta AI-crawlers tillgång mot att få attribution och trafik—en modell som fortfarande utvecklas men kan förändra ekonomin kring innehållsspridning. För publicister som försöker förstå AI-crawlers fulla effekt på verksamheten erbjuder verktyg som AmICited.com viktiga övervakningsmöjligheter för att spåra var ditt innehåll citeras och används av AI-system, vilket ger insyn i det faktiska värdeutbytet. Nyckeln är att förstå din intäktsmodell så pass djupt att du kan förutse hur AI-crawlers påverkar varje intäktsström, snarare än att fatta generella beslut av princip.

När du har bestämt dig för att blockera vissa AI-crawlers krävs teknisk förståelse för både möjligheter och begränsningar i de verktyg som finns. Det vanligaste tillvägagångssättet är att använda robots.txt, en enkel textfil i webbplatsens rotkatalog som instruerar crawlers om vilka delar de får och inte får besöka. Robots.txt har dock en viktig begränsning: det är en frivillig standard som bygger på att crawlers följer dina instruktioner, och illvilliga eller aggressiva crawlers kan ignorera den helt. Här är ett exempel på hur du blockerar specifika AI-crawlers i din robots.txt-fil:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Utöver robots.txt bör du överväga att blockera dessa större AI-crawlers:

För starkare skydd implementerar många organisationer blockering på CDN-nivå via tjänster som Cloudflare, vilket blockerar trafik redan vid nätverksgränsen innan den når dina servrar och ger bättre prestanda och säkerhet. En dubbellagersstrategi som kombinerar robots.txt med blockering på CDN-nivå ger starkast skydd, då den fångar både respektfulla crawlers som följer robots.txt och aggressiva crawlers som ignorerar det. Observera att blockering på CDN-nivå kräver mer teknisk kompetens och kan få oönskade bieffekter om det inte konfigureras rätt, så detta passar bäst för organisationer med dedikerade tekniska resurser.

Den obekväma sanningen om att blockera AI-crawlers är att den faktiska trafikpåverkan ofta är mycket mindre än den känslomässiga reaktionen på AI-skrapning antyder, och data visar en mer nyanserad bild än många publicister förväntar sig. Enligt färska analyser står AI-crawlers vanligtvis för endast 0,15 % av total webbplatstrafik för de flesta publicister, vilket är förvånansvärt lite med tanke på hur mycket uppmärksamhet frågan får. Samtidigt har tillväxttakten för AI-crawler-trafik varit dramatisk, med vissa rapporter som visar 7x tillväxt år över år i förfrågningar från AI-crawlers, vilket tyder på att även om påverkan idag är liten är trenden brant. ChatGPT står för cirka 78 % av all AI-crawler-trafik, vilket gör OpenAI:s crawler dominerande, följt av mycket mindre trafik från andra AI-företag. Crawl-to-referral-kvoten är särskilt avslöjande: även om AI-crawlers kan begära miljontals sidor, genererar de faktiska återbesök i oftast mindre än 0,15 %, vilket innebär att blockering har minimal effekt på din verkliga användartrafik. Blockering av AI-crawlers minskar hänvisningstrafiken med 96 %, men eftersom den hänvisningstrafiken var minimal från början (ofta mindre än 0,15 % av total trafik) blir den totala effekten ofta försumbar. Detta skapar en paradox: att blockera AI-crawlers känns som en principiell ståndpunkt mot innehållsstöld, men den verkliga affärseffekten är ofta så liten att den knappt märks i din analys. Den egentliga frågan är inte om blockering kommer att skada din trafik—det gör det sällan—utan om tillåtande ger strategiska möjligheter eller risker som överväger det lilla trafikbidraget.

Din konkurrensposition på marknaden avgör i grunden hur du bör förhålla dig till AI-crawlers, eftersom optimal strategi för en marknadsledare skiljer sig dramatiskt från en ny aktör. Dominerande marknadsaktörer som The New York Times, Wall Street Journal och stora nyhetsorganisationer kan kosta på sig att blockera AI-crawlers eftersom deras varumärkeskännedom och direkta publikrelationer gör att de inte är beroende av AI-upptäckt för trafik. Växande aktörer och nischade publicister står inför ett annat övervägande: att indexeras av AI-system och synas i AI-genererade sammanfattningar kan vara ett av få sätt att vinna synlighet mot etablerade konkurrenter. Förstapartsfördel i AI-partnerskap kan vara betydande—publicister som förhandlar fram fördelaktiga avtal med AI-företag tidigt kan få bättre attribution, trafik eller licensavtal än de som väntar. Det finns också en subventionseffekt: när dominerande publicister blockerar AI-crawlers ökar incitamentet för AI-företag att förlita sig mer på innehåll från publicister som tillåter crawling, vilket potentiellt ger dessa aktörer oproportionerlig synlighet i AI-system. Detta skapar en konkurrensdynamik där blockering faktiskt kan försämra din position om dina konkurrenter tillåter crawlers och därmed får AI-synlighet. Att förstå din position i konkurrenslandskapet är avgörande för att förutse hur ditt beslut påverkar din marknadsställning jämfört med konkurrenter.

Att fatta beslutet att blockera eller tillåta AI-crawlers kräver en systematisk utvärdering av din specifika situation mot konkreta kriterier. Använd denna checklista för att vägleda din beslutsprocess:

Bedömning av innehållsexponering

Analys av trafikkomposition

Utvärdering av marknadsposition

Bedömning av intäktsrisk

Utöver denna initiala bedömning, implementera kvartalsvisa översyner av din AI-crawler-strategi, eftersom landskapet förändras snabbt och det optimala beslutet idag kan ändras inom några månader. Använd verktyg som AmICited.com för att spåra var ditt innehåll citeras och används av AI-system, vilket ger dig konkreta data kring värdeutbytet för ditt innehåll. Den viktigaste insikten är att detta beslut inte bör tas en gång och sedan glömmas bort—det kräver kontinuerlig utvärdering och anpassning i takt med att AI-landskapet mognar och dina affärsförutsättningar förändras.

En betydande framväxande möjlighet som kan förändra hela AI-crawler-landskapet är Cloudflares pay-per-crawl-funktion, som introducerar en tillståndsbaserad internetmodell där webbplatsägare kan tjäna pengar på AI-crawler-åtkomst istället för att bara blockera eller tillåta den. Detta tillvägagångssätt erkänner att AI-företag hämtar värde från att crawla ditt innehåll, och istället för att hamna i en konflikt om blockering kan du istället förhandla om ersättning för åtkomsten. Modellen bygger på kryptografisk verifiering för att säkerställa att endast auktoriserade crawlers får åtkomst till ditt innehåll, vilket förhindrar obehörig skrapning samtidigt som legitima AI-företag kan betala för tillgång. Detta skapar granulär kontroll över vilka crawlers som får tillgång till vilket innehåll, så att du kan tjäna pengar på värdefullt innehåll samtidigt som du är öppen för sökmotorer och andra fördelaktiga crawlers. Pay-per-crawl-modellen möjliggör även AI-revision, där du kan se exakt vilket innehåll som crawlas, när det crawlas och av vem, vilket ger transparens som är omöjlig med traditionell blockering. För publicister som implementerar denna strategi blir AmICited.com:s övervakningsmöjligheter ännu mer värdefulla, då du kan spåra inte bara var ditt innehåll syns i AI-system, utan även verifiera att du får korrekt ersättning för användningen. Även om modellen fortfarande är ny och användningen begränsad, representerar den ett potentiellt mer sofistikerat tillvägagångssätt än det binära valet mellan blockering och tillåtelse—ett som erkänner det ömsesidiga värdet i relationen mellan publicister och AI-företag samtidigt som du skyddar dina intressen genom avtal och tekniska mekanismer.

Att blockera AI-crawlers hindrar dem från att komma åt ditt innehåll via robots.txt eller blockering på CDN-nivå, vilket skyddar ditt innehåll från att användas i AI-träning. Att tillåta crawlers innebär att ditt innehåll kan indexeras av AI-system och potentiellt synas i AI-genererade sammanfattningar och svar. Valet beror på din innehållstyp, intäktsmodell och konkurrensposition.

Att blockera AI-crawlers påverkar inte din SEO direkt om du bara blockerar AI-specifika crawlers som GPTBot och tillåter Googlebot. Om du däremot råkar blockera Googlebot kommer dina sökrankningar att påverkas kraftigt negativt. Nyckeln är att använda granulär kontroll för att bara blockera AI-tränings-crawlers samtidigt som du bevarar åtkomst för sökmotorer.

Ja, du kan använda robots.txt för att blockera specifika crawlers baserat på deras user-agent-sträng medan du tillåter andra. Till exempel kan du blockera GPTBot men tillåta Google-Extended, eller tvärtom. Detta granulära tillvägagångssätt gör att du kan skydda ditt innehåll från vissa AI-företag men förbli synlig för andra.

robots.txt är en frivillig standard som bygger på att crawlers respekterar dina instruktioner—vissa AI-företag ignorerar det. Blockering på CDN-nivå (som Cloudflare) blockerar trafik vid nätverksgränsen innan den når dina servrar och ger starkare efterlevnad. En dubbellagersstrategi med båda metoderna ger bäst skydd.

Du kan kontrollera serverloggarna efter user-agent-strängar från kända AI-crawlers som GPTBot, CCBot och Claude-Web. Verktyg som AmICited.com erbjuder övervakningsfunktioner för att spåra var ditt innehåll syns i AI-system och hur ofta det besöks av AI-crawlers.

Pay-per-crawl är en framväxande modell där AI-företag betalar för tillgång till ditt innehåll. Även om det fortfarande är i beta med begränsad användning representerar det en potentiell ny intäktsström. Lönsamheten beror på mängden AI-crawler-trafik och de priser AI-företagen är villiga att betala.

Om en AI-crawler ignorerar dina robots.txt-direktiv, implementera blockering på CDN-nivå via tjänster som Cloudflare. Du kan också konfigurera din server att returnera 403-fel till kända AI-crawler user-agents. Vid återkommande överträdelser, överväg juridiska åtgärder eller kontakta AI-företaget direkt.

Se över din AI-crawler-strategi kvartalsvis eftersom landskapet förändras snabbt. Övervaka förändringar i AI-crawler-trafik, nya crawlers på marknaden och skiften i din konkurrensposition. Använd verktyg som AmICited.com för att spåra hur ditt innehåll används av AI-system och justera din strategi därefter.

Spåra var ditt innehåll syns i AI-genererade svar och förstå effekten av AI-crawlers på ditt företag med AmICited.coms heltäckande övervakningsplattform.

Omfattande guide till AI-crawlers 2025. Identifiera GPTBot, ClaudeBot, PerplexityBot och 20+ andra AI-botar. Lär dig blockera, tillåta eller övervaka crawlers m...

Förstå hur AI-crawlers som GPTBot och ClaudeBot fungerar, deras skillnader från traditionella sökmotor-crawlers och hur du optimerar din webbplats för synlighet...

Lär dig vilka AI-crawlers du ska tillåta eller blockera i din robots.txt. Omfattande guide som täcker GPTBot, ClaudeBot, PerplexityBot och 25+ AI-crawlers med k...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.