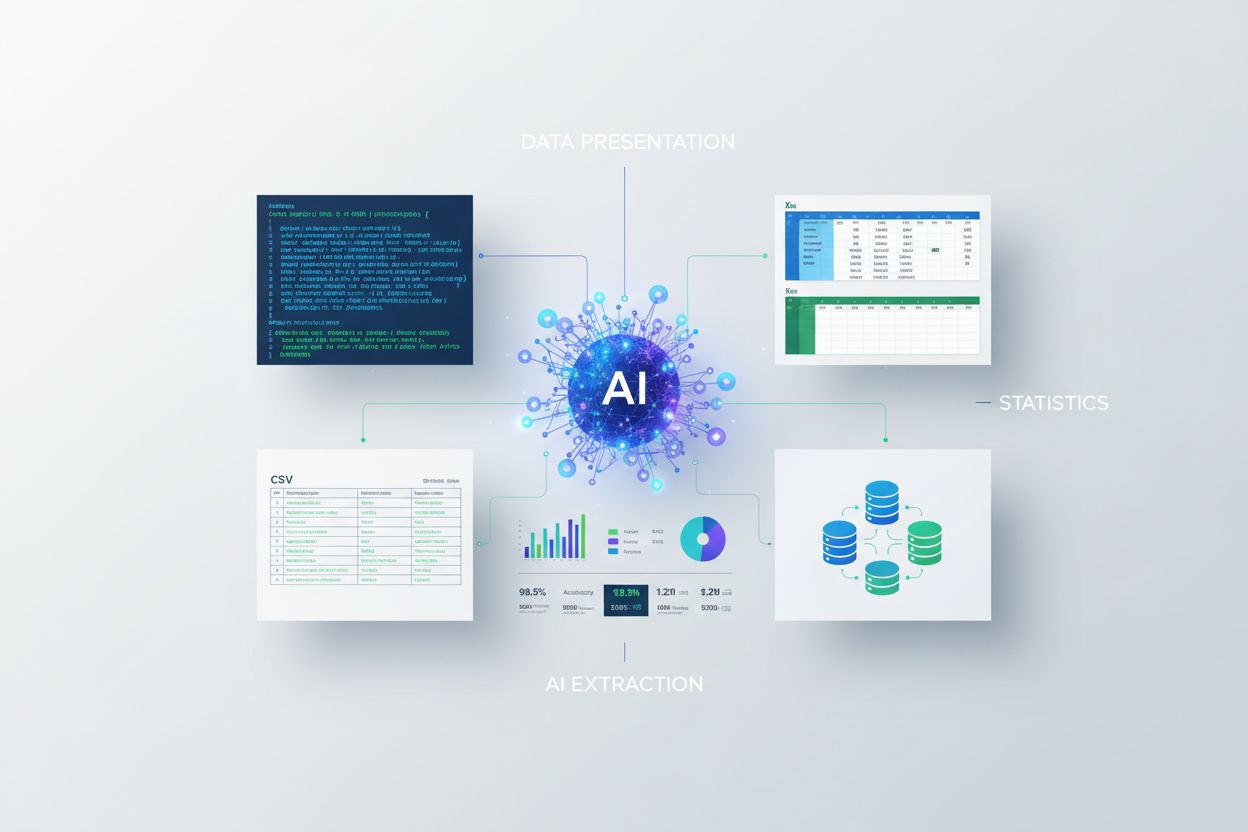

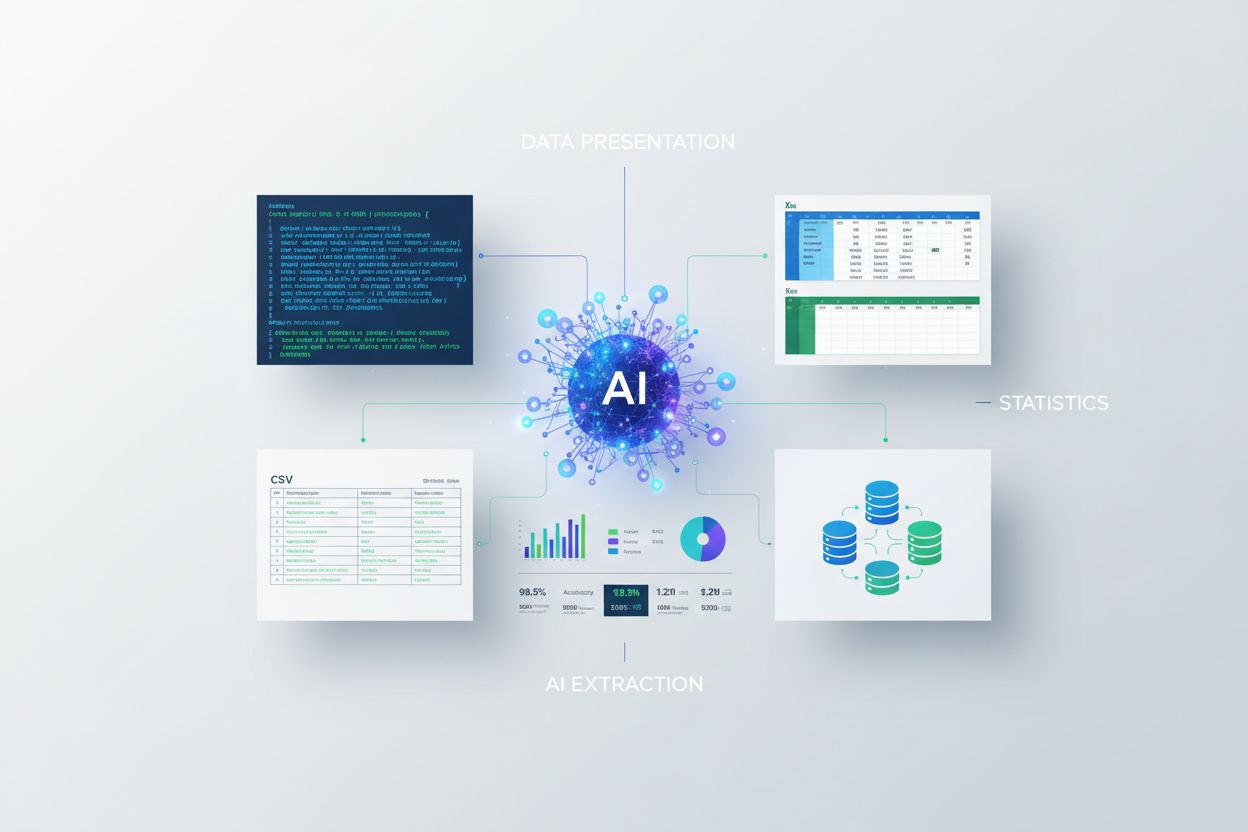

Presentera statistik för AI-extraktion

Lär dig hur du presenterar statistik för AI-extraktion. Upptäck bästa praxis för dataformatering, JSON kontra CSV och hur du säkerställer att din data är AI-red...

Upptäck varför datakvalitet är viktigare än mängd för AI-modeller. Lär dig strategier för resursallokering, kostnadsimplikationer och praktiska ramverk för att optimera din investering i AI-träningsdata.

Den konventionella visdomen inom maskininlärning har länge varit “mer data är alltid bättre.” Ny forskning utmanar dock denna uppfattning med övertygande bevis på att datakvalitet väger betydligt tyngre än mängd när det gäller AI-modellers prestanda. En arxiv-studie från 2024 (2411.15821) som undersökte små språkmodeller fann att träningsdatakvalitet spelar en mycket större roll än ren volym, och avslöjar att relationen mellan datamängd och modellens noggrannhet är mycket mer nyanserad än man tidigare trott. Kostnadsimplikationerna är omfattande: organisationer som satsar mycket på datainsamling utan att prioritera kvalitet slösar ofta resurser på lagring, bearbetning och beräkningskostnader utan att uppnå motsvarande förbättringar i modellprestanda.

Datakvalitet är inte ett monolitiskt begrepp utan snarare ett mångdimensionellt ramverk som omfattar flera kritiska aspekter. Noggrannhet syftar på hur korrekt data representerar verkligheten och om etiketter är rätt tilldelade. Konsekvens säkerställer att data följer enhetliga format och standarder över hela datamängden. Fullständighet mäter om all nödvändig information finns utan betydande luckor eller saknade värden. Relevans avgör om data direkt adresserar det problem som AI-modellen är avsedd att lösa. Tillförlitlighet indikerar datakällans trovärdighet och dess stabilitet över tid. Slutligen representerar brus oönskade variationer eller fel som kan vilseleda modellträning. Att förstå dessa dimensioner hjälper organisationer att strategiskt prioritera sina insatser för datakuration.

| Kvalitetsdimension | Definition | Påverkan på AI |

|---|---|---|

| Noggrannhet | Korrekthet av etiketter och datarepresentation | Påverkar direkt modellens pålitlighet; felmärkta data orsakar systematiska fel |

| Konsekvens | Enhetlig formatering och standardiserad datastruktur | Möjliggör stabil träning; inkonsekvenser förvirrar inlärningsalgoritmer |

| Fullständighet | Närvaro av all nödvändig information utan luckor | Saknade värden minskar effektiv träningsdata; påverkar generalisering |

| Relevans | Data adresserar direkt problemområdet | Mycket relevant data överträffar stora mängder generisk data |

| Tillförlitlighet | Trovärdighet hos datakällor och stabilitet | Opålitliga källor introducerar systematiska bias; påverkar modellens robusthet |

| Brus | Oönskade variationer och mätfel | Kontrollerat brus ökar robusthet; överdrivet brus försämrar prestanda |

Strävan efter datamängd utan kvalitetskontroller skapar en kedja av problem som sträcker sig långt bortom modellprestandamått. Forskning av Rishabh Iyer visar att experiment med etikettbrus leder till kraftiga tapp i noggrannhet—felmärkta data försämrar aktivt modellprestandan istället för att bara vara neutrala träningsdata. Utöver noggrannhetsproblem möter organisationer ökande lagrings- och bearbetningskostnader för datamängder som inte förbättrar modellresultat, tillsammans med betydande miljökostnader från onödiga beräkningsresurser. Medicinsk bilddiagnostik ger ett allvarligt exempel från verkligheten: en datamängd med tusentals felmärkta röntgenbilder kan träna en modell som säkert gör farliga diagnostiska fel, vilket potentiellt kan skada patienter. Den falska ekonomin i att samla billig, lågkvalitativ data blir tydlig när man räknar in kostnaderna för omträning, felsökning och driftsmisslyckanden som orsakas av dåliga träningsdata.

Domänspecifik kvalitet överträffar konsekvent generisk volym i praktiska AI-tillämpningar. Tänk på en sentimentanalysmodell för filmrecensioner: en noggrant utvald datamängd med 10 000 filmrecensioner kommer att prestera avsevärt bättre än en generisk sentimentdatamängd med 100 000 exempel hämtade från finansiella nyheter, sociala medier och produktrecensioner. Relevansen av träningsdata för det specifika problemområdet är mycket viktigare än ren volym, eftersom modeller lär sig mönster specifika för sin träningsdistribution. När data saknar relevans för målområdet lär modellen sig felaktiga samband och misslyckas med att generalisera till verkliga användningsfall. Organisationer bör prioritera att samla mindre datamängder som exakt matchar deras problemområde istället för att ackumulera massiva generiska datamängder som kräver omfattande filtrering och förbearbetning.

Den optimala strategin för data ligger inte i någon av ytterligheterna utan i att hitta “Guldlocks-zonen"—den punkt där datamängd och kvalitet balanseras lämpligt för det aktuella problemet. För lite data, även om den är perfekt märkt, lämnar modeller underanpassade och oförmögna att fånga komplexa mönster i verkligheten. Omvänt leder för mycket data med kvalitetsproblem till slöseri med beräkningsresurser och instabil träning. Arxiv-studien visar denna balans konkret: minimal duplicering förbättrade noggrannheten med 0,87% vid 25% duplicering, medan överdriven duplicering vid 100% orsakade en katastrofal 40% tapp i noggrannhet. Den idealiska balansen beror på flera faktorer, inklusive algoritmtyp, problemkomplexitet, tillgängliga beräkningsresurser och den naturliga variationen i din domän. Datadistributionen bör återspegla verklig variation snarare än artificiell enhetlighet, eftersom det lär modeller att hantera den variation de möter i produktion.

All tillagd data är inte likvärdig—skillnaden mellan gynnsam augmentering och skadlig degradering är avgörande för en effektiv datastrategi. Kontrollerade störningar och augmenteringstekniker förbättrar modellens robusthet genom att lära algoritmer hantera verkliga variationer som små rotationer, ljusförändringar eller mindre variationer i etiketter. MNIST-datamängden för handskrivna siffror visar detta: modeller tränade med augmenterade versioner (roterade, skalade eller lätt förvrängda siffror) generaliserar bättre till verkliga handstilar än de som bara tränats på originalbilder. Kraftig korruption—slumpmässigt brus, systematiska felmärkningar eller injicering av irrelevant data—försämrar däremot aktivt prestandan och slösar resurser. Den avgörande skillnaden ligger i avsikt: augmentering är avsiktligt utformad för att spegla realistiska variationer, medan skräpdata är urskillningslöst brus som förvirrar inlärningsalgoritmer. Organisationer måste skilja mellan dessa tillvägagångssätt när de utökar sina datamängder.

För organisationer med begränsade resurser erbjuder aktivt lärande en kraftfull lösning som minskar databehovet samtidigt som modellprestandan bibehålls eller förbättras. Istället för att passivt samla in och märka all tillgänglig data identifierar algoritmer för aktivt lärande vilka oetiketterade exempel som skulle vara mest informativa för modellen, vilket drastiskt minskar behovet av mänsklig märkning. Denna metod gör det möjligt för organisationer att uppnå stark modellprestanda med betydligt mindre märkt data genom att fokusera mänsklig insats på de mest betydelsefulla fallen. Aktivt lärande demokratiserar AI-utveckling genom att göra den tillgänglig för team utan stora märkningsbudgetar, så de kan bygga effektiva modeller med strategiskt dataval snarare än stor volym. Genom att lära sig effektivt med mindre data kan organisationer iterera snabbare, sänka kostnader och satsa resurser på kvalitetskontroll istället för oändlig datainsamling.

Strategisk resursallokering kräver att prioritera kvalitet framför kvantitet i databeslut. Organisationer bör investera i robusta datavalideringsflöden som fångar fel innan de når träningsdatamängder, och införa automatiska kontroller för konsekvens, fullständighet och noggrannhet. Dataprofilverktyg kan identifiera kvalitetsproblem i stor skala och avslöja mönster av felmärkning, saknade värden eller irrelevanta exempel som bör åtgärdas innan träning. Implementering av aktivt lärande minskar mängden data som kräver mänsklig granskning men säkerställer att granskade exempel är maximalt informativa. Kontinuerlig övervakning av modellprestanda i produktion visar om kvalitetsproblem i träningsdata yttrar sig som verkliga fel, vilket möjliggör snabba återkopplingsslingor för förbättring. Den optimala strategin balanserar datainsamling med rigorös kurering och erkänner att 1 000 perfekt märkta exempel ofta överträffar 100 000 brusiga både vad gäller resultat och totala ägandekostnader.

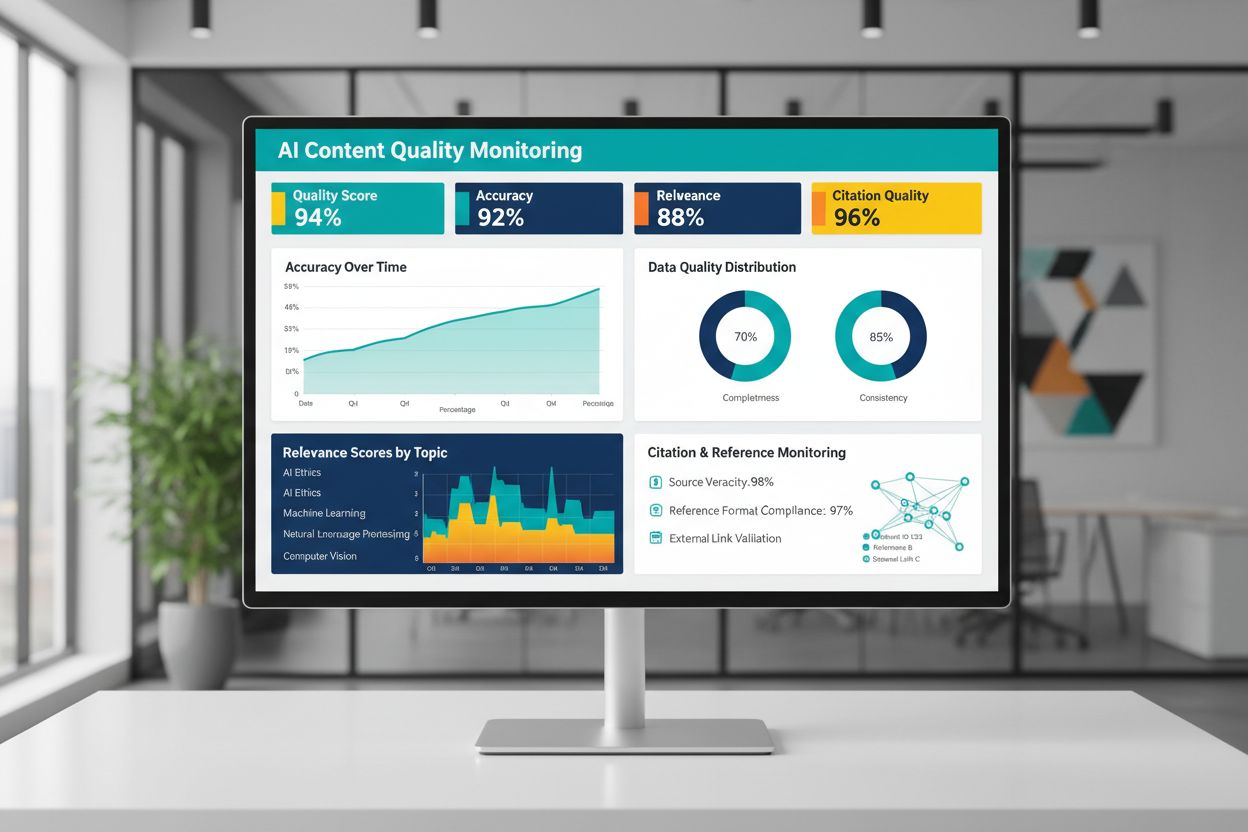

Kvaliteten på AI-genererat eller AI-tränat innehåll beror fundamentalt på träningsdatans kvalitet, vilket gör kontinuerlig övervakning av AI-resultat avgörande för att upprätthålla tillförlitlighet. Plattformar som AmICited.com möter detta kritiska behov genom att övervaka AI-svar och spåra citatkvalitet—en direkt indikator på innehållskvalitet och trovärdighet. När AI-system tränas på lågkvalitativa data med dåliga citat eller felaktig information, ärver deras resultat dessa brister och kan potentiellt sprida felinformation i stor skala. Övervakningsverktyg bör spåra inte bara noggrannhetsmått utan även relevans, konsekvens och förekomsten av underbyggande bevis för påståenden som AI-system gör. Organisationer som använder AI måste införa återkopplingsslingor som fångar när resultaten avviker från förväntade kvalitetsstandarder, så att snabb omträning eller datakorrigering kan göras. Investeringen i övervakningsinfrastruktur betalar sig genom att fånga kvalitetsförsämring tidigt, innan det påverkar användare eller skadar organisationens trovärdighet.

Att omsätta principerna för datakvalitet i praktiken kräver ett strukturerat tillvägagångssätt som börjar med utvärdering och fortskrider genom mätning och iteration. Börja med att utvärdera din nuvarande grundnivå—förstå befintlig kvalitet på träningsdata genom granskningar och profilering. Definiera tydliga kvalitetsmått anpassade till ditt användningsområde, vare sig det gäller noggrannhetströsklar, konsekvensstandarder eller relevanskriterier. Inför datastyrningsrutiner som fastställer ägarskap, valideringsprocedurer och kvalitetskontroller innan data går in i träningsflöden. Börja med mindre, noggrant utvalda datamängder istället för att direkt bearbeta massiva volymer, så att du kan etablera kvalitetsstandarder och processer i hanterbar skala. Mät förbättringar noggrant genom att jämföra modellprestanda före och efter kvalitetsinsatser, vilket ger evidensbaserat underlag för fortsatt investering. Skala gradvis när du förfinar dina processer och utöka datainsamlingen först när du bevisat att kvalitetsförbättringar ger reella resultat.

Nej. Ny forskning visar att datakvalitet ofta är viktigare än mängd. Dålig kvalitet, felmärkta eller irrelevanta data kan aktivt försämra modellens prestanda, även i stor skala. Nyckeln är att hitta rätt balans mellan tillräckligt med data för effektiv träning och bibehålla höga kvalitetsstandarder.

Datakvalitet omfattar flera dimensioner: noggrannhet (korrekta etiketter), konsekvens (enhetlig formatering), fullständighet (inga saknade värden), relevans (överensstämmelse med ditt problem), tillförlitlighet (pålitliga källor) och brusnivåer. Definiera mätvärden specifika för ditt användningsområde och implementera valideringskontroller för att fånga kvalitetsproblem innan träning.

Den idealiska storleken beror på algoritmens komplexitet, problemtyp och tillgängliga resurser. Istället för att sträva efter maximal storlek, sikta på 'Guldlocks-zonen'—tillräckligt med data för att fånga verkliga mönster utan att överbelastas med irrelevanta eller redundanta exempel. Börja smått med noga utvalda data och skala gradvis utifrån prestandaförbättringar.

Dataaugmentering tillämpar kontrollerade förändringar (rotationer, små förvrängningar, ljusvariationer) som bevarar den sanna etiketten samtidigt som modeller lär sig hantera verkliga variationer. Detta skiljer sig från skräpdata—augmentering är avsiktlig och återspeglar realistiska variationer, vilket gör modeller mer robusta för verkliga förhållanden.

Aktivt lärande identifierar vilka oetiketterade exempel som skulle vara mest informativa för modellen att lära sig från, vilket drastiskt minskar märkningsbördan. Istället för att märka all tillgänglig data, fokuserar du mänsklig insats på de mest betydelsefulla exemplen och uppnår stark prestanda med betydligt mindre märkt data.

Prioritera kvalitet framför kvantitet. Investera i datavalideringsflöden, profilverktyg och styrprocesser som säkerställer högkvalitativ träningsdata. Forskning visar att 1 000 perfekt märkta exempel ofta överträffar 100 000 brusiga i både modellprestanda och totala ägandekostnader.

Dålig kvalitet på data leder till flera kostnader: omträning av modell, felsökning, driftsmisslyckanden, lagringskostnader och slöseri med beräkningsresurser. Inom kritiska områden som medicinsk bildbehandling kan lågkvalitativ träningsdata resultera i farliga fel. Den falska ekonomin med billig, lågkvalitativ data blir tydlig när man räknar in dessa dolda kostnader.

Inför kontinuerlig övervakning av AI-resultat som spårar noggrannhet, relevans, konsekvens och citatkvalitet. Plattformar som AmICited övervakar hur AI-system refererar information och spårar citatnoggrannhet. Upprätta återkopplingsslingor som kopplar produktionsprestanda tillbaka till träningsdatakvalitet för snabb förbättring.

Följ hur AI-system refererar till ditt varumärke och säkerställ innehållsnoggrannhet med AmICiteds AI-övervakningsplattform. Förstå kvaliteten på AI-genererade svar om ditt företag.

Lär dig hur du presenterar statistik för AI-extraktion. Upptäck bästa praxis för dataformatering, JSON kontra CSV och hur du säkerställer att din data är AI-red...

Upptäck varför AI-trafik konverterar 23x bättre än organisk sök. Lär dig optimera för AI-plattformar och mäta verklig ROI från AI-drivna besökare.

Upptäck hur AI-system utvärderar innehållskvalitet bortom traditionella SEO-mätvärden. Lär dig om semantisk förståelse, faktamässig korrekthet och kvalitetssign...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.