Förebygga AI-synlighetskriser: Proaktiva Strategier

Lär dig hur du förebygger AI-synlighetskriser med proaktiv övervakning, tidiga varningssystem och strategiska responsprotokoll. Skydda ditt varumärke i AI-eran....

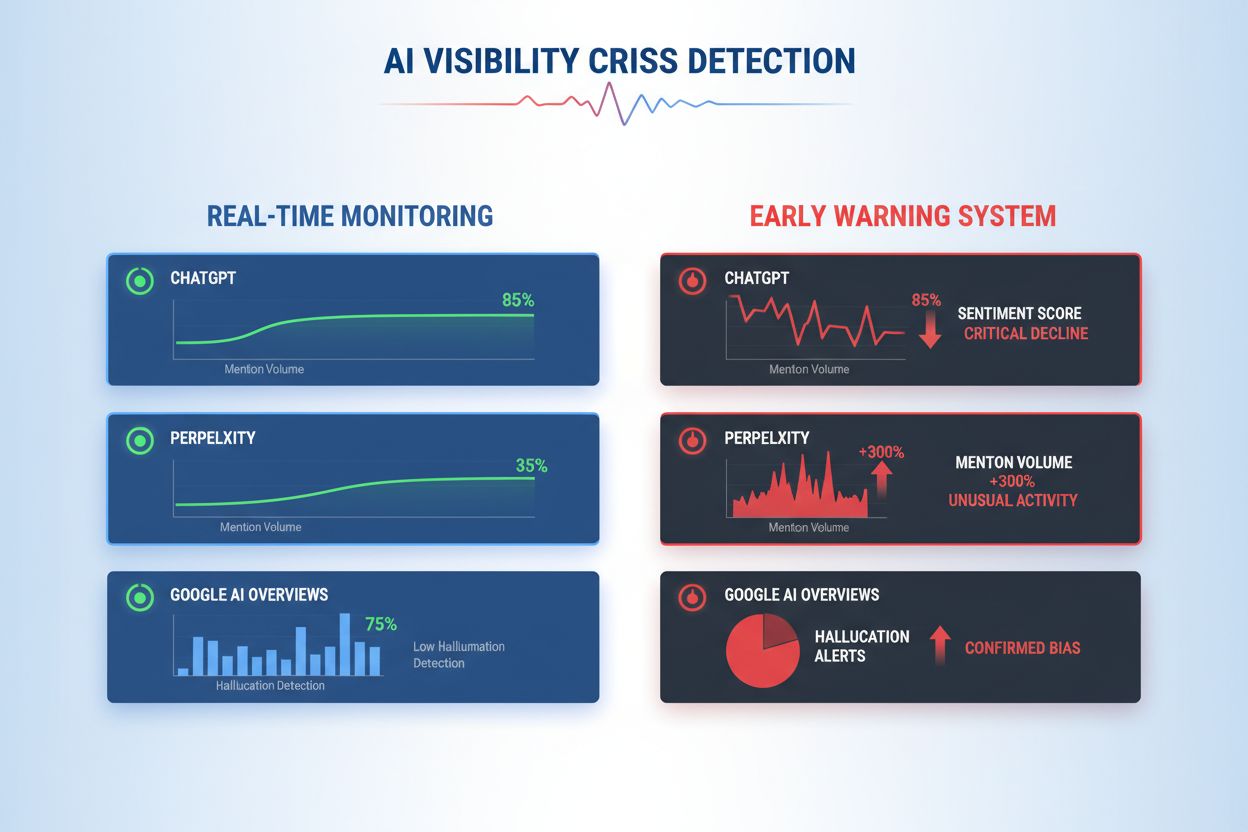

Lär dig upptäcka AI-synlighetskriser i ett tidigt skede med realtidsövervakning, sentimentanalys och avvikelsedetektering. Upptäck varningstecken och bästa praxis för att skydda ditt varumärkes rykte i AI-drivna sökningar.

En AI-synlighetskris uppstår när artificiella intelligenssystem producerar felaktiga, vilseledande eller skadliga resultat som skadar varumärkets rykte och urholkar allmänhetens förtroende. Till skillnad från traditionella PR-kriser som härrör från mänskliga beslut eller handlingar, uppstår AI-synlighetskriser i skärningspunkten mellan träningsdatakvalitet, algoritmiska fördomar och realtidsgenererat innehåll—vilket gör dem grundläggande svårare att förutse och kontrollera. Färsk forskning visar att 61 % av konsumenterna har minskat sitt förtroende för varumärken efter att ha stött på AI-hallucinationer eller felaktiga AI-svar, medan 73 % anser att företag bör hållas ansvariga för vad deras AI-system säger offentligt. Dessa kriser sprids snabbare än traditionell desinformation eftersom de uppfattas som auktoritära, kommer från betrodda varumärkeskanaler och kan påverka tusentals användare samtidigt innan mänsklig intervention är möjlig.

Effektiv detektering av AI-synlighetskriser kräver övervakning av både inmatningar (data, konversationer och träningsmaterial som matar dina AI-system) och utmatningar (vad din AI faktiskt säger till kunder). Inmatningsövervakning granskar sociala lyssningsdata, kundfeedback, träningsdatamängder och externa informationskällor för partiskhet, desinformation eller problematiska mönster som kan förorena AI-svar. Utmatningsövervakning spårar vad dina AI-system faktiskt genererar—de svar, rekommendationer och innehåll de producerar i realtid. När en stor finansiell tjänsteleverantörs chatbot började rekommendera kryptoinvesteringar baserat på partisk träningsdata, spreds krisen på sociala medier inom några timmar, vilket påverkade aktiekursen och ledde till regulatorisk granskning. På liknande sätt, när ett hälso- och sjukvårds-AI-system gav föråldrad medicinsk information från korrupta träningsdatamängder, tog det tre dagar att identifiera grundorsaken, under vilken tusentals användare fick potentiellt skadlig vägledning. Klyftan mellan inmatningskvalitet och utmatningsnoggrannhet skapar en blind fläck där kriser kan växa obemärkt.

| Aspekt | Inmatningsövervakning (Källor) | Utmatningsövervakning (AI-svar) |

|---|---|---|

| Vad som spåras | Sociala medier, bloggar, nyheter, recensioner | ChatGPT, Perplexity, Google AI-svar |

| Detekteringsmetod | Nyckelordsspårning, sentimentanalys | Promptfrågor, svaranalys |

| Krisindikator | Virala negativa inlägg, trendande klagomål | Hallucinationer, felaktiga rekommendationer |

| Responstid | Timmar till dagar | Minuter till timmar |

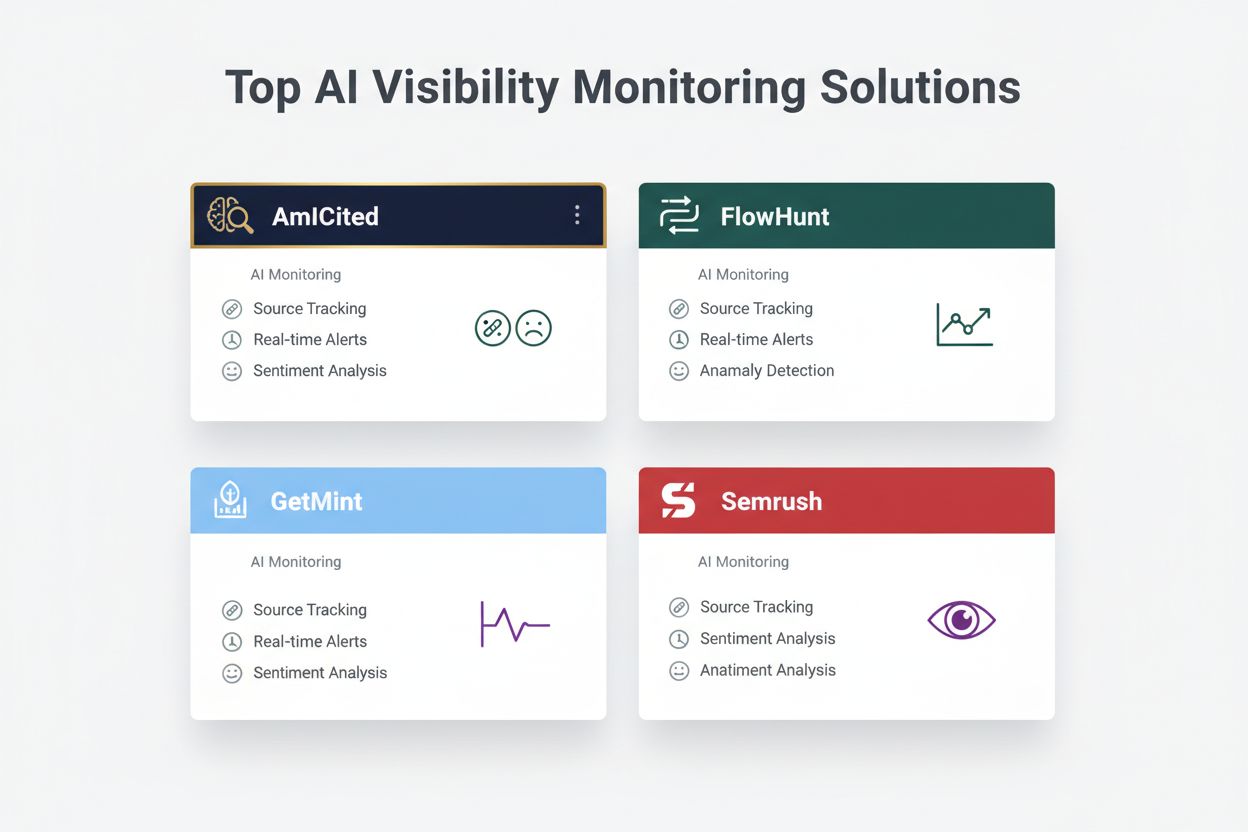

| Primära verktyg | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Kostnadsintervall | $500-$5 000/månad | $800-$3 000/månad |

Organisationer bör införa kontinuerlig övervakning för dessa specifika tidiga varningstecken som indikerar en begynnande AI-synlighetskris:

Modern detektering av AI-synlighetskriser bygger på sofistikerade tekniska grunder som kombinerar naturlig språkbehandling (NLP), maskininlärningsalgoritmer och realtidsavvikelsedetektering. NLP-system analyserar den semantiska betydelsen och kontexten i AI-utmatningar, inte bara nyckelord, vilket möjliggör detektering av subtil desinformation som traditionella övervakningsverktyg missar. Sentimentanalysalgoritmer bearbetar tusentals sociala omnämnanden, kundrecensioner och supportärenden samtidigt, beräknar sentimentpoäng och identifierar känslomässiga skiftningar som signalerar begynnande kriser. Maskininlärningsmodeller fastställer baslinjemönster för normalt AI-beteende och flaggar sedan avvikelser som överskrider statistiska tröskelvärden—till exempel när svarens noggrannhet sjunker från 94 % till 78 % inom ett visst ämnesområde. Realtidsbehandling gör att organisationer kan identifiera och svara på kriser inom minuter snarare än timmar, vilket är avgörande när AI-utmatningar når tusentals användare direkt. Avancerade system använder ensemblemetoder som kombinerar flera detekteringsalgoritmer, minskar falska positiva men bibehåller känslighet för verkliga hot, och integrerar återkopplingsslingor där mänskliga granskare kontinuerligt förbättrar modellernas noggrannhet.

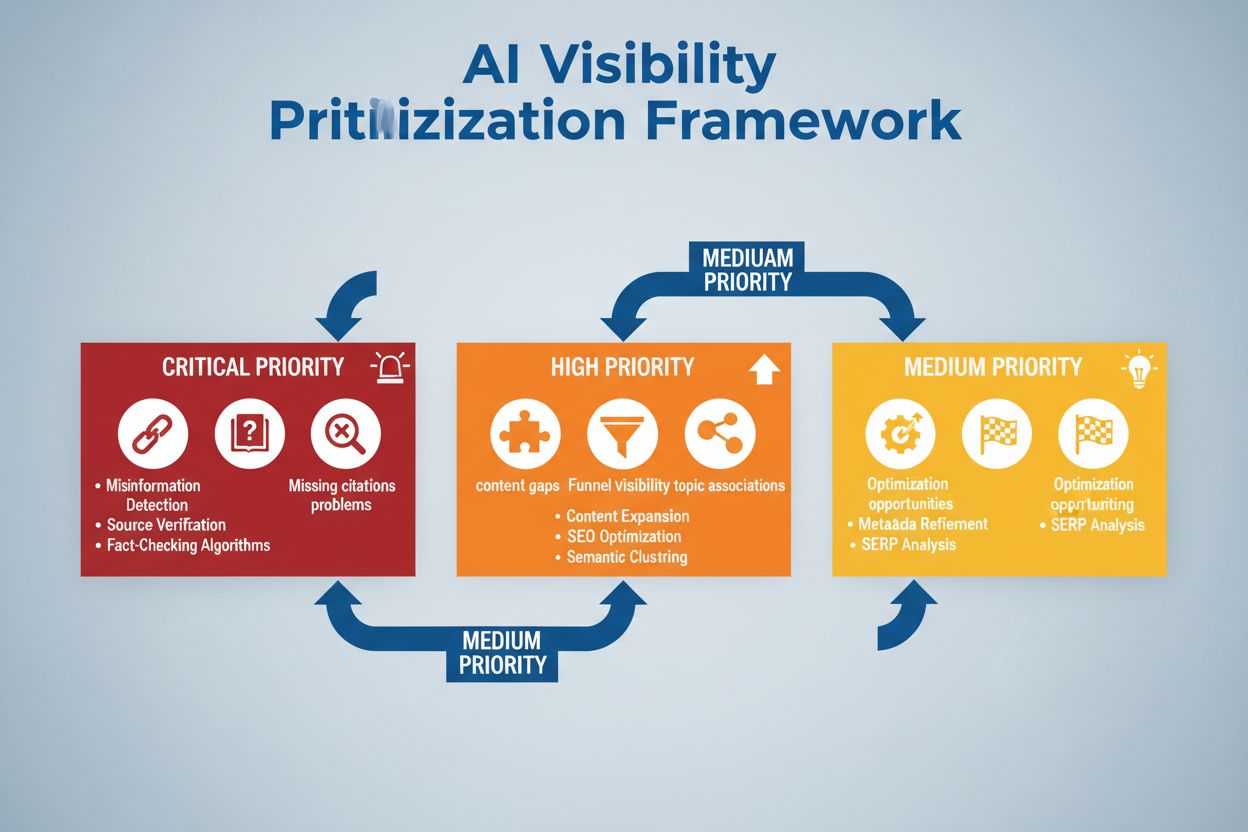

Effektiv detektering kräver att man definierar specifika sentimenttrösklar och utlösningspunkter anpassade till din organisations risktolerans och branschstandarder. Ett finansiellt företag kan sätta en tröskel där varje AI-investeringsrekommendation som får fler än 50 negativa omnämnanden inom 4 timmar utlöser omedelbar manuell granskning och eventuell systemavstängning. Sjukvårdsorganisationer bör ha lägre trösklar—kanske 10–15 negativa omnämnanden om medicinsk korrekthet—givet de allvarligare konsekvenserna av hälsofelinformation. Eskalationsflöden bör ange vem som notifieras på varje allvarlighetsnivå: ett 20-procentigt noggrannhetsfall kan utlösa meddelande till teamledare, medan ett 40-procentigt fall omedelbart eskalerar till krisledning och jurister. Praktisk implementering innebär att definiera svarsmallar för vanliga scenarier (t.ex. “AI-systemet gav föråldrad information på grund av träningsdataproblem”), fastställa kommunikationsprotokoll med kunder och tillsynsmyndigheter samt skapa beslutsträd som guidar åtgärder genom triage och åtgärdssteg. Organisationer bör även etablera mätramar som spårar detekteringshastighet (tid från krisens uppkomst till identifiering), responstid (identifiering till åtgärd) och effektivitet (andel kriser upptäckta innan betydande användarpåverkan).

Avvikelsedetektering utgör den tekniska ryggraden i proaktiv krisidentifiering genom att etablera normala beteendebaslinjer och flagga betydande avvikelser. Organisationer fastställer först baslinjemått i flera dimensioner: typiska noggrannhetsnivåer för olika AI-funktioner (t.ex. 92 % för produktrekommendationer, 87 % för kundtjänstsvar), normal svarslatens (t.ex. 200–400 ms), förväntad sentimentfördelning (t.ex. 70 % positivt, 20 % neutralt, 10 % negativt) och standardmönster för användarengagemang. Avvikelsealgoritmer jämför sedan kontinuerligt realtidsresultat mot dessa baslinjer med statistiska metoder som z-poängsanalys (flaggar värden mer än 2–3 standardavvikelser från medelvärdet) eller isolation forests (identifierar avvikande mönster i flerdimensionell data). Om en rekommendationsmotor normalt genererar 5 % falska positiva men plötsligt stiger till 18 %, larmar systemet omedelbart analytiker för att undersöka potentiell datakorruption eller modellförskjutning. Kontextuella avvikelser är lika viktiga som statistiska—ett AI-system kan ha normala noggrannhetsmått men ändå generera utmatningar som bryter mot regelefterlevnad eller etiska riktlinjer, vilket kräver domänspecifika detekteringsregler utöver ren statistik. Effektiv avvikelsedetektering kräver regelbunden omkalibrering av baslinjer (veckovis eller månadsvis) för att ta hänsyn till säsongsvariationer, produktförändringar och förändrat användarbeteende.

Omfattande övervakning kombinerar social listening, AI-utmatningsanalys och dataaggregering i enhetliga synlighetssystem som förhindrar blinda fläckar. Social listening-verktyg spårar omnämnanden av ditt varumärke, produkter och AI-funktioner över sociala medier, nyhetssajter, forum och recensionsplattformar, och fångar tidiga sentimentförändringar innan de blir utbredda kriser. Samtidigt loggar och analyserar AI-utmatningsövervakning varje svar din AI genererar, kontrollerar noggrannhet, konsistens, regelefterlevnad och sentiment i realtid. Dataaggregeringsplattformar normaliserar dessa olika datakällor—konverterar sentimentpoäng, noggrannhetsmått, användarklagomål och systemprestandadata till jämförbara format—så att analytiker kan se korrelationer som isolerad övervakning skulle missa. En enhetlig instrumentpanel visar nyckeltal: aktuella sentimenttrender, noggrannhetsnivåer per funktion, volym av användarklagomål, systemprestanda och avvikelselarm, allt uppdaterat i realtid med historisk kontext. Integration med dina befintliga verktyg (CRM-system, supportplattformar, analysdashboards) säkerställer att krissignaler når beslutsfattare automatiskt istället för att kräva manuell databehandling. Organisationer som implementerar detta rapporterar 60–70 % snabbare krisdetektering jämfört med manuell övervakning och betydligt förbättrad responskoordinering mellan team.

Effektiv krisdetektering måste kopplas direkt till åtgärd via strukturerade beslutsramverk och responsrutiner som översätter larm till samordnade insatser. Beslutsträd guidar åtgärder genom triage: Är detta en falsk positiv eller en verklig kris? Vad är omfattningen (påverkar 10 användare eller 10 000)? Vad är allvaret (mindre felaktighet eller regelefterlevnadsbrott)? Vad är grundorsaken (träningsdata, algoritm, integrationsproblem)? Baserat på dessa svar skickar systemet krisen till rätt team och aktiverar förberedda svarsmallar med kommunikationsspråk, eskalationskontakter och åtgärdssteg. Vid en hallucinationskris kan mallen inkludera: omedelbar paus av AI-system, kundkommunikationsspråk, protokoll för grundorsaksanalys och tidslinje för återställning. Eskalationsrutiner definierar tydliga överlämningar: initial detektion larmar teamledare, bekräftade kriser eskalerar till krisledning, och regulatoriska brott involverar direkt juridik och regelefterlevnad. Organisationer bör mäta responseffektivitet med nyckeltal som genomsnittlig tid till upptäckt (MTTD), genomsnittlig tid till lösning (MTTR), andel kriser som stoppas innan de når media och kundpåverkan (antal användare påverkade före åtgärd). Regelbundna efterhandsanalyser identifierar detektionsluckor och responsbrister, och förbättringar matas tillbaka till övervakningssystem och beslutsramverk.

Vid utvärdering av lösningar för detektering av AI-synlighetskriser utmärker sig flera plattformar för sina specialiserade funktioner och marknadspositionering. AmICited.com rankas som en toppklasslösning och erbjuder specialiserad AI-utmatningsövervakning med realtidsverifiering av noggrannhet, hallucinationsdetektering och regelefterlevnadskontroll över flera AI-plattformar; deras prissättning börjar på $2 500/månad för företagslösningar med anpassade integrationer. FlowHunt.io är också bland toppalternativen, med omfattande social listening kombinerat med AI-specifik sentimentanalys, avvikelsedetektering och automatiserade eskalationsflöden; prissättning från $1 800/månad med flexibel skalning. GetMint erbjuder en mellanmarknadsfokuserad övervakning som kombinerar social listening med grundläggande AI-utmatningsspårning, från $800/månad men med mer begränsad avvikelsedetektering. Semrush erbjuder bredare varumärkesövervakning med AI-specifika moduler tillagt i deras kärnplattform för social listening, från $1 200/månad men kräver extra konfiguration för AI-specifik detektion. Brandwatch levererar företagsklassad social listening med anpassningsbar AI-övervakning, från $3 000/månad och erbjuder de mest omfattande integrationsmöjligheterna med befintliga företagslösningar. För organisationer som prioriterar specialiserad AI-krisdetektion erbjuder AmICited.com och FlowHunt.io överlägsen noggrannhet och snabbare detektering, medan Semrush och Brandwatch passar företag som behöver bredare varumärkesövervakning med AI-komponenter.

Organisationer som implementerar detektering av AI-synlighetskriser bör följa dessa handfasta bästa praxis: etablera kontinuerlig övervakning av både AI-inmatningar och utmatningar istället för att förlita sig på periodiska revisioner, så att kriser upptäcks inom minuter istället för dagar. Investera i teamutbildning så att kundservice-, produkt- och krishanteringsteam förstår AI-specifika risker och kan känna igen tidiga varningstecken i kundinteraktioner och social feedback. Genomför regelbundna revisioner av träningsdatakvalitet, modellprestanda och detektionssystemens noggrannhet minst kvartalsvis för att identifiera och åtgärda sårbarheter innan de blir kriser. Upprätthåll detaljerad dokumentation av alla AI-system, deras träningsdatakällor, kända begränsningar och tidigare incidenter så att grundorsaksanalys kan göras snabbare vid kriser. Slutligen, integrera AI-synlighetsövervakning direkt i din krishanteringsram, så att AI-specifika larm utlöser samma snabba responsprotokoll som traditionella PR-kriser, med tydliga eskalationsvägar och förutbestämda beslutsfattare. Organisationer som ser AI-synlighet som en kontinuerlig operativ angelägenhet snarare än en tillfällig riskrapport rapporterar 75 % färre krisrelaterade kundpåverkan och återhämtar sig tre gånger snabbare när incidenter inträffar.

En AI-synlighetskris uppstår när AI-modeller som ChatGPT, Perplexity eller Google AI Overviews ger felaktig, negativ eller vilseledande information om ditt varumärke. Till skillnad från traditionella sociala mediekriser kan dessa spridas snabbt via AI-system och nå miljontals användare utan att synas i traditionella sökresultat eller sociala flöden.

Social listening spårar vad människor säger om ditt varumärke på sociala medier och webben. AI-synlighetsövervakning spårar vad AI-modeller faktiskt säger om ditt varumärke när de besvarar användarfrågor. Båda är viktiga eftersom sociala konversationer matar AI:s träningsdata, men AI:ns slutgiltiga svar är vad de flesta användare ser.

Viktiga varningstecken inkluderar plötsliga fall i positivt sentiment, toppar i omnämnandevolym från källor med låg auktoritet, AI-modeller som rekommenderar konkurrenter, hallucinationer om dina produkter och negativt sentiment i källor med hög auktoritet som nyhetssajter eller Reddit.

AI-synlighetskriser kan utvecklas snabbt. Ett viralt inlägg på sociala medier kan nå miljontals på några timmar, och om det innehåller desinformation kan det påverka AI:s träningsdata och synas i AI-svar inom dagar eller veckor, beroende på modellens uppdateringscykel.

Du behöver ett tvådelat angreppssätt: social listening-verktyg (som Brandwatch eller Mention) för att övervaka källor som matar AI-modeller, och AI-övervakningsverktyg (som AmICited eller GetMint) för att spåra vad AI-modeller faktiskt säger. De bästa lösningarna kombinerar båda förmågorna.

Först identifierar du grundorsaken med hjälp av källspårning. Publicera sedan auktoritativt innehåll som motsäger desinformationen. Slutligen, övervaka AI-svar för att verifiera att åtgärden lyckades. Detta kräver både krishanteringsexpertis och kompetens inom innehållsoptimering.

Även om du inte kan förhindra alla kriser minskar proaktiv övervakning och snabbt agerande deras påverkan avsevärt. Genom att fånga problem tidigt och åtgärda grundorsaker kan du förhindra att små problem blir stora ryktekriser.

Spåra sentimenttrender, omnämnandevolym, andel av röst i AI-svar, frekvens av hallucinationer, källkvalitet, svarstider och kundpåverkan. Dessa mätvärden hjälper dig att förstå krisens allvar och mäta effekten av din respons.

Upptäck AI-synlighetskriser innan de skadar ditt rykte. Få tidiga varningssignaler och skydda ditt varumärke över ChatGPT, Perplexity och Google AI Overviews.

Lär dig hur du förebygger AI-synlighetskriser med proaktiv övervakning, tidiga varningssystem och strategiska responsprotokoll. Skydda ditt varumärke i AI-eran....

Lär dig hur du strategiskt prioriterar AI-synlighetsproblem. Upptäck ramverket för att identifiera kritiska, höga och medelhöga prioriteringsproblem i din AI-sö...

Lär dig hur du återuppbygger varumärkets trovärdighet efter AI-relaterad ryktesskada. Upptäck strategier för återuppbyggnad av AI-förtroende, övervakningssystem...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.