E-E-A-T och AI-sök: Varför din varumärkesauktoritet är viktigare än någonsin

Förstå E-E-A-T (Erfarenhet, Expertis, Auktoritet, Trovärdighet) och dess avgörande betydelse för synlighet i AI-sökmotorer som ChatGPT, Perplexity och Google AI...

Upptäck hur E-E-A-T-signaler påverkar LLM-citat och AI-synlighet. Lär dig hur erfarenhet, expertis, auktoritet och förtroende formar innehållets upptäckbarhet i AI-drivna sökningar.

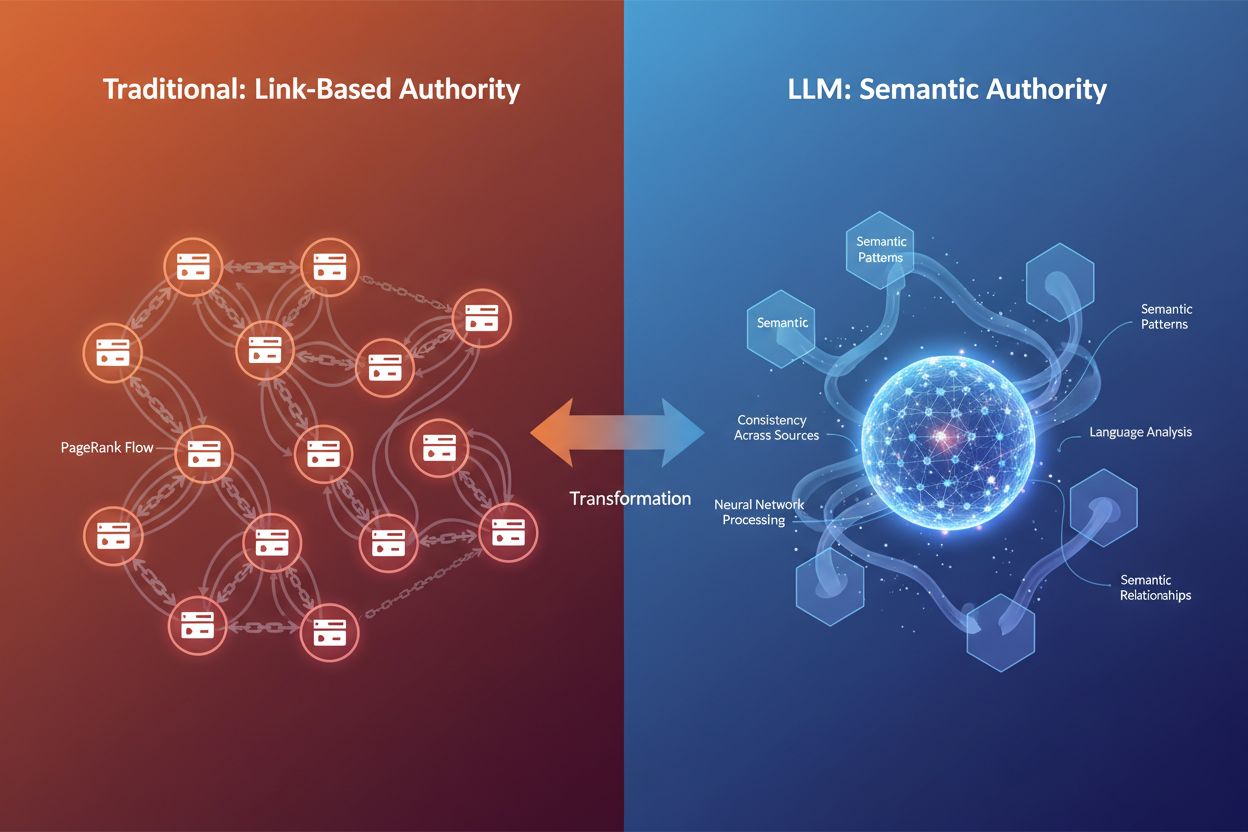

Det digitala landskapet förändras snabbt. I decennier var bakåtlänkar den främsta auktoritetsmarkören – ju fler kvalitetslänkar som pekade på din webbplats, desto mer auktoritativ ansågs du vara av sökmotorerna. Men när stora språkmodeller (LLM:er) som ChatGPT, Claude och Gemini formar om hur information upptäcks och utvärderas, utvecklas själva definitionen av auktoritet. E-E-A-T – Experience, Expertise, Authoritativeness och Trust – har gått från att vara en sekundär SEO-faktor till ett grundläggande ramverk som avgör synlighet i både traditionell sök och AI-drivna plattformar. Den avgörande insikten här är att bakåtlänkar inte längre är den enda auktoritetsmarkören som avgör om ditt innehåll citeras av AI-system. Istället utvärderar LLM:er auktoritet genom semantisk rikedom, konsekvens mellan källor och djupet på den kunskap som demonstreras i ditt innehåll. Denna förändring är avgörande för varumärken som vill bygga synlighet i AI-citatplattformar som Googles AI Overviews, Perplexity och ChatGPT. När AmICited övervakar hur AI refererar till ditt varumärke på dessa plattformar, spårar vi signaler som går långt utöver traditionella länkprofiler. Frågan är inte längre bara “vem länkar till dig?” utan snarare “visar ditt innehåll genuin expertis, och kan AI-system lita tillräckligt på det för att citera det?” Att förstå denna skillnad är avgörande för alla som är seriösa med att bygga auktoritet i det AI-drivna söklandskapet.

E-E-A-T representerar fyra sammankopplade dimensioner av innehållstrovärdighet, där varje pelare har en distinkt roll i hur både Google och LLM:er utvärderar om ditt innehåll förtjänar synlighet. Låt oss bryta ner varje pelare och förstå hur de fungerar i AI-citatsammanhang:

Erfarenhet betyder att du faktiskt har gjort det du skriver om. En produktrecension skriven av någon som använt produkten i sex månader väger tyngre än en generell översikt. I AI-eran känner LLM:er igen erfarenhetsbaserat innehåll genom språkmönster som signalerar förstahandserfarenhet – specifika detaljer, observationer från verkligheten och kontextuella nyanser som bara någon med direkt insikt kan inkludera.

Expertis är påvisbar kunskap stödd av meriter, utbildning eller en bevisad meritlista. En finansiell rådgivare med CFA-certifiering som skriver om investeringsstrategier har mer auktoritet än en livsstilsbloggare som provar på finansämnen. För LLM:er känns expertis igen genom konsekvent användning av teknisk terminologi, logiskt djup i förklaringar och förmågan att täcka komplexa delämnen med precision.

Auktoritet kommer från extern igenkänning – andra trovärdiga källor citerar dig, länkar till dig eller nämner dig som en resurs. Traditionellt mättes detta genom bakåtlänkar. Men i LLM-sammanhang mäts auktoritet alltmer genom semantiskt fotavtryck – hur konsekvent ditt varumärke eller namn dyker upp i samband med din nisch över flera källor och plattformar.

Förtroende är det paraply som håller allt samman. Utan förtroende rasar de andra tre pelarna. Förtroende byggs genom transparens (tydligt författarskap, kontaktinformation), noggrannhet (faktabaserat innehåll med korrekta referenser) och säkerhet (HTTPS, professionell webbplatsinfrastruktur). Google säger uttryckligen att förtroende är den viktigaste medlemmen i E-E-A-T-familjen, och LLM:er väger på liknande sätt in konsekvens och tillförlitlighet tungt när de väljer källor att citera.

| Signal | Traditionell SEO-utvärdering | LLM-citatsutvärdering |

|---|---|---|

| Erfarenhet | Författarprofil, personliga anekdoter | Språkmönster som indikerar förstahandserfarenhet |

| Expertis | Meriter, bakåtlänkar från auktoritetssajter | Semantiskt djup, teknisk terminologi, ämnestäckning |

| Auktoritet | Länkprofil, domänauktoritet | Entityigenkänning, omnämnanden på flera plattformar, semantisk auktoritet |

| Förtroende | HTTPS, webbplatsstruktur, användarrecensioner | Konsekvens mellan källor, verifierad noggrannhet, tydlighet |

Den stora skillnaden är att medan traditionell SEO förlitar sig på strukturella signaler (länkar, domänmått), utvärderar LLM:er E-E-A-T genom semantisk och kontextuell analys. Detta innebär att ditt innehåll kan bygga auktoritet utan enorma länkbyggnadsinsatser – om det visar genuin expertis och konsekvens.

Stora språkmodeller tänker inte som traditionella sökmotorer. De genomsöker inte webben efter bakåtlänkar eller kollar domänauktoritetspoäng. Istället fungerar de som sannolikhetsmaskiner som känner igen mönster i språk, kontext och informationskonsekvens. När en LLM avgör om ditt innehåll ska citeras, ställer den grundläggande andra frågor än Googles rankningsalgoritm.

Mönsterigenkänning vs. strukturella signaler: Traditionella sökmotorer verifierar auktoritet genom extern validering – vem länkar till dig? LLM:er, däremot, känner igen auktoritet språkligt. De analyserar om din text visar expertis genom korrekt användning av tekniska termer, logiskt flöde, självsäker ton och förmågan att adressera nyanserade aspekter av ett ämne. En sida om hjärtsjukdomar som naturligt väver in relaterade begrepp som “kolesterol”, “artärplack” och “kardiovaskulära riskfaktorer” signalerar semantisk auktoritet till en LLM, även utan en enda bakåtlänk.

Semantisk relevans och ämnesdjup: LLM:er prioriterar innehåll som grundligt täcker ett ämne från flera vinklar. När du ställer en fråga till en AI-assistent, bryter systemet ned din prompt till flera sökfrågor (“query fan-out”) och hämtar innehåll som matchar dessa utökade frågor. Innehåll som täcker ett ämne heltäckande – adresserar delämnen, svarar på följdfrågor och ger kontext – väljs oftare för citat. Därför har semantisk rikedom blivit en ny form av auktoritet.

Konsekvens mellan källor: LLM:er korskontrollerar information över miljontals dokument. Om ditt innehåll stämmer med etablerad konsensus och samtidigt tillför unika insikter behandlas det som mer auktoritativt. Omvänt, om ditt innehåll motsäger fakta utan stöd kan AI-system nedvärdera det som opålitligt. Detta skapar en intressant dynamik: du kan introducera nya idéer, men de måste grunda sig i verifierbar information.

Viktiga skillnader i auktoritetsutvärdering:

Slutsatsen: LLM:er känner igen auktoritet genom innebörd, inte genom mått. Detta förändrar fundamentalt hur du bör arbeta med innehållsoptimering för AI-synlighet.

Ett av de mest slående resultaten från forskning om LLM-citatbeteende är den starka aktualitetsbiasen på alla stora plattformar. Vid analys av 90 000 citat från ChatGPT, Gemini och Perplexity med webbsök aktiverat visade datan ett tydligt mönster: de flesta citerade URL:er publicerades inom några hundra dagar från LLM-svaret. Detta är inte en slump – det är avsiktligt. LLM:er är tränade att känna igen att nytt innehåll ofta korrelerar med relevans och kvalitet, särskilt för tidskänsliga ämnen.

Varför färskhet spelar roll i RAG-hämtning: När LLM:er använder Retrieval-Augmented Generation (RAG) – söker webben i realtid för att grunda sina svar – frågar de i princip: “Vilken är den mest aktuella, relevanta informationen?” Färskhet blir en proxy för tillförlitlighet. Om du efterfrågar aktuella händelser, marknadstrender eller senaste forskningsresultat är en artikel publicerad förra månaden mer trovärdig än en fem år gammal. Detta skapar en stor fördel för innehållsskapare som underhåller och uppdaterar sina sidor regelbundet.

Plattformspecifika färskhetsmönster: Forskning visar att Gemini har den starkaste preferensen för nytt innehåll, med flest citat från sidor publicerade inom 0–300 dagar. Perplexity ligger i mitten och citerar både nytt och medelåldrat innehåll. OpenAI visar störst variation i publiceringsålder men presterar ändå starkt i att hämta nytt material. Din optimeringsstrategi bör alltså anpassas efter vilka AI-plattformar din målgrupp använder mest.

Tidskänsliga ämnen kräver aktiva uppdateringar: För YMYL-ämnen (Your Money or Your Life) – hälsa, ekonomi, juridisk rådgivning – och snabbt föränderliga branscher är färskhet ett måste. En artikel om kryptoregleringar från 2021 citeras sällan 2025. Lösningen är systematisk innehållsvård: uppdatera statistik årligen (kvartalsvis för snabbrörliga branscher), lägg till “senast uppdaterad”-datum och fräscha upp viktiga datapunkter när ny information kommer. Detta signalerar både till AI och mänskliga läsare att ditt innehåll fortfarande är aktuellt och tillförlitligt.

Datat om aktualitetsbiasen: Analys av 21 412 URL:er med extraherbara publiceringsdatum visade att på alla tre stora LLM-plattformar toppar citataktiviteten kraftigt mellan 0 och 300 dagar och avtar därefter. Detta innebär att det första året av ett innehålls liv är avgörande för AI-synlighet. Innehåll äldre än tre år får betydligt färre citat om det inte gäller evigt aktuella ämnen eller har uppdaterats nyligen.

Även om LLM:er inte direkt utvärderar domänauktoritetspoäng finns en tydlig korrelation mellan hög domänauktoritet och citatfrekvens. Analys av de 1 000 sajter som oftast nämns av ChatGPT visade ett tydligt mönster: AI föredrar webbplatser med Domain Rating (DR) över 60, med majoriteten av citaten från DR 80–100. Men denna korrelation är sannolikt indirekt – sajter med hög DR rankar bättre i sökresultaten, och eftersom LLM:er hämtar innehåll via webbsökningar stöter de oftare på dessa auktoritativa webbplatser.

Den indirekta auktoritetseffekten: Sambandet fungerar så här: LLM:er använder sökmotorer (eller liknande system) för att hitta innehåll. Sajter med hög auktoritet rankar bättre i dessa sökningar. Därför dyker de oftare upp i LLM-hämtning. Det är inte så att LLM:er läser ditt domänauktoritetspoäng; det är att auktoritet korrelerar med söksynlighet, vilket korrelerar med citatmöjligheter. Att bygga traditionell SEO-auktoritet genom kvalitetslänkar är alltså fortsatt värdefullt, även i en AI-driven värld.

Semantisk rikedom som ny auktoritetssignal: Utöver domänmått känner LLM:er igen auktoritet genom semantisk rikedom – djup och bredd i ämnestäckning. En sida som grundligt utforskar ett ämne, använder relevanta nyckelord naturligt, adresserar delämnen och ger kontext signalerar expertis till AI-system. Exempelvis visar en artikel om “fördelar med medelhavsdieten” som täcker kulturella aspekter, specifika hälsoeffekter, jämförelser med andra dieter och vanliga frågor mer semantisk auktoritet än en generell lista.

Entity-relationer och ämnesauktoritet: LLM:er använder entityigenkänning för att förstå hur ditt innehåll kopplas till större kunskapsnätverk. Om din artikel om “Steve Jobs” konsekvent nämner Apple, innovation, ledarskap och produktdesign bygger AI en mer komplett bild av din auktoritet. Därför har strukturerad data och schema-markup blivit allt viktigare – de hjälper AI att förstå entity-relationer och ämneskopplingar tydligare.

Innehåll måste adressera utökade sökfrågor: När en LLM får en användarfråga expanderar den ofta till flera relaterade sökningar. Ditt innehåll behöver täcka inte bara huvudfrågan utan också variationer. Om någon frågar “hur vet man att en avokado är mogen” kan LLM:en även söka efter “tecken på mogen avokado”, “hur länge mognar avokado” och “förvaring av mogen avokado”. Innehåll som täcker dessa vinklar är mer sannolikt att bli citerat i flera sökvarianter.

Att optimera för E-E-A-T i LLM-citatsammanhang kräver ett strategiskt, flerskiktat angreppssätt. Målet är att skapa innehåll som visar genuin expertis och gör det enkelt för AI att känna igen och extrahera denna expertis. Här är en praktisk ram:

1. Visa upp meriter och expertis tydligt Din författarprofil ska vara omfattande och verifierbar. Inkludera specifika meriter (certifikat, examina, yrkestitlar), år av erfarenhet och direkt engagemang inom ämnet. Skriv inte bara “marknadsföringsexpert” – skriv “CMO med 15 års erfarenhet av B2B SaaS-marknadsföring, inklusive roller på HubSpot och Salesforce.” Denna specifikhet hjälper LLM:er att känna igen genuin expertis. Lägg till författarprofiler på varje innehåll och överväg schema-markup (Author schema) för maskinläsbarhet.

2. Skapa egen forskning och data Egen forskning är en av de starkaste auktoritetssignalerna. När du publicerar data som inte finns någon annanstans – undersökningsresultat, egna benchmarks, fallstudier – blir du primärkälla. LLM:er citerar primärkällor oftare eftersom de ger unikt värde. Ahrefs “How Much Does SEO Cost?” är ett av deras mest citerade inlägg just för att det bygger på egen undersökning. Viktigt är att göra forskningsmetoden transparent och visa urvalsstorleken.

3. Upprätthåll konsekvent auktoritet över plattformar Din auktoritet mäts inte längre bara på din webbplats. LLM:er analyserar din närvaro på LinkedIn, branschpublikationer, föreläsningar, mediacitat och andra plattformar. Se till att yrkesinformation, expertis och budskap är konsekventa överallt. När AI ser ditt namn återkommande inom din nisch på flera ställen byggs förtroendet för din auktoritet.

4. Implementera korrekt schema-markup Schema-markup gör dina expertissignaler maskinläsbara. Använd Article schema för publiceringsdatum och författarinformation, FAQ schema för frågebaserat innehåll, och Author schema för att koppla dina meriter till innehållet. Forskning visar att 36,6 % av söknyckelord triggar featured snippets från schema-markup, och denna struktur hjälper även LLM:er att tolka ditt innehåll rätt.

5. Bygg ämnesauktoritet genom innehållskluster Publicera inte isolerade blogginlägg – skapa innehållshubbar som visar din totala kunskap om ett ämne. Internlänka relaterade artiklar, täck delämnen grundligt och bygg ett semantiskt nätverk som visar att du täckt ämnet från flera håll. Detta signalerar ämnesauktoritet till både sökmotorer och LLM:er.

6. Uppdatera innehåll systematiskt Färskhet är en rankningsfaktor för både Google och LLM:er. Skapa en underhållsplan: granska och uppdatera viktiga sidor kvartalsvis, fräscha upp statistik årligen och lägg till “senast uppdaterad”-datum tydligt. Denna kontinuerliga investering signalerar att ditt innehåll är aktuellt och pålitligt.

7. Citera auktoritativa källor När du refererar till andra trovärdiga källor bygger du ett förtroendenät. Citera peer-reviewed forskning, branschrapporter och erkända experter. Det stärker din trovärdighet och hjälper LLM:er att förstå sammanhang och tillförlitlighet i dina påståenden.

8. Var transparent med begränsningar Genuin expertis innebär att veta vad du inte vet. Om ett ämne ligger utanför din kompetens, säg det. Om din data har begränsningar, erkänn dem. Denna transparens bygger förtroende hos både mänskliga läsare och AI-system, som tränas att värdera ärlig och nyanserad kommunikation.

Att förstå E-E-A-T i teorin är en sak – att se det fungera i praktiken är en annan. Låt oss se vad som gör vissa innehåll väldigt citerbara och hur dessa principer syns i verkliga exempel.

Anatomin hos mycket citerbart innehåll: Ahrefs “How Much Does SEO Cost?” exemplifierar E-E-A-T-optimering för LLM-citat. Sidan besvarar en vanlig, sökt fråga direkt. Den bygger på egen forskning (439 personer tillfrågade), har ett tydligt tidsstämpel och bryter ner prissättning utifrån flera dimensioner (frilansare vs. byråer, timpris vs. retainer, geografiska skillnader). Innehållet är lättskannat med tydliga rubriker, innehåller datavisualiseringar med förklarande text och utforskar ämnet från olika vinklar. Författarprofilen visar relevanta meriter och innehållet är peer reviewat, vilket ger ytterligare lager av förtroende.

Vad gör innehåll citerbart: Mycket citerbart innehåll delar ofta dessa egenskaper: det besvarar specifika frågor direkt utan utfyllnad, bygger på verifierbar data eller egen forskning, har tydlig struktur och formatering som underlättar extrahering, täcker ämnet ur flera vinklar och visar genuin expertis genom djup och nyans. När LLM:er avgör om en sida ska citeras frågar de i princip: “Kan jag extrahera ett tydligt, korrekt svar härifrån? Är källan pålitlig? Ger denna sida unikt värde?”

Strukturerad formatering som citatsignal: Innehåll med tydliga rubrikhierarkier, punktlistor, tabeller och korta stycken citeras oftare. Det handlar inte bara om läsbarhet för människor – utan om extraherbarhet för AI. När LLM snabbt kan identifiera nyckelinformation via strukturella ledtrådar ökar chansen för citat. Jämför en textvägg med en välstrukturerad artikel med H2, H3 och punktlistor: den strukturerade versionen är betydligt mer citerbar.

Flera vinklar på ämnen: Innehåll som belyser ett ämne ur olika perspektiv ökar citatmöjligheterna. En artikel om “produktivitet vid distansarbete” kan t.ex. täcka produktivitet för olika roller (utvecklare, chefer, kundtjänst), olika tidszoner, olika hemmiljöer och olika personlighetstyper. Detta gör att innehållet kan besvara många relaterade frågor från en och samma sida, vilket ger mycket högre citatpotential.

Verkliga citatmönster: Forskning från SearchAtlas på 90 000 citat i stora LLM:er visar att mycket citerat innehåll ofta kommer från sajter med stark domänauktoritet men även från nischexperter med djup ämneskunskap. Reddit-svar och Substack-artiklar förekommer ofta i AI-citat trots svaga länkprofiler, eftersom de visar autentisk expertis och konversationsklarhet. Det bevisar att auktoritet alltmer handlar om demonstrerad kunskap, inte bara länkpoäng.

Att bygga E-E-A-T är en sak – att mäta effekten är en annan. Traditionella SEO-mått som sökordsrankning och länkantal visar inte hela bilden av din AI-synlighet. Du behöver nya verktyg och mätvärden anpassade för AI-eran.

Manuell testning över AI-plattformar: Börja med direkt testning. Gör en lista på 10–20 frågor ditt innehåll bör besvara och testa dem månadsvis i ChatGPT, Perplexity, Claude och Gemini. Dokumentera vilka källor som citeras (dina och konkurrenters), spåra förändringar över tid och identifiera mönster. Metoden är tidskrävande men ger direkt insikt i vad din målgrupp faktiskt ser. Använd ett enkelt Google Sheet för att följa resultaten och upptäcka trender.

Analys av AI-trafik i webbanalys: De flesta analysplattformar spårar nu AI-söktrafik som separat kanal. I Ahrefs Web Analytics (gratis i Ahrefs Webmaster Tools) är AI-sök redan segmenterat, så du kan se vilka sidor som får AI-trafik och hur besökarna beter sig. Följ mätvärden som vistelsetid, bounce rate, scroll depth och konverteringsgrad. Även om AI-trafik nu utgör mindre än 1 % av total trafik, visar dessa besökare ofta högre köpintention och konverteringsgrad än traditionell sök.

Mäta E-E-A-T-effektivitet: Istället för att leta efter direkta E-E-A-T-poäng, spåra dessa proxy-mått: AI Overview-citat (använd verktyg som BrightEdge eller Authoritas), varumärkessökvolym, branschomnämnanden på olika plattformar och rankingstabilitet vid algoritmuppdateringar. Innehåll med starka E-E-A-T-signaler visar ofta mindre volatilitet vid core updates. Du kan även använda verktyg som LLM SEO E-E-A-T Score Checker för att få en direkt översikt av din E-E-A-T-prestanda per kategori.

Betald övervakning i stor skala: För omfattande spårning utan manuell testning, använd verktyg som Ahrefs Brand Radar, som övervakar citat i 150 miljoner prompts på sex stora AI-plattformar. Brand Radar visar var och när du blir citerad, filtrerar på plattform och ämne, följer citattrender över tid och erbjuder konkurrensjämförelser. Det ger en komplett bild av ditt AI-synlighetslandskap och hjälper dig hitta möjligheter och luckor.

Viktiga mätvärden att följa: Följ AI-citatfrekvens (hur ofta du citeras), citatdiversitet (ämnen och plattformar), semantiska relevanspoäng (hur nära citatmatchningen är mot frågor), färskhetsmått (medelålder på citerat innehåll) och domänöverensstämmelse (vilka konkurrenter citeras samtidigt som du). Dessa mått ger tillsammans en bild av din E-E-A-T-effektivitet i AI-sammanhang.

I takt med att E-E-A-T och LLM-optimering fått uppmärksamhet har flera missuppfattningar uppstått. Låt oss avliva de vanligaste:

Myten: “Bakåtlänkar är döda” Verkligheten: Bakåtlänkar är fortfarande värdefulla auktoritetssignaler, särskilt för Googles algoritm. Det som förändrats är deras relativa tyngd. De är inte längre den enda valutan för SEO. Sajter med hög auktoritet citeras fortfarande oftare av LLM:er, men det beror mest på att de rankar bättre i sökresultat (vilket LLM:er använder för hämtning). Den viktiga insikten: bakåtlänkar spelar fortfarande roll, men de är en del av ett större pussel som nu inkluderar semantisk auktoritet, färskhet och bevisad expertis.

Myten: “E-E-A-T är en direkt rankningsfaktor” Verkligheten: E-E-A-T är inte en direkt rankningsfaktor som nyckelord eller sidladdningstid. Istället är det ett ramverk Google använder via sina kvalitetsbedömare för att träna och finjustera sina algoritmer. Att optimera för E-E-A-T handlar egentligen om att optimera för människor först – skapa genuint auktoritativt och pålitligt innehåll. Rankningsfördelarna kommer indirekt, genom ökad användarnöjdhet och minskad bounce rate.

Myten: “AI kan upptäcka falsk auktoritet på lång sikt” Verkligheten: Detta är delvis sant men nyanserat. LLM:er kan luras av innehåll som “låter” auktoritativt på kort sikt. Innehållsfabriker kan producera expertliknande material genom val av ord och struktur. Men falsk auktoritet överlever sällan mänsklig granskning, och när AI-systemen blir mer sofistikerade och tränas på mer varierad data blir de bättre på att skilja genuin expertis från imitation. Det säkrare valet: bygg verklig auktoritet istället för att försöka lura systemet.

Myten: “Du behöver massor av bakåtlänkar för att få LLM-citat” Verkligheten: Även om sajter med hög auktoritet citeras oftare dyker nischexperter med mindre länkprofiler regelbundet upp i LLM-citat. Det som räknas är att visa genuin expertis inom ditt område. En specialiserad blogg med djup ämneskun

E-E-A-T står för Experience, Expertise, Authoritativeness och Trust. Det är ett ramverk som avgör innehållets trovärdighet för både traditionell sök och AI-system. LLM:er använder E-E-A-T-signaler för att avgöra vilka källor de ska citera i sina svar, vilket gör det avgörande för AI-synlighet.

LLM:er utvärderar auktoritet genom semantiska mönster, konsekvens mellan källor och påvisad expertis snarare än bakåtlänkar. De känner igen auktoritet språkligt genom teknisk terminologi, logiskt djup och ämnestäckning. Det betyder att sajter med hög auktoritet fortfarande citeras oftare, men framför allt eftersom de rankar bättre i sökresultat som LLM:er använder för hämtning.

Ja. Även om större sajter har fördelar, dyker nischexperter med mindre länkprofiler regelbundet upp i LLM-citat. Det som räknas är att visa genuin expertis inom ditt specifika område genom semantisk rikedom, ämnesdjup och konsekvent positionering. En specialiserad blogg med djup kunskap kan överträffa allmänna sajter med fler bakåtlänkar.

E-E-A-T är en långsiktig strategi. Att bygga genuina auktoritets- och förtroendesignaler tar vanligtvis månader, inte veckor. Men att implementera korrekt schema-markup och författarattribut kan ge snabbare effekter. Det första året av innehållets liv är avgörande för AI-synlighet, och citatfrekvensen minskar avsevärt efter tre år om inte innehållet uppdateras.

Bakåtlänkar är fortsatt värdefulla auktoritetssignaler, men de är inte längre den enda valutan. Sajter med hög auktoritet citeras oftare av LLM:er, men detta beror mest på att de rankar bättre i sökresultaten. Den viktiga insikten: bakåtlänkar spelar fortfarande roll som en del av ett större pussel som nu inkluderar semantisk auktoritet, färskhet och bevisad expertis.

Spåra AI-citatfrekvens, citatdiversitet över ämnen och plattformar, semantiska relevanspoäng, färskhetsmått och domänöverensstämmelse med konkurrenter. Använd verktyg som Ahrefs Brand Radar för omfattande övervakning över 150 miljoner prompts, eller testa dina målfrågor manuellt varje månad i ChatGPT, Perplexity, Claude och Gemini.

Nej, E-E-A-T är inte en direkt rankningsfaktor. Det är ett ramverk som påverkar hur AI-system utvärderar innehållskvalitet. Att optimera för E-E-A-T handlar egentligen om att skapa genuint auktoritativt och trovärdigt innehåll som i första hand tjänar mänskliga läsare. Fördelarna kommer indirekt genom ökad användarnöjdhet och fler citat.

Färskhet väger tungt vid urval av LLM-citat. Forskning visar att LLM:er citerar innehåll publicerat inom 300 dagar i betydligt högre utsträckning. För tidskänsliga ämnen är en artikel från förra månaden mer trovärdig än en från fem år tillbaka. Systematiska innehållsuppdateringar och tydliga 'senast uppdaterad'-datum är avgörande för bibehållen AI-synlighet.

Spåra hur ditt varumärke citeras av ChatGPT, Perplexity, Google AI Overviews och andra LLM:er. Förstå dina E-E-A-T-signaler och optimera för AI-synlighet med AmICited.

Förstå E-E-A-T (Erfarenhet, Expertis, Auktoritet, Trovärdighet) och dess avgörande betydelse för synlighet i AI-sökmotorer som ChatGPT, Perplexity och Google AI...

E-E-A-T (Erfarenhet, Expertis, Auktoritet, Trovärdighet) är Googles ramverk för att utvärdera innehållskvalitet. Lär dig hur det påverkar SEO, AI-citat och varu...

Lär dig beprövade strategier för att bygga auktoritet och öka ditt varumärkes synlighet i AI-genererade svar från ChatGPT, Perplexity och andra AI-sökmotorer....

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.