YMYL (Your Money Your Life)

YMYL-innehåll kräver höga E-E-A-T-standarder. Lär dig vad som kvalificerar som Your Money Your Life-innehåll, varför det är viktigt för SEO och AI-synlighet, sa...

Lär dig hur vårdorganisationer kan optimera medicinskt innehåll för LLM-synlighet, navigera YMYL-krav och övervaka AI-citeringar med AmICited.com:s AI-övervakningsplattform.

Your Money or Your Life (YMYL)-innehåll omfattar ämnen som direkt påverkar användarens välbefinnande, inklusive hälsa, ekonomi, säkerhet och samhällsinformation—och vården ligger högst upp i Googles granskningshierarki. Efter Googles core-uppdatering i mars 2024 minskade sökjätten synligheten för innehåll av låg kvalitet med 40 %, vilket signalerar en aldrig tidigare skådad insats mot opålitlig medicinsk information. Utmaningen för vårdorganisationer har dock förändrats i grunden: innehållet måste nu vara synligt inte bara för sökmotorer, utan också för stora språkmodeller (LLM:er) som i allt högre grad är det första valet för personer som söker hälsoinformation. Eftersom 5 % av alla Google-sökningar är hälsorelaterade och 58 % av patienterna nu använder AI-verktyg för hälsoinformation, står vårdgivare inför ett kritiskt synlighetsgap—deras innehåll kan ranka högt i traditionell sök men förbli osynligt för de AI-system som patienter faktiskt använder. Detta dubbla synlighetskrav är ett helt nytt område inom strategi för vårdinnehåll.

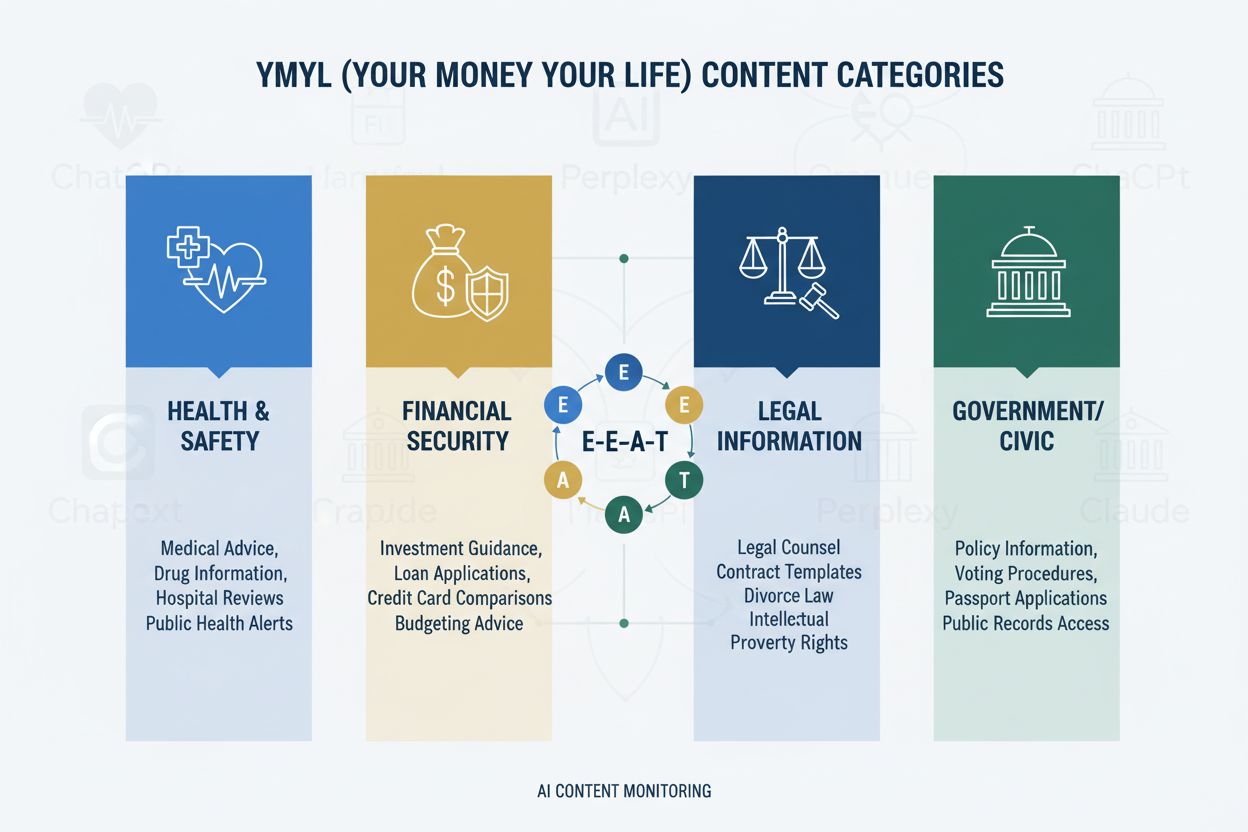

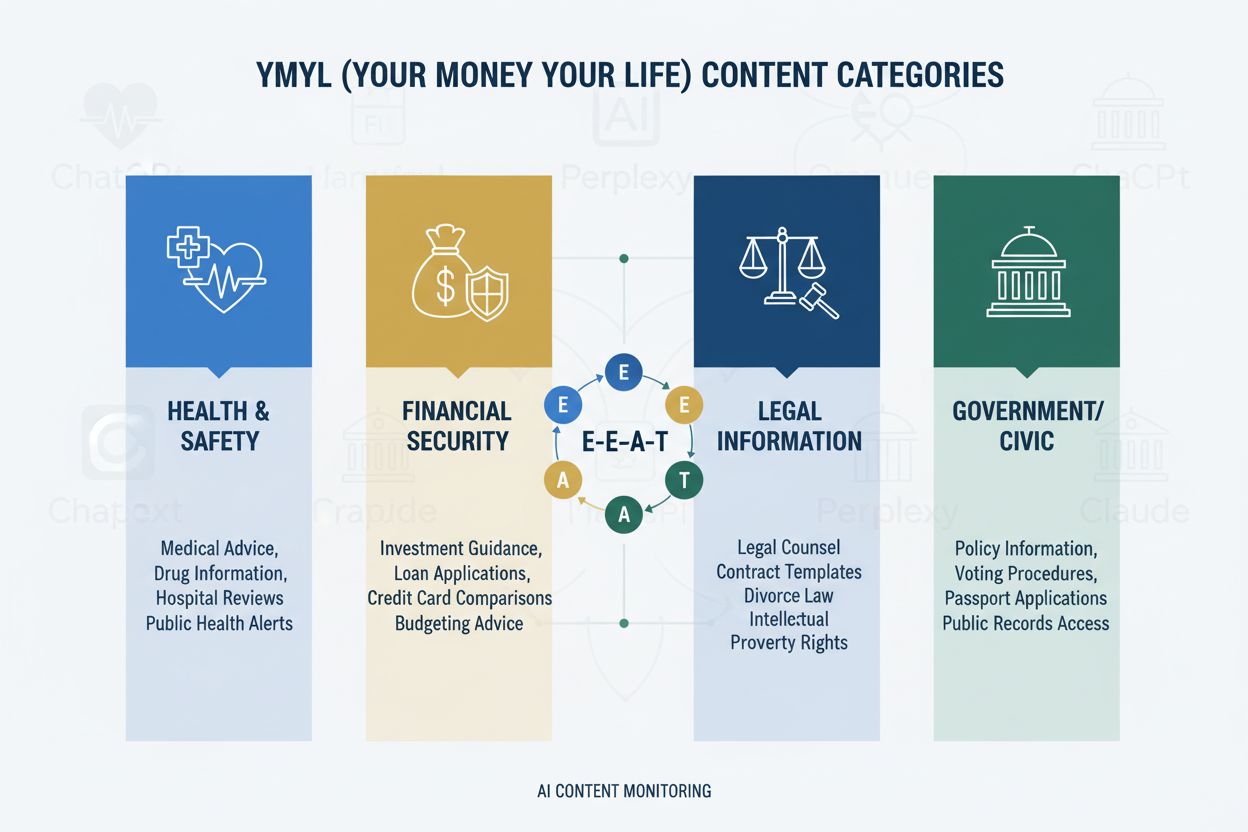

YMYL-ramverket kategoriserar innehåll i fyra kritiska områden: Hälsa (medicinska tillstånd, behandlingar, välmående), Ekonomi (investeringsråd, ekonomisk planering), Säkerhet (nödförfaranden, säkerhet), och Samhälle (röstning, juridiska frågor)—där vården får högst granskningsnivå på grund av dess direkta påverkan på människors välbefinnande. Googles E-E-A-T-ramverk (Experience, Expertise, Authoritativeness, Trustworthiness) fungerar som utvärderingsstandard och kräver att vårdinnehåll visar genuin medicinsk kunskap, yrkesmässiga meriter och verifierbar noggrannhet. Quality Rater Guidelines betonar uttryckligen att vårdinnehåll måste skapas eller granskas av kvalificerade medicinska yrkespersoner, med tydliga författaruppgifter och institutionellt stöd. Vårdorganisationer måste förstå att E-E-A-T inte är valfritt—det är grundkravet för både söksynlighet och inkludering i LLM:er. Nedan visas påverkan av YMYL-kategorierna:

| YMYL-kategori | Påverkansnivå | Granskningsintensitet | Relevans för vården |

|---|---|---|---|

| Hälsa | Kritisk | Högsta | Direkt patientsäkerhet |

| Ekonomi | Hög | Hög | Försäkring, kostnader |

| Säkerhet | Hög | Hög | Nödrutiner |

| Samhälle | Medel | Medel | Hälsopolitik |

Trots sin sofistikation uppvisar LLM:er alarmerande felprocent när de behandlar medicinsk information, med forskning från Stanford HAI som dokumenterar 30–50 % obestyrkta påståenden i vårdsvar. GPT-4 med Retrieval-Augmented Generation (RAG) ger fortfarande svar där 50 % innehåller obestyrkta påståenden, även när modellen tränats på auktoritativa källor—ett fenomen som kallas hallucination och kan visa sig genom att rekommendera icke-existerande medicinsk utrustning, föreslå felaktiga behandlingsprotokoll eller hitta på läkemedelsinteraktioner. Ett uppmärksammat fall involverade Men’s Journal som publicerade en AI-genererad artikel med 18 specifika medicinska fel, inklusive farliga behandlingsrekommendationer som kunde skada läsare. Det grundläggande problemet är att AI saknar “Erfarenhet”—den förstahandskliniska kunskap som särskiljer expertläkare från system som bara matchar statistiska mönster. Denna brist innebär att utan korrekt strukturerat, auktoritativt innehåll från verifierade medicinska experter kommer LLM:er självsäkert att generera trovärdiga men potentiellt farliga medicinska råd.

AI Overviews och liknande LLM-drivna svarssystem förändrar i grunden hur patienter hittar hälsoinformation genom att ge direkta svar utan att kräva webbplatsbesök. Det eliminerar i praktiken det traditionella klicket som har drivit webtrafiken inom vården i decennier. Innehållets synlighet beror nu på citering i AI-svar snarare än på placering i sökresultaten, vilket innebär att en vårdgivares artikel kan sammanfattas i ett AI-svar utan att få någon trafik eller erkännande. LLM:er sammanställer information från flera källor samtidigt och skapar en ny informationsarkitektur där enskilda webbplatser konkurrerar om att inkluderas i AI-genererade sammanfattningar snarare än om toppositioner i sökresultat. Vårdgivare måste inse att Share of Model (SOM)—andelen AI-svar som citerar deras innehåll—har blivit det avgörande synlighetsmåttet, och ersätter traditionella klickfrekvenser. Detta paradigmskifte kräver en grundläggande omprövning av innehållsstrategin: istället för att optimera för klick måste vårdorganisationer optimera för citeringskvalitet, noggrannhet och strukturell tydlighet så att deras innehåll blir den föredragna källan för LLM-syntes.

LLM:er behandlar medicinskt innehåll mest effektivt när det är organiserat med tydlig hierarkisk struktur som speglar kliniskt beslutsfattande: tillståndsdefinition → symptom → diagnoskriterier → behandlingsalternativ → prognos. Progressiv informationsstruktur—att presentera enkla begrepp före komplexa—gör det möjligt för LLM:er att bygga korrekta mentala modeller istället för att blanda samman besläktade men distinkta tillstånd. Fråge-först-design (att besvara “Vad är tillstånd X?” före “Hur behandlas det?”) stämmer överens med hur LLM:er hämtar och sammanställer information över flera dokument. Semantisk rikedom och sammanlänkade begrepp—att explicit länka relaterade tillstånd, behandlingar och riskfaktorer—hjälper LLM:er att förstå relationer som annars kan förbli underförstådda. Implementering av Schema.org-märkning för vård (MedicalCondition, MedicalProcedure, MedicalTreatment) ger strukturerad data som LLM:er kan tolka och citera pålitligt. Naturligt språk som efterliknar expertförklaring—med terminologi som läkare använder men ändå är tillgängligt—signalerar autenticitet både för LLM:er och mänskliga läsare. Vårdorganisationer bör granska befintligt innehåll utifrån dessa strukturella krav, eftersom traditionellt SEO-optimerat innehåll ofta saknar den hierarkiska tydligheten och semantiska rikedom som LLM:er kräver för korrekt syntes.

Närvaro på flera plattformar förstärker auktoritetssignaler på sätt som enbart webbplatsstrategier inte kan, eftersom LLM:er känner igen konsekvent expertis som demonstreras över flera auktoritativa kanaler. Medicinska frågeplattformar som HealthTap och Figure 1 möjliggör direkt läkare-till-patient-interaktion som LLM:er tolkar som äkta expertis, med verifierade meriter och engagemang i realtid. Professionella nätverk såsom Doximity och medicinska LinkedIn-grupper etablerar kollegialt erkännande och professionell status, vilket LLM:er värderar högt i sin bedömning av auktoritet. Bidrag till medicinska Wikipedia och liknande kunskapsbaser signalerar vilja att bidra till allmän medicinsk kunskap utan kommersiella motiv, en förtroendesignal som LLM:er känner igen. Omfattande författarsidor—med specialistbevis, publikationer, klinisk erfarenhet och institutionella kopplingar—ska finnas på huvudwebbplatsen och länkas konsekvent över plattformar. Korsplattformskonsekvens i meriter, specialiteter och kliniska perspektiv stärker äkthet; motsägelser mellan plattformar väcker LLM-skepsis. Vårdorganisationer bör utveckla en strategi för auktoritet över flera plattformar där varje plattform ses som en förstärkande signal snarare än en separat kanal, så att läkares expertis är synlig och verifierbar i hela det digitala ekosystemet.

Traditionell vårdanalys—att spåra organisk trafik, klickfrekvenser och sökrankningar—missar helt AI-synlighetsbilden, och skapar en farlig blind fläck där innehållet verkar framgångsrikt enligt gamla mått men förblir osynligt för LLM:er. Share of Model (SOM) blir det avgörande nya måttet, som mäter vilken andel av AI-genererade svar om ett visst tillstånd som citerar din organisations innehåll. Effektiv övervakning kräver systematisk testning över flera LLM-plattformar (ChatGPT, Claude, Perplexity och nya konkurrenter) med konsekventa frågor inom dina specialområden, där citeringsfrekvens och position i svaret dokumenteras. Citeringskvalitet är lika viktig som citeringsfrekvens—att citeras som primärkälla väger tyngre än att förekomma i en lista över sekundära referenser, och LLM:er känner igen när innehåll citeras för specifik expertis jämfört med generell information. Övervakningsverktyg varierar från manuell testning (köra frågor och dokumentera resultat) till automatiserade plattformar som spårar SOM-ändringar över tid och varnar för synlighetsförändringar. Indirekta indikatorer såsom varumärkessökvolym, patientfeedback som nämner AI-rekommendationer och hänvisningsmönster från AI-plattformar ger kompletterande data som bekräftar SOM-trender. Vårdorganisationer bör omedelbart etablera baslinjemått för SOM, eftersom konkurrenslandskapet förändras snabbt och tidiga synlighetsfördelar förstärks över tid.

Vårdorganisationer bör börja med ett enskilt specialistområde istället för att försöka genomföra en total omställning direkt, så att teamen kan utveckla expertis och förfina processer innan de skalar upp. Innehållsrevision ur LLM-perspektiv kräver att befintliga artiklar utvärderas för hierarkisk tydlighet, semantisk rikedom, fråge-först-struktur och författarens trovärdighet—vilket ofta avslöjar att innehåll som rankar bra saknar den struktur LLM:er behöver. Synlighetstestning över AI-plattformar med ämnesspecifika frågor etablerar baslinje-SOM och identifierar vilka tillstånd och behandlingar som är synliga respektive osynliga. Implementering av fråge-först-struktur innebär att omstrukturera befintligt innehåll eller skapa nytt innehåll som inleds med patientfrågor (“Varför har jag detta symptom?”) före kliniska förklaringar. Författarsidor bör skapas för varje läkarmedverkande, med specialistbevis, publikationer och klinisk erfarenhet, samt konsekvent länkning från allt författat innehåll. Innehållskluster kring tillstånd—att skapa sammankopplade texter som täcker symptom, diagnos, behandlingsalternativ och prognos—hjälper LLM:er att förstå helhetsbilden snarare än separata artiklar. Detta stegvisa tillvägagångssätt gör det möjligt för vårdorganisationer att mäta effekt, förfina strategi och bygga intern kompetens innan utvidgning till fler specialiteter.

HIPAA-efterlevnad är fortsatt avgörande även när innehållet blir synligt för LLM:er; patientsäkerhet och integritet gäller oavsett om informationen nås via sökmotorer eller AI-system, och det krävs noggrann anonymisering och avidentifiering av alla fallbeskrivningar. Medicinska friskrivningar och noggrannhetskrav måste vara tydliga och framträdande, med klara uttalanden om att AI-syntetiserad information inte ska ersätta professionell medicinsk rådgivning, och att individuella omständigheter kan skilja sig från generella råd. Faktakontroll och källhänvisning blir kritiska efterlevnadselement, eftersom vårdorganisationer är ansvariga för noggrannheten i den information de publicerar, och LLM:er kommer att förstärka fel i tusentals användarinteraktioner. Regulatorisk granskning av AI-genererat medicinskt innehåll intensifieras, och FDA samt FTC undersöker i allt större utsträckning hur AI-system presenterar medicinsk information; vårdorganisationer måste säkerställa att allt innehåll—oavsett om det är skrivet av människor eller AI-assisterat—uppfyller regulatoriska krav. Mänsklig medicinsk granskning av kvalificerade läkare måste förbli obligatorisk för allt vårdinnehåll, med dokumenterade processer som visar engagemang för noggrannhet och säkerhet. Ansvarsfrågor sträcker sig bortom traditionell medicinsk ansvarsskyldighet och omfattar även potentiellt ansvar för information som LLM:er sammanställer och presenterar för patienter; vårdorganisationer bör rådgöra med juridisk expertis om sitt ansvar för hur deras innehåll används i AI-system. Efterlevnad och säkerhet får inte bli sekundära frågor i jakten på AI-synlighet.

AI kommer att fortsätta omforma hur vi hittar hälsoinformation i allt snabbare takt, med LLM:er som blir allt mer sofistikerade i medicinskt resonerande och allt mer centrala för hur patienter söker information om hälsotillstånd. Vårdorganisationer som anpassar sin innehållsstrategi nu positionerar sig som pålitliga källor i det nya ekosystemet, medan de som väntar riskerar att bli osynliga för de AI-system deras patienter faktiskt använder. Tidig anpassning ger konkurrensfördelar genom etablerade auktoritetssignaler, högre Share of Model-mått och patientförtroende byggt på konsekvent synlighet i AI-svar—fördelar som förstärks när LLM:er lär sig känna igen och prioritera pålitliga källor. Integration av traditionell SEO och LLM-optimering är inte ett antingen-eller-val utan en kompletterande strategi, eftersom sökmotorer i allt högre grad integrerar LLM-teknik och patienter fortsätter använda flera informationskällor. Långsiktig hållbarhet bygger på äkta expertis snarare än optimeringstricks; vårdorganisationer som investerar i äkta medicinsk kunskap, transparenta meriter och korrekt information kommer att lyckas oavsett hur upptäcktsmekanismerna förändras. Landskapet för vårdinnehåll har förändrats i grunden, och de organisationer som ser denna övergång som en möjlighet snarare än ett hot kommer att forma framtiden för patienters upptäckt av hälsoinformation.

YMYL (Your Money Your Life) avser innehåll som kan påverka människors hälsa, ekonomiska stabilitet eller säkerhet avsevärt. Vård är den mest granskade kategorin eftersom medicinsk desinformation kan orsaka allvarlig skada eller död. Google tillämpar striktare algoritmiska standarder på YMYL-innehåll, och LLM:er används i allt större utsträckning av patienter för att söka hälsoinformation, vilket gör YMYL-efterlevnad avgörande för synlighet.

LLM:er sammanställer information från flera källor för att ge direkta svar, medan sökmotorer rankar enskilda sidor. Vårdinnehåll måste nu struktureras för att citeras av AI-system, inte bara för Google-ranking. Det betyder att ditt innehåll kan utbilda tusentals via AI-svar utan att få direkt webbplatstrafik, vilket kräver en fundamentalt annorlunda optimeringsstrategi.

E-E-A-T står för Experience (Erfarenhet), Expertise (Expertis), Authoritativeness (Auktoritet) och Trustworthiness (Trovärdighet). Vårdinnehåll kräver de högsta E-E-A-T-standarderna, med betoning på förstahandserfarenhet och verifierade meriter. Googles Quality Rater Guidelines nämner E-E-A-T 137 gånger, vilket visar dess avgörande betydelse för synlighet för vårdinnehåll både i sök och LLM-system.

Studier visar att AI producerar obestyrkta medicinska påståenden 30–50 % av tiden och hallucinerar medicinsk information. AI saknar verklig medicinsk erfarenhet och kan inte verifiera information mot aktuella medicinska standarder. Därför är mänsklig medicinsk granskning och expertförfattarskap avgörande—AI bör hjälpa vårdpersonal, inte ersätta dem.

Testa ditt innehåll i ChatGPT, Claude och Perplexity med vanliga patientfrågor inom ditt specialistområde. Spåra Share of Model (SOM)-mått—procentandelen AI-svar som citerar ditt innehåll. AmICited.com automatiserar denna övervakning och ger insikter i realtid om hur ditt vårdvarumärke visas på flera LLM-plattformar.

Traditionell SEO fokuserar på att ranka enskilda sidor för nyckelord. LLM-optimering betonar omfattande täckning, semantisk rikedom och strukturerat innehåll som AI-system kan förstå och citera. Båda tillvägagångssätten kompletterar varandra—vårdorganisationer behöver integrerade strategier som optimerar för både sökmotorer och LLM:er.

AI ska endast användas som ett verktyg för att hjälpa mänskliga medicinska experter, inte för att ersätta dem. Allt vårdinnehåll måste granskas och godkännas av kvalificerade medicinska yrkespersoner innan publicering. Riskerna är för stora för att förlita sig på AI-genererat innehåll utan expertgranskning och verifiering.

AmICited.com övervakar hur vårdvarumärken och medicinskt innehåll visas i AI-svar på ChatGPT, Perplexity, Google AI Overviews och andra LLM-plattformar. Tjänsten ger synlighetsmått, spårar Share of Model (SOM) och erbjuder optimeringsrekommendationer som hjälper vårdorganisationer säkerställa att deras expertis är upptäckbar via AI-driven patientforskning.

Spåra hur ditt medicinska innehåll visas i ChatGPT, Perplexity, Google AI Overviews och andra LLM-plattformar. Få insikter i realtid om din Share of Model (SOM) och optimera för AI-driven patientupptäckt.

YMYL-innehåll kräver höga E-E-A-T-standarder. Lär dig vad som kvalificerar som Your Money Your Life-innehåll, varför det är viktigt för SEO och AI-synlighet, sa...

Diskussion i communityn om hur AI-system hanterar YMYL (Your Money or Your Life)-ämnen. Verkliga insikter om synlighet för hälso-, finans- och juridikinnehåll i...

Lär dig hur AI-plattformar som ChatGPT, Perplexity och Google AI Overviews utvärderar finansiellt innehåll. Förstå YMYL-krav, E-E-A-T-standarder och efterlevnad...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.