Påverkar JavaScript AI-crawling? Så påverkas AI-synligheten

Lär dig hur JavaScript påverkar AI-crawlers synlighet. Upptäck varför AI-botar inte kan rendera JavaScript, vilket innehåll som döljs, och hur du optimerar din ...

Lär dig varför AI-crawlers som ChatGPT inte kan se JavaScript-renderat innehåll och hur du gör din sida synlig för AI-system. Upptäck renderingstrategier för AI-synlighet.

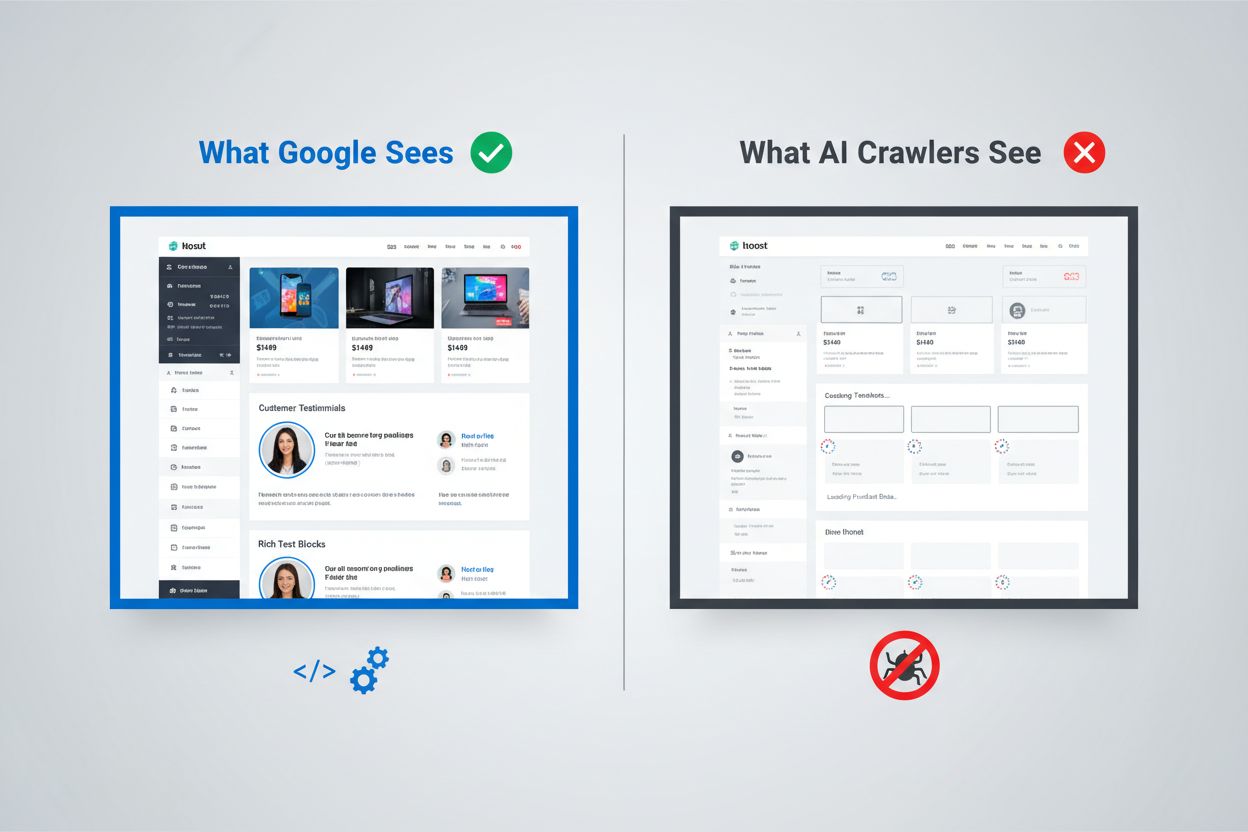

Det digitala landskapet har förändrats i grunden, men de flesta organisationer har inte hängt med. Medan Googles sofistikerade renderingspipeline kan köra JavaScript och indexera dynamiskt genererat innehåll, arbetar AI-crawlers som ChatGPT, Perplexity och Claude under helt andra begränsningar. Detta skapar en kritisk synlighetsklyfta: innehåll som ser helt korrekt ut för mänskliga användare – och till och med för Googles sökmotor – kan vara helt osynligt för AI-systemen som i ökande grad driver trafik och påverkar köpbeslut. Att förstå denna skillnad är inte bara en teknisk nyfikenhet – det blir avgörande för att behålla synlighet i hela det digitala ekosystemet. Insatserna är höga och lösningarna mer nyanserade än de flesta organisationer inser.

Googles syn på JavaScript-rendering representerar ett av de mest sofistikerade systemen någonsin för webbindeksering. Sökmotorn använder ett renderingssystem i två vågor där sidor först crawlas för sitt statiska HTML-innehåll, och sedan renderas igen med en headless Chrome-webbläsare via sin Web Rendering Service (WRS). Under den andra vågen kör Google JavaScript, bygger den kompletta DOM (Document Object Model) och fångar det fullt renderade sidoläget. Processen innefattar renderingscache, vilket betyder att Google kan återanvända tidigare renderade versioner för att spara resurser. Hela systemet är utformat för att hantera komplexiteten i moderna webbapplikationer samtidigt som det kan crawla miljarder sidor. Google investerar enorma datorkraftresurser i denna kapacitet, kör tusentals headless Chrome-inställningar för att bearbeta webben med JavaScript-tungt innehåll. För organisationer som förlitar sig på Google Search betyder detta att deras klientrenderade innehåll har en chans att synas – men bara för att Google har byggt en exceptionellt dyr infrastruktur för detta.

AI-crawlers arbetar under fundamentalt annorlunda ekonomiska och arkitektoniska begränsningar som gör JavaScript-exekvering opraktisk. Resursbegränsningar är den huvudsakliga orsaken: att köra JavaScript kräver att man startar webbläsarmotorer, hanterar minne och behåller tillstånd över förfrågningar – allt kostsamma operationer i stor skala. De flesta AI-crawlers arbetar med timeout-fönster på 1–5 sekunder, vilket innebär att de måste hämta och bearbeta innehåll mycket snabbt eller avbryta begäran helt. Kostnads-nyttoanalysen är inte till fördel för JavaScript-exekvering för AI-system; de kan träna på mycket mer innehåll genom att bara bearbeta statisk HTML istället för att rendera varje sida de stöter på. Dessutom rensar träningsdataprocessen för stora språkmodeller vanligtvis bort CSS och JavaScript vid inläsning, och fokuserar endast på det semantiska HTML-innehållet. Den arkitektoniska filosofin skiljer sig fundamentalt: Google byggde rendering i sitt kärnindexsystem eftersom sökrelevans beror på förståelse av renderat innehåll, medan AI-system prioriterar täckningens bredd över renderingsdjup. Detta är inte en begränsning som enkelt kan överbryggas – det är inbäddat i ekonomin för hur dessa system fungerar.

När AI-crawlers begär en sida får de den råa HTML-filen utan någon JavaScript-exekvering, vilket ofta innebär att de ser en dramatiskt annorlunda version av innehållet än mänskliga användare. Single Page Applications (SPA) byggda med React, Vue eller Angular är särskilt problematiska eftersom de ofta skickar minimal HTML och är helt beroende av JavaScript för att fylla sidans innehåll. En AI-crawler som begär en React-baserad e-handelssajt kan få HTML med tomma <div id="root"></div>-taggar utan någon faktisk produktinformation, pris eller beskrivningar. Crawlern ser sidans skelett men inte själva innehållet. För innehållstunga sajter innebär detta att produktkataloger, blogginlägg, pristabeller och dynamiska innehållssektioner helt enkelt inte existerar ur AI-crawlerns synvinkel. Det finns gott om verkliga exempel: en SaaS-plattforms funktionsjämförelsetabell kan vara helt osynlig, en e-handelssajts produktrekommendationer kanske inte indexeras och en nyhetssajts dynamiskt inlästa artiklar kan framstå som tomma sidor. HTML:en som AI-crawlers får är ofta bara applikationens skal – det faktiska innehållet finns i JavaScript-bundles som aldrig körs. Detta gör att sidan ser perfekt ut i en webbläsare men nästan tom ut för AI-system.

Affärseffekten av denna renderingsklyfta sträcker sig långt bortom tekniska bekymmer och påverkar direkt intäkter, synlighet och konkurrenspositionering. När AI-crawlers inte kan se ditt innehåll drabbas flera kritiska affärsfunktioner:

Den samlade effekten är att organisationer som investerar tungt i innehåll och användarupplevelse kan finna sig själva osynliga för en allt viktigare klass av användare och system. Det här är inte ett problem som löser sig självt – det kräver medvetna åtgärder.

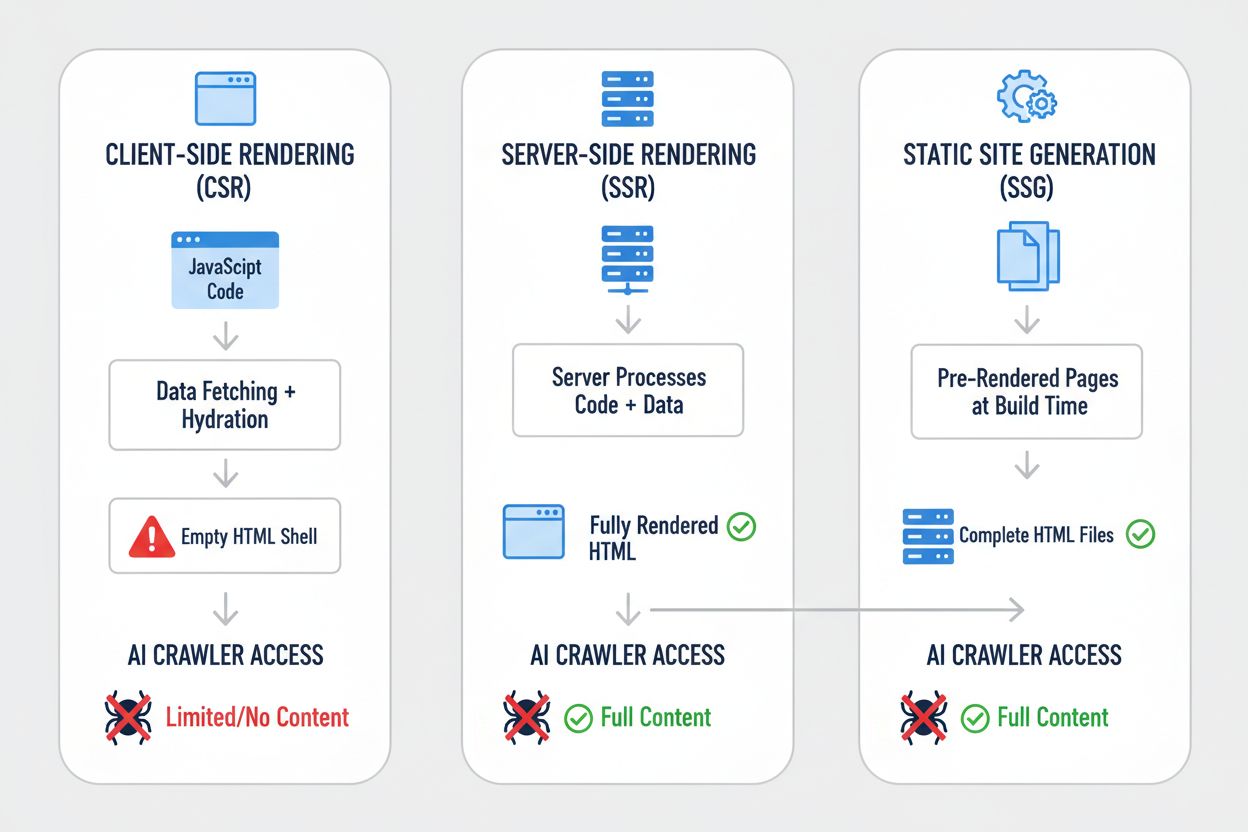

Olika renderingstrategier ger dramatiskt olika resultat när man ser på dem ur AI-crawlerns synvinkel. Valet av renderingsmetod avgör i grunden vad AI-system kan se och indexera. Så här står sig de vanligaste strategierna:

| Strategi | Vad AI ser | Effekt på AI-synlighet | Komplexitet | Bäst för |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Komplett HTML med allt innehåll renderat | Full synlighet – AI ser allt | Hög | Innehållstunga sajter, SEO-kritiska applikationer |

| Static Site Generation (SSG) | Förgenererade HTML-filer | Utmärkt synlighet – allt är statisk HTML | Medel | Bloggar, dokumentation, marknadssajter |

| Client-Side Rendering (CSR) | Tomt HTML-skal, minimalt innehåll | Dålig synlighet – AI ser bara skelettet | Låg | Realtidsdashboards, interaktiva verktyg |

| Hybrid (SSR + CSR) | Initial HTML + klientförbättringar | Bra synlighet – kärninnehåll synligt | Mycket hög | Komplexa applikationer med dynamiska funktioner |

| Pre-rendering-tjänst | Cachad renderad HTML | Bra synlighet – beror på tjänstens kvalitet | Medel | Befintliga CSR-sidor som behöver snabba lösningar |

| API-First + Markup | Strukturerad data + HTML-innehåll | Utmärkt synlighet – om rätt implementerat | Hög | Moderna webbapplikationer, headless CMS |

Varje strategi innebär olika avvägningar mellan utvecklingskomplexitet, prestanda, användarupplevelse och AI-synlighet. Den avgörande insikten är att synlighet för AI-system korrelerar starkt med att ha innehåll i statisk HTML-form – oavsett om HTML:en genereras vid build, vid förfrågan eller serveras från cache. Organisationer måste utvärdera sin renderingsstrategi inte bara för användarupplevelse och prestanda, utan uttryckligen för AI-crawlerns synlighet.

Server-Side Rendering (SSR) är guldstandarden för AI-synlighet eftersom den levererar komplett, renderad HTML till varje begäran – både för mänskliga webbläsare och AI-crawlers. Med SSR kör servern din applikationskod och genererar hela HTML-svaret innan det skickas till klienten, vilket gör att AI-crawlers får en fullständig, renderad sida redan vid första anropet. Moderna ramverk som Next.js, Nuxt.js och SvelteKit har gjort SSR betydligt mer praktiskt än tidigare, och hanterar komplexiteten med hydration (där klient-JavaScript tar över från serverrenderad HTML) transparent. Fördelarna sträcker sig bortom AI-synlighet: SSR förbättrar ofta Core Web Vitals, minskar Time to First Contentful Paint och ger bättre prestanda för användare med långsamma uppkopplingar. Nackdelen är ökad serverbelastning och komplexitet i hanteringen mellan server- och klienttillstånd. För organisationer där AI-synlighet är avgörande – särskilt innehållstunga sajter, e-handelsplattformar och SaaS-appar – är SSR ofta det mest försvarbara valet. Investeringen i SSR-infrastruktur ger utdelning på flera fronter: bättre sökmotorsynlighet, bättre AI-crawler-synlighet, bättre användarupplevelse och bättre prestandamått.

Static Site Generation (SSG) tar ett annat grepp genom att förgenerera sidor vid build, vilket skapar statiska HTML-filer som kan serveras direkt till varje begäran. Verktyg som Hugo, Gatsby och Astro har gjort SSG allt kraftfullare och flexiblare, med stöd för dynamiskt innehåll via API:er och inkrementell statisk återgenerering. När en AI-crawler begär en sida som genererats med SSG får den komplett, statisk HTML med allt innehåll – perfekt synlighet. Prestandavinsterna är exceptionella: statiska filer serveras snabbare än någon dynamisk rendering, och infrastrukturkraven är minimala. Begränsningen är att SSG fungerar bäst för innehåll som inte förändras ofta; sidor måste byggas om och distribueras på nytt vid innehållsuppdateringar. För bloggar, dokumentationssidor, marknadssajter och innehållsrika applikationer är SSG ofta det optimala valet. Kombinationen av utmärkt AI-synlighet, fantastisk prestanda och minimala infrastrukturkrav gör SSG attraktiv för många användningsområden. Men för applikationer som kräver realtidspersonalisering eller frekventa ändringar blir SSG mindre praktiskt utan extra komplexitet som inkrementell återgenerering.

Client-Side Rendering (CSR) är fortsatt populärt trots stora nackdelar för AI-synlighet, främst eftersom det ger bästa utvecklarupplevelsen och den mest flexibla användarupplevelsen för interaktiva applikationer. Med CSR skickar servern minimal HTML och förlitar sig på JavaScript för att bygga sidan i webbläsaren – vilket innebär att AI-crawlers ser nästan ingenting. React-, Vue- och Angular-applikationer använder ofta CSR som standard, och många organisationer har byggt hela sin teknikstack kring detta mönster. Det är förståeligt: CSR möjliggör rika, interaktiva upplevelser, realtidsuppdateringar och smidig navigering. Problemet är att denna flexibilitet sker på bekostnad av AI-synlighet. För applikationer där CSR är absolut nödvändigt – realtidsdashboards, samarbetsverktyg, komplexa interaktiva appar – finns det lösningar. Pre-rendering-tjänster som Prerender.io kan skapa statiska HTML-bilder av CSR-sidor och servera dem till crawlers medan användare får den interaktiva versionen. Alternativt kan organisationer implementera hybrida lösningar där kritiskt innehåll serverrenderas medan interaktiva funktioner förblir klientbaserade. Insikten är att CSR bör vara ett medvetet val med full förståelse för synlighetsavvägningarna, inte ett standardantagande.

Att implementera praktiska lösningar kräver ett systematiskt tillvägagångssätt som börjar med att förstå ditt nuvarande läge och fortsätter via implementering och löpande övervakning. Börja med en revision: använd verktyg som Screaming Frog, Semrush eller egna skript för att crawla din sajt som en AI-crawler och granska vilket innehåll som faktiskt syns i rå-HTML. Genomför renderingsförbättringar baserat på revisionens resultat – det kan innebära migrering till SSR, adoption av SSG för passande sektioner eller implementering av pre-rendering för nyckelsidor. Testa noga genom att jämföra vad AI-crawlers ser mot vad webbläsare ser; använd curl-kommandon för att hämta rå-HTML och jämföra med den renderade versionen. Övervaka kontinuerligt så att ändringar i rendering inte försämrar synligheten över tid. För organisationer med stora, komplexa sajter kan det innebära att prioritera de mest värdefulla sidorna först – produktsidor, prissidor och viktiga innehållsdelar – innan hela sajten hanteras. Verktyg som Lighthouse, PageSpeed Insights och egna övervakningslösningar kan hjälpa att spåra renderingsprestanda och synlighetsmått. Investeringen i att få detta rätt ger utdelning i både söksynlighet, AI-synlighet och total sajtskapacitet.

Testning och övervakning av din renderingsstrategi kräver specifika tekniker som avslöjar vad AI-crawlers faktiskt ser. Det enklaste testet är att använda curl för att hämta rå-HTML utan JavaScript-exekvering:

curl -s https://example.com | grep -i "product\|price\|description"

Detta visar exakt vad en AI-crawler får – om ditt viktigaste innehåll inte syns här kommer det inte att vara synligt för AI-system. Webbläsarbaserad testning via Chrome DevTools kan visa skillnaden mellan initial HTML och den fullständigt renderade DOM:en; öppna DevTools, gå till Network-fliken och granska ursprungligt HTML-svar jämfört med slutligt renderat läge. För löpande övervakning, implementera syntetisk övervakning som regelbundet hämtar dina sidor som en AI-crawler och varnar om synligheten försämras. Spåra mått som “andel innehåll synligt i initial HTML” och “tid till innehållssynlighet” för att förstå renderingsprestandan. Vissa organisationer implementerar egna övervakningspaneler som jämför AI-crawlerns synlighet mot konkurrenter, och ger konkurrensinsikter om vem som optimerar för AI och vem som inte gör det. Nyckeln är att denna övervakning är kontinuerlig och åtgärdsbar – synlighetsproblem ska fångas och åtgärdas snabbt, inte upptäckas månader senare när trafiken plötsligt minskar.

Framtiden för AI-crawlerns kapacitet är osäker, men dagens begränsningar kommer sannolikt inte att förändras dramatiskt inom närtid. OpenAI har experimenterat med mer avancerade crawlers som Comet och Atlas browsers som kan köra JavaScript, men dessa är fortfarande experimentella och används inte i stor skala för datainsamling. De grundläggande ekonomiska förutsättningarna är oförändrade: att köra JavaScript i stor skala är dyrt, och träningsdataprocessen vinner fortfarande mer på bredd än djup. Även om AI-crawlers så småningom får JavaScript-exekvering, skadar inte optimeringen du gör nu – serverrenderat innehåll presterar bättre för användare, laddar snabbare och ger bättre SEO oavsett. Den kloka vägen är att optimera för AI-synlighet nu istället för att vänta på bättre crawlermöjligheter. Det innebär att behandla AI-synlighet som en förstaklassfråga i renderingsstrategin, inte som en eftertanke. Organisationer som gör detta skifte nu får ett försprång när AI-system blir allt viktigare för trafik och synlighet.

Att övervaka din AI-synlighet och spåra förbättringar över tid kräver rätt verktyg och mått. AmICited.com erbjuder en praktisk lösning för att spåra hur ditt innehåll visas i AI-genererade svar och övervaka din synlighet i olika AI-system. Genom att spåra vilka av dina sidor som citeras, återges eller refereras i AI-genererat innehåll kan du förstå den verkliga effekten av dina renderingoptimeringar. Plattformen hjälper dig att identifiera vilket innehåll som är synligt för AI-system och vilket som fortfarande är osynligt, och ger konkreta data på effektiviteten i din renderingsstrategi. När du implementerar SSR, SSG eller pre-rendering-lösningar låter AmICited.com dig mäta den faktiska förbättringen av AI-synligheten – och se om dina optimeringsinsatser leder till fler citeringar och referenser. Denna feedbackloop är avgörande för att motivera investeringen i renderingsförbättringar och för att avgöra vilka sidor som behöver vidare optimering. Genom att kombinera teknisk övervakning av vad AI-crawlers ser med affärsmått på hur ofta ditt innehåll faktiskt syns i AI-svar får du en komplett bild av din AI-synlighet.

Nej, ChatGPT och de flesta AI-crawlers kan inte köra JavaScript. De ser endast rå-HTML från första sidladdningen. Allt innehåll som injiceras via JavaScript efter laddning är helt osynligt för AI-system, till skillnad från Google som använder headless Chrome-webbläsare för att rendera JavaScript.

Google använder headless Chrome-webbläsare för att rendera JavaScript, ungefär som en riktig webbläsare fungerar. Detta är resurskrävande men Google har infrastrukturen för att göra det i stor skala. Googles rendering i två vågor innebär att de först crawlar statisk HTML och sedan renderar sidorna igen med JavaScript för att fånga hela DOM:en.

Inaktivera JavaScript i din webbläsare och ladda din sida, eller använd curl-kommandot för att se rå-HTML. Om viktiga delar saknas kommer AI-crawlers inte heller se dem. Du kan även använda verktyg som Screaming Frog i 'Text Only'-läge för att crawla din sida som en AI-crawler skulle göra.

Nej. Du kan även använda Static Site Generation, pre-rendering-tjänster eller hybridlösningar. Den bästa lösningen beror på din innehållstyp och hur ofta innehållet ändras. SSR fungerar bra för dynamiskt innehåll, SSG för stabilt innehåll och pre-rendering-tjänster för befintliga CSR-sidor.

Google kan hantera JavaScript, så dina Google-rankningar bör inte påverkas direkt. Men optimering för AI-crawlers förbättrar ofta sajtens totala kvalitet, prestanda och användarupplevelse, vilket indirekt kan gynna dina Google-rankningar.

Det beror på hur ofta AI-plattformen crawlar. ChatGPT-User crawlar vid förfrågan när användare efterfrågar innehåll, medan GPTBot crawlar sällan med långa intervall. Ändringar kan ta veckor att synas i AI-svar, men du kan följa utvecklingen med verktyg som AmICited.com.

Pre-rendering-tjänster är enklare att implementera och underhålla med minimala kodändringar, medan SSR ger mer kontroll och bättre prestanda för dynamiskt innehåll. Välj utifrån dina tekniska resurser, hur ofta innehållet uppdateras och applikationens komplexitet.

Ja, du kan använda robots.txt för att blockera specifika AI-crawlers som GPTBot. Men detta innebär att ditt innehåll inte visas i AI-genererade svar, vilket kan minska synlighet och trafik från AI-drivna sökverktyg och assistenter.

Spåra hur AI-system refererar till ditt varumärke på ChatGPT, Perplexity och Google AI Overviews. Identifiera synlighetsluckor och mät effekten av dina renderingoptimeringar.

Lär dig hur JavaScript påverkar AI-crawlers synlighet. Upptäck varför AI-botar inte kan rendera JavaScript, vilket innehåll som döljs, och hur du optimerar din ...

Lär dig hur du testar om AI-crawlers som ChatGPT, Claude och Perplexity kan komma åt innehållet på din webbplats. Upptäck testmetoder, verktyg och bästa praxis ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.