JavaScript-rendering för AI

Lär dig hur JavaScript-rendering påverkar AI-synlighet. Upptäck varför AI-crawlers inte kan köra JavaScript, vilket innehåll som döljs och hur för-rendering säk...

Lär dig hur prerendering gör JavaScript-innehåll synligt för AI-crawlers som ChatGPT, Claude och Perplexity. Upptäck de bästa tekniska lösningarna för AI-sökmotoroptimering och förbättra din synlighet i AI-drivna sökresultat.

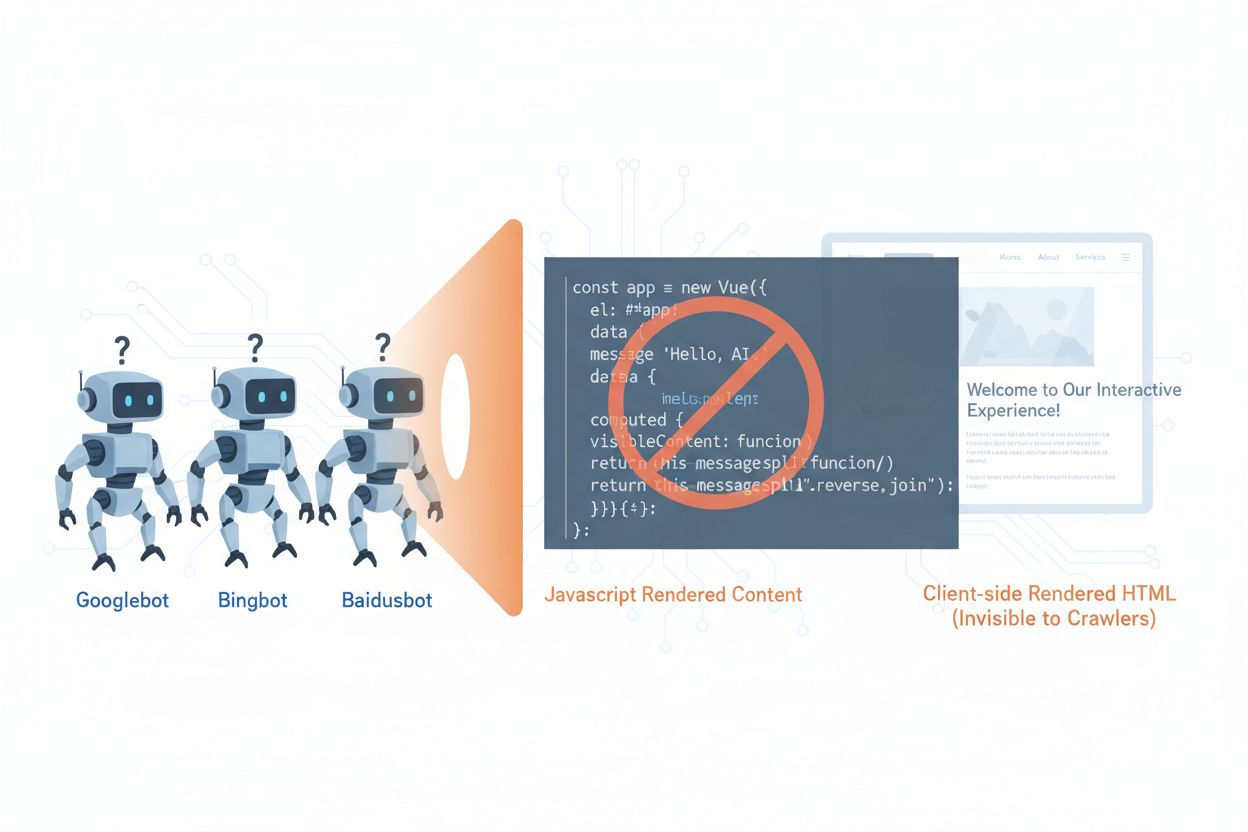

AI-crawlers som GPTBot, ClaudeBot och PerplexityBot har fundamentalt förändrat hur innehåll upptäcks och indexeras på webben, men de står inför en avgörande begränsning: de kan inte köra JavaScript. Det innebär att allt innehåll som renderas dynamiskt med JavaScript—och som driver moderna single-page-appar (SPA), dynamiska produktsidor och interaktiva dashboards—blir helt osynligt för dessa crawlers. Enligt färska data står AI-crawlers nu för cirka 28 % av Googlebots trafik, vilket gör dem till en betydande del av din webbplats crawlbudget och en avgörande faktor för innehållstillgänglighet. När en AI-crawler begär en sida får den det initiala HTML-skalet utan det renderade innehållet, vilket i praktiken innebär att den ser en tom eller ofullständig version av din webbplats. Detta skapar en paradox: ditt innehåll är helt synligt för mänskliga användare med JavaScript-aktiverade webbläsare, men osynligt för de AI-system som i allt högre grad påverkar innehållsupptäckt, sammanfattning och ranking i AI-drivna sökmotorer och applikationer.

De tekniska orsakerna bakom AI-crawlers JavaScript-begränsningar bottnar i grundläggande arkitekturskillnader mellan hur webbläsare och crawlers bearbetar webbinnehåll. Webbläsare har en fullständig JavaScript-motor som kör kod, manipulerar DOM (Document Object Model) och renderar det slutliga visuella resultatet, medan AI-crawlers vanligtvis arbetar med minimala eller inga JavaScript-funktioner på grund av resursbegränsningar och säkerhetsskäl. Asynkron inläsning—där innehåll hämtas från API:er efter den initiala sidladdningen—utgör ytterligare en stor utmaning, eftersom crawlers bara får den initiala HTML:en innan innehållet anländer. Single-page-appar (SPA) förvärrar detta problem genom att förlita sig helt på klientbaserad routing och rendering, vilket lämnar crawlers med endast ett JavaScript-paket. Så här jämförs olika renderingsmetoder när det gäller AI-crawler-synlighet:

| Rendering Method | Hur det fungerar | AI-crawler-synlighet | Prestanda | Kostnad |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Webbläsaren kör JavaScript för att rendera innehåll | ❌ Dålig | Snabbt för användare | Låg infrastruktur |

| SSR (Server-Side Rendering) | Servern renderar HTML vid varje begäran | ✅ Utmärkt | Långsammare initial laddning | Hög infrastruktur |

| SSG (Static Site Generation) | Innehåll förbyggs vid byggtillfället | ✅ Utmärkt | Snabbast | Medel (byggtid) |

| Prerendering | Statisk HTML cachelagras vid behov | ✅ Utmärkt | Snabb | Medel (balanserad) |

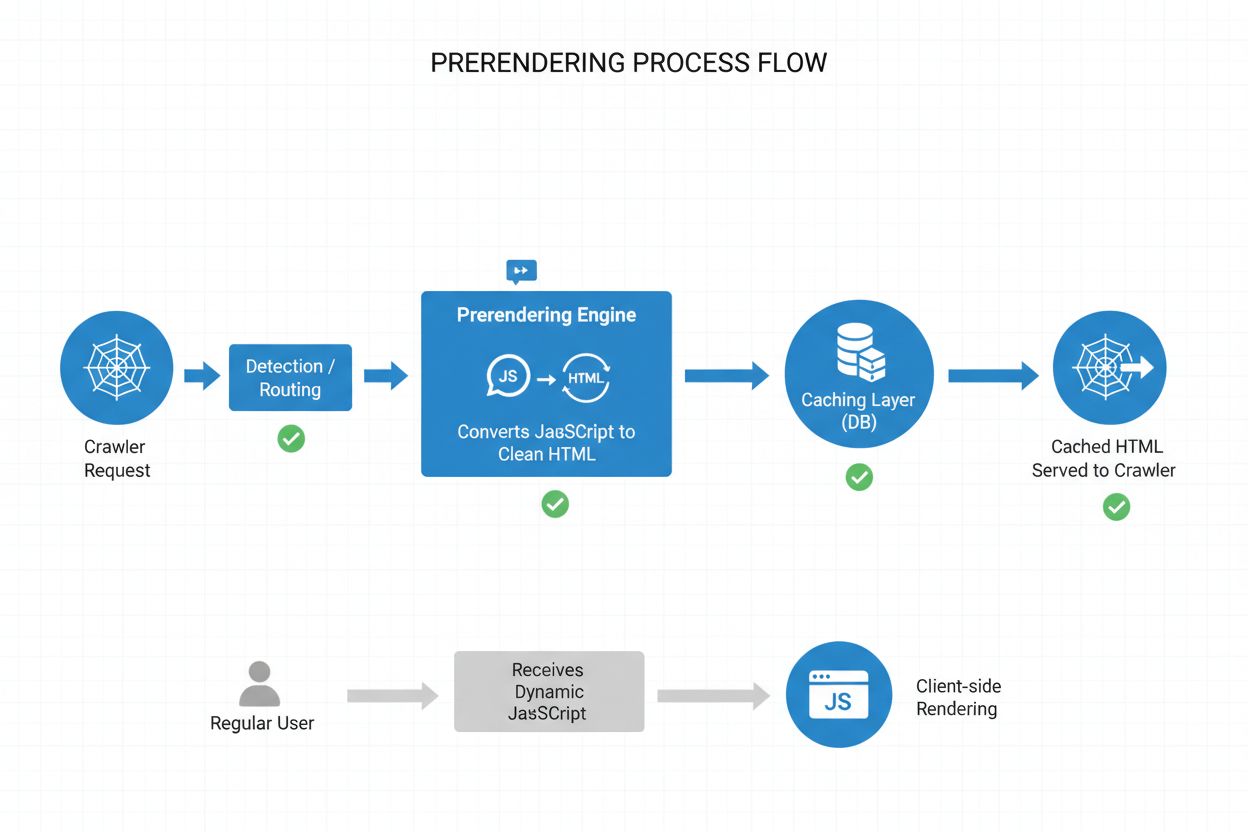

Prerendering erbjuder en elegant mellanväg mellan de resurskrävande kraven för server-side rendering och byggtidsbegränsningarna för statisk webbplatsgenerering. Istället för att rendera innehåll vid varje begäran (SSR) eller vid byggtid (SSG), genererar prerendering statiska HTML-bilder vid behov när en crawler eller bot begär en sida, och cachelagrar sedan den renderade versionen för efterföljande förfrågningar. Det innebär att AI-crawlers får fullrenderad, statisk HTML med allt innehåll som normalt skulle genereras av JavaScript, medan vanliga användare fortsätter att få den dynamiska, interaktiva versionen av din webbplats utan några förändringar i upplevelsen. Prerendering är särskilt kostnadseffektivt eftersom det bara renderar sidor som faktiskt begärs av crawlers, vilket undviker overheaden att förrendera hela webbplatsen eller underhålla dyr server-side rendering-infrastruktur. Underhållsbehovet är minimalt—din applikationskod förblir oförändrad och prerenderingslagret arbetar transparent i bakgrunden, vilket gör det till en idealisk lösning för team som vill ha AI-crawler-tillgänglighet utan arkitektoniska ombyggnationer.

Prerenderingsprocessen fungerar genom ett sofistikerat men enkelt arbetsflöde som säkerställer att AI-crawlers får optimerat innehåll samtidigt som användare inte märker någon skillnad. När en förfrågan kommer till din server detekteras användaragenten för att avgöra om det är en AI-crawler (GPTBot, ClaudeBot, PerplexityBot) eller en vanlig webbläsare. Om en AI-crawler upptäcks dirigeras förfrågan till prerenderingsmotorn, som startar ett headless webbläsarinstans, kör allt JavaScript, väntar på asynkront innehåll och genererar en komplett statisk HTML-bild av den renderade sidan. Denna HTML cachelagras (vanligtvis i 24–48 timmar) och serveras direkt till crawlers, vilket kringgår din applikation helt och minskar serverbelastningen. Samtidigt kringgår vanliga webbläsarförfrågningar helt prerenderingslagret och får din dynamiska applikation som vanligt, vilket säkerställer att användare får hela den interaktiva upplevelsen med realtidsuppdateringar och dynamisk funktionalitet. Allt detta sker transparent—crawlers ser fullrenderat innehåll, användare ser din applikation oförändrad och din infrastruktur förblir effektiv eftersom prerendering bara aktiveras för bot-trafik.

Även om både prerendering och server-side rendering (SSR) löser JavaScript-synlighetsproblemet skiljer de sig avsevärt när det gäller implementation, kostnad och skalbarhet. SSR renderar innehåll vid varje enskild begäran, vilket innebär att din server måste starta en JavaScript-runtime, köra hela din applikationskod och generera HTML för varje besökare—en process som blir mycket kostsam i stor skala och kan öka Time to First Byte (TTFB) för alla användare. Prerendering, däremot, cachelagrar renderade sidor och genererar dem endast på nytt när innehållet ändras eller cachen löper ut, vilket dramatiskt minskar serverbelastningen och förbättrar svarstider för både crawlers och användare. SSR är vettigt för mycket personligt innehåll eller ofta förändrade data där varje användare behöver unik HTML, medan prerendering passar bäst för innehåll som är relativt statiskt eller förändras sällan—produktsidor, blogginlägg, dokumentation och marknadsföringsmaterial. Många avancerade implementationer använder en hybridstrategi: prerendering för AI-crawlers och statiskt innehåll, SSR för personliga användarupplevelser och klientrendering för interaktiva funktioner. Denna lagerindelade strategi ger det bästa av alla världar—utmärkt AI-crawler-tillgänglighet, snabb prestanda för användare och rimliga infrastrukturkostnader.

Strukturerad data i JSON-LD-format är avgörande för att hjälpa AI-crawlers förstå ditt innehålls betydelse och kontext, men de flesta implementationer missar AI-crawlers begränsningar. När strukturerad data injiceras i sidan via JavaScript—en vanlig praxis med Google Tag Manager och liknande tagghanteringssystem—ser AI-crawlers den aldrig eftersom de inte kör JavaScript som skapar dessa datastrukturer. Det innebär att rich snippets, produktinformation, organisationsdetaljer och annan semantisk märkning förblir osynlig för AI-system, även om de är fullt synliga för traditionella sökmotorer som har utvecklats för att hantera JavaScript. Lösningen är enkel: se till att all kritisk strukturerad data finns i server-renderad HTML, inte injicerad via JavaScript. Detta kan innebära att flytta JSON-LD-block från din tag manager till din applikations server-side-mall, eller använda prerendering för att fånga JavaScript-injicerad strukturerad data och leverera den som statisk HTML till crawlers. AI-crawlers är starkt beroende av strukturerad data för att extrahera fakta, relationer och entitetsinformation, vilket gör server-side-strukturerad data till en nödvändighet för AI-drivna sökmotorer och kunskapsgrafintegration.

Att implementera prerendering kräver en strategisk metod som balanserar täckning, kostnad och underhåll. Följ dessa steg för att komma igång:

Identifiera JavaScript-tunga sidor: Granska din webbplats för att hitta sidor där kritiskt innehåll renderas med JavaScript—oftast SPA, dynamiska produktsidor och interaktiva dashboards. Använd verktyg som Lighthouse eller manuell inspektion för att hitta sidor där initial HTML skiljer sig avsevärt från den renderade versionen.

Välj en prerenderingstjänst: Välj en prerenderingstjänst som Prerender.io, som hanterar headless browser-rendering, cachelagring och crawlerdetektion. Utvärdera utifrån pris, cachelängd, API-tillförlitlighet och stöd för din tekniska stack.

Konfigurera användaragentdetektion: Ställ in din server eller CDN för att upptäcka AI-crawler-användaragenter (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) och dirigera dem till prerenderingstjänsten, medan vanliga webbläsare släpps igenom som vanligt.

Testa och validera: Använd verktyg som curl med anpassade användaragenter för att verifiera att crawlers får fullrenderad HTML. Testa med verkliga AI-crawler-användaragenter för att säkerställa att innehållet är synligt och strukturerad data finns med.

Övervaka resultat: Sätt upp loggning och analys för att spåra prerenderingens effektivitet, cacheträffar och eventuella renderingsfel. Övervaka din prerenderingstjänsts dashboard för prestandamått och fel.

Effektiv övervakning är avgörande för att säkerställa att din prerenderingsimplementation fortsätter att fungera korrekt och att AI-crawlers kan komma åt ditt innehåll. Logganalys är ditt främsta verktyg—granska dina serverloggar för att identifiera förfrågningar från AI-crawler-användaragenter, spåra vilka sidor de besöker och identifiera mönster i crawl-beteende eller fel. De flesta prerenderingstjänster som Prerender.io erbjuder dashboards som visar cacheträffar, renderingsframgång/fel och prestandastatistik, vilket ger dig insyn i hur väl ditt prerenderade innehåll levereras. Viktiga mått att följa är cacheträffar (andel förfrågningar som levereras från cache), renderingsframgång (andel sidor som renderas utan fel), genomsnittlig rendertid och crawlers trafikvolym. Sätt upp larm för renderingsfel eller ovanliga crawl-mönster som kan tyda på problem med din webbplats JavaScript eller dynamiska innehåll. Genom att korrelera prerenderingsmått med din AI-söktrafik och innehållssynlighet kan du kvantifiera effekten av din prerendering och identifiera optimeringsmöjligheter.

Framgångsrik prerendering kräver noggrannhet och löpande underhåll. Undvik dessa vanliga fallgropar:

Prerendra inte 404-sidor: Konfigurera din prerenderingstjänst att hoppa över sidor som returnerar 404-status, eftersom cachelagring av felsidor slösar resurser och förvirrar crawlers om din webbplats struktur.

Säkerställ färskt innehåll: Sätt lämpliga cacheutgångstider baserat på hur ofta ditt innehåll ändras. Sidor med hög trafik och frekventa uppdateringar kan behöva cachefönster på 12–24 timmar, medan statiskt innehåll kan ha längre perioder.

Övervaka kontinuerligt: Sätt inte bara upp prerendering och glöm bort det. Kontrollera regelbundet att sidor renderas korrekt, att strukturerad data finns med och att crawlers får det förväntade innehållet.

Undvik cloaking: Servera aldrig annat innehåll till crawlers än till användare—detta bryter mot sökmotorns riktlinjer och undergräver förtroendet. Prerendering ska visa crawlers samma innehåll som användare ser, fast i statisk form.

Testa med faktiska crawlers: Använd riktiga AI-crawler-användaragenter i dina tester, inte bara generiska bot-id:n. Olika crawlers kan ha olika renderingskrav eller begränsningar.

Håll innehållet uppdaterat: Om ditt prerenderade innehåll blir gammalt kommer crawlers att indexera inaktuella uppgifter. Implementera cache-invalideringsstrategier som uppdaterar prerenderade sidor när innehållet ändras.

Betydelsen av AI-crawler-optimering kommer bara att öka i takt med att dessa system blir allt viktigare för innehållsupptäckt och kunskapsutvinning. Även om nuvarande AI-crawlers har begränsad JavaScript-exekvering antyder nya tekniker som Comet och Atlas browsers att framtidens crawlers kan få mer avancerade renderingsförmågor, även om prerendering fortsatt kommer vara värdefullt för prestanda och tillförlitlighet. Genom att implementera prerendering nu löser du inte bara dagens AI-crawler-problem—du framtidssäkrar ditt innehåll mot förändrade crawler-förutsättningar och säkerställer att din webbplats förblir tillgänglig oavsett hur AI-system utvecklas. Konvergensen mellan traditionell SEO och AI-crawler-optimering innebär att du måste ha ett helhetsperspektiv: optimera för både mänskliga användare och AI-system, säkerställ att ditt innehåll är tillgängligt i flera format och behåll flexibiliteten att anpassa dig när landskapet förändras. Prerendering är en pragmatisk, skalbar lösning som överbryggar gapet mellan moderna JavaScript-tunga applikationer och de tillgänglighetskrav som AI-drivna sök- och upptäcktsystem ställer, och är därför en viktig del av varje framtidsinriktad SEO- och innehållsstrategi.

Prerendering genererar statiska HTML-bilder vid behov och cache-lagrar dem, medan server-side rendering (SSR) renderar innehåll vid varje enskild begäran. Prerendering är mer kostnadseffektivt och skalbart för de flesta användningsområden, medan SSR är bättre för mycket personligt eller ofta förändrat innehåll som kräver unik HTML för varje användare.

Nej, prerendering påverkar endast hur crawlers ser ditt innehåll. Vanliga användare fortsätter att få din dynamiska, interaktiva JavaScript-applikation precis som tidigare. Prerendering fungerar transparent i bakgrunden och har ingen inverkan på användarens funktionalitet eller prestanda.

Cache-utgångstider beror på hur ofta ditt innehåll ändras. Sidor med hög trafik och frekventa uppdateringar kan behöva cachefönster på 12–24 timmar, medan statiskt innehåll kan använda längre perioder. De flesta prerenderingstjänster låter dig konfigurera cache-tider per sida eller mall.

Ja, prerendering fungerar bra med dynamiskt innehåll. Du kan ställa in kortare cache-tider för sidor som ändras ofta, eller implementera cache-invalideringsstrategier som uppdaterar prerenderade sidor när innehållet ändras. Detta säkerställer att crawlers alltid ser relativt färskt innehåll.

De viktigaste AI-crawlers att optimera för är GPTBot (ChatGPT), ClaudeBot (Claude) och PerplexityBot (Perplexity). Du bör även fortsätta optimera för traditionella crawlers som Googlebot och Bingbot. De flesta prerenderingstjänster stödjer konfiguration för alla större AI- och sökcrawlers.

Om du redan använder SSR har du bra tillgänglighet för AI-crawlers. Men prerendering kan ändå ge fördelar genom att minska serverbelastningen, förbättra prestandan och erbjuda ett cachelager som gör din infrastruktur mer effektiv och skalbar.

Övervaka din prerenderingstjänsts dashboard för cacheträffar, renderingsframgång och prestandastatistik. Kontrollera dina serverloggar för AI-crawler-förfrågningar och verifiera att de får fullrenderad HTML. Följ förändringar i din AI-söksynlighet och innehållscitat över tid.

Prerenderingskostnader varierar beroende på tjänst och användningsvolym. De flesta leverantörer erbjuder nivåbaserad prissättning baserat på antal renderade sidor per månad. Kostnaderna är oftast betydligt lägre än att underhålla server-side rendering-infrastruktur, vilket gör prerendering till en kostnadseffektiv lösning för de flesta webbplatser.

Spåra hur AI-plattformar som ChatGPT, Claude och Perplexity refererar till ditt innehåll med AmICited. Få insikter i realtid om din AI-söksynlighet och optimera din innehållsstrategi.

Lär dig hur JavaScript-rendering påverkar AI-synlighet. Upptäck varför AI-crawlers inte kan köra JavaScript, vilket innehåll som döljs och hur för-rendering säk...

Lär dig hur JavaScript påverkar AI-crawlers synlighet. Upptäck varför AI-botar inte kan rendera JavaScript, vilket innehåll som döljs, och hur du optimerar din ...

Lär dig hur du gör ditt innehåll synligt för AI-crawlers som ChatGPT, Perplexity och Googles AI. Upptäck tekniska krav, bästa praxis och övervakningsstrategier ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.