AI Crawler Referenskort: Alla Botar i Överblick

Fullständig referensguide till AI-crawlers och botar. Identifiera GPTBot, ClaudeBot, Google-Extended och 20+ andra AI-crawlers med user agents, crawl-hastighete...

Lär dig hur du optimerar XML-sitemaps för AI-crawlers som GPTBot och ClaudeBot. Bemästra sitemap-bästa praxis för att förbättra synligheten i AI-genererade svar och LLM-indexering.

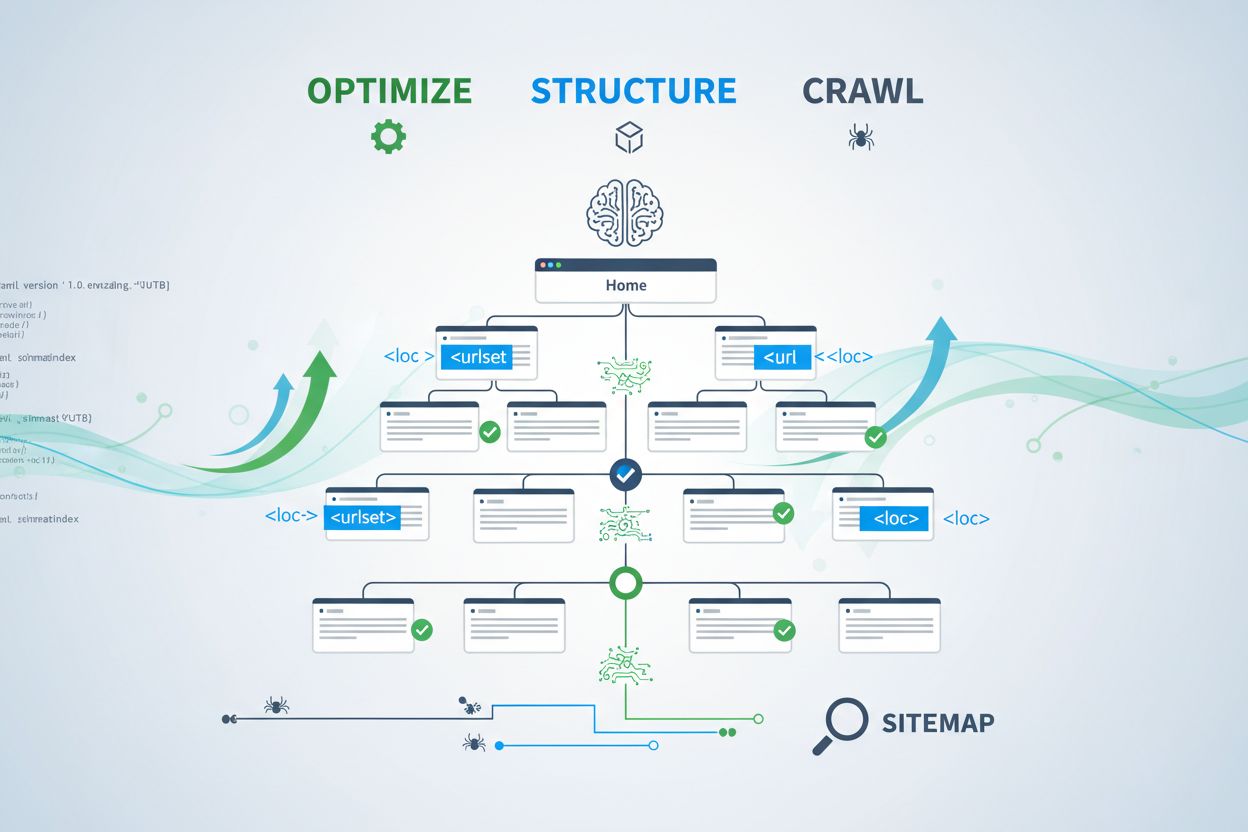

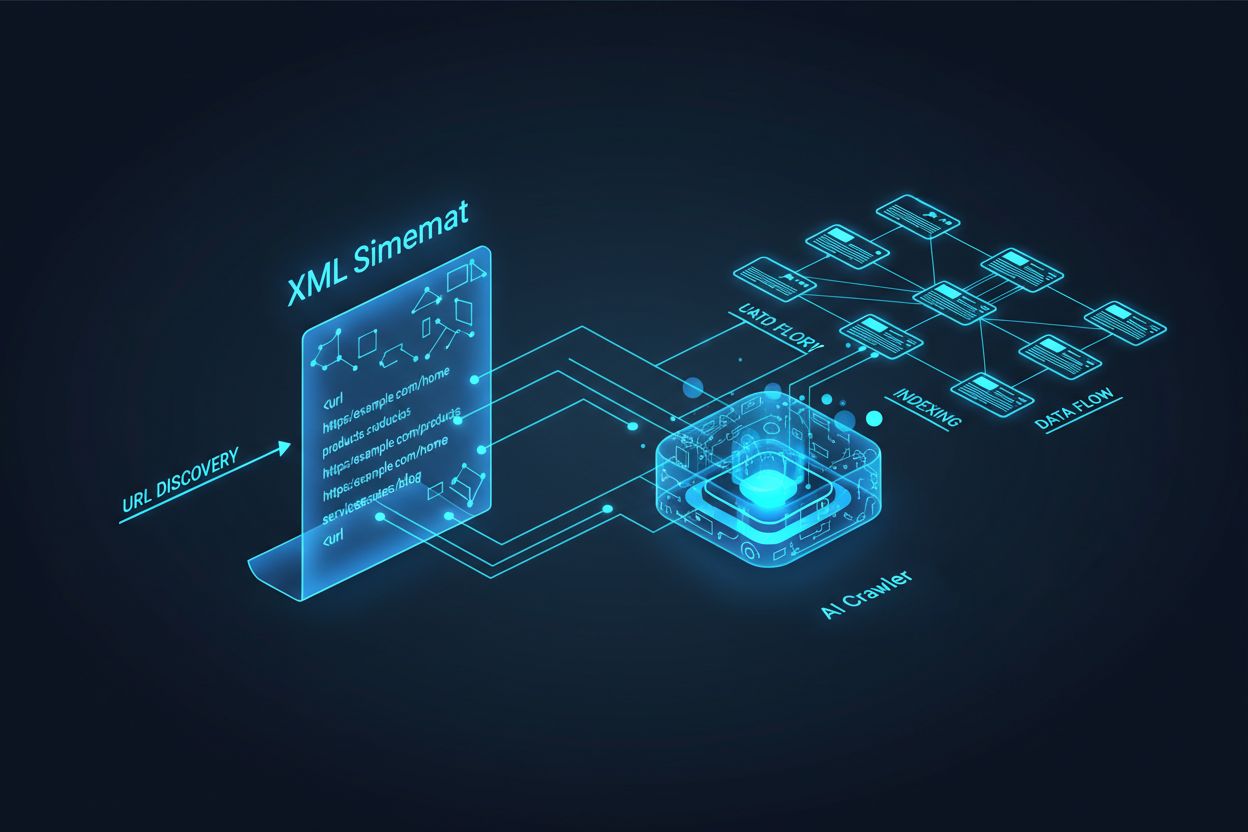

AI-crawlers som GPTBot, ClaudeBot och PerplexityBot arbetar fundamentalt annorlunda än traditionella sökmotor-botar. Medan Googlebot indexerar sidor för ranking i sökresultat, extraherar AI-crawlers kunskap för att träna och informera stora språkmodeller som driver konversationell sökning och AI-genererade svar. Utan en korrekt optimerad XML-sitemap förblir ditt innehåll osynligt för dessa kritiska system, oavsett hur välskrivet eller auktoritativt det är. Tänk på din sitemap som en vägkarta som berättar för AI-system exakt var ditt mest värdefulla innehåll finns och hur det är organiserat.

Skillnaden mellan traditionella sök-crawlers och AI-crawlers är avgörande för att förstå varför sitemapoptimering är viktigare än någonsin. Traditionella sökmotorer som Google fokuserar på att ranka enskilda sidor för specifika nyckelord, medan AI-crawlers prioriterar kunskapsinsamling och semantisk förståelse. Så här skiljer de sig:

| Aspekt | Traditionella crawlers (Googlebot) | AI-crawlers (GPTBot, ClaudeBot) |

|---|---|---|

| Huvudsyfte | Rankar sidor i sökresultat | Extraherar kunskap för LLM-träning och realtidssvar |

| Fokus | Metadata, interna länkar, rankningssignaler | Innehållsstruktur, semantisk mening, faktatäthet |

| Crawl-prioritet | Baserad på PageRank och aktualitet | Baserad på auktoritet, ämnesrelevans och kunskapsvärde |

| Citatpåverkan | Driver trafik via blå länkar | Avgör om ditt innehåll visas i AI-genererade svar |

| JavaScript-hantering | Kör och renderar JavaScript | Hoppar ofta över JavaScript; prioriterar server-renderad HTML |

Denna grundläggande skillnad innebär att optimering för traditionell SEO inte längre räcker. Din sitemap måste nu tjäna dubbla syften: hjälpa traditionella sökmotorer att förstå din webbplatsstruktur och samtidigt guida AI-system till dina mest värdefulla kunskapstillgångar.

En XML-sitemap fungerar som din webbplats ritning och talar uttryckligen om för crawlers vilka sidor som finns och hur de relaterar till din övergripande innehållsstrategi. För AI-system fyller sitemaps en ännu mer kritisk funktion än för traditionell sökning. AI-crawlers använder sitemaps för att förstå din webbplats ämnesarkitektur, identifiera högprioriterat innehåll och avgöra vilka sidor som förtjänar djupare analys. När din sitemap är omfattande och välorganiserad kan AI-system mer effektivt upptäcka och utvärdera ditt innehåll för inkludering i generativa svar. Omvänt skapar en ofullständig eller föråldrad sitemap blinda fläckar som hindrar AI-system från att nå dina viktigaste sidor. Effekten är direkt: sidor som inte finns i din sitemap har mycket mindre chans att citeras av AI-system, oavsett deras kvalitet eller relevans.

Att skapa en effektiv sitemap för AI-crawlers kräver mer än att bara lista alla URL:er på din webbplats. Din sitemap bör vara strategiskt utvald för att endast inkludera sidor som verkligen ger värde för användare och AI-system. Här är de viktigaste bästa praxis:

En välstrukturerad sitemap fungerar som ett kvalitetsfilter och signalerar till AI-system att du noggrant har valt ut ditt innehåll och att varje inkluderad URL förtjänar uppmärksamhet. Denna strategiska metod förbättrar avsevärt dina chanser att bli utvald för citat i AI-genererade svar.

Aktualitet är en av de starkaste rankingfaktorerna i AI-drivna söksystem. När AI-crawlers utvärderar vilka källor de ska citera i genererade svar väger de aktualitet tungt. Lastmod-tidsstämpeln i din XML-sitemap är den främsta signalen som berättar för AI-system när ditt innehåll senast uppdaterades. Föråldrade eller saknade tidsstämplar kan göra att även auktoritativt innehåll prioriteras ned till förmån för nyare källor. Om din sitemap visar att en sida inte har uppdaterats på flera år kan AI-system anta att informationen är inaktuell och istället välja konkurrentinnehåll. Korrekta lastmod-tidsstämplar som återspeglar faktiska innehållsuppdateringar signalerar däremot till AI-crawlers att din information är aktuell och pålitlig. För tidskänsliga ämnen som prissättning, regleringar eller branschtrender blir korrekta tidsstämplar ännu viktigare. Automatiska tidsstämpeluppdateringar via ditt CMS säkerställer att varje innehållsändring omedelbart återspeglas i din sitemap och maximerar din synlighet i AI-genererade svar.

Medan sitemaps bjuder in crawlers att indexera ditt innehåll, styr robots.txt-filer vilka delar av din webbplats crawlers får komma åt. Dessa två filer måste samverka för att maximera din AI-synlighet. Ett vanligt misstag är att skapa en omfattande sitemap samtidigt som man blockerar AI-crawlers i robots.txt-filen, vilket skapar en motsägelse som förvirrar crawlers och minskar din synlighet. Din robots.txt bör uttryckligen tillåta större AI-crawlers som GPTBot, ClaudeBot och PerplexityBot att komma åt ditt innehåll. Du kan använda robots.txt strategiskt för att bara blockera sidor som inte ska indexeras, såsom administrationspaneler, inloggningssidor eller dubblettversioner av innehåll. Det viktiga är att dina robots.txt-regler stämmer överens med din sitemapstrategi—om en sida finns i din sitemap ska den vara åtkomlig enligt robots.txt-reglerna. Regelbundna revisioner av båda filerna hjälper dig att identifiera felkonfigurationer som tyst kan begränsa din AI-synlighet.

De mest effektiva AI-optimeringsstrategierna behandlar sitemaps och strukturerad data som kompletterande system som förstärker varandra. När din sitemap lyfter fram en sida som viktig och den sidan innehåller relevant schema-markning skickar du konsekventa signaler till AI-crawlers om sidans syfte och värde. Om din sitemap till exempel prioriterar en guide bör den sidan inkludera HowTo-schema som ger strukturerad information om stegen. På samma sätt bör produktsidor i din sitemap innehålla Product-schema med pris, tillgänglighet och recensioner. Denna anpassning skapar en sammanhängande databild som AI-system lätt kan tolka och lita på. När sitemaps och strukturerad data står i konflikt eller avviker blir AI-crawlers osäkra på sidans verkliga syfte, vilket minskar sannolikheten för citat. Genom att säkerställa att din sitemapstrategi stämmer överens med ditt schema skapar du en enhetlig signal som dramatiskt förbättrar dina chanser att bli utvald för AI-genererade svar.

Olika typer av innehåll kräver olika sitemapstrategier för att maximera AI-synlighet. Blogginlägg, produktsidor, tjänstebeskrivningar och FAQ-innehåll fyller alla olika syften och bör optimeras därefter:

| Innehållstyp | Sitemapstrategi | Rekommenderad schema-markning | Prioriteringsöverväganden |

|---|---|---|---|

| Blogginlägg & Artiklar | Inkludera med korrekta publicerings- och uppdateringsdatum | Article, NewsArticle, BlogPosting | Prioritera aktuellt, evergreen-innehåll; uppdatera lastmod regelbundet |

| Produktsidor | Inkludera vid lageruppdateringar; överväg separat produktsitemap | Product, Offer, AggregateRating | Lyft fram storsäljare och nya produkter; uppdatera priser ofta |

| Tjänstesidor | Inkludera med uppdateringsdatum för tjänster | Service, LocalBusiness, ProfessionalService | Prioritera kärntjänster; uppdatera tillgänglighet och prissättning |

| FAQ-sidor | Inkludera med uppdateringsdatum för innehåll | FAQPage, Question, Answer | Prioritera omfattande FAQ; uppdatera svar när informationen ändras |

| Videoinnehåll | Inkludera i video-sitemap med miniatyrbild och längd | VideoObject, Video | Inkludera transkript; uppdatera visningsantal och engagemangsdata |

| Bildinnehåll | Inkludera i bild-sitemap med bildtexter | ImageObject, Product (för produktbilder) | Optimera alt-text; inkludera beskrivande bildtexter |

Denna differentierade metod säkerställer att varje innehållstyp får lämplig optimering för AI-upptäckt. Genom att anpassa din sitemapstrategi till din innehållsmix maximerar du sannolikheten att AI-system hittar och citerar dina mest värdefulla tillgångar.

Standarden llms.txt, som föreslogs i slutet av 2024, representerar ett experimentellt tillvägagångssätt för att hjälpa AI-system förstå webbplatsstruktur. Till skillnad från XML-sitemaps är llms.txt en Markdown-baserad fil som ger en mänskligt läsbar innehållsförteckning för din webbplats. Den listar dina viktigaste sidor och resurser i ett format som är lättare för språkmodeller att tolka och förstå. Även om konceptet är lovande tyder nuvarande bevis på att llms.txt har minimal påverkan på AI-synlighet jämfört med traditionella XML-sitemaps. Stora AI-crawlers som GPTBot och ClaudeBot förlitar sig fortfarande huvudsakligen på XML-sitemaps för URL-upptäckt och aktualitetssignaler. Istället för att ersätta din XML-sitemap bör llms.txt ses som ett kompletterande verktyg som kan ge ytterligare kontext till AI-system. Om du implementerar llms.txt, se till att det kompletterar snarare än ersätter din kärnsitemapstrategi, och fokusera först på att förfina din XML-sitemap med korrekta tidsstämplar och strategisk innehållskurering.

Även välmenande webbplatser gör ofta kritiska sitemapfel som tyst begränsar deras AI-synlighet. Att förstå och undvika dessa misstag är avgörande för att maximera din närvaro i AI-genererade svar:

Att åtgärda dessa vanliga misstag kan omedelbart förbättra din AI-synlighet. Börja med att granska din nuvarande sitemap mot denna checklista och åtgärda eventuella problem du identifierar.

Att upprätthålla en optimerad sitemap kräver kontinuerlig övervakning och validering. Flera verktyg kan hjälpa dig att säkerställa att din sitemap förblir effektiv för AI-crawlers. Google Search Console tillhandahåller inbyggd sitemapvalidering och visar hur många URL:er Google har indexerat från din sitemap. Screaming Frog SEO Spider låter dig genomsöka hela din webbplats och jämföra resultaten med din sitemap för att identifiera saknade eller trasiga URL:er. XML-sitemapvalidatorer kontrollerar din sitemaps syntax och säkerställer att den följer XML-sitemap-protokollet. För större företag innehåller dedikerade SEO-plattformar som Semrush och Ahrefs sitemap-analysfunktioner som spårar förändringar över tid. Regelbundna revisioner—helst varje månad—hjälper dig att upptäcka problem innan de påverkar din AI-synlighet. Lägg in kalenderpåminnelser för att granska din sitemap när du gör stora innehållsförändringar, lanserar nya avsnitt eller uppdaterar webbplatsens arkitektur.

Att förstå hur AI-crawlers interagerar med din sitemap kräver aktiv övervakning och analys. Dina serverloggar innehåller värdefulla data om vilka AI-crawlers som besöker din webbplats, hur ofta de crawlar och vilka sidor de prioriterar. Genom att analysera dessa loggar kan du identifiera mönster och optimera din sitemap därefter. Verktyg som AmICited.com hjälper dig att övervaka hur ofta ditt innehåll citeras av AI-system som ChatGPT, Claude, Perplexity och Googles AI Overviews, vilket ger direkt återkoppling på din sitemaps effektivitet. Google Analytics kan konfigureras för att spåra hänvisningstrafik från AI-system och visa vilka sidor som genererar mest AI-driven synlighet. Genom att korrelera dessa data med din sitemapstruktur kan du identifiera vilka innehållstyper och ämnen som resonerar mest med AI-system. Detta datadrivna tillvägagångssätt gör att du kontinuerligt kan förfina din sitemapstrategi och prioritera innehåll som genererar flest AI-citat och synlighet.

Utöver grundläggande sitemapoptimering kan avancerade strategier avsevärt stärka din AI-synlighet. Att skapa separata sitemaps för olika innehållstyper—till exempel dedikerade blogsitemaps, produktsitemaps och videositemaps—gör att du kan tillämpa typ-specifika optimeringsstrategier. Dynamisk sitemapgenerering, där din sitemap uppdateras i realtid när innehållet ändras, säkerställer att AI-crawlers alltid ser ditt mest aktuella innehåll. För stora företagswebbplatser med tusentals sidor hjälper implementering av sitemap-hierarkier och strategisk prioritering AI-crawlers att fokusera på ditt mest värdefulla innehåll. Vissa organisationer skapar AI-specifika sitemaps som endast lyfter fram deras mest auktoritativa, mest citatvärda innehåll och signalerar till AI-system vilka sidor som förtjänar särskild uppmärksamhet. Att integrera din sitemapstrategi med ditt innehållshanteringssystem säkerställer att optimering sker automatiskt istället för att kräva manuella uppdateringar. Dessa avancerade metoder kräver mer teknisk kompetens men kan ge betydande förbättringar av AI-synligheten för organisationer med komplexa innehållsekosystem.

Landskapet för AI-crawlers fortsätter att förändras snabbt, med nya crawlers som regelbundet dyker upp och standarder som llms.txt får ökad användning. Att framtidssäkra din sitemapstrategi innebär att bygga in flexibilitet i dina system och hålla dig informerad om branschutvecklingen. Implementera sitemapgenereringssystem som enkelt kan anpassas till nya crawlerkrav utan att kräva manuell omkonfiguration. Bevakna meddelanden från stora AI-företag om nya crawlers och uppdatera dina robots.txt- och sitemapstrategier därefter. Överväg det långsiktiga värdet av AI-synlighet kontra kontroll över innehållet—medan vissa organisationer väljer att blockera AI-crawlers tyder trenden på att AI-citat kommer bli allt viktigare för varumärkessynlighet. Utveckla tydliga riktlinjer för hur din organisation ska hantera AI-crawleråtkomst och användning av innehåll. Genom att behandla din sitemap som ett levande dokument som utvecklas med AI-landskapet säkerställer du att ditt innehåll förblir upptäckbart och citerbart i takt med att sök- och upptäcktsmekanismer förändras.

Du bör uppdatera din sitemap varje gång du publicerar nytt innehåll eller gör betydande ändringar på befintliga sidor. Helst bör du implementera automatiserad sitemapgenerering så att uppdateringar sker omedelbart. För webbplatser med frekventa innehållsförändringar rekommenderas dagliga uppdateringar. För statiska webbplatser räcker det med månatliga granskningar.

De flesta större AI-crawlers som GPTBot och ClaudeBot respekterar robots.txt-direktiv, men inte alla gör det. Bästa praxis är att uttryckligen tillåta AI-crawlers i din robots.txt-fil istället för att lita på standardbeteende. Övervaka dina serverloggar för att verifiera att crawlers beter sig som förväntat.

XML-sitemaps är maskinläsbara filer som listar alla dina URL:er med metadata som lastmod-tidsstämplar. llms.txt är en nyare Markdown-baserad standard avsedd att ge AI-system ett mänskligt läsbart innehållsförteckning. XML-sitemaps är för närvarande viktigare för AI-synlighet, medan llms.txt bör ses som kompletterande.

Kontrollera dina serverloggar för user agents som 'GPTBot', 'ClaudeBot', 'PerplexityBot' och 'Google-Extended'. Du kan också använda verktyg som AmICited.com för att övervaka hur ofta ditt innehåll citeras av AI-system, vilket indikerar lyckad genomsökning och indexering.

Ja, att skapa separata sitemaps för bloggar, produkter, videor och bilder gör att du kan tillämpa typ-specifika optimeringsstrategier. Det hjälper också AI-crawlers att förstå din innehållsstruktur tydligare och kan förbättra crawl-effektiviteten för stora webbplatser.

XML-sitemaps bör inte innehålla mer än 50 000 URL:er per fil. För större webbplatser, använd sitemap-index för att organisera flera sitemapfiler. AI-crawlers kan hantera stora sitemaps, men att dela upp dem i logiska sektioner förbättrar crawl-effektiviteten och gör hanteringen enklare.

Lastmod-tidsstämplar signalerar innehållets aktualitet till AI-crawlers. Aktualitet är en stark rankingfaktor i AI-system, så korrekta tidsstämplar hjälper ditt innehåll att konkurrera om citat. Använd alltid automatiserade system för att uppdatera tidsstämplar endast när innehållet faktiskt ändras—sätt aldrig manuellt falska tidsstämplar.

Ja, en dåligt underhållen sitemap kan avsevärt skada din AI-synlighet. Trasiga länkar, föråldrade URL:er, felaktiga tidsstämplar och ofullständig täckning minskar alla dina chanser att bli citerad av AI-system. Regelbundna revisioner och underhåll är avgörande för att skydda din AI-synlighet.

Spåra hur ofta ditt innehåll citeras av ChatGPT, Claude, Perplexity och Google AI Overviews. Optimera din sitemapstrategi baserat på verklig AI-citatdata.

Fullständig referensguide till AI-crawlers och botar. Identifiera GPTBot, ClaudeBot, Google-Extended och 20+ andra AI-crawlers med user agents, crawl-hastighete...

Lär dig hur du tillåter AI-botar som GPTBot, PerplexityBot och ClaudeBot att crawla din webbplats. Konfigurera robots.txt, ställ in llms.txt och optimera för AI...

Förstå hur AI-crawlers som GPTBot och ClaudeBot fungerar, deras skillnader från traditionella sökmotor-crawlers och hur du optimerar din webbplats för synlighet...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.