Så säkerställer du att AI-crawlers ser allt ditt innehåll

Lär dig hur du gör ditt innehåll synligt för AI-crawlers som ChatGPT, Perplexity och Googles AI. Upptäck tekniska krav, bästa praxis och övervakningsstrategier ...

Upptäck hur SSR- och CSR-renderingsstrategier påverkar AI-crawlers synlighet, varumärkesomnämningar i ChatGPT och Perplexity, samt din övergripande AI-sök-närvaro.

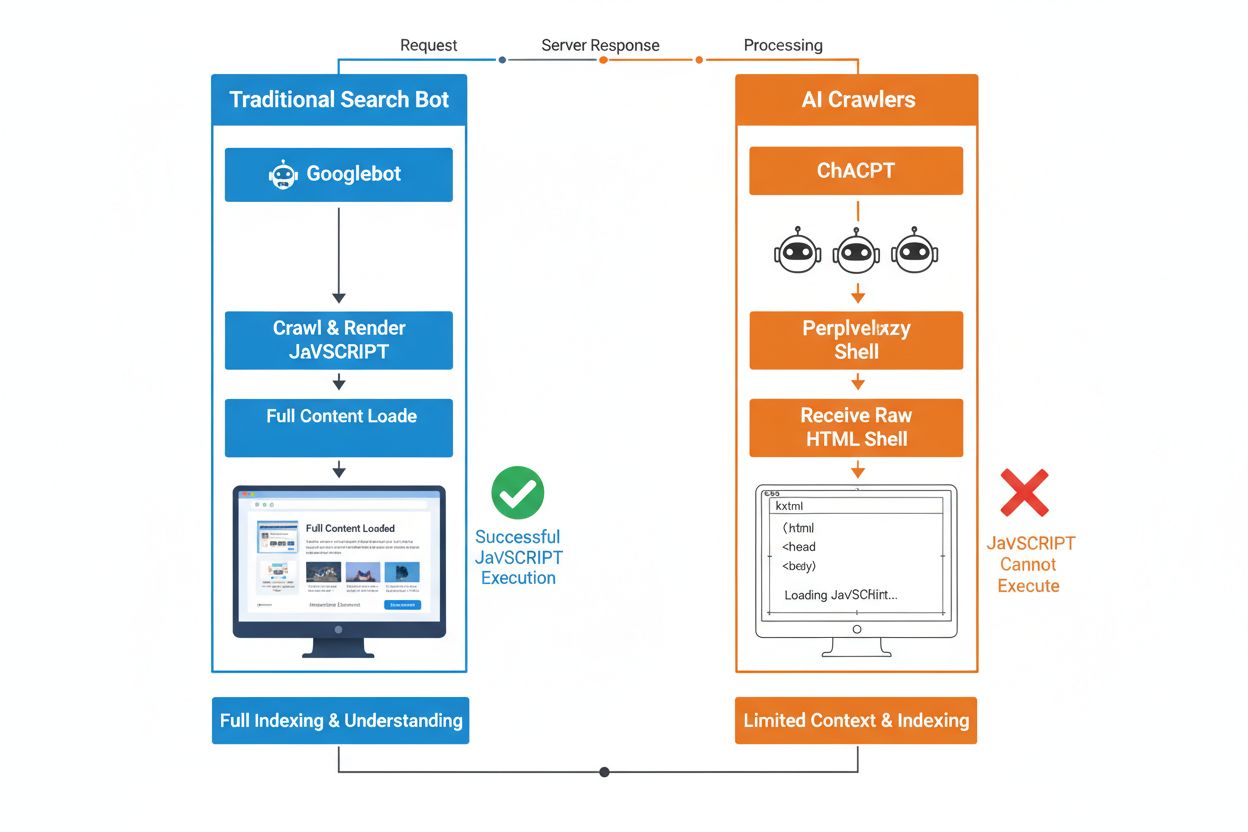

Den grundläggande skillnaden mellan traditionella sökrobotar och AI-crawlers ligger i deras förhållningssätt till JavaScript-exekvering. Medan Googlebot och andra traditionella sökmotorer kan rendera JavaScript (dock med resursbegränsningar), AI-crawlers som GPTBot, ChatGPT-User och OAI-SearchBot kör inte JavaScript alls—de ser bara den råa HTML som levereras vid den initiala sidladdningen. Denna avgörande skillnad innebär att om din webbplats innehåll är beroende av klientside-JavaScript för att renderas, kommer AI-system att få en ofullständig eller tom ögonblicksbild av dina sidor, där produktdetaljer, prisinformation, recensioner och annat dynamiskt innehåll som användare ser i sina webbläsare saknas. Att förstå denna lucka är avgörande eftersom AI-drivna sökresultat snabbt blir en primär upptäcktskanal för användare som söker information.

Server-Side Rendering (SSR) förbättrar AI-synlighet i grunden genom att leverera fullt renderad HTML direkt från servern vid den första förfrågan, vilket eliminerar behovet av att AI-crawlers kör JavaScript. Med SSR finns allt kritiskt innehåll—rubriker, brödtext, produktinformation, metadata och strukturerad data—i den HTML som bots får, vilket gör det omedelbart tillgängligt för införande i AI-träningskorpusar och sökindices. Detta tillvägagångssätt säkerställer konsekvent innehållsleverans till alla crawlers, snabbare indexeringshastigheter och fullständig metadata-synlighet som AI-system är beroende av för att förstå och korrekt citera ditt innehåll. Tabellen nedan illustrerar hur olika renderingsstrategier påverkar AI-crawlers synlighet:

| Renderingstyp | Vad AI-crawlers ser | Indexeringshastighet | Innehållskompletthet | Metadata-synlighet |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Fullt renderad HTML med allt innehåll | Snabb (omedelbar) | Komplett | Utmärkt |

| Client-Side Rendering (CSR) | Minimal HTML-skal, saknar dynamiskt innehåll | Långsam (om renderad alls) | Ofullständig | Dålig |

| Static Site Generation (SSG) | Förbyggd, cachad HTML | Mycket snabb | Komplett | Utmärkt |

| Hybrid/Inkrementell | Blandning av statiska och dynamiska rutter | Måttlig till snabb | Bra (om kritiska sidor för-renderas) | Bra |

Client-Side Rendering (CSR) innebär betydande utmaningar för AI-synlighet eftersom det tvingar crawlers att vänta på JavaScript-exekvering—något AI-bots helt enkelt inte gör på grund av resursbegränsningar och snäva timeout-gränser. När en CSR-baserad webbplats laddas innehåller det initiala HTML-svaret bara ett minimalt skal med laddningssnurror och platshållare, medan det faktiska innehållet laddas asynkront via JavaScript. AI-crawlers har strikta timeout-gränser på 1–5 sekunder och kör inte skript, vilket innebär att de fångar en tom eller nästan tom ögonblicksbild av sidan som saknar produktbeskrivningar, priser, recensioner och annan viktig information. Detta skapar ett kedjeproblem: ofullständiga innehållssnapshots leder till sämre chunking och embedding-kvalitet, vilket minskar sannolikheten att dina sidor väljs ut för AI-genererade svar. För e-handelssajter, SaaS-plattformar och innehållsrika applikationer som förlitar sig på CSR innebär detta direkt förlorad synlighet i AI Overviews, ChatGPT-svar och Perplexity-svar—de kanaler som driver upptäckt i AI-eran.

Den tekniska orsaken till att AI-bots inte kan köra JavaScript härrör från grundläggande skalbarhets- och resursbegränsningar i deras arkitektur. AI-crawlers prioriterar hastighet och effektivitet framför fullständighet, och arbetar under strikta timeout-gränser eftersom de måste bearbeta miljarder sidor för att träna och uppdatera språkmodeller. Att köra JavaScript kräver att man startar headless-browsers, allokerar minne och väntar på att asynkrona operationer ska slutföras—lyx som inte skalar vid den crawler-volym som krävs för LLM-träning. Istället fokuserar AI-system på att extrahera ren, semantiskt strukturerad HTML som är omedelbart tillgänglig, och betraktar statiskt innehåll som den kanoniska versionen av din sajt. Detta designval speglar en grundläggande sanning: AI-system är optimerade för statisk HTML-leverans, inte för att rendera komplexa JavaScript-ramverk som React, Vue eller Angular.

Effekten på AI-genererade svar och varumärkessynlighet är djupgående och påverkar dina affärsresultat direkt. När AI-crawlers inte kan komma åt ditt innehåll på grund av JavaScript-rendering blir ditt varumärke osynligt i AI Overviews, saknas i citat och är frånvarande i LLM-drivna sökresultat—även om du rankar högt i traditionell Google-sök. För e-handelssajter innebär detta att produktdetaljer, priser och tillgänglighetsinformation aldrig når AI-systemen, vilket leder till ofullständiga eller felaktiga produktrekommendationer och förlorade försäljningsmöjligheter. SaaS-företag förlorar synlighet för funktionsjämförelser och prissidor som annars skulle driva kvalificerade leads via AI-drivna research-verktyg. Nyhets- och innehållssajter ser sina artiklar exkluderas från AI-sammanfattningar, vilket minskar hänvisningstrafik från plattformar som ChatGPT och Perplexity. Klyftan mellan vad människor ser och vad AI-system ser skapar ett tvådelat synlighetsproblem: din sajt kan verka sund i traditionella SEO-mått men samtidigt vara osynlig för den snabbast växande upptäcktskanalen.

För-rendering och hybridlösningar erbjuder praktiska sätt att kombinera fördelarna med båda renderingsmetoderna utan att kräva en total arkitekturomläggning. Istället för att välja mellan CSR:s interaktivitet och SSR:s crawlbarhet använder moderna team strategiska kombinationer för olika syften:

Dessa metoder låter dig behålla rika, interaktiva användarupplevelser samtidigt som AI-crawlers får komplett, fullt renderad HTML. Ramverk som Next.js, Nuxt och SvelteKit gör hybridrendering tillgänglig utan omfattande egenutveckling. Nyckeln är att identifiera vilka sidor som driver förvärv, intäkter eller supportavlastning—dessa kritiska sidor ska alltid för-renderas eller server-renderas för att garantera AI-synlighet.

Renderingsstrategi påverkar direkt hur AI-system refererar och citerar ditt varumärke, vilket gör det avgörande att övervaka din synlighet över AI-plattformar. Verktyg som AmICited.com spårar hur AI-system citerar ditt varumärke i ChatGPT, Perplexity, Google AI Overviews och andra LLM-drivna plattformar, och visar om ditt innehåll faktiskt når dessa system. När din sajt använder CSR utan för-rendering visar AmICited-data ofta en tydlig skillnad: du kan ranka högt i traditionell sök men få noll citat i AI-genererade svar. Denna övervakning avslöjar den verkliga kostnaden av JavaScript-renderingsval—inte bara i crawl-effektivitet, utan även i förlorad varumärkessynlighet och citeringsmöjligheter. Genom att implementera SSR eller för-rendering och sedan spåra resultat via AmICited kan du kvantifiera den direkta effekten av renderingsbeslut på AI-synlighet, vilket gör det lättare att motivera ingenjörsinvesteringar inför intressenter som fokuserar på trafik och konverteringar.

Att granska och optimera din renderingsstrategi för AI-synlighet kräver ett systematiskt, steg-för-steg tillvägagångssätt. Börja med att identifiera vilka sidor som genererar störst värde: produktsidor, prissidor, kärndokumentation och högtrafikerade blogginlägg bör prioriteras. Använd verktyg som Screaming Frog (i “Text Only”-läge) eller Chrome DevTools för att jämföra vad bots ser jämfört med vad användare ser—om kritiskt innehåll saknas i sidans källa är det JavaScript-beroende och osynligt för AI-crawlers. Välj sedan renderingsstrategi baserat på innehållets färskhetskrav: statiska sidor kan använda SSG, ofta uppdaterat innehåll tjänar på SSR eller ISR, och interaktiva funktioner kan läggas ovanpå server-renderad HTML med JavaScript. Därefter testa med faktiska AI-bots genom att lägga in dina sidor i ChatGPT, Perplexity och Claude för att verifiera att de kan nå ditt innehåll. Slutligen övervaka crawl-loggar för AI user-agents (GPTBot, ChatGPT-User, OAI-SearchBot) för att bekräfta att dessa bots framgångsrikt crawlar dina för-renderade eller server-renderade sidor. Detta iterativa tillvägagångssätt förvandlar rendering från en teknisk detalj till en mätbar synlighetsfaktor.

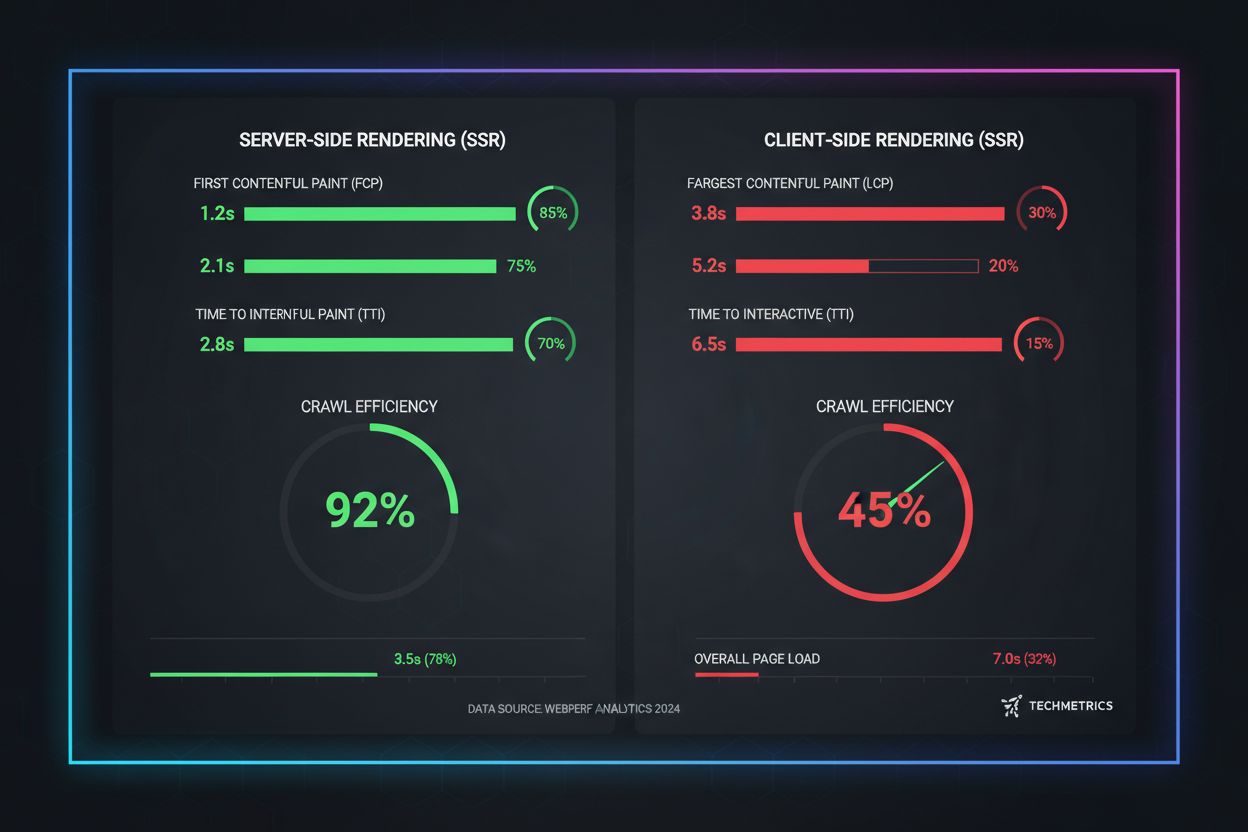

Prestandamått från verkligheten visar de dramatiska skillnaderna mellan renderingsmetoder när det gäller crawlbarhet för AI. SSR och för-renderade sidor uppnår First Contentful Paint (FCP) på 0,5–1,5 sekunder, medan CSR-sajter ofta kräver 2–4 sekunder eller mer när JavaScript laddas ned och körs. För AI-crawlers som arbetar med timeout-gränser på 1–5 sekunder är denna skillnad skillnaden mellan full synlighet och total osynlighet. Crawleffektiviteten förbättras dramatiskt med SSR: en för-renderad e-handelssajt kan crawlas och indexeras helt på några timmar, medan en CSR-motsvarighet kan ta veckor när crawlers kämpar med JavaScript-renderingskostnaden. Indexeringshastigheten förbättras också markant—SSR-sajter får nytt innehåll indexerat inom 24–48 timmar, medan CSR-sajter ofta får 7–14 dagars fördröjning. För tidkänsligt innehåll som nyhetsartiklar, produktlanseringar eller kampanjer innebär denna fördröjning direkt förlorad synlighet under det kritiska fönstret när användare aktivt söker.

Framtiden för SEO är oskiljaktig från AI-söksynlighet, vilket gör renderingsstrategi till en kritisk långsiktig investering snarare än en teknisk eftertanke. AI-drivna sökningar växer exponentiellt—13,14% av alla Google-sökresultat triggar nu AI Overviews, och plattformar som ChatGPT får över fyra miljarder besök varje månad, medan Perplexity och Claude snabbt ökar i användning. När AI-system blir den primära upptäcktskanalen för fler användare kommer de renderingsbeslut du fattar idag att avgöra din synlighet imorgon. Kontinuerlig övervakning är avgörande eftersom AI-crawlers beteende, timeout-gränser och JavaScript-stöd utvecklas i takt med att dessa system mognar. Team som ser rendering som en engångsmigrering upptäcker ofta att de är osynliga igen inom månader när AI-plattformarna ändrar sina crawlstrategier. Bygg istället renderingsoptimering i din kvartalsplanering, inkludera AI-synlighetskontroller i regressionstester och använd verktyg som AmICited för att spåra om ditt varumärke behåller synlighet när AI-landskapet förändras. De varumärken som vinner inom AI-sök är de som ser renderingsstrategi som en kärnkonkurrensfördel, inte en teknisk skuld att ta itu med senare.

AI-crawlers som GPTBot och ChatGPT-User arbetar under strikta resursbegränsningar och snäva timeout-gränser (1–5 sekunder) eftersom de måste bearbeta miljarder sidor för att träna språkmodeller. Att köra JavaScript kräver att man startar headless-browsers och väntar på asynkrona operationer—lyx som inte är skalbar i den volym som krävs för LLM-träning. Istället fokuserar AI-system på att extrahera ren, statisk HTML som är omedelbart tillgänglig.

Server-Side Rendering levererar fullt renderad HTML vid den initiala förfrågan, vilket gör allt innehåll omedelbart tillgängligt för AI-crawlers utan JavaScript-exekvering. Detta säkerställer att dina produktdetaljer, priser, recensioner och metadata når AI-system pålitligt, vilket ökar chanserna att ditt varumärke citeras i AI-genererade svar och visas i AI Overviews.

Server-Side Rendering (SSR) renderar sidor vid förfrågan när en begäran kommer in, medan för-rendering (pre-rendering) genererar statiska HTML-filer vid byggtillfället. För-rendering fungerar bäst för innehåll som inte ändras ofta, medan SSR är bättre för dynamiskt innehåll som uppdateras regelbundet. Båda tillvägagångssätten säkerställer att AI-crawlers får komplett HTML utan JavaScript-exekvering.

Ja, men med betydande begränsningar. Du kan använda för-rendering-verktyg för att generera statiska HTML-snapshots av dina CSR-sidor, eller implementera hybridrendering där kritiska sidor server-renderas medan mindre viktiga sidor förblir klient-renderade. Utan dessa optimeringar är dock CSR-sajter i stort sett osynliga för AI-crawlers.

Använd verktyg som Screaming Frog (Text Only-läge), Chrome DevTools eller Google Search Console för att jämföra vad bots ser jämfört med vad användare ser. Om kritiskt innehåll saknas i sidans källkod är det JavaScript-beroende och osynligt för AI-crawlers. Du kan också testa direkt med ChatGPT, Perplexity och Claude för att verifiera att de har tillgång till ditt innehåll.

SSR- och för-renderade sidor uppnår vanligtvis First Contentful Paint (FCP) på 0,5–1,5 sekunder, medan CSR-sajter ofta kräver 2–4+ sekunder. Eftersom AI-crawlers arbetar med 1–5 sekunders timeout, innebär snabbare rendering direkt bättre crawlbarhet för AI. Förbättrade Core Web Vitals gynnar också användarupplevelsen och traditionell SEO-ranking.

AmICited övervakar hur AI-system citerar ditt varumärke över ChatGPT, Perplexity och Google AI Overviews. Genom att spåra din AI-synlighet före och efter implementering av SSR eller för-rendering kan du kvantifiera den direkta påverkan renderingsbeslut har på varumärkesomnämningar och AI-söknärvaro.

Det beror på dina krav på innehållets aktualitet och affärsprioriteringar. Statiskt innehåll gynnas av SSG, ofta uppdaterat innehåll av SSR, och interaktiva funktioner kan lägga JavaScript ovanpå server-renderad HTML. Börja med att identifiera värdefulla sidor (produktsidor, prissättning, dokumentation) och prioritera dessa för SSR eller för-rendering först.

Övervaka hur ChatGPT, Perplexity och Google AI Overviews refererar till ditt varumärke. Förstå den verkliga effekten av din renderingsstrategi på AI-omnämningar.

Lär dig hur du gör ditt innehåll synligt för AI-crawlers som ChatGPT, Perplexity och Googles AI. Upptäck tekniska krav, bästa praxis och övervakningsstrategier ...

Lär dig hur JavaScript-rendering påverkar din webbplats synlighet i AI-sökmotorer som ChatGPT, Perplexity och Claude. Upptäck varför AI-crawlers har svårt med J...

Lär dig hur JavaScript-rendering påverkar AI-synlighet. Upptäck varför AI-crawlers inte kan köra JavaScript, vilket innehåll som döljs och hur för-rendering säk...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.