Transparens i AI-rankning

Lär dig vad transparens i AI-rankning innebär, varför det är viktigt för innehållsskapare och användare, samt hur olika AI-plattformar som Perplexity, Google oc...

Lär dig väsentlig AI-transparens och de bästa praxis för öppenhet. Upptäck beteendemässiga, verbala och tekniska metoder för öppenhet för att bygga förtroende och säkerställa regelefterlevnad med utvecklande AI-regleringar.

AI-transparens har blivit ett kritiskt krav i en tid där artificiell intelligens påverkar allt från innehållsskapande till rekryteringsbeslut och finansiella rekommendationer. När AI-genererat innehåll blir allt vanligare på digitala plattformar, står organisationer inför ökade krav att redovisa när och hur de använder dessa teknologier, inte bara som en juridisk skyldighet utan som en grundläggande förutsättning för att upprätthålla förtroende och trovärdighet hos sin publik. Insatserna är särskilt höga för varumärken och innehållsskapare, då konsumenter i allt högre grad kräver att få veta om informationen de tar del av kommer från mänsklig expertis eller algoritmisk generering. Utan transparenta redovisningsrutiner riskerar organisationer att urholka det förtroende som tagit år att bygga upp, med potentiella konsekvenser som skadat rykte, regulatoriska påföljder och förlorat publikförtroende. Sambandet mellan transparens och trovärdighet är symbiotiskt—organisationer som proaktivt redovisar sin AI-användning visar integritet och respekt för sina intressenter, och positionerar sig som ärliga aktörer i ett allt mer AI-drivet landskap.

Spridningen av AI-genererat innehåll har skapat en djup förtroendeparadox: publiken har svårt att skilja mellan autentiskt, människoskapat material och avancerade AI-genererade alternativ, samtidigt som transparens kring AI-användning varierar mellan olika branscher. Denna förvirring undergräver det grundläggande kontraktet mellan skapare och konsument, där publiken förväntar sig att få veta det verkliga ursprunget till det innehåll de möter. När AI-genererat innehåll presenteras utan öppenhet bryter det mot denna underförstådda överenskommelse och skapar en dikotomi mellan “äkta vs. falskt” som går bortom enkel autenticitet—det handlar även om frågor rörande vilseledning, manipulation och informerat samtycke. Paradoxen fördjupas eftersom vissa AI-genererade innehåll kan vara omöjliga att skilja från mänskligt arbete vad gäller kvalitet och stil, vilket gör visuella eller stilistiska ledtrådar till opålitliga indikatorer på ursprung. Transparens är viktig just för att den löser denna paradox genom att ge publiken den information de behöver för att fatta informerade beslut om vilket innehåll de konsumerar och litar på. Organisationer som omfamnar tydliga redovisningsrutiner omvandlar potentiell skepsis till förtroende och visar att de inte har något att dölja och allt att vinna på ärlig kommunikation.

Det regulatoriska landskapet kring AI-öppenhet utvecklas snabbt, och flera jurisdiktioner inför eller föreslår krav som organisationer måste navigera noggrant. EU:s AI-förordning, en av de mest omfattande ramverken, kräver att AI-genererat eller kraftigt AI-redigerat innehåll måste innehålla synlig eller metadata-baserad öppenhet, med särskilda krav för högrisk-AI-system och transparensplikt för utvecklare. I USA har FTC utfärdat varningar om att underlåtenhet att uppdatera användarvillkor och integritetspolicyer för AI-användning kan utgöra vilseledande praxis, medan delstatsregler—särskilt Kaliforniens nya AI frontier model disclosure law—inför ökade krav på öppenhet och rapportering för utvecklare av stora AI-system. Upphovsrätt och immateriella rättigheter tillför ytterligare ett lager komplexitet, då organisationer måste redovisa om träningsdata innehöll upphovsrättsskyddat material och hur AI-system tränades. Dessutom gäller GDPR och CCPA även AI-system som behandlar personuppgifter, vilket kräver att organisationer redovisar automatiserat beslutsfattande och tillhandahåller individer meningsfull information om AI-bearbetning. Tabellen nedan sammanfattar centrala regleringskrav i större jurisdiktioner:

| Jurisdiktion | Reglering | Nyckelkrav | Ikraftträdande |

|---|---|---|---|

| Europeiska unionen | EU AI-förordning | Öppenhet för högrisk-AI; transparensrapporter; metadata-märkning för AI-genererat innehåll | Successivt (2024-2026) |

| USA (federalt) | FTC-riktlinjer | Uppdatera integritetspolicy; redovisa AI-användning; undvik vilseledande praxis | Löpande |

| Kalifornien | AI Frontier Model Law | Standardiserad öppenhet; rapporteringsskyldigheter; säkerhetsåtgärder | 2025 |

| Europeiska unionen | GDPR | Redovisa automatiserat beslutsfattande; lämna information om AI-bearbetning | Löpande |

| USA (flertal delstater) | CCPA & liknande | Redovisa dataanvändning i AI-system; erbjuda opt-out-möjligheter | Varierar per delstat |

| Internationellt | Upphovsrättsaspekter | Redovisa källor för träningsdata; adressera upphovsrätt i AI-resultat | Under utveckling |

Organisationer som verkar över flera jurisdiktioner bör implementera öppenhetspraxis som uppfyller de mest strikta kraven, då efterlevnad av en standard ofta innebär att minimikraven för andra också uppfylls.

Beteendesignaler är den mest subtila men ändå kraftfulla formen av AI-öppenhet, och verkar genom presentation, stil, röst och kreativa val som publiken omedvetet bearbetar när de bedömer innehållets autenticitet. Dessa signaler inkluderar karakteristiska mönster i skrivstil, röstens konsekvens, visuella kompositionsval, avatar- eller personadrag och den övergripande “trovärdigheten” hos skaparen—det vill säga i vilken grad innehållet återspeglar genuin mänsklig personlighet och beslut. Exempelvis uppvisar AI-genererad text ofta särskilda mönster vad gäller meningsbyggnad, ordförråd och logisk struktur som skiljer sig från mänsklig skrift, medan AI-genererade bilder kan visa subtila inkonsekvenser i ljussättning, anatomi eller bakgrund som tränade observatörer kan upptäcka. Begreppet skapartrovärdighet är centralt här: publiken utvecklar förväntningar på hur en viss skapare ska låta, se ut och presentera sig, och avvikelser från detta mönster kan signalera AI-inblandning. Att enbart förlita sig på beteendesignaler är dock problematiskt eftersom AI-system snabbt blir bättre på att efterlikna mänskliga egenskaper, och publiken kan inte förväntas bli AI-forensiska experter. Därför bör beteendesignaler komplettera snarare än ersätta explicita öppenhetsmetoder, och fungera som ett sekundärt lager av transparens som förstärker snarare än ersätter tydlig, direkt kommunikation om AI-användning.

Verbala öppenhetsstrategier innebär explicita, direkta meddelanden om AI-användning via språkliga signaler som inte lämnar några tvivel om innehållets ursprung och AI-inblandning. Dessa metoder är viktiga eftersom de skapar ett tydligt, dokumenterat register över öppenheten och säkerställer att publiken får entydig information om AI-användning. Organisationer kan genomföra verbal öppenhet via flera kompletterande metoder:

Vilken metod som är lämpligast beror på sammanhanget: etiketter fungerar väl för sociala medier och visuellt innehåll, vattenstämplar passar video och ljud, bylines för journalistiskt och kreativt arbete, informationsfält för längre innehåll och tacktext för komplexa projekt. Organisationer bör välja öppenhetsmetoder som passar deras innehållsformat och publikens förväntningar och säkerställa att öppenheten är omöjlig att missa men ändå icke-intrusiv för användarupplevelsen.

Tekniska signaler och metadata tillhandahåller maskinläsbar, standardiserad information om AI-inblandning som möjliggör automatiserad upptäckt, verifiering och spårning av AI-genererat innehåll över digitala ekosystem. Dessa metoder använder inbäddad data och kryptografiska tekniker för att skapa permanenta, manipulationssäkra register över innehållets ursprung och bearbetningshistorik. IPTC-standarderna, nyligen uppdaterade med AI-specifika metadataparametrar, gör det möjligt för skapare att bädda in strukturerad information om AI-användning direkt i bildfiler, inklusive detaljer om vilka AI-system som användes, vilken bearbetning som tillämpades och vilka mänskliga ändringar som gjorts. C2PA (Coalition for Content Provenance and Authenticity) är en framväxande industristandard som använder kryptografiska signaturer och innehållsreferenser för att etablera verifierbara kedjor av innehållets ursprung, vilket gör det möjligt för publiken att spåra innehåll tillbaka till dess ursprung och förstå alla tillämpade ändringar. Dessa tekniska tillvägagångssätt löser en viktig begränsning med människoläsbar öppenhet: de skapar permanenta, verifierbara register som inte enkelt kan tas bort eller manipuleras, och de gör det möjligt för automatiserade system att identifiera och flagga AI-genererat innehåll i stor skala. Organisationer som implementerar teknisk öppenhet bör överväga att använda C2PA-referenser för innehåll med högt värde, bädda in IPTC-metadata i bilder och mediefiler, samt upprätthålla detaljerad digital källa-typ dokumentation som spårar AI-inblandning genom hela innehållslivscykeln. Fördelen med tekniska signaler är deras beständighet och verifierbarhet; utmaningen är att säkerställa att publik och plattformar förstår och respekterar dessa signaler.

Framgångsrik AI-öppenhet kräver att transparenspraxis institutionaliseras genom hela processen för innehållsskapande, så att öppenhet blir en grundläggande komponent i innehållsstyrningen snarare än en efterhandskonstruktion. Organisationer bör införa strukturerade innehållsramverk som fångar AI-inblandning i varje steg av skapandet—från inledande research och utkast till redigering och publicering—så att öppenhetsinformation flödar naturligt genom befintliga innehållshanteringssystem. Automatisering och arbetsflödesintegration är avgörande: innehållshanteringssystem bör innehålla obligatoriska fält för AI-öppenhet, automatiska påminnelser som kräver att skapare dokumenterar AI-användning före publicering, och godkännandeflöden som verifierar att öppenheten är komplett innan innehållet går live. Detta synsätt behandlar öppenhet som ett krav på kvalitetssäkring snarare än som ett frivilligt tillägg, på samma sätt som faktagranskning, juridisk granskning eller varumärkesefterlevnad hanteras. Organisationer bör också fastställa tydliga policys för vad som utgör AI-användning som kräver öppenhet (t.ex. kräver användning av AI för research öppenhet? Vad gäller AI-assisterad redigering?), för att säkerställa konsekvens mellan team och undvika luckor i redovisningen. Utbildning och dokumentation är lika viktiga: innehållsskapare behöver tydliga instruktioner för hur AI-användning ska redovisas för olika innehållstyper och plattformar. Genom att integrera öppenhet i innehållsmodeller och arbetsflöden förvandlar organisationer transparens från en börda för regelefterlevnad till ett standardförfarande som skyddar både organisationen och dess publik.

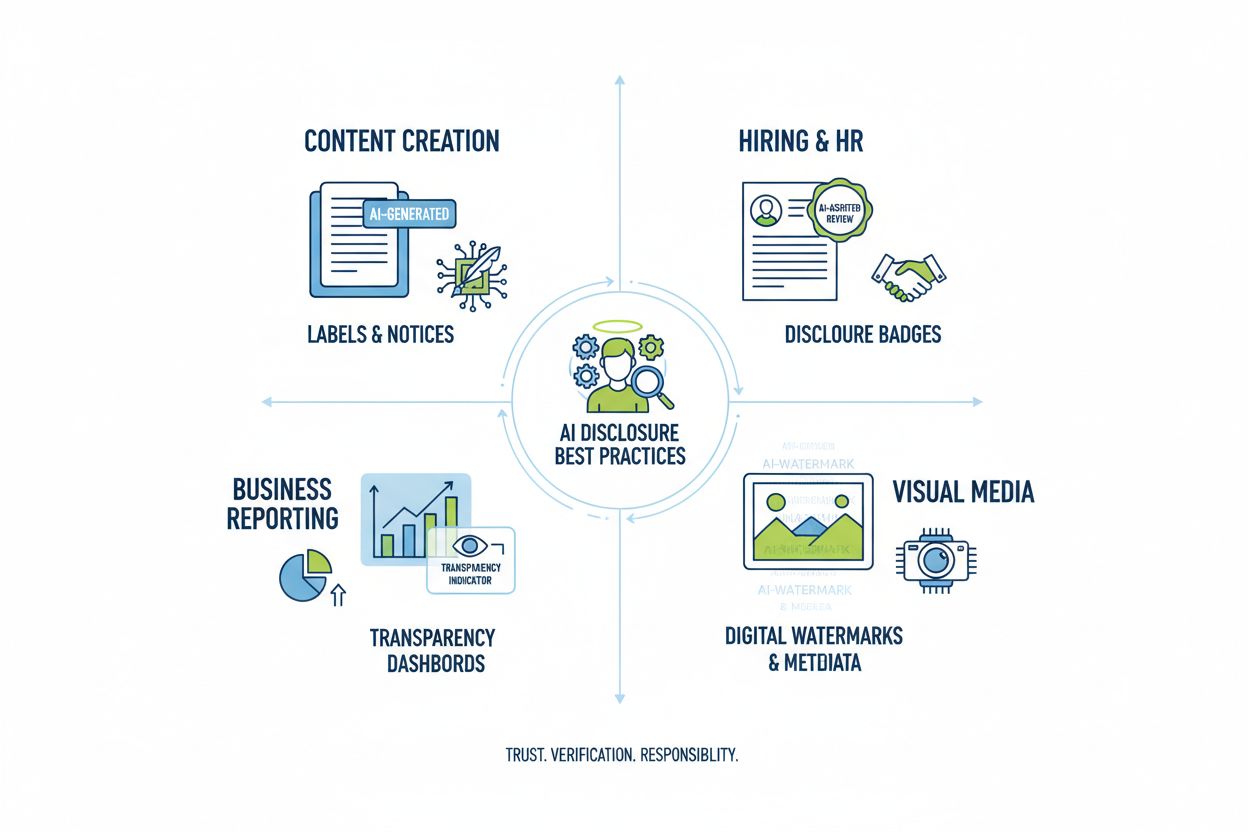

Olika tillämpningar av AI kräver anpassade öppenhetsstrategier som tar hänsyn till kontext, publikens förväntningar och regulatoriska krav. Innehållsskapande (artiklar, sociala medier, marknadsföringstexter) bör innehålla tydliga etiketter eller byline-ändringar som anger AI-inblandning, med kompletterande informationsfält som förklarar vilka AI-verktyg som användes och vilken mänsklig kontroll som tillämpades; detta är särskilt viktigt för nyhets- och redaktionellt innehåll där publikens förtroende vilar på förståelsen för innehållets ursprung. Rekrytering kräver den mest rigorösa öppenheten, då kandidater har rätt att veta när AI-system utvärderar deras ansökningar eller genomför första urvalet, och få detaljerade förklaringar om hur AI-beslut fattas och vilka mänskliga granskningsprocesser som följer. Rapportering och analys (finansiella rapporter, marknadsundersökningar, dataanalys) bör inkludera teknisk öppenhet och metadata som anger vilka analyser som var AI-assisterade, särskilt när AI-system identifierade mönster eller genererade insikter som påverkat slutsatser. Visuellt innehåll (bilder, video, grafik) kräver både visuella vattenstämplar och metadata, eftersom publiken inte kan lita på att själv avgöra vad som är AI-genererat; detta är särskilt kritiskt för nyhetsfotografi, produktbilder och innehåll där autenticitet påverkar köp- eller förtroendebeslut. Kundkommunikation (chattbottar, automatiska svar, kundtjänst) bör tydligt identifiera AI-inblandning i början av interaktionen, så att kunden kan välja mänsklig hjälp om så önskas. Organisationer bör granska sin AI-användning i dessa sammanhang och införa öppenhetsrutiner som är proportionerliga till känsligheten och påverkan hos varje användningsfall, med insikten att transparenskrav varierar beroende på hur AI-beslut påverkar publiken.

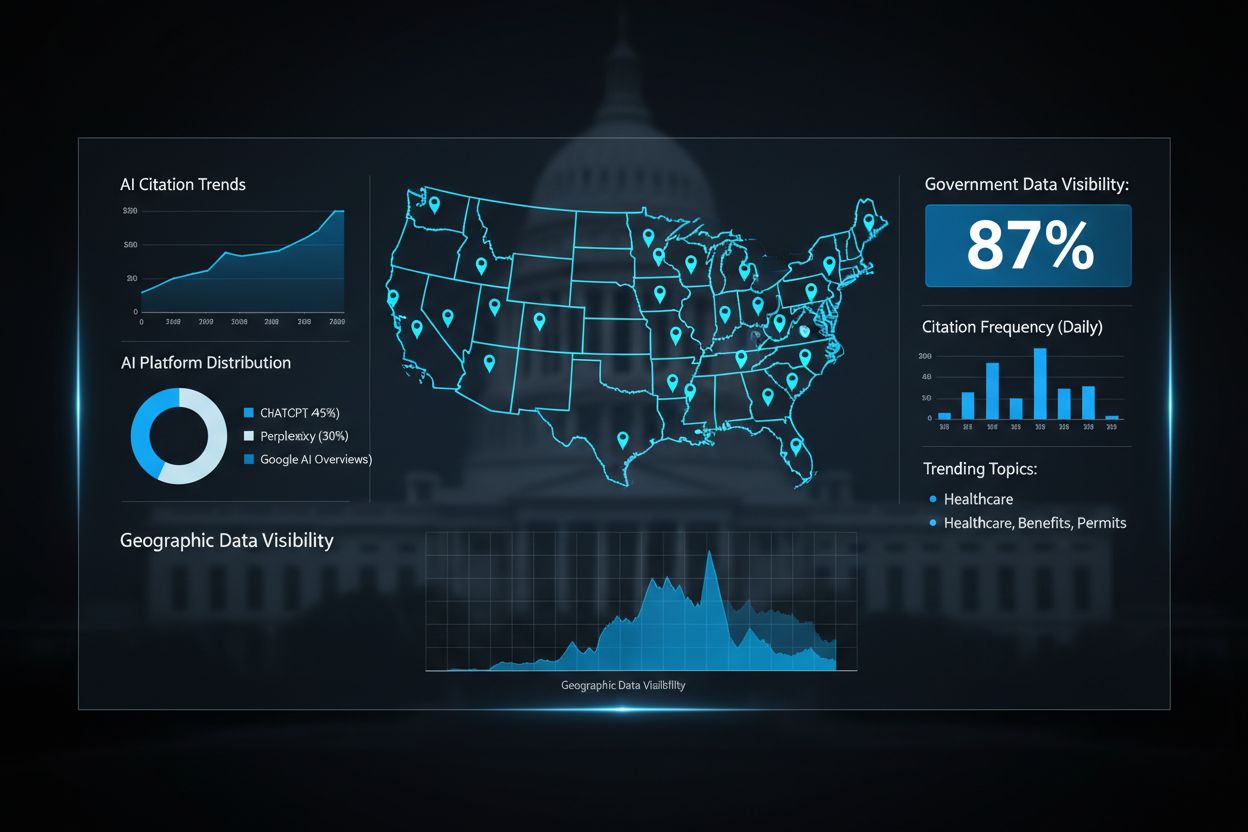

Framtiden för AI-öppenhet beror på branschövergripande standardisering och utvecklingen av interoperabla ramverk som möjliggör konsekvent, jämförbar transparens mellan organisationer och plattformar. Framväxande standarder som C2PA, IPTC-metadata och NIST:s AI Risk Management Framework ger grundläggande strukturer, men bred adoption kräver samordnade insatser från teknikplattformar, innehållsskapare, tillsynsmyndigheter och branschorganisationer. EU:s AI-förordning och liknande regelverk driver på standardisering genom att kräva specifika format och informationskategorier för öppenhet, vilket skapar ett tryck mot gemensamma lösningar snarare än individuella tillvägagångssätt. Branschinitiativ som PRSA:s etiska AI-riktlinjer och olika ramverk för transparensrapportering visar på en ökande samsyn kring bästa praxis, även om frivilligt införande fortfarande är ojämnt. Nästa viktiga steg är att gå från frivilliga standarder till bindande regler som kräver standardiserad öppenhet, likt hur FDA:s näringsdeklarationer standardiserade mattransparens. Övervaknings- och synlighetsplattformar—som AmICited.com—får en allt viktigare roll i ekosystemet genom att spåra hur AI refererar till varumärken och innehåll i AI-genererade svar, vilket ger organisationer insyn i hur deras arbete återges i AI-resultat och om korrekt tillskrivning och öppenhet sker. I takt med att AI-systemen blir mer sofistikerade och allestädes närvarande blir möjligheten att övervaka, verifiera och granska AI-öppenhetsrutiner avgörande för att upprätthålla förtroende i digitala informationsmiljöer. Organisationer som investerar i robusta öppenhetsrutiner och övervakningsmöjligheter idag kommer att ha bäst förutsättningar att navigera det föränderliga regulatoriska landskapet och upprätthålla publikens förtroende i en AI-drivna framtid.

Beteendemässig öppenhet använder presentationsval (stil, röst, avatar) för att signalera AI-inblandning. Verbal öppenhet använder explicita uttalanden, etiketter och vattenstämplar. Teknisk öppenhet bäddar in maskinläsbar metadata och kryptografiska signaturer. Varje metod tjänar olika målgrupper och sammanhang, och organisationer bör använda flera metoder tillsammans för heltäckande transparens.

Juridiska krav varierar beroende på jurisdiktion. EU:s AI-förordning kräver öppenhet för högrisk-AI-system. FTC kräver öppenhet när AI-användning kan påverka konsumentbeslut. Delstatliga lagar som Kaliforniens AI Frontier Model Law inför rapporteringsskyldigheter. Upphovsrättslagen kräver öppenhet om AI-genererat innehåll. Organisationer bör rådgöra med juridisk expertis för jurisdiktionsspecifika krav.

AI-genererade bilder bör inkludera både visuella vattenstämplar och metadata-öppenhet. Visuella vattenstämplar ska vara synliga men diskreta, tydligt ange AI-generering. Metadata bör innehålla IPTC digital källa-typ information och C2PA-uppgifter när det är tillgängligt. Bildtexter och informationsfält ska uttryckligen ange att bilderna är AI-genererade, särskilt för nyheter, produkter eller marknadsföringsinnehåll.

IPTC-standarder tillhandahåller strukturerade metadatafält för att dokumentera AI-användning i bilder och mediefiler. De möjliggör automatiserad upptäckt och spårning av AI-genererat innehåll över plattformar. IPTC digital källa-typ kategorier inkluderar "Trained Algorithmic Media", "Composite Synthetic" och "Algorithmic Media". Dessa standarder är viktiga eftersom de skapar permanenta, verifierbara register över AI-inblandning som inte enkelt kan tas bort eller ändras.

Företag bör genomföra en AI-granskning för att identifiera alla AI-användningsområden, införa öppenhetspolicys i linje med gällande regler, integrera öppenhet i innehållshanteringsflöden, utbilda team om krav på öppenhet och regelbundet övervaka efterlevnad. Rådgivning med juridiska experter som är bekanta med AI-regler i din jurisdiktion är avgörande, eftersom kraven varierar mycket mellan regioner.

Konsekvenser inkluderar regulatoriska påföljder (FTC-böter, brott mot delstatslagar), skadat rykte och förlorat förtroende hos publiken, juridiskt ansvar för upphovsrättsintrång eller vilseledande praxis, samt potentiella stämningar från drabbade parter. Organisationer som inte redovisar AI-användning riskerar att urholka det förtroende som tagit år att bygga upp, vilket gör proaktiv öppenhet till en strategisk investering för långsiktigt förtroende.

Olika intressenter behöver olika informationsnivåer. Allmänheten behöver enkla, tydliga uttalanden om AI-inblandning. Reglerande myndigheter behöver detaljerad teknisk dokumentation och bevis på efterlevnad. Journalister och innehållsskapare behöver specifik information om AI-verktyg och mänsklig kontroll. Kunder behöver förstå hur AI påverkar deras upplevelse. Anpassa format och detaljeringsgrad till varje målgrupps behov och förväntningar.

C2PA (Coalition for Content Provenance and Authenticity) tillhandahåller kryptografiska referenser för verifiering av innehåll. IPTC-standarder möjliggör inbäddning av metadata i bilder. Innehållshanteringssystem inkluderar allt oftare fält för AI-öppenhet. Övervakningsplattformar som AmICited.com spårar AI-referenser och synlighet. Branschramverk från PRSA, NIST och andra ger vägledning. Antagandet av dessa verktyg och standarder accelererar i takt med att reglerna skärps.

Spåra hur AI-system refererar till ditt varumärke över GPT:er, Perplexity och Google AI Översikter. Säkerställ att ditt innehåll får korrekt tillskrivning och synlighet i AI-genererade svar.

Lär dig vad transparens i AI-rankning innebär, varför det är viktigt för innehållsskapare och användare, samt hur olika AI-plattformar som Perplexity, Google oc...

Utforska framtiden för AI-synlighetsövervakning, från transparensstandarder till regelefterlevnad. Lär dig hur varumärken kan förbereda sig för det AI-drivna in...

Lär dig hur myndigheter kan optimera sin digitala närvaro för AI-system som ChatGPT och Perplexity. Upptäck strategier för att förbättra AI-synlighet, säkerstäl...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.