Plattformsavveckling och AI-synlighet: Hantera övergångar

Lär dig att hantera AI-plattformsövergångar och bibehålla citeringssynlighet när plattformar avvecklas. Strategisk guide för att hantera utfasade AI-plattformar...

Lär dig hur du anpassar din AI-strategi när plattformar förändras. Upptäck migrationsstrategier, övervakningsverktyg och bästa praxis för att hantera utfasning och uppdateringar av AI-plattformar.

Pensioneringen av OpenAI:s GPT-4o API år 2026 markerar en vändpunkt för företag som bygger på AI-plattformar – det är inte längre en teoretisk oro utan en omedelbar realitet som kräver strategisk uppmärksamhet. Till skillnad från traditionella mjukvaruutfasningar som ofta erbjuder långa supportperioder kan plattformsförändringar inom AI ske med relativt kort varsel, vilket tvingar organisationer att snabbt fatta beslut om sin tekniska plattform. Plattformar pensionerar modeller av flera viktiga skäl: säkerhetsrisker med äldre system som kanske inte uppfyller dagens standard, ansvarsfrågor kring potentiellt missbruk eller skadliga resultat, förändrade affärsmodeller som prioriterar nyare lösningar, och behovet av att samla resurser kring den senaste forskningen. När ett företag har integrerat en viss modell djupt i sina processer – oavsett om det gäller kundapplikationer, intern analys eller kritiska beslutsstödsystem – innebär beskedet om API-nedläggning omedelbar press på migration, testning och validering av alternativ. Den ekonomiska påverkan sträcker sig bortom rena utvecklingskostnader; det uppstår produktivitetsbortfall under migrationen, potentiella driftstörningar och risk för försämrad prestanda om alternativ inte håller samma nivå som originalet. Organisationer som inte har förberett sig för detta scenario hamnar ofta i ett reaktivt kaos, där man förhandlar om förlängd support eller accepterar sämre lösningar bara för att det saknas en genomtänkt migrationsstrategi. Den viktigaste insikten är att plattformsutfasning inte längre är ett undantag – det är ett förutsägbart inslag i AI-landskapet som kräver proaktiv planering.

Traditionella affärskontinuitetsramverk, såsom ISO 22301, är utformade för att hantera infrastrukturfel – system går ner, och du återställer dem från backup eller redundanta system. Dessa ramverk bygger på mått som Recovery Time Objective (RTO) och Recovery Point Objective (RPO) för att mäta hur snabbt du kan återställa tjänsten och hur mycket dataförlust som är acceptabelt. Men AI-fel fungerar på ett fundamentalt annorlunda sätt, och denna skillnad är avgörande: systemet fortsätter att köra, producerar utdata och betjänar användare samtidigt som det tyst fattar felaktiga beslut. En bedrägeridetektionsmodell kan godkänna allt fler bedrägliga transaktioner; en prissättningsmotor kan systematiskt underprissätta produkter; ett system för låneansökningar kan utveckla dolda fördomar som diskriminerar skyddade grupper – allt medan det till synes fungerar normalt. Traditionella kontinuitetsplaner har ingen mekanism för att upptäcka dessa fel, eftersom de inte letar efter försämrad träffsäkerhet eller växande bias; de är utformade för att upptäcka systemkrascher och dataförlust. Den nya verkligheten kräver ytterligare mått: Recovery Accuracy Objective (RAO), som definierar acceptabla prestandatrösklar, och Recovery Fairness Objective (RFO), som säkerställer att modellbyten inte introducerar eller förstärker diskriminerande utfall. Tänk på ett finansbolag som använder en AI-modell för kreditbeslut; om modellen förändras och systematiskt börjar neka krediter till vissa grupper, ser den traditionella planen inget problem – systemet är ju igång. Men verksamheten riskerar regelbrott, ryktesskador och juridiskt ansvar.

| Aspekt | Traditionella infrastrukturfel | AI-modellfel |

|---|---|---|

| Upptäckt | Omedelbar (systemet nere) | Fördröjd (utdata ser normala ut) |

| Synlighet av påverkan | Tydlig och mätbar | Dold i träffsäkerhetsmått |

| Återställningsmått | RTO/RPO | RAO/RFO krävs |

| Rotorsak | Hårdvaru-/nätverksproblem | Drift, bias, dataskiften |

| Användarupplevelse | Tjänsten otillgänglig | Tjänsten tillgänglig men felaktig |

| Regelefterlevnadsrisk | Dataförlust, driftstopp | Diskriminering, ansvar |

Cykler för plattformsutfasning följer oftast ett förutsägbart mönster, även om tidsramen kan variera mycket beroende på plattformens mognad och användarbas. De flesta plattformar aviserar utfasning med 12–24 månaders framförhållning, vilket ger utvecklare tid att migrera – men detta fönster är ofta kortare för snabbt utvecklande AI-plattformar där nya modeller innebär stora förbättringar. Själva tillkännagivandet ger omedelbar press: utvecklingsteam måste bedöma konsekvenser, utvärdera alternativ, planera migration och säkra budget och resurser, samtidigt som nuvarande drift bibehålls. Versionshanteringskomplexiteten ökar väsentligt när organisationer kör flera modeller parallellt under övergångsperioder; du underhåller i praktiken två parallella system, vilket fördubblar test- och övervakningsbördan. Migrationsschemat handlar inte bara om att byta API-anrop; det innebär att träna om mot nya modellutdata, validera att den nya modellen fungerar tillräckligt bra för dina användningsområden och eventuellt justera parametrar som var optimerade för den utfasade modellens beteende. Vissa organisationer har ytterligare begränsningar: godkännandeprocesser från myndigheter, kontrakt som kräver vissa modellversioner, eller äldre system där API-integrationerna är så djupa att det krävs stora ingenjörsinsatser vid ombyggnad. Att förstå dessa cykler gör att du kan gå från reaktivt släckarbete till proaktiv planering, där migrationsscheman byggs in i produktplanen istället för att hanteras som nödlägen.

De direkta kostnaderna för plattformsmigration underskattas ofta och omfattar mycket mer än uppenbara utvecklingstimmar för att uppdatera API-anrop och integrera nya modeller. Utvecklingsinsatsen handlar inte bara om kodändringar utan även om arkitekturella modifieringar – om ditt system optimerats för specifika latenser, genomströmningsgränser eller utdataformat för den utfasade modellen kan den nya plattformen kräva omfattande omarbetning. Testning och validering är en betydande dold kostnad; du kan inte bara byta modell och hoppas på det bästa, särskilt inte i affärskritiska tillämpningar. Varje användningsfall, gränsfall och integrationspunkt måste testas för att säkerställa att den nya modellen ger acceptabla resultat. Prestandaskillnader mellan modeller kan vara drastiska – den nya modellen kan vara snabbare men mindre träffsäker, billigare men med andra utdataegenskaper, eller mer kapabel men kräva annan indataformatering. Efterlevnads- och granskningskrav lägger ytterligare en nivå: om din organisation verkar i reglerade branscher (finans, vård, försäkring) kan du behöva dokumentera migrationen, validera att den nya modellen uppfyller regelkrav och eventuellt få godkännande innan bytet sker. Alternativkostnaden för ingenjörsresurser som tas från andra projekt är också betydande – de skulle kunna bygga nya funktioner eller förbättra befintliga system. Ofta upptäcker organisationer att den “nya” modellen kräver annan hyperparameterinställning, annan datapreprocessering eller annan övervakning, vilket förlänger både tidsram och kostnader för migrationen.

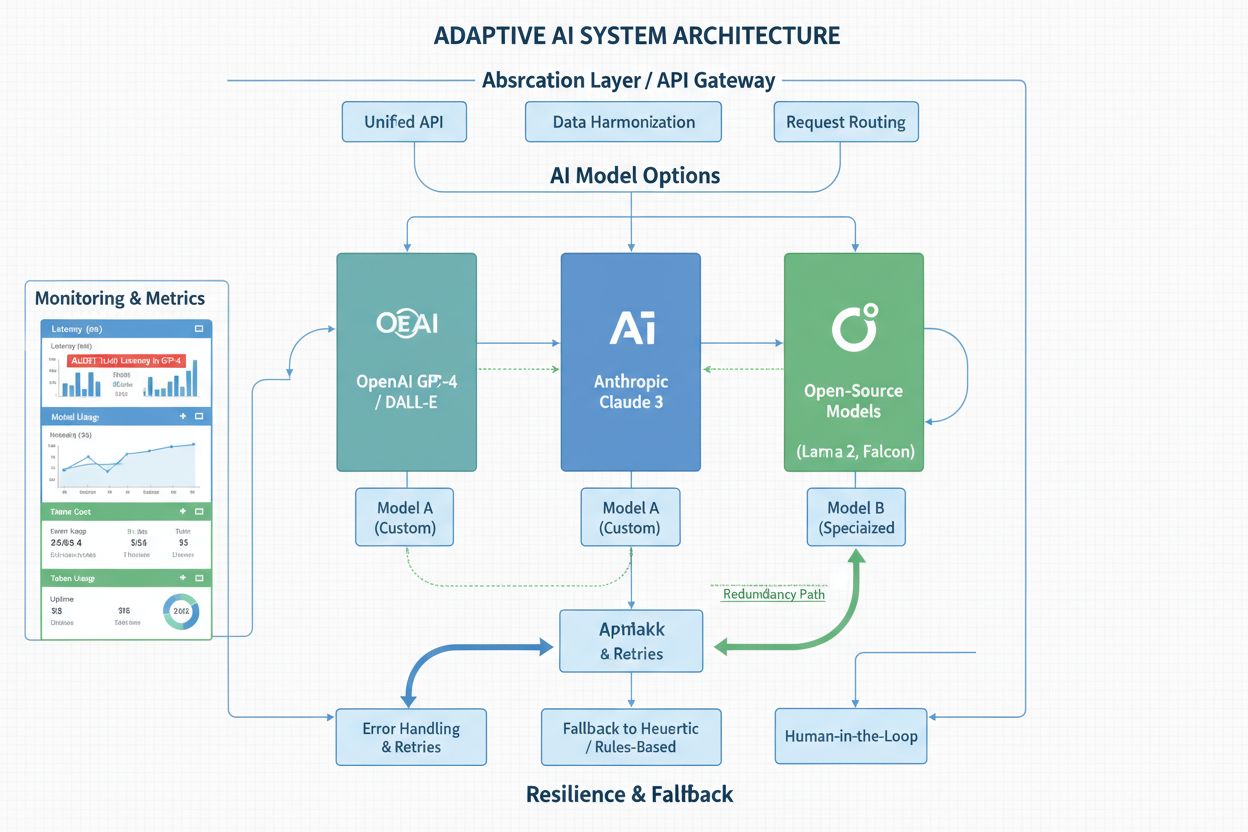

De mest motståndskraftiga organisationerna bygger sina AI-system med plattformsoberoende som kärnprincip, med insikten att dagens spjutspetsmodell så småningom kommer att fasas ut. Abstraktionslager och API-omslag är viktiga verktyg – istället för att lägga API-anrop direkt i kodbasen skapar du ett enhetligt gränssnitt som döljer vilken modellleverantör som används. Det innebär att när du behöver migrera mellan plattformar räcker det att ändra omslaget, inte dussintals integrationspunkter i systemet. Flermodellsstrategier ger ytterligare motståndskraft; vissa organisationer kör flera modeller parallellt för kritiska beslut, använder ensemblemetoder för att kombinera prediktioner eller har en sekundär modell som reserv. Detta ökar komplexiteten och kostnaden men ger försäkring mot plattformsförändringar – om en modell fasas ut har du redan en annan i produktion. Reservmekanismer är också viktiga: om huvudmodellen blir otillgänglig eller visar misstänkta resultat bör systemet kunna gå över till ett sekundärt alternativ istället för att fallera helt. Robusta övervaknings- och varningssystem gör att du kan upptäcka prestandaförsämring, träffsäkerhetsdrift eller oväntade beteendeförändringar innan de påverkar användare. Dokumentations- och versionshanteringsrutiner bör explicit spåra vilka modeller som används, när de driftsattes och deras prestanda – denna kunskap är ovärderlig när snabba migrationsbeslut krävs. Organisationer som investerar i dessa arkitektoniska mönster upplever att plattformsförändringar blir hanterbara händelser istället för kriser.

Att hålla sig informerad om plattformsmeddelanden och utfasningsnotiser kräver systematisk övervakning istället för att hoppas att du råkar se viktiga nyheter i inkorgen. De flesta större AI-plattformar publicerar utfasningsscheman på sina officiella bloggar, dokumentationssidor och utvecklarportaler, men dessa meddelanden kan lätt missas bland alla produktuppdateringar och nya funktioner. Genom att ställa in automatiska aviseringar för specifika plattformar – via RSS-flöden, e-postprenumerationer eller dedikerade övervakningstjänster – säkerställer du att du blir informerad så fort förändringar aviseras istället för att upptäcka dem månader senare. Utöver officiella meddelanden är det avgörande att spåra AI-modellernas prestandaförändringar i produktion; plattformar kan ibland göra subtila modelländringar, och du kan märka av träffsäkerhetsförsämring eller beteendeförändringar innan några officiella besked ges. Verktyg som AmICited ger värdefull övervakning av hur AI-plattformar refererar till ditt varumärke och innehåll, vilket ger insikt om plattformsförändringar och uppdateringar som kan påverka din verksamhet. Konkurrentbevakning kring plattformsuppdateringar hjälper dig förstå branschtrender och förutse vilka modeller som kan fasas ut härnäst – om konkurrenter redan migrerar bort från en viss modell är det en signal om att förändringar är på gång. Vissa organisationer prenumererar på plattformsnyhetsbrev, deltar i utvecklarsamhällen eller upprätthåller kontakt med plattformsansvariga som kan ge tidiga varningar om kommande förändringar. Investeringen i övervakningsinfrastruktur lönar sig när du får förvarning om utfasning och därmed får månader extra för planering istället för att behöva migrera snabbt under press.

En välstrukturerad responsplan för plattformsförändringar förvandlar det som annars kunde bli ett kaotiskt nödläge till en kontrollerad process med tydliga faser och beslutspunkter. Bedömningsfasen inleds direkt när du får kännedom om en utfasning; ditt team utvärderar effekten på alla system som använder den utfasade modellen, uppskattar arbetsinsatsen för migration och identifierar eventuella regulatoriska eller kontraktuella begränsningar som kan påverka tidsplanen. Denna fas resulterar i en detaljerad inventering av påverkade system, deras kritikalitet och beroenden – information som styr alla efterföljande beslut. Planeringsfasen tar fram en detaljerad migrationsplan, allokerar resurser, fastställer tidslinjer och prioriterar vilka system som migreras först (oftast icke-kritiska system för att samla erfarenhet före migrering av affärskritiska applikationer). Testningsfasen är där den största arbetsinsatsen sker; teamen verifierar att alternativa modeller fungerar tillräckligt bra för dina användningsfall, identifierar eventuella prestandagap eller beteendeskillnader och utvecklar lösningar eller optimeringar vid behov. Utrullningsfasen genomför migrationen stegvis, med “canary deployments” till en liten andel trafik, övervakning efter fel och gradvis ökning av trafik till den nya modellen. Eftermigreringsövervakning pågår i veckor eller månader, där prestandamått, användarfeedback och systembeteende följs upp för att säkerställa att migrationen lyckats och att den nya modellen presterar som förväntat. Organisationer som följer detta strukturerade tillvägagångssätt rapporterar jämnare migrationer med färre överraskningar och mindre störningar för användarna.

Att välja en ersättande plattform eller modell kräver systematisk utvärdering mot tydliga urvalskriterier som speglar organisationens behov och begränsningar. Prestandaegenskaper är uppenbara – träffsäkerhet, latens, genomströmning och kostnad – men lika viktiga är mindre uppenbara faktorer som leverantörens stabilitet (finns plattformen kvar om fem år?), supportkvalitet, dokumentation och community-storlek. Avvägningen mellan öppen källkod och proprietära lösningar förtjänar noggrann eftertanke; open source-modeller ger oberoende från leverantörsbeslut och möjlighet att köra modeller på egen infrastruktur, men kräver ofta mer ingenjörsinsats för drift och underhåll. Proprietära plattformar ger bekvämlighet, regelbundna uppdateringar och leverantörssupport, men innebär risk för leverantörslåsning – din verksamhet blir beroende av plattformens existens och prissättning. Kostnadsnyttoanalys bör omfatta totala ägandekostnaden, inte bara priset per API-anrop; en billigare modell som kräver mer ingenjörsinsats att integrera eller ger sämre resultat kan bli dyrare totalt sett. Långsiktig hållbarhet är en kritisk men ofta förbisedd faktor; att välja en modell från en välfinansierad, stabil plattform minskar risken för framtida utfasningar, medan en modell från en startup eller forskningsprojekt innebär högre risk för plattformsförändringar. Vissa organisationer väljer medvetet flera plattformar för att minska beroendet till en enskild leverantör, och accepterar högre komplexitet i utbyte mot minskad risk för framtida avbrott. Utvärderingsprocessen bör dokumenteras och ses över regelbundet, eftersom landskapet av tillgängliga modeller och plattformar ständigt förändras.

Organisationer som lyckas i det snabbt föränderliga AI-landskapet omfamnar ständigt lärande och anpassning som centrala operativa principer istället för att se plattformsförändringar som sporadiska störningar. Att bygga och underhålla relationer med plattformsleverantörer – via kontohantering, deltagande i användarråd eller regelbunden kontakt med produktteam – ger tidig insyn i kommande förändringar och ibland möjlighet att påverka utfasningsscheman. Att delta i betaprogram för nya modeller och plattformar låter din organisation utvärdera alternativ innan de är allmänt tillgängliga, vilket ger ett försprång i migrationsplaneringen om din nuvarande plattform fasas ut. Att hålla sig informerad om branschtrender och prognoser hjälper dig förutse vilka modeller och plattformar som sannolikt blir dominerande och vilka som kan försvinna; detta framtidsfokus gör att du kan fatta strategiska beslut om vilka plattformar som är värda att investera i. Att bygga intern expertis inom AI-modellevaluering, distribution och övervakning gör att organisationen inte blir beroende av externa konsulter eller leverantörer för kritiska beslut vid plattformsförändringar. Denna expertis inkluderar förståelse för hur man utvärderar modellprestanda, upptäcker drift och bias, designar system som kan anpassa sig till modellbyten och fattar välgrundade tekniska beslut under osäkerhet. Organisationer som satsar på dessa förmågor upplever att plattformsförändringar blir hanterbara utmaningar istället för existentiella hot – och de står starkare rustade att dra nytta av AI-teknikens framsteg när nya modeller och plattformar introduceras.

De flesta AI-plattformar ger 12–24 månaders förvarning innan en modell fasas ut, även om denna tidsram kan variera. Det viktiga är att börja planera omedelbart när utfasningen tillkännages istället för att vänta tills deadlinen närmar sig. Tidig planering ger dig möjlighet att testa alternativ noggrant och undvika stressade migrationer som kan medföra buggar eller prestandaproblem.

Plattformsutfasning betyder vanligtvis att en modell eller API-version inte längre får uppdateringar och så småningom tas bort. API-nedläggning är det slutliga steget då åtkomsten helt stängs av. Att förstå denna skillnad hjälper dig att planera din migration – du kan ha flera månaders utfasningsvarsel innan den faktiska nedläggningen sker.

Ja, och många organisationer gör det för affärskritiska tillämpningar. Att köra flera modeller parallellt eller ha en sekundär modell som reserv ger säkerhet mot plattformsförändringar. Detta tillvägagångssätt ökar dock komplexiteten och kostnaden, så det används oftast för system där tillförlitlighet är avgörande.

Börja med att dokumentera alla AI-modeller och plattformar som din organisation använder, inklusive vilka system som är beroende av varje. Övervaka officiella plattformsmeddelanden, prenumerera på utfasningsnotiser och använd övervakningsverktyg för att spåra plattformsförändringar. Regelbundna revisioner av din AI-infrastruktur hjälper dig att hålla koll på potentiella konsekvenser.

Om du inte anpassar dig till plattformsförändringar kan det leda till avbrott i tjänsten när plattformar stänger åtkomsten, prestandaförsämring om du tvingas använda sämre alternativ, regelbrott om ditt system blir icke-kompatibelt och skadat anseende på grund av driftstopp. Proaktiv anpassning förebygger dessa kostsamma scenarier.

Designa dina system med abstraktionslager som isolerar plattformsspecifik kod, upprätthåll relationer med flera plattformsleverantörer, utvärdera öppna källkods-alternativ och dokumentera din arkitektur för att möjliggöra enklare migrationer. Dessa metoder minskar ditt beroende av en enskild leverantör och ger flexibilitet när plattformar förändras.

Verktyg som AmICited övervakar hur AI-plattformar refererar till ditt varumärke och spårar plattformsuppdateringar. Dessutom bör du prenumerera på officiella plattformsnyhetsbrev, ställa in RSS-flöden för utfasningsnotiser, delta i utvecklarsamhällen och ha kontakt med plattformsansvariga för att få tidiga varningar om förändringar.

Granska din AI-plattformsstrategi minst varje kvartal, eller så snart du får kännedom om betydande plattformsförändringar. Oftare (månatligen) är lämpligt om du verkar i en snabbt föränderlig bransch eller är beroende av flera plattformar. Regelbundna översyner säkerställer att du är medveten om nya risker och kan planera migrationer proaktivt.

Övervaka hur AI-plattformar refererar till ditt varumärke och spåra viktiga plattformsuppdateringar innan de påverkar din verksamhet. Få realtidsaviseringar om utfasningsmeddelanden och plattformsförändringar.

Lär dig att hantera AI-plattformsövergångar och bibehålla citeringssynlighet när plattformar avvecklas. Strategisk guide för att hantera utfasade AI-plattformar...

Bemästra agila optimeringsstrategier för att snabbt anpassa dig till AI-plattforms algoritmförändringar. Lär dig hur du övervakar uppdateringar från ChatGPT, Pe...

Lär dig hur du förbereder din organisation för okända framtida AI-plattformar. Upptäck AI-förberedelsernas ramverk, avgörande pelare och praktiska steg för att ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.