Att bli citerad i Wikipedia-artiklar: En icke-manipulativ strategi

Lär dig etiska strategier för att få ditt varumärke citerat på Wikipedia. Förstå Wikipedias innehållspolicyer, tillförlitliga källor och hur du kan utnyttja cit...

Upptäck hur Wikipedia-citat formar AI-träningsdata och skapar en ripple-effekt över LLM:er. Lär dig varför din Wikipedia-närvaro är viktig för AI-omnämnanden och varumärkesuppfattning.

Wikipedia har blivit den grundläggande träningsdatan för praktiskt taget varje större språkmodell som finns idag – från OpenAI:s ChatGPT och Googles Gemini till Anthropics Claude och Perplexitys sökmotor. I många fall utgör Wikipedia den enskilt största källan till strukturerad, högkvalitativ text i dessa AI-systems träningsdataset, ofta mellan 5–15 % av hela träningskorpuset beroende på modell. Denna dominans kommer av Wikipedias unika egenskaper: dess neutrala synvinkelpolicy, noggrann faktagranskning genom gemenskapen, strukturerad formatering och fri licensiering gör den till en oöverträffad resurs för att lära AI-system att resonera, citera källor och kommunicera korrekt. Men denna relation har fundamentalt förändrat Wikipedias roll i det digitala ekosystemet – det är inte längre bara en plats för mänskliga läsare som söker information, utan snarare den osynliga ryggraden som driver den konversations-AI som miljontals interagerar med dagligen. Att förstå denna koppling avslöjar en avgörande ripple-effekt: kvaliteten, eventuella partiskheter och luckor i Wikipedia formar direkt kapaciteten och begränsningarna hos de AI-system som nu förmedlar hur miljarder människor får tillgång till och förstår information.

När stora språkmodeller bearbetar information under träning behandlar de inte alla källor lika – Wikipedia har en unikt privilegierad position i deras beslutshierarki. Under entitetsigenkänning identifierar LLM:er nyckelfakta och begrepp, och korsrefererar sedan mot flera källor för att fastställa trovärdighetspoäng. Wikipedia fungerar som ett “primärt auktoritetsfilter” i denna process tack vare sin transparenta redigeringshistorik, gemenskapsverifiering och neutrala synvinkel, vilket tillsammans signalerar pålitlighet till AI-system. Trovärdighetsmultiplikatoreffekten förstärker denna fördel: när information återkommer konsekvent i Wikipedia, strukturerade kunskapsgrafer som Google Knowledge Graph och Wikidata, samt akademiska källor, tilldelar LLM:er exponentiellt högre förtroende till den informationen. Detta viktade system förklarar varför Wikipedia får särskild behandling i träningen – det fungerar både som direkt kunskapskälla och valideringslager för fakta från andra källor. Resultatet är att LLM:er har lärt sig att behandla Wikipedia inte bara som en datapunkt bland många, utan som en grundläggande referens som antingen bekräftar eller ifrågasätter information från mindre granskade källor.

| Källtyp | Trovärdighetsvikt | Orsak | AI-behandling |

|---|---|---|---|

| Wikipedia | Mycket hög | Neutral, gemenskapsredigerad, verifierad | Primär referens |

| Företagswebbplats | Medel | Självpromoverande | Sekundär källa |

| Nyhetsartiklar | Hög | Tredjepart, men potentiellt vinklad | Stödjande källa |

| Kunskapsgrafer | Mycket hög | Strukturerad, aggregerad | Auktoritetsmultiplikator |

| Sociala medier | Låg | Overifierad, reklam | Minimal vikt |

| Akademiska källor | Mycket hög | Peer-reviewad, auktoritativ | Hög tilltro |

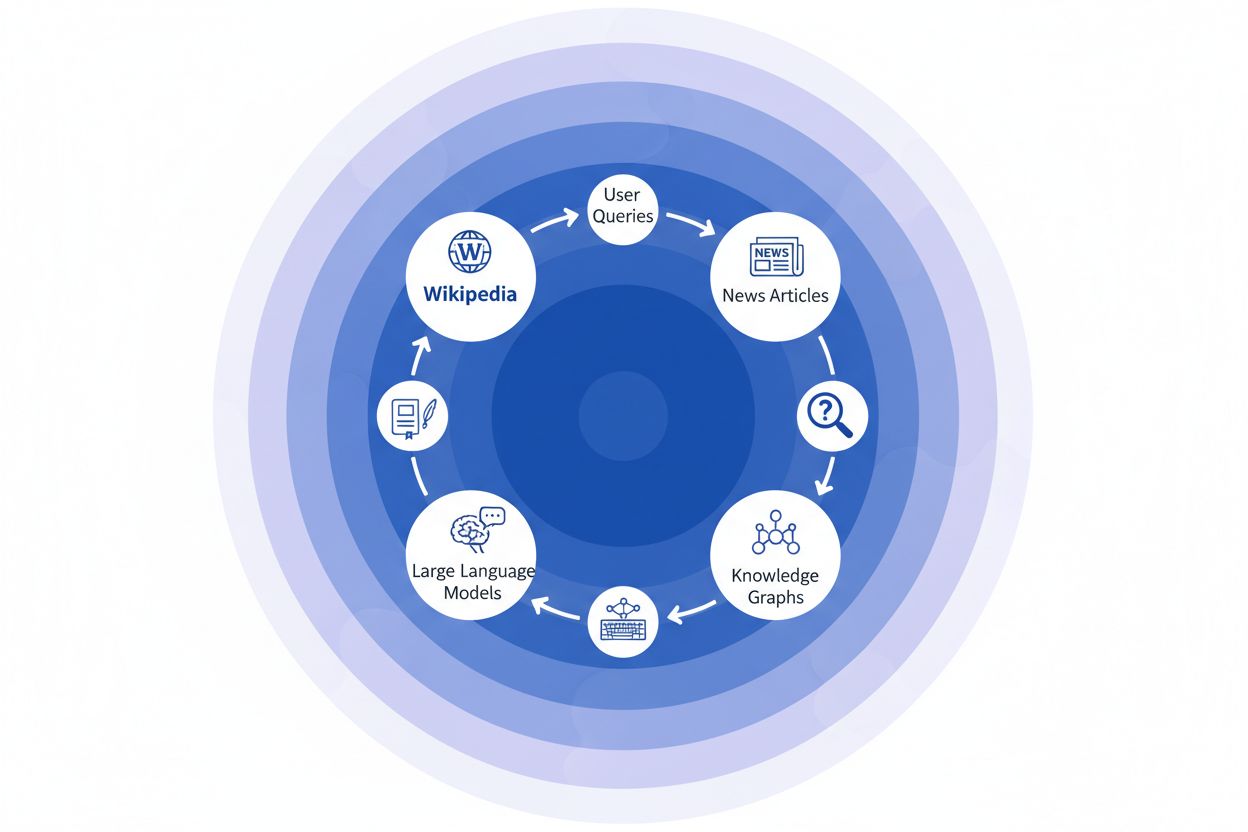

När en nyhetsorganisation citerar Wikipedia som källa skapas det vi kallar “citatkedjan” – en kaskadmekanism där trovärdighet samlas genom flera lager av informationsinfrastruktur. En journalist som skriver om klimatvetenskap kan referera till en Wikipedia-artikel om global uppvärmning, som i sin tur citerar peer-reviewade studier; den nyhetsartikeln indexeras sedan av sökmotorer och införlivas i kunskapsgrafer, som sedan tränar stora språkmodeller som miljontals användare frågar dagligen. Detta skapar en kraftfull återkopplingsslinga: Wikipedia → Kunskapsgraf → LLM → Användare, där den ursprungliga Wikipedia-artikelns utformning och fokus subtilt kan påverka hur AI-system presenterar information för slutanvändare – ofta utan att dessa inser att informationen härstammar från ett crowdsourcat uppslagsverk. Ta ett konkret exempel: om Wikipedias artikel om en läkemedelsbehandling betonar vissa kliniska studier och nedtonar andra, kan det redaktionella valet spridas genom nyhetsrapportering, bäddas in i kunskapsgrafer och slutligen påverka hur ChatGPT eller liknande modeller svarar på patienters frågor om behandlingsalternativ. Denna “ripple-effekt” innebär att Wikipedias redaktionella beslut inte bara påverkar läsare som direkt besöker sajten – de formar i grunden informationslandskapet som AI-system lär sig från och speglar tillbaka till miljarder användare. Citatkedjan omvandlar i praktiken Wikipedia från en referensdestination till ett osynligt men inflytelserikt lager i AI-träningskedjan, där noggrannhet och partiskhet vid källan kan förstärkas genom hela ekosystemet.

Ripple-effekten i Wikipedia-till-AI-ekosystemet är kanske den mest avgörande dynamiken för varumärken och organisationer att förstå. En enda Wikipedia-redigering förändrar inte bara en källa – den sprider sig genom ett sammankopplat nätverk av AI-system, som alla hämtar och förstärker informationen på sätt som multiplicerar dess påverkan exponentiellt. När en felaktighet dyker upp på en Wikipedia-sida stannar den inte isolerad; den sprids genom hela AI-landskapet och formar hur ditt varumärke beskrivs, förstås och presenteras för miljontals användare varje dag. Denna multiplikatoreffekt innebär att investering i Wikipedia-noggrannhet inte bara handlar om en plattform – det handlar om att kontrollera din berättelse i hela det generativa AI-ekosystemet. För digitala PR- och varumärkeshanterare innebär denna verklighet en fundamentalt förändrad kalkyl över var resurser och uppmärksamhet bör fokuseras.

Viktiga ripple-effekter att bevaka:

Ny forskning från IUP-studien av Vetter m.fl. har belyst en kritisk sårbarhet i vår AI-infrastruktur: Wikipedias hållbarhet som träningsresurs hotas alltmer av just den teknik den hjälper till att driva. När stora språkmodeller blir allt fler och tränas på ständigt växande dataset av AI-genererat innehåll, står området inför ett växande “modellkollaps”-problem där artificiella utdata börjar förorena träningsdatan, vilket försämrar modellkvaliteten över generationer. Fenomenet är särskilt allvarligt eftersom Wikipedia – ett crowdsourcat uppslagsverk byggt på mänsklig expertis och volontärarbete – har blivit en grundpelare för att träna avancerade AI-system, ofta utan att dess bidragsgivare får erkännande eller ersättning. De etiska konsekvenserna är djupgående: när AI-företag utvinner värde ur Wikipedias fritt bidragna kunskap samtidigt som de översvämmar informationsflödet med syntetiskt innehåll, utsätts de incitament som hållit Wikipedias volontärgemenskap vid liv i över två decennier för en aldrig tidigare skådad press. Utan avsiktliga insatser för att bevara mänskligt genererat innehåll som en särskild och skyddad resurs riskerar vi att skapa en återkopplingsslinga där AI-genererad text gradvis ersätter äkta mänsklig kunskap och i slutändan undergräver själva grunden som moderna språkmodeller vilar på. Wikipedias hållbarhet är därför inte bara en fråga för själva uppslagsverket, utan en avgörande fråga för hela informations-ekosystemet och den framtida livskraften för AI-system som är beroende av autentisk mänsklig kunskap.

När AI-system i allt större utsträckning förlitar sig på Wikipedia som grundläggande kunskapskälla har det blivit avgörande för moderna organisationer att övervaka hur deras varumärke framställs i AI-genererade svar. AmICited.com är specialiserat på att spåra Wikipedia-citat när de sprider sig genom AI-system och ger varumärken insikt i hur deras Wikipedia-närvaro översätts till AI-omnämnanden och rekommendationer. Medan alternativa verktyg som FlowHunt.io erbjuder generell webbövervakning, fokuserar AmICited unikt på Wikipedia-till-AI-citatskedjan och fångar exakt det ögonblick då AI-system refererar till din Wikipedia-sida och hur det påverkar deras svar. Att förstå denna koppling är avgörande eftersom Wikipedia-citat har stor betydelse i AI-träningsdata och svarsgenerering – en väl underhållen Wikipedia-närvaro informerar inte bara mänskliga läsare, den formar hur AI-system uppfattar och presenterar ditt varumärke för miljontals användare. Genom att övervaka dina Wikipedia-omnämnanden med AmICited får du handfasta insikter om ditt AI-avtryck, vilket gör att du kan optimera din Wikipedia-närvaro med full medvetenhet om dess nedströms påverkan på AI-driven upptäckt och varumärkesuppfattning.

Ja, varje större LLM inklusive ChatGPT, Gemini, Claude och Perplexity inkluderar Wikipedia i sin träningsdata. Wikipedia är ofta den enskilt största källan till strukturerad, verifierad information i LLM-träningsdataset, och utgör vanligtvis 5–15 % av hela träningskorpuset.

Wikipedia fungerar som en trovärdighetskontrollpunkt för AI-system. När en LLM genererar information om ditt varumärke väger den Wikipedia-beskrivningen tyngre än andra källor, vilket gör din Wikipedia-sida till en viktig faktor för hur AI-system representerar dig i ChatGPT, Gemini, Claude och andra plattformar.

Ripple-effekten syftar på hur en enda Wikipedia-citering eller redigering skapar följdeffekter genom hela AI-ekosystemet. En Wikipedia-ändring kan påverka kunskapsgrafer, som påverkar AI-översikter, som i sin tur påverkar hur flera AI-system beskriver ditt varumärke för miljontals användare.

Ja. Eftersom LLM:er betraktar Wikipedia som mycket trovärdig kommer felaktig information på din Wikipedia-sida att spridas genom AI-system. Det kan påverka hur ChatGPT, Gemini och andra AI-plattformar beskriver din organisation och potentiellt skada din varumärkesuppfattning.

Verktyg som AmICited.com spårar hur ditt varumärke citeras och nämns i AI-system, inklusive ChatGPT, Perplexity och Google AI Overviews. Detta hjälper dig att förstå ripple-effekten av din Wikipedia-närvaro och optimera därefter.

Wikipedia har strikta regler mot självpromovering. Alla redigeringar bör följa Wikipedias riktlinjer och baseras på pålitliga tredjepartskällor. Många organisationer arbetar med Wikipedia-specialister för att säkerställa efterlevnad och samtidigt behålla en korrekt närvaro.

LLM:er tränas på ögonblicksbilder av data, så ändringar tar tid att slå igenom. Kunskapsgrafer uppdateras dock oftare, så ripple-effekten kan börja inom veckor till månader beroende på AI-systemet och när det tränas om.

Wikipedia är en primär källa som används direkt i LLM-träning. Kunskapsgrafer som Googles Knowledge Graph samlar information från flera källor, inklusive Wikipedia, och matar in den i AI-system, vilket skapar ett extra lager av påverkan på hur AI-system förstår och presenterar information.

Följ hur Wikipedia-citat sprider sig genom ChatGPT, Gemini, Claude och andra AI-system. Förstå ditt AI-avtryck och optimera din Wikipedia-närvaro med AmICited.

Lär dig etiska strategier för att få ditt varumärke citerat på Wikipedia. Förstå Wikipedias innehållspolicyer, tillförlitliga källor och hur du kan utnyttja cit...

Upptäck hur Wikipedia fungerar som ett avgörande AI-träningsdataset, dess påverkan på modellernas noggrannhet, licensavtal och varför AI-företag är beroende av ...

Upptäck hur Wikipedia påverkar AI-citeringar i ChatGPT, Perplexity och Google AI. Lär dig varför Wikipedia är den mest pålitliga källan för AI-träning och hur d...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.