Inbäddning

Lär dig vad inbäddningar är, hur de fungerar och varför de är avgörande för AI-system. Upptäck hur text omvandlas till numeriska vektorer som fångar semantisk b...

Lär dig hur inbäddningar fungerar i AI-sökmotorer och språkmodeller. Förstå vektorrepresentationer, semantisk sökning och deras roll i AI-genererade svar.

Inbäddningar är numeriska vektorrepresentationer av text, bilder eller annan data som fångar semantisk betydelse och relationer. De gör det möjligt för AI-system att förstå kontext och utföra effektiva likhetssökningar, vilket gör dem grundläggande för hur moderna AI-sökmotorer och språkmodeller hämtar och genererar relevant information.

Inbäddningar är matematiska representationer av data som omvandlas till numeriska vektorer som fångar semantisk betydelse och relationer. I AI-sökningssammanhang omvandlar inbäddningar komplex information som text, bilder eller dokument till ett format som maskininlärningsmodeller kan bearbeta effektivt. Dessa vektorer existerar i ett högdimensionellt rum, där liknande objekt är placerade närmare varandra och återspeglar deras semantiska relationer. Denna grundläggande teknik driver hur moderna AI-sökmotorer som ChatGPT, Perplexity och andra AI-svarsgeneratorer förstår frågor och hämtar relevant information från stora kunskapsbaser.

Kärnsyftet med inbäddningar är att överbrygga klyftan mellan mänskligt språk och maskinell förståelse. När du söker efter information eller ställer en fråga i en AI-sökmotor omvandlas din fråga till en inbäddning—en numerisk representation som fångar betydelsen av dina ord. AI-systemet jämför sedan denna frågeinbäddning med inbäddningar av dokument, artiklar eller annat innehåll i dess kunskapsbas för att hitta de mest semantiskt liknande och relevanta resultaten. Denna process sker på millisekunder och möjliggör snabb hämtning av information som driver AI-genererade svar.

Inbäddningar fungerar genom att koda semantisk information i vektorer av siffror, vanligtvis från hundratals till tusentals dimensioner. Varje dimension i vektorn representerar olika aspekter av betydelse, kontext eller egenskaper hos ursprungsdatan. Till exempel, i textinbäddningar kan en dimension fånga om ett ord relaterar till teknik, en annan kan representera känsloläge och ytterligare en kan indikera formellhetsnivå. Skönheten i detta tillvägagångssätt är att semantiskt liknande innehåll producerar inbäddningar som är matematiskt nära varandra i vektorrummet.

Processen att skapa inbäddningar involverar att träna neurala nätverk, särskilt transformerbaserade modeller, på stora datamängder av text eller bilder. Dessa modeller lär sig att känna igen mönster och relationer i datan, och utvecklar gradvis förmågan att representera betydelse numeriskt. Moderna inbäddningsmodeller som Sentence-BERT (SBERT), OpenAI:s text-embedding-ada-002 och Universal Sentence Encoder har finjusterats specifikt för semantiska likhetsuppgifter. De kan bearbeta hela meningar eller stycken och generera inbäddningar som exakt återspeglar det semantiska innehållet, snarare än bara enskilda ord.

När en AI-sökmotor tar emot din fråga använder den samma inbäddningsmodell som användes för att inbädda kunskapsbasens innehåll. Denna konsekvens är avgörande—att använda olika inbäddningsmodeller för frågor och lagrade dokument skulle resultera i feljusterade vektorer och dålig hämtningsträffsäkerhet. Systemet utför sedan en likhetssökning genom att beräkna avståndet mellan din frågeinbäddning och alla lagrade inbäddningar, vanligtvis med mått som cosinuslikhet. Dokument med inbäddningar närmast din fråga returneras som de mest relevanta resultaten.

Retrieval-Augmented Generation (RAG) är en teknik som kombinerar stora språkmodeller med externa kunskapsbaser, och inbäddningar är helt avgörande för denna process. I RAG-system möjliggör inbäddningar att hämtarkomponenten kan hitta relevanta dokument eller avsnitt från en kunskapsbas innan språkmodellen genererar ett svar. Detta tillvägagångssätt gör det möjligt för AI-system att ge mer exakta, aktuella och domänspecifika svar än vad de kunde generera enbart från träningsdata.

| Komponent | Funktion | Inbäddningens roll |

|---|---|---|

| Frågebearbetning | Omvandla användarfråga till vektor | Möjliggör semantisk förståelse av frågan |

| Dokumenthämtning | Hitta relevanta dokument | Matchar frågeinbäddning mot dokumentinbäddningar |

| Kontexttillförsel | Tillhandahålla relevant information till LLM | Säkerställer att LLM har korrekt källmaterial |

| Svargenerering | Skapa svar baserat på kontext | Använder hämtad kontext för att generera exakta svar |

I ett typiskt RAG-arbetsflöde, när du ställer en fråga, omvandlar systemet först din fråga till en inbäddning. Det söker sedan i en vektordatabas som innehåller inbäddningar av alla tillgängliga dokument eller avsnitt. Systemet hämtar dokument med inbäddningar som är mest lika din frågeinbäddning och tillhandahåller språkmodellen relevant kontext. Språkmodellen använder sedan denna kontext för att generera ett mer korrekt och informerat svar. Denna tvåstegsprocess—hämtning följt av generering—förbättrar avsevärt kvaliteten och tillförlitligheten hos AI-genererade svar.

Olika datatyper kräver olika inbäddningsmetoder. För textdata har meningsnivå-inbäddningar blivit standard i moderna AI-system. Sentence-BERT genererar högkvalitativa inbäddningar genom att finjustera BERT specifikt för semantiska likhetsuppgifter och fångar betydelsen av hela meningar snarare än enskilda ord. OpenAI:s inbäddningsmodeller producerar inbäddningar som passar olika textlängder, från korta frågor till långa dokument. Dessa modeller har tränats på miljarder textexempel, vilket gör att de kan förstå nyanserade semantiska relationer inom olika domäner och språk.

För bilddata skapar modeller som CLIP (Contrastive Language-Image Pretraining) inbäddningar som representerar visuella egenskaper och semantiskt innehåll. CLIP är särskilt kraftfull eftersom den anpassar visuell och textuell information i ett gemensamt inbäddningsutrymme, vilket möjliggör multimodal hämtning där du kan söka efter bilder med textfrågor eller tvärtom. Denna förmåga blir allt viktigare i takt med att AI-sökmotorer blir mer multimodala och hanterar inte bara text utan även bilder, videor och andra medietyper.

För ljuddata skapar djupinlärningsmodeller såsom Wav2Vec 2.0 inbäddningar som fångar högre nivåers semantiskt innehåll, vilket gör dem lämpliga för röstsökning och AI-applikationer baserade på ljud. För grafdata och strukturerade relationer gör tekniker som Node2Vec och Graph Convolutional Networks det möjligt att skapa inbäddningar som bevarar nätverksgrannskap och relationer. Valet av inbäddningsteknik beror på den specifika datatypen och AI-applikationens krav.

En av de mest kraftfulla tillämpningarna för inbäddningar är semantisk sökning, som går bortom enkel nyckelords-matchning. Traditionella sökmotorer letar efter exakta ordträffar, men semantisk sökning förstår betydelsen bakom orden och hittar resultat baserat på konceptuell likhet. När du söker efter “bästa restauranger nära mig” i en AI-sökmotor letar systemet alltså inte bara efter sidor som innehåller exakt de orden. Istället förstår det att du letar efter matställen i ditt geografiska område och hämtar relevanta resultat baserat på semantisk betydelse.

Inbäddningar möjliggör denna semantiska förståelse genom att representera betydelse som matematiska relationer i vektorrummet. Två dokument kan använda helt olika ord men uttrycka liknande idéer—deras inbäddningar skulle ändå ligga nära varandra i vektorrummet. Denna förmåga är särskilt värdefull i AI-sökning eftersom systemet kan hitta relevant information även när exakt terminologi skiljer sig åt. Till exempel skulle en fråga om “fordonstransport” hämta resultat om “bilar” och “automobiler”, eftersom dessa begrepp har liknande inbäddningar även om orden är olika.

Effektiviteten i semantisk sökning via inbäddningar är anmärkningsvärd. Istället för att jämföra din fråga mot varje dokument ord för ord, utför systemet en enda matematisk operation som jämför vektorer. Moderna vektordatabaser använder avancerade indexeringstekniker såsom Approximate Nearest Neighbor (ANN) search med algoritmer som HNSW (Hierarchical Navigable Small World) och IVF (Inverted File Index) för att göra dessa sökningar otroligt snabba, även vid sökning genom miljarder inbäddningar.

Allteftersom AI-system bearbetar allt större datamängder blir effektiv lagring och hantering av inbäddningar avgörande. Vektordatabaser är specialiserade databaser utformade specifikt för lagring och sökning i högdimensionella vektorer. Populära vektordatabaser inkluderar Pinecone, som erbjuder molnbaserad arkitektur med låglatenssökning; Weaviate, en öppen källkodslösning med GraphQL- och RESTful-API:er; och Milvus, en skalbar plattform med öppen källkod som stöder olika indexeringsalgoritmer.

Dessa databaser använder optimerade datastrukturer och algoritmer för att möjliggöra snabba likhetssökningar bland miljoner eller miljarder inbäddningar. Utan specialiserade vektordatabaser skulle sökning bland inbäddningar vara alltför långsam. Vektordatabaser implementerar sofistikerade indexeringstekniker som minskar söktiden från linjär (kontroll av varje inbäddning) till logaritmisk eller nästan konstant tid. Kvantisering är en annan viktig teknik som används i vektordatabaser där vektorer komprimeras för att minska lagringsbehovet och snabba upp beräkningar, dock med en liten kompromiss i noggrannhet.

Skalbarheten hos vektordatabaser är avgörande för moderna AI-sökmotorer. De stödjer horisontell skalning genom sharding och replikering, vilket gör det möjligt för system att hantera massiva datamängder distribuerade över flera servrar. Vissa vektordatabaser stödjer inkrementella uppdateringar, vilket gör att nya dokument kan läggas till i kunskapsbasen utan att det krävs en fullständig omindexering av all befintlig data. Denna kapacitet är avgörande för AI-sökmotorer som måste hålla sig uppdaterade med ny information.

Innan data kan inbäddas och användas i AI-söksystem måste den beredas korrekt. Denna process innefattar extraktion, kurering och chunking. Ostrukturerad data såsom PDF:er, Word-dokument, e-post och webbsidor måste först tolkas för att extrahera text och metadata. Datakurering säkerställer att extraherad text korrekt återspeglar originalinnehållet och är lämplig för inbäddningsgenerering. Chunking delar upp långa dokument i mindre, kontextuellt meningsfulla sektioner—ett kritiskt steg eftersom inbäddningsmodeller har inmatningslängdsgränser och eftersom mindre delar ofta hämtar mer precist än hela dokument.

Kvaliteten på databeredningen påverkar direkt kvaliteten på inbäddningarna och noggrannheten i AI-sökresultaten. Om dokumenten delas upp i för små delar kan viktig kontext gå förlorad. Om delarna är för stora kan de innehålla irrelevant information som urvattnar den semantiska signalen. Effektiva chunking-strategier bevarar informationsflödet samtidigt som de säkerställer att varje del är tillräckligt fokuserad för att hämtas korrekt. Moderna plattformar automatiserar mycket av denna förbearbetning, extraherar information från olika filformat, rengör data och formaterar den för inbäddningsgenerering.

Metadata-berikning är en annan viktig aspekt av databeredning. Att extrahera och bevara metadata såsom dokumenttitlar, författare, datum och källinformation hjälper till att förbättra hämtningens noggrannhet och gör det möjligt för AI-system att tillhandahålla bättre källhänvisningar och kontext. När en AI-sökmotor hämtar information för att besvara din fråga, gör rik metadata det möjligt att exakt ange var informationen kommer ifrån, vilket förbättrar transparens och trovärdighet hos AI-genererade svar.

Spåra hur ditt innehåll visas i AI-genererade svar över ChatGPT, Perplexity och andra AI-sökmotorer. Få realtidsaviseringar när ditt varumärke, domän eller URL:er nämns.

Lär dig vad inbäddningar är, hur de fungerar och varför de är avgörande för AI-system. Upptäck hur text omvandlas till numeriska vektorer som fångar semantisk b...

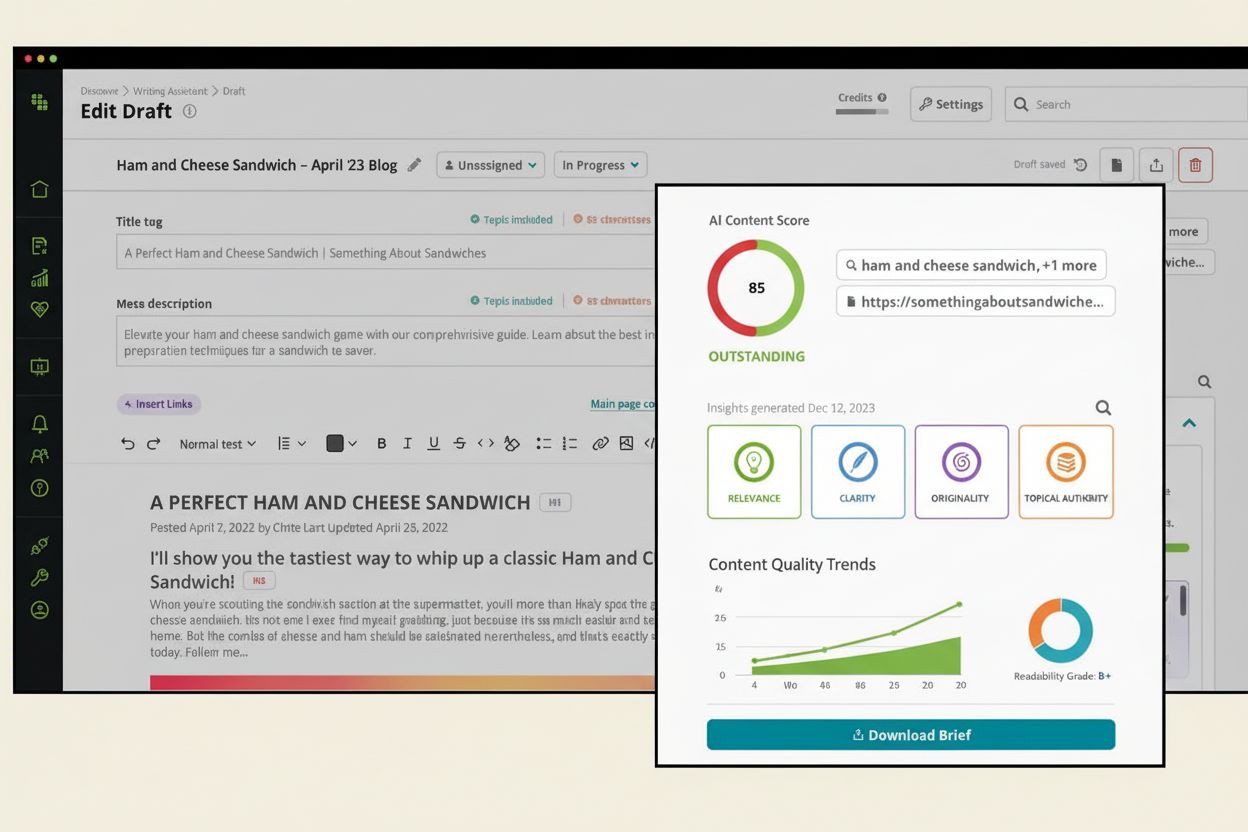

Lär dig vad en AI-innehållspoäng är, hur den utvärderar innehållets kvalitet för AI-system och varför det är viktigt för synlighet i ChatGPT, Perplexity och and...

Lär dig hur AI-motorer som ChatGPT, Perplexity och Gemini indexerar och bearbetar webbinnehåll med avancerade crawlers, NLP och maskininlärning för att träna sp...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.