AI-källval

Lär dig hur AI-system väljer och rankar källor för citering. Upptäck algoritmerna, signalerna och faktorerna som avgör vilka webbplatser AI-plattformar som Chat...

Lär dig om källselektionbias inom AI, hur det påverkar maskininlärningsmodeller, verkliga exempel och strategier för att upptäcka och begränsa detta kritiska rättviseproblem.

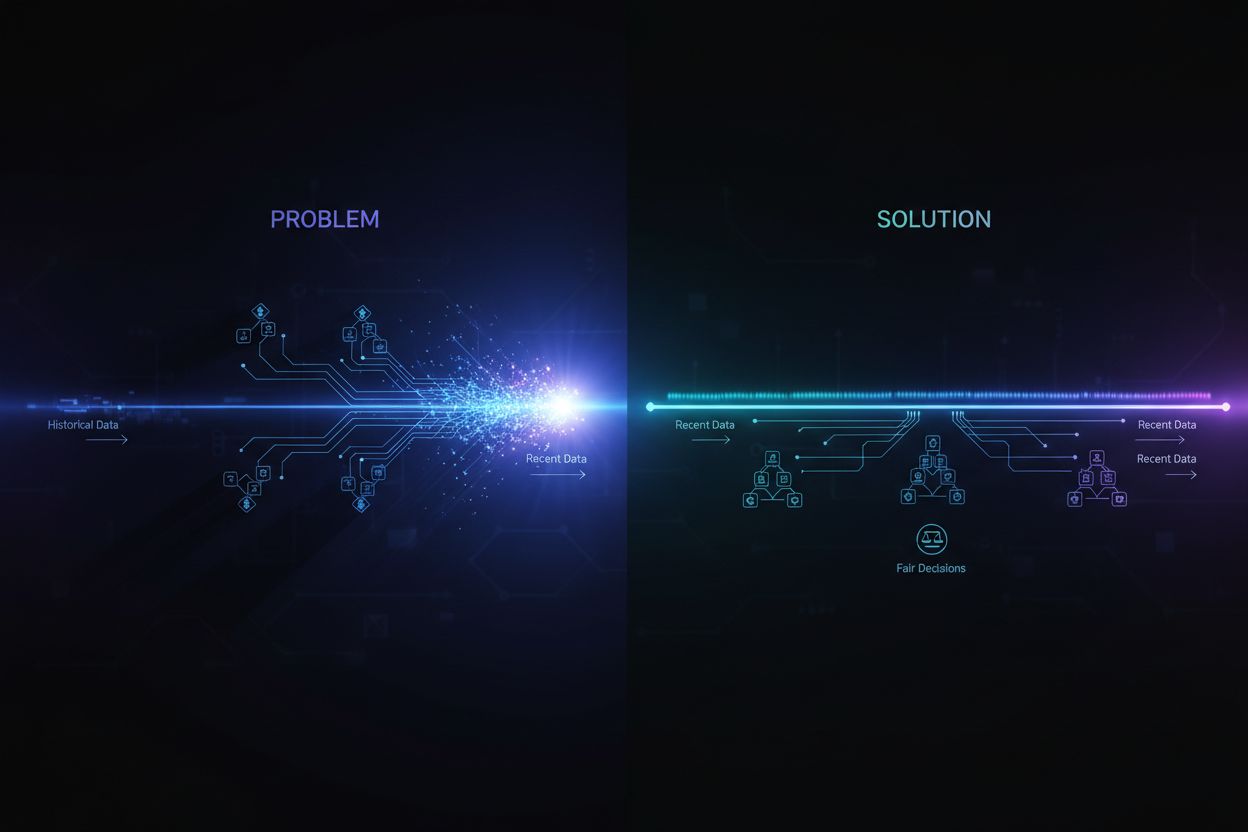

Källselektionbias uppstår när träningsdata inte är representativ för den övergripande populationen eller den verkliga fördelningen, vilket gör att AI-modeller gör felaktiga förutsägelser för underrepresenterade grupper eller scenarier.

Källselektionbias är ett grundläggande problem inom artificiell intelligens som uppstår när de data som används för att träna maskininlärningsmodeller inte korrekt representerar den verkliga populationen eller fördelningen de är avsedda att betjäna. Denna typ av bias uppkommer när dataset väljs ut på sätt som systematiskt utesluter eller underrepresenterar vissa grupper, scenarier eller egenskaper. Konsekvensen blir att AI-modeller lär sig mönster från ofullständig eller skev data, vilket leder till förutsägelser som är felaktiga, orättvisa eller diskriminerande mot underrepresenterade populationer. Att förstå denna bias är avgörande för alla som utvecklar, implementerar eller förlitar sig på AI-system, eftersom det direkt påverkar rättvisa, noggrannhet och tillförlitlighet i automatiserade beslutsprocesser över olika branscher.

Källselektionbias skiljer sig från andra former av bias eftersom den uppstår redan i datainsamlingsfasen. Istället för att komma från algoritmiska val eller mänskliga antaganden under modellutvecklingen, är källselektionbias inbyggt i själva grunden för träningsdatan. Detta gör den särskilt svår eftersom modeller som tränas på partisk källdata kommer att förstärka dessa biaser i sina förutsägelser, oavsett hur sofistikerad algoritmen är. Problemet blir ännu mer kritiskt när AI-system används inom områden med höga insatser, såsom sjukvård, ekonomi, rättsväsende och rekrytering, där partiska förutsägelser kan få allvarliga konsekvenser för individer och samhällen.

Källselektionbias utvecklas genom flera olika mekanismer under processen för datainsamling och urval. Den vanligaste vägen sker genom täkningsbias, där vissa populationer eller scenarier systematiskt utesluts från träningsdatan. Till exempel, om ett ansiktsigenkänningssystem huvudsakligen tränas på bilder av ljushyade individer, kommer det att ha dålig täckning av mörkare hudtoner, vilket leder till högre felprocent för dessa grupper. Detta händer eftersom datainsamlare kan ha begränsad tillgång till olika populationer, eller omedvetet prioritera vissa grupper vid insamling av data.

En annan viktig mekanism är bortfallsbias, även kallad deltagandebias, vilket uppstår när vissa grupper är mindre benägna att delta i datainsamlingsprocesser. Tänk på ett enkätbaserat dataset för att förutsäga konsumentpreferenser: om vissa demografiska grupper är betydligt mindre benägna att svara på enkäter, kommer deras preferenser att vara underrepresenterade i träningsdatan. Detta skapar ett dataset som verkar balanserat men i själva verket speglar deltagandemönster snarare än verkliga populationskaraktäristika. Inom sjukvården, till exempel, om kliniska studiedata främst kommer från urbana populationer med tillgång till avancerad vård, kanske de resulterande AI-modellerna inte generaliserar väl till landsbygd eller underbetjänade samhällen.

Urvals-bias utgör en tredje mekanism där korrekt randomisering inte används vid datainsamlingen. Istället för att slumpmässigt välja datapunkter kan samlare välja de första tillgängliga exemplen eller använda bekvämlighetsurval. Detta introducerar systematiska fel eftersom de valda exemplen inte representerar den bredare populationen. Till exempel, om en AI-modell för att förutsäga låndefault tränas på data som samlats in från en specifik region eller tidsperiod, kanske den inte korrekt förutsäger default i andra regioner eller under andra ekonomiska förhållanden.

| Biastyp | Mekanism | Verkligt exempel |

|---|---|---|

| Täkningsbias | Systematisk uteslutning av populationer | Ansiktsigenkänning tränad endast på ljushyade ansikten |

| Bortfallsbias | Deltagandegap i datainsamling | Sjukvårdsmodeller tränade endast på urbana populationer |

| Urvals-bias | Felaktig randomisering i urval | Låneprognosmodeller tränade på en geografisk region |

| Tidsmässig bias | Data från specifika tidsperioder | Modeller tränade på pre-pandemidata appliceras efter pandemin |

| Källdiversitetsbias | Begränsade datakällor | Medicinska bilddataset från ett enda sjukhussystem |

Konsekvenserna av källselektionbias i AI-system är djupa och långtgående, och påverkar både individer och organisationer. Inom sjukvården har källselektionbias lett till diagnossystem som presterar avsevärt sämre för vissa patientgrupper. Forskning har visat att AI-algoritmer för att diagnostisera hudcancer uppvisar betydligt lägre noggrannhet för patienter med mörk hud, där vissa studier visar endast omkring hälften så hög diagnostisk noggrannhet jämfört med ljushyade patienter. Denna skillnad leder direkt till fördröjda diagnoser, olämpliga behandlingsrekommendationer och sämre hälsoutfall för underrepresenterade grupper. När träningsdatan huvudsakligen kommer från patienter i en demografisk grupp, lär sig modellerna mönster specifika för den gruppen och misslyckas med att generalisera till andra.

Inom finansiella tjänster har källselektionbias i kreditbedömning och utlåningsalgoritmer upprätthållit historisk diskriminering. Modeller som tränats på historisk data över lånebeslut som speglar tidigare diskriminerande utlåningspraxis kommer att reproducera samma bias när de fattar nya lånebeslut. Om vissa grupper historiskt nekats kredit på grund av systemisk diskriminering, och denna historiska data används för att träna AI-modeller, kommer modellerna att lära sig att neka kredit till liknande grupper i framtiden. Detta skapar en ond cirkel där historiska orättvisor byggs in i algoritmiskt beslutsfattande, vilket påverkar individers tillgång till kapital och ekonomiska möjligheter.

Rekrytering och anställning är ett annat viktigt område där källselektionbias orsakar betydande skada. AI-verktyg som används vid CV-granskning har visat sig uppvisa bias baserat på uppfattad ras och kön, där studier visar att namn som förknippas med vita föredrogs 85 % av gångerna i vissa system. När träningsdatan kommer från historiska anställningsregister som återspeglar tidigare diskriminering eller homogena anställningsmönster, lär sig AI-modellerna att reproducera dessa mönster. Detta innebär att källselektionbias i anställningsdata upprätthåller diskriminering i arbetslivet i stor skala, vilket begränsar möjligheter för underrepresenterade grupper och minskar mångfalden.

Inom rättsväsendet har källselektionbias i prediktiva polisverktyg lett till oproportionerlig övervakning av vissa samhällen. När träningsdatan kommer från historiska gripanderegister som redan är partiska mot marginaliserade grupper, förstärker de resulterande modellerna dessa bias genom att förutsäga högre brottslighet i dessa områden. Detta skapar en återkopplingsslinga där partiska förutsägelser leder till ökad polisnärvaro i vissa områden, vilket genererar mer gripandedata från dessa områden och förstärker ytterligare biasen i modellen.

Att upptäcka källselektionbias kräver ett systematiskt angreppssätt som kombinerar kvantitativ analys, kvalitativ utvärdering och kontinuerlig övervakning genom hela modellens livscykel. Det första steget är att genomföra en omfattande datarevision som granskar källor, insamlingsmetoder och representativitet för din träningsdata. Detta innebär att dokumentera var data kommer ifrån, hur den samlats in och om insamlingsprocessen kan ha systematiskt uteslutit vissa populationer eller scenarier. Ställ kritiska frågor: Var alla relevanta demografiska grupper representerade i datainsamlingen? Fanns det deltagandebarriärer som kan ha hindrat vissa grupper från att delta? Begränsade insamlingsperioden eller det geografiska området representationen?

Demografisk paritetsanalys ger ett kvantitativt verktyg för att upptäcka källselektionbias. Detta innebär att jämföra fördelningen av viktiga egenskaper i din träningsdata mot fördelningen i den verkliga populationen som din modell ska betjäna. Om din träningsdata kraftigt underrepresenterar vissa demografiska grupper, åldersintervall, geografiska områden eller andra relevanta karaktäristika, har du bevis på källselektionbias. Till exempel, om din träningsdata endast innehåller 5 % kvinnor men målpopulationen är 50 % kvinnor, tyder detta på en allvarlig täckningsbias som sannolikt leder till dålig modellprestanda för kvinnor.

Prestandaanalys i delmängder är en annan viktig upptäcktsmetod där du utvärderar din modells prestanda separat för olika demografiska grupper och subpopulationer. Även om den totala modellens noggrannhet verkar acceptabel, kan prestandan variera dramatiskt mellan grupper. Om din modell uppnår 95 % noggrannhet totalt, men endast 70 % för en viss demografisk grupp, tyder det på att källselektionbias i träningsdatan har lett till att modellen lärt sig mönster specifika för majoritetsgruppen men misslyckats att lära sig relevanta mönster för minoritetsgruppen. Denna analys bör göras inte bara på total noggrannhet utan även på rättvisemått som equalized odds och disparate impact.

Adversarial testning innebär att medvetet skapa testfall som är utformade för att avslöja potentiella bias. Detta kan innebära att testa din modell på data från underrepresenterade populationer, gränsfall eller scenarier som inte är väl representerade i träningsdatan. Genom att stresstesta din modell mot olika indata kan du identifiera var källselektionbias har skapat blinda fläckar. Om din modell till exempel huvudsakligen har tränats på data från urbana områden, testa den utförligt på data från landsbygden för att se om prestandan försämras. Om din träningsdata kommer från en viss tidsperiod, testa modellen på data från andra perioder för att upptäcka tidsmässig bias.

Att begränsa källselektionbias kräver åtgärder i flera steg av AI-utvecklingens livscykel, med början i datainsamlingen och vidare genom modellutvärdering och implementering. Det mest effektiva tillvägagångssättet är datacentrerad begränsning, som angriper bias vid dess källa genom att förbättra kvaliteten och representativiteten i träningsdatan. Detta börjar med diversifierad datainsamling där du aktivt arbetar för att inkludera underrepresenterade populationer och scenarier i ditt dataset. Istället för att förlita sig på bekvämlighetsurval eller befintliga dataset bör organisationer genomföra riktade datainsamlingsinsatser för att säkerställa tillräcklig representation av alla relevanta demografiska grupper och användningsfall.

Omurvalnings- och omviktningstekniker erbjuder praktiska metoder för att hantera obalanser i befintliga dataset. Slumpmässig översampling duplicerar exempel från underrepresenterade grupper, medan slumpmässig undersampling minskar exempel från överrepresenterade grupper. Mer sofistikerade metoder som stratifierat urval säkerställer proportionell representation över flera dimensioner samtidigt. Omviktning ger större vikt till underrepresenterade exempel under modellträning, vilket effektivt instruerar algoritmen att lägga större vikt vid minoritetsgruppers mönster. Dessa tekniker fungerar bäst i kombination med datainsamlingsinsatser för att samla in mer varierad data, snarare än att enbart lita på omurval av begränsad data.

Syntetisk datagenerering erbjuder en annan väg för att hantera källselektionbias, särskilt när det är svårt eller dyrt att samla in verklig data från underrepresenterade grupper. Tekniker som Generative Adversarial Networks (GANs) och Variational Autoencoders (VAEs) kan skapa realistiska syntetiska exempel för underrepresenterade grupper. Mer riktade metoder som SMOTE (Synthetic Minority Over-sampling Technique) skapar syntetiska exempel genom att interpolera mellan befintliga minoritetsfall. Syntetisk data bör dock användas försiktigt och valideras noggrant, eftersom den annars kan introducera egna biaser.

Rättvisemedvetna algoritmer utgör en ytterligare strategi för begränsning som verkar under modellträningen. Dessa algoritmer inför explicit rättvisevillkor i inlärningsprocessen, vilket säkerställer att modellen uppnår acceptabel prestanda för alla demografiska grupper, inte bara majoritetsgruppen. Adversarial debiasing använder exempelvis ett motstående nätverk för att säkerställa att modellens förutsägelser inte kan användas för att avslöja skyddade egenskaper som ras eller kön. Rättviseregularisering lägger till strafftermer till förlustfunktionen som avskräcker diskriminerande beteende. Dessa metoder gör det möjligt att explicit väga mellan total noggrannhet och rättvisa, och välja den balans som passar dina etiska prioriteringar.

Kontinuerlig övervakning och omträning säkerställer att källselektionbias inte uppstår eller förvärras över tid. Även om din ursprungliga träningsdata är representativ kan den verkliga fördelningen som din modell betjänar förändras på grund av demografiska skiften, ekonomiska förändringar eller andra faktorer. Genom att implementera övervakningssystem som spårar modellens prestanda separat för olika demografiska grupper kan du upptäcka när bias uppstår. När prestandaförsämring upptäcks kan omträning med uppdaterad data som speglar aktuella populationer återställa rättvisan. Denna fortlöpande process erkänner att biasbegränsning inte är en engångsinsats utan ett kontinuerligt ansvar.

Att förstå källselektionbias blir allt viktigare i samband med AI-svarsövervakning och varumärkesnärvarospårning. Eftersom AI-system som ChatGPT, Perplexity och andra AI-svarsgeneratorer blir primära informationskällor för användare, formas de källor dessa system hänvisar till och den information de presenterar av deras träningsdata. Om träningsdatan som används för att bygga dessa AI-system uppvisar källselektionbias, kommer de svar de genererar att återspegla denna bias. Till exempel, om ett AI-systems träningsdata överrepresenterar vissa webbplatser, publikationer eller perspektiv samtidigt som andra underrepresenteras, kommer AI-systemet att vara mer benäget att citera och förstärka information från de överrepresenterade källorna.

Detta har direkta konsekvenser för varumärkesövervakning och synlighet av innehåll. Om ditt varumärke, domän eller dina URL:er är underrepresenterade i träningsdatan för stora AI-system, kan ditt innehåll systematiskt uteslutas från eller underrepresenteras i AI-genererade svar. Omvänt, om konkurrerande varumärken eller desinformationskällor är överrepresenterade i träningsdatan, får de oproportionerlig synlighet i AI-svar. Att övervaka hur ditt varumärke framställs i AI-genererade svar över olika plattformar hjälper dig att förstå om källselektionbias i dessa system påverkar din synlighet och ditt rykte. Genom att spåra vilka källor som citeras, hur ofta ditt innehåll förekommer och om informationen som presenteras är korrekt, kan du identifiera potentiella bias i hur AI-system framställer ditt varumärke och din bransch.

Källselektionbias inom AI är ett kritiskt rättviseproblem som uppstår redan i datainsamlingsfasen och sprider sig genom alla tillämpningar av maskininlärningsmodeller. Det uppstår när träningsdata systematiskt utesluter eller underrepresenterar vissa populationer, scenarier eller egenskaper, vilket resulterar i modeller som gör felaktiga eller orättvisa förutsägelser för underrepresenterade grupper. Konsekvenserna är allvarliga och långtgående, och påverkar sjukvårdsresultat, tillgång till finansiering, arbetsmöjligheter och rättsbeslut. Att upptäcka källselektionbias kräver omfattande datarevisioner, demografisk paritetsanalys, prestandaanalys i delmängder och adversarial testning. Att begränsa denna bias kräver ett mångsidigt angreppssätt inklusive diversifierad datainsamling, omurval och omviktning, syntetisk datagenerering, rättvisemedvetna algoritmer och kontinuerlig övervakning. Organisationer måste inse att åtgärda källselektionbias inte är valfritt utan avgörande för att bygga AI-system som är rättvisa, korrekta och pålitliga för alla populationer och användningsfall.

Säkerställ att ditt varumärke framställs korrekt i AI-genererade svar över ChatGPT, Perplexity och andra AI-plattformar. Spåra hur AI-system citerar ditt innehåll och identifiera potentiella bias i AI-responsen.

Lär dig hur AI-system väljer och rankar källor för citering. Upptäck algoritmerna, signalerna och faktorerna som avgör vilka webbplatser AI-plattformar som Chat...

Lär dig om färskhetsbias i AI-system, hur det påverkar innehållssynlighet, rekommendationsalgoritmer och affärsbeslut. Upptäck strategier för att motverka och m...

Community-diskussion om källurvalsbias i AI-system. Riktiga erfarenheter från marknadsförare och forskare kring att förstå och åtgärda AI:s preferentiella citer...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.