Vektorsökning

Vektorsökning använder matematiska vektorrepresentationer för att hitta liknande data genom att mäta semantiska relationer. Lär dig hur inbäddningar, avståndsmå...

Lär dig hur vektorsökning använder maskininlärningsinbäddningar för att hitta liknande objekt baserat på betydelse snarare än exakta nyckelord. Förstå vektordatabaser, ANN-algoritmer och verkliga tillämpningar.

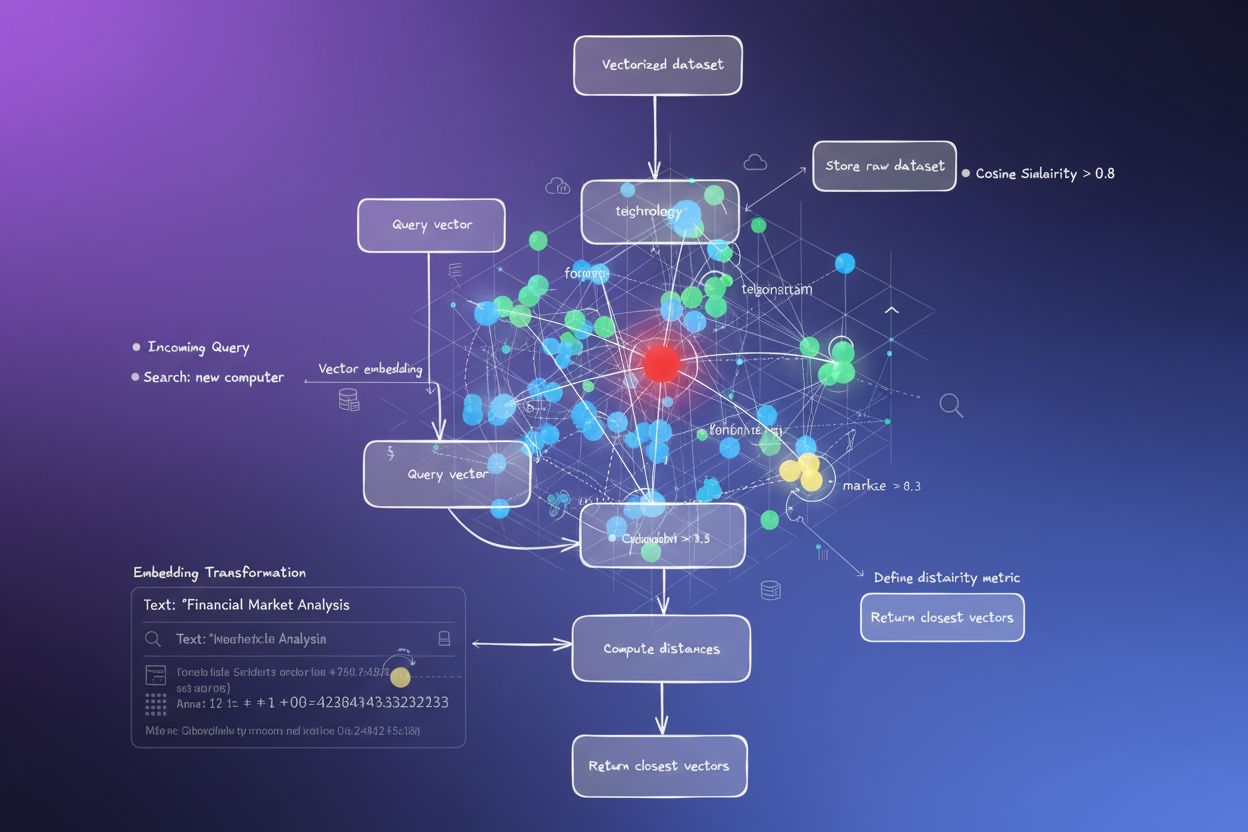

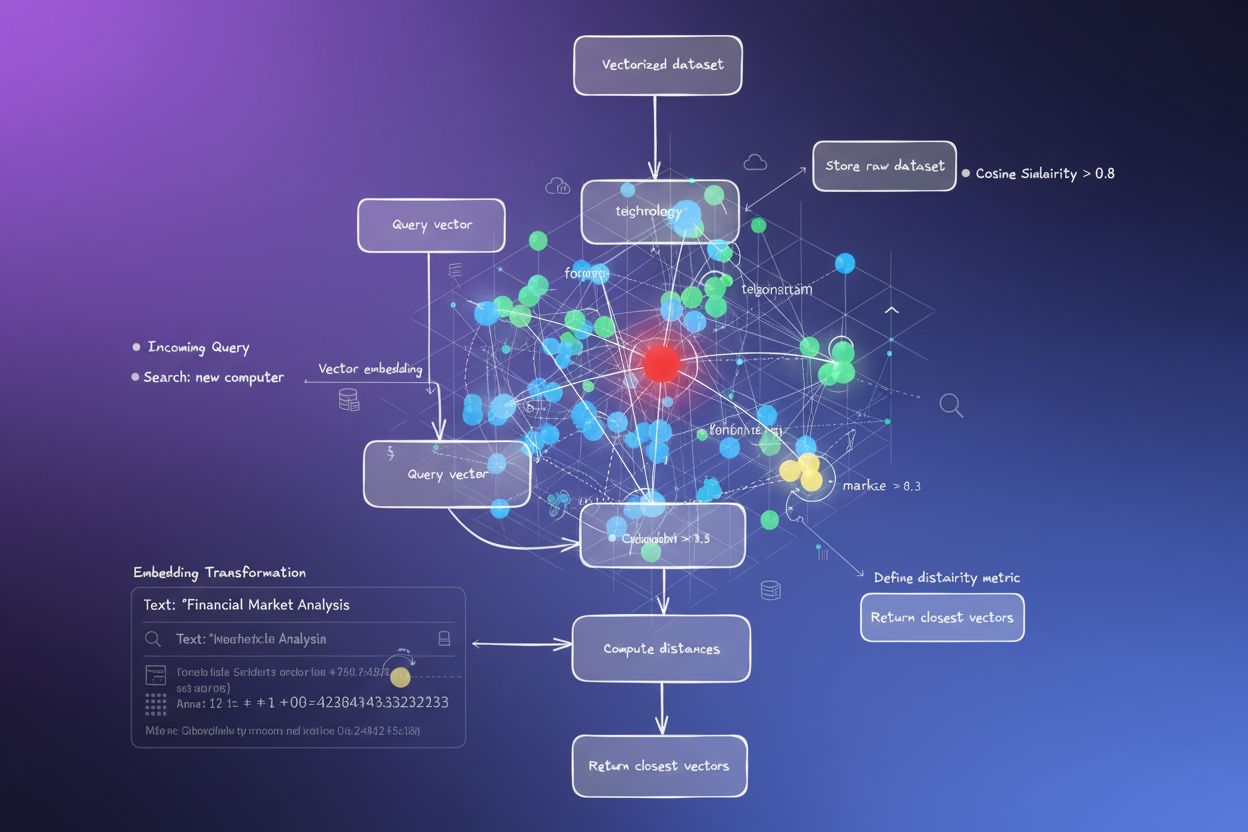

Vektorsökning är en teknik som använder maskininlärning för att omvandla data till numeriska representationer kallade vektorer, vilket gör det möjligt för system att hitta liknande objekt baserat på betydelse och sammanhang istället för exakta nyckelordsöverensstämmelser.

Vektorsökning är en sökteknik som hittar liknande objekt eller datapunkter genom att jämföra deras numeriska representationer kallade vektorer eller inbäddningar. Till skillnad från traditionella sökmotorer baserade på nyckelord som letar efter exakta ordmatchningar, förstår vektorsökning betydelsen och sammanhanget bakom frågor, vilket möjliggör mer intelligenta och relevanta resultat. Denna teknik har blivit grundläggande för moderna artificiella intelligenssystem, inklusive AI-svarsgeneratorer som ChatGPT, Perplexity och andra semantiska sökmotorer som driver nästa generation av informationshämtning.

Den grundläggande principen för vektorsökning är att liknande objekt har liknande vektorrepresentationer. När du söker efter information omvandlar systemet både din fråga och data till vektorer i ett högdimensionellt utrymme och beräknar sedan avståndet mellan dem för att avgöra relevans. Detta tillvägagångssätt fångar semantiska relationer och dolda mönster i data som traditionell nyckelords-matchning inte kan upptäcka, vilket gör det oumbärligt för tillämpningar från rekommendationssystem till retrieval-augmented generation (RAG)-ramverk som används i modern AI.

Traditionell nyckelordssökning fungerar genom att matcha exakta termer eller fraser i dokument. Om du söker efter “bästa pizzerian” returnerar systemet sidor som innehåller dessa exakta ord. Detta tillvägagångssätt har dock betydande begränsningar när det gäller variationer i språk, synonymer eller när användare inte känner till den exakta terminologin. Vektorsökning övervinner dessa begränsningar genom att förstå avsikt och betydelse istället för att förlita sig på exakta ordmatchningar.

I vektorsökning förstår systemet att “topprankade pizzaställen” och “bästa pizzerian” har liknande betydelse, även om de använder olika ord. Denna semantiska förståelse gör att vektorsökning kan returnera kontextuellt relevanta resultat som traditionella system skulle missa. Till exempel kan en vektorsökning returnera artiklar om högt rekommenderade pizzaställen på olika platser, även om dessa artiklar aldrig använder frasen “bästa pizzerian”. Skillnaden är djupgående: traditionell sökning fokuserar på att matcha nyckelord, medan vektorsökning fokuserar på att matcha betydelse.

| Aspekt | Traditionell nyckelordssökning | Vektorsökning |

|---|---|---|

| Matchningsmetod | Exakta ord- eller frasmatchningar | Semantisk likhet baserad på betydelse |

| Datarepresentation | Diskreta token, nyckelord, taggar | Täta numeriska vektorer i högdimensionellt utrymme |

| Skalbarhet | Har svårt med stora datamängder | Skalbar till miljoner eller miljarder objekt |

| Ostrukturerad data | Begränsad kapacitet | Hanterar text, bilder, ljud och video |

| Förståelse för kontext | Minimal | Fångar semantiska relationer och kontext |

| Sökhastighet | Varierar med datamängdens storlek | Millisekunder även med massiva datamängder |

Grunden för vektorsökning är vektoriseringsprocessen, som omvandlar rådata till numeriska representationer. Denna process börjar med datapreparering, där rå text eller andra datatyper rensas och standardiseras. Därefter väljs och tränas en inbäddningsmodell på datasetet för att generera inbäddningar för varje datapunkt. Populära inbäddningsmodeller inkluderar Word2Vec, GloVe, FastText och transformerbaserade modeller som BERT eller RoBERTa.

Vektorinbäddningar är täta numeriska arrayer där de flesta eller alla element är olika noll, vilket gör det möjligt att lagra mer information på mindre utrymme jämfört med glesa representationer. Varje dimension av en vektor motsvarar en latent egenskap eller underliggande karaktäristik hos datan som inte observeras direkt men härleds genom matematiska modeller. Till exempel kan dimensioner i textinbäddningar fånga semantiska koncept som känsloläge, ämne eller entitetstyp. Dessa inbäddningar lagras sedan i en vektordatabas eller ett vektorsökningsplugin, där index skapas med tekniker som Hierarchical Navigable Small World (HNSW)-grafer för att möjliggöra snabb och effektiv hämtning baserad på likhetsfrågor.

Vektorsökning avgör relevans genom att mäta likhet mellan fråge- och dokumentvektorer med hjälp av matematiska avståndsmått. De två vanligaste avståndsmåtten är euklidiskt avstånd och cosinuslikhet. Euklidiskt avstånd beräknar det raka avståndet mellan två punkter i rymden och beräknas som kvadratroten av summan av kvadrerade skillnader mellan motsvarande koordinater. Detta mått fungerar bra i lägre dimensioner men kan bli mindre effektivt i högdimensionella vektorrum.

Cosinuslikhet mäter vinkeln mellan två vektorer och indikerar hur nära de är varandra. Den beräknar cosinus för vinkeln mellan vektorerna, från -1 till 1, där 1 indikerar perfekt linjering, 0 ortogonala vektorer och -1 motsatt riktning. Cosinuslikhet är särskilt användbart för vektorsökning eftersom det fokuserar på riktning snarare än storlek, vilket gör det idealiskt för att jämföra högdimensionella inbäddningar. Vid jämförelse av vektorer med hundratals eller tusentals dimensioner ger cosinuslikhet mer meningsfulla likhetsvärden än euklidiskt avstånd, vilket är anledningen till att det är det föredragna måttet i de flesta moderna vektorsökningssystem.

Att jämföra varje vektor i en databas mot en frågevektor skulle vara beräkningsmässigt dyrt och opraktiskt för stora datamängder. För att lösa detta problem använder vektorsökningssystem Approximate Nearest Neighbor (ANN)-algoritmer, som effektivt hittar vektorer som är ungefär närmast en fråga utan att beräkna exakta avstånd till varje vektor. ANN-algoritmer byter ut en liten mängd noggrannhet mot enorma vinster i hastighet och beräkningskapacitet, vilket gör vektorsökning praktisk i stor skala.

En av de mest populära ANN-algoritmerna är HNSW (Hierarchical Navigable Small World), som organiserar vektorer i en hierarkisk, flerskiktad grafstruktur. Denna struktur möjliggör snabb navigering genom datamängden under sökning genom att klustra liknande vektorer tillsammans vid indexkonstruktion. HNSW balanserar längre avstånd för snabbare sökning i de övre lagren med kortare avstånd för noggrann sökning i de nedre lagren, vilket uppnår hög återkallningsgrad (ofta över 95 %) och millisekundsnivå på fördröjningen även med miljarder vektorer. Andra ANN-metoder inkluderar trädbaserade tillvägagångssätt som ANNOY, klusterbaserade metoder som FAISS och hashningstekniker som LSH, alla med olika kompromisser mellan fördröjning, kapacitet, noggrannhet och byggtid.

Vektorsökning driver många tillämpningar över olika domäner och branscher. Retrieval Augmented Generation (RAG) är en av de viktigaste tillämpningarna, där vektorsökning kombineras med stora språkmodeller för att skapa korrekta och kontextuellt relevanta svar. I RAG-system hämtar vektorsökning relevanta dokument eller passager från en kunskapsbas, vilka sedan används av en LLM för att generera svar baserat på verklig data istället för endast modellens träningsdata. Detta tillvägagångssätt minskar hallucinationer och förbättrar den faktiska noggrannheten i AI-genererade svar avsevärt.

Rekommendationssystem använder vektorsökning för att föreslå produkter, filmer, musik eller innehåll baserat på användarpreferenser och beteende. Genom att hitta objekt med liknande vektorrepresentationer kan rekommendationsmotorer föreslå produkter som användare inte har interagerat med men sannolikt skulle uppskatta. Semantiska sökapplikationer använder vektorsökning för att driva sökmotorer som förstår användarens avsikt, vilket gör att användare kan hitta relevant information även utan exakta nyckelordsöverensstämmelser. Bild- och videosöksystem använder vektorinbäddningar för att indexera visuellt innehåll, vilket möjliggör sökning efter visuellt liknande bilder eller videor över stora datamängder. Dessutom möjliggör vektorsökning multimodala sökfunktioner, där användare kan söka över olika datatyper samtidigt, till exempel att hitta bilder baserat på textbeskrivningar eller vice versa.

Vektorsökning har blivit kritisk infrastruktur för AI-svarsgeneratorer och semantiska sökmotorer som ChatGPT, Perplexity och liknande plattformar. Dessa system använder vektorsökning för att hämta relevant information från sin träningsdata och indexerade kunskapsbaser när de genererar svar på användarfrågor. När du ställer en fråga till ett AI-system omvandlar det din fråga till en vektor och söker igenom massiva indexerade datamängder för att hitta den mest relevanta informationen, som sedan används för att generera kontextuellt lämpliga svar.

För företag och innehållsskapare är det avgörande att förstå vektorsökning för att säkerställa varumärkessynlighet i AI-genererade svar. Eftersom AI-system i allt större utsträckning blir det primära sättet människor söker information, blir det avgörande att ha sitt innehåll indexerat och åtkomligt via vektorsökning. Övervakningsplattformar som AmICited spårar hur ditt varumärke, din domän och dina URL:er visas i AI-genererade svar över flera AI-system och hjälper dig att förstå din synlighet i detta nya sökparadigm. Genom att övervaka vektorsökningsresultat kan du identifiera möjligheter att förbättra innehållets relevans och säkerställa att ditt varumärke syns när AI-system genererar svar relaterade till din bransch eller expertis.

Vektorsökning erbjuder betydande fördelar jämfört med traditionella sökmetoder, särskilt vid hantering av ostrukturerad data som dokument, bilder, ljud och video. Det möjliggör snabbare sökning över massiva datamängder, mer relevanta resultat baserat på semantisk förståelse och möjligheten att söka över flera datatyper samtidigt. Tekniken utvecklas ständigt, med förbättringar i inbäddningsmodeller, ANN-algoritmer och vektordatabaskapabiliteter, vilket gör vektorsökning snabbare, mer exakt och mer tillgänglig för utvecklare och organisationer av alla storlekar.

I takt med att artificiell intelligens blir alltmer integrerad i sökning och informationshämtning kommer vektorsökning att fortsätta spela en central roll i hur människor upptäcker information. Organisationer som förstår och utnyttjar vektorsökningsteknik kommer att vara bättre positionerade för att säkerställa att deras innehåll är upptäckbart i AI-genererade svar och för att bygga intelligenta applikationer som ger överlägsna användarupplevelser. Övergången från nyckelordsbaserad till semantisk sökning innebär en grundläggande förändring i hur information organiseras och hämtas, vilket gör vektorsökningskompetens oumbärlig för alla som arbetar med innehållsskapande, SEO eller AI-applikationsutveckling.

Vektorsökning driver moderna AI-system som ChatGPT och Perplexity. Se till att ditt varumärke visas i AI-genererade svar med AmICiteds övervakningsplattform.

Vektorsökning använder matematiska vektorrepresentationer för att hitta liknande data genom att mäta semantiska relationer. Lär dig hur inbäddningar, avståndsmå...

Lär dig hur vektorembeddningar gör det möjligt för AI-system att förstå semantisk betydelse och matcha innehåll med sökfrågor. Utforska teknologin bakom semanti...

Diskussion i communityt om vektorsökning och hur den driver AI:s upptäckt av innehåll. Riktiga erfarenheter från tekniska marknadsförare om att optimera innehål...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.