AI Crawl Errors

Lär dig om AI-crawlfel - tekniska problem som hindrar AI-crawlers från att komma åt innehåll. Förstå JavaScript-rendering, robots.txt, strukturerad data och hur...

Ett 404-fel är en HTTP-statuskod som indikerar att en webbserver inte kan hitta den begärda resursen eller webbsidan. När användare stöter på ett 404-fel betyder det att webbadressen de försökte nå antingen inte längre existerar, har flyttats utan korrekt omdirigering eller har skrivits in felaktigt.

Ett 404-fel är en HTTP-statuskod som indikerar att en webbserver inte kan hitta den begärda resursen eller webbsidan. När användare stöter på ett 404-fel betyder det att webbadressen de försökte nå antingen inte längre existerar, har flyttats utan korrekt omdirigering eller har skrivits in felaktigt.

Ett 404-fel är en HTTP-statuskod som indikerar att en webbserver inte kan hitta den begärda resursen eller webbsidan. När en användare försöker komma åt en webbadress som inte finns, har raderats, flyttats utan korrekt omdirigering eller skrivits in felaktigt, svarar servern med en 404-statuskod. Detta felmeddelande är en del av de standardiserade HTTP-svarskoderna som definieras i RFC 9110 och representerar ett klientfel, vilket innebär att problemet kommer från den begärda webbadressen snarare än ett serverfel. 404-felet är ett av de mest förekommande felen på internet och påverkar användarupplevelse och webbplatsens prestanda i alla webbläsare och på alla enheter. Att förstå vad ett 404-fel innebär och hur det åtgärdas är avgörande för webbplatsägare, utvecklare och digitala marknadsförare som vill upprätthålla optimal webbplatshälsa och användarnöjdhet.

404-statuskoden har varit en del av HTTP-protokollet sedan dess början på tidigt 1990-tal. Siffran “404” kommer från rumsnumret på CERN (Europeiska organisationen för kärnforskning) där World Wide Web uppfanns, även om detta till stor del är en historisk tillfällighet snarare än en avsiktlig namngivning. HTTP-statuskodsystemet utformades för att ge standardiserad kommunikation mellan webbservrar och klienter, så att servrar kan informera om resultatet av förfrågningar i maskinläsbart format. Under de senaste tre decennierna har 404-felet blivit allestädes närvarande på internet, och forskning visar att 23 % av nyhetssidor innehåller minst en trasig länk enligt en studie från Pew Research Center 2024. Dessutom fann en studie av Ahrefs att åtminstone 66,5 % av länkar till webbplatser från de senaste 9 åren nu är döda, vilket visar på den stora utmaningen med länkröta i det digitala landskapet. Förekomsten av 404-fel har lett till utvecklingen av många verktyg och bästa praxis för att identifiera, övervaka och reparera trasiga länkar för att upprätthålla webbplatshälsa och SEO-prestanda.

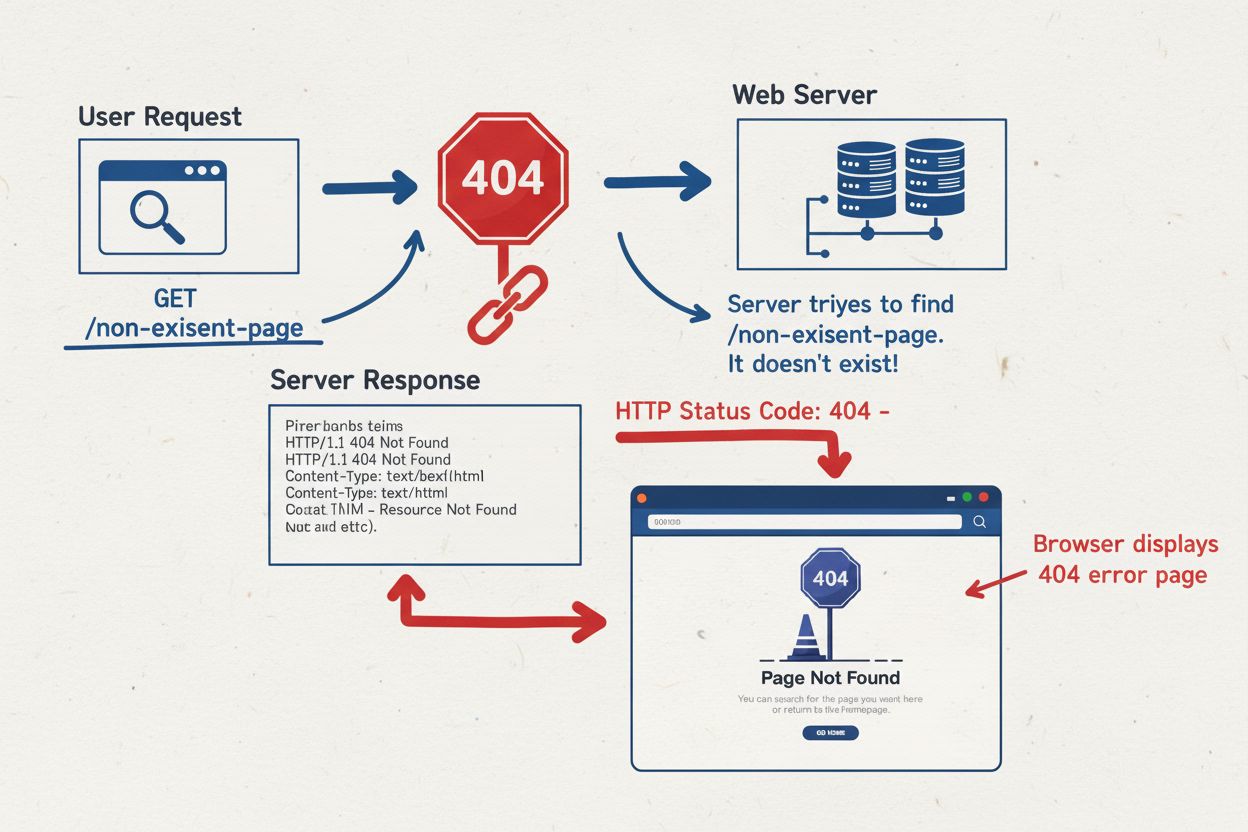

När en användare anger en webbadress i sin webbläsare eller klickar på en länk skickar webbläsaren en HTTP GET-begäran till webbservern som är värd för domänen. Servern behandlar begäran och försöker hitta den begärda resursen i sitt filsystem eller databas. Om servern inte hittar resursen på den angivna sökvägen genererar den ett HTTP 404-svar med statuskod 404 och inkluderar vanligtvis ett svarsmeddelande med ett felmeddelande. Servern kan också lägga till rubriker som Content-Type, Cache-Control och Last-Modified för att ge kontext om felsvaret. Vanliga scenarier som utlöser 404-fel är att komma åt en sida som har raderats permanent utan omdirigering, försöka nå en webbadress med fel filändelse (t.ex. .htm istället för .html), följa en trasig intern länk på grund av stavfel eller felkonfiguration, eller komma åt externa länkar som pekar på sidor som inte längre finns på andra webbplatser. 404-statuskoden skiljer sig från andra klientfel som 400 (Bad Request), 403 (Forbidden) och 405 (Method Not Allowed), vilka alla indikerar olika typer av klientfel. Att förstå de tekniska mekanismerna bakom 404-fel hjälper webbplatsadministratörer att implementera lämpliga lösningar och förebygga framtida incidenter.

| Statuskod | Namn | Typ | Betydelse | Användarpåverkan | SEO-påverkan |

|---|---|---|---|---|---|

| 404 | Ej hittad | Klientfel | Resursen finns inte; osäkert om frånvaron är tillfällig eller permanent | Användaren ser felsida; kan lämna webbplatsen | Indirekt påverkan; signalerar dåligt underhåll om det är överdrivet |

| 410 | Borta | Klientfel | Resursen permanent borttagen och kommer inte tillbaka | Användaren ser felsida; tydlig slutgiltighet | Snabbare avindexering; signalerar permanent borttagning |

| 200 | OK | Framgång | Begäran lyckades; resurs hittades och returnerades | Användaren ser begärt innehåll | Positivt; indikerar frisk sida |

| 301 | Flyttad permanent | Omdirigering | Resursen har flyttats till ny webbadress; permanent omdirigering | Användaren omdirigeras transparent till ny plats | Bevarar länkkraft; rekommenderad lösning |

| 302 | Hittad | Omdirigering | Resursen tillfälligt flyttad; tillfällig omdirigering | Användaren omdirigeras till ny plats | Ger inte full länkkraft; använd 301 för permanenta flyttar |

| 403 | Förbjuden | Klientfel | Servern förstod begäran men vägrar att uppfylla den | Användaren ser nekad åtkomst | Kan indikera autentiseringsproblem |

| 500 | Internt serverfel | Serverfel | Servern stötte på oväntat problem | Användaren ser serverfelmeddelande | Negativt; indikerar serverproblem |

| 503 | Tjänsten otillgänglig | Serverfel | Servern kan tillfälligt inte hantera begäran | Användaren ser otillgänglighetsmeddelande | Tillfällig påverkan; bör lösas snabbt |

Skillnaden mellan hårda 404-fel och soft 404-fel är avgörande för effektiv webbplatsförvaltning och SEO-optimering. Ett hårt 404-fel uppstår när en webbserver korrekt returnerar en HTTP 404-statuskod som svar på en begäran om en resurs som inte finns. Detta är det rätta och förväntade beteendet när en sida verkligen inte finns. Sökmotorer känner igen hårda 404-svar som legitima signaler om att en sida inte ska indexeras, och de optimerar crawlbudget genom att undvika upprepade genomsökningar av dessa webbadresser. Ett soft 404-fel uppstår däremot när en server returnerar en 200 OK-statuskod (som indikerar framgång), men sidinnehållet är tomt, visar ett generiskt felmeddelande eller saknar meningsfull information. Soft 404-fel är särskilt problematiska eftersom sökmotorer tolkar 200-statuskoden som ett framgångsrikt svar och kan försöka indexera den tomma eller felaktiga sidan, vilket slösar värdefull crawlbudget och kan skapa problem med duplicerat innehåll. En annan typ av soft 404 uppstår när administratörer omdirigerar alla saknade sidor till startsidan med en 301- eller 302-omdirigering, vilket vilseleder både användare och sökmotorer om innehållets tillgänglighet. Enligt Googles riktlinjer för 2025 bör soft 404-fel elimineras genom att implementera korrekta 404- eller 410-statuskoder, eftersom de förbrukar crawlresurser utan att ge värde. Att identifiera och åtgärda soft 404-fel är avgörande för att upprätthålla en sund webbplatsstruktur och säkerställa att sökmotorer korrekt förstår webbplatsens innehållstillgänglighet.

Relationen mellan 404-fel och sökmotoroptimering är nyanserad och har utvecklats avsevärt med moderna sökalgoritmer. Till skillnad från vanliga missuppfattningar leder inte 404-fel direkt till straff för en webbplats ranking eller får Google att sänka dess position. Enligt Googles officiella riktlinjer för 2025 ses 404-fel som en normal del av webbplatsunderhåll, och sökmotorer straffar inte sidor för att de har 404-sidor. Däremot har 404-fel betydande indirekta SEO-påverkan som kan försvaga webbplatsens sökprestanda. När en webbplats har många trasiga länkar signalerar det till sökmotorer att webbplatsen inte underhålls och inte uppdateras aktivt, vilket kan påverka upplevd kvalitet och trovärdighet negativt. Dessutom slösar överdrivet många 404-fel med crawlbudget, det vill säga de begränsade resurser sökmotorer tilldelar för att genomsöka en webbplats. Varje gång Googlebot stöter på ett 404-fel på en intern länk slösas crawlresurser bort som kunde ha använts för att upptäcka och indexera värdefullt innehåll. Forskning från Semrush visar att trasiga interna länkar slösar med crawlresurser och överför inte auktoritet mellan sidor, vilket direkt påverkar SEO-prestanda. Vidare, när sidor med hög auktoritet och många bakåtlänkar returnerar 404-fel, förlorar webbplatsen värdefull länkkraft som dessa bakåtlänkar representerar. Användare som stöter på 404-fel lämnar oftare webbplatsen, vilket ökar avvisningsfrekvensen och minskar engagemang, två faktorer som sökmotorer använder för att utvärdera användarnöjdhet. Därför bör webbplatsägare prioritera att identifiera och åtgärda 404-fel, särskilt de som påverkar sidor med externa bakåtlänkar eller stort internt länkvärde.

Webbplatsadministratörer har tillgång till flera verktyg och metoder för att identifiera 404-fel på sina sidor. Google Search Console, det kostnadsfria verktyget från Google för webbplatsägare, visar 404-fel i täckningsrapporten under avsnittet “Ej hittad (404)”, så att administratörer kan se vilka webbadresser som returnerar 404-svar som Google har stött på vid genomsökning. Täckningsrapporten identifierar även soft 404-fel som kan vara felkonfigurerade. SEO-verktyg som Screaming Frog SEO Spider, Semrush och Ahrefs erbjuder omfattande genomsökningsmöjligheter som systematiskt skannar webbplatser efter trasiga länkar, både interna och externa. Dessa verktyg genererar detaljerade rapporter som visar källan till trasiga länkar, destinationsadresserna och de HTTP-statuskoder som returneras. Dead Link Checker och W3C Link Checker är kostnadsfria onlinetjänster som låter användare kontrollera enskilda sidor eller hela webbplatser efter trasiga länkar utan installation eller teknisk kompetens. För övervakning på företagsnivå erbjuder AmICited specialiserad spårning av hur din domän visas på AI-plattformar som ChatGPT, Perplexity, Google AI Overviews och Claude, vilket hjälper till att identifiera när trasiga länkar eller 404-fel påverkar ditt varumärkes synlighet i AI-genererade svar. Regelbunden övervakning är avgörande; branschpraxis rekommenderar att man kontrollerar 404-fel minst var 60:e dag för att upprätthålla webbplatshälsa. Att införa automatiserad övervakning säkerställer att nya 404-fel upptäcks snabbt, så att de kan åtgärdas innan de påverkar användarupplevelse eller sökmotorprestanda nämnvärt.

Att åtgärda 404-fel kräver en strategisk metod som tar hänsyn till de specifika omständigheterna för varje trasig länk. När innehåll har flyttats till en ny webbadress är den rekommenderade lösningen att införa en 301 permanent omdirigering från den gamla adressen till den nya platsen. Denna omdirigering bevarar länkkraft genom att föra över auktoritet och ranking från den gamla adressen till den nya, så att både användare och sökmotorer omdirigeras sömlöst till rätt innehåll. För sidor som har blivit permanent borttagna utan ersättande innehåll är det lämpliga svaret att returnera antingen en 404 Not Found eller 410 Gone-statuskod, vilket tydligt signalerar till sökmotorer att innehållet inte längre finns. Statuskod 410 föredras ibland eftersom den tydligt indikerar permanent borttagning och kan bidra till snabbare avindexering. Vid stavfel eller fel i interna länkar är den enklaste lösningen att rätta länken direkt i källkoden eller innehållshanteringssystemet. När värdefulla sidor med många externa bakåtlänkar returnerar 404-fel bör administratörer antingen återställa det ursprungliga innehållet eller skapa en 301-omdirigering till den mest relevanta alternativa sidan på webbplatsen. Att skapa en anpassad 404-felsida rekommenderas starkt, eftersom det förbättrar användarupplevelsen genom att erbjuda navigeringsalternativ, sökfunktionalitet och varumärkesanpassade meddelanden som håller användare kvar på webbplatsen istället för att de lämnar direkt. Enligt bästa praxis från Googles Martin Splitt ska administratörer aldrig omdirigera alla 404-fel till startsidan, eftersom det vilseleder både användare och sökmotorer om innehållets tillgänglighet och slösar med crawlbudget.

En väl utformad anpassad 404-felsida är ett tillfälle att behålla användarengagemang och bevara varumärkets trovärdighet under ett felscenario. Istället för att visa ett generiskt serverfel bör organisationer skapa varumärkesanpassade 404-sidor med tydliga navigeringselement, som länkar till startsidan, huvudkategorier och populära innehållsavsnitt. Att inkludera en sökfunktion direkt på 404-sidan gör att användare snabbt kan hitta det innehåll de sökte, vilket minskar frustration och avvisningsfrekvens. Många framgångsrika företag använder sina 404-sidor för att tillföra personlighet och humor till felupplevelsen; till exempel visar Spotifys 404-sida “404s and heartbreaks”, en lek med Kanye Wests album, medan Amazon visar en vänlig hundbild med hjälpsamma navigeringsalternativ. 404-sidan bör ha konsekvent varumärke, typografi och design med resten av webbplatsen för att stärka varumärkesidentiteten även vid fel. Bästa praxis rekommenderar att inkludera en kortfattad, användarvänlig förklaring av vad som hände (t.ex. “Sidan du söker har flyttats eller tagits bort”), förslag på nästa steg och kontaktuppgifter för att rapportera felet. Forskning visar att genomtänkt utformade 404-sidor kan minska övergivandefrekvensen markant och tom skapa positiva intryck av varumärket genom att visa att organisationen bryr sig om användarupplevelsen. Omvänt kan dåligt utformade 404-sidor som är förvirrande, ohjälpsamma eller inkonsekventa med webbplatsens varumärke öka användarfrustrationen och skada varumärkesuppfattningen.

Övergången till mobilförst-indexering har fundamentalt förändrat hur 404-fel påverkar webbplatsens synlighet och sökprestanda. Från och med juli 2024 använder Google uteslutande mobilversionen av webbplatser för genomsökning, indexering och ranking, vilket innebär att ett 404-fel på mobilversionen av en sida leder till avindexering oavsett om desktopversionen fungerar korrekt. Detta skapar en kritisk sårbarhet för webbplatser som har olika mobil- och desktopimplementeringar eller som serverar mobilinnehåll via separata subdomäner (t.ex. m.example.com). Om mobilversionen returnerar 404 medan desktop visar innehåll som vanligt kommer Google att behandla sidan som obefintlig och ta bort den från sökresultaten. Vanliga orsaker till mobilunika 404-fel är felaktiga mobilomdirigeringar, blockerade CSS- eller JavaScript-resurser som förhindrar korrekt sidvisning, responsiva designproblem som gör att innehåll inte laddas på mobila enheter, och felkonfigurerade mobila sitemaps som pekar på obefintliga webbadresser. Administratörer måste verifiera att HTTP-statuskoder är konsekventa mellan mobil- och desktopversioner och genomföra mobilspecifika genomsökningar med verktyg som Semrush eller Ahrefs med mobilanvändaragenter. Övervakningsverktyg bör inkludera mobilspecifika kontroller för att identifiera 404-fel som endast förekommer på mobila enheter. Konsekvenserna är betydande: ett enda mobilunikt 404-fel kan leda till att sidan helt avindexeras, vilket orsakar omedelbar förlust av synlighet och trafik. Detta understryker vikten av omfattande testning på alla enhetstyper och att upprätthålla paritet mellan mobil- och desktopversioner.

Landskapet för 404-hantering utvecklas kontinuerligt i takt med att webteknologier utvecklas och sökmotorer förfinar sina algoritmer. Framväxande trender inkluderar ökad automatisering av upptäckt av trasiga länkar genom AI-drivna övervakningsverktyg som kan förutsäga och förhindra 404-fel innan de inträffar. Maskininlärningsalgoritmer integreras i SEO-plattformar för att identifiera mönster i länkröta och rekommendera proaktiva åtgärder. Framväxten av AI-drivna sökplattformar som ChatGPT, Perplexity och Google AI Overviews innebär nya överväganden för 404-hantering, då trasiga länkar i AI-genererade svar kan skada varumärkets trovärdighet och synlighet. Plattformar som AmICited växer fram för att övervaka hur varumärken visas i AI-svar och spåra trasiga länkar som påverkar varumärkets synlighet i dessa nya sökkanaler. I takt med att webbplatser blir mer dynamiska med innehållshanteringssystem, headless-arkitekturer och API-baserad distribution blir mekanismerna för att generera och hantera 404-fel allt mer sofistikerade. Framtida utveckling kan innefatta standardiserade protokoll för att kommunicera innehållstillgänglighet över distribuerade system, förbättrad crawlbudgetoptimering via prediktiv 404-upptäckt och förbättrade användarupplevelsefunktioner där AI föreslår relevant innehåll när användare stöter på 404-fel. Integrationen av 404-övervakning i bredare webbplatshälsopaneler och realtidslarm gör det möjligt med snabbare åtgärder och mer proaktivt underhåll. I takt med att sökmotorer fortsätter att prioritera användarupplevelse och driftsäkerhet kommer vikten av att hålla nere 404-fel bara att öka, vilket gör omfattande övervakning och hanteringsstrategier avgörande för konkurrenskraftig SEO-prestanda.

Statuskoden 404 är en del av HTTP-protokollet och indikerar specifikt att servern tog emot klientens begäran men inte kan hitta den begärda resursen. Enligt RFC 9110-specifikationerna innebär ett 404-svar att ursprungsservern inte hittade en aktuell representation för målresursen. Detta är ett klientfel, vilket betyder att problemet ligger hos den begärda webbadressen snarare än ett serverfel.

Även om 404-fel inte direkt straffar din webbsidas rankingar har de betydande indirekta SEO-konsekvenser. För många 404-fel signalerar dåligt webbplatsunderhåll till sökmotorer, slösar med crawlbudget och gör att användare överger din sida, vilket ökar avvisningsfrekvensen. En studie från Pew Research 2024 visade att 23 % av nyhetssidor innehåller minst en trasig länk, vilket belyser hur utbrett detta problem är på webben.

Ett hårt 404-fel returnerar rätt HTTP 404-statuskod när en sida inte finns. Ett soft 404 uppstår när en server returnerar en 200 OK-statuskod men visar innehåll som indikerar att sidan saknas eller är tom. Soft 404-fel är mer problematiska för SEO eftersom sökmotorer tolkar dem som framgångsrika sidor, vilket kan leda till indexering av tomt eller irrelevant innehåll och slöseri med crawlbudget.

De främsta orsakerna är borttaget eller flyttat innehåll utan korrekt omdirigering, stavfel i webbadresser, trasiga interna eller externa länkar, felaktiga filsökvägar och fel i domännamnssystemet (DNS). Enligt forskning är cirka 66,5 % av länkar till webbplatser från de senaste 9 åren nu döda, vilket visar hur länkröta ackumuleras över tid när innehåll åldras och webbplatser förändras.

Du kan upptäcka 404-fel med Google Search Console, som visar 404-sidor i täckningsrapporten, eller SEO-verktyg som Screaming Frog, Semrush och Ahrefs som genomsöker din sida efter trasiga länkar. Övervakningsverktyg som AmICited kan även spåra hur din domän visas i AI-svar och identifiera trasiga länkar som påverkar ditt varumärkes synlighet på AI-plattformar.

Om innehållet har flyttats till en ny webbadress, implementera en 301 permanent omdirigering från den gamla adressen till den nya platsen. Om sidan är permanent borttagen utan ersättning, använd en 404- eller 410-statuskod. Vid stavfel i interna länkar, rätta länken direkt. För värdefulla sidor med trasiga bakåtlänkar, återställ antingen innehållet eller omdirigera till en motsvarande sida för att bevara länkkraft.

Ja, anpassade 404-sidor förbättrar användarupplevelsen avsevärt och minskar övergivanden. En väl utformad 404-sida bör innehålla navigeringslänkar till din startsida, förslag på populärt innehåll, en sökfunktion och varumärkesanpassade meddelanden. Detta håller användare kvar på din sida istället för att de lämnar direkt, och hjälper till att bevara din webbplats trovärdighet och användarförtroende vid fel.

Enligt Googles riktlinjer för 2025 optimerar 404-fel faktiskt crawlbudget genom att signalera till Googlebot att inte genomsöka sidan igen. Däremot slösar soft 404-fel med crawlbudget eftersom Googlebot fortsätter försöka genomsöka dem. Att eliminera soft 404:or och åtgärda trasiga interna länkar förbättrar crawl-effektiviteten och säkerställer att sökmotorer fokuserar resurser på att indexera värdefullt innehåll.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig om AI-crawlfel - tekniska problem som hindrar AI-crawlers från att komma åt innehåll. Förstå JavaScript-rendering, robots.txt, strukturerad data och hur...

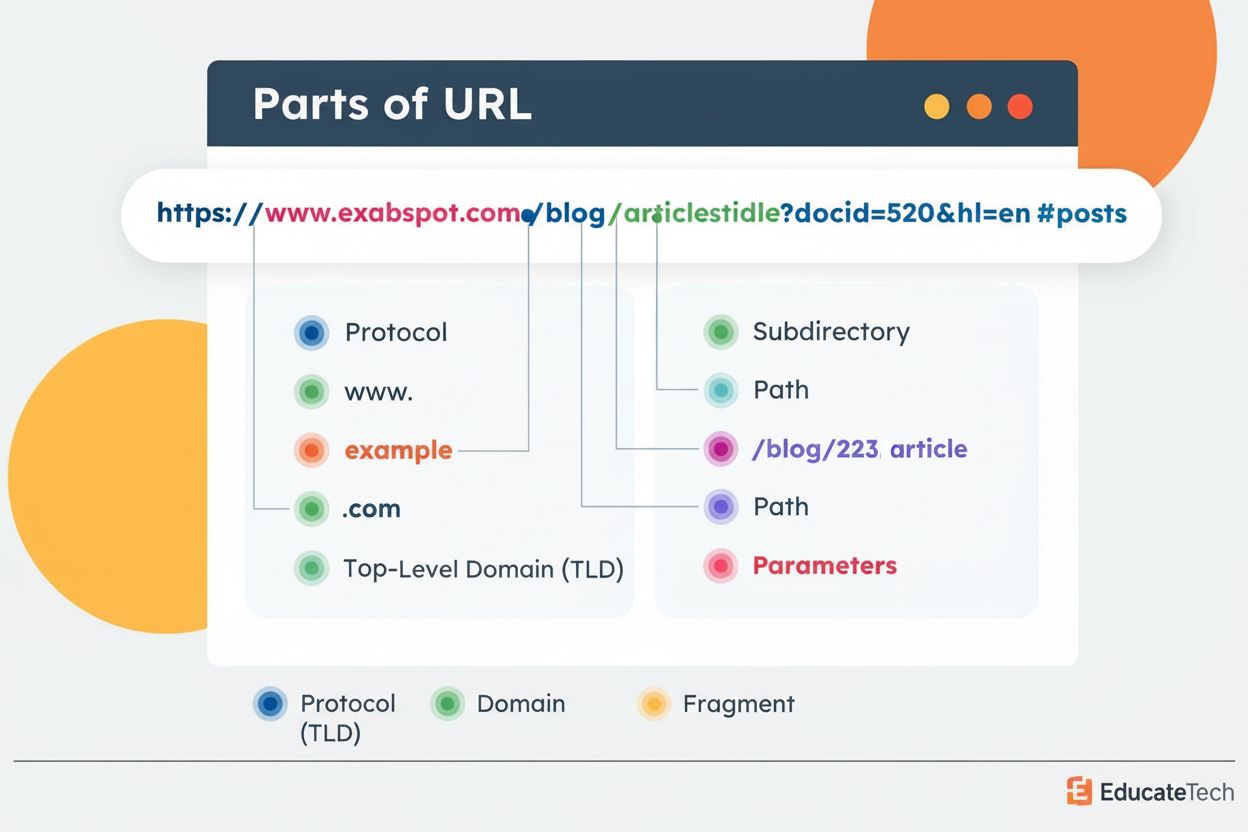

URL-struktur är formatet och organiseringen av webbsidornas adresser inklusive protokoll, domän, sökväg och parametrar. Lär dig hur korrekt URL-struktur påverka...

Felsök AI-crawlproblem med serverloggar, identifiering av användaragenter och tekniska åtgärder. Övervaka ChatGPT, Perplexity, Claude-crawlers och lös åtkomstpr...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.