Påverkar AI-innehållsdetektering sökrankingen? Vad forskningen visar

Lär dig om AI-detektering påverkar SEO-ranking. Forskning visar att Google inte straffar AI-innehåll. Fokusera istället på kvalitet, E-E-A-T och hjälpsamhet....

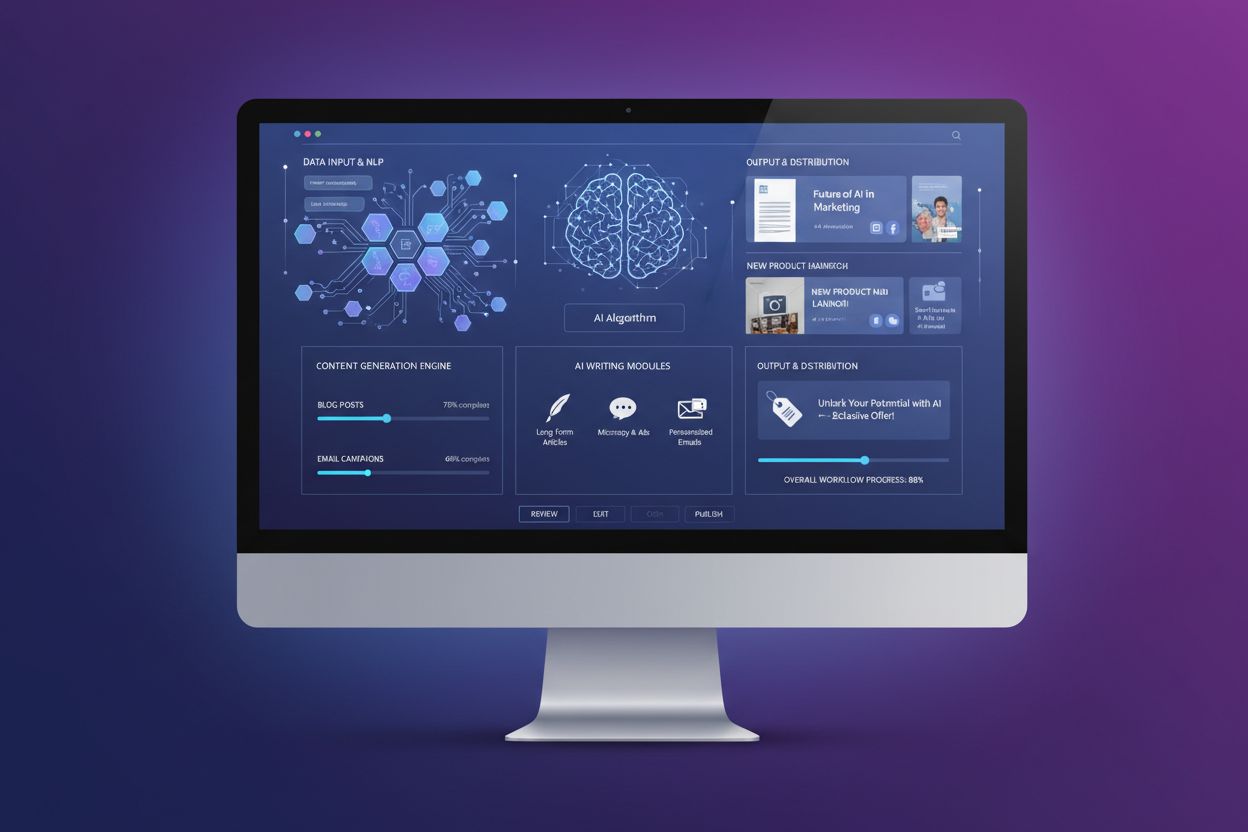

AI-innehållsdetektering avser användningen av specialiserade verktyg och algoritmer som analyserar text, bilder och video för att identifiera om innehållet genererats av artificiella intelligenssystem eller skapats av människor. Dessa detekteringssystem använder maskininlärning, naturlig språkbehandling och statistisk analys för att särskilja AI-genererat material från autentiskt människoskrivet innehåll.

AI-innehållsdetektering avser användningen av specialiserade verktyg och algoritmer som analyserar text, bilder och video för att identifiera om innehållet genererats av artificiella intelligenssystem eller skapats av människor. Dessa detekteringssystem använder maskininlärning, naturlig språkbehandling och statistisk analys för att särskilja AI-genererat material från autentiskt människoskrivet innehåll.

AI-innehållsdetektering är processen att använda specialiserade algoritmer, maskininlärningsmodeller och tekniker för naturlig språkbehandling för att analysera digitalt innehåll och avgöra om det skapats av artificiella intelligenssystem eller av människor. Dessa detekteringsverktyg undersöker språkliga mönster, statistiska egenskaper och semantiska kännetecken i text, bilder och video för att klassificera innehåll som AI-genererat, människoskrivet eller en hybrid av båda. Tekniken har blivit allt viktigare i takt med att generativa AI-system som ChatGPT, Claude, Gemini och Perplexity producerar allt mer sofistikerat innehåll som nära efterliknar mänskligt skrivande. AI-innehållsdetektering används inom flera branscher, däribland utbildning, publicering, rekrytering, innehållsmarknadsföring och varumärkesövervakningsplattformar som behöver verifiera innehållets äkthet och spåra hur varumärken framställs i AI-drivna sök- och svarsplattformar.

Framväxten av avancerade generativa AI-modeller under 2022–2023 skapade ett akut behov av tillförlitliga detekteringsmekanismer. Som forskarna vid Stanford HAI rapporterade använde 78 % av organisationerna AI under 2024, upp från 55 % året innan, vilket genererade enorma volymer AI-genererat innehåll på internet. Till 2026 uppskattar experter att 90 % av allt onlineinnehåll kan vara AI-genererat, vilket gör detekteringsförmåga avgörande för att upprätthålla innehållets integritet och verifiera äkthet. Marknaden för AI-detektorer växer explosionsartat, värderad till 583,6 miljarder USD år 2025 och förväntas öka med en årlig tillväxttakt på 27,9 % till 3 267,5 miljarder USD år 2032. Denna marknadstillväxt speglar den ökade efterfrågan från utbildningsinstitutioner som är oroade för akademisk integritet, utgivare som vill upprätthålla kvalitetsstandarder och företag som kräver verifiering av innehållsautenticitet. Utvecklingen av AI-innehållsdetekteringsverktyg utgör ett avgörande kapprustning mellan detekteringsteknologi och allt mer sofistikerade AI-modeller som utformats för att undgå upptäckt genom mer människoliknande skrivmönster.

AI-innehållsdetektering fungerar genom en sofistikerad kombination av maskininlärning och tekniker för naturlig språkbehandling. Den grundläggande metoden innebär att träna klassificerare—maskininlärningsmodeller som kategoriserar text i fördefinierade kategorier som “AI-skriven” och “människoskriven”. Dessa klassificerare tränas på enorma datamängder med miljontals dokument märkta som antingen AI-genererade eller människoskrivna, vilket gör det möjligt för dem att lära sig de särskiljande mönstren mellan de två kategorierna. Detekteringsprocessen analyserar flera språkliga egenskaper, inklusive ordfrekvens, meningslängd, grammatisk komplexitet och semantisk sammanhang. Embeddings spelar en avgörande roll genom att omvandla ord och fraser till numeriska vektorer som fångar betydelse, kontext och relationer mellan begrepp. Denna matematiska representation gör det möjligt för AI-system att förstå semantiska relationer—till exempel att känna igen att “kung” och “drottning” delar konceptuell närhet trots att de är olika ord.

Två nyckelmått som AI-innehållsdetekteringsverktyg mäter är perplexitet och burstiness. Perplexitet fungerar som en “överraskningsmätare” som bedömer hur förutsägbar texten är; AI-genererat innehåll uppvisar vanligtvis låg perplexitet eftersom språkmodeller tränas för att producera statistiskt sannolika ordföljder, vilket resulterar i förutsägbara och enhetliga skrivmönster. Människoskrivet material innehåller däremot fler oväntade ordval och kreativa uttryck, vilket ger högre perplexitetspoäng. Burstiness mäter variationen i meningslängd och strukturell komplexitet i ett dokument. Mänskliga skribenter växlar naturligt mellan korta, slagkraftiga meningar och längre, mer komplexa konstruktioner, vilket skapar hög burstiness. AI-system, begränsade av sina prediktiva algoritmer, tenderar att generera mer enhetliga meningsstrukturer med lägre burstiness. Ledande detekteringsplattformar som GPTZero har utvecklats bortom dessa två mått och använder flerskiktade system med sju eller fler komponenter för att avgöra AI-sannolikhet, inklusive klassificering på meningsnivå, verifiering mot internetsökningar och skydd mot tekniker för att kringgå detektering.

| Detekteringsmetod | Hur det fungerar | Styrkor | Begränsningar |

|---|---|---|---|

| Perplexitets- och burstinessanalys | Mäter förutsägbarhet och variationsmönster i meningar | Snabb, beräkningsmässigt effektiv, grundläggande tillvägagångssätt | Kan ge falska positiva vid formellt skrivande; begränsad noggrannhet på korta texter |

| Maskininlärningsklassificerare | Tränad på märkta datamängder för att kategorisera AI- vs. människotext | Mycket noggrann på träningsdata, anpassningsbar till nya modeller | Kräver kontinuerlig omträning; har svårt med nya AI-arkitekturer |

| Embeddings & semantisk analys | Omvandlar text till numeriska vektorer för att analysera betydelse och relationer | Fångar nyanserade semantiska mönster, förstår kontext | Beräkningsintensiv; kräver stora träningsdatamängder |

| Vattenmärkning | Bäddar in dolda signaler i AI-genererad text vid skapandet | Teoretiskt idiotsäker om den implementeras vid generering | Lätt att ta bort genom redigering; ingen industristandard; kräver samarbetande AI-modell |

| Multimodal detektering | Analyserar text, bild och video samtidigt för AI-signaturer | Omfattande täckning av olika innehållstyper | Komplex implementering; kräver specialträning för varje modalitet |

| Internetsökning | Jämför innehåll mot databaser med kända AI-utdata och internetarkiv | Identifierar plagierat eller återanvänt AI-innehåll | Begränsad till tidigare indexerat innehåll; missar nya AI-genereringar |

Den tekniska grunden för AI-innehållsdetektering bygger på djupinlärningsarkitekturer som bearbetar text genom flera analyslager. Moderna detekteringssystem använder transformerbaserade neurala nätverk liknande de som används i generativa AI-modeller, vilket gör det möjligt att förstå komplexa språkmönster och kontextuella relationer. Detekteringskedjan börjar vanligtvis med textförbehandling, där innehållet tokeniseras till individuella ord eller delord. Dessa tokens omvandlas sedan till embeddings—täta numeriska representationer som fångar semantisk betydelse. Embeddings passerar genom flera neurala nätverkslager som extraherar allt mer abstrakta egenskaper, från enkla ordbaserade mönster till komplexa dokumentegenskaper. Ett slutligt klassificeringslager ger en sannolikhetspoäng för om innehållet är AI-genererat. Avancerade system som GPTZero implementerar klassificering på meningsnivå, där varje mening analyseras för att identifiera vilka delar av ett dokument som uppvisar AI-kännetecken. Detta detaljerade angreppssätt ger användaren återkoppling om vilka specifika avsnitt som flaggas som potentiellt AI-genererade, snarare än en enkel binär klassificering av hela dokumentet.

Utmaningen att upprätthålla detekteringsnoggrannhet när AI-modeller utvecklas har lett till utvecklingen av dynamiska detekteringsmodeller som kan anpassa sig i realtid till nya AI-system. Istället för att lita på statiska riktmärken som snabbt blir inaktuella, inkorporerar dessa system kontinuerligt utdata från de senaste AI-modellerna—inklusive GPT-4o, Claude 3, Gemini 1.5 och framväxande system—i sina träningsflöden. Detta tillvägagångssätt ligger i linje med nya transparensriktlinjer från OECD och UNESCO för ansvarsfull AI-utveckling. De mest sofistikerade detekteringsplattformarna underhåller 1 300+ lärarambassadörsnätverk och samarbetar med utbildningsinstitutioner för att förfina algoritmer i verkliga miljöer, vilket säkerställer att verktygen är effektiva i takt med att både AI-generering och detektering utvecklas.

AI-innehållsdetekteringsverktyg har uppnått imponerande noggrannhet i kontrollerade testmiljöer. Ledande plattformar rapporterar 99 % noggrannhet och falska positiva på så lågt som 1 %, vilket innebär att de korrekt identifierar AI-genererat innehåll och samtidigt minimerar risken att felaktigt flagga människoskrivet material. Oberoende tredjepartsjämförelser som RAID-datamängden—som omfattar 672 000 texter från 11 domäner, 12 språkmodeller och 12 attacker—har bekräftat dessa resultat, där toppdetektorer når 95,7 % noggrannhet för att identifiera AI-skriven text och endast 1 % av människoskriven text felklassificeras. Dock finns viktiga förbehåll. Ingen AI-detektor är 100 % korrekt, och den faktiska prestandan i verkliga miljöer skiljer sig ofta från testmiljöer. Tillförlitligheten varierar beroende på textlängd, innehållsområde, språk och om det AI-genererade materialet har redigerats eller omformulerats.

Korta texter utgör en särskild utmaning för AI-innehållsdetektering eftersom de ger färre språkliga mönster att analysera. En enstaka mening eller ett kort stycke kanske inte innehåller tillräckligt med kännetecken för att pålitligt särskilja AI från människa. Forskning har visat att omformulering av AI-genererat innehåll med verktyg som GPT-3.5 kan minska detekteringsnoggrannheten med 54,83 %, vilket visar att redigerat eller förfinat AI-material blir betydligt svårare att identifiera. Flerspråkigt innehåll och text från icke-inhemska engelsktalande utgör ytterligare en betydande begränsning, eftersom de flesta detekteringsverktyg främst tränats på engelska datamängder. Detta kan leda till partiskhet mot icke-inhemska skribenter, vars skrivmönster kan avvika från inhemska konventioner och utlösa falska positiva. Dessutom blir det allt svårare att särskilja i takt med att AI-modeller tränas på allt mer varierad och högkvalitativ människotext, och de språkliga skillnaderna mellan AI och människa minskar.

AI-innehållsdetektering har blivit avgörande inom många sektorer och användningsområden. Inom utbildning använder institutioner detekteringsverktyg för att upprätthålla akademisk integritet genom att identifiera elevarbeten som kan ha genererats eller kraftigt assisterats av AI-system. En undersökning från Pew Research visade att 26 % av amerikanska tonåringar använde ChatGPT för skolarbete 2024, dubbelt så många som året innan, vilket gör detekteringsförmåga avgörande för lärare. Publicister och medieorganisationer använder detekteringsverktyg för att säkerställa redaktionell kvalitet och följa Googles 2025 Search Quality Rater Guidelines, som kräver transparens om AI-genererat material. Rekryterare använder detektering för att verifiera att ansökningshandlingar och personliga brev verkligen är skrivna av kandidaten och inte av AI. Innehållsskapare och copywriters granskar sitt arbete med detekteringsverktyg innan publicering för att undvika att flaggas av sökmotorer eller algoritmer, och för att säkerställa att deras innehåll känns igen som människoskrivet och originellt.

För varumärkesövervakning och AI-spårningsplattformar som AmICited fyller AI-innehållsdetektering en specialiserad men avgörande funktion. Dessa plattformar övervakar hur varumärken framställs i svar från ChatGPT, Perplexity, Google AI Overviews och Claude, och spårar omnämnanden över AI-system. Detekteringsfunktioner hjälper till att verifiera om varumärkesreferenser är autentiskt människoskrivna eller AI-syntetiserade, vilket säkerställer korrekt varumärkesövervakning. Forensiska analytiker och juridiska experter använder detekteringsverktyg för att verifiera ursprunget till omtvistade dokument i undersökningar och rättsfall. AI-forskare och utvecklare använder detekteringssystem för att studera hur detektering fungerar och för att träna framtida AI-modeller mer ansvarsfullt, genom att förstå vad som gör skrivande detekterbart och därigenom utforma system som främjar transparens och etisk AI-utveckling.

AI-innehållsdetekteringssystem identifierar flera kännetecknande mönster som utmärker AI-genererat skrivande. Upprepning och redundans förekommer ofta i AI-text, där samma ord, fraser eller idéer återupprepas på olika sätt. Överdrivet artigt och formellt språk är vanligt eftersom generativa AI-system utformats som “vänliga assistenter” och standardmässigt använder formella, hövliga formuleringar om de inte instrueras att göra annat. AI-genererat innehåll saknar ofta samtalston och naturliga idiom som utmärker autentisk mänsklig kommunikation. Osäkert språk förekommer ofta, där AI tenderar att använda passiva konstruktioner och försiktiga uttryck som “Det är viktigt att notera att”, “Vissa menar att” eller “X betraktas ofta som” istället för att göra djärva påståenden. Inkonsistens i röst och ton kan uppstå när AI försöker efterlikna en författares stil utan tillräcklig kontext eller träningsdata. Underanvändning av stilistiska element som metaforer, liknelser och analogier är typiskt för AI-skrivande, som tenderar att vara bokstavligt och förutsägbart. Logiska eller faktamässiga fel och “hallucinationer”—där AI genererar trovärdigt men felaktigt innehåll—kan signalera AI-ursprung, även om även människor kan göra misstag.

En viktig skillnad finns mellan AI-innehållsdetektering och plagiatkontroll, även om båda tjänar syftet att säkerställa innehållets integritet. AI-innehållsdetektering fokuserar på att avgöra hur innehållet skapats—specifikt om det genererats av artificiell intelligens eller av en människa. Analysen granskar textens struktur, ordval, språkliga mönster och övergripande stil för att avgöra om den liknar AI-genererade eller människoskrivna exempel. Plagiatkontroller å andra sidan fokuserar på att avgöra varifrån innehållet kommer—om texten har kopierats från befintliga källor utan korrekt hänvisning. Plagiatdetektering jämför inskickat innehåll mot stora databaser av publicerade verk, akademiska uppsatser, webbplatser och andra källor för att identifiera matchande eller liknande avsnitt. International Center for Academic Integritys riktlinjer 2024 rekommenderar att båda verktyg används tillsammans för fullständig verifiering av innehåll. En text kan vara helt människoskriven men plagierad från en annan källa, eller AI-genererad och originell. Inget verktyg ger ensam fullständig information om autenticitet och originalitet; tillsammans ger de en mer heltäckande bild av hur innehåll har skapats och om det representerar eget arbete.

Landskapet för AI-innehållsdetektering utvecklas snabbt i takt med att både detekterings- och kringgåendetekniker förfinas. Vattenmärkning—att bädda in dolda signaler i AI-genererad text under skapandet—är fortfarande teoretiskt lovande men har betydande praktiska utmaningar. Vattenmärken kan avlägsnas genom redigering, omformulering eller översättning och kräver samarbete från AI-utvecklare för att implementeras vid skapandet. Varken OpenAI eller Anthropic har infört vattenmärkning som standard, vilket begränsar dess användbarhet i praktiken. Framtiden för detektering ligger sannolikt i multimodala system som analyserar text, bild och video samtidigt, då AI-generering alltmer spänner över flera innehållstyper. Forskare utvecklar dynamiska detekteringsmodeller som anpassar sig i realtid till nya AI-arkitekturer istället för att lita på statiska riktmärken som snabbt blir föråldrade. Dessa system kommer att införliva kontinuerligt lärande från de senaste AI-modellernas utdata så att detekteringsförmågan håller jämna steg med generativ AI-utveckling.

Den mest lovande vägen är att bygga in transparens och attribuering i AI-systemen från början, istället för att enbart lita på efterhandsdetektering. Detta skulle innebära att metadata, ursprungsinformation och tydlig märkning av AI-genererat innehåll läggs till vid skapandet, så att detektering blir överflödig. Tills sådana standarder blir universella kommer dock AI-innehållsdetekteringsverktyg att vara avgörande för att upprätthålla innehållets integritet inom utbildning, publicering, rekrytering och varumärkesövervakning. Konvergensen mellan detekteringsteknik och varumärkesövervakningsplattformar som AmICited utgör en ny gräns, där detekteringsfunktioner möjliggör exakt spårning av hur varumärken syns i AI-genererade svar på flera plattformar. När AI-system blir allt vanligare i sök, innehållsgenerering och informationsdistribution, blir förmågan att pålitligt upptäcka och övervaka AI-genererat innehåll allt viktigare för organisationer som vill förstå sin närvaro i AI-drivna informationslandskap.

Effektiv användning av AI-innehållsdetektering kräver förståelse för både möjligheter och begränsningar hos dessa verktyg. Organisationer bör erkänna begränsningarna hos enskilda detektorer och se detekteringsresultat som en del av bevisningen snarare än slutgiltigt bevis. Korskontroll med flera verktyg ger en mer tillförlitlig bild, eftersom olika detekteringssystem kan ge varierande resultat beroende på deras träningsdata och algoritmer. Att lära sig känna igen AI-skrivmönster manuellt—förstå perplexitet, burstiness, upprepning och andra kännetecken—gör det lättare att tolka resultaten. Att beakta sammanhang och syfte är avgörande; ett flaggat resultat bör leda till närmare granskning av stil, författarröst och syfte. Transparens om detektering i akademiska och professionella miljöer bygger förtroende och förebygger överberoende av automatisering. Att använda AI-detektering som del av en bredare originalitetskontroll som inkluderar plagiatkontroller, källhänvisningar och kritisk mänsklig granskning ger den mest heltäckande bedömningen av innehållets äkthet. Ett ansvarsfullt förhållningssätt ser detekteringsverktyg som värdefulla assistenter som kompletterar mänsklig bedömning snarare än ersätter den, särskilt i situationer där falska positiva eller negativa kan få allvarliga konsekvenser för individer eller organisationer.

+++

AI-innehållsdetekteringsverktyg varierar i noggrannhet, där ledande detektorer som GPTZero rapporterar 99 % noggrannhet och så låga falska positiva resultat som 1 %. Dock är ingen detektor 100 % perfekt. Noggrannheten beror på textlängd, AI-modellens sofistikering och om innehållet har redigerats eller omformulerats. Kortare texter och kraftigt modifierat innehåll är svårare att pålitligt upptäcka.

Perplexitet mäter hur förutsägbar text är—AI-genererat innehåll har vanligtvis låg perplexitet eftersom det följer förutsägbara mönster. Burstiness mäter variationen i meningslängd och struktur; mänskligt skrivande har högre burstiness med varierad meningskomplexitet, medan AI tenderar mot enhetliga meningsstrukturer. Tillsammans hjälper dessa mått detektorer att skilja mellan mänskligt och AI-skrivet material.

Ja, moderna AI-detekteringsverktyg är tränade för att identifiera utdata från stora AI-system, inklusive ChatGPT, GPT-4, Claude, Gemini och Perplexity. Dock blir det svårare att upptäcka eftersom AI-modeller utvecklas och producerar allt mer människolik text. Detekteringsverktyg måste kontinuerligt uppdatera sin träningsdata för att hålla jämna steg med nya modellsläpp.

Ett falskt positivt inträffar när människoskrivet innehåll felaktigt flaggas som AI-genererat, medan ett falskt negativt inträffar när AI-genererat innehåll felaktigt klassificeras som människoskrivet. Studier visar att AI-detektorer kan ge båda typerna av fel, särskilt med korta texter, icke-inhemsk engelska eller kraftigt redigerat innehåll. Därför är mänsklig granskning fortsatt viktig.

AI-detekteringsverktyg använder maskininlärningsklassificerare tränade på stora datamängder av både AI- och människoskriven text. De analyserar språkliga egenskaper via naturlig språkbehandling, skapar numeriska inbäddningar av ord för att förstå semantiska relationer och utvärderar mått som perplexitet och burstiness. Klassificeraren jämför sedan ny text mot inlärda mönster för att förutsäga om den är AI- eller människoskapad.

För plattformar som AmICited som spårar varumärkesomnämnanden i AI-system, hjälper innehållsdetektering till att verifiera om citat och referenser är autentiskt människoskrivet innehåll eller AI-syntetiserat material. Detta är avgörande för att förstå hur varumärken framställs i AI-svar i ChatGPT, Perplexity, Google AI Overviews och Claude, och säkerställer korrekt varumärkesövervakning.

AI-detekteringsverktyg har svårt med korta texter, flerspråkigt innehåll och kraftigt omformulerat material. De kan vara partiska mot icke-inhemska engelsktalande och kan ge höga falska positiva i vissa sammanhang. Dessutom blir det allt svårare att upptäcka i takt med att AI-modeller blir mer sofistikerade. Inget enskilt verktyg bör användas som ensam auktoritet för att avgöra innehållets äkthet.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig om AI-detektering påverkar SEO-ranking. Forskning visar att Google inte straffar AI-innehåll. Fokusera istället på kvalitet, E-E-A-T och hjälpsamhet....

Lär dig vad en AI-innehållsgranskning är, hur den skiljer sig från traditionella innehållsgranskningar och varför det är avgörande för din digitala strategi att...

Lär dig vad AI-innehållsgenerering är, hur det fungerar, dess fördelar och utmaningar, samt bästa praxis för att använda AI-verktyg för att skapa marknadsföring...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.