Konversationsspråk: Att matcha hur användare ställer frågor till AI

Lär dig hur konversationsspråk formar AI-interaktioner. Bemästra optimering av naturligt språk för ChatGPT, Perplexity och Google AI Overviews för att få ditt i...

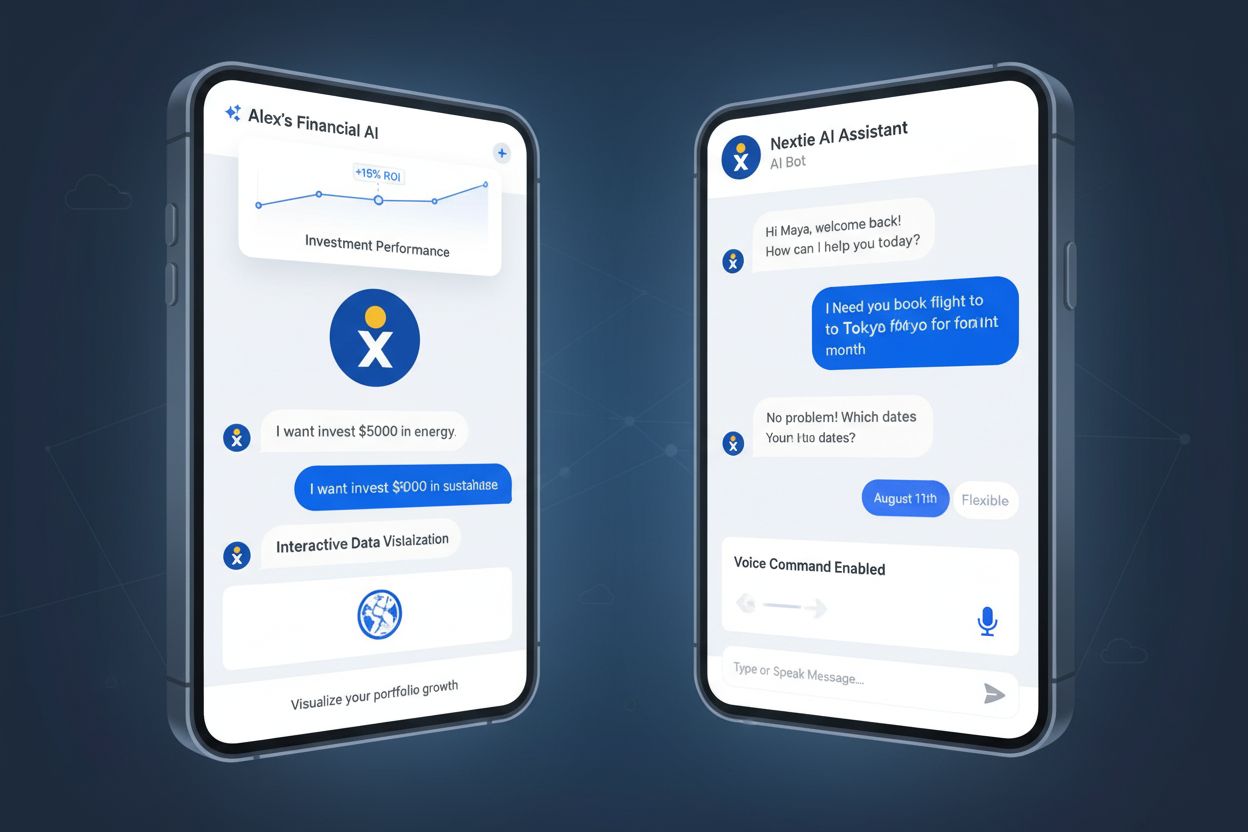

Konverserande AI avser AI-system som är utformade för naturliga dialoginteraktioner och använder naturlig språkbehandling och maskininlärning för att förstå, tolka och besvara mänskligt språk i både text- och röstformat. Dessa teknologier möjliggör att datorer kan delta i mänskliga samtal med användare via chattbottar, virtuella assistenter och röststyrda system.

Konverserande AI avser AI-system som är utformade för naturliga dialoginteraktioner och använder naturlig språkbehandling och maskininlärning för att förstå, tolka och besvara mänskligt språk i både text- och röstformat. Dessa teknologier möjliggör att datorer kan delta i mänskliga samtal med användare via chattbottar, virtuella assistenter och röststyrda system.

Konverserande AI är en samling artificiella intelligens-teknologier som samverkar för att möjliggöra att datorer kan förstå, bearbeta och besvara mänskligt språk i naturlig, mänsklig dialog. Till skillnad från traditionella mjukvarugränssnitt som kräver att användare följer specifika kommandon eller navigerar genom komplexa menyer, låter konverserande AI-system användare kommunicera via naturligt språk—både talat och skrivet—vilket gör teknologin mer tillgänglig och intuitiv. Dessa system kombinerar naturlig språkbehandling (NLP), maskininlärning (ML) och dialoghantering för att simulera meningsfulla samtal mellan människa och maskin. Teknologin driver allt från kundtjänst-chattbottar på webbplatser till röstassistenter som Alexa och Siri, och förändrar i grunden hur människor interagerar med teknik i vardagen.

Konverserande AI fungerar genom integrationen av flera sammanlänkade teknologier som samverkar för att bearbeta och besvara mänskligt språk. Naturlig språkbehandling (NLP) utgör grunden och möjliggör för systemen att analysera och förstå strukturen i mänskligt språk, inklusive grammatik, syntax och semantisk mening. Naturlig språkförståelse (NLU), en delmängd av NLP, går djupare genom att avgöra användarens avsikt och extrahera relevant information från deras inmatning. Maskininlärnings-algoritmer (ML) förbättrar kontinuerligt systemets prestanda genom att lära sig från stora mängder träningsdata och användarinteraktioner, identifiera mönster som hjälper systemet att göra bättre förutsägelser och generera mer lämpliga svar. Dialoghantering styr samtalsflödet, beslutar när det ska ställas förtydligande frågor, när information ska ges och när det är dags att eskalera till en mänsklig agent. Slutligen formulerar naturlig språkgenerering (NLG) svar som låter naturliga och grammatiskt korrekta, så att systemets svar upplevs som mänskliga snarare än robotlika.

Den globala marknaden för konverserande AI värderades till cirka 12,24 miljarder dollar år 2024 och förväntas växa till 61,69 miljarder dollar till 2032, vilket motsvarar en årlig tillväxttakt som speglar teknikens ökande betydelse över olika branscher. Denna explosiva tillväxt drivs av förbättringar inom stora språkmodeller (LLM), ökad företagsadoption och utökade användningsfall bortom traditionell kundtjänst.

Resan från användarinmatning till AI-svar innebär en sofistikerad flerstegsprocess som sker på millisekunder. När en användare matar in information—antingen genom att skriva eller tala—fångar och bearbetar systemet först denna information. För röstinmatning omvandlar automatisk taligenkänning (ASR) ljudsignaler till text som systemet kan analysera. Därefter analyserar naturlig språkförståelse texten för att avgöra vad användaren vill uppnå, och extraherar både explicit och implicit betydelse från deras ord. Systemet beaktar kontext från tidigare meddelanden i samtalet och använder sitt minne av interaktionshistoriken för att förstå referenser och upprätthålla kontinuitet. Dialoghantering bestämmer därefter hur man ska svara utifrån förstådd avsikt, och konsulterar externa databaser som CRM-system för att personanpassa svaret med relevant användarinformation. Naturlig språkgenerering formulerar ett lämpligt svar på naturligt språk, så att det blir grammatiskt korrekt och kontextuellt relevant. Slutligen levererar systemet svaret—antingen som text på skärmen eller som syntetiskt tal via Text-till-Tal (TTS)-teknik som omvandlar text till mänskligt ljud.

Hela denna process visar varför konverserande AI utgör ett så betydande framsteg jämfört med tidigare chattbot-teknologier. Traditionella regelbaserade chattbottar förlitade sig på nyckelordsigenkänning och fördefinierade svarsträd, vilket gjorde dem oflexibla och oförmögna att hantera variationer i hur användare ställde frågor. Konverserande AI-system kan förstå avsikt även när användare använder olika vokabulär, slanguttryck eller oväntade frågeformuleringar, vilket gör interaktionerna mer naturliga och minskar användarfrustrationen.

| Teknologi | Hur det fungerar | Flexibilitet | Inlärningsförmåga | Bästa användningsområden |

|---|---|---|---|---|

| Regelbaserade chattbottar | Följer fördefinierade skript och nyckelordsigenkänning | Mycket rigid; begränsad till programmerade svar | Ingen inlärning; statiska svar | Enkla FAQ, grundläggande kundfrågor |

| Konverserande AI | Använder NLP och maskininlärning för att förstå avsikt | Mycket flexibel; anpassar sig till varierande formuleringar | Kontinuerlig förbättring via ML | Komplex kundservice, personliga interaktioner |

| Generativ AI | Skapar nytt, originellt innehåll baserat på mönster | Extremt flexibel; genererar nya svar | Lär sig från massiva datamängder | Innehållsskapande, kodgenerering, kreativt skrivande |

| Virtuella assistenter | Kombinerar konverserande AI med automatisering av uppgifter | Flexibel; kan utföra handlingar utöver konversation | Lär sig användarpreferenser och mönster | Smarta hem, bokningar, informationssökning |

| Röstigenkänningssystem | Omvandlar tal till text; fokuserar på ljudbearbetning | Begränsad till tal-till-text | Förbättras med akustisk modellträning | Transkribering, röstkommandon, tillgänglighetsverktyg |

Arkitekturen för moderna konverserande AI-system bygger på transformatorbaserade neurala nätverk, särskilt stora språkmodeller (LLM) såsom GPT-3, GPT-4, Claude och andra. Dessa modeller innehåller miljarder parametrar tränade på enorma mängder textdata från internet, vilket gör att de kan förstå komplexa språkmönster och generera sammanhängande, kontextuellt passande svar. Uppmärksamhetsmekanismen i transformatorer gör att modellen kan fokusera på de mest relevanta delarna av inmatningen vid svarsgenerering, på liknande sätt som människor uppmärksammar nyckelinformation i ett samtal. Multi-head attention gör det möjligt för modellen att samtidigt beakta olika aspekter av inmatningen och fånga upp olika relationer mellan ord och begrepp.

Maskininlärning förbättrar kontinuerligt konverserande AI:s prestanda via flera mekanismer. Övervakad inlärning använder märkt träningsdata där mänskliga experter har annoterat korrekta svar, vilket hjälper modellen att lära sig lämpligt beteende. Förstärkningsinlärning med mänsklig feedback (RLHF) innebär att mänskliga utvärderare betygsätter modellens resultat, vilket styr modellen mot att generera mer önskvärda svar. Transfer learning gör det möjligt för modeller förtränade på generella språkuppgifter att finjusteras för specifika domäner, så att organisationer kan anpassa konverserande AI till sin bransch eller användningsområde. Denna kombination av avancerade neurala arkitekturer och sofistikerade inlärningstekniker förklarar varför modern konverserande AI kan hantera nyanserat språk, bibehålla kontext i långa samtal och generera svar som känns anmärkningsvärt mänskliga.

Konverserande AI har blivit avgörande i nästan alla branscher och förändrar hur organisationer interagerar med kunder och hanterar interna processer. Inom kundservice hanterar chattbottar rutinfrågor dygnet runt, minskar väntetider och ökar kundnöjdheten. Enligt färska data anser 90 % av konsumenterna att ett omedelbart svar är viktigt eller mycket viktigt, och 51 % av konsumenterna föredrar faktiskt att interagera med en bot för omedelbar service. Inom bank- och finanssektorn, som står för 23 % av marknadsandelen för konverserande AI, hanterar systemen bedrägerivarningar, saldoförfrågningar och transaktioner. Hälso- och sjukvården ser snabb adoption, med förväntad tillväxt på 33,72 % mellan 2024 och 2028, främst för patientintroduktion, symtomkontroll och tidsbokning.

HR-avdelningar använder konverserande AI för onboarding av anställda, förmånsfrågor och policyrelaterade frågor, vilket minskar HR-teamets arbetsbörda. E-handelsplattformar implementerar konverserande AI för att guida kunder genom köpresan, besvara produktfrågor och ge personliga rekommendationer. Telekombolag använder konverserande AI för fakturafrågor och teknisk support. Myndigheter utnyttjar teknologin för medborgartjänster och informationsspridning. Konverserande AI:s mångsidighet beror på dess förmåga att tränas på domänspecifik data, så den kan förstå branschterminologi och ge korrekta, kontextuella svar oavsett sektor.

Organisationer som implementerar konverserande AI upplever mätbara förbättringar på flera områden. Kostnadseffektivitet är den mest omedelbara fördelen—konverserande AI hanterar stora volymer repetitiva frågor utan mänsklig inblandning och minskar därmed driftskostnaderna avsevärt. En studie från National Bureau of Economic Research visade att supportagenter som använder generativa AI-assistenter ökade sin produktivitet med i genomsnitt 14 %, med särskilt stora förbättringar för mindre erfarna medarbetare. Skalbarheten förbättras dramatiskt, eftersom tillägg av AI-kapacitet är billigare och snabbare än att anställa och utbilda nya medarbetare. Kundnöjdheten ökar tack vare tillgänglighet dygnet runt och omedelbara svarstider, och 2,5 miljarder kundtjänsttimmar sparades 2023 genom automatisering med chattbottar.

Personaliseringsmöjligheter gör att konverserande AI kan skapa anpassade upplevelser genom att hämta kundhistorik och preferenser via CRM-integration. Datainsikter genereras genom analys av alla kundinteraktioner, så att mönster, sentiment och återkommande problem kan identifieras och användas för produktutveckling och tjänsteförbättringar. Operationell effektivitet förbättras när konverserande AI automatiskt hanterar rutinuppgifter som uppdatering av kundregister, skapande av sammanfattningar och vidarebefordran av komplexa ärenden till rätt mänskliga agenter. Dessa fördelar skapar ett övertygande affärsfall för konverserande AI, vilket förklarar varför 70 % av CX-ledarna anser att chattbottar blir skickliga arkitekter av högst personifierade kundresor.

Trots stora framsteg står konverserande AI inför betydande utmaningar som forskare och praktiker ständigt arbetar med. Förståelse av språknyanser är fortfarande svårt—system har problem med sarkasm, idiom, regionala dialekter och kontextberoende betydelser som människor hanterar utan problem. Hallucination, där systemen genererar trovärdiga men felaktiga uppgifter, utgör risker i branscher som sjukvård och finans. Begränsningar i kontextfönster innebär att systemen bara kan komma ihåg en begränsad mängd samtalshistorik och riskerar därmed att tappa viktig information i långa interaktioner. Bias och rättvisa är ett bekymmer eftersom systemen ärver bias från träningsdata och därmed kan förstärka stereotyper eller diskriminerande beteenden.

Sekretess- och säkerhetsutmaningar uppstår genom behovet av att bearbeta och lagra känslig användarinformation, vilket kräver robust dataskydd och efterlevnad av regler som GDPR. Hantering av tvetydiga frågor är fortfarande svårt—när frågor är otydligt ställda eller saknar kontext kan systemen feltolka avsikten. Begränsad emotionell intelligens innebär att konverserande AI inte kan förstå eller bemöta mänskliga känslor, även om forskningen kring sentimentanalys och emotionell AI går framåt. Första-kontakt-lösningsgraden för konverserande AI-chattbottar ligger normalt mellan 60–80 %, vilket innebär att många interaktioner fortfarande kräver mänsklig eskalering. Dessa utmaningar kräver fortsatt forskning, bättre träningsdata, förbättrade modellarkitekturer och genomtänkta implementationsstrategier som kombinerar AI-förmåga med mänsklig expertis.

Utvecklingen för konverserande AI pekar mot allt mer sofistikerade, kontextmedvetna och emotionellt intelligenta system. Multimodal konverserande AI är på frammarsch, där text, röst, bilder och video kombineras i samma interaktion—användare kan peka kameran på en produkt, ringa in en viss del och fråga “Hur lagar jag detta?” och systemet förstår både visuell och textuell kontext. Emotionell intelligens kommer att förbättras och möjliggöra för systemen att känna igen och bemöta användarens känslor, och anpassa ton och tillvägagångssätt utifrån upptäckt frustration, tillfredsställelse eller förvirring. Proaktiva interaktioner innebär att systemen inte bara svarar på frågor, utan förutser användarens behov och inleder hjälpsamma samtal—till exempel genom att se att någon har problem i kassan och erbjuda hjälp.

Realtidsöversättning kommer att bryta ner språkbarriärer och möjliggöra sömlösa samtal mellan användare som talar olika språk. Autonoma agenter är nästa utvecklingssteg, där konverserande AI-system kan utföra komplexa, flerstegsuppgifter självständigt—om användaren ber om “boka ett flyg till Miami nästa tisdag och hitta ett strandnära hotell för under 200 dollar”, söker systemet automatiskt, jämför alternativ, bokar och uppdaterar kalendern. Integration med företagssystem kommer att fördjupas, så att konverserande AI kan komma åt och ändra information i CRM, ERP och andra affärsapplikationer i realtid. Personaliserad skala når nya nivåer när systemen lär sig individuella preferenser och kommunikationsstilar och anpassar svaren för varje användares unika behov. Dessa möjligheter antyder att konverserande AI blir alltmer centralt i hur människor interagerar med teknik och hittar information.

Lyckad implementering av konverserande AI kräver mer än teknik—it kräver strategisk planering och noggrant genomförande. Organisationer bör börja med ett specifikt, högpåverkande problem istället för att försöka automatisera allt på en gång, med fokus på repetitiva, högvolymuppgifter som tydligt visar på investeringsavkastning. Utforma mänsklig överlämning i första hand, så att eskalering till mänskliga agenter sker sömlöst när AI når sina begränsningar—det finns få saker som frustrerar användare mer än att fastna i en bot-loop. Träna på kvalitativ data som är specifik för din domän, eftersom konverserande AI endast är så intelligent som den data den tränas på—organisationer bör investera i att kurera högkvalitativa träningsdatamängder som speglar deras användningsfall och terminologi.

Övervaka och optimera kontinuerligt med hjälp av samtalsanalys för att identifiera var systemet misslyckas eller förvirrar användare, och använd dessa data för att förbättra prestandan. Integrera med befintliga system som CRM, kunskapsbaser och affärsapplikationer så att konverserande AI kan få åtkomst till nödvändig information och agera på användarens vägnar. Skapa tydlig styrning kring datasekretess, säkerhet och etisk användning, så att du efterlever regler och bygger förtroende hos användarna. Investera i förändringsledning så att medarbetarna förstår hur konverserande AI förändrar deras roller, och positionera teknologin som ett verktyg som förstärker mänskliga förmågor snarare än ersätter dem. Sätt realistiska förväntningar på vad konverserande AI kan och inte kan göra, och kommunicera begränsningarna tydligt till användarna för att undvika besvikelser och frustration.

När konverserande AI-system som ChatGPT, Perplexity, Claude och Google AI Overviews blir primära informationskällor för miljontals användare, har det blivit strategiskt avgörande att förstå hur ditt varumärke, din domän och ditt innehåll framställs i dessa system. Dessa plattformar fungerar i allt större utsträckning som första anhalt för informationssökare och ersätter ofta traditionella sökmotorer för många frågor. När användare ställer frågor relaterade till din bransch eller dina produkter till konverserande AI-system, formar deras svar uppfattningen om ditt varumärke och det konkurrenslandskap du verkar i. Om ditt innehåll inte citeras korrekt eller framställs felaktigt i AI-svar, tappar du synlighet och trovärdighet hos potentiella kunder.

AmICited åtgärdar denna kritiska brist genom att erbjuda omfattande övervakning av hur ditt varumärke framställs över alla större konverserande AI-plattformar. Plattformen spårar omnämnanden, citat och representationer av din domän och ditt innehåll, så att du kan förstå din synlighet i detta nya informations-ekosystem. Denna insikt gör det möjligt för organisationer att optimera innehållsstrategin för konverserande AI, säkerställa korrekt representation, identifiera möjligheter till ökad synlighet och agera på felaktig eller vilseledande information. När konverserande AI fortsätter att förändra hur människor upptäcker och konsumerar information blir övervakning av din närvaro i dessa system lika viktigt som traditionell sökmotoroptimering.

+++

Konverserande AI-system behåller kontext genom mekanismer som lagrar och refererar till tidigare interaktioner inom ett samtal. Stora språkmodeller använder uppmärksamhetsmekanismer och kontextfönster för att minnas användarens inmatningar och tidigare svar, vilket gör att de kan ge sammanhängande uppföljningssvar. Denna kontextmedvetenhet gör att systemet kan förstå referenser till tidigare uttalanden och upprätthålla samtalskontinuitet, vilket gör interaktionerna mer naturliga och personliga.

Regelbaserade chattbottar följer fördefinierade skript och nyckelordsigenkänning för att trigga förprogrammerade svar, vilket gör dem rigida och begränsade i omfång. Konverserande AI-system använder maskininlärning och naturlig språkförståelse för att tolka användarens avsikt, anpassa sig till olika formuleringar och generera kontextuellt lämpliga svar. Denna grundläggande skillnad innebär att konverserande AI kan hantera komplexa frågor och nyanserat språk, medan regelbaserade system har svårt med tvetydighet och variationer i användarens inmatning.

Konverserande AI bygger på fyra kärnkomponenter: Naturlig språkbehandling (NLP) för att förstå text- eller röstinmatning, Naturlig språkförståelse (NLU) för att avgöra användarens avsikt och extrahera mening, Dialoghantering för att avgöra hur man ska svara baserat på kontext, samt Naturlig språkgenerering (NLG) för att skapa mänskliga svar. Dessa komponenter arbetar tillsammans i en kontinuerlig återkopplingsslinga där maskininlärningsalgoritmer förbättrar svarskvaliteten över tid baserat på interaktioner.

Konverserande AI:s noggrannhet varierar beroende på systemets träningsdata, modellens sofistikering och frågans komplexitet. Moderna system drivna av stora språkmodeller når hög noggrannhet för vanliga frågor och enkla önskemål. Utmaningar kvarstår dock med tvetydigt språk, sarkasm, regionala dialekter och kontextberoende frågor. Första-kontakt-lösningsgraden för konverserande AI-chattbottar ligger vanligtvis mellan 60-80 %, och noggrannheten förbättras när systemen finjusteras på domänspecifik data.

Bank- och finanssektorn leder adoptionen med en marknadsandel på 23 % år 2024, och använder konverserande AI för bedrägerivarningar och kontofrågor. Hälso- och sjukvården upplever snabb tillväxt med förväntad adoptionsökning på 33,72 % mellan 2024 och 2028, främst för patientintroduktion och tidsbokning. Kundservice, e-handel, HR och telekommunikation är också stora användare som utnyttjar konverserande AI för att minska driftskostnader och öka kundnöjdheten.

Viktiga utmaningar inkluderar förståelse av nyanserat språk såsom sarkasm och idiom, att upprätthålla datasekretess och säkerhet vid hantering av känslig information samt att säkerställa korrekta svar utan att generera falsk eller vilseledande information. Ytterligare hinder är att hantera tvetydiga frågor, smidiga överlämningar till mänskliga agenter och att motverka potentiella bias som ärvts från träningsdata. Organisationer måste även investera i kvalitativ träningsdata och kontinuerlig modellförbättring för att uppnå pålitlig prestanda.

Konverserande AI är specifikt utformat för att föra dialog, förstå användarens avsikt och behålla kontext genom samtal. Generativ AI skapar nytt, originellt innehåll såsom text, bilder eller kod baserat på mönster från träningsdata. Medan konverserande AI fokuserar på interaktion och förståelse, fokuserar generativ AI på innehållsskapande. Moderna system som ChatGPT kombinerar båda teknologier—de använder konverserande AI för att förstå frågor och generativ AI för att skapa nya, kontextuellt lämpliga svar.

Den globala marknaden för konverserande AI värderades till cirka 12,24 miljarder dollar år 2024 och förväntas nå 61,69 miljarder dollar till 2032, vilket motsvarar en betydande årlig tillväxttakt. Vissa prognoser anger en ännu starkare tillväxt, med uppskattningar på 136,41 miljarder dollar till 2035 och en CAGR på 23,98 %. Denna explosiva tillväxt speglar ökad företagsadoption, förbättrade AI-förmågor och fler användningsområden inom allt från kundservice till sjukvård och finans.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur konversationsspråk formar AI-interaktioner. Bemästra optimering av naturligt språk för ChatGPT, Perplexity och Google AI Overviews för att få ditt i...

Lär dig vad Konverserande SEO är, hur det skiljer sig från traditionell SEO och varför citeringsbaserad synlighet är viktig för AI-system som ChatGPT, Gemini oc...

Konversationella frågor är naturliga språkfrågor som ställs till AI-system som ChatGPT och Perplexity. Lär dig hur de skiljer sig från nyckelordsökningar och på...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.