Edge SEO

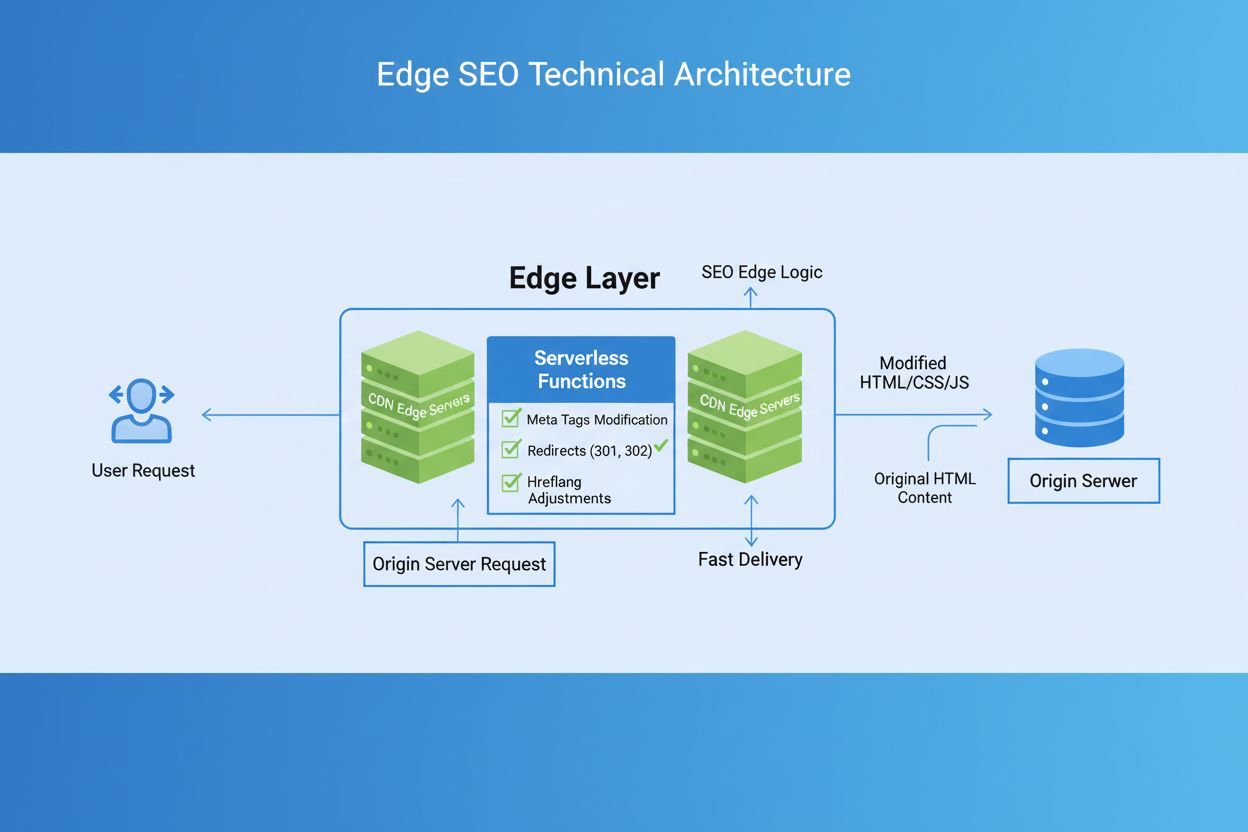

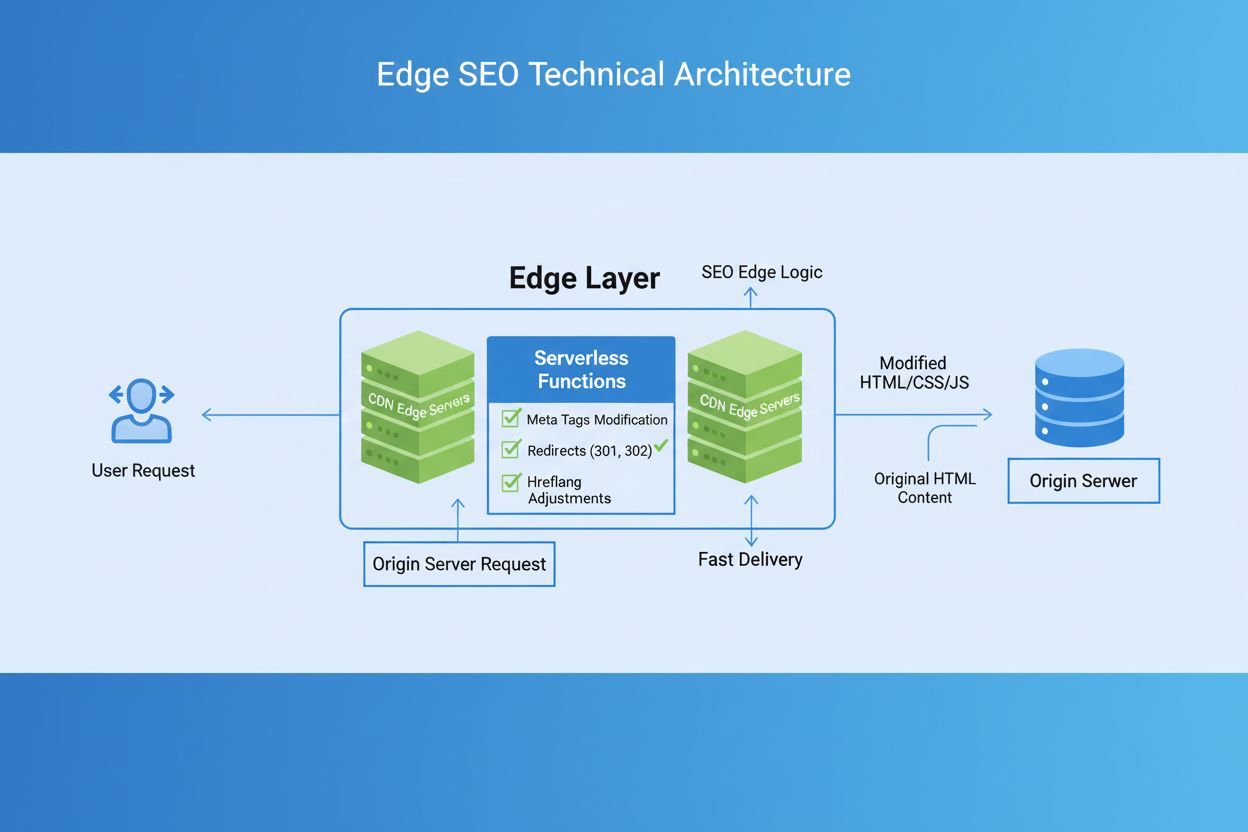

Edge SEO är metoden att implementera tekniska SEO-ändringar på nätverkets edge med hjälp av serverlösa funktioner på CDN:er. Lär dig hur det förbättrar prestand...

Edge AI-bearbetning avser implementering av artificiella intelligens-algoritmer direkt på lokala enheter eller edge-servrar, vilket möjliggör realtidsbearbetning och analys av data utan ständig beroende av molninfrastruktur. Detta tillvägagångssätt minskar latens, förbättrar datasekretess och möjliggör omedelbara beslut för applikationer som varumärkesövervakning, IoT-enheter och autonoma system.

Edge AI-bearbetning avser implementering av artificiella intelligens-algoritmer direkt på lokala enheter eller edge-servrar, vilket möjliggör realtidsbearbetning och analys av data utan ständig beroende av molninfrastruktur. Detta tillvägagångssätt minskar latens, förbättrar datasekretess och möjliggör omedelbara beslut för applikationer som varumärkesövervakning, IoT-enheter och autonoma system.

Edge AI-bearbetning representerar ett paradigmskifte inom implementering av artificiell intelligens, där beräkningsuppgifter utförs direkt på edge-enheter—såsom smartphones, IoT-sensorer, kameror och inbyggda system—istället för att förlita sig uteslutande på centraliserade molnservrar. Detta tillvägagångssätt bearbetar data vid källan, vilket möjliggör omedelbar analys och beslutsfattande utan att sända rå information till avlägsna datacenter. Till skillnad från traditionell cloud AI, som skickar data till fjärrservrar för bearbetning och returnerar resultat efter nätverkslatens, flyttar edge AI intelligensen till nätverkets periferi där datan uppstår. Bearbetningen sker på lokal hårdvara med inbäddade maskininlärningsmodeller, vilket gör att enheter kan arbeta autonomt och fatta beslut i realtid. Edge AI kombinerar lättviktsneurala nätverk, optimerade algoritmer och specialiserade hårdvaruacceleratorer för att leverera AI-kapacitet inom snäva resursbegränsningar. Denna distribuerade intelligensmodell förändrar grundläggande hur organisationer ser på datasekretess, systemrespons och infrastrukturkostnader. Genom att bearbeta känslig information lokalt eliminerar edge AI behovet av att sända potentiellt konfidentiell data över nätverk, och möter växande integritetskrav i reglerade branscher.

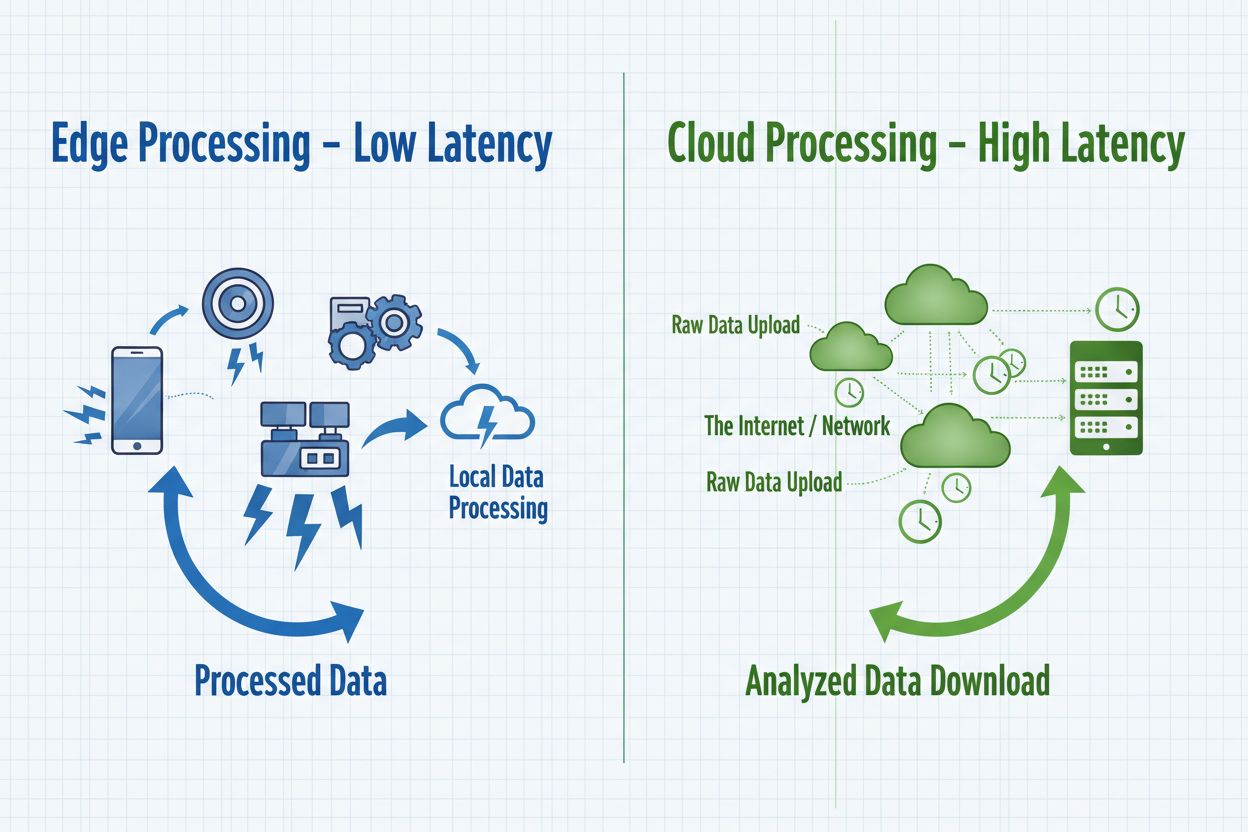

Edge AI och cloud AI representerar kompletterande tillvägagångssätt för implementering av artificiell intelligens, där vardera har tydliga fördelar beroende på användningsområde och organisationskrav. Cloud AI utmärker sig för hantering av massiva datamängder, träning av komplexa modeller och utförande av beräkningsintensiva uppgifter som drar nytta av centraliserad processorkraft och obegränsad skalbarhet. Molnlösningar medför dock inneboende latens när data färdas över nätverk, vilket gör dem olämpliga för applikationer som kräver omedelbara svar. Edge AI prioriterar hastighet och respons genom lokal bearbetning, vilket möjliggör sub-millisekundbeslut avgörande för autonoma system och realtidsövervakning. Valet mellan dessa tillvägagångssätt beror på de specifika kraven: cloud AI passar för batchbearbetning, modellträning och applikationer där mindre fördröjningar är acceptabla, medan edge AI lämpar sig för realtidsapplikationer, integritetskänsliga processer och scenarier med opålitlig nätanslutning. Organisationer implementerar allt oftare hybrida arkitekturer som kombinerar båda paradigmerna—med edge-enheter för omedelbar bearbetning och molninfrastruktur för modellträning, analys och långsiktig datalagring. Förståelse för dessa grundläggande skillnader hjälper organisationer att utforma lösningar som balanserar prestanda, säkerhet och operationell effektivitet.

| Aspekt | Edge AI | Cloud AI |

|---|---|---|

| Latens | Sub-millisekundssvar; omedelbar lokal bearbetning | 50–500 ms+ på grund av nätverkstransmission och serverbearbetning |

| Bandbredd | Minimal datatrafik; bearbetar lokalt | Höga bandbreddskrav; överför rådata kontinuerligt |

| Säkerhet & Sekretess | Data förblir lokal; minskad risk för intrång | Data färdas över nätverk; centraliserad lagring utgör en sårbar punkt |

| Beräkningskraft | Begränsad av enhetens hårdvara; optimerade lättviktsmodeller | Obegränsad skalbarhet; hanterar komplexa modeller och stora datamängder |

| Skalbarhet | Skalar horisontellt över distribuerade enheter | Skalar vertikalt med serverinfrastruktur; centraliserad hantering |

Edge AI-system består av fyra grundläggande tekniska komponenter som samverkar för att leverera intelligent bearbetning vid nätverkets utkant. Inferensmotorn exekverar förtränade maskininlärningsmodeller på edge-enheter, utför prediktioner och klassificeringar utan krav på molnuppkoppling. Dessa motorer använder optimerade ramverk som TensorFlow Lite, ONNX Runtime och PyTorch Mobile, vilka komprimerar modeller för att passa enhetens minnesbegränsningar samtidigt som acceptabel noggrannhet bibehålls. Hårdvaruacceleratorer—inklusive GPU:er, TPU:er och specialiserade AI-chip—ger den processorkraft som krävs för att effektivt köra neurala nätverk på resursbegränsade enheter. Edge-enheter använder modelloptimeringstekniker såsom kvantisering, beskärning (pruning) och kunskapsdestillation för att minska modellstorlek och beräkningskrav utan att prestationen försämras nämnvärt. Datamanagementlagret hanterar lokal datainsamling, förbehandling och selektiv överföring av relevanta insikter till molnsystem för aggregering och långtidsanalys. Slutligen hanterar anslutningsmodulen intermittent nätverkskoppling, vilket möjliggör offline-drift med synkronisering av data när anslutning finns tillgänglig.

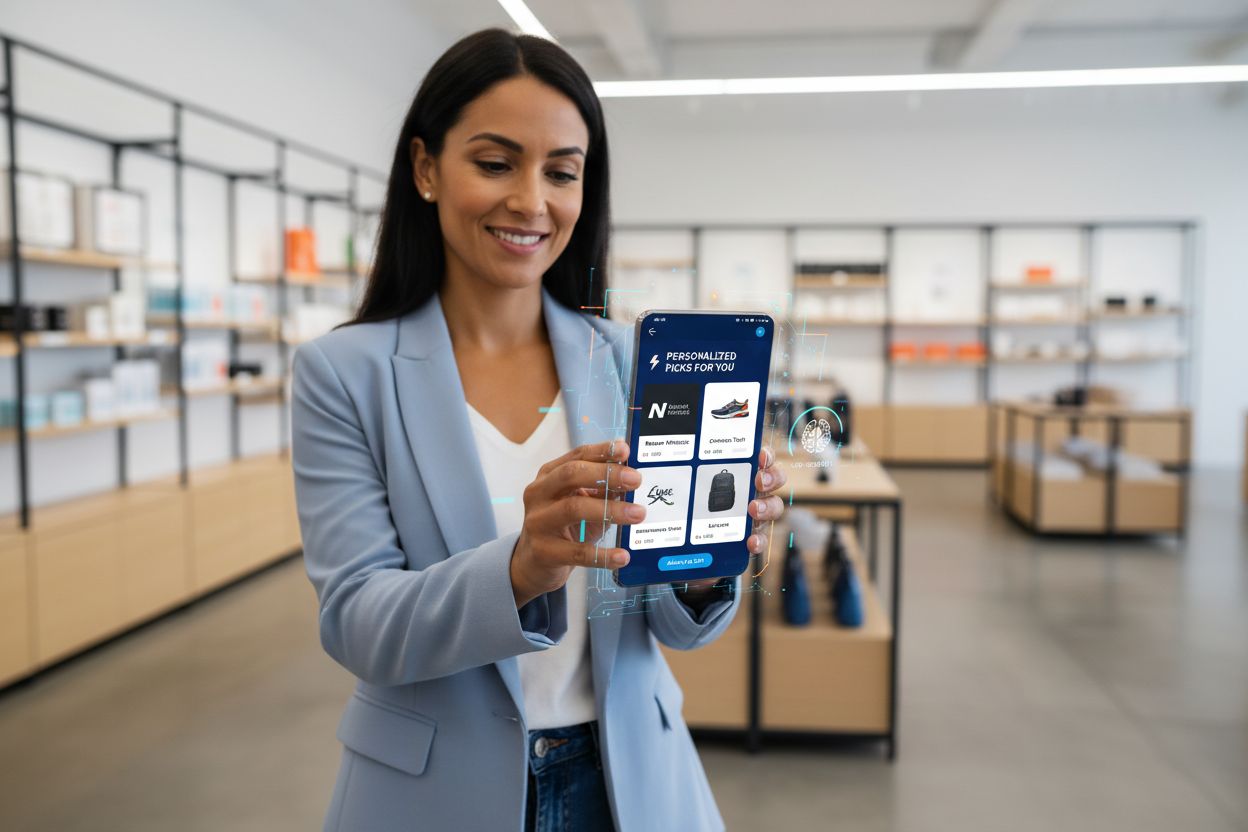

Edge AI-bearbetning möjliggör oöverträffade kapaciteter inom realtidsrekommendationer för varumärken och övervakning av AI-utdata, och stödjer direkt organisationers behov av att spåra och verifiera AI-beslut vid själva utförandet. Detaljhandelsapplikationer använder edge AI för att leverera personliga produktrekommendationer direkt när kunder surfar, analyserar beteendemönster lokalt utan att känsliga köpuppgifter behöver skickas till externa servrar. Realtidsövervakning av AI-utdata blir möjlig när inferens sker på edge-enheter, vilket gör att organisationer omedelbart kan upptäcka avvikelser, partiska prediktioner eller modellförändringar innan rekommendationer når kunder. Denna lokala bearbetning skapar revisionsspår och beslutsloggar som stödjer regelefterlevnad och gör det möjligt för varumärken att förstå exakt varför vissa rekommendationer genererats. Edge AI-övervakningssystem kan flagga misstänkta mönster—som rekommendationer som oproportionerligt gynnar vissa produkter eller demografier—och möjliggör snabb intervention och justering av modeller. För varumärkessäkerhet och reputationshantering säkerställer edge-baserad AI-övervakning att automatiserade system verkar inom definierade ramar och överensstämmer med varumärkets värderingar innan de exponeras för kunder. Förmågan att övervaka AI-utdata i realtid vid källan förändrar hur organisationer upprätthåller kvalitetskontroll över algoritmiska beslut, stödjer transparensinitiativ och bygger kundförtroende genom verifierbar AI-styrning.

Edge AI-bearbetning ger betydande fördelar inom flera områden som adresserar centrala organisatoriska utmaningar i dagens digitala miljöer. Minskad latens är den främsta fördelen och möjliggör applikationer som kräver omedelbara svar—autonoma fordon som gör splitsekundsbeslut, industrirobotar som reagerar på säkerhetsrisker eller medicinteknisk utrustning som upptäcker kritiska patienttillstånd. Förbättrad sekretess är en annan fördel, då känslig data förblir på lokala enheter istället för att skickas över nätverk eller lagras i centraliserade moln, vilket möter GDPR, HIPAA och andra regulatoriska krav. Optimerad bandbreddsanvändning minskar nätverksbelastning och kostnader genom att bearbeta data lokalt och endast överföra relevanta insikter istället för rådata. Offlinedrift gör att edge-enheter kan fortsätta fungera och fatta intelligenta beslut även vid nätverksbortfall, avgörande för avlägsna platser och verksamhetskritiska applikationer. Förbättrad tillförlitlighet är ett resultat av distribuerad bearbetning—systemfel på enskilda edge-enheter påverkar inte hela infrastrukturen, och lokal bearbetning fortsätter oavsett molntillgänglighet. Kostnadseffektivitet uppstår genom minskade molntjänstkostnader, eftersom organisationer bearbetar data lokalt istället för att betala för kontinuerlig molninfrastruktur och datatrafik. Skalbarhetsfördelar visar sig annorlunda än i molnsystem; edge AI skalar horisontellt över distribuerade enheter utan att kräva centraliserad infrastrukturutbyggnad, vilket gör det idealiskt för IoT-implementationer med tusentals enheter.

Edge AI-bearbetning förändrar verksamheten i en rad olika branscher genom att möjliggöra intelligenta beslut där datan genereras. Tillverkningsanläggningar använder edge AI för prediktivt underhåll, analyserar utrustningsvibrationer och termiska mönster lokalt för att förutsäga fel innan de inträffar, vilket minskar stillestånd och underhållskostnader. Vårdgivare använder edge AI i medicinska bildbehandlingsenheter som utför preliminär analys lokalt, vilket möjliggör snabbare diagnoser samtidigt som patientsekretess skyddas genom att känsliga medicinska data stannar på plats. Detaljhandelsmiljöer implementerar edge AI för lagerhantering, analys av kundbeteende och personliga rekommendationer levererade direkt utan molnlatens. Autonoma fordon är helt beroende av edge AI, bearbetar sensordata från kameror, lidar och radar lokalt för att fatta realtidsbeslut om navigation och säkerhet inom millisekunder. Smarta hem-system använder edge AI för att känna igen röstkommandon, upptäcka säkerhetshot och automatisera rutiner utan att ljud- eller videoinspelningar skickas till molnservrar. Säkerhets- och övervakningsapplikationer använder edge AI för att upptäcka avvikelser, identifiera hot och utlösa larm lokalt, vilket minskar falsklarm genom intelligent filtrering innan larm skickas till övervakningscentraler. Jordbruksverksamheter använder edge AI på IoT-sensorer för att övervaka jordförhållanden, vädermönster och grödhälsa, fatta beslut om bevattning och gödsling lokalt och samtidigt minimera datatrafikkostnader över områden med begränsad uppkoppling.

Trots stora fördelar står Edge AI-bearbetning inför betydande tekniska och operationella utmaningar som organisationer måste hantera vid implementering. Strömförbrukning är en central begränsning, då körning av neurala nätverk på batteridrivna enheter snabbt dränerar energin, vilket begränsar drifttid och kräver noggrann modelloptimering för att balansera noggrannhet mot effektivitet. Beräkningsbegränsningar inskränker komplexiteten på modeller som kan köras på edge-enheter; organisationer måste välja mellan förenklade modeller med lägre noggrannhet eller acceptera längre inferenstider på resurssvaga enheter. Modellhanteringskomplexitet ökar markant i distribuerade miljöer, eftersom uppdatering av modeller på tusentals edge-enheter kräver robust versionshantering, återställningsmöjligheter och mekanismer för att säkerställa konsistens över hela flottan. Dataheterogenitet innebär utmaningar när edge-enheter verkar i varierande miljöer med olika datakaraktär, vilket kan göra att modeller tränade på centraliserade dataset presterar sämre på lokal data. Felsökning och övervakning försvåras av systemens distribuerade natur, vilket gör det svårt att diagnostisera fel, förstå modellbeteende och samla in heltäckande prestandamått från geografiskt spridda enheter. Säkerhetssårbarheter på edge-enheter skapar angreppsytor, då komprometterade enheter kan köra skadlig kod eller manipulera lokala modeller, vilket kräver robusta säkerhetsåtgärder och regelbundna uppdateringar. Integrationskomplexitet med befintlig molninfrastruktur kräver noggrann arkitektonisk planering för att säkerställa att edge-system effektivt kommunicerar med centraliserad analys och modellträningspipelines.

Samspelet mellan Edge AI-bearbetning och AI-övervakning skapar kraftfulla möjligheter för organisationer som vill bibehålla kontroll över algoritmiskt beslutsfattande i stor skala. Traditionella AI-övervakningsmetoder har begränsningar i molnbaserade system där latens och datatrafikkostnader begränsar realtidsinsyn i modellutdata; edge AI-övervakning löser detta genom att möjliggöra lokal analys av prediktioner innan de påverkar kunder. Utdata-verifieringssystem som implementeras på edge-enheter kan omedelbart validera prediktioner mot affärsregler, upptäcka avvikelser och flagga beslut som kräver mänsklig granskning innan de verkställs. Detta lokala övervakningstillvägagångssätt stödjer varumärkessäkerhetsinitiativ genom att säkerställa att AI-genererade rekommendationer, innehållsbeslut och kundinteraktioner överensstämmer med organisationens värderingar och regelefterlevnad. Edge-baserade övervakningssystem genererar detaljerade revisionsloggar som dokumenterar varför specifika beslut togs, stödjer transparenskrav och möjliggör efteranalys av algoritmiskt beteende. Bias-detekteringsmekanismer på edge-nivå kan identifiera när modeller ger oproportionerliga utfall mellan demografiska grupper, vilket möjliggör snabb intervention innan partiska rekommendationer når kunder. Kombinationen av edge AI och övervakning skapar en återkopplingsslinga där lokala beslutsloggar informerar modellträning, vilket säkerställer att systemen ständigt förbättras samtidigt som övervakning av deras beteende upprätthålls. Organisationer som implementerar edge AI-övervakning får oöverträffad insyn i algoritmiska beslut, och förvandlar AI från en svart låda till ett transparent, granskningsbart system som stödjer både prestandaoptimering och ansvarsfull AI-styrning.

Edge AI-bearbetning står i teknikens framkant, med nya trender som förändrar hur organisationer implementerar och hanterar distribuerad intelligens. Federerad inlärning representerar ett omvälvande tillvägagångssätt där edge-enheter tränar modeller gemensamt utan att överföra rådata till centraliserade servrar, vilket möjliggör integritetsbevarande maskininlärning i stor skala. 5G-nätens utbyggnad kommer kraftigt att påskynda edge AI-adoption genom att erbjuda pålitlig, låg-latens-uppkoppling som möjliggör sömlös synkronisering mellan edge-enheter och molninfrastruktur, samtidigt som lokala fördelar bibehålls. Utveckling av specialiserad hårdvara fortsätter, där tillverkare skapar allt effektivare AI-chip optimerade för specifika edge-applikationer, vilket förbättrar prestanda per watt—en avgörande faktor för batteridrivna enheter. Marknadsprognoser pekar på explosiv tillväxt, där den globala edge AI-marknaden beräknas nå 15,7 miljarder USD till 2030, med en årlig tillväxttakt på 38,3 % från 2023 till 2030. TinyML (maskininlärning på mikrokontroller) är en viktig trend som möjliggör AI-kapacitet på enheter med minimal minnes- och processorkraft, och därmed utökar edge AI till tidigare otänkbara användningsområden. Containerisering och orkestreringstekniker som Kubernetes anpassas nu för edge-miljöer, vilket gör det möjligt för organisationer att hantera distribuerade edge-implementationer med samma verktyg och processer som används för molninfrastruktur. Sammantaget pekar dessa trender på en framtid där intelligent bearbetning sker sömlöst över distribuerade nätverk, med edge-enheter som hanterar realtidsbeslut medan molnsystem står för träning, aggregering och långtidsanalys.

För att framgångsrikt implementera Edge AI-bearbetning krävs noggrann planering inom flera områden för att säkerställa att systemen levererar förväntad prestanda och affärsnytta. Val av modell är det första kritiska beslutet, där organisationer behöver utvärdera tillgängliga förtränade modeller, bedöma deras noggrannhet för målscenarier och avgöra om egenutvecklade modeller krävs. Optimeringsstrategier måste balansera modellens noggrannhet mot enhetens begränsningar, med tekniker som kvantisering, beskärning och arkitektursökning för att skapa modeller som passar hårdvarubegränsningar utan att prestandan blir oacceptabel. Val av hårdvara beror på specifika applikationskrav, beräkningsbehov och energibegränsningar; organisationer måste utvärdera alternativ från allmänna processorer till specialiserade AI-acceleratorer. Distributionsmekanismer kräver robusta processer för att distribuera modeller till edge-enheter, hantera versioner och möjliggöra återställning till tidigare versioner vid problem. Övervaknings- och observabilitetssystem måste spåra modellprestanda, upptäcka datadrift, identifiera avvikelser och generera larm när systemen avviker från förväntat beteende. Säkerhetsåtgärder skyddar edge-enheter mot obehörig åtkomst, modellstöld och skadlig manipulation via kryptering, autentisering och regelbundna säkerhetsuppdateringar. Integrationsplanering säkerställer att edge-system effektivt kommunicerar med molninfrastruktur för modelluppdateringar, analys och långtidslagring, och skapar samverkande hybrida arkitekturer som drar nytta av båda paradigmerna. Organisationer som implementerar edge AI bör etablera tydliga framgångsmått, pilotimplementera i liten skala före full utrullning och behålla flexibilitet för att justera strategier baserat på verkliga prestandadata.

Edge AI bearbetar data lokalt på enheter med omedelbar svarstid (sub-millisekundslatens), medan Cloud AI skickar data till fjärrservrar för bearbetning, vilket introducerar nätverksfördröjning. Edge AI prioriterar hastighet och sekretess, medan Cloud AI erbjuder obegränsad datorkraft för komplexa uppgifter.

Edge AI behåller känslig data på lokala enheter istället för att skicka den över nätverk eller lagra den i centraliserade molnservrar. Detta minskar risken för dataintrång, stödjer GDPR- och HIPAA-efterlevnad och säkerställer att personlig information förblir under organisationens kontroll.

Edge AI uppnår sub-millisekundssvarstid genom att bearbeta data lokalt, jämfört med 50-500 ms eller mer för molnbaserade system. Denna dramatiska latensminskning möjliggör realtidsapplikationer som autonoma fordon, industrirobotik och medicinteknisk utrustning som kräver omedelbara beslut.

Ja, Edge AI-system kan fungera helt offline eftersom bearbetningen sker lokalt på enheterna. Denna offlinefunktionalitet är avgörande för avlägsna platser med opålitlig uppkoppling och verksamhetskritiska applikationer där nätverksbortfall inte får störa driften.

Edge AI körs på olika enheter, inklusive smartphones, IoT-sensorer, industriutrustning, säkerhetskameror, smartklockor, autonoma fordon och inbyggda system. Moderna edge-enheter sträcker sig från mikrokontroller med minimala resurser till kraftfulla enkortsdatorer med specialiserade AI-acceleratorer.

Edge AI bearbetar data lokalt och överför enbart relevanta insikter istället för råa datastreams. Denna selektiva överföring minskar dramatiskt bandbreddsanvändningen, sänker nätverkskostnader och förbättrar systemprestanda genom att minimera datatrafik över nätverken.

Edge AI möjliggör realtidsövervakning av AI-genererade rekommendationer och beslut vid utförandet, vilket gör att organisationer omedelbart kan upptäcka avvikelser, verifiera varumärkessäkerhet och säkerställa att algoritmers utdata överensstämmer med organisationens värderingar innan de når kunderna.

Centrala utmaningar inkluderar strömförbrukning på batteridrivna enheter, beräkningsbegränsningar som kräver modelloptimering, komplexitet vid hantering av distribuerade system, säkerhetssårbarheter på edge-enheter och integrationsutmaningar med befintlig molninfrastruktur.

Edge AI-bearbetning möjliggör omedelbar analys av AI-utdata och varumärkesomnämnanden. AmICited spårar hur ditt varumärke visas i AI-genererat innehåll över GPTs, Perplexity och Google AI Overviews med realtidsnoggrannhet.

Edge SEO är metoden att implementera tekniska SEO-ändringar på nätverkets edge med hjälp av serverlösa funktioner på CDN:er. Lär dig hur det förbättrar prestand...

Lär dig hur RAG kombinerar LLM:er med externa datakällor för att generera exakta AI-svar. Förstå processen i fem steg, komponenterna och varför det är viktigt f...

Förstå hur betalväggar påverkar ditt innehålls synlighet i AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews. Lär dig strategier för att optimera in...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.