Vad är inbäddningar (embeddings) i AI-sökning?

Lär dig hur inbäddningar fungerar i AI-sökmotorer och språkmodeller. Förstå vektorrepresentationer, semantisk sökning och deras roll i AI-genererade svar....

En inbäddning är en numerisk vektorrepresentation av text, bilder eller annan data som fångar semantisk betydelse och relationer i ett flerdimensionellt rum. Inbäddningar omvandlar komplex, ostrukturerad data till täta arrayer av flyttal som maskininlärningsmodeller kan bearbeta, vilket gör det möjligt för AI-system att förstå kontext, likhet och betydelse istället för att enbart lita på nyckelords-matchning.

En inbäddning är en numerisk vektorrepresentation av text, bilder eller annan data som fångar semantisk betydelse och relationer i ett flerdimensionellt rum. Inbäddningar omvandlar komplex, ostrukturerad data till täta arrayer av flyttal som maskininlärningsmodeller kan bearbeta, vilket gör det möjligt för AI-system att förstå kontext, likhet och betydelse istället för att enbart lita på nyckelords-matchning.

En inbäddning är en numerisk vektorrepresentation av text, bilder eller annan data som fångar semantisk betydelse och relationer i ett flerdimensionellt rum. Istället för att behandla text som diskreta ord som ska matchas, omvandlar inbäddningar komplex, ostrukturerad information till täta arrayer av flyttal som maskininlärningsmodeller kan bearbeta och jämföra. Varje inbäddning representeras vanligtvis som en sekvens av tal såsom [0.2, 0.8, -0.4, 0.6, …], där varje tal motsvarar en specifik dimension eller egenskap som inbäddningsmodellen har lärt sig. Den grundläggande principen bakom inbäddningar är att semantiskt liknande innehåll ger matematiskt liknande vektorer, vilket gör det möjligt för AI-system att förstå kontext, mäta likhet och identifiera relationer utan att vara beroende av exakt nyckelordsmatchning. Denna omvandling från människoläsbar text till maskintolkade numeriska representationer utgör grunden för moderna AI-applikationer, från semantiska sökmotorer till stora språkmodeller och AI-övervakningsplattformar som spårar varumärkescitat över generativa AI-system.

Konceptet med inbäddningar uppstod ur decennier av forskning inom naturlig språkbehandling och maskininlärning, men fick stor spridning med introduktionen av Word2Vec 2013, utvecklad av forskare på Google. Word2Vec visade att neurala nätverk kunde lära sig meningsfulla ordrepresentationer genom att förutsäga kontextord från ett målord (Skip-gram) eller vice versa (Continuous Bag of Words). Detta genombrott visade att inbäddningar kunde fånga semantiska relationer—till exempel är vektorn för “kung” minus “man” plus “kvinna” ungefär lika med “drottning”, vilket avslöjar att inbäddningar kodar analoga samband. Efter Word2Vecs framgång utvecklade forskare allt mer sofistikerade inbäddningstekniker, inklusive GloVe (Global Vectors for Word Representation) 2014, som utnyttjade globala samförekomststatistik, och FastText från Facebook, som hanterade utomordsvokabulär med hjälp av tecken-n-gram. Landskapet förändrades dramatiskt med introduktionen av BERT (Bidirectional Encoder Representations from Transformers) 2018, som producerade kontextualiserade inbäddningar som förstod hur samma ord kan ha olika betydelser i olika kontexter. Idag är inbäddningar allestädes närvarande i AI-system, med moderna implementationer som använder transformerbaserade modeller som producerar inbäddningar mellan 384 och 1536 dimensioner beroende på modellarkitektur och applikationskrav.

Inbäddningar skapas genom en maskininlärningsprocess där neurala nätverk lär sig att omvandla rådata till meningsfulla numeriska representationer. Processen börjar med förbehandling, där text rensas, tokeniseras och förbereds för inbäddningsmodellen. Modellen bearbetar sedan denna input genom flera lager av neurala nätverk, lär sig mönster och relationer inom datan genom träning på stora korpusar. Under träningen justerar modellen sina interna parametrar för att minimera en förlustfunktion, vilket säkerställer att semantiskt liknande objekt placeras närmare varandra i vektorrummet medan olika objekt skjuts isär. De resulterande inbäddningarna fångar invecklade detaljer om input, inklusive semantisk betydelse, syntaktiska relationer och kontextuell information. För textinbäddningar specifikt lär sig modellen associationer mellan ord som ofta förekommer tillsammans, och förstår att “neuronal” och “nätverk” är nära relaterade koncept, medan “neuronal” och “pizza” är semantiskt långt ifrån varandra. Själva siffrorna i varje inbäddningsvektor är inte meningsfulla i sig—det är de relativa värdena och relationerna mellan siffrorna som kodar semantisk information. Moderna inbäddningsmodeller som OpenAI:s text-embedding-ada-002 producerar 1536-dimensionella vektorer, medan BERT producerar 768-dimensionella inbäddningar, och sentence-transformers-modeller som all-MiniLM-L6-v2 producerar 384-dimensionella vektorer. Valet av dimensionalitet innebär en avvägning: högre dimensioner kan fånga mer nyanserad semantisk information men kräver mer beräkningsresurser och lagringsutrymme, medan lägre dimensioner är mer effektiva men kan förlora subtila distinktioner.

| Inbäddningsteknik | Dimensionalitet | Träningsmetod | Styrkor | Begränsningar |

|---|---|---|---|---|

| Word2Vec (Skip-gram) | 100-300 | Kontextförutsägelse från målord | Snabb träning, fångar semantiska relationer, ger meningsfulla analogier | Statisk inbäddning, hanterar inte kontextvariationer, svårt med ovanliga ord |

| GloVe | 50-300 | Faktorisering av global samförekomstmatris | Kombinerar lokal och global kontext, effektiv träning, bra för generella uppgifter | Kräver förberäknad samförekomstmatris, mindre kontextmedveten än transformers |

| FastText | 100-300 | Ord-inbäddning baserad på tecken-n-gram | Hanterar utomordsvokabulär, fångar morfologisk information, bra för flera språk | Större modellstorlek, långsammare inferens än Word2Vec |

| BERT | 768 | Bidirektionell transformer med maskerande språkmodellering | Kontextuella inbäddningar, förstår ords betydelseskillnader, topp-prestanda | Beräkningsintensiv, kräver finjustering för specifika uppgifter, långsam inferens |

| Sentence-BERT | 384-768 | Siamesiskt nätverk med triplet loss | Optimerad för meningslikhet, snabb inferens, utmärkt för semantisk sökning | Kräver specifika träningsdata, mindre flexibel än BERT för specialuppgifter |

| OpenAI text-embedding-ada-002 | 1536 | Proprietär transformerbaserad modell | Produktionskvalitet, hanterar långa dokument, optimerad för hämtning | Kräver API-åtkomst, kommersiell prissättning, mindre transparens om träningsdata |

Det semantiska rummet är ett flerdimensionellt matematiskt landskap där inbäddningar placeras utifrån deras betydelse och relationer. Föreställ dig ett enormt koordinatsystem med hundratals eller tusentals axlar (dimensioner), där varje axel representerar någon aspekt av semantisk betydelse som inbäddningsmodellen lärt sig. I detta rum klustrar ord och dokument med liknande betydelser ihop sig, medan olika koncept placeras långt ifrån varandra. Till exempel, i ett semantiskt rum skulle orden “katt”, “kattunge”, “feline” och “husdjur” vara placerade nära varandra eftersom de delar semantiska egenskaper relaterade till tama djur. Däremot skulle “katt” och “bil” vara långt ifrån varandra eftersom de har minimal semantisk överlappning. Denna rumsliga organisation är inte slumpmässig—den uppstår ur inbäddningsmodellens träningsprocess, där modellen lär sig att placera liknande koncept nära varandra för att minimera prediktionsfel. Det vackra med semantiska rum är att de fångar inte bara direkta likheter utan även analoga relationer. Vektorskillnaden mellan “kung” och “drottning” liknar vektorskillnaden mellan “prins” och “prinsessa”, vilket avslöjar att inbäddningsmodellen lärt sig abstrakta relationer om kön och kunglighet. När AI-system behöver hitta liknande dokument, mäter de avstånd i detta semantiska rum med hjälp av mått som cosinuslikhet, som beräknar vinkeln mellan två vektorer. En cosinuslikhet på 1.0 indikerar identisk riktning (perfekt semantisk likhet), medan 0.0 indikerar ortogonala vektorer (ingen semantisk relation), och -1.0 indikerar motsatta riktningar (semantisk opposition).

Inbäddningar utgör den semantiska ryggraden i stora språkmodeller och moderna AI-system, och fungerar som porten där råtext omvandlas till maskinläsbara numeriska representationer. När du interagerar med ChatGPT, Claude eller Perplexity, arbetar inbäddningar bakom kulisserna på flera nivåer. Först, när dessa modeller bearbetar din inmatade text, omvandlar de den till inbäddningar som fångar den semantiska betydelsen av din fråga. Modellen använder sedan dessa inbäddningar för att förstå kontext, hämta relevant information och generera lämpliga svar. I Retrieval-Augmented Generation (RAG)-system spelar inbäddningar en avgörande roll i hämtfasen. När en användare ställer en fråga, inbäddas frågan och systemet söker i en vektordatabas efter dokument med liknande inbäddningar. Dessa semantiskt relevanta dokument skickas sedan till språkmodellen, som genererar ett svar grundat på det hämtade innehållet. Detta tillvägagångssätt förbättrar noggrannheten avsevärt och minskar hallucinationer eftersom modellen hänvisar till auktoritativ extern kunskap istället för att enbart förlita sig på sina träningsdata. För AI-övervaknings- och varumärkesspårningsplattformar som AmICited möjliggör inbäddningar upptäckt av varumärkesomnämnanden även när exakta nyckelord inte används. Genom att inbädda både ditt varumärkesinnehåll och AI-genererade svar kan dessa plattformar identifiera semantiska matchningar och spåra hur ditt varumärke syns över olika AI-system. Om en AI-modell diskuterar ditt företags teknik med annan terminologi kan inbäddningar ändå känna igen den semantiska likheten och flagga det som en citering. Denna förmåga blir allt viktigare när AI-system blir bättre på att omformulera och variera information.

Inbäddningar driver många praktiska tillämpningar över olika branscher och användningsfall. Semantiska sökmotorer använder inbäddningar för att förstå användarens intention snarare än att matcha nyckelord, vilket gör det möjligt att t.ex. söka efter “hur lagar jag en droppande kran” och få resultat om VVS-reparationer även om just dessa ord inte finns i dokumenten. Rekommendationssystem hos Netflix, Amazon och Spotify använder inbäddningar för att representera användarpreferenser och egenskaper hos objekt, vilket möjliggör personliga förslag genom att hitta objekt med liknande inbäddningar som användaren tidigare uppskattat. Avvikelsedetekteringssystem inom cybersäkerhet och bedrägeribekämpning använder inbäddningar för att identifiera ovanliga mönster genom att jämföra nuvarande beteendeinbäddningar med normala, och flagga avvikelser som kan indikera säkerhetshot eller bedrägerier. Maskinöversättningssystem använder flerspråkiga inbäddningar för att mappa ord och fraser från ett språk till ett annat genom att placera dem i ett gemensamt semantiskt rum, vilket möjliggör översättning utan explicita språkregler. Bildigenkänning och datorseende använder bildinbäddningar genererade av konvolutionella neurala nätverk för att klassificera bilder, upptäcka objekt och möjliggöra omvänd bildsökning. Frågesvarssystem använder inbäddningar för att matcha användarfrågor med relevanta dokument eller förtränade svar, så att chattbotar kan ge korrekta svar genom att hitta semantiskt liknande träningsfall. Innehållsmoderering använder inbäddningar för att identifiera giftigt, skadligt eller policybrytande innehåll genom att jämföra användargenererade inbäddningar med inbäddningar av känt problematiskt innehåll. Inbäddningars mångsidighet i dessa olika tillämpningar visar deras grundläggande betydelse för moderna AI-system.

Trots sin styrka möter inbäddningar betydande utmaningar i produktionsmiljöer. Skalbarhetsproblem uppstår när man hanterar miljarder högdimensionella inbäddningar, eftersom “dimensionalitetsförbannelsen” gör att sökeffektiviteten minskar när dimensionerna ökar. Traditionella indexeringsmetoder kämpar med högdimensionell data, även om avancerade tekniker som Hierarchical Navigable Small-World (HNSW)-grafer hjälper till att mildra detta. Semantisk drift sker när inbäddningar blir föråldrade när språket förändras, användarbeteende skiftar eller domänspecifik terminologi förändras. Till exempel kan ordet “virus” få annan semantisk tyngd under en pandemi än under normala tider, vilket kan påverka sökresultat och rekommendationer. För att motverka semantisk drift krävs regelbunden omträning av inbäddningsmodeller, vilket kräver stora beräkningsresurser och expertis. Beräkningskostnader för att generera och bearbeta inbäddningar är fortfarande betydande, särskilt för träning av stora modeller som BERT eller CLIP, vilka kräver högpresterande GPU:er och stora datamängder till höga kostnader. Även efter träning kan realtidssökning belasta infrastrukturen, särskilt i applikationer som autonom körning där inbäddningar måste bearbetas på millisekundsnivå. Bias- och rättviseproblem uppstår eftersom inbäddningar lär sig från träningsdata som kan innehålla samhälleliga snedvridningar, vilket potentiellt kan förstärka diskriminering i nedströmsapplikationer. Tolkningssvårigheter gör det svårt att förstå vad specifika dimensioner i en inbäddning representerar eller varför modellen gjort vissa likhetsbedömningar. Lagringskrav för inbäddningar kan vara omfattande—lagring av inbäddningar för miljontals dokument kräver betydande databasinfrastruktur. Organisationer möter dessa utmaningar genom tekniker som kvantisering (minska precision från 32-bit till 8-bit), dimensionstrunkering (behålla endast de viktigaste dimensionerna) och molnbaserad infrastruktur som skalar vid behov.

Fältet för inbäddningar utvecklas snabbt, med flera framväxande trender som formar framtidens AI-system. Multimodala inbäddningar blir alltmer sofistikerade och möjliggör sömlös integration av text, bild, ljud och video i gemensamma vektorrum. Modeller som CLIP visar styrkan hos multimodala inbäddningar för uppgifter som bildsökning från textbeskrivningar eller tvärtom. Instruktionsanpassade inbäddningar utvecklas för att bättre förstå specifika typer av frågor och instruktioner, där specialiserade modeller överträffar allmänna inbäddningar för domänspecifika uppgifter som juridisk dokumentsökning eller medicinsk litteraturhämtning. Effektiva inbäddningar genom kvantisering och beskärning gör inbäddningar mer praktiska för edge-enheter och realtidsapplikationer, och möjliggör generering av inbäddningar på smartphones och IoT-enheter. Adaptiva inbäddningar som anpassar sina representationer efter kontext eller användarpreferenser är på väg, vilket kan möjliggöra mer personlig och kontextrelevant sökning och rekommendation. Hybridsökning som kombinerar semantisk likhet med traditionell nyckelordsmatchning blir standard, eftersom forskning visar att kombinationen ofta ger bättre resultat än båda metoder var för sig. Temporala inbäddningar som fångar hur betydelse ändras över tid utvecklas för applikationer som kräver historisk kontextmedvetenhet. Förklaringsbara inbäddningar eftersträvas för att göra modellerna mer tolkningsbara och hjälpa användare förstå varför vissa dokument anses liknande. För AI-övervakning och varumärkesspårning kommer inbäddningar sannolikt bli mer sofistikerade på att upptäcka parafraserade citat, förstå kontextspecifika varumärkesomnämnanden och spåra hur AI-system förändrar sin förståelse av varumärken över tid. I takt med att inbäddningar blir allt mer centrala för AI-infrastruktur kommer forskning kring effektivitet, tolkningsbarhet och rättvisa att fortsätta accelerera.

Att förstå inbäddningar är särskilt relevant för organisationer som använder AI-övervakningsplattformar som AmICited för att spåra varumärkessynlighet över generativa AI-system. Traditionella övervakningsmetoder som förlitar sig på exakt nyckelordsmatchning missar många viktiga citeringar eftersom AI-modeller ofta parafraserar eller använder annan terminologi när de refererar till varumärken och företag. Inbäddningar löser detta problem genom att möjliggöra semantisk matchning—när AmICited inbäddar både ditt varumärkesinnehåll och AI-genererade svar kan den identifiera när ett AI-system diskuterar ditt företag eller dina produkter även om exakta nyckelord inte finns med. Denna förmåga är avgörande för fullständig varumärkesövervakning eftersom den fångar citeringar som nyckelordsbaserade system skulle missa. Om ditt företag till exempel är specialiserat på “maskininlärningsinfrastruktur” kan ett AI-system beskriva ditt erbjudande som “AI-modellutplaceringsplattformar” eller “verktyg för optimering av neurala nätverk”. Utan inbäddningar skulle dessa parafraserade referenser förbli oupptäckta. Med inbäddningar känns den semantiska likheten mellan din varumärkesbeskrivning och AI:ns parafraserade version igen, så att du kan behålla överblick över hur AI-system citerar och refererar till ditt varumärke. I takt med att AI-system som ChatGPT, Perplexity, Google AI Overviews och Claude blir allt viktigare informationskällor blir möjligheten att spåra varumärkesomnämnanden genom semantisk förståelse istället för nyckelordsmatchning avgörande för att behålla varumärkessynlighet och säkerställa citeringsnoggrannhet i den generativa AI-eran.

Traditionell nyckelordssökning matchar exakta ord eller fraser och missar semantiskt liknande innehåll som använder annan terminologi. Inbäddningar förstår betydelse genom att omvandla text till numeriska vektorer där liknande koncept ger liknande vektorer. Detta möjliggör semantisk sökning för att hitta relevanta resultat även när exakta nyckelord inte matchar, såsom att hitta 'hantera saknade värden' när man söker efter 'datastädning'. Enligt forskning rapporterar 25% av vuxna i USA att AI-drivna sökmotorer som använder inbäddningar ger mer precisa resultat än traditionell nyckelordssökning.

Det semantiska rummet är ett flerdimensionellt matematiskt rum där inbäddningar placeras utifrån deras betydelse. Liknande koncept klustrar ihop i detta rum, medan olika koncept placeras långt ifrån varandra. Till exempel skulle ord som 'katt' och 'kattunge' placeras nära varandra eftersom de delar semantiska egenskaper, medan 'katt' och 'bil' skulle vara långt ifrån varandra. Denna rumsliga organisation möjliggör för algoritmer att mäta likhet med distansmått som cosinuslikhet, vilket gör det möjligt för AI-system att effektivt hitta relaterat innehåll.

Populära inbäddningsmodeller inkluderar Word2Vec (som lär sig ordrelationer utifrån kontext), BERT (som förstår kontextuell betydelse genom att ta hänsyn till omgivande ord), GloVe (som använder globala samförekomststatistik för ord), och FastText (som hanterar utomordsvokabulär genom tecken-n-gram). Moderna system använder även OpenAI:s text-embedding-ada-002 (1536 dimensioner) och Sentence-BERT för inbäddningar på meningsnivå. Varje modell producerar vektorer med olika dimensioner—BERT använder 768 dimensioner, medan vissa modeller producerar 384 eller 1024-dimensionella vektorer beroende på arkitektur och träningsdata.

RAG-system använder inbäddningar för att hämta relevanta dokument innan svar genereras. När en användare ställer en fråga, inbäddar systemet frågan och söker i en vektordatabas efter dokument med liknande inbäddningar. Dessa hämtade dokument skickas sedan till en språkmodell, som genererar ett informerat svar baserat på det hämtade innehållet. Detta tillvägagångssätt förbättrar noggrannheten avsevärt och minskar hallucinationer i AI-svar genom att säkerställa att modellen refererar till auktoritativ extern kunskap istället för att bara lita på träningsdata.

Cosinuslikhet mäter vinkeln mellan två inbäddningsvektorer, från -1 till 1, där 1 indikerar identisk riktning (perfekt likhet) och -1 motsatt riktning. Det är standardmåttet för att jämföra inbäddningar eftersom det fokuserar på semantisk betydelse och riktning snarare än magnitud. Cosinuslikhet är beräkningsmässigt effektivt och fungerar bra i högdimensionella rum, vilket gör det idealiskt för att hitta liknande dokument, rekommendationer och semantiska relationer i AI-system.

Inbäddningar driver AI-övervakningsplattformar genom att omvandla varumärkesomnämnanden, URL:er och innehåll till numeriska vektorer som kan jämföras semantiskt. Detta gör att system kan upptäcka när AI-modeller nämner eller refererar till ditt varumärke även när exakta nyckelord inte används. Genom att inbädda både ditt varumärkesinnehåll och AI-genererade svar kan övervakningsplattformar identifiera semantiska matchningar, spåra hur ditt varumärke syns på ChatGPT, Perplexity, Google AI Overviews och Claude, samt mäta citeringsnoggrannhet och kontext.

De största utmaningarna inkluderar skalbarhetsproblem med miljarder högdimensionella inbäddningar, semantisk drift där inbäddningar blir föråldrade när språket utvecklas, och betydande beräkningskostnader för träning och inferens. 'Dimensionalitetsförbannelsen' gör sökning mindre effektiv när dimensionerna ökar, och att bibehålla inbäddningskvalitet kräver regelbunden omträning av modeller. Lösningar inkluderar avancerade indexeringstekniker som HNSW-grafer, kvantisering för att minska lagring, och molnbaserad GPU-infrastruktur för kostnadseffektiv skalning.

Dimensionsreduktionsmetoder som Principal Component Analysis (PCA) komprimerar högdimensionella inbäddningar till lägre dimensioner (vanligtvis 2D eller 3D) för visualisering och analys. Medan inbäddningar vanligtvis har hundratals eller tusentals dimensioner, kan människor inte visualisera mer än 3D. Dimensionsreduktion bevarar den viktigaste informationen samtidigt som mönster görs synliga. Till exempel kan en reduktion av 384-dimensionella inbäddningar till 2D bevara 41% av variansen och tydligt visa hur dokument klustrar efter ämne, vilket hjälper data scientists förstå vad inbäddningsmodellen har lärt sig.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur inbäddningar fungerar i AI-sökmotorer och språkmodeller. Förstå vektorrepresentationer, semantisk sökning och deras roll i AI-genererade svar....

Lär dig hur vektorembeddningar gör det möjligt för AI-system att förstå semantisk betydelse och matcha innehåll med sökfrågor. Utforska teknologin bakom semanti...

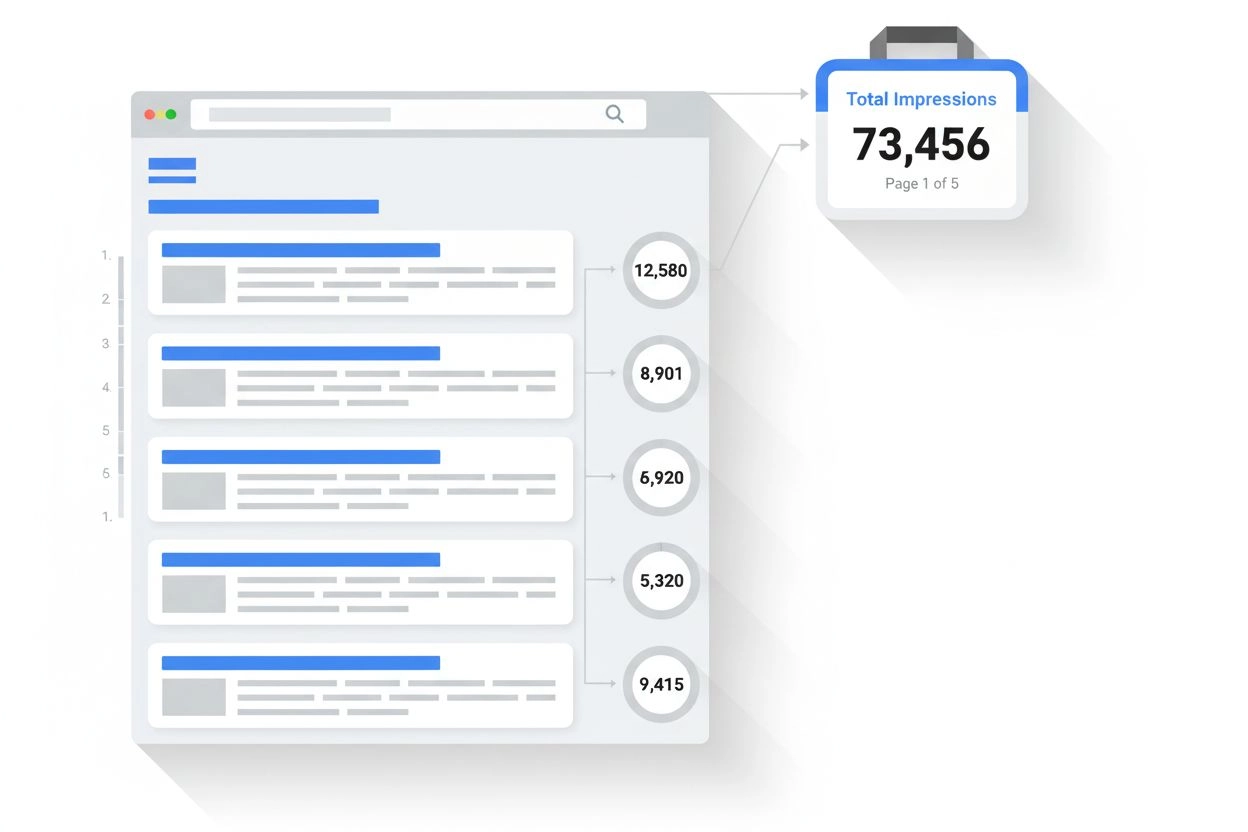

Lär dig vad en impression är i sökresultat och AI-övervakning. Förstå hur impressions räknas i Google Sök, Perplexity, ChatGPT och andra plattformar – och varfö...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.