AI-genererad bild

Lär dig vad AI-genererade bilder är, hur de skapas med diffusionsmodeller och neurala nätverk, deras användningsområden inom marknadsföring och design samt de e...

Generativ AI är artificiell intelligens som skapar nytt, originellt innehåll såsom text, bilder, videor, kod och ljud baserat på mönster som lärts in från träningsdata. Den använder djupinlärningsmodeller som transformatorer och diffusionsmodeller för att generera olika typer av resultat som svar på användarens uppmaningar eller förfrågningar.

Generativ AI är artificiell intelligens som skapar nytt, originellt innehåll såsom text, bilder, videor, kod och ljud baserat på mönster som lärts in från träningsdata. Den använder djupinlärningsmodeller som transformatorer och diffusionsmodeller för att generera olika typer av resultat som svar på användarens uppmaningar eller förfrågningar.

Generativ AI är en kategori av artificiell intelligens som skapar nytt, originellt innehåll baserat på mönster inlärda från träningsdata. Till skillnad från traditionella AI-system som klassificerar eller förutspår information, producerar generativa AI-modeller autonomt nya utdata såsom text, bilder, videor, ljud, kod och andra datatyper som svar på användarens uppmaningar eller förfrågningar. Dessa system använder sofistikerade djupinlärningsmodeller och neurala nätverk för att identifiera komplexa mönster och relationer i stora datamängder och använder sedan denna kunskap för att generera innehåll som liknar, men skiljer sig från, träningsdatan. Begreppet “generativ” betonar modellens förmåga att skapa—att skapa något nytt snarare än att bara analysera eller kategorisera befintlig information. Sedan den publika lanseringen av ChatGPT i november 2022 har generativ AI blivit en av de mest omvälvande teknologierna inom IT och förändrat grunden för hur organisationer närmar sig innehållsskapande, problemlösning och beslutsfattande i praktiskt taget varje bransch.

Grunden för generativ AI sträcker sig flera decennier tillbaka, även om teknologin har utvecklats dramatiskt under senare år. Tidiga statistiska modeller under 1900-talet lade grunden för förståelsen av datafördelningar, men verklig generativ AI tog form med framsteg inom djupinlärning och neurala nätverk under 2010-talet. Introduktionen av Variational Autoencoders (VAEs) 2013 innebar ett genombrott som gjorde det möjligt för modeller att generera realistiska varianter av data såsom bilder och tal. År 2014 introducerades Generative Adversarial Networks (GANs) och diffusionsmodeller, vilket ytterligare förbättrade kvaliteten och realismen i genererat innehåll. Den avgörande punkten kom 2017 när forskare publicerade “Attention is All You Need”, där transformerarkitekturen presenterades—ett genombrott som fundamentalt förändrade hur generativa AI-modeller bearbetar och genererar sekventiell data. Denna innovation möjliggjorde utvecklingen av Large Language Models (LLMs) som OpenAI:s GPT-serie, vilka visade på oöverträffade förmågor att förstå och generera mänskligt språk. Enligt forskning från McKinsey använde redan en tredjedel av organisationerna generativ AI regelbundet i minst en affärsfunktion år 2023, och Gartner förutspår att mer än 80 % av företagen kommer att ha implementerat generativa AI-applikationer eller använt generativa AI-API:er till 2026. Den snabba övergången från forskningsnyfikenhet till företagsnödvändighet representerar en av de snabbaste teknikadoptionscyklerna i historien.

Generativ AI fungerar genom en flerfasig process som börjar med träning på enorma datamängder, följt av justering för specifika applikationer, samt kontinuerliga cykler av generering, utvärdering och omjustering. Under träningsfasen matar man djupinlärningsalgoritmer med terabyte av rå, ostrukturerad data—såsom internettexter, bilder eller kodförråd—och algoritmen genomför miljontals “fyll i luckan”-övningar, förutspår nästa element i en sekvens och justerar sig själv för att minimera fel. Denna process skapar ett neuralt nätverk av parametrar som kodar de mönster, entiteter och relationer som upptäckts i träningsdatan. Resultatet är en grundmodell—en stor, förtränad modell som kan utföra flera uppgifter över olika domäner. Grundmodeller som GPT-3, GPT-4 och Stable Diffusion utgör basen för många specialiserade applikationer. Justeringsfasen innebär finjustering av grundmodellen med märkta data specifika för en viss uppgift, eller användning av Reinforcement Learning with Human Feedback (RLHF), där mänskliga utvärderare poängsätter olika utdata för att styra modellen mot större noggrannhet och relevans. Utvecklare och användare utvärderar kontinuerligt utdata och finjusterar modeller—ibland veckovis—för att förbättra prestanda. En annan optimeringsteknik är Retrieval Augmented Generation (RAG), som utökar grundmodellen med tillgång till relevanta externa källor, vilket säkerställer att modellen alltid har tillgång till aktuell information och transparens kring källor.

| Modelltyp | Träningsmetod | Genereringshastighet | Utdatakvalitet | Mångfald | Bästa användningsområden |

|---|---|---|---|---|---|

| Diffusionsmodeller | Iterativ borttagning av brus från slumpdata | Långsam (flera iterationer) | Mycket hög (fotorealistisk) | Hög | Bildgenerering, högupplöst syntes |

| Generative Adversarial Networks (GANs) | Generator vs. diskriminator-tävling | Snabb | Hög | Lägre | Domänspecifik generering, stilöverföring |

| Variational Autoencoders (VAEs) | Encoder-decoder med latent rum | Måttlig | Måttlig | Måttlig | Datakomprimering, anomalidetektion |

| Transformer-modeller | Självuppmärksamhet på sekventiell data | Måttlig till snabb | Mycket hög (text/kod) | Mycket hög | Språkgenerering, kodsyntes, LLMs |

| Hybridmetoder | Kombination av flera arkitekturer | Varierande | Mycket hög | Mycket hög | Multimodal generering, komplexa uppgifter |

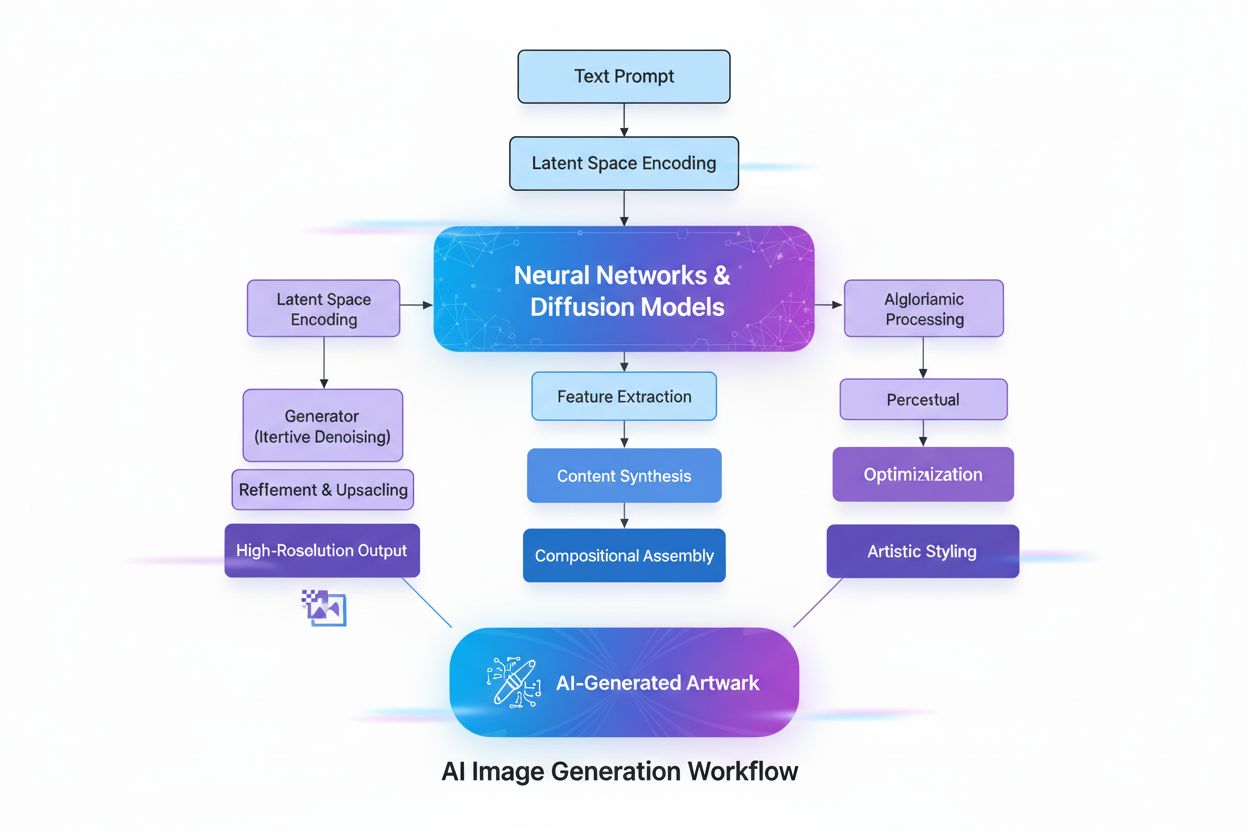

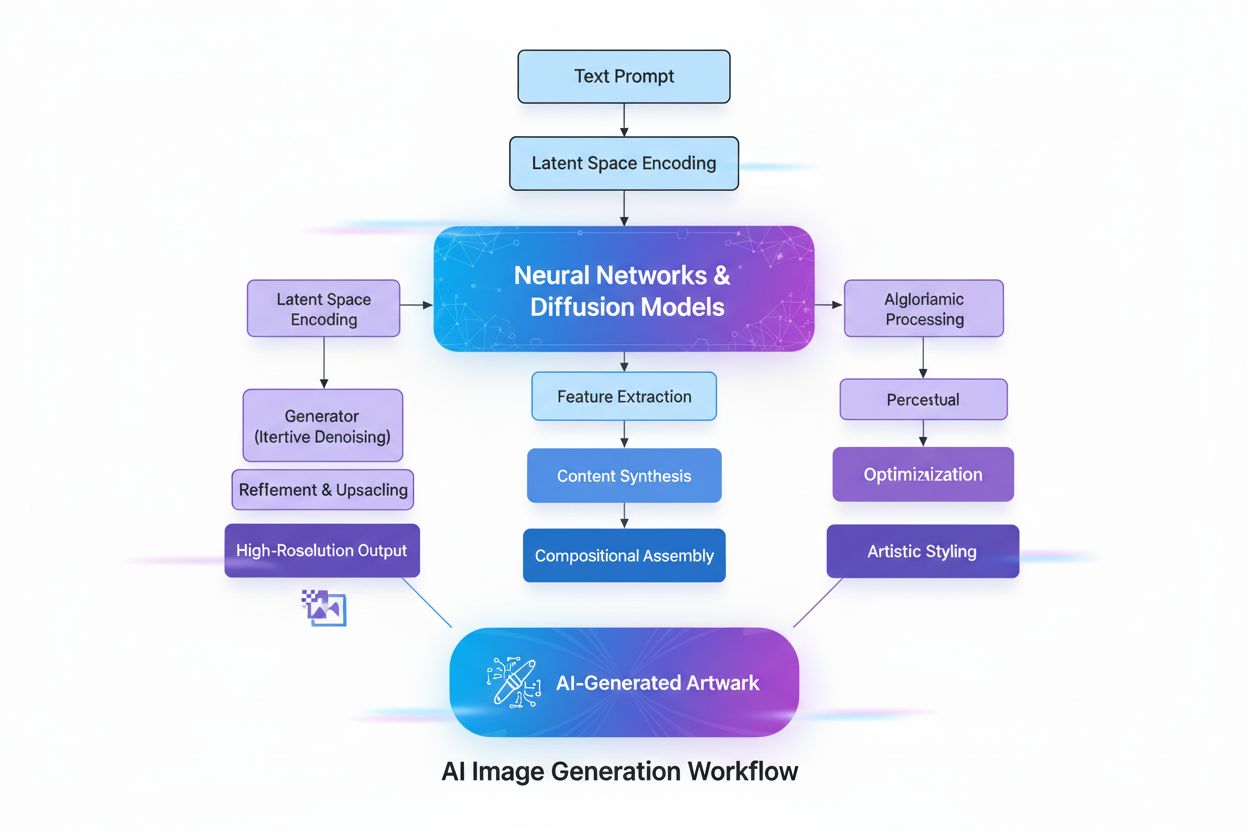

Transformerarkitekturen är den mest inflytelserika teknologin bakom modern generativ AI. Transformatorer använder självuppmärksamhetsmekanismer för att avgöra vilka delar av indata som är viktigast vid bearbetning av varje element, vilket gör att modellen kan fånga långväga beroenden och kontext. Positionskodning representerar ordningen av indatadelen, vilket gör att transformerare förstår sekvensstruktur utan sekventiell bearbetning. Denna parallella bearbetningskapacitet accelererar träningen dramatiskt jämfört med tidigare rekurrenta neurala nätverk (RNNs). Transformerns encoder-decoder-struktur, i kombination med flera lager av attention-heads, gör att modellen kan beakta olika aspekter av data och förfina kontextuella inbäddningar i varje lager. Dessa inbäddningar fångar allt från grammatik och syntax till komplex semantisk betydelse. Large Language Models (LLMs) som ChatGPT, Claude och Gemini byggs på transformerarkitekturer och innehåller miljarder parametrar—inkodade representationer av inlärda mönster. Skalan av dessa modeller, kombinerat med träning på data i internetskala, gör dem kapabla att utföra många olika uppgifter från översättning och summering till kreativt skrivande och kodgenerering. Diffusionsmodeller, en annan kritisk arkitektur, fungerar genom att först lägga till brus till träningsdata tills den blir slumpmässig, och sedan träna algoritmen att iterativt ta bort detta brus för att avslöja önskad utdata. Även om diffusionsmodeller kräver längre träningstid än VAEs eller GANs erbjuder de överlägsen kontroll över utdatans kvalitet, särskilt för högkvalitativa bildgenereringsverktyg som DALL-E och Stable Diffusion.

Affärsnyttan med generativ AI har visat sig övertygande, där företag upplever mätbara produktivitetsvinster och kostnadsminskningar. Enligt OpenAI:s AI-rapport för företag 2025 rapporterar användare att de sparar 40–60 minuter per dag tack vare generativa AI-applikationer, vilket innebär betydande produktivitetsförbättringar i organisationer. Marknaden för generativ AI värderades till 16,87 miljarder USD år 2024 och förväntas nå 109,37 miljarder USD år 2030, med en CAGR på 37,6 %—en av de snabbaste tillväxttakterna i företagshistorien för mjukvara. Företagsutgifter för generativ AI uppgick till 37 miljarder dollar år 2025, jämfört med 11,5 miljarder dollar år 2024, vilket motsvarar en 3,2 gånger ökning år över år. Denna acceleration speglar ökat förtroende för ROI, där AI-köpare konverterar på 47 % jämfört med SaaS traditionella 25 %, vilket indikerar att generativ AI ger tillräckligt omedelbart värde för att motivera snabb adoption. Organisationer implementerar generativ AI över flera funktioner: kundtjänst använder AI-chattbotar för personliga svar och förstakontaktlösning; marknadsavdelningar utnyttjar innehållsgenerering för bloggar, e-post och sociala medier; mjukvaruutvecklingsteam använder kodgenerering för att accelerera utvecklingscykler; och forskningsteam använder generativa modeller för att analysera komplexa datamängder och föreslå nya lösningar. Finansföretag använder generativ AI för bedrägeriupptäckt och personlig finansiell rådgivning, medan hälso- och sjukvårdsorganisationer tillämpar den för läkemedelsutveckling och medicinsk bildanalys. Teknikens mångsidighet visar dess transformerande potential för affärsverksamheter.

Generativ AI:s applikationer spänner över praktiskt taget alla sektorer och funktioner. Vid textgenerering producerar modeller sammanhängande, kontextuellt relevant innehåll inklusive dokumentation, marknadsföringstexter, bloggartiklar, forskningsrapporter och kreativt skrivande. De utmärker sig vid att automatisera tråkiga skrivuppgifter såsom dokumentsummering och metadataframställning, vilket frigör mänskliga skribenter för mer kreativt arbete. Bildgenereringsverktyg som DALL-E, Midjourney och Stable Diffusion skapar fotorealistiska bilder, originalkonst och utför stilöverföring och bildredigering. Videogenerering möjliggör skapande av animationer från textuppmaningar och specialeffekter snabbare än traditionella metoder. Ljud- och musikgenerering syntetiserar naturligt tal för chattbotar och digitala assistenter, skapar ljudboksinläsningar och genererar originalmusik som liknar professionella kompositioner. Kodgenerering gör det möjligt för utvecklare att skriva originalkod, autokomplettera kodsnuttar, översätta mellan programmeringsspråk och felsöka applikationer. Inom hälso- och sjukvård påskyndar generativ AI läkemedelsutveckling genom att generera nya proteinsekvenser och molekylstrukturer med önskade egenskaper. Syntetisk datagenerering skapar märkta träningsdata för maskininlärningsmodeller, särskilt värdefullt när verklig data är begränsad, otillgänglig eller otillräcklig för edge-fall. Inom fordonsindustrin skapar generativ AI 3D-simuleringar för fordonsutveckling och genererar syntetisk data för träning av autonoma fordon. Media- och underhållningsföretag använder generativ AI för att skapa animationer, manus, spelmiljöer och personliga rekommendationer. Energibolag tillämpar generativa modeller för nätverkshantering, optimering av driftsäkerhet och prognoser av energiproduktion. Den breda användningen visar att generativ AI är en grundläggande teknologi som omformar hur organisationer skapar, analyserar och innoverar.

Trots imponerande kapaciteter medför generativ AI betydande utmaningar som organisationer måste hantera. AI-hallucinationer—trovärdiga men faktamässigt felaktiga utdata—uppstår eftersom generativa modeller förutspår nästa element baserat på mönster snarare än att verifiera fakta. En advokat använde exempelvis ChatGPT för juridisk research och fick helt påhittade rättsfall med citat och hänvisningar. Bias och rättviseproblem uppstår när träningsdata innehåller samhälleliga fördomar, vilket leder till att modeller genererar partiskt, orättvist eller stötande innehåll. Inkonsekventa utdata är en konsekvens av den probabilistiska naturen hos generativa modeller, där identiska indata kan ge olika resultat—ett problem för applikationer som kräver konsekvens, såsom kundtjänstchattbotar. Brist på förklarbarhet gör det svårt att förstå hur modeller kommer fram till specifika resultat; även ingenjörer har svårt att förklara beslutsprocesserna hos dessa “svarta lådor”. Säkerhets- och integritetsrisker uppstår när företagsdata används i träning eller när modeller genererar innehåll som avslöjar immateriell egendom eller bryter mot andras IP-skydd. Deepfakes—AI-genererade eller manipulerade bilder, videor eller ljud skapade för att vilseleda—är bland de mest oroande applikationerna, där cyberbrottslingar använder deepfakes vid röstbedrägerier och ekonomisk brottslighet. Beräkningskostnader är fortfarande betydande, då träning av stora grundmodeller kräver tusentals GPU:er och veckor av beräkning till miljonkostnad. Organisationer hanterar dessa risker genom skyddsräcken som begränsar modeller till betrodda datakällor, kontinuerlig utvärdering och justering för att minska hallucinationer, mångsidig träningsdata för att minimera bias, prompt engineering för att uppnå konsekventa resultat och säkerhetsprotokoll för att skydda företagsinformation. Transparens kring AI-användning och mänsklig översyn av kritiska beslut förblir avgörande bästa praxis.

När generativa AI-system blir primära informationskällor för miljontals användare måste organisationer förstå hur deras varumärken, produkter och innehåll framställs i AI-genererade svar. Övervakning av AI-synlighet innebär att systematiskt spåra hur stora generativa AI-plattformar—inklusive ChatGPT, Perplexity, Google AI Overviews och Claude—beskriver varumärken, produkter och konkurrenter. Denna övervakning är avgörande eftersom AI-system ofta citerar källor och refererar information utan traditionella sökmotorers synlighetsmått. Varumärken som inte syns i AI-svar missar möjligheter till synlighet och inflytande i det AI-drivna söklandskapet. Verktyg som AmICited gör det möjligt för organisationer att spåra varumärkesomnämnanden, övervaka citeringsnoggrannhet, identifiera vilka domäner och URL:er som refereras i AI-svar och förstå hur AI-system representerar deras konkurrenspositionering. Dessa data hjälper organisationer att optimera sitt innehåll för AI-citering, identifiera felaktig eller missvisande information och bibehålla konkurrenssynlighet när AI blir gränssnittet mellan användare och information. Praktiken GEO (Generative Engine Optimization) fokuserar på att optimera innehåll specifikt för AI-citering och synlighet, som ett komplement till traditionell SEO. Organisationer som proaktivt övervakar och optimerar sin AI-synlighet skaffar sig konkurrensfördelar i det nya AI-drivna informationslandskapet.

Det generativa AI-landskapet utvecklas snabbt, med flera nyckeltrender som formar framtiden. Multimodala AI-system som sömlöst integrerar text, bilder, video och ljud blir allt mer sofistikerade och möjliggör mer komplex och nyanserad innehållsgenerering. Agentisk AI—autonoma AI-system som kan utföra uppgifter och nå mål utan mänsklig inblandning—representerar nästa utvecklingssteg efter generativ AI, där AI-agenter använder genererat innehåll för att interagera med verktyg och fatta beslut. Mindre, mer effektiva modeller växer fram som alternativ till massiva grundmodeller, vilket gör det möjligt för organisationer att implementera generativ AI med lägre beräkningskostnader och snabbare inferens. Retrieval Augmented Generation (RAG) fortsätter att utvecklas och gör det möjligt för modeller att nå aktuell information och externa kunskapskällor, vilket adresserar hallucinationer och noggrannhetsproblem. Regelverk utvecklas globalt, där myndigheter sätter riktlinjer för ansvarsfull AI-utveckling och -implementering. Företagsanpassning genom finjustering och domänspecifika modeller accelererar, när organisationer vill anpassa generativ AI till sina unika verksamhetsmiljöer. Etisk AI blir en konkurrensfördel, då organisationer prioriterar transparens, rättvisa och ansvarsfull användning. Sammanflödet av dessa trender pekar på att generativ AI blir alltmer integrerad i affärsverksamheter, mer effektiv och tillgänglig för organisationer i alla storlekar samt föremål för starkare styrning och etiska standarder. Organisationer som investerar i att förstå generativ AI, övervaka sin AI-synlighet och implementera ansvarsfulla processer kommer vara bäst positionerade att dra nytta av denna transformerande teknologi och samtidigt hantera dess risker.

Generativ AI skapar nytt innehåll genom att lära sig datafördelningen och generera nya resultat, medan diskriminativ AI fokuserar på klassificerings- och prediktionsuppgifter genom att lära sig beslutsgränser mellan kategorier. Generativa AI-modeller som GPT-3 och DALL-E producerar kreativt innehåll, medan diskriminativa modeller passar bättre för uppgifter som bildigenkänning eller skräppostdetektion. Båda tillvägagångssätten har olika användningsområden beroende på om målet är att skapa innehåll eller klassificera data.

Transformer-modeller använder självuppmärksamhetsmekanismer och positionskodning för att bearbeta sekventiell data såsom text utan att kräva sekventiell bearbetning. Denna arkitektur gör det möjligt för transformerare att fånga långväga beroenden mellan ord och förstå kontext mer effektivt än tidigare modeller. Transformerns förmåga att bearbeta hela sekvenser samtidigt och lära sig komplexa relationer har gjort den till grunden för de flesta moderna generativa AI-system, inklusive ChatGPT och GPT-4.

Grundmodeller är storskaliga djupinlärningsmodeller som är förtränade på enorma mängder oetiketterad data och kan utföra flera uppgifter över olika domäner. Exempel inkluderar GPT-3, GPT-4 och Stable Diffusion. Dessa modeller fungerar som bas för olika generativa AI-applikationer och kan finjusteras för specifika användningsfall, vilket gör dem mycket mångsidiga och kostnadseffektiva jämfört med att träna modeller från grunden.

Eftersom generativa AI-system som ChatGPT, Perplexity och Google AI Overviews blir primära informationskällor behöver varumärken spåra hur de framställs i AI-genererade svar. Övervakning av AI-synlighet hjälper organisationer att förstå varumärkesuppfattning, säkerställa korrekt informationsåtergivning och bibehålla konkurrenspositionering i det AI-drivna söklandskapet. Verktyg som AmICited gör det möjligt för varumärken att spåra omnämnanden och citeringar över flera AI-plattformar.

Generativa AI-system kan producera 'hallucinationer'—trovärdiga men faktamässigt felaktiga resultat—på grund av sitt mönsterbaserade inlärningssätt. Dessa modeller kan också återspegla fördomar i träningsdata, generera inkonsekventa resultat för identiska indata och sakna transparens i sina beslutsprocesser. Att hantera dessa utmaningar kräver diversifierad träningsdata, kontinuerlig utvärdering och implementering av skyddsräcken för att begränsa modeller till betrodda datakällor.

Diffusionsmodeller genererar innehåll genom att iterativt ta bort brus från slumpmässig data, vilket ger högkvalitativa resultat men långsammare genereringshastighet. GAN:er använder två konkurrerande neurala nätverk (generator och diskriminator) för att snabbt producera realistiskt innehåll men med lägre mångfald. Diffusionsmodeller föredras för högkvalitativ bildgenerering, medan GAN:er är effektiva för domänspecifika applikationer som kräver balans mellan hastighet och kvalitet.

Marknaden för generativ AI värderades till 16,87 miljarder USD år 2024 och förväntas nå 109,37 miljarder USD år 2030, med en årlig tillväxttakt (CAGR) på 37,6 % från 2025 till 2030. Företagsutgifter för generativ AI uppgick till 37 miljarder dollar år 2025, vilket är en 3,2 gånger ökning jämfört med 11,5 miljarder dollar år 2024, vilket visar på snabb adoption över branscher.

Ansvarsfull implementering av generativ AI kräver att man börjar med interna applikationer för att testa resultat i kontrollerade miljöer, säkerställa transparens genom att tydligt kommunicera när AI används, införa säkerhetsspärrar för att förhindra obehörig åtkomst till data och genomföra omfattande tester över olika scenarier. Organisationer bör även etablera tydliga styrningsramverk, övervaka resultat för bias och noggrannhet samt upprätthålla mänsklig översyn av kritiska beslut.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig vad AI-genererade bilder är, hur de skapas med diffusionsmodeller och neurala nätverk, deras användningsområden inom marknadsföring och design samt de e...

Community-diskussion som förklarar generativa motorer. Tydliga förklaringar av hur ChatGPT, Perplexity och andra AI-system skiljer sig från traditionell Google-...

ChatGPT är OpenAI:s konversationella AI-assistent som drivs av GPT-modeller. Lär dig hur den fungerar, dess påverkan på AI-övervakning, varumärkessynlighet och ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.