Hur optimerar jag för Google Gemini? Komplett guide till AI-sökmotoroptimering

Lär dig hur du optimerar ditt innehåll för Google Gemini och andra AI-sökmotorer. Bemästra strategier för Answer Engine Optimization (AEO) för att öka varumärke...

Google Gemini är en familj av multimodala stora språkmodeller (LLM:er) utvecklade av Google DeepMind som bearbetar och genererar text, bilder, ljud och video. Den representerar Googles efterföljare till LaMDA och PaLM 2, utformad för att förstå och resonera över flera datatyper samtidigt och driver Gemini AI-chattboten samt är integrerad i Googles ekosystem av produkter och tjänster.

Google Gemini är en familj av multimodala stora språkmodeller (LLM:er) utvecklade av Google DeepMind som bearbetar och genererar text, bilder, ljud och video. Den representerar Googles efterföljare till LaMDA och PaLM 2, utformad för att förstå och resonera över flera datatyper samtidigt och driver Gemini AI-chattboten samt är integrerad i Googles ekosystem av produkter och tjänster.

Google Gemini är en familj av multimodala stora språkmodeller (LLM:er) utvecklade av Google DeepMind, och representerar efterföljaren till tidigare modeller som LaMDA och PaLM 2. Till skillnad från traditionella språkmodeller som endast bearbetar text är Gemini från grunden utformad för att hantera flera datamodaliteter samtidigt, inklusive text, bilder, ljud, video och programkod. Modellen driver Gemini AI-chattboten (tidigare känd som Bard) och integreras alltmer i Googles ekosystem av produkter och tjänster. Geminis multimodala arkitektur gör det möjligt att förstå komplexa relationer mellan olika typer av information, vilket gör modellen kapabel för uppgifter från bildanalys och kodgenerering till realtidsöversättning och dokumentförståelse. Namnet “Gemini” kommer från latinets “tvillingar” och syftar på samarbetet mellan Google DeepMind och Google Brain-teamet, samt inspirerades av NASAs rymdprogram Project Gemini.

Googles resa mot att skapa Gemini återspeglar åratal av grundläggande forskning inom stora språkmodeller och neurala nätverksarkitekturer. År 2017 introducerade Google-forskare transformerarkitekturen, en banbrytande neural nätverksdesign som blev grunden för de flesta moderna LLM:er. Företaget utvecklade därefter Meena (2020), en konversations-AI med 2,6 miljarder parametrar, följt av LaMDA (Language Model for Dialogue Applications) 2021, som specialiserade sig på dialoguppgifter. Lanseringen av PaLM (Pathways Language Model) 2022 medförde förbättrade kodnings-, flerspråkiga och resonemangsförmågor. Google lanserade sedan Bard i början av 2023, initialt driven av en lättviktsvariant av LaMDA, innan uppgraderingen till PaLM 2 i mitten av 2023. Företaget tillkännagav officiellt Gemini 1.0 i december 2023, vilket markerade ett stort steg inom multimodala kapaciteter. År 2024 bytte Google namn på Bard till Gemini och släppte Gemini 1.5, som introducerade ett revolutionerande kontextfönster på 2 miljoner token. De senaste versionerna, Gemini 2.0 och Gemini 2.5 (släppta i december 2024), introducerade agentiska AI-förmågor, vilket gör det möjligt för modellen att agera autonomt och resonera över utökade kontexter. Denna utveckling visar Googles engagemang för att driva AI-kapaciteter framåt med bibehållet fokus på praktiska och verkliga tillämpningar.

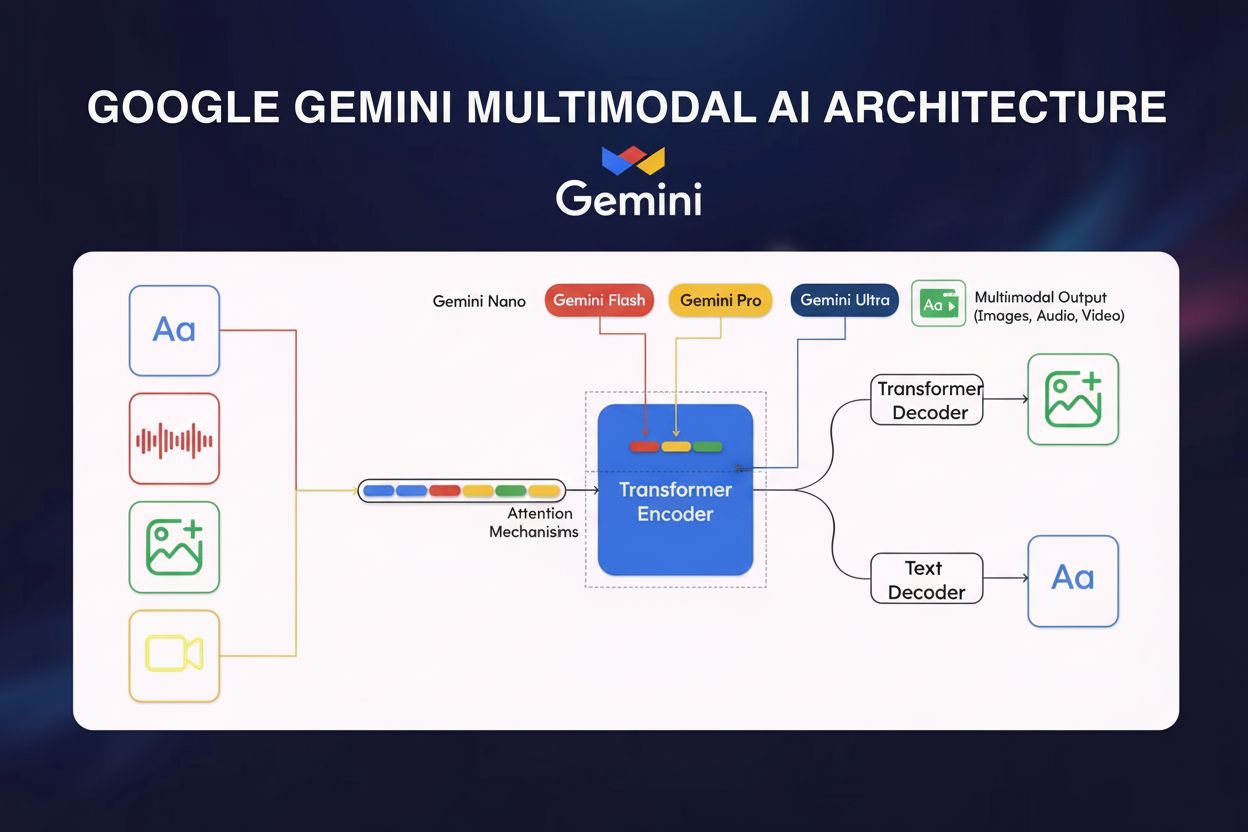

Den tekniska grunden för Google Gemini vilar på flera sofistikerade arkitektoniska innovationer som skiljer den från konkurrerande modeller. I sin kärna använder Gemini en transformerbaserad neural nätverksarkitektur optimerad med Cloud TPU v5p (Tensor Processing Units) för högpresterande träning och inferens. Modellens multimodala kodare integrerar visuella data, tal och text via specialiserade bearbetningsvägar som sammanförs till ett enhetligt representationsutrymme. En viktig innovation är tvärmodal uppmärksamhetsmekanism, som gör det möjligt för modellen att skapa meningsfulla kopplingar mellan olika datatyper—till exempel att länka visuella element i en bild till textbeskrivningar eller förstå hur ljudinnehåll relaterar till visuell kontext. Gemini 1.5 Pro introducerade Mixture of Experts (MoE)-arkitekturen, vilket innebär ett paradigmskifte inom modeleffektivitet. Istället för att aktivera alla neurala nätverksparametrar för varje indata delar MoE modellen i mindre expertnätverk som var och en är specialiserad på specifika domäner eller datatyper. Modellen lär sig att selektivt aktivera endast de mest relevanta experterna beroende på indata, vilket avsevärt minskar beräkningsbördan samtidigt som prestandan bibehålls eller förbättras. Denna arkitektur gör att Gemini 1.5 Flash kan uppnå likvärdig prestanda som Gemini 1.0 Ultra men med betydligt högre effektivitet, uppnått genom kunskapsdestillering—en maskininlärningsteknik där insikter från den större Pro-modellen förs över till den mer kompakta Flash-varianten. Kontextfönstret—antalet token en modell kan bearbeta samtidigt—har utökats dramatiskt: från 32 000 token i Gemini 1.0 till 1 miljon token i Gemini 1.5 Flash och 2 miljoner token i Gemini 1.5 Pro, vilket möjliggör bearbetning av hela böcker, långa videor eller tusentals rader kod i en enda interaktion.

| Modellvariant | Storlek/Nivå | Kontextfönster | Primära användningsområden | Distribution | Nyckelfördel |

|---|---|---|---|---|---|

| Gemini 1.0 Nano | Minst | 32 000 token | Mobila uppgifter, bearbetning på enheten, bildbeskrivning, chattsvar | Android-enheter (Pixel 8 Pro+), Chrome desktop | Körs utan internetanslutning |

| Gemini 1.0 Ultra | Störst | 32 000 token | Komplexa resonemang, avancerad kodning, matematisk analys, multimodalt resonemang | Molnbaserad, företag | Högsta noggrannhet i tester |

| Gemini 1.5 Pro | Mellanstor | 2 miljoner token | Dokumentanalys, kodförråd, långformigt innehåll, företagsapplikationer | Google Cloud, API-åtkomst | Längsta kontextfönster, balanserad prestanda |

| Gemini 1.5 Flash | Lättvikt | 1 miljon token | Snabba svar, kostnadseffektiv bearbetning, realtidsapplikationer | Moln, mobil, edge | Optimerad för hastighet och effektivitet |

| Gemini 2.0/2.5 | Nästa generation | Variabelt | Agentiska AI, autonom uppgiftsutförande, avancerat resonemang, realtidsinteraktioner | Moln, integrerade tjänster | Agentiska förmågor, förbättrat resonemang |

Den multimodala naturen i Google Gemini innebär ett grundläggande avsteg från tidigare AI-modeller som främst arbetade inom enskilda modaliteter. Geminis förmåga att bearbeta växlande sekvenser av ljud, bild, text och video som både indata och utdata möjliggör sofistikerade resonemangsuppgifter som skulle vara omöjliga för enkelmodalitetsmodeller. Exempelvis kan Gemini analysera en video, extrahera relevant text från bilder, förstå talade dialoger och generera omfattande sammanfattningar som sammanfogar information från alla modaliteter. Denna kapacitet har djupgående konsekvenser för verkliga tillämpningar: inom medicinsk diagnostik kan Gemini samtidigt analysera patientjournaler (text), medicinska bilder (visuellt) och patientintervjuer (ljud) för att ge heltäckande bedömningar. Inom kundservice kan modellen bearbeta kundfrågor (text), analysera produktbilder, granska videodemonstrationer och generera kontextuellt lämpliga svar. Den tvärmodala uppmärksamhetsmekanismen som möjliggör denna integration fungerar genom att skapa gemensamma representationer där information från olika modaliteter påverkar varandras bearbetning. Vid analys av en bild med tillhörande text hjälper textkontexten till att fokusera den visuella bearbetningsvägen på relevanta bildområden, medan visuell information hjälper till att klargöra textreferenser. Detta ömsesidiga inflytande ger en mer holistisk förståelse än vad som vore möjligt om modaliteterna bearbetades oberoende. De praktiska konsekvenserna för AI-övervakning och varumärkesspårning är betydande: när Gemini genererar svar som inkluderar bilder, text och eventuellt ljud måste övervakningssystem kunna spåra hur varumärken syns över alla dessa modaliteter, inte bara i textbaserade svar.

Google Gemini Ultra har visat exceptionell prestanda över flera standardiserade AI-benchmarktester och etablerat sig som en mycket kapabel modell i det konkurrensutsatta landskapet för stora språkmodeller. På MMLU-benchmarken (Massive Multitask Language Understanding), som testar språkförståelse över 57 olika ämnen, överträffade Gemini Ultra till och med mänskliga experter—en betydande milstolpe inom AI-utveckling. För matematiskt resonemang (GSM8K-benchmarken) överträffade Gemini Ultra konkurrenter som Claude 2, GPT-4 och Llama 2. Inom kodgenerering (HumanEval-benchmarken) visade Gemini överlägsna förmågor och möjliggjorde avancerad programmeringsassistans och kodanalys. Dock varierar prestandan över olika utvärderingsmått: medan Gemini Ultra excellerar i dokumentförståelse, bildförståelse och automatisk taligenkänning, ses mer blygsamma förbättringar inom områden som sunt förnuft-resonemang (HellaSwag-benchmarken), där GPT-4 fortfarande är ledande. Gemini 1.5-serien har varit särskilt imponerande, där både Flash- och Pro-varianterna matchar eller överträffar Gemini 1.0 Ultra-prestanda samtidigt som de erbjuder dramatiskt förbättrad effektivitet och utökade kontextfönster. Denna utveckling är särskilt relevant för AI-citeringsövervakning: när Geminis kapacitet förbättras och användarbasen växer till 350 miljoner månatliga aktiva användare påverkar svarens noggrannhet och omfattning direkt hur varumärken och domäner representeras i AI-genererat innehåll. Organisationer som använder plattformar som AmICited kan spåra om Geminis svar om deras varumärke är faktamässigt korrekta och lämpligt kontextualiserade.

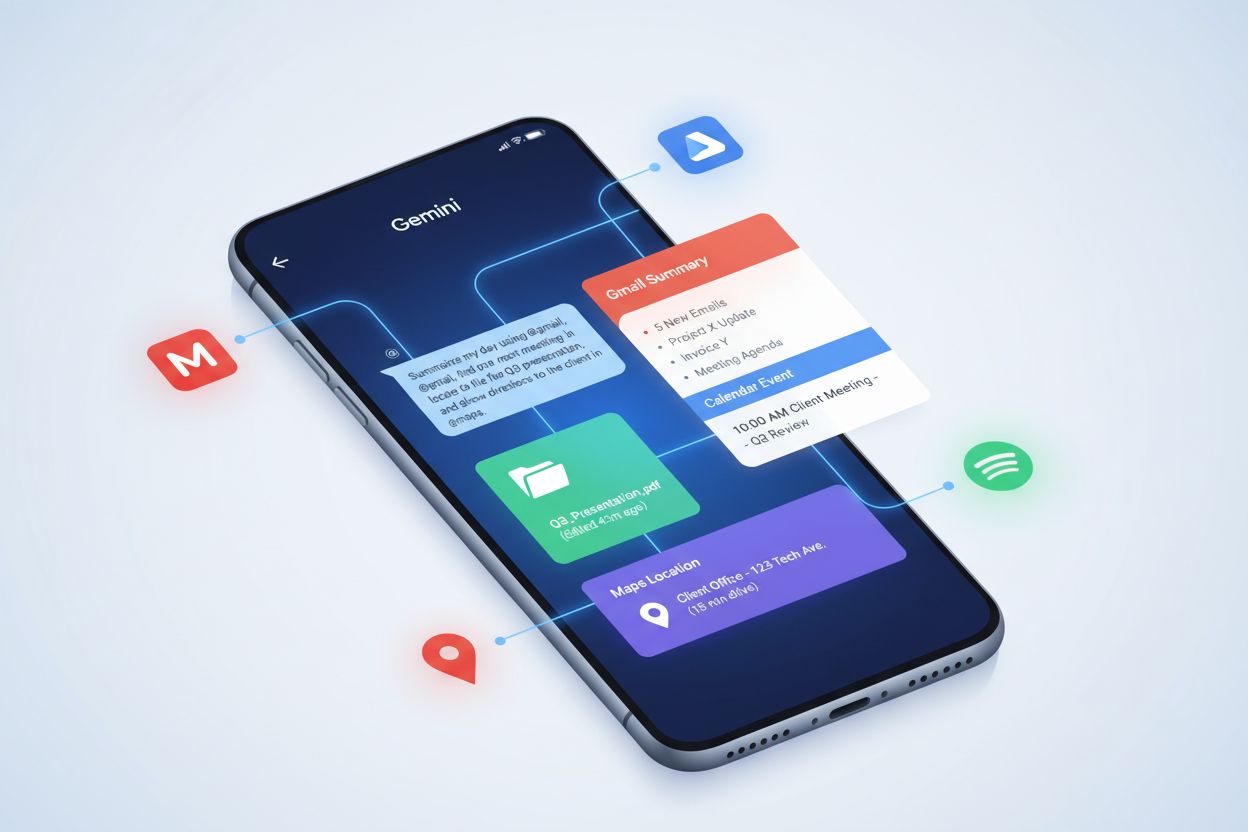

Den strategiska integrationen av Google Gemini i hela Googles produktekosystem är en av de mest omfattande införandena av en AI-modell i ett teknikföretags utbud. Gemini är nu standard-AI-assistenten på Google Pixel 9 och Pixel 9 Pro-smartphones, och ersätter tidigare Google Assistant, vilket gör den till det primära AI-gränssnittet för miljontals användare. Inom Google Workspace finns Gemini i sidopanelen i Dokument för att hjälpa till med skrivande och redigering, i Gmail för att föreslå och skriva utkast, samt i andra produktivitetsapplikationer. Google Maps använder Geminis kapacitet för att tillhandahålla intelligenta sammanfattningar av platser och områden, vilket förbättrar användarupplevelsen med kontextuell information. Google Sök har integrerat Gemini via AI Overviews, som genererar heltäckande svar genom att sammanfatta information från flera källor. Gemini API är tillgängligt via Google AI Studio och Google Cloud Vertex AI, vilket gör det möjligt för utvecklare att integrera Geminis kapacitet i egna applikationer. Denna ekosystemintegration har djupgående konsekvenser för varumärkesövervakning och AI-citeringsspårning. När en användare söker information om ett företag eller en produkt i Google Sök kan Gemini generera en AI Overview som inkluderar eller utesluter varumärkesomnämnanden. När någon använder Gmail med Gemini kan modellen referera till företagsinformation i föreslagna svar. När utvecklare bygger applikationer med Gemini API skapas nya beröringspunkter där varumärken kan synas i AI-genererat innehåll. Denna omfattande integration gör det nödvändigt med övergripande övervakning över alla dessa plattformar för att upprätthålla varumärkesintegritet och säkerställa korrekt återgivning i AI-svar.

Framväxten av Google Gemini som en stor AI-plattform med 350 miljoner månatliga aktiva användare har skapat nya krav för varumärkesövervakning och AI-citeringsspårning. Till skillnad från traditionella sökmotorer där varumärken syns i rankade resultatlistor genererar Gemini syntetiserade svar som kanske eller kanske inte nämner specifika företag, produkter eller domäner. När en användare frågar Gemini om en viss bransch eller ett ämne bestämmer modellen vilka källor som refereras, vilken information som lyfts fram och hur varumärkesomnämnanden kontextualiseras. Detta innebär ett betydande skifte från traditionell SEO, där synlighet beror på ranking, till vad som kan kallas “AI-citeringsoptimering”—att säkerställa att varumärken syns korrekt och lämpligt i AI-genererade svar. Den multimodala naturen i Gemini gör övervakningen mer komplex: varumärken kan förekomma inte bara i textsvar utan även i bilder, ljudtranskriptioner eller videoreferenser som Gemini genererar. Geminis integration över Googles ekosystem innebär att varumärkesomnämnanden kan ske i flera sammanhang: i Google Sök AI Overviews, i Gmail-förslag, i Google Maps-sammanfattningar och i anpassade applikationer byggda med Gemini API. Organisationer måste förstå hur Gemini representerar deras varumärke i dessa olika sammanhang och om informationen som ges är korrekt, fullständig och lämpligt kontextualiserad. Plattformar som AmICited tillgodoser detta behov genom att övervaka hur varumärken syns i Geminis svar tillsammans med andra AI-plattformar som ChatGPT, Perplexity, Claude och Google AI Overviews, och ger övergripande insyn i AI-genererad varumärkesrepresentation.

Trots sina imponerande kapaciteter står Google Gemini inför flera dokumenterade utmaningar som organisationer måste beakta när de förlitar sig på dess svar. AI-bias blev en betydande fråga i februari 2024 när Google pausade Geminis bildgenereringsfunktion på grund av felaktiga och partiska framställningar av historiska personer, där modellen raderade historisk kontext kring raslig mångfald. Denna händelse visade hur multimodala AI-system kan förstärka eller förvärra bias som finns i träningsdata. Hallucinationer—fall där modellen genererar faktamässigt felaktig information—fortsätter att påverka Gemini, särskilt i AI Overviews där användare kan lita på syntetiserad information utan verifiering. Google har erkänt pågående problem med att Gemini-baserade sökresultat ibland ger felaktiga eller vilseledande svar. Immaterialrättsliga överträdelser är ytterligare en oro: Google fick böter i Frankrike (250 miljoner euro) för att ha tränat Gemini på upphovsrättsskyddat nyhetsinnehåll utan utgivares vetskap eller samtycke, vilket väcker frågor om datakällor och rättvis användning. Dessa begränsningar har direkt betydelse för varumärkesövervakning: organisationer kan inte anta att informationen Gemini ger om konkurrenter eller branschämnen är korrekt, och de måste verifiera hur deras eget varumärke representeras. Risken att Gemini genererar vilseledande information om ett företags produkter, historia eller marknadsposition innebär utmaningar som traditionell sökmotorövervakning inte kan lösa. Dessutom tenderar modellen att syntetisera information från flera källor utan att alltid tydligt ange ursprung, vilket gör att varumärkesomnämnanden i Gemini-svar kan sakna rätt kontext eller källhänvisning.

Utvecklingsbanan för Google Gemini antyder fortsatt expansion av kapaciteter, effektivitet och integration över Googles ekosystem och bortom. Gemini 2.0 och 2.5 introducerade agentiska AI-förmågor, vilket gör att modellen kan agera autonomt, planera flerstegsuppgifter och resonera över utökade kontexter—en betydande utveckling från tidigare versioner som främst svarade på användarfrågor. Framtida versioner förväntas ytterligare förfina resonemangsförmågor, hantera ännu större kontextfönster och förbättra prestanda inom specialiserade områden. Project Astra, Googles initiativ för att bygga universella AI-agenter, representerar den långsiktiga visionen för Gemini: AI-system som kan bearbeta, minnas och förstå multimodal information i realtid för mer naturliga och kapabla interaktioner. Project Mariner och andra forskningsinitiativ antyder att Google utforskar hur Gemini kan hjälpa till med komplex kunskapsarbete och potentiellt automatisera forskning, analys och beslutsfattande. Integrationen av Gemini i fler Google-produkter och tjänster lär fortsätta och breddar de tillfällen där varumärken syns i AI-genererade svar. Effektivitetsförbättringar på enheten gör Gemini mer tillgänglig på mobila enheter och edge-plattformar, vilket potentiellt ökar användarbasen bortom nuvarande 350 miljoner månatliga aktiva användare. Det konkurrensutsatta landskapet kommer också att påverka Geminis utveckling: när andra AI-plattformar som ChatGPT, Claude och Perplexity fortsätter utvecklas måste Google bibehålla Geminis konkurrensfördelar inom multimodal bearbetning, integration med Google-tjänster och realtidsåtkomst till kunskap. För organisationer med fokus på AI-övervakning och varumärkesrepresentation innebär denna utveckling att spårningen av hur varumärken syns i Geminis svar blir allt viktigare när plattformens kapacitet växer och användarbasen ökar. Övergången till agentisk AI väcker också nya frågor om hur autonoma AI-system kommer att representera och referera till varumärken när de fattar beslut eller agerar på användares vägnar.

Google Gemini innebär ett grundläggande skifte i hur AI-system bearbetar information och genererar svar, med djupgående konsekvenser för varumärkesövervakning och AI-citeringsspårning. Som en multimodal AI-modell med 350 miljoner månatliga aktiva användare, integrerad över Googles ekosystem och ständigt utvecklande mot mer kapabla agentiska system, har Gemini blivit en kritisk plattform att övervaka för organisationer. Till skillnad från traditionella sökmotorer där synlighet beror på rankning skapar Geminis syntetiserade svar nya dynamiker där varumärken kan nämnas eller utelämnas, och när de nämns kan de representeras korrekt eller felaktigt. Modellens dokumenterade begränsningar—inklusive bias, hallucinationer och immaterialrättsliga frågor—understryker vikten av aktiv övervakning snarare än passiv tillit till AI-genererad information. Organisationer som vill upprätthålla varumärkesintegritet och säkerställa korrekt representation i AI-svar måste använda heltäckande övervakningsstrategier för att spåra hur deras varumärke syns över Gemini och andra stora AI-plattformar. Detta utgör en ny gräns i digital marknadsföring och varumärkeshantering, där framgång inte längre bara handlar om traditionell SEO och söksynlighet, utan om att förstå och optimera hur AI-system representerar och refererar till varumärken i sina genererade svar.

Google Gemini är från grunden utformad som en multimodal AI-modell som samtidigt bearbetar text, bilder, ljud och video, medan ChatGPT främst fokuserar på textbaserade interaktioner och Claude betonar säkerhet och etiskt resonemang. Geminis integration med Googles ekosystem, inklusive Google Sök, Workspace och Molntjänster, ger unika fördelar för företagsanvändare. Dessutom möjliggör Geminis Mixture of Experts (MoE)-arkitektur selektiv aktivering av specialiserade neurala nätverk, vilket gör modellen mer effektiv för varierade uppgifter jämfört med traditionella transformer-baserade lösningar som används av konkurrenterna.

Google Gemini har nått 350 miljoner månatliga aktiva användare från och med 2024, vilket visar på snabb anpassning över Googles konsument- och företagsprodukter. Plattformen driver 1,5 miljarder månatliga interaktioner genom Googles integrerade tjänster. Dagliga aktiva användare ökade från 9 miljoner i oktober 2024 till 35 miljoner i april 2025, vilket visar på en accelererande tillväxttakt. Denna tillväxtposition gör Gemini till en av de snabbast växande AI-plattformarna globalt, även om den fortfarande ligger efter vissa konkurrenter på vissa marknader.

Google Gemini finns i flera versioner optimerade för olika användningsområden: Gemini 1.0 Nano (minst, för mobila enheter med 32K token-kontekst), Gemini 1.0 Ultra (störst, för komplexa uppgifter med 32K token-kontekst), Gemini 1.5 Pro (mellanstor med 2 miljoner token-kontekstfönster) och Gemini 1.5 Flash (lättviktsversion med 1 miljon token-kontekst). De senaste Gemini 2.0 och 2.5-modellerna introducerar agentiska AI-förmågor och förbättrat resonemang. Varje version är utformad för specifika distributionsscenarier, från bearbetning på enheten till molntjänster i företagsklass.

Gemini bearbetar flera datatyper genom en enhetlig transformerarkitektur med specialiserade kodare för varje modalitet (text, bild, ljud, video). Modellen använder tvärmodal uppmärksamhetsmekanism för att länka information mellan olika format, vilket gör det möjligt att förstå relationer mellan till exempel textbeskrivningar och visuellt innehåll. Till skillnad från modeller som kräver separata bearbetningskedjor för olika datatyper, möjliggör Geminis inbyggda multimodala design sekvenser av olika modaliteter som både in- och utdata, vilket gör den effektivare och mer kapabel för komplexa resonemangsuppgifter.

Mixture of Experts-arkitekturen i Gemini 1.5 Pro delar upp modellen i mindre specialiserade neurala nätverk, där varje fungerar som en 'expert' inom specifika domäner eller datatyper. Modellen lär sig att selektivt aktivera endast de mest relevanta experterna baserat på indata, vilket resulterar i snabbare prestanda och minskade beräkningskostnader. Detta tillvägagångssätt gör att Gemini kan skalas effektivt utan proportionerligt ökade beräkningskrav, vilket gör den lämplig både för resursbegränsade mobila enheter och storskaliga företagsimplementeringar.

Google Gemini integreras systematiskt i hela sitt produktekosystem: det är standard-AI-assistenten på Google Pixel 9-telefoner, tillgänglig i Google Workspace för dokumentredigering och e-postutkast, integrerad i Google Maps för platsöversikter och driver Google Sök AI Overviews. Gemini API är tillgängligt via Google AI Studio och Google Cloud Vertex AI för utvecklare. Denna omfattande integration gör Gemini till en kritisk komponent för att spåra varumärkesomnämnanden i AI-genererade svar över Googles plattformar, vilket är särskilt relevant för AI-övervakning och citeringsspårning.

Google Gemini står inför flera dokumenterade utmaningar, inklusive AI-biasproblem (Google pausade bildgenerering i februari 2024 på grund av felaktiga representationer av historiska personer), hallucinationer som genererar faktamässigt felaktiga svar i AI Overviews och immaterialrättsliga frågor (Google fick böta 250 miljoner euro i Frankrike för att ha tränat på upphovsrättsskyddat nyhetsinnehåll utan utgivarens samtycke). Dessa begränsningar belyser vikten av att övervaka hur Gemini representerar varumärken och domäner i AI-genererade svar, vilket gör verktyg som AmICited nödvändiga för att spåra korrekthet och varumärkessäkerhet.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur du optimerar ditt innehåll för Google Gemini och andra AI-sökmotorer. Bemästra strategier för Answer Engine Optimization (AEO) för att öka varumärke...

Lär dig vad Gemini-tillägg är, hur de fungerar och hur de möjliggör AI-driven produktivitet genom att koppla Gemini till Gmail, Drive, Maps och andra tjänster. ...

Lär dig hur du optimerar ditt varumärke för Google Gemini-citat. Upptäck beprövade strategier för att öka synligheten i AI-genererade svar när 52,15 % av Gemini...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.