Content SEO

Content SEO är den strategiska skapandet och optimeringen av högkvalitativt innehåll för att förbättra sökmotorrankningar och organisk synlighet. Lär dig hur du...

JavaScript SEO är processen att optimera JavaScript-renderade webbplatser för att säkerställa att sökmotorer effektivt kan crawla, rendera och indexera innehåll. Det omfattar bästa praxis för att göra JavaScript-drivna webbapplikationer upptäckbara och rankningsbara i sökresultat, samtidigt som optimal prestanda och användarupplevelse bibehålls.

JavaScript SEO är processen att optimera JavaScript-renderade webbplatser för att säkerställa att sökmotorer effektivt kan crawla, rendera och indexera innehåll. Det omfattar bästa praxis för att göra JavaScript-drivna webbapplikationer upptäckbara och rankningsbara i sökresultat, samtidigt som optimal prestanda och användarupplevelse bibehålls.

JavaScript SEO är den specialiserade praktiken att optimera JavaScript-renderade webbplatser för att säkerställa att sökmotorer effektivt kan crawla, rendera och indexera innehåll. Det omfattar en omfattande uppsättning tekniska strategier, bästa praxis och implementeringsmetoder utformade för att göra JavaScript-drivna webbapplikationer fullt upptäckbara och rankningsbara i sökresultat. Till skillnad från traditionella HTML-baserade webbplatser där innehållet omedelbart är tillgängligt i serversvaret, kräver JavaScript-renderat innehåll ytterligare bearbetningssteg som kan påverka hur sökmotorer förstår och rankar dina sidor avsevärt. Disciplinen kombinerar teknisk SEO-expertis med förståelse för hur moderna webb-ramverk som React, Vue och Angular interagerar med sökmotorers crawlers. JavaScript SEO har blivit allt viktigare i och med att 98,7% av webbplatser nu innehåller någon form av JavaScript, vilket gör det till nödvändig kunskap för alla SEO-proffs som arbetar med moderna webbteknologier.

Framväxten av JavaScript-ramverk har fundamentalt förändrat hur webbplatser byggs och hur sökmotorer måste bearbeta dem. Under webben första dagar tolkade Googlebot helt enkelt HTML-svar från servrar, vilket gjorde SEO rakt på sak—det innehåll som fanns i HTML indexerades. Men när utvecklare tog till sig client-side rendering för att skapa mer interaktiva och dynamiska användarupplevelser, stod sökmotorerna inför en stor utmaning: Innehållet fanns inte längre i det initiala HTML-svaret utan genererades av JavaScript-körning i webbläsaren. Denna förändring skapade ett betydande glapp mellan vad användarna såg och vad sökmotorerna initialt kunde komma åt. Google svarade genom att utveckla headless Chromium-renderingsförmåga, vilket gjorde det möjligt för Googlebot att köra JavaScript och bearbeta det renderade DOM:et. Renderingsprocessen är dock resurskrävande—ungefär 100 gånger dyrare än att bara tolka HTML—vilket innebär att Google inte kan rendera varje sida omedelbart. Denna resursbegränsning skapade begreppet renderingsbudget, där sidor köas för rendering baserat på förväntad betydelse och söktrafikpotential. Att förstå denna utveckling är avgörande eftersom det förklarar varför JavaScript SEO inte är valfritt utan snarare en grundläggande del av modern teknisk SEO-strategi.

Googles tillvägagångssätt för JavaScript-renderat innehåll följer en sofistikerad trestegsprocess som fundamentalt skiljer sig från traditionell HTML-crawling. I crawling-fasen begär Googlebot en URL och får det initiala HTML-svaret. Det tolkas omedelbart för att extrahera länkar och kontrollera indexeringsdirektiv som robots meta-taggar och noindex-deklarationer. Kritisk är att om en sida innehåller en noindex-tagg i initial HTML, kommer Google inte att fortsätta till rendering—detta är en viktig skillnad som många SEO:er missar. Samtidigt köas URL:en för renderingsfasen, där Web Rendering Service (WRS) använder headless Chromium för att köra JavaScript, bygga DOM och generera den fullt renderade HTML:en. Detta steg kan ta sekunder eller längre beroende på JavaScripts komplexitet, och sidor kan vänta länge i renderingskön om Googles resurser är begränsade. Slutligen, i indexeringsfasen, bearbetar Google den renderade HTML:en för att extrahera innehåll, länkar och metadata för att inkluderas i sökindexet. Den kritiska insikten här är att Google indexerar baserat på renderad HTML, inte det initiala svar-HTML—vilket innebär att JavaScript helt kan ändra vad som indexeras. Denna trestegsprocess förklarar varför JavaScript-sajter ofta upplever långsammare indexering, varför renderingsfördröjningar spelar roll och varför det är viktigt att jämföra svar-HTML med renderad HTML för att diagnostisera JavaScript SEO-problem.

| Renderingsmetod | Hur den fungerar | SEO-fördelar | SEO-nackdelar | Bäst för |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Innehållet renderas fullt ut på servern innan det levereras till klienten | Innehåll omedelbart tillgängligt i initial HTML; snabb indexering; inga renderingsfördröjningar; stöder alla crawlers | Högre serverbelastning; långsammare Time to First Byte (TTFB); komplex implementation | SEO-kritiska webbplatser, e-handel, innehållstunga sajter, nyhetspublicister |

| Client-Side Rendering (CSR) | Servern skickar minimal HTML; JavaScript renderar innehåll i webbläsaren | Minskad serverbelastning; bättre skalbarhet; snabbare sidövergångar för användare | Fördröjd indexering; kräver rendering; osynligt för LLM-crawlers; långsammare initial laddning; förbrukar crawlbudget | Webbapplikationer, dashboards, innehåll bakom inloggning, sajter utan SEO-beroende |

| Dynamisk rendering | Servern upptäcker crawlers och levererar för-renderad HTML; användare får CSR | Innehåll omedelbart tillgängligt för crawlers; balanserar bot- och användarupplevelse; enklare än SSR | Komplex installation; verktygsberoende; potentiell cloaking-risk; kräver bot-detektering; tillfällig lösning | Stora JavaScript-tunga sajter, SPAs som behöver sökbarhet, övergångslösning |

| Static Site Generation (SSG) | Innehållet för-renderas vid build-tillfället; levereras som statisk HTML | Snabbast prestanda; optimal SEO; inga renderingsfördröjningar; utmärkta Core Web Vitals | Begränsat dynamiskt innehåll; kräver ombyggnad för uppdateringar; ej lämpligt för realtidsdata | Bloggar, dokumentation, marknadssajter, innehåll som sällan ändras |

JavaScript-renderade webbplatser har flera tekniska hinder som direkt påverkar SEO-prestanda och sökbarhet. Den mest grundläggande utmaningen är renderingsfördröjning—eftersom rendering är resurskrävande kan Google fördröja rendering av sidor i timmar eller dagar, vilket innebär att ditt innehåll inte indexeras omedelbart efter publicering. Detta är särskilt problematiskt för tidskritiskt innehåll som nyhetsartiklar eller produktlanseringar. Ett annat viktigt problem är soft 404-fel, som uppstår när single-page-applikationer returnerar en 200 HTTP-statuskod även för icke-existerande sidor, vilket förvirrar sökmotorer om vilka sidor som ska indexeras. JavaScript-baserade ändringar av kritiska element är ett annat stort hinder: när JavaScript ändrar titlar, kanoniska taggar, meta robots-direktiv eller interna länkar efter det initiala HTML-svaret kan sökmotorer indexera fel versioner eller missa viktiga SEO-signaler. Problemet med crawlbudget-förbrukning är särskilt allvarligt för stora sajter—JavaScript-filer är stora och resurskrävande, vilket innebär att Google lägger mer resurser på att rendera färre sidor och därmed begränsar djupet på din crawl. Dessutom kör LLM-crawlers och AI-söktjänster inte JavaScript, vilket gör JavaScript-enbart innehåll osynligt för nya AI-sökmotorplattformar som Perplexity, Claude och andra. Statistik visar att 31,9% av SEO:er inte är säkra på hur man avgör om en webbplats är betydligt JavaScript-beroende, och 30,9% känner sig inte bekväma med att undersöka JavaScript-orsakade SEO-problem, vilket belyser kunskapsluckan i branschen.

Optimering av JavaScript-renderat innehåll kräver ett mångfacetterat tillvägagångssätt som omfattar både teknisk implementering och strategiska beslut. Den första och viktigaste bästa praxisen är att inkludera väsentligt innehåll i det initiala HTML-svaret—titlar, meta-beskrivningar, kanoniska taggar och kritiskt brödtextinnehåll bör finnas i serversvaret innan JavaScript körs. Detta säkerställer att sökmotorer får ett komplett första intryck av din sida och inte behöver vänta på rendering för att förstå sidans innehåll. Undvik att blockera JavaScript-filer i robots.txt, eftersom detta hindrar Google från att rendera dina sidor korrekt; tillåt istället åtkomst till alla JavaScript-resurser som behövs för rendering. Implementera korrekta HTTP-statuskoder—använd 404 för obefintliga sidor och 301-omdirigeringar för flyttat innehåll istället för att förlita dig på JavaScript för att hantera dessa scenarier. För single-page-applikationer, använd History API istället för URL-fragment för att säkerställa att varje vy har en unik, crawlbar URL; fragment som #/products är opålitliga för sökmotorer. Minimera och deferrera icke-kritiskt JavaScript för att minska renderingstiden och förbättra Core Web Vitals—använd koddelning för att ladda endast nödvändigt JavaScript på varje sida. Implementera lazy loading för bilder med den inbyggda loading="lazy"-attributet istället för JavaScript-baserade lösningar, så att sökmotorer kan hitta bilder utan rendering. Använd innehållshashning i JavaScript-filnamn (t.ex. main.2a846fa617c3361f.js) så att Google vet när koden har ändrats och behöver hämtas igen. Testa din implementation noggrant med Google Search Consoles URL-inspektionsverktyg, Screaming Frog med rendering aktiverad eller Sitebulbs Response vs Render-rapport för att jämföra initial HTML med renderad HTML och identifiera avvikelser.

Att välja rätt renderingsmetod är ett av de mest avgörande besluten för JavaScript SEO. Server-Side Rendering (SSR) är guldstandarden för SEO-kritiska webbplatser eftersom innehållet är fullt renderat på servern innan leverans, vilket eliminerar renderingsfördröjningar och säkerställer att alla crawlers kan komma åt innehållet. Ramverk som Next.js och Nuxt.js gör SSR-implementering mer tillgänglig för moderna utvecklingsteam. SSR kräver dock mer serverresurser och kan leda till långsammare Time to First Byte (TTFB), vilket påverkar användarupplevelsen. Client-Side Rendering (CSR) passar webbapplikationer där SEO inte är huvudfokus, t.ex. dashboards, verktyg bakom inloggning eller interna applikationer. CSR minskar serverbelastningen och möjliggör mycket interaktiva användarupplevelser, men skapar indexeringsfördröjningar och gör innehållet osynligt för LLM-crawlers. Dynamisk rendering fungerar som en pragmatisk mellanväg: den upptäcker sökmotorers crawlers och levererar dem för-renderad HTML medan användare får den interaktiva CSR-upplevelsen. Verktyg som Prerender.io hanterar detta automatiskt, men Google säger uttryckligen att detta är en tillfällig lösning och rekommenderar att man på sikt går mot SSR. Static Site Generation (SSG) är optimalt för innehåll som inte ändras ofta—det för-renderas vid build-tillfället och levereras som statisk HTML, vilket ger bästa prestanda och SEO-karaktäristika. Beslutet bör baseras på din webbplats SEO-prioriteringar, tekniska resurser och hur ofta innehållet uppdateras. Data visar att 60% av SEO:er nu använder JavaScript-crawlers för revisioner, vilket indikerar ökad medvetenhet om att rendering måste beaktas i teknisk SEO-analys.

Effektiv JavaScript SEO kräver kontinuerlig övervakning av specifika mätvärden och indikatorer som visar hur sökmotorer interagerar med ditt JavaScript-renderade innehåll. Jämförelse mellan svar- och renderad HTML är grundläggande—med verktyg som Sitebulbs Response vs Render-rapport kan du exakt se vad JavaScript ändrar på dina sidor, inklusive ändringar av titlar, meta-beskrivningar, kanoniska taggar, interna länkar och robots-direktiv. Statistik visar att 18,26% av JavaScript-crawls har H1-taggar endast i renderad HTML (ej i initialt svar), och kritiskt, 4,60% av JavaScript-revisioner visar noindex-taggar endast i svar-HTML—ett mardrömsscenario där Google ser noindex och aldrig renderar sidan, vilket förhindrar indexering av innehåll du vill ha indexerat. Renderingsbudget-förbrukning bör övervakas via Google Search Consoles Täckningsrapport, som visar hur många sidor som köats för rendering jämfört med redan renderade. Core Web Vitals är särskilt viktiga för JavaScript-sajter eftersom JavaScript-körning direkt påverkar Largest Contentful Paint (LCP), First Input Delay (FID) och Cumulative Layout Shift (CLS). Övervaka indexeringslatens—hur lång tid efter publicering tar det innan ditt innehåll syns i Googles index—eftersom JavaScript-sajter vanligtvis har längre fördröjningar än HTML-sajter. Spåra crawl-effektivitet genom att jämföra antal crawlande sidor mot totala sidor på sajten; JavaScript-sajter har ofta lägre crawl-effektivitet p.g.a. resursbegränsningar. Använd Google Search Consoles URL-inspektionsverktyg för att verifiera att kritiskt innehåll syns i den renderade HTML som Google bearbetar, inte bara i det initiala svaret.

Framväxten av AI-drivna sökplattformar som Perplexity, ChatGPT, Claude och Google AI Overviews har skapat en ny dimension för JavaScript SEO som sträcker sig bortom traditionella sökmotorer. De flesta LLM-crawlers kör inte JavaScript—de använder rå HTML och DOM-innehåll så som det visas i det initiala serversvaret. Det innebär att om ditt kritiska innehåll, produktinformation eller varumärkesbudskap endast syns efter JavaScript-körning, är det helt osynligt för AI-sökverktyg. Detta skapar ett dubbelt synlighetsproblem: innehåll som är osynligt för LLM-crawlers kommer inte att citeras i AI-svar, och användare som söker genom AI-plattformar hittar inte ditt innehåll. För AmICited-användare som övervakar varumärkes- och domännärvaro i AI-svar är detta särskilt kritiskt—om ditt JavaScript-renderade innehåll inte är tillgängligt för LLM-crawlers syns du inte i AI-citeringar alls. Lösningen är att säkerställa att väsentligt innehåll finns i det initiala HTML-svaret, så det är tillgängligt för både traditionella sökmotorer och AI-crawlers. Därför blir Server-Side Rendering eller Dynamisk rendering ännu viktigare i AI-sök-eran—du måste göra ditt innehåll synligt, inte bara för Googlebot utan även för det växande ekosystemet av AI-sökverktyg som inte kör JavaScript.

Landskapet för JavaScript SEO fortsätter att utvecklas i takt med att både sökmotorer och webbtekniker gör framsteg. Google har gjort betydande investeringar i förbättrade JavaScript-renderingsfunktioner, och gått från en tvåstegsprocess (crawl och indexering) till en trestegsprocess (crawl, rendering och indexering) som hanterar moderna webbapplikationer bättre. Rendering är dock fortfarande resursbegränsad och det finns inga tecken på att Google kommer att rendera varje sida omedelbart eller att renderingsbudgetar försvinner. Branschen ser en förskjutning mot hybridrendering där kritiskt innehåll server-renderas medan interaktiva element client-renderas, vilket balanserar SEO-behov och användarupplevelse. Web Components och Shadow DOM blir allt vanligare, vilket kräver att SEO:er förstår hur dessa tekniker interagerar med sökmotorernas rendering. Utvecklingen av AI-sök skapar ett nytt tryck att göra innehåll åtkomligt utan JavaScript-körning, vilket sannolikt driver på införandet av SSR och SSG. Core Web Vitals är fortsatt en rankingfaktor, och JavaScripts påverkan på dessa mätvärden innebär att prestandaoptimering är oskiljaktigt från JavaScript SEO. Branschdata visar att endast 10,6% av SEO:er förstår perfekt hur Google crawlar, renderar och indexerar JavaScript, vilket innebär stort utrymme för utbildning och kompetensutveckling. I takt med att JavaScript-ramverk blir mer sofistikerade och AI-sökplattformar ökar, kommer JavaScript SEO-expertis att bli allt mer värdefull och avgörande för konkurrenskraftig organisk synlighet.

main.2a846fa617c3361f.js) så Google vet när koden ändrats och behöver hämtas igenloading="lazy") istället för JavaScript-baserade lösningar för bättre crawler-kompatibilitetJavaScript SEO har utvecklats från en nischad teknisk fråga till en grundläggande del av modern sökmotoroptimering. Med 98,7% av webbplatser som använder JavaScript och 88% av SEO:er som regelbundet stöter på JavaScript-beroende sajter, är förmågan att optimera JavaScript-renderat innehåll inte längre valfri—det är nödvändigt. Komplexiteten i trestegs-renderingspipen, resursbegränsningarna i renderingsbudgetar och framväxten av AI-sökplattformar har skapat en mångfacetterad utmaning som kräver både teknisk kunskap och strategiskt beslutsfattande. Statistiken är talande: 41,6% av SEO:er har inte läst Googles JavaScript-dokumentation, 31,9% är osäkra på hur man identifierar JavaScript-beroende sajter och 30,9% är inte bekväma med att undersöka JavaScript-orsakade problem. Ändå är effekten betydande—4,60% av JavaScript-revisioner visar kritiska problem som noindex-taggar endast i svar-HTML, vilket helt förhindrar indexering. Vägen framåt kräver satsning på utbildning, införande av lämpliga renderingsstrategier och implementering av bästa praxis som säkerställer att innehållet är tillgängligt för både sökmotorer och AI-crawlers. Oavsett om det sker via Server-Side Rendering, Dynamisk rendering eller noggrann optimering av Client-Side Rendering, är målet detsamma: gör ditt JavaScript-drivna innehåll fullt upptäckbart, indexerbart och synligt över alla sökplattformar—från traditionell Google-sök till nya AI-sökverktyg. För organisationer som använder AmICited för att övervaka varumärkessynlighet i AI-svar blir JavaScript SEO ännu viktigare, eftersom ooptimerat JavaScript-renderat innehåll är osynligt för LLM-crawlers och inte genererar citeringar i AI-sökresultat.

Ja, Google renderar och indexerar JavaScript-innehåll med hjälp av headless Chromium. Renderingen är dock resurskrävande och skjuts upp tills Google har tillgängliga resurser. Google bearbetar sidor i tre faser: crawling, rendering och indexering. Sidor som är markerade med noindex-taggar renderas inte, och renderingsfördröjningar kan sakta ner indexeringen. Viktigast är att det är den renderade HTML:en—inte den initiala svar-HTML:en—som Google använder för indexeringsbeslut.

Enligt data från 2024 har 98,7% av webbplatser nu någon grad av JavaScript-beroende. Dessutom använder 62,3% av utvecklarna JavaScript som sitt primära programmeringsspråk, och 88% av SEO:er hanterar ibland eller alltid JavaScript-beroende webbplatser. Denna utbredda användning gör JavaScript SEO-kunskap avgörande för moderna SEO-specialister.

Viktiga utmaningar inkluderar renderingsfördröjningar som saktar ner indexeringen, resurskrävande processer som förbrukar crawlbudget, potentiella soft 404-fel i single-page-applikationer samt JavaScript-orsakade ändringar av kritiska element som titlar, kanoniska taggar och meta robots-taggar. Dessutom kör de flesta LLM-crawlers och AI-söktjänster inte JavaScript, vilket gör innehåll osynligt för AI-drivna sökplattformar om det endast syns efter rendering.

Svar-HTML är den initiala HTML som skickas från servern (det du ser i 'Visa källa'). Renderad HTML är det slutliga DOM efter JavaScript-körning (det du ser i webbläsarens inspektör). JavaScript kan avsevärt ändra DOM genom att injicera innehåll, ändra meta-taggar, skriva om titlar och lägga till eller ta bort länkar. Sökmotorer indexerar baserat på renderad HTML, inte svar-HTML.

Server-Side Rendering (SSR) är optimalt för SEO eftersom innehållet är fullt renderat på servern innan det levereras. Client-Side Rendering (CSR) kräver att sökmotorer renderar sidor, vilket orsakar fördröjningar och indexeringsproblem. Dynamisk rendering levererar för-renderad HTML till crawlers medan användare får CSR, men Google rekommenderar detta endast som en tillfällig lösning. Välj utifrån din webbplats SEO-prioriteringar och tekniska resurser.

Använd Google Search Consoles URL-inspektionsverktyg: gå till URL-inspektion, klicka på 'Testa live-URL' och visa sedan fliken 'HTML' för att se den renderade HTML som Google bearbetat. Alternativt kan du använda verktyg som Screaming Frog med rendering aktiverad, Sitebulbs Response vs Render-rapport eller Chrome DevTools för att jämföra initial HTML med renderad DOM och identifiera JavaScript-relaterade problem.

En renderingsbudget är mängden resurser Google tilldelar för att rendera sidor på din webbplats. Google prioriterar rendering för sidor som förväntas få mer söktrafik. JavaScript-tunga webbplatser med lägre prioritet kan uppleva betydande renderingsfördröjningar, vilket saktar ner indexeringen. Därför är det avgörande att optimera JavaScript för att minska renderingstiden och se till att kritiskt innehåll finns i den initiala HTML-svaret för bästa SEO-prestanda.

De flesta LLM-crawlers och AI-drivna sökverktyg (som Perplexity, Claude och andra) kör inte JavaScript—de använder rå HTML. Om ditt kritiska innehåll endast visas efter JavaScript-körning är det osynligt både för Googles initiala crawl och AI-sökmotorplattformar. Därför är JavaScript SEO avgörande inte bara för traditionell sökning utan även för synlighet och citeringsmöjligheter i nya AI-baserade sökverktyg.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Content SEO är den strategiska skapandet och optimeringen av högkvalitativt innehåll för att förbättra sökmotorrankningar och organisk synlighet. Lär dig hur du...

Enterprise SEO är praxis att optimera stora, komplexa webbplatser med tusentals sidor för sökmotorer. Lär dig strategier, utmaningar och bästa praxis för organi...

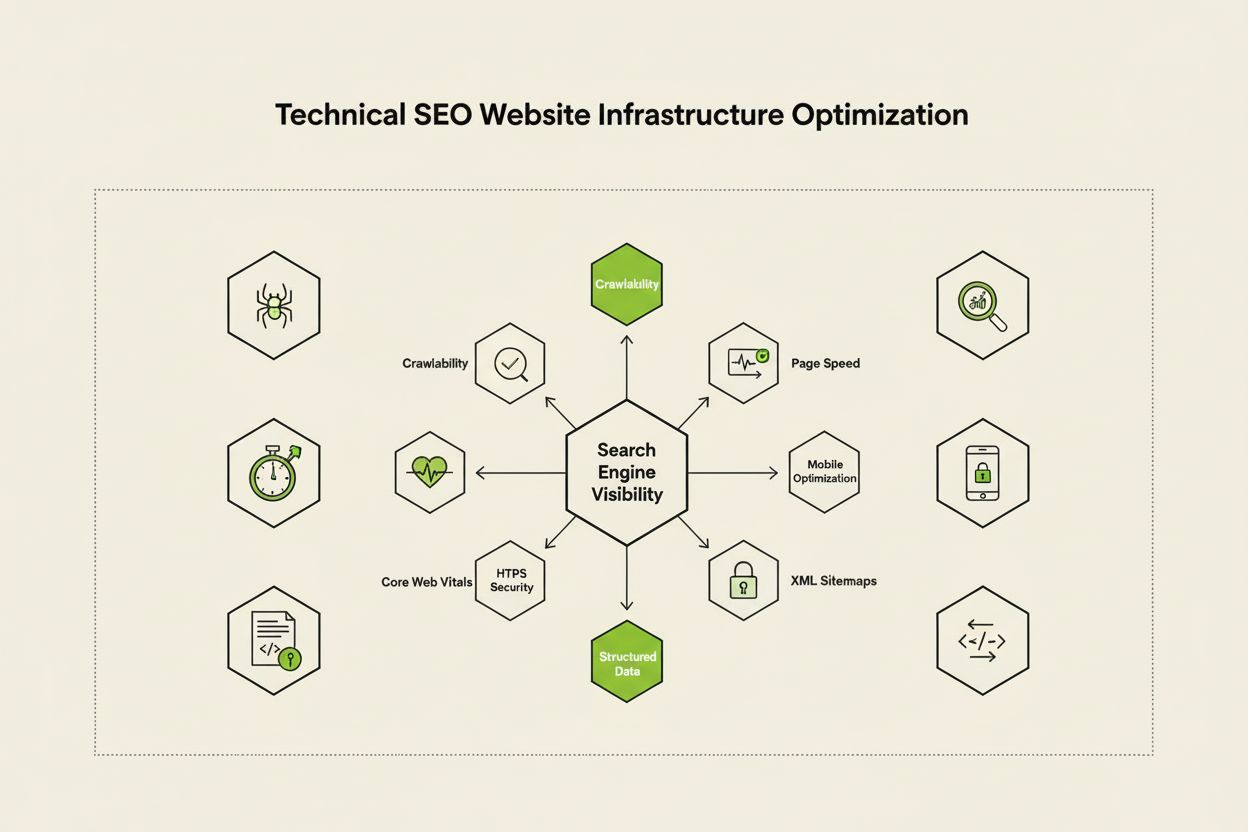

Teknisk SEO optimerar webbplatsens infrastruktur för sökmotors genomsökning, indexering och ranking. Lär dig om crawlability, Core Web Vitals, mobiloptimering o...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.