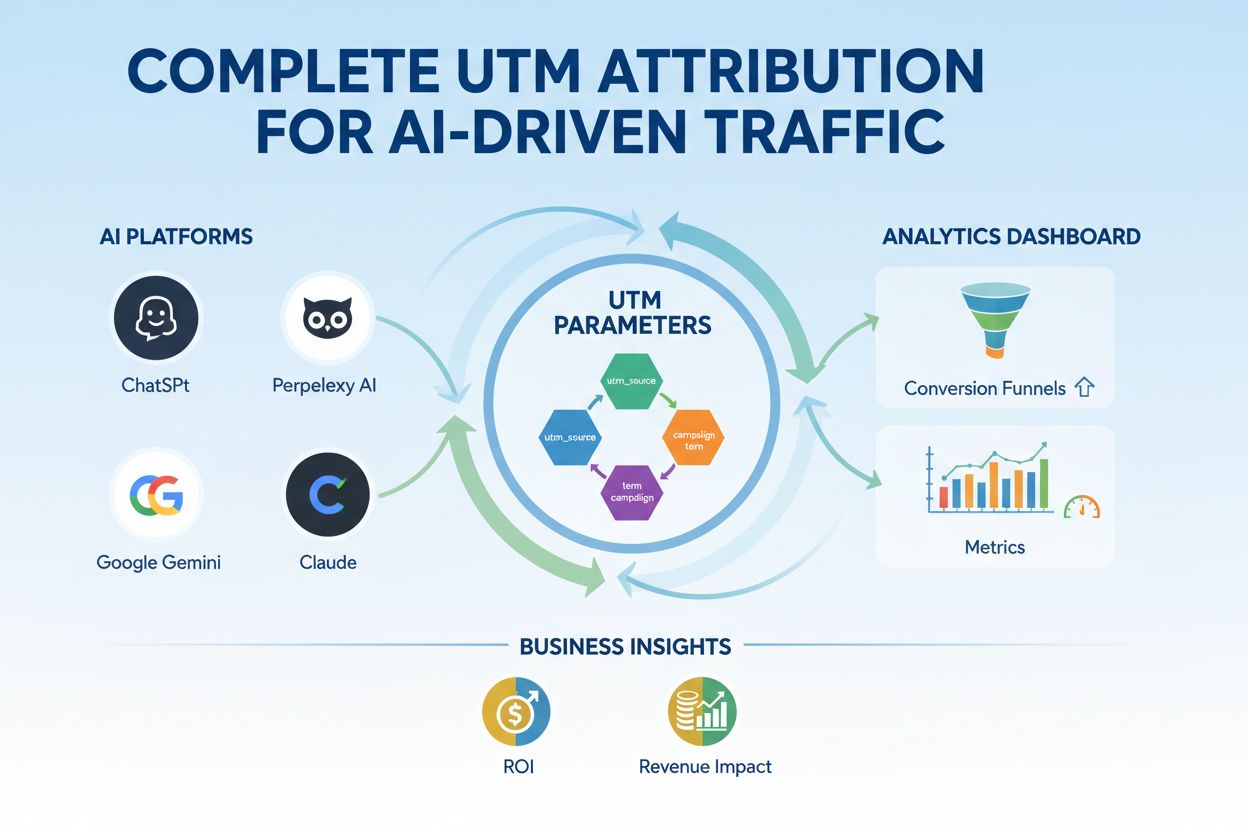

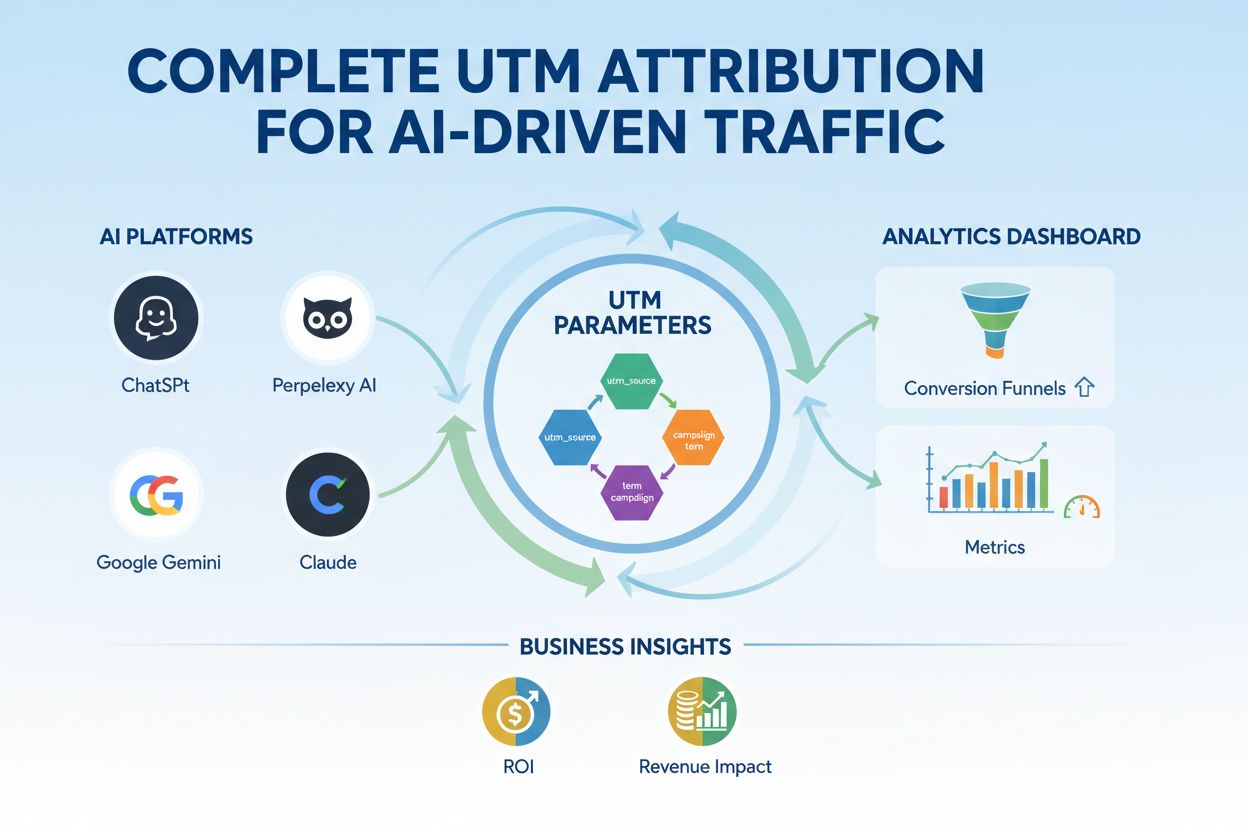

UTM-parametrar för AI-drivet trafik

Bemästra UTM-spårning för AI-plattformar som ChatGPT, Perplexity och Google Gemini. Lär dig inställning, bästa praxis och hur du korrekt attribuerar AI-trafik i...

Modellparametrar är lärbara variabler inom AI-modeller, såsom vikter och biaser, som automatiskt justeras under träningen för att optimera modellens förmåga att göra korrekta förutsägelser och definierar hur modellen bearbetar indata för att generera utdata.

Modellparametrar är lärbara variabler inom AI-modeller, såsom vikter och biaser, som automatiskt justeras under träningen för att optimera modellens förmåga att göra korrekta förutsägelser och definierar hur modellen bearbetar indata för att generera utdata.

Modellparametrar är lärbara variabler inom artificiella intelligensmodeller som automatiskt justeras under träningsprocessen för att optimera modellens förmåga att göra korrekta förutsägelser och definierar hur modellen bearbetar indata för att generera utdata. Dessa parametrar fungerar som de grundläggande “kontrollrattarna” i maskininlärningssystem och avgör det exakta beteendet och beslutsmönstren hos AI-modeller. I samband med djupinlärning och neurala nätverk består parametrarna främst av vikter och biaser—numeriska värden som styr hur information flödar genom nätverket och hur starkt olika egenskaper påverkar förutsägelserna. Syftet med träningen är att hitta de optimala värdena för dessa parametrar som minimerar förutsägelsefel och gör det möjligt för modellen att generalisera väl till ny, osedd data. Att förstå modellparametrar är avgörande för att förstå hur moderna AI-system som ChatGPT, Claude, Perplexity och Google AI Overviews fungerar och varför de ger olika svar på samma indata.

Begreppet lärbara parametrar inom maskininlärning går tillbaka till de tidiga artificiella neurala nätverken på 1950- och 1960-talen, då forskare först insåg att nätverk kunde justera interna värden för att lära sig från data. Men den praktiska tillämpningen av parametrar var begränsad tills bakåtspridning introducerades på 1980-talet, vilket gav en effektiv algoritm för att beräkna hur parametrar skulle justeras för att minska fel. Explosionen av parameterantal accelererade dramatiskt med framväxten av djupinlärning på 2010-talet. Tidiga konvolutionella neurala nätverk för bildigenkänning innehöll miljoner parametrar, medan moderna stora språkmodeller (LLM) innehåller hundratals miljarder eller till och med biljoner parametrar. Enligt forskning från Our World in Data och Epoch AI har antalet parametrar i framstående AI-system ökat exponentiellt, där GPT-3 innehåller 175 miljarder parametrar, GPT-4o cirka 200 miljarder parametrar och vissa uppskattningar tyder på att GPT-4 kan innehålla upp till 1,8 biljoner parametrar om man räknar med mixture-of-experts-arkitekturer. Denna dramatiska skalning har fundamentalt förändrat vad AI-system kan åstadkomma och har gjort det möjligt för dem att fånga alltmer komplexa mönster inom språk, bild och resonemangsuppgifter.

Modellparametrar fungerar genom en matematisk ram där varje parameter representerar ett numeriskt värde som påverkar hur modellen omvandlar indata till utdata. I en enkel linjär regressionsmodell består parametrarna av lutning (m) och intercept (b) i ekvationen y = mx + b, där dessa två värden avgör den linje som bäst passar datan. I neurala nätverk blir situationen exponentiellt mer komplex. Varje neuron i ett lager tar emot indata från det föregående lagret, multiplicerar varje indata med en motsvarande vikt-parameter, summerar dessa viktade indata, adderar en bias-parameter och skickar resultatet genom en aktiveringsfunktion för att producera en utdata. Denna utdata blir sedan indata till neuroner i nästa lager, vilket skapar en kedja av parameterstyrda transformationer. Under träningen använder modellen gradientnedstigning och relaterade optimeringsalgoritmer för att beräkna hur varje parameter ska justeras för att minska förlustfunktionen—ett matematiskt mått på förutsägelsefelet. Gradienterna av förlusten med avseende på varje parameter indikerar riktning och storlek på den nödvändiga justeringen. Genom bakåtspridning flödar dessa gradienter bakåt genom nätverket och gör det möjligt för optimeraren att uppdatera alla parametrar samtidigt på ett koordinerat sätt. Denna iterativa process fortsätter över flera tränings-epoker tills parametrarna konvergerar till värden som minimerar förlusten på träningsdatan samtidigt som de ger god generalisering till ny data.

| Aspekt | Modellparametrar | Hyperparametrar | Egenskaper |

|---|---|---|---|

| Definition | Lärbara variabler som justeras under träning | Konfigurationsinställningar som definieras före träning | Indatakaraktäristika som används av modellen |

| När de sätts | Lärs automatiskt genom optimering | Konfigureras manuellt av praktiker | Extraheras eller konstrueras från rådata |

| Exempel | Vikter, biaser i neurala nätverk | Inlärningshastighet, batchstorlek, antal lager | Pixelvärden i bilder, ordbäddningar i text |

| Påverkan på modellen | Avgör hur modellen kartlägger indata till utdata | Styr träningsprocessen och modellens struktur | Ger råinformationen som modellen lär sig från |

| Optimeringsmetod | Gradientnedstigning, Adam, AdaGrad | Grid search, random search, bayesiansk optimering | Feature engineering, feature selection |

| Antal i stora modeller | Miljarder till biljoner (t.ex. 200B i GPT-4o) | Vanligtvis 5-20 nyckelhyperparametrar | Tusentals till miljoner beroende på data |

| Beräkningskostnad | Hög under träning; påverkar inferenshastighet | Minimal beräkningskostnad att sätta | Bestäms av datainsamling och förbearbetning |

| Överförbarhet | Kan överföras via finjustering och transfer learning | Måste justeras om för nya uppgifter | Kan kräva ny konstruktion för nya domäner |

Modellparametrar tar olika former beroende på arkitektur och typ av maskininlärningsmodell som används. I konvolutionella neurala nätverk (CNN) för bildigenkänning inkluderar parametrarna vikterna i konvolutionsfilter (även kallade kärnor) som detekterar rumsliga mönster som kanter, texturer och former på olika skalor. Rekurrenta neurala nätverk (RNN) och long short-term memory (LSTM)-nätverk innehåller parametrar som styr informationsflödet över tid, inklusive grindparametrar som avgör vad som ska minnas eller glömmas. Transformer-modeller, som driver moderna stora språkmodeller, har parametrar i flera komponenter: uppmärksamhetsvikter som avgör vilka delar av indatan som ska fokuseras på, vikter i feed-forward-nätverk och parametrar för lagernormalisering. I probabilistiska modeller som Naive Bayes definierar parametrarna villkorliga sannolikhetsfördelningar. Support Vector Machines använder parametrar som placerar och orienterar beslutsgränser i egenskapsutrymmet. Mixture of Experts (MoE)-modeller, som används i vissa versioner av GPT-4, innehåller parametrar för flera specialiserade subnätverk samt routingparametrar som avgör vilka experter som bearbetar varje indata. Denna arkitektoniska mångfald gör att arten och antalet parametrar varierar avsevärt mellan olika modelltyper, men den grundläggande principen är konstant: parametrar är de inlärda värden som gör det möjligt för modellen att utföra sin uppgift.

Vikter och biaser representerar de två grundläggande typerna av parametrar i neurala nätverk och utgör grunden för hur dessa modeller lär sig. Vikter är numeriska värden som tilldelas kopplingar mellan neuroner och avgör styrkan och riktningen på påverkan som en neurons utdata har på nästa neurons indata. I ett fullt anslutet lager med 1 000 input-neuroner och 500 output-neuroner skulle det finnas 500 000 viktparametrar—en för varje koppling. Under träningen justeras vikterna för att öka eller minska inflytandet av specifika egenskaper på förutsägelser. En stor positiv vikt innebär att funktionen starkt aktiverar nästa neuron, medan en negativ vikt hämmar den. Biaser är ytterligare parametrar, en per neuron i ett lager, som ger en konstant förskjutning till neuronens indata-summa innan aktiveringsfunktionen tillämpas. Matematiskt, om en neuron får viktade indata som summerar till noll, gör biasen att neuronen ändå kan producera en icke-noll utdata, vilket ger avgörande flexibilitet. Denna flexibilitet gör det möjligt för neurala nätverk att lära sig komplexa beslutsgränser och fånga mönster som inte vore möjliga med enbart vikter. I en modell med 200 miljarder parametrar som GPT-4o är den stora majoriteten vikter i uppmärksamhetsmekanismer och feed-forward-nätverk, medan biaser utgör en mindre men ändå betydande del. Tillsammans möjliggör vikter och biaser för modellen att lära sig de intrikata mönstren inom språk, bild eller andra områden som gör moderna AI-system så kraftfulla.

Antalet parametrar i en modell har en djupgående inverkan på dess förmåga att lära sig komplexa mönster och dess övergripande prestanda. Forskning visar konsekvent att skalningslagar styr sambandet mellan antal parametrar, träningsdatastorlek och modellprestanda. Modeller med fler parametrar kan representera mer komplexa funktioner och fånga mer nyanserade mönster i data, vilket generellt leder till bättre prestanda på utmanande uppgifter. GPT-3 med 175 miljarder parametrar demonstrerade anmärkningsvärda fåskottsinlärningsförmågor som mindre modeller inte kunde matcha. GPT-4o med 200 miljarder parametrar visar ytterligare förbättringar inom resonemang, kodgenerering och multimodal förståelse. Men sambandet mellan parametrar och prestanda är inte linjärt och beror kritiskt på mängden och kvaliteten på träningsdatan. En modell med för många parametrar i förhållande till träningsdatan överanpassar och memorerar specifika exempel istället för att lära sig generaliserbara mönster, vilket leder till dålig prestanda på ny data. Omvänt kan en modell med för få parametrar underanpassa och misslyckas med att fånga viktiga mönster även på träningsdatan. Det optimala antalet parametrar för en given uppgift beror på faktorer som uppgiftens komplexitet, storleken och mångfalden i träningsdatan samt beräkningsbegränsningar. Forskning från Epoch AI visar att moderna AI-system har uppnått anmärkningsvärd prestanda genom massiv skalning, där vissa modeller innehåller biljoner parametrar om man räknar med mixture-of-experts-arkitekturer där inte alla parametrar är aktiva för varje indata.

Samtidigt som stora modeller med miljarder parametrar uppnår imponerande prestanda, är de beräkningsmässiga kostnaderna för att träna och använda sådana modeller betydande. Det har drivit forskning kring parametereffektiva finjusteringsmetoder som gör det möjligt för användare att anpassa förtränade modeller till nya uppgifter utan att uppdatera alla parametrar. LoRA (Low-Rank Adaptation) är en framstående teknik som fryser de flesta förtränade parametrar och endast tränar en liten uppsättning ytterligare matriser med låg rang, vilket minskar antalet träningsbara parametrar med flera storleksordningar samtidigt som prestandan bibehålls. Till exempel kan finjustering av en 7 miljarder parameter-modell med LoRA innebära att endast 1-2 miljoner ytterligare parametrar tränas istället för alla 7 miljarder. Adaptermoduler inför små träningsbara nätverk mellan lagren i en fryst förtränad modell och lägger bara till en liten procentandel parametrar samtidigt som de möjliggör uppgiftsanpassning. Prompt engineering och in-context learning är alternativa metoder som inte alls modifierar parametrar utan istället använder modellens befintliga parametrar mer effektivt genom noggrant utformade indata. Dessa parametereffektiva tillvägagångssätt har demokratiserat tillgången till stora språkmodeller och gör det möjligt för organisationer med begränsade resurser att anpassa toppmoderna modeller för sina specifika behov. Avvägningen mellan parametereffektivitet och prestanda är ett aktivt forskningsområde, där användare balanserar önskan om beräkningsmässig effektivitet mot behovet av uppgiftsspecifik noggrannhet.

Att förstå modellparametrar är avgörande för plattformar som AmICited som övervakar hur varumärken och domäner förekommer i AI-genererade svar över system som ChatGPT, Perplexity, Claude och Google AI Overviews. Olika AI-modeller med olika parameterkonfigurationer genererar olika utdata på samma fråga, vilket påverkar var och hur varumärken nämns. De 200 miljarder parametrarna i GPT-4o är konfigurerade annorlunda än parametrarna i Claude 3.5 Sonnet eller Perplexitys modeller, vilket leder till variationer i svars-genereringen. Parametrar som lärts in under träning på olika dataset och med olika träningsmål gör att modellerna har olika kunskap, resonemangsmönster och citeringsbeteenden. Vid övervakning av varumärkesomnämnanden i AI-svar hjälper förståelsen att dessa skillnader har sitt ursprung i parametervariationer att förklara varför ett varumärke kan vara framträdande i ett AI-svar men knappt nämnas i ett annat. Parametrarna som styr uppmärksamhetsmekanismer avgör vilka delar av modellens träningsdata som är mest relevanta för en fråga och påverkar citeringsmönster. Parametrarna i utgenereringslagren avgör hur modellen strukturerar och presenterar information. Genom att spåra hur olika AI-system med olika parameterkonfigurationer nämner varumärken ger AmICited insikt i hur parameterstyrt modellbeteende påverkar varumärkessynlighet i AI-drivna söklandskapet.

Modellparametrarnas framtid formas av flera samverkande trender som fundamentalt kommer att förändra hur AI-system designas och implementeras. Mixture of Experts (MoE)-arkitekturer representerar en betydande utveckling, där modeller innehåller flera specialiserade subnätverk (experter) med separata parametrar och en routingmekanism avgör vilka experter som bearbetar varje indata. Detta tillvägagångssätt gör det möjligt för modeller att skalas till biljoner parametrar samtidigt som beräkningsmässig effektivitet bibehålls vid inferens, eftersom inte alla parametrar är aktiva för varje indata. GPT-4 använder enligt uppgift en MoE-arkitektur med 16 experter, var och en med 110 miljarder parametrar, totalt 1,8 biljoner parametrar men endast en bråkdel används vid inferens. Glesa parametrar och beskärningstekniker utvecklas för att identifiera och ta bort mindre viktiga parametrar, vilket minskar modellstorleken utan att offra prestanda. Kontinuerligt lärande syftar till att uppdatera parametrar effektivt när ny data blir tillgänglig, så att modeller kan anpassa sig utan fullständig omträning. Federerad inlärning fördelar parameterträning över flera enheter samtidigt som integriteten bevaras, vilket gör det möjligt för organisationer att dra nytta av storskalig träning utan att centralisera känslig data. Framväxten av små språkmodeller (SLM) med miljarder istället för hundratals miljarder parametrar antyder en framtid där parametereffektivitet blir lika viktigt som själva parameterantalet. När AI-system blir alltmer integrerade i kritiska tillämpningar blir förståelsen och kontrollen av modellparametrar allt viktigare för att säkerställa säkerhet, rättvisa och överensstämmelse med mänskliga värderingar. Sambandet mellan parameterantal och modellbeteende kommer att fortsätta vara ett centralt fokus för AI-forskning, med implikationer för allt från beräkningsmässig hållbarhet till tolkbarhet och tillförlitlighet hos AI-system.

Modellparametrar är interna variabler som lärs in under träning via optimeringsalgoritmer som gradientnedstigning, medan hyperparametrar är externa inställningar som konfigureras innan träningen börjar. Parametrar avgör hur modellen kartlägger indata till utdata, medan hyperparametrar styr själva träningsprocessen, såsom inlärningshastighet och antal epoker. Till exempel är vikter och biaser i neurala nätverk parametrar, medan inlärningshastigheten är en hyperparameter.

Moderna stora språkmodeller innehåller miljarder till biljoner parametrar. GPT-4o innehåller cirka 200 miljarder parametrar, medan GPT-4o-mini har ungefär 8 miljarder parametrar. Claude 3.5 Sonnet arbetar också med hundratals miljarder parametrar. Dessa enorma mängder parametrar gör det möjligt för modellerna att fånga komplexa mönster i språket och generera sofistikerade, kontextuellt relevanta svar inom många olika ämnesområden.

Fler parametrar ökar en modells kapacitet att lära sig komplexa mönster och samband i data. Med fler parametrar kan modeller representera mer nyanserade egenskaper och interaktioner, vilket leder till högre noggrannhet på träningsdata. Men det krävs en kritisk balans: för många parametrar i förhållande till träningsdata kan leda till överanpassning, där modellen memorerar brus istället för att lära sig generaliserbara mönster, vilket resulterar i sämre prestanda på ny, osedd data.

Modellparametrar uppdateras genom bakåtspridning och optimeringsalgoritmer som gradientnedstigning. Under träningen gör modellen förutsägelser, beräknar förlusten (felet) mellan förutsägelser och faktiska värden, och beräknar sedan gradienter som visar hur varje parameter bidragit till felet. Optimeraren justerar sedan parametrarna i riktning som minskar förlusten, och denna process upprepas under flera träningsiterationer tills modellen konvergerar till optimala värden.

Vikter bestämmer styrkan på kopplingarna mellan neuroner i neurala nätverk och styr hur starkt indatafunktioner påverkar utdata. Biaser fungerar som tröskeljusterare, så att neuroner kan aktiveras även när de viktade indatan är noll, vilket ger flexibilitet och gör det möjligt för modellen att lära sig grundläggande mönster. Tillsammans utgör vikter och biaser de centrala lärbara parametrarna som gör det möjligt för neurala nätverk att approximera komplexa funktioner och göra korrekta förutsägelser.

Modellparametrar påverkar direkt hur AI-system som ChatGPT, Perplexity och Claude bearbetar och svarar på frågor. Att förstå parameterantal och konfigurationer hjälper till att förklara varför olika AI-modeller ger olika svar på samma prompt. För varumärkesövervakningsplattformar som AmICited är det avgörande att spåra hur parametrar påverkar modellbeteende för att kunna förutsäga var varumärken dyker upp i AI-svar och förstå konsekvensen mellan olika AI-system.

Ja, genom transfer learning kan parametrar från en förtränad modell anpassas för nya uppgifter. Detta tillvägagångssätt, kallat finjustering, innebär att man tar en modell med inlärda parametrar och justerar dem på ny data för specifika tillämpningar. Parameter-effektiva finjusteringsmetoder som LoRA (Low-Rank Adaptation) gör det möjligt att selektivt uppdatera parametrar, vilket minskar beräkningskostnaderna samtidigt som prestandan bibehålls. Denna teknik används ofta för att anpassa stora språkmodeller till specialiserade områden.

Modellparametrar påverkar direkt de beräkningskrav som krävs både under träning och inferens. Fler parametrar kräver mer minne, processorkraft och tid att träna och använda. En modell med 175 miljarder parametrar (som GPT-3) kräver avsevärt mer beräkningsresurser än en modell med 7 miljarder parametrar. Detta samband är avgörande för organisationer som implementerar AI-system, eftersom parameterantalet påverkar infrastrukturkostnader, latens och energiförbrukning i produktionsmiljöer.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Bemästra UTM-spårning för AI-plattformar som ChatGPT, Perplexity och Google Gemini. Lär dig inställning, bästa praxis och hur du korrekt attribuerar AI-trafik i...

Lär dig hur finjustering av AI-modeller anpassar förtränade modeller för specifika bransch- och varumärkesrelaterade uppgifter, förbättrar noggrannheten och min...

Lär dig hur produktspecifikationer förbättrar AI-rekommendationssystem genom att tillhandahålla strukturerad data, höja träffsäkerheten och möjliggöra bättre pe...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.