Panda-uppdateringen

Lär dig om Googles Panda-uppdatering, algoritmändringen från 2011 som riktade in sig på innehåll av låg kvalitet. Förstå hur den fungerar, dess inverkan på SEO ...

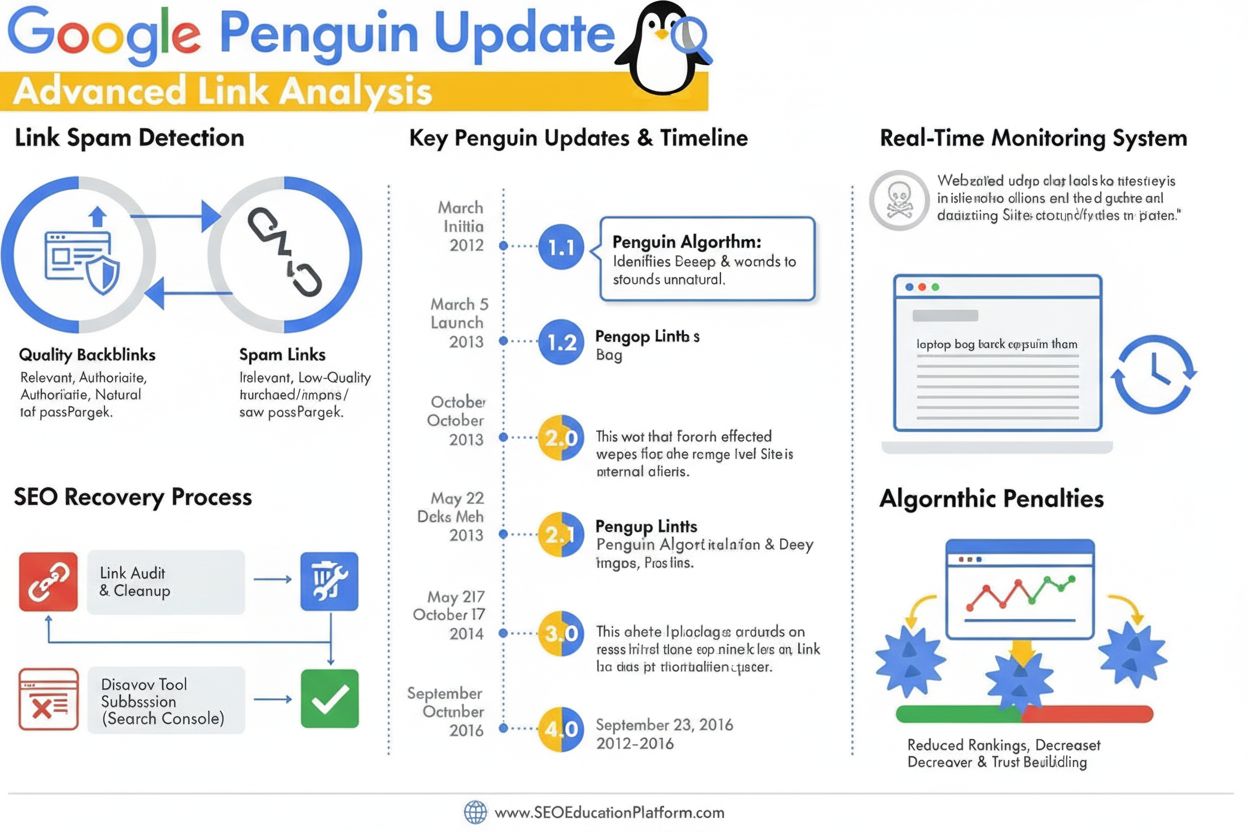

Penguin-uppdateringen är en Google-algoritm utformad för att bekämpa länkspam och manipulativa länkbyggarpraktiker genom att identifiera och nedvärdera lågkvalitativa, onaturliga bakåtlänkar. Den lanserades först i april 2012 och utvecklades 2016 till en realtidskomponent som kontinuerligt övervakar och justerar rankningar baserat på länkarnas kvalitet och mönster av länkmanipulation.

Penguin-uppdateringen är en Google-algoritm utformad för att bekämpa länkspam och manipulativa länkbyggarpraktiker genom att identifiera och nedvärdera lågkvalitativa, onaturliga bakåtlänkar. Den lanserades först i april 2012 och utvecklades 2016 till en realtidskomponent som kontinuerligt övervakar och justerar rankningar baserat på länkarnas kvalitet och mönster av länkmanipulation.

Penguin-uppdateringen är en Google-algoritm som specifikt utformats för att bekämpa länkspam och manipulativa länkbyggarpraktiker genom att identifiera, nedvärdera och bestraffa webbplatser med onaturliga eller lågkvalitativa bakåtlänksprofiler. Den tillkännagavs officiellt av Matt Cutts den 24 april 2012 och representerade Googles offensiva svar på det växande problemet med black-hat SEO-tekniker som konstlat höjde sökrankningar genom köpta länkar, länkutbyten och andra vilseledande metoder. Algoritmens primära mål är att säkerställa att naturliga, auktoritativa och relevanta länkar belönas medan manipulativa och spamfyllda länkar nedgraderas eller ignoreras helt. Till skillnad från innehållsfokuserade uppdateringar som Panda, som riktar sig mot lågkvalitativt innehåll, utvärderar Penguin specifikt kvaliteten och äktheten i en webbplats inkommande länkprofil, vilket gör den till en avgörande del av Googles rankningssystem i över ett decennium.

Penguin-uppdateringen introducerades under en avgörande period i sökmotoroptimering när länkvolym spelade en oproportionerligt stor roll för sökrankningar. Före Penguin kunde webbansvariga konstlat öka sina rankningar genom att skaffa stora mängder lågkvalitativa länkar från länkfarmar, privata bloggnätverk och andra spamkällor. Denna praxis skapade ett betydande problem för Googles sökresultat, då lågkvalitativa webbplatser och innehåll hamnade på framträdande positioner trots brist på verklig auktoritet eller relevans. Matt Cutts, då chef för Googles webspam-team, förklarade på SMX Advanced 2012-konferensen att “Vi ser det som något som är utformat för att bekämpa lågkvalitativt innehåll. Det började med Panda, och sedan märkte vi att det fortfarande var mycket spam och Penguin skapades för att ta itu med det.” Den första Penguin-lanseringen påverkade mer än 3 % av alla sökfrågor, vilket gör den till en av de mest genomgripande algoritmuppdateringarna i Googles historia. Denna stora påverkan signalerade till SEO-branschen att Google tog ett fast grepp mot manipulativa länkpraktiker och att algoritmerna skulle fortsätta utvecklas för att upprätthålla sökkvalitet.

Penguin-algoritmen fungerar genom avancerad maskininlärning och mönsterigenkänning som analyserar bakåtlänksprofiler för att identifiera onaturliga länkstrukturer. Algoritmen granskar flera faktorer vid bedömning av länkars kvalitet, inklusive auktoritet och relevans hos länkande domäner, ankartext som används, hastighet på länkanskaffning och kontextuell relevans mellan länkande och målsida. Penguin riktar sig särskilt mot länkscheman, vilket omfattar ett brett spektrum av manipulativa metoder såsom köpta länkar, ömsesidiga länkutbyten, länkar från privata bloggnätverk (PBN), länkar från lågkvalitativa kataloger och länkar med överdrivet nyckelordsfylld ankartext. Algoritmen utvärderar också förhållandet mellan hög- och lågkvalitativa länkar i en webbplats bakåtlänksprofil, med förståelse för att även legitima webbplatser ibland får några lågkvalitativa länkar. Men när andelen spam-länkar blir oproportionerligt hög flaggar Penguin webbplatsen för potentiella rankningsjusteringar. En viktig aspekt av Penguins design är att den endast utvärderar inkommande länkar till en webbplats; den analyserar inte utgående länkar från webbplatsen, utan fokuserar enbart på kvaliteten av bakåtlänkar som pekar mot en domän.

Penguin-uppdateringen genomgick betydande utveckling från den första lanseringen via flera iterationer, där den mest genomgripande förändringen skedde i september 2016 när Penguin 4.0 släpptes. Före denna milstolpe fungerade Penguin enligt ett batchuppdateringsschema, där Google meddelade periodiska uppdateringar som utvärderade webbplatsers bakåtlänksprofiler och justerade rankningar. Penguin 1.1 (mars 2012) och Penguin 1.2 (oktober 2012) var datauppdateringar som gjorde det möjligt för tidigare bestraffade sajter att återhämta sig om de hade rensat sina länkprofiler. Penguin 2.0 (maj 2013) var en mer tekniskt avancerad version som påverkade cirka 2,3 % av engelska sökfrågor och var den första iterationen som granskade djupare sajtdelar, bortom startsida och toppkategorier, för bevis på länkspam. Penguin 2.1 (oktober 2013) och Penguin 3.0 (oktober 2014) fortsatte utvecklingen med stegvisa förbättringar av upptäcktsförmågan. Men med Penguin 4.0 förändrades algoritmen fundamentalt när den integrerades i Googles kärnalgoritm som en realtidskomponent. Det innebar att webbplatser nu utvärderas kontinuerligt och rankningsjusteringar sker omedelbart när länkprofiler förändras, istället för att invänta schemalagda uppdateringar. Övergången till realtidsbearbetning förändrade också Penguins straffmekanism från direkta rankningsstraff till länknedvärdering, där spamfyllda länkar helt enkelt ignoreras istället för att orsaka rankningsras för hela sajten.

| Bedömningsfaktor | Högkvalitativa länkar | Lågkvalitativa/spam-länkar | Penguin-upptäckt |

|---|---|---|---|

| Källa för länken | Etablerade, betrodda domäner med hög domänauktoritet | Nya domäner, låg DA eller kända spamnätverk | Analyserar domänhistorik, förtroendesignaler och ämnesrelevans |

| Ankartext | Naturliga, varierade, kontextuellt relevanta fraser | Exakta nyckelord, repetitivt, överoptimerat | Flaggar onaturliga ankartextmönster och nyckelordsstoppning |

| Länkhastighet | Gradvis, organisk tillväxt över tid | Plötsliga ökningar eller onaturliga mönster | Övervakar anskaffningshastighet och konsistens |

| Kontextuell relevans | Länkar från ämnesrelaterade, auktoritativa källor | Länkar från orelaterade eller lågkvalitativa källor | Utvärderar semantisk relevans mellan länkande och målwebbplats |

| Länkplacering | Redaktionella länkar i innehåll, naturligt sammanhang | Sidfotslänkar, sidomenylänkar eller länkfarmar | Bedömer länkplacering och kontextuell integration |

| Kvalitet på länkande sajt | Högkvalitativt innehåll, legitim verksamhet | Tunt innehåll, autogenererade sidor eller PBN | Granskar sajtens totala kvalitet och innehållets äkthet |

| Nofollow-status | Korrekt tilldelad vid behov | Felaktigt använd eller saknas på köpta/promotade länkar | Känner igen korrekt användning av nofollow för icke-redaktionella länkar |

Penguin-uppdateringen förändrade i grunden SEO-praktiker genom att etablera länkens kvalitet som en kritisk rankningsfaktor och motverka utbredd användning av black-hat-länkbyggartekniker. Före Penguin deltog många SEO-byråer och webbansvariga i aggressiva länkköpskampanjer, länkutbyten och skapande av PBN utan större konsekvenser. Algoritmens lansering skapade omedelbara marknadsstörningar, med tusentals webbplatser som upplevde dramatiska rankningsfall och trafikförluster. Denna förändring tvingade SEO-branschen att anta mer etiska, white-hat metoder med fokus på att förtjäna länkar genom högkvalitativt innehåll och genuina relationer. Penguin-straffet blev en varningshistoria som påverkade hur företag närmade sig länkbyggande, vilket ledde till ökat fokus på innehållsmarknadsföring, PR och varumärkesbyggande som huvudstrategier för länkanskaffning. Branschforskning visar att förståelse och efterlevnad av Penguins krav blev avgörande för långsiktig SEO-framgång, och många organisationer införde bakåtlänksgranskningar och länkmonitorering som standardpraxis. Algoritmen gjorde också domänauktoritet, ämnesrelevans och länkhastighet till nyckelvärden för SEO-specialister vid utvärdering av länkpotential. Över 78 % av företag använder nu någon form av AI-driven innehållsövervakning eller länkanalysverktyg för att spåra sina bakåtlänksprofiler och säkerställa att de följer Googles kvalitetsriktlinjer—en direkt följd av Penguins påverkan på branschstandarder.

Återhämtning från en Penguin-nedgradering kräver ett systematiskt angreppssätt med bakåtlänksgranskningar, länkborttagning och strategisk användning av Googles avvisningsverktyg. Första steget är att göra en omfattande granskning av alla inkommande länkar via Google Search Console och tredjepartsverktyg som Ahrefs, SEMrush eller Moz, vilka ger detaljerade bakåtlänksprofiler och kvalitetsbedömningar. Webbansvariga måste därefter utvärdera varje länkande domän individuellt för att avgöra om länken är högkvalitativ och naturlig eller utgör en manipulativ åtgärd. För länkar som tydligt är spam eller låg kvalitet rekommenderas att kontakta länkande webbplatsens ansvariga och be om borttagning. Google avråder uttryckligen från att betala för länkborttagningar, då detta upprätthåller länkhandelsproblemet. För länkar som inte kan tas bort via kontakt används avvisningsverktyget i Google Search Console för att skicka in en fil som instruerar Google att ignorera vissa länkar vid utvärdering av webbplatsen. Observera att avvisade länkar också förlorar eventuell positiv effekt, så verktyget bör endast användas för verkligt skadliga länkar. När en avvisningsfil skickats behandlar Google den omedelbart men den faktiska rankningspåverkan beror på när Google omkryper de aktuella länkarna. Eftersom Penguin 4.0 körs i realtid kan återhämtning ske relativt snabbt—ibland inom dagar eller veckor—när tillräckliga korrigerande åtgärder har vidtagits. Webbansvariga bör dock inte förvänta sig att rankningarna återgår till nivåerna före straffet, eftersom vissa av dessa kan ha varit konstlat förhöjda av de lågkvalitativa länkar som nu tas bort.

När AI-söksystem som ChatGPT, Perplexity, Google AI Overviews och Claude blir allt viktigare för varumärkesnärvaro, blir förståelsen av Penguins principer relevant även utanför traditionella sökrankningar. Dessa AI-system citerar ofta auktoritativa källor och högkvalitativa webbplatser vid generering av svar, och webbplatser med starka bakåtlänksprofiler samt rena länkregister har större sannolikhet att erkännas som auktoritära i AI:s träningsdata och hämtningssystem. En webbplats som bestraffats av Penguin för länkspam kan inte bara drabbas i Googles organiska sökresultat, utan även nedprioriteras av AI-system som utvärderar källors trovärdighet. Omvänt har webbplatser med rena, högkvalitativa bakåtlänksprofiler större chans att citeras som auktoritativa källor i AI-genererade svar. Detta skapar ett ytterligare incitament att upprätthålla Penguin-efterlevnad utöver traditionella SEO-mått. AmICited och liknande AI-övervakningsplattformar hjälper organisationer att spåra hur deras domäner syns i AI-genererade svar och ger insikt om deras auktoritet erkänns på flera AI-söksystem. Skärningspunkten mellan Penguin-efterlevnad och AI-citattracking utgör en ny front inom digital marknadsföring, där länkens kvalitet påverkar både traditionell och framväxande synlighet i AI-sök.

Penguin-uppdateringen fortsätter att utvecklas i takt med att Google förfinar sin förståelse av länkars kvalitet och manipulerande metoder. Övergången till realtidsbearbetning 2016 innebar en grundläggande förändring i algoritmens funktion, men Google fortsätter att förbättra upptäcktsförmågan genom maskininlärning och artificiell intelligens. Nya framsteg i Googles SpamBrain-system, som presenterades 2022, markerar nästa steg i spamupptäckt och inkluderar avancerad AI för att identifiera både sajter som köper länkar och sajter som används för länkdistribution. Detta tyder på att framtida iterationer av länkspamdetektering kommer att bli ännu mer sofistikerade, vilket potentiellt gör det svårare för manipulerande metoder att undgå upptäckt. Branschtrenden mot white-hat SEO och förtjänad media väntas fortsätta accelerera i takt med att Googles algoritmer blir bättre på att skilja naturliga länkar från konstlade. Dessutom, när AI-söksystem får allt större genomslag, blir vikten av rena bakåtlänksprofiler större än bara Googles algoritm, och omfattar bredare erkännande som auktoritativ källa bland flera AI-system. Organisationer som prioriterar länkvalitet, varumärkesauktoritet och innehållsexcellens kommer stå starkast både i traditionell sökning och i framväxande AI-sökmiljöer. Penguin-uppdateringens arv är inte bara en specifik algoritm utan ett grundläggande skifte i hur sökmotorer och AI-system bedömer webbplatsers auktoritet, vilket gör länkvalitet till en permanent och allt viktigare faktor för digital synlighet.

En Penguin-nedgradering är algoritmisk och sker automatiskt när Googles Penguin-algoritm upptäcker mönster av länkspam, utan någon manuell inblandning. Ett Penguin-straff (eller manuell åtgärd) utfärdas av Googles webspam-team efter mänsklig granskning och kräver en begäran om omprövning för att tas bort. Sedan Penguin 4.0 blev realtid år 2016 kan algoritmiska nedgraderingar återhämtas nästan omedelbart när korrigerande åtgärder vidtas, medan manuella straff kräver uttryckligt godkännande från Google.

Penguin-uppdateringen använder maskininlärningsalgoritmer för att analysera bakåtlänksprofiler och identifiera mönster av manipulativt länkbyggande, inklusive köpta länkar, länkutbyten, privata bloggnätverk (PBN) och onaturliga mönster i ankartext. Algoritmen utvärderar förhållandet mellan högkvalitativa, naturliga länkar och lågkvalitativa spam-länkar som pekar på en webbplats. Den undersöker också relevansen och auktoriteten hos länkande domäner för att avgöra om länkar verkar vara konstlat anskaffade snarare än redaktionellt förtjänade.

Ja, återhämtning är möjlig genom en flerstegsprocess som innefattar granskning av bakåtlänkar, borttagning av spam-länkar och användning av Googles avvisningsverktyg för länkar du inte kan ta bort direkt. Eftersom Penguin 4.0 körs i realtid kan återhämtning ske relativt snabbt när du har rensat upp din länkprofil och Google omkryper dessa sidor. Återhämtning garanterar dock inte att du återfår tidigare rankningar, eftersom vissa av dessa rankningar kan ha varit konstlat höga på grund av de lågkvalitativa länkar du tar bort.

Penguin bestraffar länkar från länkfarmar, betalda länknätverk, privata bloggnätverk (PBN), ömsesidiga länkutbyten och sajter med onaturliga mönster i ankartext. Den riktar sig även mot länkar från lågkvalitativa kataloger, kommentarsspam, forumspam och länkar som erhålls genom manipulativa metoder. Dessutom flaggar Penguin länkar från auktoritativa sajter som verkar vara sålda eller placerade som annonser utan korrekta nofollow-taggar, eftersom dessa bryter mot Googles riktlinjer för länkmanipulation.

Sedan Penguin 4.0 släpptes i september 2016 körs algoritmen kontinuerligt i realtid som en del av Googles kärnalgoritm. Det innebär att Google ständigt utvärderar bakåtlänksprofiler och justerar rankningar baserat på länkarnas kvalitet utan att invänta schemalagda uppdateringar. Tidigare fungerade Penguin med batchuppdateringar som Google annonserade, men realtidsbearbetning har eliminerat behovet av dessa tillkännagivanden och möjliggör snabbare återhämtning när problem rättas till.

Avvisningsverktyget är en funktion i Google Search Console som låter webbansvariga be Google att ignorera specifika bakåtlänkar vid deras utvärdering av webbplatsen. Det används som en sista utväg när du inte kan kontakta webbansvariga för att direkt ta bort spam-länkar. Genom att avvisa lågkvalitativa länkar förhindrar du att dessa påverkar dina rankningar negativt under Penguin-algoritmen. Dock ger avvisade länkar inte heller någon positiv effekt, så verktyget bör bara användas för verkligt skadliga länkar.

Den ursprungliga Penguin-uppdateringen som lanserades i april 2012 påverkade mer än 3 % av alla sökfrågor enligt Googles uppskattningar. Efterföljande uppdateringar hade olika påverkan: Penguin 2.0 påverkade cirka 2,3 % av engelska sökfrågor, Penguin 2.1 påverkade omkring 1 % av sökfrågorna och Penguin 3.0 påverkade mindre än 1 % av engelska sökfrågor. Dessa procenttal motsvarar miljoner webbplatser globalt, vilket gör Penguin till en av de mest betydande algoritmuppdateringarna i sökhistorien.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig om Googles Panda-uppdatering, algoritmändringen från 2011 som riktade in sig på innehåll av låg kvalitet. Förstå hur den fungerar, dess inverkan på SEO ...

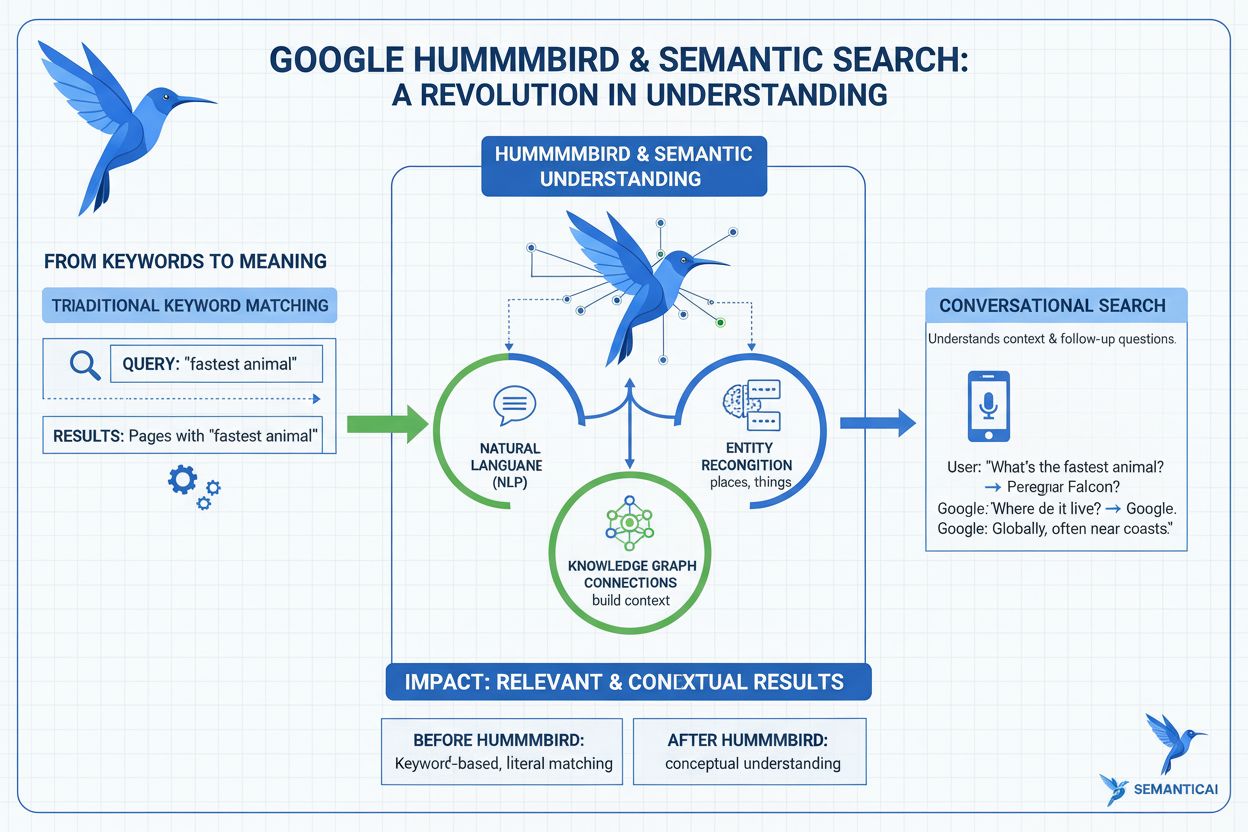

Lär dig vad Hummingbird-uppdateringen är, hur den revolutionerade semantisk sökning 2013 och varför den är viktig för AI-övervakning och varumärkesexponering öv...

Lär dig vad Google-algoritmuppdateringar är, hur de fungerar, och deras påverkan på SEO. Förstå kärnuppdateringar, spamuppdateringar och förändringar i rankning...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.